البشر في الحلقة – دليل قادة الأعمال للذكاء الاصطناعي المسؤول

دليل عملي لقادة الأعمال حول تطبيق أطر العمل البشري في الحلقة (HITL) من أجل حوكمة الذكاء الاصطناعي المسؤول، وتقليل المخاطر، والامتثال، وبناء الثقة في أنظمة الذكا...

يقدم دليل KPMG لمخاطر الذكاء الاصطناعي وإجراءات الضبط للمؤسسات منهجًا منظمًا وأخلاقيًا لإدارة مخاطر الذكاء الاصطناعي، ويدعم النشر المسؤول والامتثال للمعايير العالمية.

قد تكون هذه الإحصائية من العام الماضي، لكنها تظل أكثر أهمية اليوم. وفقًا لتوقعات الرؤساء التنفيذيين في الولايات المتحدة لعام 2024 من KPMG، حدد 68٪ من الرؤساء التنفيذيين الذكاء الاصطناعي كأولوية استثمارية قصوى. إنهم يعتمدون عليه لتعزيز الكفاءة، وتطوير مهارات القوى العاملة لديهم، ودفع الابتكار في جميع أنحاء مؤسساتهم.

هذا يُعد تصويتًا كبيرًا بالثقة في الذكاء الاصطناعي — لكنه يثير أيضًا سؤالًا مهمًا: مع وجود الكثير على المحك، كيف تضمن المؤسسات استخدام الذكاء الاصطناعي بطريقة مسؤولة وأخلاقية؟

هنا يأتي دور دليل KPMG لمخاطر الذكاء الاصطناعي وإجراءات الضبط. فهو يقدم إطارًا واضحًا وعمليًا لمساعدة الشركات على الاستفادة من إمكانيات الذكاء الاصطناعي مع إدارة المخاطر الحقيقية التي يجلبها. في ظل الظروف الحالية، فإن بناء ذكاء اصطناعي جدير بالثقة ليس مجرد ممارسة جيدة — بل أصبح ضرورة تجارية.

يحدث الذكاء الاصطناعي (AI) ثورة في الصناعات، ويطلق مستويات جديدة من الكفاءة والابتكار والقدرة التنافسية. لكن مع هذا التحول تأتي مجموعة فريدة من المخاطر والتحديات الأخلاقية التي يجب على المؤسسات إدارتها بعناية للحفاظ على الثقة وضمان الاستخدام المسؤول. تم تصميم دليل KPMG لمخاطر الذكاء الاصطناعي وإجراءات الضبط لدعم المؤسسات في التنقل بين هذه التعقيدات، من خلال توفير نهج عملي ومنظم وقائم على القيم نحو حوكمة الذكاء الاصطناعي.

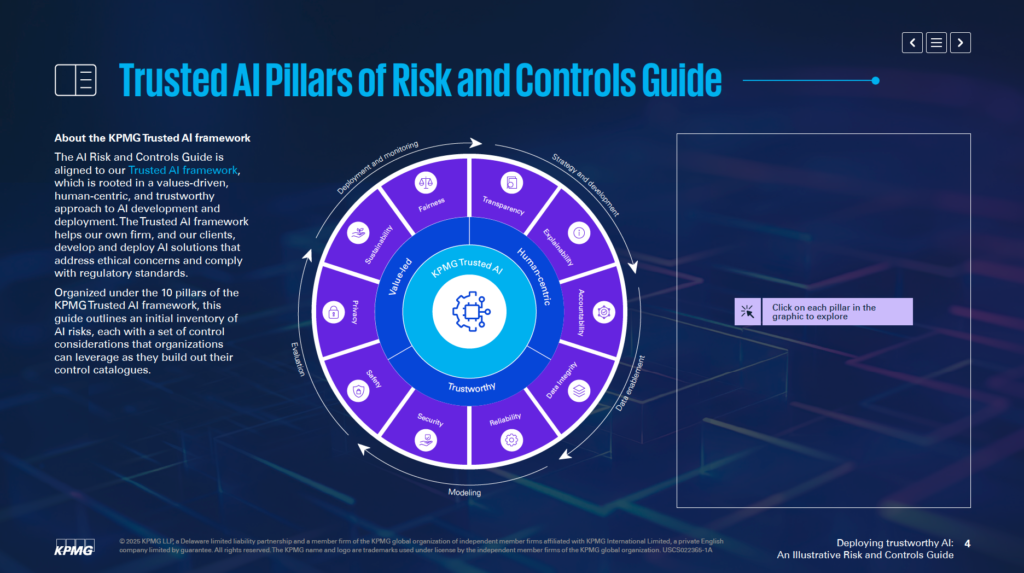

وبالاعتماد على إطار الذكاء الاصطناعي الموثوق من KPMG، يساعد هذا الدليل الشركات على تطوير ونشر حلول ذكاء اصطناعي أخلاقية ومتمركزة حول الإنسان ومتوافقة مع المعايير التنظيمية العالمية. وهو منظم حول 10 أعمدة أساسية، كل منها يعالج جانبًا حاسمًا من إدارة مخاطر الذكاء الاصطناعي:

من خلال التركيز على هذه الأعمدة، يمكن للمؤسسات تضمين المبادئ الأخلاقية في جميع مراحل دورة حياة الذكاء الاصطناعي — من الاستراتيجية والتطوير إلى النشر والمراقبة. لا يعزز هذا الدليل القدرة على مواجهة المخاطر فحسب، بل يشجع أيضًا على الابتكار المستدام والجدير بالثقة والمتوافق مع توقعات المجتمع.

سواء كنت متخصصًا في المخاطر أو قائداً تنفيذياً أو عالم بيانات أو مستشارًا قانونيًا، يقدم لك هذا الدليل الأدوات والرؤى الأساسية لمساعدتك على الاستفادة من قوة الذكاء الاصطناعي بمسؤولية.

يعمل دليل KPMG لمخاطر الذكاء الاصطناعي وإجراءات الضبط كمورد متخصص لمساعدة المؤسسات على إدارة المخاطر المرتبطة بالذكاء الاصطناعي. فهو يُقر بأنه على الرغم من الإمكانيات الكبيرة للذكاء الاصطناعي، إلا أن تعقيداته واعتباراته الأخلاقية تتطلب نهجًا مركزًا في إدارة المخاطر. يوفر الدليل إطارًا منظمًا لمعالجة هذه التحديات بطريقة مسؤولة وفعالة.

لا يهدف الدليل إلى استبدال الأنظمة الحالية، بل تم تصميمه ليكمل عمليات إدارة المخاطر القائمة. هدفه الرئيسي هو دمج الاعتبارات الخاصة بالذكاء الاصطناعي في هياكل الحوكمة للمؤسسة، مما يضمن التوافق السلس مع الممارسات التشغيلية الجارية. يسمح هذا النهج للمؤسسات بتعزيز قدراتها في إدارة المخاطر دون الحاجة إلى إعادة تصميم أطر عملها بالكامل.

يعتمد الدليل على إطار الذكاء الاصطناعي الموثوق من KPMG، والذي يروج لنهج قائم على القيم ومتمركز حول الإنسان تجاه الذكاء الاصطناعي. يدمج الدليل مبادئ من معايير معترف بها على نطاق واسع، بما في ذلك ISO 42001، وإطار إدارة مخاطر الذكاء الاصطناعي من NIST، وقانون الذكاء الاصطناعي الأوروبي. هذا يضمن أن الدليل عملي ومتوافق مع أفضل الممارسات والمتطلبات التنظيمية المعترف بها عالميًا لحوكمة الذكاء الاصطناعي.

يوفر الدليل رؤى قابلة للتنفيذ وأمثلة عملية مصممة لمواجهة المخاطر المتعلقة بالذكاء الاصطناعي. ويشجع المؤسسات على تكييف هذه الأمثلة وفقًا لظروفها الخاصة، مع مراعاة متغيرات مثل ما إذا كانت أنظمة الذكاء الاصطناعي مطورة داخليًا أو من قبل موردين، بالإضافة إلى أنواع البيانات والتقنيات المستخدمة. تضمن هذه القدرة على التكيف بقاء الدليل ذا صلة بمختلف الصناعات وتطبيقات الذكاء الاصطناعي.

يركز الدليل على تمكين المؤسسات من نشر تقنيات الذكاء الاصطناعي بطريقة آمنة وأخلاقية وشفافة. من خلال معالجة الجوانب التقنية والتشغيلية والأخلاقية لمخاطر الذكاء الاصطناعي، يساعد الدليل المؤسسات على بناء الثقة بين أصحاب المصلحة مع الاستفادة من القدرات التحويلية للذكاء الاصطناعي.

يعمل الدليل كمورد لضمان توافق أنظمة الذكاء الاصطناعي مع أهداف الأعمال مع التخفيف من المخاطر المحتملة. فهو يدعم الابتكار بطريقة تعطي الأولوية للمساءلة والمسؤولية.

تم تصميم دليل حوكمة الذكاء الاصطناعي من KPMG للمهنيين المسؤولين عن إدارة تنفيذ الذكاء الاصطناعي وضمان نشره بشكل آمن وأخلاقي وفعال. ينطبق الدليل على الفرق في مختلف المجالات داخل المؤسسات، بما في ذلك:

سيجد الرؤساء التنفيذيون وكبار القادة مثل CEOs وCIOs وCTOs هذا الدليل مفيدًا في إدارة الذكاء الاصطناعي كأولوية استراتيجية. وفقًا لتوقعات KPMG للرؤساء التنفيذيين في الولايات المتحدة لعام 2024، يعتبر 68٪ من الرؤساء التنفيذيين الذكاء الاصطناعي مجال استثمار رئيسي. يمكّنهم هذا الدليل من مواءمة استراتيجيات الذكاء الاصطناعي مع أهداف المؤسسة مع معالجة المخاطر المصاحبة.

يمكن لمهندسي البرمجيات وعلماء البيانات وغيرهم ممن يتولون إنشاء ونشر حلول الذكاء الاصطناعي استخدام الدليل لدمج المبادئ الأخلاقية وإجراءات الضبط القوية مباشرة في أنظمتهم. يركز الدليل على تكييف ممارسات إدارة المخاطر مع بنية الذكاء الاصطناعي وتدفقات البيانات الخاصة به.

الدليل قابل للتكيف مع الشركات التي تطور أنظمة الذكاء الاصطناعي داخليًا أو تستوردها من موردين أو تستخدم مجموعات بيانات خاصة. وهو ذو صلة خاصة بالصناعات مثل المالية والرعاية الصحية والتكنولوجيا، حيث تعتبر تطبيقات الذكاء الاصطناعي المتقدمة والبيانات الحساسة ضرورية للعمليات.

يمكن أن يؤدي نشر الذكاء الاصطناعي دون إطار حوكمة واضح إلى مخاطر مالية وتنظيمية وسمعة. يعمل دليل KPMG مع العمليات القائمة لتوفير منهج منظم وأخلاقي لإدارة الذكاء الاصطناعي. فهو يعزز المساءلة والشفافية والممارسات الأخلاقية، مما يساعد المؤسسات على استخدام الذكاء الاصطناعي بمسؤولية مع تحقيق أقصى استفادة منه.

يجب أن تبدأ المؤسسات بربط المخاطر الخاصة بالذكاء الاصطناعي مع تصنيف المخاطر الحالي لديها. تصنيف المخاطر هو إطار منظم يُستخدم لتحديد وتنظيم ومعالجة نقاط الضعف المحتملة. نظرًا لأن الذكاء الاصطناعي يقدم تحديات فريدة، يجب توسيع التصنيفات التقليدية لتشمل عوامل خاصة بالذكاء الاصطناعي. قد تتعلق هذه العوامل بدقة تدفق البيانات، ومنطق الخوارزميات، وموثوقية مصادر البيانات. من خلال القيام بذلك، تصبح مخاطر الذكاء الاصطناعي جزءًا من جهود إدارة المخاطر الأوسع للمؤسسة بدلاً من معالجتها بشكل منفصل.

يشير الدليل إلى ضرورة تقييم دورة الحياة الكاملة لأنظمة الذكاء الاصطناعي. تشمل المناطق المهمة التي يجب فحصها مصدر البيانات، وكيفية انتقالها عبر العمليات، والمنطق الأساسي لنموذج الذكاء الاصطناعي. يساعد هذا المنظور الشامل في تحديد أماكن حدوث نقاط الضعف أثناء تطوير واستخدام الذكاء الاصطناعي.

تختلف أنظمة الذكاء الاصطناعي وفقًا لغرضها وطرق تطويرها ونوع البيانات التي تستخدمها. سواء تم إنشاء النموذج داخليًا أو الحصول عليه من مزود خارجي يؤثر كثيرًا على المخاطر المعنية. وبالمثل، يتطلب نوع البيانات — سواء كانت بيانات خاصة أو عامة أو حساسة — إلى جانب تقنيات بناء الذكاء الاصطناعي، استراتيجيات مخصصة لإدارة المخاطر.

يقترح الدليل تكييف إجراءات الضبط لتتناسب مع الاحتياجات الخاصة بأنظمة الذكاء الاصطناعي لديك. على سبيل المثال، إذا كنت تعتمد على بيانات خاصة، فقد تحتاج إلى ضوابط وصول أكثر صرامة. من ناحية أخرى، قد يتطلب استخدام نظام ذكاء اصطناعي من مورد إجراء تقييمات معمقة للمخاطر الخارجية. من خلال تخصيص هذه الإجراءات، يمكنك معالجة التحديات المحددة لأنظمة الذكاء الاصطناعي لديك بشكل أكثر فعالية.

يوصي الدليل بإدراج ممارسات إدارة المخاطر في كل مرحلة من مراحل دورة حياة الذكاء الاصطناعي. يشمل ذلك التخطيط للمخاطر أثناء مرحلة التصميم، وإنشاء أنظمة مراقبة قوية أثناء النشر، وتحديث تقييمات المخاطر بانتظام مع تطور النظام. من خلال معالجة المخاطر في كل خطوة، يمكنك تقليل نقاط الضعف وضمان أن أنظمة الذكاء الاصطناعي لديك أخلاقية وموثوقة.

يساعد اتخاذ الخطوة الأولية في مواءمة مخاطر الذكاء الاصطناعي مع تصنيف المخاطر الحالي وتخصيص إجراءات الضبط وفقًا لاحتياجاتك على بناء قاعدة قوية للذكاء الاصطناعي الموثوق. تمكّن هذه الجهود المؤسسات من تحديد وتقييم وإدارة المخاطر بشكل منهجي، وبناء إطار قوي لحوكمة الذكاء الاصطناعي.

يعتمد إطار الذكاء الاصطناعي الموثوق من KPMG على عشرة أعمدة رئيسية تعالج التحديات الأخلاقية والتقنية والتشغيلية للذكاء الاصطناعي. توجه هذه الأعمدة المؤسسات في تصميم وتطوير ونشر أنظمة الذكاء الاصطناعي بشكل مسؤول، مما يضمن الثقة والمساءلة خلال دورة حياة الذكاء الاصطناعي.

يجب أن تكون الرقابة البشرية والمسؤولية جزءًا من كل مرحلة من دورة حياة الذكاء الاصطناعي. ويشمل ذلك تحديد من هو المسؤول عن إدارة مخاطر الذكاء الاصطناعي، وضمان الامتثال للقوانين واللوائح، والحفاظ على القدرة على التدخل أو تجاوز أو عكس قرارات الذكاء الاصطناعي عند الحاجة.

يجب أن تهدف أنظمة الذكاء الاصطناعي إلى تقليل أو إزالة التحيز الذي قد يؤثر سلبًا على الأفراد أو المجتمعات أو المجموعات. ويتطلب ذلك فحص البيانات بعناية لضمان تمثيلها لمجموعات سكانية متنوعة، وتطبيق مقاييس العدالة أثناء التطوير، ومراقبة النتائج باستمرار لتعزيز المعاملة العادلة.

تتطلب الشفافية مشاركة كيفية عمل أنظمة الذكاء الاصطناعي وسبب اتخاذها لقرارات معينة بشكل علني. يشمل ذلك توثيق حدود النظام، ونتائج الأداء، وطرق الاختبار. يجب إخطار المستخدمين عند جمع بياناتهم، كما يجب تصنيف المحتوى الذي ينتجه الذكاء الاصطناعي بوضوح، ويجب على التطبيقات الحساسة مثل التصنيف البيومتري توفير إشعارات واضحة للمستخدمين.

يجب أن توفر أنظمة الذكاء الاصطناعي أسبابًا مفهومة لقراراتها. لتحقيق ذلك، يجب على المؤسسات توثيق مجموعات البيانات والخوارزميات ومقاييس الأداء بالتفصيل، مما يمكّن أصحاب المصلحة من تحليل النتائج وإعادة إنتاجها بشكل فعال.

تعد جودة وموثوقية البيانات طوال دورة حياتها — من الجمع والتصنيف والتخزين والتحليل — أمرًا أساسيًا. يجب أن تكون هناك إجراءات ضبط لمعالجة مخاطر مثل تلف البيانات أو التحيز. يساهم فحص جودة البيانات بانتظام وإجراء اختبارات الانحدار أثناء تحديث الأنظمة في الحفاظ على دقة وموثوقية أنظمة الذكاء الاصطناعي.

يجب أن تلتزم حلول الذكاء الاصطناعي بقوانين الخصوصية وحماية البيانات. يحتاج المؤسسات إلى التعامل مع طلبات أصحاب البيانات بشكل مناسب، وإجراء تقييمات تأثير الخصوصية، واستخدام أساليب متقدمة مثل الخصوصية التفاضلية لتحقيق توازن بين استخدام البيانات وحماية خصوصية الأفراد.

يجب أن تؤدي أنظمة الذكاء الاصطناعي وظائفها باستمرار وفقًا للغرض المقصود والدقة المطلوبة. ويتطلب ذلك اختبارًا شاملاً، وآليات لاكتشاف الحالات الشاذة، وحلقات تغذية راجعة مستمرة للتحقق من صحة مخرجات النظام.

تحمي تدابير السلامة أنظمة الذكاء الاصطناعي من التسبب في ضرر للأفراد أو الشركات أو الممتلكات. وتشمل هذه التدابير تصميم آليات فشل آمنة، ومراقبة المشكلات مثل تسميم البيانات أو هجمات الحقن، وضمان توافق الأنظمة مع المعايير الأخلاقية والتشغيلية.

تعد ممارسات الأمان القوية ضرورية لحماية أنظمة الذكاء الاصطناعي من التهديدات والأنشطة الضارة. يجب على المؤسسات إجراء عمليات تدقيق منتظمة، وتنفيذ تقييمات الثغرات، واستخدام التشفير لحماية البيانات الحساسة.

يجب تصميم أنظمة الذكاء الاصطناعي لتقليل استهلاك الطاقة ودعم الأهداف البيئية. يجب تضمين اعتبارات الاستدامة منذ بداية عملية التصميم، مع مراقبة مستمرة لاستهلاك الطاقة والكفاءة والانبعاثات خلال دورة حياة الذكاء الاصطناعي.

من خلال اتباع هذه الأعمدة العشرة، يمكن للمؤسسات إنشاء أنظمة ذكاء اصطناعي أخلاقية وجديرة بالثقة ومتوافقة مع توقعات المجتمع. يوفر هذا الإطار هيكلًا واضحًا لإدارة تحديات الذكاء الاصطناعي مع تعزيز الابتكار المسؤول.

تعد نزاهة البيانات أمرًا بالغ الأهمية لضمان بقاء أنظمة الذكاء الاصطناعي دقيقة وعادلة وموثوقة. يمكن أن تؤدي إدارة البيانات غير الجيدة إلى مخاطر مثل التحيز وعدم الدقة والنتائج غير الموثوقة. قد تضعف هذه المشكلات الثقة في مخرجات الذكاء الاصطناعي وتتسبب في مشاكل تشغيلية وسمعة كبيرة. يؤكد إطار الذكاء الاصطناعي الموثوق من KPMG على ضرورة الحفاظ على جودة عالية للبيانات طوال دورة حياتها لضمان عمل أنظمة الذكاء الاصطناعي بفعالية وتحقيق المعايير الأخلاقية.

بدون حوكمة بيانات قوية، قد تنتج أنظمة الذكاء الاصطناعي نتائج معيبة. يمكن أن تؤدي مشكلات مثل البيانات غير المكتملة أو غير الدقيقة أو غير ذات الصلة إلى مخرجات متحيزة أو غير موثوقة، مما يزيد المخاطر عبر تطبيقات الذكاء الاصطناعي المختلفة.

تنتقل البيانات غالبًا بين الأنظمة لأغراض مثل التدريب أو الاختبار أو التشغيل. إذا لم تتم معالجة هذه النقلات بشكل صحيح، فقد تتلف البيانات أو تُفقد أو تتدهور، مما يؤثر على أداء أنظمة الذكاء الاصطناعي.

لتحسين حوكمة البيانات، يمكن للمؤسسات:

لتقليل المخاطر أثناء نقل البيانات، يجب على المؤسسات:

تساعد أنظمة المراقبة المستمرة في الحفاظ على نزاهة البيانات طوال دورة حياة الذكاء الاصطناعي. يمكن لهذه الأنظمة اكتشاف المشكلات مثل التغيرات غير المتوقعة في جودة البيانات أو عدم الاتساق في معالجتها، مما يسمح باتخاذ إجراءات تصحيحية سريعة عند ظهور المشاكل.

الحفاظ على نزاهة البيانات أمر أساسي لنشر أنظمة ذكاء اصطناعي جديرة بالثقة. يمكن للمؤسسات تقليل المخاطر من خلال تأسيس أطر حوكمة قوية، وحماية تفاعلات البيانات، والحفاظ على عمليات تحقق مستمرة. تعزز هذه الإجراءات موثوقية مخرجات الذكاء الاصطناعي مع ضمان تحقيق المعايير الأخلاقية والتشغيلية، مما يساعد على بناء الثقة في تقنيات الذكاء الاصطناعي.

إدارة الطلبات المتعلقة بحق وصول أصحاب البيانات تمثل تحديًا رئيسيًا في الخصوصية عند استخدام الذكاء الاصطناعي. يجب على المؤسسات التأكد من أن الأفراد يمكنهم ممارسة حقوقهم في الوصول إلى معلوماتهم الشخصية أو تصحيحها أو حذفها بموجب قوانين مثل GDPR وCCPA. إذا لم تتم معالجة هذه الطلبات بشكل صحيح، فقد يؤدي ذلك إلى انتهاكات تنظيمية وفقدان الثقة لدى العملاء والإضرار بسمعة المؤسسة.

لتقليل هذا الخطر، يجب على الشركات إنشاء برامج لتثقيف الأفراد حول حقوقهم المتعلقة بالبيانات عند التفاعل مع الذكاء الاصطناعي. يجب إعداد أنظمة لمعالجة هذه الطلبات بسرعة وشفافية، كما يجب على المؤسسات الاحتفاظ بسجلات مفصلة حول كيفية التعامل مع هذه الطلبات لإثبات الامتثال أثناء التدقيق.

تتعامل أنظمة الذكاء الاصطناعي غالبًا مع معلومات شخصية حساسة، مما يجعلها أهدافًا جذابة للهجمات الإلكترونية. إذا حدث اختراق، فقد يؤدي ذلك إلى غرامات تنظيمية كبيرة وإضرار بسمعة الشركة وفقدان ثقة العملاء.

لمواجهة ذلك، يقترح إطار الذكاء الاصطناعي الموثوق من KPMG إجراء مراجعات أخلاقية للأنظمة التي تستخدم البيانات الشخصية لضمان امتثالها للوائح الخصوصية. كما أن عمليات التدقيق المنتظمة لحماية البيانات وتقييمات تأثير الخصوصية (PIA) ضرورية، خاصة عند استخدام بيانات حساسة لتدريب النماذج. بالإضافة إلى ذلك، يمكن أن تساعد تقنيات مثل الخصوصية التفاضلية، والتي تضيف ضجيجًا إحصائيًا إلى البيانات، في إخفاء هوية المعلومات مع السماح بالتحليل.

يمكن أن تتسبب أنظمة الذكاء الاصطناعي التي لا تتضمن تدابير خصوصية منذ البداية في مشاكل خطيرة. بدون تطبيق مبدأ الخصوصية من التصميم، تخاطر المؤسسات بكشف بيانات حساسة أو عدم الامتثال للمتطلبات القانونية.

يجب على الشركات تضمين تدابير الخصوصية أثناء مراحل تطوير أنظمة الذكاء الاصطناعي. يشمل ذلك الالتزام بقوانين الخصوصية وحماية البيانات من خلال ممارسات إدارة بيانات قوية. التوثيق الواضح لكيفية جمع البيانات واستخدامها وتخزينها أمر بالغ الأهمية. كما يجب الحصول على موافقة صريحة من المستخدمين لجمع ومعالجة البيانات، خاصة في المجالات الحساسة مثل البيانات البيومترية.

عندما لا تشرح أنظمة الذكاء الاصطناعي بوضوح كيفية التعامل مع بيانات المستخدمين، فقد يؤدي ذلك إلى عدم ثقة ومساءلة قانونية. يجب أن يعرف المستخدمون عند جمع بياناتهم وكيفية استخدامها

دليل KPMG لمخاطر الذكاء الاصطناعي وإجراءات الضبط هو إطار عملي صُمم لمساعدة المؤسسات على إدارة المخاطر الفريدة للذكاء الاصطناعي، وضمان النشر المسؤول والأخلاقي والمتوافق للذكاء الاصطناعي عبر الصناعات.

يعتمد الدليل على عشرة أعمدة أساسية: المساءلة، العدالة، الشفافية، التوضيح، نزاهة البيانات، الموثوقية، الأمان، السلامة، الخصوصية، والاستدامة — كل منها يعالج جانبًا حاسمًا في إدارة مخاطر الذكاء الاصطناعي.

الدليل موجه لمتخصصي المخاطر، فرق الامتثال، المتخصصين في الأمن السيبراني، المستشارين القانونيين، التنفيذيين، مطوري الذكاء الاصطناعي، المهندسين، والمؤسسات من جميع الأحجام التي تسعى لإدارة الذكاء الاصطناعي بمسؤولية.

يتماشى مع المعايير العالمية مثل ISO 42001، وإطار إدارة مخاطر الذكاء الاصطناعي من NIST، وقانون الذكاء الاصطناعي الأوروبي، مما يساعد المؤسسات على دمج إجراءات ضبط خاصة بالذكاء الاصطناعي ضمن عمليات الحوكمة القائمة وتلبية متطلبات التشريعات.

يقترح إجراءات مثل حوكمة البيانات القوية، الخصوصية من التصميم، المراقبة المستمرة، الشفافية في قرارات الذكاء الاصطناعي، اكتشاف الحالات الشاذة، حلقات التغذية الراجعة، وأهداف الاستدامة لتقليل المخاطر المرتبطة بالذكاء الاصطناعي.

اكتشف كيف يمكن أن يساعدك دليل KPMG لمخاطر الذكاء الاصطناعي وإجراءات الضبط في تبني الابتكار في الذكاء الاصطناعي مع ضمان النشر الأخلاقي والآمن والمتوافق.

دليل عملي لقادة الأعمال حول تطبيق أطر العمل البشري في الحلقة (HITL) من أجل حوكمة الذكاء الاصطناعي المسؤول، وتقليل المخاطر، والامتثال، وبناء الثقة في أنظمة الذكا...

عمليات اعتماد الذكاء الاصطناعي هي تقييمات شاملة وصادقة تهدف إلى التأكد من أن أنظمة الذكاء الاصطناعي تفي بالمعايير والتنظيمات المحددة مسبقًا. تعمل هذه الشهادات ك...

الأطر التنظيمية للذكاء الاصطناعي هي إرشادات منظمة وتدابير قانونية تهدف إلى تنظيم تطوير ونشر واستخدام تقنيات الذكاء الاصطناعي. تهدف هذه الأطر إلى ضمان عمل أنظمة ...