أوبن سي في (OpenCV)

أوبن سي في هو مكتبة متقدمة ومفتوحة المصدر للرؤية الحاسوبية وتعلم الآلة، تقدم أكثر من 2500 خوارزمية لمعالجة الصور، واكتشاف الأجسام، والتطبيقات اللحظية عبر لغات و...

وان 2.1 هو نموذج قوي مفتوح المصدر لتوليد الفيديو بالذكاء الاصطناعي من علي بابا، يقدم فيديوهات بجودة الاستوديو من النصوص أو الصور، ومتاح مجانًا للجميع للاستخدام المحلي.

وان 2.1 (ويُسمى أيضًا WanX 2.1) يفتح آفاقًا جديدة كنموذج مفتوح المصدر بالكامل لتوليد الفيديو بالذكاء الاصطناعي طورته مختبرات تونغي التابعة لعلي بابا. على عكس العديد من أنظمة توليد الفيديو المغلقة التي تتطلب اشتراكات باهظة أو وصولًا عبر واجهات برمجة التطبيقات، يقدم وان 2.1 جودة مماثلة أو متفوقة مع بقائه مجانيًا بالكامل ومتاحًا للمطورين والباحثين والمحترفين المبدعين.

ما يجعل وان 2.1 مميزًا حقًا هو الجمع بين سهولة الوصول والأداء العالي. الإصدار الأصغر T2V-1.3B يتطلب فقط حوالي 8.2 جيجابايت من ذاكرة GPU، ما يجعله متوافقًا مع معظم وحدات معالجة الرسومات الاستهلاكية الحديثة. في حين يقدم الإصدار الأكبر ذو 14 مليار معلمة أداءً متقدمًا يتفوق على بدائل مفتوحة المصدر وكثير من النماذج التجارية في المقاييس القياسية.

لا يقتصر وان 2.1 على تحويل النص إلى فيديو فقط. بنيته المرنة تدعم:

هذا التنوع يعني أنه يمكنك البدء بتعليمات نصية، أو صورة ثابتة، أو حتى فيديو موجود وتحويله بناءً على رؤيتك الإبداعية.

باعتباره أول نموذج فيديو قادر على كتابة نصوص إنجليزية وصينية قابلة للقراءة ضمن الفيديوهات المولدة، يفتح وان 2.1 آفاقًا جديدة لصناع المحتوى الدوليين. هذه الميزة ذات قيمة خاصة لإضافة ترجمات أو نصوص مشهدية في فيديوهات متعددة اللغات.

في قلب كفاءة وان 2.1 يوجد Wan-VAE السببي ثلاثي الأبعاد. هذا الابتكار التقني يضغط المعلومات المكانية والزمنية بكفاءة، مما يسمح للنموذج بـ:

النموذج الأصغر (1.3B) يتطلب فقط 8.19 جيجابايت من VRAM ويمكنه إنتاج فيديو مدته 5 ثوانٍ بدقة 480p في حوالي 4 دقائق على RTX 4090. وعلى الرغم من هذه الكفاءة، فإن جودته تضاهي أو تتفوق على نماذج أكبر بكثير، ما يجعله مثاليًا من حيث السرعة ودقة الصورة.

في التقييمات العامة، حقق نموذج وان 14B أعلى نتيجة إجمالية في اختبارات Wan-Bench، متفوقًا على المنافسين في:

على عكس الأنظمة مغلقة المصدر مثل Sora من OpenAI أو Gen-2 من Runway، فإن وان 2.1 متاح مجانًا للتشغيل محليًا. غالبًا ما يتفوق على النماذج مفتوحة المصدر السابقة (مثل CogVideo، MAKE-A-VIDEO، وPika) وحتى العديد من الحلول التجارية في معايير الجودة.

ذكرت دراسة صناعية حديثة أن “من بين العديد من نماذج الفيديو بالذكاء الاصطناعي، يبرز وان 2.1 وSora” – يتميز وان 2.1 بانفتاحه وكفاءته، بينما تتميز Sora بابتكاراتها الملكية. وفي اختبارات المجتمع، أفاد المستخدمون بأن ميزة تحويل الصورة إلى فيديو في وان 2.1 تتفوق على المنافسين من حيث الوضوح والإحساس السينمائي.

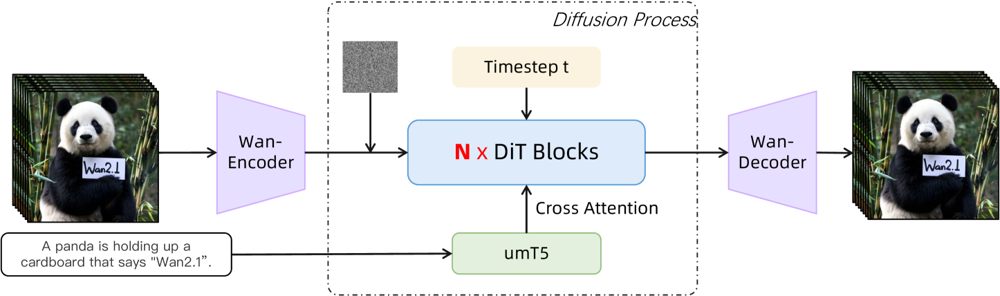

يعتمد وان 2.1 على بنية تحويلية-انتشارية مع Wan-VAE مكاني-زماني مبتكر. كيف يعمل ذلك:

الشكل: البنية عالية المستوى لـ وان 2.1 (حالة تحويل النص إلى فيديو). يُشفَّر الفيديو (أو الصورة) أولاً بواسطة مشفر Wan-VAE إلى تمثيل كامن. يُمرر هذا الكامن عبر N من كتل المحول الانتشاري، والتي تولي اهتمامًا لتضمين النص (من umT5) عبر Cross-Attention. في النهاية، يعيد فك تشفير Wan-VAE بناء إطارات الفيديو. هذا التصميم – الذي يتميز بـ"مشفر/فك مشفر VAE سببي ثلاثي الأبعاد يحيط بمحور انتشاري" (ar5iv.org) – يسمح بضغط فعال للبيانات المكانية-الزمانية ويدعم إخراج فيديو عالي الجودة.

تسمح هذه البنية المبتكرة — التي تتميز بـ"مشفر/فك مشفر VAE سببي ثلاثي الأبعاد يحيط بمحور انتشاري" — بضغط فعال للبيانات المكانية-الزمانية ودعم إخراج فيديو عالي الجودة.

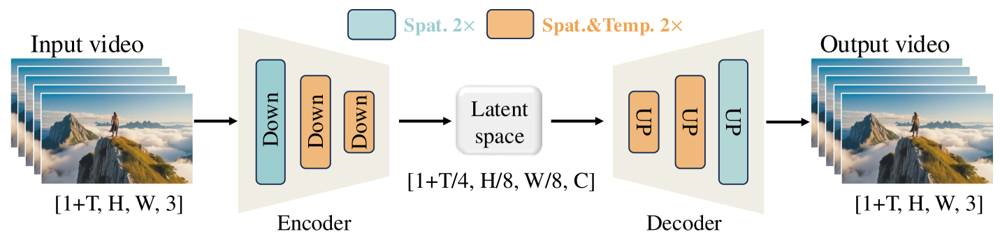

تم تصميم Wan-VAE خصيصًا للفيديوهات، حيث يضغط الإدخال بعوامل مذهلة (4× زمنيًا و8× مكانيًا) إلى كامن صغير قبل فك تشفيره إلى فيديو كامل. استخدام التلافيف ثلاثية الأبعاد والطبقات السببية (المحافظة على التسلسل الزمني) يضمن حركة متسقة في المحتوى الناتج.

الشكل: إطار عمل Wan-VAE في وان 2.1 (ترميز-فك ترميز). يقوم مشفر Wan-VAE (يسار) بتطبيق سلسلة من الطبقات الهابطة (“Down”) على فيديو الإدخال (بنية الإطارات [1+T, H, W, 3]) حتى يصل إلى كامن مضغوط ([1+T/4, H/8, W/8, C]). أما فك التشفير Wan-VAE (يمين) فيعيد رفع هذا الكامن بشكل متماثل (“UP”) إلى الإطارات الأصلية للفيديو. الكتل الزرقاء تشير إلى الضغط المكاني، والكتل البرتقالية تشير إلى الضغط المكاني+الزمني معًا (ar5iv.org). من خلال ضغط الفيديو بمقدار 256× (في الحجم المكاني الزمني)، يجعل Wan-VAE نمذجة الفيديو عالي الدقة ممكنة للنموذج الانتشاري اللاحق.

هل أنت مستعد لتجربة وان 2.1 بنفسك؟ إليك كيفية البدء:

استنساخ المستودع وتثبيت الاعتماديات:

git clone https://github.com/Wan-Video/Wan2.1.git

cd Wan2.1

pip install -r requirements.txt

تنزيل أوزان النموذج:

pip install "huggingface_hub[cli]"

huggingface-cli login

huggingface-cli download Wan-AI/Wan2.1-T2V-14B --local-dir ./Wan2.1-T2V-14B

توليد أول فيديو لك:

python generate.py --task t2v-14B --size 1280*720 \

--ckpt_dir ./Wan2.1-T2V-14B \

--prompt "A futuristic city skyline at sunset, with flying cars zooming overhead."

--offload_model True --t5_cpu لنقل أجزاء من النموذج إلى وحدة المعالجة المركزية--size (مثال: 832*480 لدقة 16:9 480p)للمرجع، يمكن لـ RTX 4090 توليد فيديو مدته 5 ثوانٍ بدقة 480p في حوالي 4 دقائق. يدعم الاستخدام على نطاق واسع إعدادات تعدد وحدات GPU والعديد من تحسينات الأداء (FSDP، التكميم، إلخ).

بصفته قوة مفتوحة المصدر تتحدى عمالقة مجال توليد الفيديو بالذكاء الاصطناعي، يمثل وان 2.1 تحولًا مهمًا في سهولة الوصول. طبيعته المجانية والمفتوحة تعني أن أي شخص يملك وحدة معالجة رسومات جيدة يمكنه اكتشاف أحدث تقنيات توليد الفيديو دون رسوم اشتراك أو تكاليف واجهات برمجة التطبيقات.

للمطورين، يتيح الترخيص مفتوح المصدر تخصيص وتحسين النموذج. يمكن للباحثين توسيع إمكانياته، بينما يستطيع المبدعون تصميم محتوى فيديو بسرعة وكفاءة.

في عصر تتزايد فيه النماذج الملكية خلف جدران دفع، يبرهن وان 2.1 أن الأداء المتقدم يمكن أن يكون ديمقراطيًا ومتاحًا للمجتمع الأوسع.

وان 2.1 هو نموذج مفتوح المصدر بالكامل لتوليد الفيديو بالذكاء الاصطناعي طورته مختبرات تونغي التابعة لعلي بابا، وقادر على إنشاء فيديوهات عالية الجودة من التعليمات النصية أو الصور أو الفيديوهات الموجودة مسبقًا. مجاني للاستخدام، يدعم مهام متعددة، ويعمل بكفاءة على وحدات معالجة الرسومات الاستهلاكية.

يدعم وان 2.1 توليد الفيديو متعدد المهام (تحويل النص إلى فيديو، تحويل الصورة إلى فيديو، تحرير الفيديو، إلخ)، وكتابة نصوص متعددة اللغات داخل الفيديوهات، وكفاءة عالية بفضل Wan-VAE ثلاثي الأبعاد السببي، ويتفوق على العديد من النماذج التجارية ومفتوحة المصدر في المقاييس.

تحتاج إلى بايثون 3.8 أو أحدث، بايتورتش 2.4.0 أو أحدث مع دعم CUDA، ووحدة معالجة رسومات من NVIDIA (ذاكرة 8GB أو أكثر للنموذج الصغير، و16-24GB للنموذج الكبير). قم باستنساخ المستودع من GitHub، وبتثبيت الاعتماديات، وتنزيل أوزان النموذج، واستخدم السكريبتات المرفقة لتوليد الفيديوهات محليًا.

وان 2.1 يتيح للجميع الوصول إلى أحدث تقنيات توليد الفيديو بفضل كونه مفتوح المصدر ومجاني، ما يسمح للمطورين والباحثين والمبدعين بالتجربة والابتكار دون حواجز مالية أو قيود ملكية.

على عكس البدائل مغلقة المصدر مثل Sora أو Runway Gen-2، فإن وان 2.1 مفتوح المصدر بالكامل ويمكن تشغيله محليًا. يتفوق عمومًا على النماذج مفتوحة المصدر السابقة ويضاهي أو يتفوق على الكثير من الحلول التجارية في معايير الجودة.

أرشيا هو مهندس سير عمل الذكاء الاصطناعي في FlowHunt. بخلفية في علوم الحاسوب وشغف بالذكاء الاصطناعي، يختص في إنشاء سير عمل فعّال يدمج أدوات الذكاء الاصطناعي في المهام اليومية، مما يعزز الإنتاجية والإبداع.

ابدأ ببناء أدوات الذكاء الاصطناعي الخاصة بك وتدفقات عمل توليد الفيديو مع FlowHunt أو احجز عرضًا توضيحيًا لمشاهدة المنصة أثناء العمل.

أوبن سي في هو مكتبة متقدمة ومفتوحة المصدر للرؤية الحاسوبية وتعلم الآلة، تقدم أكثر من 2500 خوارزمية لمعالجة الصور، واكتشاف الأجسام، والتطبيقات اللحظية عبر لغات و...

قم بدمج FlowHunt مع خادم json2video-mcp لأتمتة إنشاء الفيديو برمجياً، إدارة القوالب المخصصة، وربط سير عمل الفيديو بالوكلاء، ونماذج اللغة الكبيرة (LLMs)، وأدوات ...

جيميني فلاش 2.0 يضع معايير جديدة في الذكاء الاصطناعي مع أداء معزز وسرعة وقدرات متعددة الوسائط. اكتشف إمكانياته في التطبيقات الواقعية....