ما هو مكون ميتاإيه إل إل إم؟

يربط مكون LLM Meta AI عائلة نماذج Claude بتدفقك في Flow. بينما يتم تنفيذ العمليات الفعلية في المولدات والوكلاء، تتيح لك مكونات LLM التحكم في النموذج المستخدم. جميع المكونات تأتي افتراضيًا مع ChatGPT-4. يمكنك ربط هذا المكون إذا رغبت في تغيير النموذج أو الحصول على المزيد من التحكم فيه.

تذكر أن ربط مكون LLM اختياري. جميع المكونات التي تستخدم LLM تأتي مع ChatGPT-4o افتراضيًا. تسمح لك مكونات LLM بتغيير النموذج والتحكم في إعداداته.

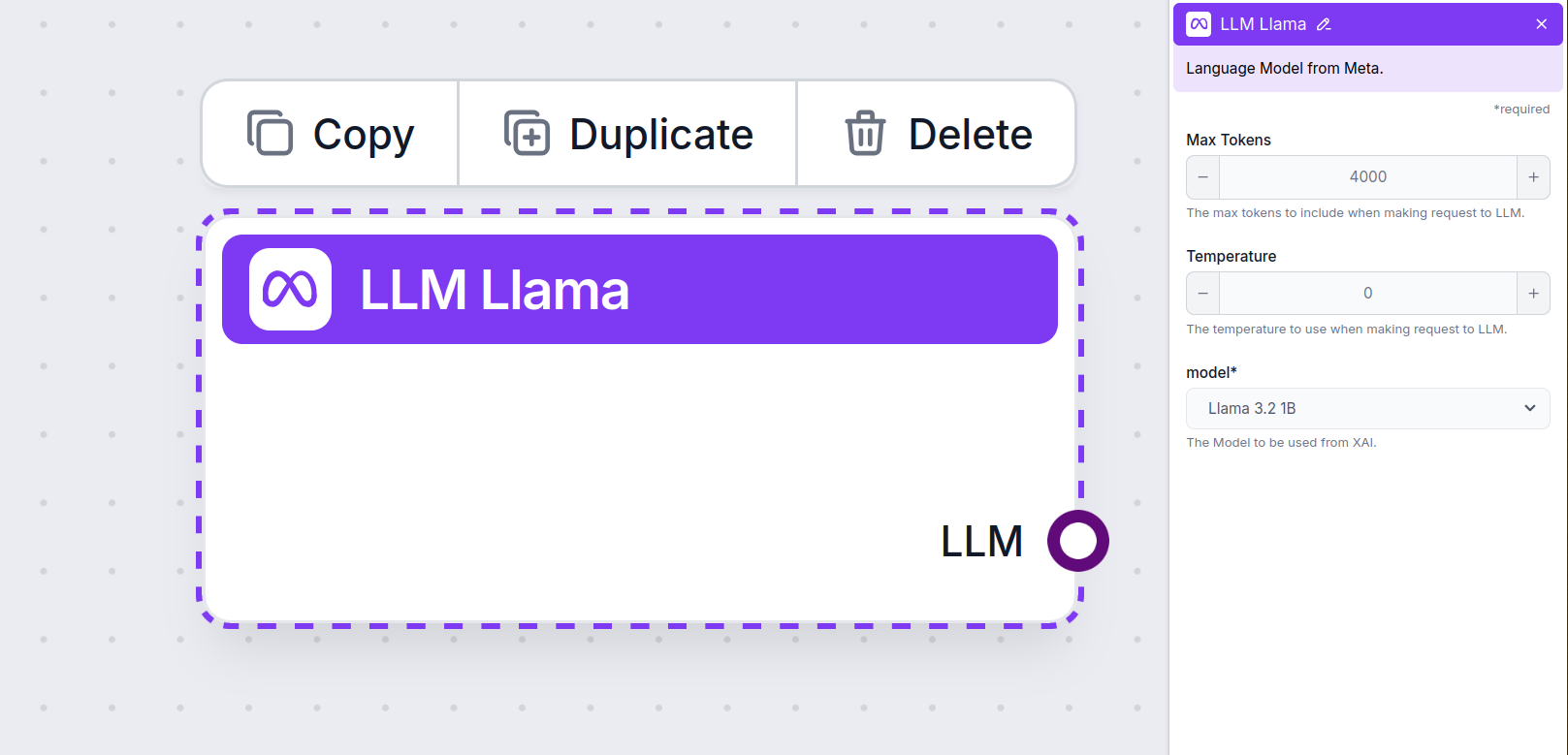

إعدادات مكون LLM Meta AI

الحد الأقصى للرموز (Max Tokens)

الرموز (Tokens) تمثل الوحدات الفردية للنص التي يعالجها ويولدها النموذج. يختلف استخدام الرموز حسب النماذج، ويمكن أن يكون الرمز الواحد كلمة أو جزءًا من كلمة أو حتى حرفًا واحدًا. عادةً ما تُسعّر النماذج بالملايين من الرموز.

يحدد إعداد الحد الأقصى للرموز العدد الإجمالي للرموز التي يمكن معالجتها في تفاعل أو طلب واحد، ما يضمن أن يتم توليد الردود ضمن حدود معقولة. الحد الافتراضي هو 4000 رمز، وهو الحجم الأمثل لتلخيص المستندات والعديد من المصادر لإنتاج إجابة.

درجة الحرارة

تتحكم درجة الحرارة في تنوع الإجابات، وتتراوح من 0 إلى 1.

درجة حرارة 0.1 تجعل الردود مباشرة جدًا ولكنها قد تصبح متكررة وضعيفة.

درجة حرارة عالية بقيمة 1 تسمح بأقصى قدر من الإبداع في الإجابات، لكنها تزيد من خطر وجود إجابات غير ذات صلة أو حتى وهمية.

على سبيل المثال، درجة الحرارة الموصى بها لروبوت خدمة العملاء هي ما بين 0.2 و0.5. هذا المستوى يساعد في إبقاء الإجابات ذات صلة وضمن النص المقرر، مع السماح بتنوع طبيعي في الردود.

النموذج

هذا هو منتقي النماذج. ستجد هنا جميع النماذج المدعومة من Meta AI. نحن ندعم نماذج Llama الخفيفة مفتوحة المصدر من Meta. تم تصميم هذه النماذج لتكون فعالة للاستخدام على الأجهزة والحافة:

- Llama 3.2 1B – يحتوي هذا النموذج على حوالي 1.23 مليار معلمة، مع طول سياق يصل إلى 128,000 رمز. النموذج محسن لمهام مثل التلخيص، وتتبع التعليمات، وإعادة الصياغة، مما يجعله مناسبًا لتطبيقات الأجهزة المحمولة والمضمنة. تعرف على المزيد حول هذا النموذج وطريقة عمله في هذا المقال.

- Llama 3.2. 3B – يحتوي نموذج 3B على حوالي 3.21 مليار معلمة مع طول سياق يصل حتى 128,000 رمز. تعرف على كيفية تعامل هذا النموذج مع المهام المختلفة.

كيفية إضافة ميتاإيه إل إل إم إلى تدفقك

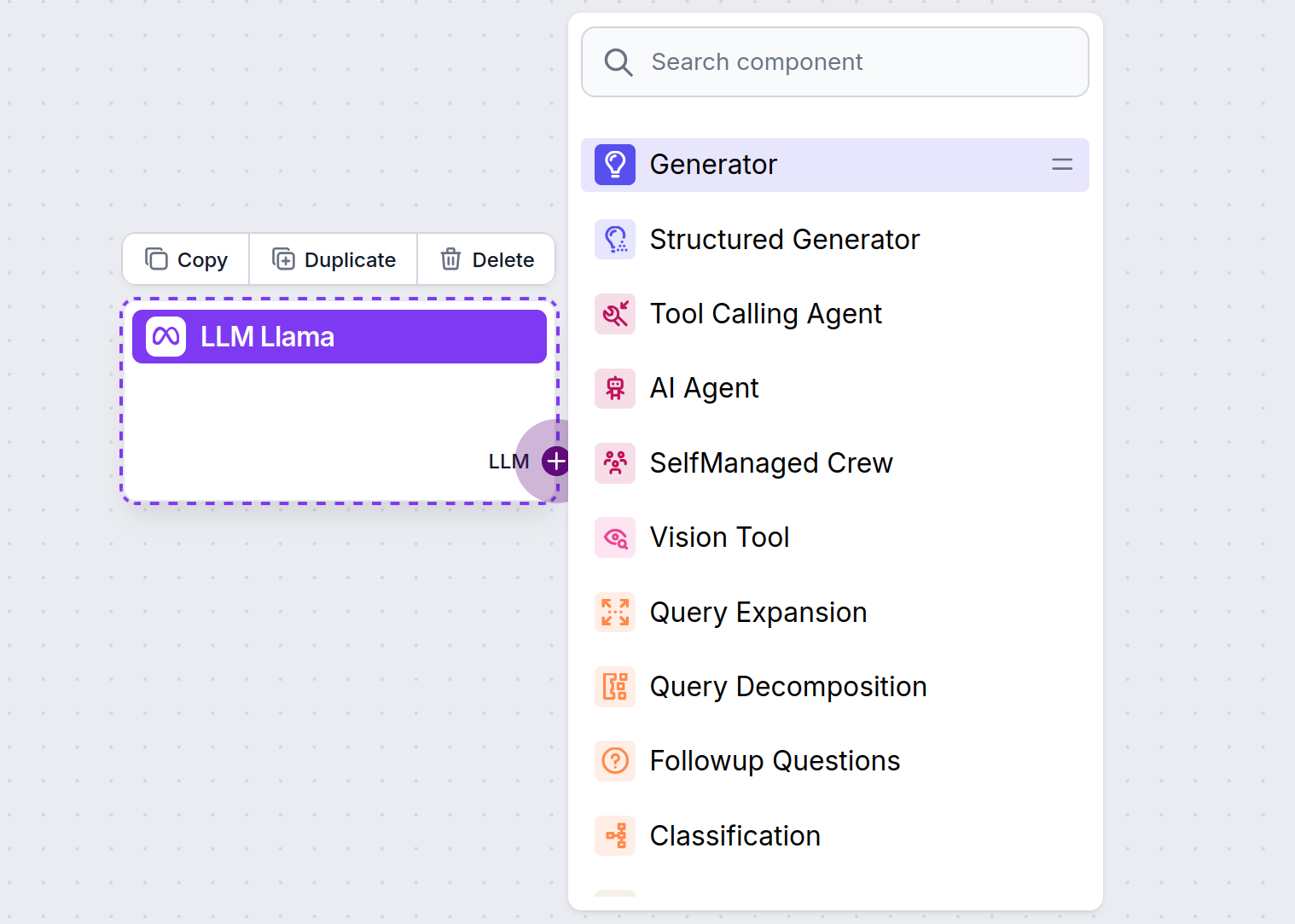

ستلاحظ أن جميع مكونات LLM لديها فقط مقبض إخراج. لا يمر الإدخال عبر المكون، حيث أنه يمثل النموذج فقط، بينما تتم عملية التوليد الفعلي في وكلاء ومولدات الذكاء الاصطناعي.

يكون مقبض LLM دائمًا أرجواني. يوجد مقبض إدخال LLM في أي مكون يستخدم الذكاء الاصطناعي لتوليد النصوص أو معالجة البيانات. يمكنك رؤية الخيارات بالنقر على المقبض:

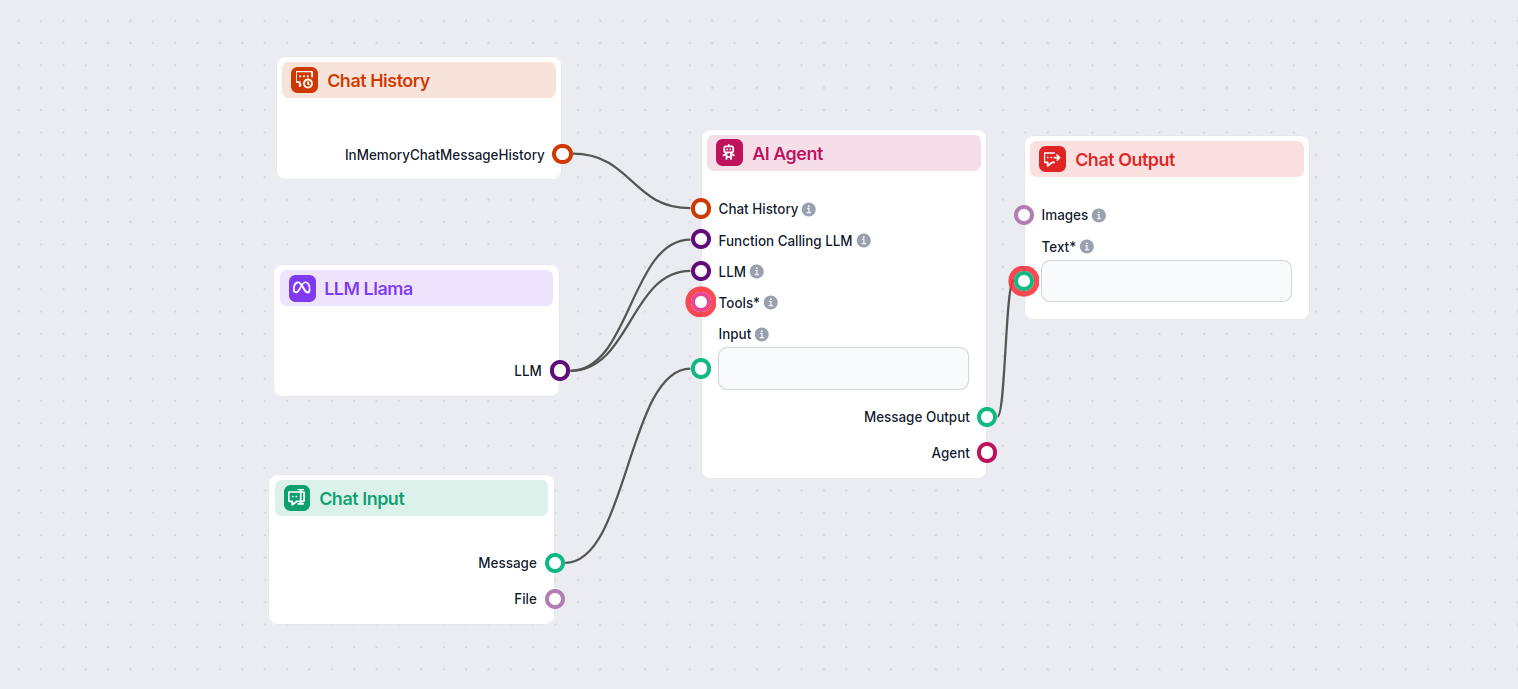

يسمح لك هذا بإنشاء جميع أنواع الأدوات. دعنا نرى المكون أثناء العمل. إليك مثال بسيط على تدفق دردشة بوت وكيل ذكاء اصطناعي يستخدم Llama 3.2 1B من Meta AI لتوليد الردود. يمكنك اعتباره روبوت دردشة Llama أساسي.

يحتوي تدفق الدردشة البسيط هذا على:

- إدخال الدردشة: يمثل الرسالة التي يرسلها المستخدم في الدردشة.

- سجل الدردشة: يضمن أن البوت يمكنه تذكر الردود السابقة وأخذها في الاعتبار.

- إخراج الدردشة: يمثل الرد النهائي للبوت.

- وكيل الذكاء الاصطناعي: وكيل ذكاء اصطناعي مستقل يتولى توليد الردود.

- LLM Meta AI: الاتصال بنماذج توليد النصوص من Meta.