ميتاإيه إل إل إم

يدعم FlowHunt عشرات نماذج توليد النصوص، بما في ذلك نماذج Llama من Meta. تعرف على كيفية دمج Llama في أدوات الذكاء الاصطناعي والدردشات، وتخصيص الإعدادات مثل الحد ...

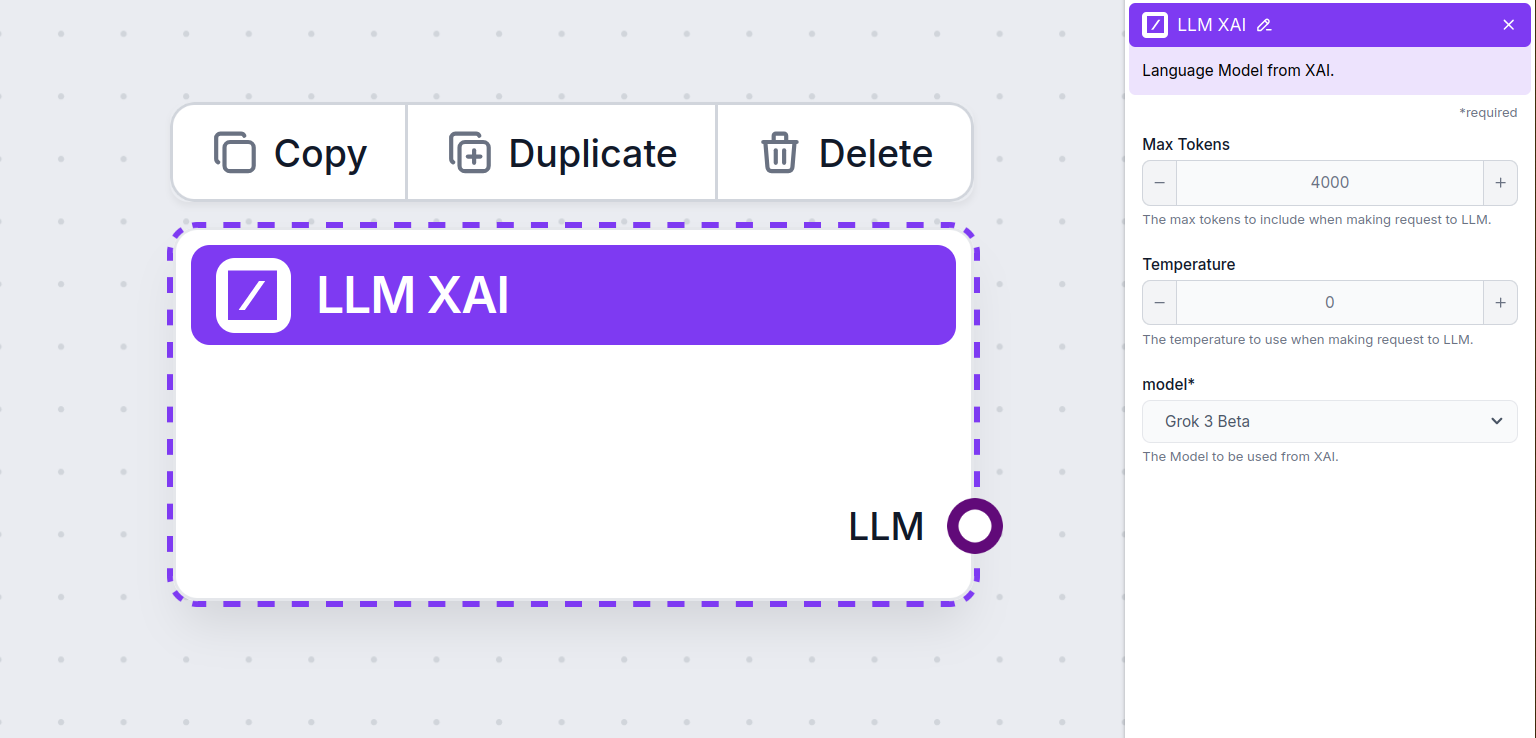

يتيح لك LLM xAI من FlowHunt دمج نماذج توليد النصوص من xAI مثل Grok-beta في الدردشات الذكية وأدوات الذكاء الاصطناعي الخاصة بك، مع إعدادات مرنة لعدد الرموز ودرجة الحرارة واختيار النموذج.

وصف المكون

يقوم مكون LLM xAI بتوصيل نموذج Grok بتدفقك. بينما تحدث المعالجة الفعلية في المولدات والوكلاء الذكيين، تتيح لك مكونات LLM التحكم بالنموذج المستخدم. جميع المكونات تأتي افتراضياً مع ChatGPT-4. يمكنك توصيل هذا المكون إذا أردت تغيير النموذج أو الحصول على تحكم أكبر فيه.

تذكر أن توصيل مكون LLM هو اختياري. جميع المكونات التي تستخدم LLM تأتي مع ChatGPT-4o كإعداد افتراضي. تسمح لك مكونات LLM بتغيير النموذج والتحكم في إعداداته.

الرموز هي الوحدات الفردية من النص التي يعالجها النموذج وينتجها. يختلف استخدام الرموز بين النماذج، ويمكن أن يكون الرمز كلمة أو جزءاً من كلمة أو حتى حرفاً واحداً. غالباً ما يتم تسعير النماذج بملايين الرموز.

يحدد إعداد الحد الأقصى للرموز العدد الكلي للرموز الممكن معالجتها في تفاعل أو طلب واحد، لضمان أن تكون الإجابات ضمن حدود معقولة. الحد الافتراضي هو 4000 رمز، وهو الحجم الأمثل لتلخيص المستندات وعدة مصادر لإنتاج إجابة.

تتحكم درجة الحرارة في تنويع الإجابات، وتتراوح من 0 إلى 1.

درجة حرارة 0.1 ستجعل الإجابات مركزة جداً ولكن قد تكون متكررة أو ناقصة.

درجة حرارة عالية مثل 1 تسمح بأقصى قدر من الإبداع في الإجابات لكنها ترفع خطورة أن تكون الإجابات غير ذات صلة أو حتى متخيلة.

على سبيل المثال، درجة الحرارة الموصى بها لروبوت خدمة العملاء هي بين 0.2 و0.5. هذا المستوى يحافظ على ملاءمة الإجابات للنص مع السماح ببعض التنوع الطبيعي في الردود.

هذا هو محدد النموذج. هنا ستجد جميع النماذج المدعومة من مزود xAI. النموذج النصي الرئيسي لـ xAI يسمى Grok. حالياً، ندعم فقط نموذج grok-beta، لأنه الوحيد المتاح للاستخدام العام عبر واجهة البرمجة.

هل ترغب في معرفة المزيد عن Grok-beta ومقارنته بالنماذج الأخرى؟ اطلع على هذا المقال.

ستلاحظ أن جميع مكونات LLM لديها فقط مقبض إخراج. المدخلات لا تمر عبر المكون، لأنه يمثل النموذج فقط، بينما تتم عملية التوليد الفعلية في الوكلاء الذكيين والمولدات.

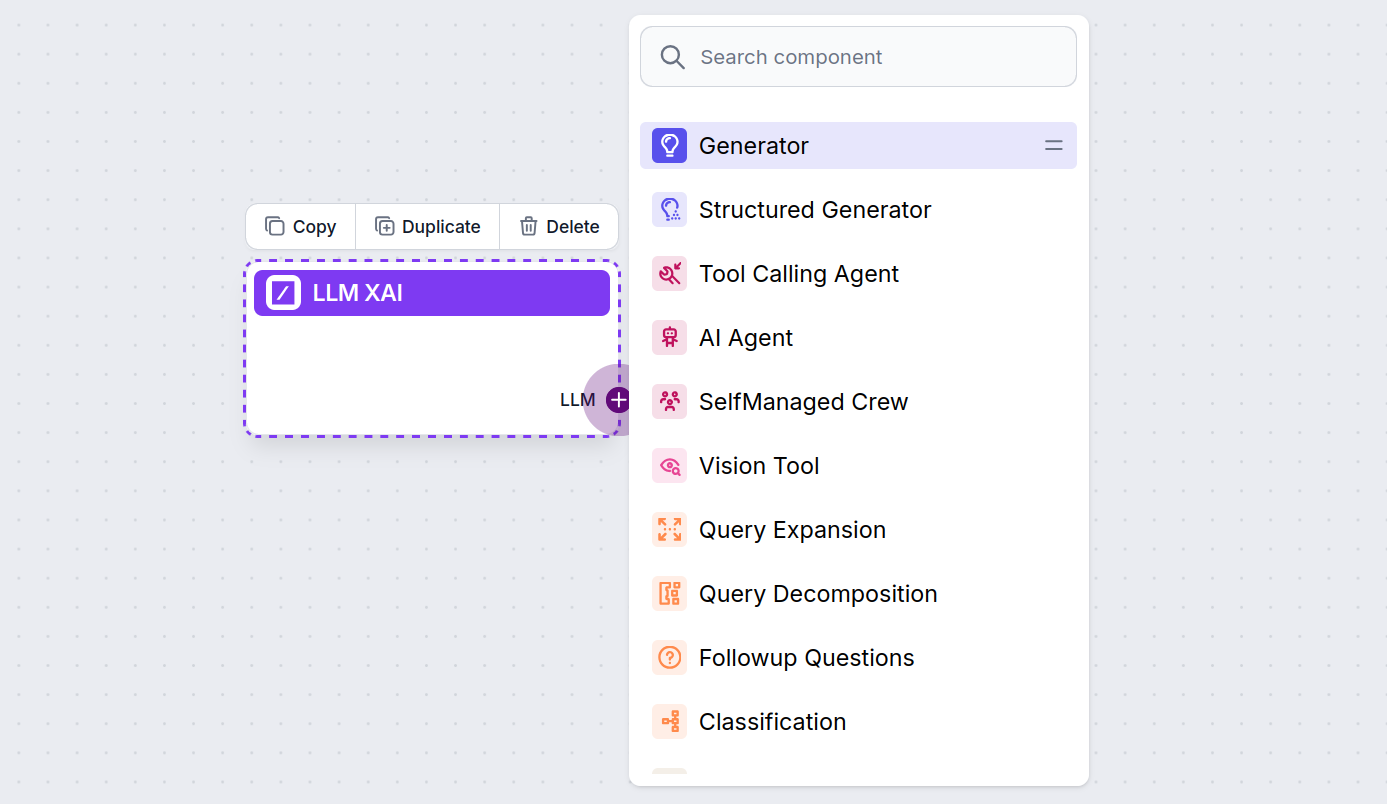

مقبض LLM يكون دائماً أرجواني. مقبض إدخال LLM يوجد في أي مكون يستخدم الذكاء الاصطناعي لتوليد النصوص أو معالجة البيانات. يمكنك رؤية الخيارات بالنقر على المقبض:

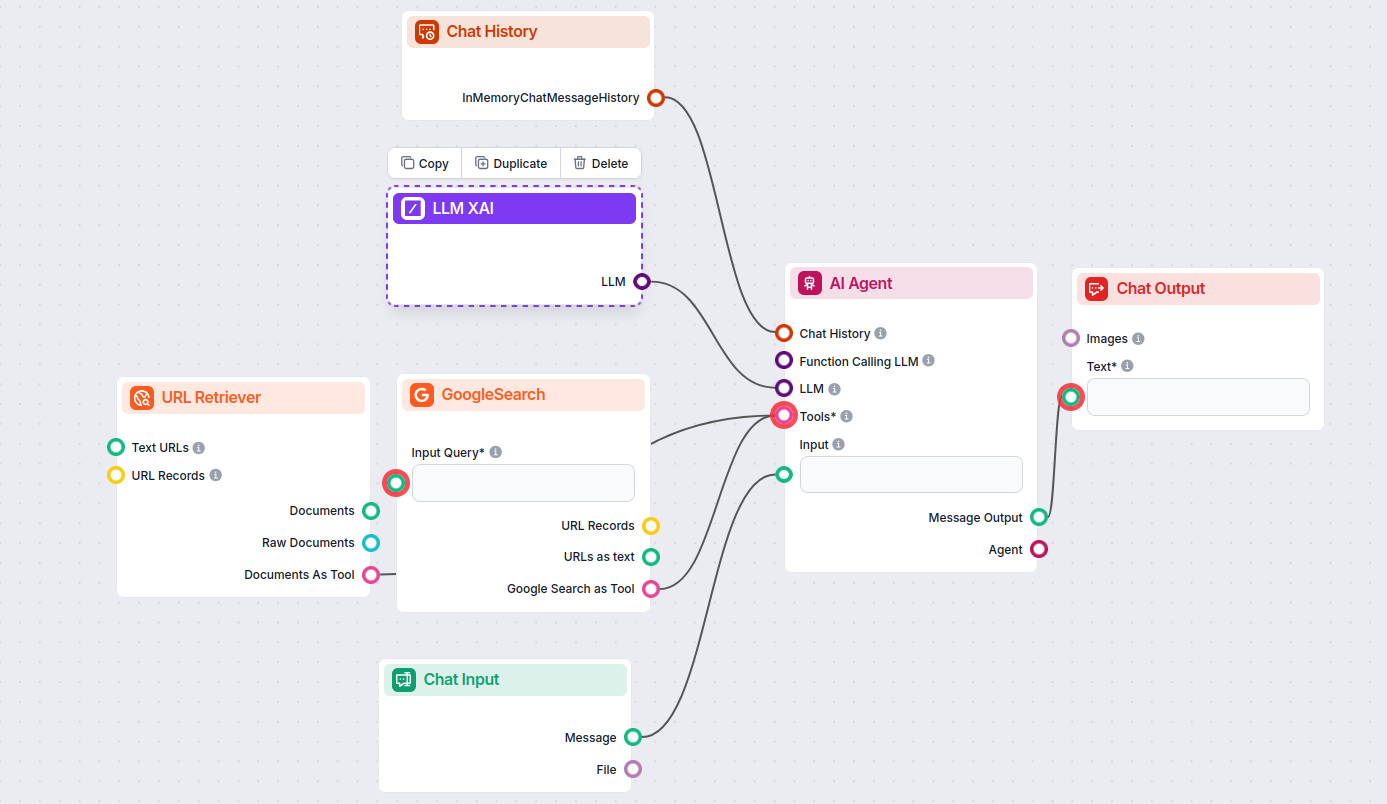

يتيح لك هذا إنشاء جميع أنواع الأدوات. لنرَ المكون أثناء العمل. إليك تدفق دردشة ذكي بسيط لوكيل ذكاء اصطناعي يستخدم grok-beta من xAI لتوليد الردود. يمكنك اعتباره دردشة xAI أساسية.

يتضمن هذا التدفق البسيط للدردشة الذكية:

LLM xAI هو مكون في FlowHunt يتيح لك الاتصال والتحكم في نماذج توليد النصوص من مزودي xAI مثل Grok-beta ضمن تدفقات الذكاء الاصطناعي والدردشات الذكية الخاصة بك.

حالياً، يدعم FlowHunt نموذج grok-beta من xAI، وسيتم إضافة المزيد من النماذج عند توفرها للاستخدام عبر واجهة البرمجة العامة (API).

يمكنك ضبط الحد الأقصى للرموز، ودرجة الحرارة (تنويع الإجابات)، واختيار من بين نماذج xAI المتاحة لتخصيص سلوك الدردشة الذكية أو أداة الذكاء الاصطناعي الخاصة بك.

لا، الأمر اختياري. بشكل افتراضي، تستخدم المكونات ChatGPT-4o، ولكن يمكنك توصيل LLM xAI للتحول إلى نماذج xAI أو الحصول على تحكم أكبر.

ما عليك سوى إضافة مكون LLM إلى التدفق الخاص بك؛ فهو يعمل كمحدد للنموذج. عملية توليد النصوص الفعلية تحدث في الوكلاء الذكيين والمولدات المتصلة به.

ابدأ في بناء دردشات ذكية وأدوات ذكاء اصطناعي أكثر ذكاءً مع FlowHunt. اتصل بأفضل نماذج xAI مثل Grok-beta في لوحة تحكم مرنة وبدون كود.

يدعم FlowHunt عشرات نماذج توليد النصوص، بما في ذلك نماذج Llama من Meta. تعرف على كيفية دمج Llama في أدوات الذكاء الاصطناعي والدردشات، وتخصيص الإعدادات مثل الحد ...

يدعم FlowHunt عشرات نماذج الذكاء الاصطناعي، بما في ذلك نماذج DeepSeek الثورية. إليك كيفية استخدام DeepSeek في أدوات الذكاء الاصطناعي وروبوتات الدردشة الخاصة بك....

يدعم FlowHunt العشرات من نماذج الذكاء الاصطناعي النصية، بما في ذلك نماذج Mistral. إليك كيفية استخدام Mistral في أدوات الذكاء الاصطناعي وروبوتات الدردشة الخاصة ب...