LSTM ثنائي الاتجاه

ذاكرة طويلة وقصيرة المدى ثنائية الاتجاه (BiLSTM) هي نوع متقدم من بنية الشبكات العصبية المتكررة (RNN) التي تعالج البيانات التسلسلية في كلا الاتجاهين الأمامي والخ...

شبكات LSTM هي بنى متقدمة من RNN تحل مشكلة تلاشي التدرج، مما يتيح التعلم الفعال من الاعتماديات طويلة الأمد في البيانات التسلسلية.

ذاكرة طويلة وقصيرة الأمد (LSTM) هي فئة متخصصة من بنى الشبكات العصبية المتكررة (RNN) تتقن تعلم الاعتماديات طويلة الأمد ضمن البيانات التسلسلية. تم تطوير شبكات LSTM لأول مرة بواسطة Hochreiter و Schmidhuber عام 1997، وقد صُممت لمعالجة القيود الموجودة في الشبكات العصبية المتكررة التقليدية، وخاصة مشكلة تلاشي التدرج. تمنع هذه المشكلة عادةً شبكات RNN من تعلم الاعتماديات طويلة الأمد بشكل فعال بسبب التناقص الأسي للتدرجات. تستخدم شبكات LSTM بنية متطورة تتضمن خلايا ذاكرة وآليات للبوابات، مما يمكّنها من الاحتفاظ بالمعلومات واستخدامها عبر فترات زمنية ممتدة. تجعل هذه القدرة شبكات LSTM مناسبة للمهام التي تتطلب تسلسلات يكون فيها السياق أمراً محورياً، مثل الترجمة اللغوية والتنبؤ بالسلاسل الزمنية.

خلية الذاكرة هي حجر الزاوية في وحدة LSTM، وتعمل كمخزن ديناميكي للمعلومات عبر الزمن. تحتوي كل خلية LSTM على حالة تُعرف بحالة الخلية، والتي تعمل كقناة تتدفق من خلالها المعلومات. يتم تنظيم تدفق المعلومات بدقة بواسطة ثلاثة أنواع من البوابات: بوابة الإدخال، بوابة النسيان، وبوابة الإخراج. تضمن هذه البوابات أن تحتفظ حالة الخلية بالمعلومات ذات الصلة وتتخلص من غير الضروري منها.

تُعد عملية كل بوابة أساسية لقدرة LSTM على معالجة مشكلة تلاشي التدرج، حيث تدير هذه البوابات مجتمعة تدفق المعلومات واحتفاظها، مما يضمن الحفاظ على الاعتماديات طويلة الأمد.

تتكون بنية شبكات LSTM من سلسلة من خلايا LSTM مرتبطة ببعضها في شكل سلسلة، مما يتيح معالجة تسلسلات كاملة من البيانات بدلاً من نقاط بيانات منفردة. وتعد هذه البنية التسلسلية محورية في التقاط كل من الاعتماديات قصيرة وطويلة الأمد ضمن البيانات. وعلى عكس الشبكات العصبية المتكررة التقليدية، تدمج LSTM وصلات راجعة تسمح لها بمعالجة تسلسلات البيانات بكفاءة. وتشمل البنية استخدام خلايا الذاكرة المنظمة بواسطة البوابات، مما يسهل الاحتفاظ الانتقائي بالمعلومات أو تجاهلها، وبالتالي تعزيز قدرة الشبكة على التعلم من التسلسلات الزمنية.

تعمل شبكات LSTM من خلال المرور عبر بوابات الإدخال والنسيان والإخراج عند كل خطوة زمنية، مما يسمح لها بإدارة تدفق المعلومات عبر الشبكة بشكل فعال. فيما يلي شرح لهذه العملية:

تعد آلية البوابات هذه جوهرية في شبكات LSTM، إذ تمكّنها من معالجة مشكلة تلاشي التدرج التي تؤثر غالباً على الشبكات العصبية المتكررة التقليدية. ومن خلال إدارة تدفق المعلومات واحتفاظها، تحافظ شبكات LSTM على السياق ذي الصلة عبر تسلسلات طويلة، مما يجعلها فعالة بشكل خاص لمهام البيانات التسلسلية.

تجد شبكات LSTM تطبيقات واسعة في العديد من المجالات نظراً لقدرتها على معالجة البيانات التسلسلية ذات الاعتماديات طويلة الأمد. ومن بين التطبيقات الرئيسية:

رغم قوتها، فإن شبكات LSTM تتطلب قدرات حسابية عالية وتستدعي ضبطاً دقيقاً لمعاملات الضبط. كما يمكن أن تعاني من فرط التكيّف، خاصة عند التدريب على مجموعات بيانات صغيرة، وبنيتها المعقدة قد تجعل من تنفيذها وتفسيرها أمراً صعباً.

لتعزيز الأداء وتقليل التعقيد، تم تطوير عدة أنواع من LSTM:

تلعب شبكات LSTM دوراً محورياً في تطوير روبوتات الدردشة الذكية والمساعدين الصوتيين ضمن مجالات الذكاء الاصطناعي والأتمتة. وتتيح هذه الأنظمة، المدعومة بـ LSTM، فهم وتوليد ردود فعل بشرية، مما يعزز بشكل كبير تفاعل العملاء من خلال تقديم تجارب خدمة سلسة وسريعة الاستجابة. ومن خلال تضمين شبكات LSTM في الأنظمة المؤتمتة، يمكن للشركات تقديم تجارب مستخدم محسّنة عبر تفاعلات أكثر دقة ووعياً بالسياق.

ذاكرة طويلة وقصيرة الأمد (LSTM) في الشبكات العصبية

تعد شبكات LSTM نوعاً من بنية الشبكات العصبية المتكررة (RNN) المصممة للتعامل مع مشكلة تلاشي التدرج التي قد تظهر عند تدريب الشبكات العصبية المتكررة التقليدية. وهذا يجعل LSTM مناسبة بشكل خاص للتعلم من تسلسلات البيانات مثل السلاسل الزمنية أو مهام معالجة اللغة الطبيعية، حيث تكون الاعتماديات طويلة الأمد ضرورية.

تقدم ورقة “Augmenting Language Models with Long-Term Memory” لـ Weizhi Wang وآخرين إطار عمل لتعزيز نماذج اللغة بقدرات الذاكرة طويلة الأمد. يوضح هذا العمل كيف يمكن دمج الذاكرة طويلة الأمد في النماذج الحالية لتوسيع قدرتها على الاستفادة من السياق عبر تسلسلات أطول، بطريقة مشابهة لاستخدام LSTM في التقاط الاعتماديات طويلة الأمد في مهام معالجة اللغة. اقرأ المزيد.

في ورقة “Portfolio Optimization with Sparse Multivariate Modelling” لـ Pier Francesco Procacci و Tomaso Aste، يستكشف المؤلفان النمذجة متعددة المتغيرات في الأسواق المالية ويتناولان عدة مصادر للخطأ في نمذجة الأنظمة المعقدة. وعلى الرغم من أن التركيز ليس بشكل مباشر على LSTM، إلا أن الورقة تبرز أهمية التعامل مع عدم الثبات وتحسين معلمات النموذج، وهي اعتبارات ذات صلة عند تصميم بنى LSTM قوية لتحليل البيانات المالية. اقرأ المزيد.

تقدم ورقة “XMem: Long-Term Video Object Segmentation with an Atkinson-Shiffrin Memory Model” لـ Ho Kei Cheng و Alexander G. Schwing بنية لتجزئة كائنات الفيديو مستوحاة من نموذج الذاكرة Atkinson-Shiffrin، وتدمج عدة مخازن للذاكرة المميزة. يرتبط هذا البحث بـ LSTM من حيث التأكيد على أهمية إدارة الذاكرة بكفاءة في تسلسلات الفيديو الطويلة، على غرار إدارة LSTM للاعتماديات طويلة الأمد في البيانات التسلسلية. اقرأ المزيد.

شبكة LSTM (ذاكرة طويلة وقصيرة الأمد) هي نوع من بنية الشبكات العصبية المتكررة (RNN) قادرة على تعلم الاعتماديات طويلة الأمد في البيانات التسلسلية من خلال استخدام خلايا الذاكرة وآليات البوابات لإدارة تدفق المعلومات واحتفاظها.

تُستخدم شبكات LSTM على نطاق واسع في معالجة اللغة الطبيعية، والتعرف على الكلام، والتنبؤ بالسلاسل الزمنية، واكتشاف الشذوذ، وأنظمة التوصية، وتحليل الفيديو نظراً لقدرتها على الاحتفاظ بالسياق عبر تسلسلات طويلة.

تستخدم شبكات LSTM خلايا الذاكرة وثلاثة أنواع من البوابات (الإدخال، والنسيان، والإخراج) لتنظيم تدفق المعلومات، مما يسمح للشبكة بالحفاظ على المعلومات واستخدامها عبر فترات زمنية طويلة، وهذا يخفف من مشكلة تلاشي التدرج الشائعة في الشبكات العصبية المتكررة التقليدية.

تشمل الأنواع الشائعة من LSTM شبكات LSTM ثنائية الاتجاه، ووحدات التكرار البوابية (GRUs)، وLSTM مع اتصالات الرؤية، حيث تقدم كل منها تعديلات معمارية لتحسين الأداء أو الكفاءة في مهام مختلفة.

تم تصميم شبكات LSTM للبيانات التسلسلية وتتفوق في تعلم الاعتماديات الزمنية، بينما تم تحسين شبكات CNN للتعامل مع البيانات المكانية مثل الصور. كل بنية مناسبة بشكل أفضل لطبيعة بياناتها ومهامها الخاصة.

استفد من قوة شبكات ذاكرة طويلة وقصيرة الأمد (LSTM) لتعزيز تطبيقات الذكاء الاصطناعي لديك. استكشف أدوات FlowHunt للذكاء الاصطناعي وابتكر حلولاً ذكية لمهام البيانات التسلسلية.

ذاكرة طويلة وقصيرة المدى ثنائية الاتجاه (BiLSTM) هي نوع متقدم من بنية الشبكات العصبية المتكررة (RNN) التي تعالج البيانات التسلسلية في كلا الاتجاهين الأمامي والخ...

يشير توليد النصوص باستخدام النماذج اللغوية الكبيرة (LLMs) إلى الاستخدام المتقدم لنماذج تعلم الآلة لإنتاج نصوص تشبه النصوص البشرية من خلال التعليمات. اكتشف كيف ت...

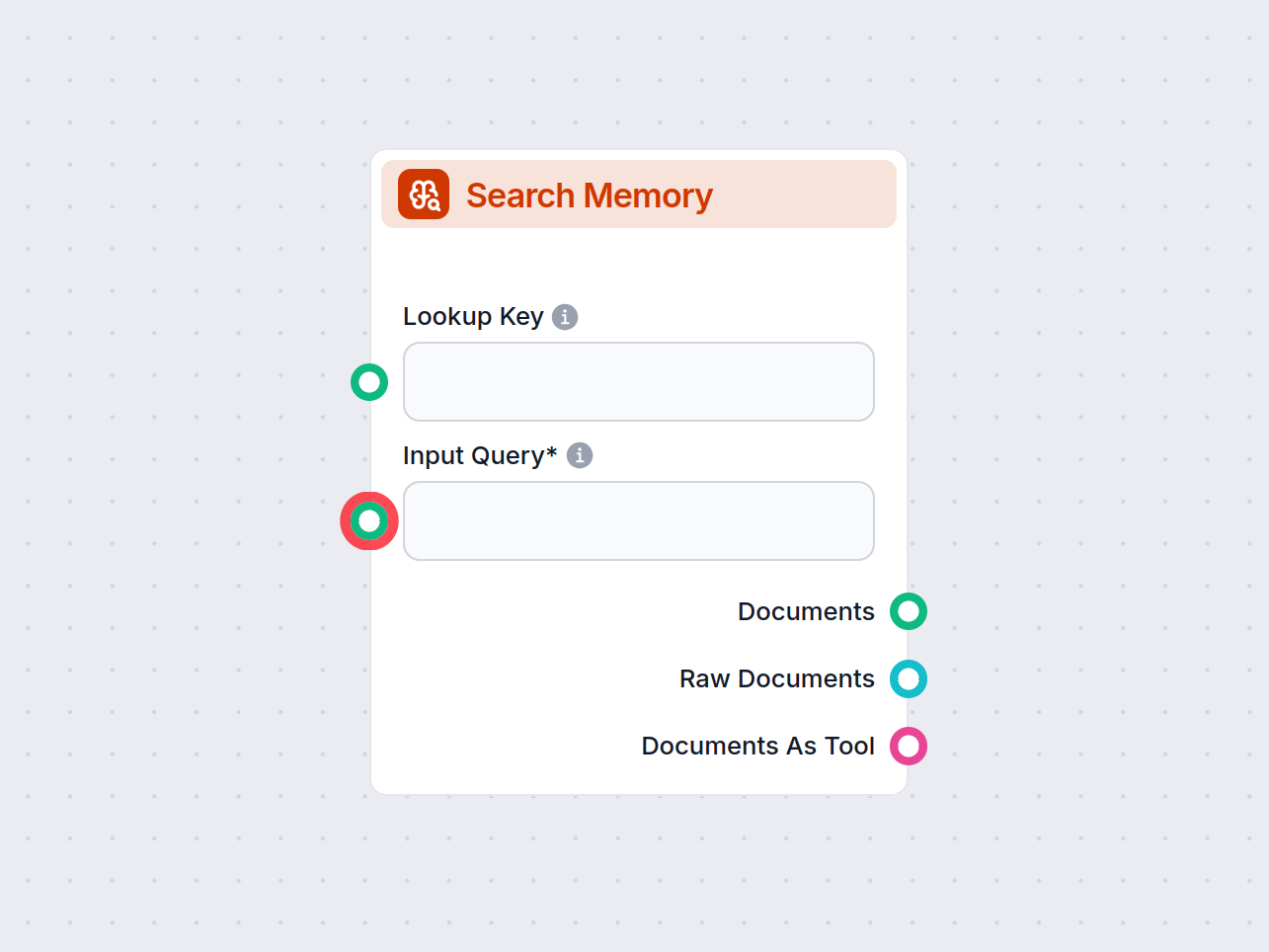

اكتشف قوة سير العمل لديك مع مكون بحث الذاكرة—استرجع المعلومات ذات الصلة من الذاكرة المخزنة باستخدام استفسارات المستخدم. ابحث، وصفِّ، واستخرج المستندات أو مقتطفا...