نموذج اللغة Pathways (PaLM)

نموذج اللغة Pathways (PaLM) هو عائلة متقدمة من نماذج اللغة الكبيرة من جوجل، مصمم لتطبيقات متنوعة مثل توليد النصوص، الاستدلال، تحليل الشيفرة، والترجمة متعددة الل...

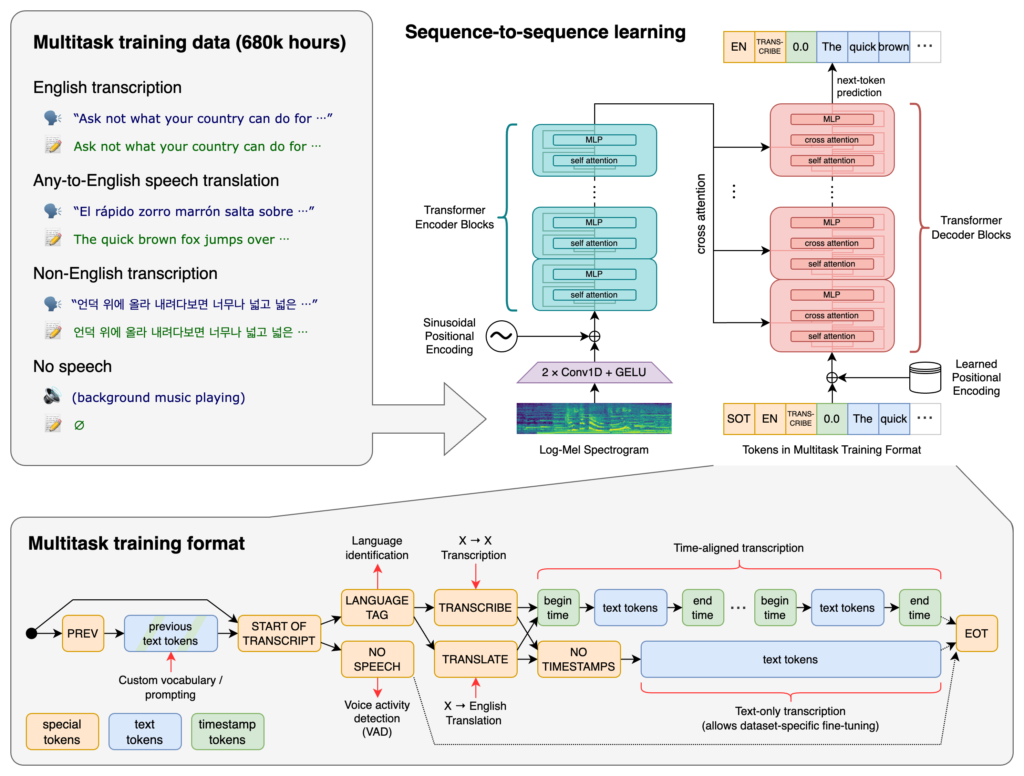

OpenAI Whisper هو نظام ASR مفتوح المصدر يحول الكلام إلى نص بدقة في 99 لغة، ويدعم النسخ والترجمة وتحديد اللغة لتقنيات الأتمتة الذكية.

يمكن اعتبار OpenAI Whisper نموذجًا ونظامًا في آن واحد حسب السياق.

الوظيفة الأساسية لـ Whisper هي نسخ الكلام إلى نص. يتميز بـ:

في قلب Whisper توجد بنية المحول، وتحديدًا نموذج مشفر-فك تشفير. المحولات هي شبكات عصبية تتفوق في معالجة البيانات التسلسلية وفهم السياق عبر سلاسل طويلة. وقد أُدخلت في ورقة “Attention is All You Need” عام 2017 وأصبحت أساسية في العديد من مهام معالجة اللغة الطبيعية.

عملية Whisper تتضمن:

تم تدريب Whisper على مجموعة ضخمة من 680,000 ساعة من البيانات الخاضعة للإشراف التي جُمعت من الإنترنت. يشمل ذلك:

بفضل تغطيته لـ99 لغة، يتميز Whisper بقدرته على التعامل مع مدخلات لغوية متنوعة. هذه الإمكانية تجعله مناسبًا للتطبيقات والخدمات العالمية.

تم تدريبه على بيانات خاضعة للإشراف بشكل واسع، ليحقق معدلات دقة مرتفعة في مهام النسخ. ومرونته مع اللهجات والضوضاء تجعله موثوقًا في سيناريوهات العالم الحقيقي.

إضافةً للنسخ، يمكن لـ Whisper تنفيذ:

بصفته برنامجًا مفتوح المصدر، يسمح Whisper للمطورين بـ:

بدمج Whisper في روبوتات الدردشة والمساعدات الذكية، يمكن للمطورين تمكين:

تم تنفيذ Whisper كمكتبة بايثون، مما يتيح دمجها بسهولة في المشاريع المبنية على بايثون. لاستخدام Whisper في بايثون يجب إعداد البيئة المناسبة، وتثبيت الاعتمادات اللازمة، واستخدام دوال المكتبة لنسخ أو ترجمة الملفات الصوتية.

قبل استخدام Whisper، تحتاج إلى إعداد بيئة التطوير الخاصة بك بتثبيت بايثون، PyTorch، FFmpeg، ومكتبة Whisper نفسها.

إذا لم يكن لديك بايثون مثبتًا، حمله من الموقع الرسمي. لتثبيت PyTorch، استخدم pip:

pip install torch

بدلاً من ذلك، يمكنك زيارة موقع PyTorch للحصول على تعليمات التثبيت حسب نظام التشغيل وإصدار بايثون.

يحتاج Whisper إلى FFmpeg لمعالجة الملفات الصوتية. ثبّت FFmpeg باستخدام مدير الحزم المناسب لنظام التشغيل.

أوبونتو/ديبيان:

sudo apt update && sudo apt install ffmpeg

ماك (مع Homebrew):

brew install ffmpeg

ويندوز (مع Chocolatey):

choco install ffmpeg

ثبت حزمة Whisper لبايثون باستخدام pip:

pip install -U openai-whisper

لتثبيت أحدث إصدار مباشرة من مستودع GitHub:

pip install git+https://github.com/openai/whisper.git

تأكد من تفعيل وضع المطور:

يوفر Whisper عدة نماذج تختلف في الحجم والقدرات. تتراوح النماذج من tiny إلى large، كل منها يوازن بين السرعة والدقة بشكل مختلف.

| الحجم | عدد المعاملات | نموذج للإنجليزية فقط | النموذج متعدد اللغات | VRAM المطلوب | السرعة النسبية |

|---|---|---|---|---|---|

| tiny | 39 M | tiny.en | tiny | ~1 GB | ~32x |

| base | 74 M | base.en | base | ~1 GB | ~16x |

| small | 244 M | small.en | small | ~2 GB | ~6x |

| medium | 769 M | medium.en | medium | ~5 GB | ~2x |

| large | 1550 M | N/A | large | ~10 GB | 1x |

.en): محسنة لنسخ الصوت الإنجليزي وتقدم أداءً أفضل للإنجليزية.بعد إعداد البيئة وتثبيت المكونات اللازمة، يمكنك البدء في استخدام Whisper في مشاريعك بايثون.

ابدأ باستيراد مكتبة Whisper وتحميل النموذج المطلوب:

import whisper

# تحميل النموذج المطلوب

model = whisper.load_model("base")

استبدل "base" باسم النموذج الذي يناسب تطبيقك.

يوفر Whisper دالة transcribe مباشرة لتحويل الملفات الصوتية إلى نص.

مثال: نسخ ملف صوتي باللغة الإنجليزية

# نسخ الملف الصوتي

result = model.transcribe("path/to/english_audio.mp3")

# طباعة النص المنسوخ

print(result["text"])

model.transcribe(): يعالج الملف الصوتي ويُخرج قاموسًا يحتوي على النسخ ومعلومات أخرى.result["text"]: يحصل على النص المنسوخ من النتيجة.يمكن لـ Whisper ترجمة الصوت من لغات مختلفة إلى الإنجليزية.

مثال: ترجمة صوت إسباني إلى الإنجليزية

# نسخ وترجمة الصوت الإسباني إلى الإنجليزية

result = model.transcribe("path/to/spanish_audio.mp3", task="translate")

# طباعة النص المترجم

print(result["text"])

task="translate": يوجه النموذج لترجمة الصوت إلى الإنجليزية بدلاً من نسخه كما هو.رغم أن Whisper يمكنه اكتشاف اللغة تلقائيًا، إلا أن تحديدها يدويًا قد يُحسن الدقة والسرعة.

مثال: نسخ صوت فرنسي

# نسخ صوت فرنسي مع تحديد اللغة

result = model.transcribe("path/to/french_audio.wav", language="fr")

# طباعة النص المنسوخ

print(result["text"])

يمكن لـ Whisper تحديد اللغة المنطوقة في ملف صوتي باستخدام دالة detect_language.

مثال: اكتشاف اللغة

# تحميل ومعالجة الصوت

audio = whisper.load_audio("path/to/unknown_language_audio.mp3")

audio = whisper.pad_or_trim(audio)

# تحويله إلى طيف log-Mel

mel = whisper.log_mel_spectrogram(audio).to(model.device)

# اكتشاف اللغة

_, probs = model.detect_language(mel)

language = max(probs, key=probs.get)

print(f"Detected language: {language}")

whisper.load_audio(): تحميل الملف الصوتي.whisper.pad_or_trim(): ضبط طول الصوت ليناسب متطلبات النموذج.whisper.log_mel_spectrogram(): تحويل الصوت إلى طيف log-Mel المناسب للنموذج.model.detect_language(): يُرجع احتمالات لكل لغة ويحدد اللغة الأكثر ترجيحًا.للحصول على تحكم أكبر في عملية النسخ، يمكنك استخدام دوال منخفضة المستوى وتخصيص خيارات فك الشيفرة.

decodeتتيح دالة decode تحديد خيارات مثل اللغة، نوع المهمة، وما إذا كنت تريد تضمين الطوابع الزمنية.

مثال: خيارات فك شيفرة مخصصة

# تعيين خيارات فك الشيفرة

options = whisper.DecodingOptions(language="de", without_timestamps=True)

# فك الشيفرة للصوت

result = whisper.decode(model, mel, options)

# طباعة النص المعترف عليه

print(result.text)

يمكنك دمج Whisper لنسخ الصوت المباشر من الميكروفون.

مثال: نسخ مدخل ميكروفون مباشر

import whisper

import sounddevice as sd

# تحميل النموذج

model = whisper.load_model("base")

# تسجيل الصوت من الميكروفون

duration = 5 # ثوانٍ

fs = 16000 # معدل العينة

print("Recording...")

audio = sd.rec(int(duration * fs), samplerate=fs, channels=1, dtype='float32')

sd.wait

OpenAI Whisper هو نظام متقدم للتعرف التلقائي على الكلام (ASR) من تطوير OpenAI، مصمم لتحويل اللغة المنطوقة إلى نص مكتوب باستخدام التعلم العميق. يدعم 99 لغة ويتميز في النسخ والترجمة وتحديد اللغة.

يستخدم Whisper بنية مشفر-فك تشفير معتمدة على المحولات (Transformer)، ويعالج الصوت إلى طيف log-Mel، ويخرج النص عبر نموذج لغوي. تم تدريبه على 680,000 ساعة من البيانات متعددة اللغات والمهام لتحقيق دقة وموثوقية عالية.

يدعم Whisper التعرف على الكلام بعدة لغات، ترجمة الكلام، تحديد اللغة تلقائيًا، ومقاومة اللهجات والضوضاء، ويوفر وصولًا مفتوح المصدر للتخصيص والدمج.

تعتمد متطلبات العتاد على حجم النموذج: النماذج الصغيرة مثل 'tiny' تتطلب حوالي 1GB VRAM، بينما الأكبر تتطلب حوالي 10GB. يعمل Whisper أسرع على بطاقات الرسوميات (GPU) لكنه يمكن أن يعمل على المعالج (CPU) مع وقت معالجة أطول.

نعم، تم تنفيذ Whisper كمكتبة بايثون ويمكن تثبيتها عبر pip. يسمح ذلك بالدمج السهل في مشاريع بايثون لنسخ الكلام، الترجمة، وتطبيقات الصوت في الوقت الفعلي.

تشمل الاستخدامات الشائعة نسخ الاجتماعات تلقائيًا، روبوتات الدردشة الصوتية، الترجمة المباشرة، أدوات الإتاحة (الترجمة المصاحبة وتقنيات الدعم)، أتمتة مراكز الاتصال، وأنظمة الأتمتة الصوتية.

نعم، البدائل تشمل محركات مفتوحة المصدر مثل Mozilla DeepSpeech، Kaldi، Wav2vec، وواجهات برمجة التطبيقات التجارية مثل Google Cloud Speech-to-Text، Microsoft Azure AI Speech، وAWS Transcribe.

نعم، OpenAI Whisper مفتوح المصدر، مما يسمح للمطورين بتخصيصه وتعديله ودمجه في منتجاتهم وخدماتهم دون قيود ترخيص.

ادمج قدرات تحويل الكلام إلى نص المتقدمة في تطبيقاتك، وأتمت سير العمل، وحسّن تجربة المستخدم مع OpenAI Whisper وFlowHunt.

نموذج اللغة Pathways (PaLM) هو عائلة متقدمة من نماذج اللغة الكبيرة من جوجل، مصمم لتطبيقات متنوعة مثل توليد النصوص، الاستدلال، تحليل الشيفرة، والترجمة متعددة الل...

نموذج الذكاء الاصطناعي الأساسي هو نموذج تعلم آلي واسع النطاق يتم تدريبه على كميات هائلة من البيانات، وقابل للتكيف مع مجموعة واسعة من المهام. لقد أحدثت نماذج الأ...

نموذج اللغة الكبير (LLM) هو نوع من الذكاء الاصطناعي يتم تدريبه على كميات هائلة من البيانات النصية لفهم وتوليد ومعالجة اللغة البشرية. تستخدم هذه النماذج التعلم ا...