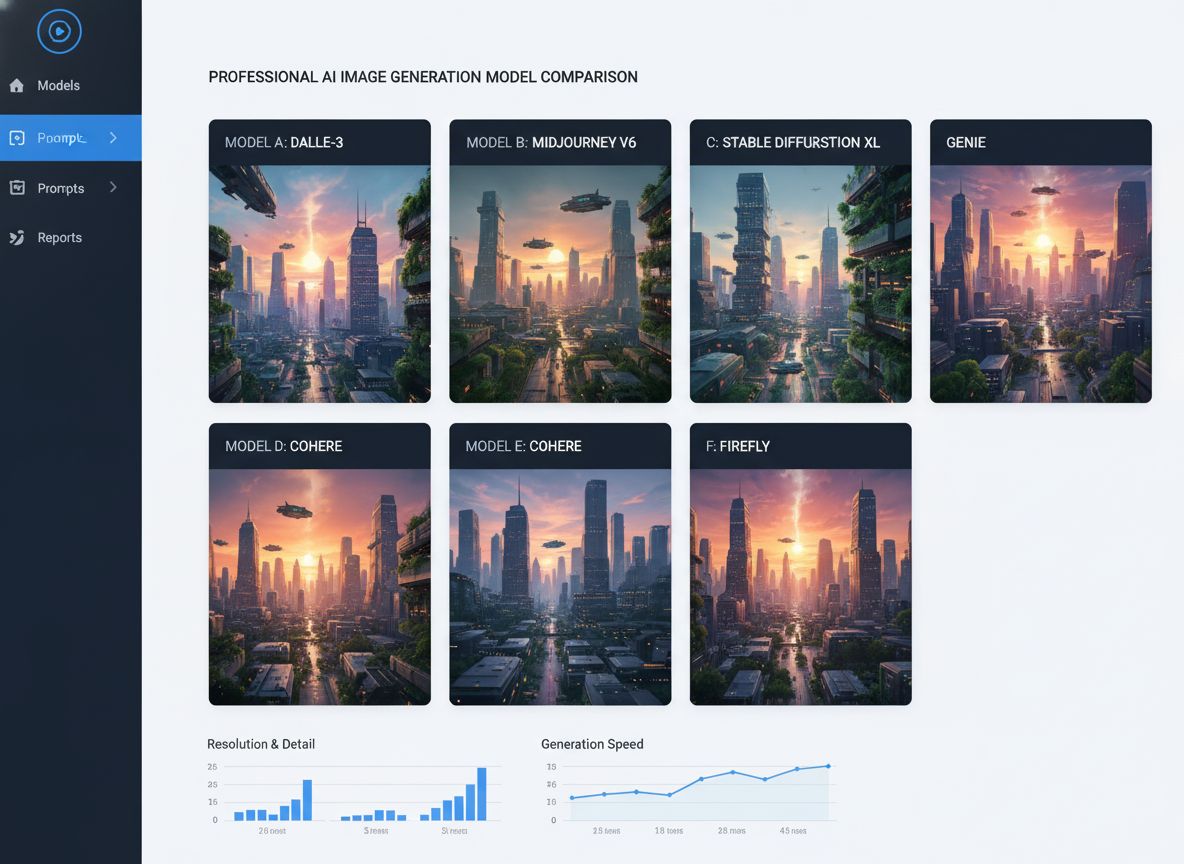

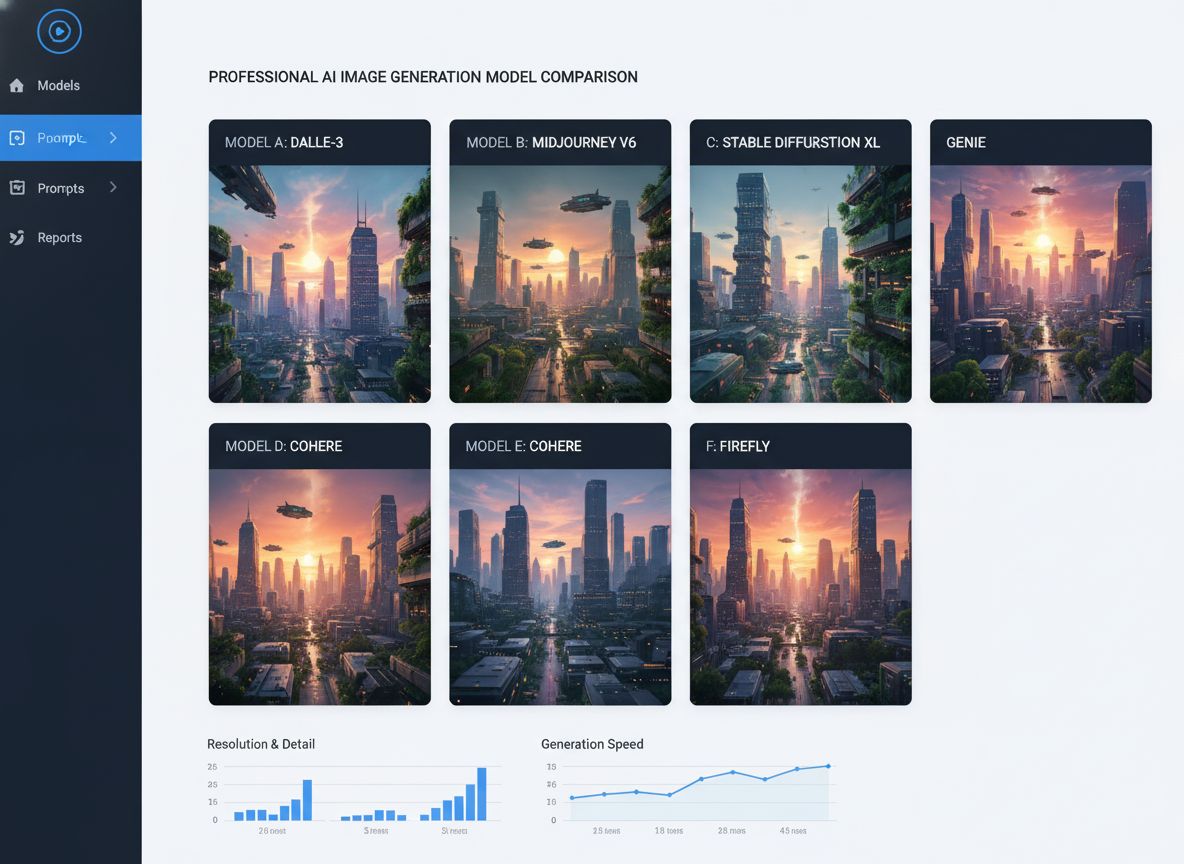

Srovnání AI modelů pro generování obrázků: Qwen, GPT-4 Vision, Seadream, Nano Banana

Komplexní srovnání předních AI modelů pro generování obrázků včetně Qwen ImageEdit Plus, Nano Banana, GPT Image 1 a Seadream. Zjistěte, který model vyniká v růz...

Ponořte se do hloubkové srovnávací analýzy 20 předních AI agentních modelů, hodnotících jejich silné a slabé stránky a výkon v úlohách jako generování obsahu, řešení problémů, sumarizace, srovnání a kreativní psaní.

Testovali jsme 20 různých AI agentních modelů v rámci pěti klíčových úloh, z nichž každá byla navržena tak, aby prověřila jiné schopnosti:

Naše analýza se zaměřila jak na kvalitu výstupu, tak na myšlenkové pochody agenta – hodnotili jsme jeho schopnost plánovat, uvažovat, adaptovat se a efektivně využívat dostupné nástroje. Modely jsme seřadili podle jejich výkonu jako AI agentů, přičemž větší váha byla dána jejich myšlenkovým procesům a strategiím.

Všech dvacet modelů prokázalo silnou schopnost generovat kvalitní, informativní články. Následující žebříček zohledňuje i vnitřní myšlenkové pochody každého agenta a to, jak dospěli ke svému výsledku:

Hodnotili jsme matematické schopnosti modelů a jejich strategie při řešení problémů:

Hodnotili jsme schopnosti modelů vytáhnout klíčové informace a vytvořit stručné shrnutí:

Tato analýza hodnotí 20 předních AI agentních modelů a posuzuje jejich výkon v úlohách, jako je generování obsahu, řešení problémů, sumarizace, srovnání a kreativní psaní, se zvláštním důrazem na myšlenkové pochody jednotlivých modelů a jejich adaptabilitu.

Podle závěrečného pořadí dosáhl nejlepšího celkového výkonu Claude 3.5 Sonnet, který vyniká v přesnosti, strategickém myšlení a konzistentně vysoce kvalitních výstupech.

Každý model byl testován v pěti klíčových úlohách: generování obsahu, řešení problémů, sumarizace, srovnání a kreativní psaní. Vyhodnocení zohledňovalo nejen kvalitu výstupu, ale také schopnost uvažovat, plánovat, používat nástroje a adaptovat se.

Ano, FlowHunt nabízí platformu pro tvorbu, vyhodnocení a nasazení vlastních AI agentů a chatbotů, která vám umožní automatizovat úkoly, zefektivnit pracovní toky a využít pokročilé AI schopnosti pro vaše podnikání.

Blogový příspěvek obsahuje detailní rozbory úkol po úkolu a závěrečná pořadí pro každého z 20 AI agentních modelů, přičemž zdůrazňuje jejich jedinečné silné a slabé stránky napříč různými úlohami.

Začněte budovat vlastní AI řešení na výkonné platformě FlowHunt. Srovnávejte, vyhodnocujte a nasazujte špičkové AI agenty dle potřeb vašeho podnikání.

Komplexní srovnání předních AI modelů pro generování obrázků včetně Qwen ImageEdit Plus, Nano Banana, GPT Image 1 a Seadream. Zjistěte, který model vyniká v růz...

Prozkoumejte pokročilé schopnosti AI agenta Claude 3. Tato detailní analýza odhaluje, jak Claude 3 překračuje rámec pouhé generace textu a ukazuje své schopnost...

Hloubková analýza modelu pro uvažování EXAONE Deep 32B od LG testovaného proti DeepSeek R1 a Alibaba QwQ, zkoumající tvrzení o vyšším výkonu a skutečné schopnos...