LLM OpenAI

FlowHunt podporuje desítky modelů pro generování textu, včetně modelů od OpenAI. Zjistěte, jak používat ChatGPT ve svých AI nástrojích a chatbotech....

Komponenta Vlastní OpenAI LLM vám umožní připojit a nastavit vaše vlastní jazykové modely kompatibilní s OpenAI pro flexibilní a pokročilé konverzační AI toky.

Popis komponenty

Komponenta Vlastní LLM OpenAI poskytuje flexibilní rozhraní pro práci s velkými jazykovými modely kompatibilními s OpenAI API. Zahrnuje modely nejen od OpenAI, ale i od alternativních poskytovatelů, jako jsou JinaChat, LocalAI a Prem. Komponenta je navržena jako vysoce konfigurovatelná, což ji činí vhodnou pro různé scénáře AI workflowů vyžadujících zpracování přirozeného jazyka.

Tato komponenta funguje jako most mezi vaším AI workflowem a jazykovými modely využívajícími standard OpenAI API. Umožňuje zadat poskytovatele modelu, API endpoint a další parametry, takže můžete generovat nebo zpracovávat text, chat či jiné jazykové výstupy přímo ve workflowu. Ať už potřebujete shrnout obsah, odpovídat na dotazy, tvořit kreativní texty nebo provádět jiné NLP úlohy, komponentu lze nastavit přesně podle vašich potřeb.

Chování komponenty můžete ovládat prostřednictvím několika parametrů:

| Parametr | Typ | Povinné | Výchozí | Popis |

|---|---|---|---|---|

| Max Tokenů | int | Ne | 3000 | Omezuje maximální délku vygenerovaného textového výstupu. |

| Název modelu | string | Ne | (prázdné) | Určete přesný model, který se má použít (např. gpt-3.5-turbo). |

| OpenAI API Base | string | Ne | (prázdné) | Můžete zadat vlastní API endpoint (např. pro JinaChat, LocalAI nebo Prem). Pokud prázdné, použije se OpenAI. |

| API klíč | string | Ano | (prázdné) | Váš tajný API klíč pro přístup k vybranému poskytovateli jazykového modelu. |

| Teplota | float | Ne | 0.7 | Ovlivňuje kreativitu výstupu. Nižší hodnoty znamenají více deterministické výsledky. Rozsah: 0 až 1. |

| Použít cache | bool | Ne | true | Povolit/zakázat ukládání dotazů do cache pro zvýšení efektivity a snížení nákladů. |

Poznámka: Všechna tato konfigurační nastavení jsou pokročilá a umožní vám detailně řídit chování a integraci modelu.

Vstupy:

Tato komponenta nemá žádné vstupní konektory.

Výstupy:

BaseChatModel, který lze dále použít v následujících komponentách workflowu pro další zpracování či interakci.| Funkce | Popis |

|---|---|

| Podpora poskytovatelů | OpenAI, JinaChat, LocalAI, Prem nebo jakákoli služba kompatibilní s OpenAI API |

| Typ výstupu | BaseChatModel |

| API endpoint | Konfigurovatelný |

| Bezpečnost | API klíč vyžadován (uchován v tajnosti) |

| Uživatelskost | Pokročilá nastavení pro náročné uživatele, ale výchozí hodnoty postačí většině |

Tato komponenta je ideální pro každého, kdo chce integrovat flexibilní, robustní a konfigurovatelné LLM schopnosti do svých AI workflowů, bez ohledu na to, zda využíváte přímo OpenAI nebo alternativního poskytovatele.

Komponenta Vlastní OpenAI LLM vám umožní propojit jakýkoli jazykový model kompatibilní s OpenAI – například JinaChat, LocalAI nebo Prem – poskytnutím vlastních API přihlašovacích údajů a endpointů, čímž získáte plnou kontrolu nad schopnostmi vaší AI.

Můžete nastavit název modelu, API klíč, API endpoint, teplotu, maximální počet tokenů a povolit cacheování výsledků pro optimalizovaný výkon i flexibilitu.

Ano, pokud model využívá rozhraní OpenAI API, můžete připojit i alternativy jako JinaChat, LocalAI nebo Prem.

Váš API klíč je vyžadován k propojení modelu a platforma s ním zachází bezpečně. Nikdy není sdílen ani zpřístupněn neoprávněným osobám.

Ano, můžete povolit cacheování pro ukládání a opětovné použití předchozích výsledků, což snižuje latenci i spotřebu API při opakovaných dotazech.

Propojte své vlastní jazykové modely a posuňte své AI workflowy na novou úroveň. Vyzkoušejte komponentu Vlastní OpenAI LLM ve FlowHunt ještě dnes.

FlowHunt podporuje desítky modelů pro generování textu, včetně modelů od OpenAI. Zjistěte, jak používat ChatGPT ve svých AI nástrojích a chatbotech....

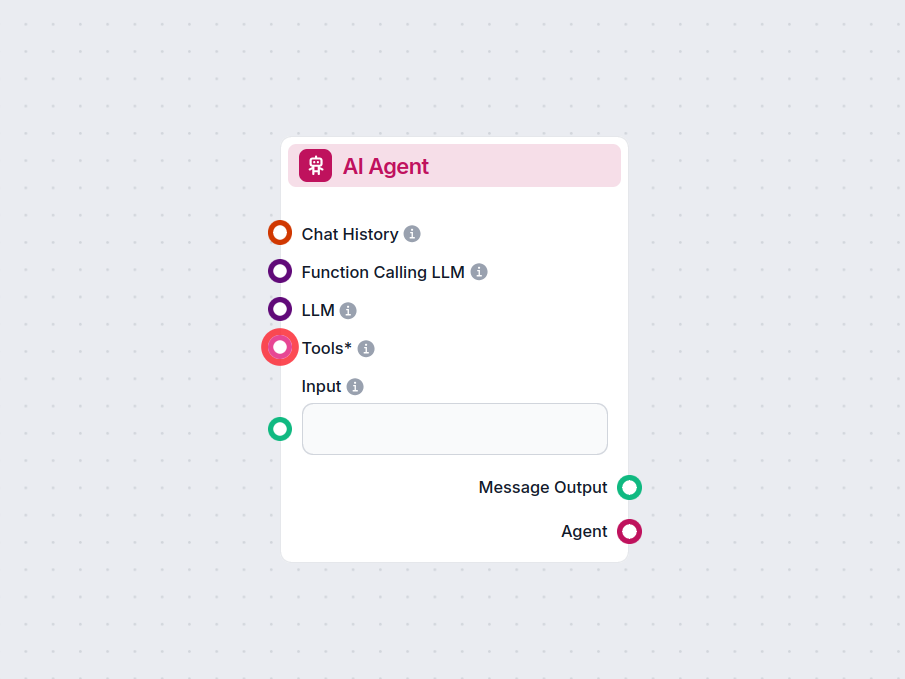

Komponenta AI Agent ve FlowHunt posiluje vaše pracovní toky autonomním rozhodováním a schopností využívat nástroje. Využívá velké jazykové modely a propojuje se...

FlowHunt podporuje desítky AI modelů včetně modelů Claude od Anthropic. Naučte se používat Claude ve svých AI nástrojích a chatbotech s možností přizpůsobení na...