Umělé neuronové sítě (ANN)

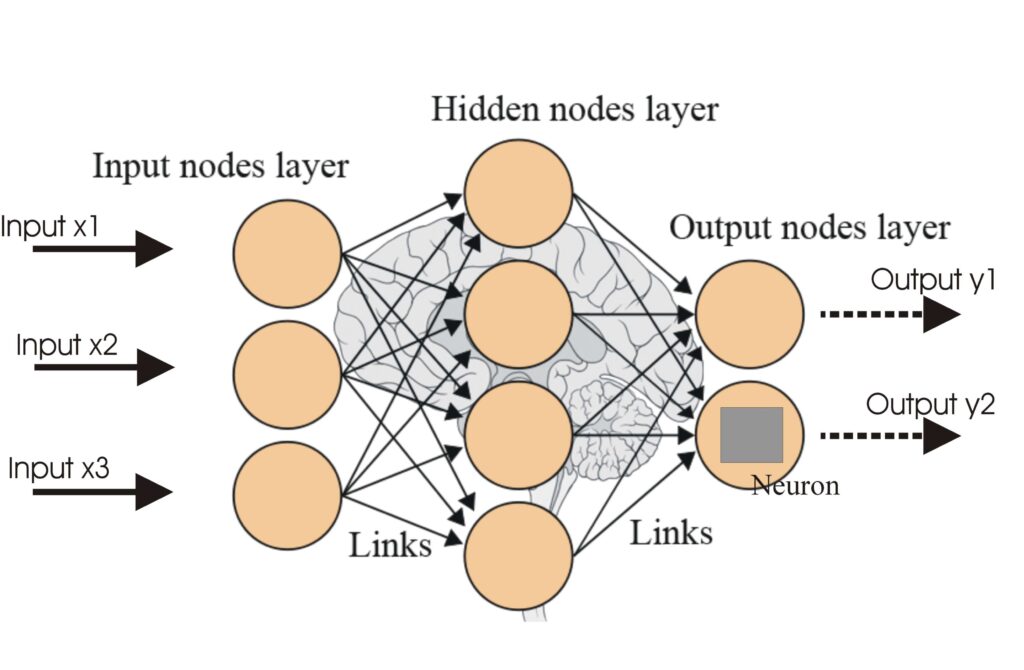

Umělé neuronové sítě (ANN) jsou podmnožinou algoritmů strojového učení inspirovaných lidským mozkem. Tyto výpočetní modely se skládají z propojených uzlů neboli...

Aktivační funkce vnášejí do neuronových sítí nelinearitu, což jim umožňuje učit se složité vzory nezbytné pro aplikace v AI a deep learningu.

Aktivační funkce jsou základním stavebním kamenem architektury umělých neuronových sítí (ANN), a významně ovlivňují schopnost sítě učit se a vykonávat složité úlohy. Tento slovníkový článek se zabývá složitostí aktivačních funkcí, jejich účelem, typy a využitím, zejména v oblasti AI, deep learningu a neuronových sítí.

Aktivační funkce v neuronové síti je matematická operace aplikovaná na výstup neuronu. Určuje, zda má být neuron aktivován, a vnáší do modelu nelinearitu, která umožňuje síti učit se složité vzory. Bez těchto funkcí by neuronová síť fungovala v podstatě jako lineární regrese, bez ohledu na její hloubku nebo počet vrstev.

Sigmoid

Tanh

ReLU (Rectified Linear Unit)

Leaky ReLU

Softmax

Swish

Aktivační funkce jsou nedílnou součástí různých AI aplikací, včetně:

Aktivační funkce je matematická operace aplikovaná na výstup neuronu, která vnáší do sítě nelinearitu a umožňuje neuronovým sítím učit se složité vzory nad rámec jednoduchých lineárních vztahů.

Aktivační funkce umožňují neuronovým sítím řešit složité, nelineární úlohy tím, že umožňují učení komplexních vzorů, což je klíčové například pro rozpoznávání obrazu, zpracování jazyka a automatizaci.

Mezi běžné typy patří Sigmoid, Tanh, ReLU, Leaky ReLU, Softmax a Swish, z nichž každý má specifické vlastnosti a využití v různých vrstvách neuronových sítí.

Mezi běžné výzvy patří problém mizejícího gradientu (zejména u Sigmoid a Tanh), problém "umírajícího" ReLU a výpočetní náročnost funkcí jako Softmax v reálném čase.

Chytré chatboty a AI nástroje pod jednou střechou. Propojte intuitivní bloky a proměňte své nápady v automatizované Flow.

Umělé neuronové sítě (ANN) jsou podmnožinou algoritmů strojového učení inspirovaných lidským mozkem. Tyto výpočetní modely se skládají z propojených uzlů neboli...

Neuronová síť, nebo také umělá neuronová síť (ANN), je výpočetní model inspirovaný lidským mozkem, klíčový v AI a strojovém učení pro úkoly jako rozpoznávání vz...

Rekurentní neuronové sítě (RNN) jsou sofistikovanou třídou umělých neuronových sítí navržených pro zpracování sekvenčních dat využitím paměti předchozích vstupů...