Vektorové reprezentace slov (Word Embeddings)

Vektorové reprezentace slov (word embeddings) jsou sofistikované reprezentace slov v plynulém vektorovém prostoru, zachycující sémantické a syntaktické vztahy p...

Vektor vnoření číselně reprezentuje data v mnohorozměrném prostoru, což umožňuje AI systémům zachytit sémantické vztahy pro úlohy jako klasifikace, shlukování a doporučování.

Vektor vnoření je hustá číselná reprezentace dat, ve které je každý prvek dat mapován na bod v mnohorozměrném prostoru. Toto mapování je navrženo tak, aby zachytilo sémantickou informaci a kontextové vztahy mezi různými datovými body. Podobné body dat jsou v tomto prostoru umisťovány blíže k sobě, což usnadňuje úlohy jako klasifikace, shlukování nebo doporučování.

Vektory vnoření jsou v podstatě pole čísel, která zachycují vnitřní vlastnosti a vztahy dat, která reprezentují. Překladem složitých typů dat do těchto vektorů mohou AI systémy provádět různé operace efektivněji.

Vektory vnoření jsou základem mnoha aplikací umělé inteligence a strojového učení. Zjednodušují reprezentaci vysoce dimenzionálních dat, což usnadňuje jejich analýzu a interpretaci.

Vytváření vektorů vnoření zahrnuje několik kroků:

Knihovna Huggingface Transformers nabízí špičkové transformační modely jako BERT, RoBERTa a GPT-3. Tyto modely jsou předtrénovány na rozsáhlých datasetech a poskytují kvalitní vektory vnoření, které lze dále doladit pro specifické úlohy, což je činí ideálními pro robustní NLP aplikace.

Nejprve se ujistěte, že máte ve svém Python prostředí nainstalovanou knihovnu transformers. Instalovat ji můžete pomocí pip:

pip install transformers

Dále načtěte předtrénovaný model z hubu Huggingface. V tomto příkladu použijeme BERT.

from transformers import BertModel, BertTokenizer

model_name = 'bert-base-uncased'

tokenizer = BertTokenizer.from_pretrained(model_name)

model = BertModel.from_pretrained(model_name)

Tokenizujte váš vstupní text, abyste jej připravili pro model.

inputs = tokenizer("Hello, Huggingface!", return_tensors='pt')

Proveďte tokenizovaný text modelem, abyste získali vektory vnoření.

outputs = model(**inputs)

embedding_vectors = outputs.last_hidden_state

Zde je kompletní příklad, který ukazuje výše zmíněné kroky:

from transformers import BertModel, BertTokenizer

# Načtení předtrénovaného BERT modelu a tokenizéru

model_name = 'bert-base-uncased'

tokenizer = BertTokenizer.from_pretrained(model_name)

model = BertModel.from_pretrained(model_name)

# Tokenizace vstupního textu

text = "Hello, Huggingface!"

inputs = tokenizer(text, return_tensors='pt')

# Generování vektorů vnoření

outputs = model(**inputs)

embedding_vectors = outputs.last_hidden_state

print(embedding_vectors)

SNE je raná metoda pro redukci dimenzionality, vyvinutá Geoffrey Hintonem a Samem Roweisem. Pracuje na základě výpočtu párových podobností ve vysoce dimenzionálním prostoru a snaží se tyto podobnosti zachovat v prostoru s nižší dimenzí.

t-SNE je vylepšením SNE a široce se používá pro vizualizaci vysoce dimenzionálních dat. Minimalizuje odchylku mezi dvěma rozděleními: jedno reprezentuje párové podobnosti v původním prostoru, druhé v redukovaném prostoru, přičemž používá rozdělení Student-t s těžkými chvosty.

UMAP je novější technika, která nabízí rychlejší výpočty a lepší zachování globální struktury dat oproti t-SNE. Funguje tak, že konstruuje graf ve vysokodimenzionálním prostoru a optimalizuje graf v prostoru s nižší dimenzí tak, aby si byly strukturálně co nejpodobnější.

Několik nástrojů a knihoven usnadňuje vizualizaci vektorů vnoření:

Vektor vnoření je hustá číselná reprezentace dat, která každému datovému bodu přiřazuje pozici v mnohorozměrném prostoru za účelem zachycení sémantických a kontextových vztahů.

Vektory vnoření jsou v AI základní pro zjednodušení složitých dat, což umožňuje úlohy jako klasifikaci textu, rozpoznávání obrázků a personalizovaná doporučení.

Vektory vnoření lze generovat pomocí předtrénovaných modelů jako BERT z knihovny Huggingface Transformers. Tokenizací dat a jejich průchodem těmito modely získáte kvalitní vektory vnoření pro další analýzu.

Techniky redukce dimenzionality jako t-SNE a UMAP se běžně používají k vizualizaci vysoce dimenzionálních vektorů vnoření a pomáhají interpretovat a analyzovat datové vzory.

Začněte budovat vlastní AI nástroje a chatboty bez programování na platformě FlowHunt. Proměňte své nápady v automatizované toky snadno.

Vektorové reprezentace slov (word embeddings) jsou sofistikované reprezentace slov v plynulém vektorovém prostoru, zachycující sémantické a syntaktické vztahy p...

AI vyhledávání je sémantická nebo vektorová metoda vyhledávání, která využívá modely strojového učení k pochopení záměru a kontextového významu vyhledávacích do...

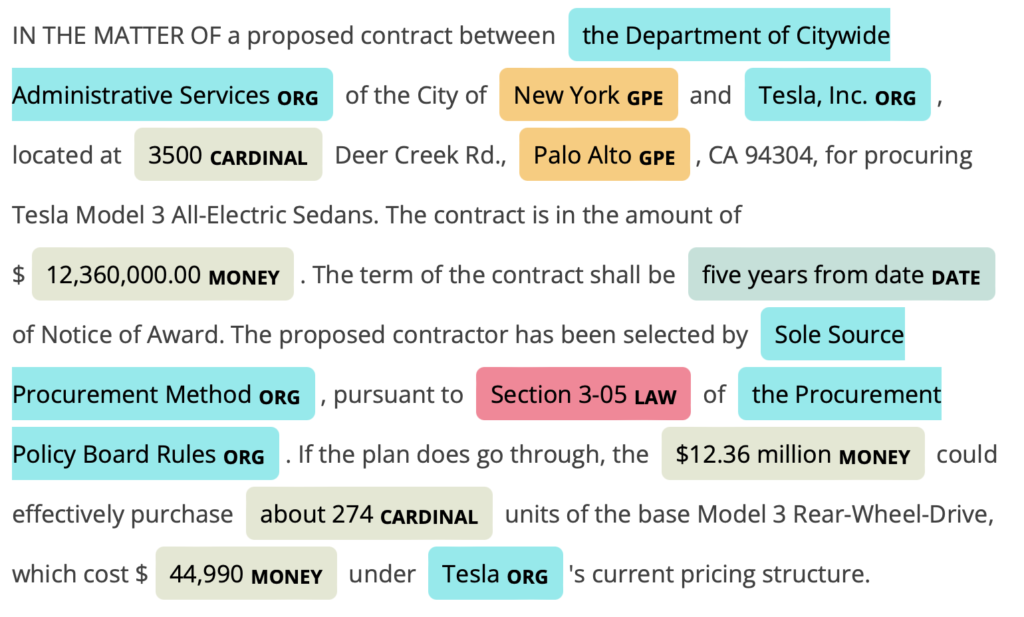

Rozpoznávání pojmenovaných entit (NER) je klíčovou podoblastí zpracování přirozeného jazyka (NLP) v AI, zaměřenou na identifikaci a klasifikaci entit v textu do...