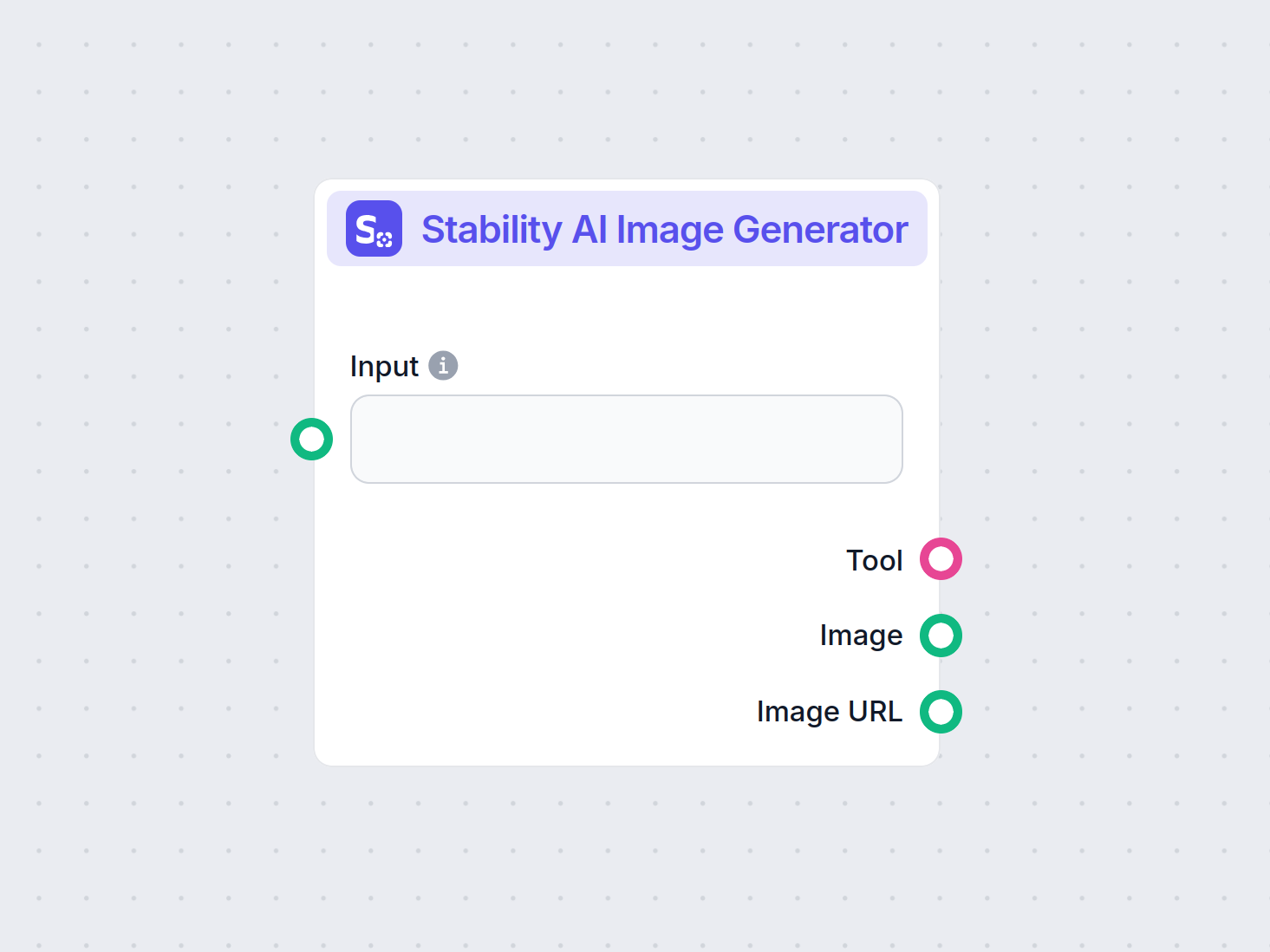

Generátor obrázků Stability AI

Generujte vysoce kvalitní obrázky z textových zadání pomocí komponenty Generátor obrázků Stability AI. Poháněno modely Stable Diffusion, tento nástroj nabízí na...

Stable Diffusion je špičkový AI model pro převod textu na obrázek, který umožňuje uživatelům generovat fotorealistické vizuály z promptů pomocí pokročilých technik latentní difuze a hlubokého učení.

Stable Diffusion je AI model na převod textu na obrázek, který vytváří vysoce kvalitní obrázky z popisů pomocí hlubokého učení. Využívá techniky jako negativní prompty a referenční obrázky pro lepší výsledky, zejména u složitých prvků, jako jsou ruce.

Stable Diffusion je pokročilý model pro generování obrázků z textových popisů, který využívá techniky hlubokého učení k tvorbě vysoce kvalitních, fotorealistických obrázků. Byl vyvinut jako latentní difuzní model a představuje významný průlom v oblasti generativní umělé inteligence, protože kombinuje principy difuzních modelů a strojového učení pro tvorbu obrázků co nejvíce odpovídajících zadaným textovým promptům.

Stable Diffusion využívá hluboké učení a difuzní modely k vytváření obrázků tím, že postupně odstraňuje náhodný šum, až vznikne koherentní vizuál. Přestože byl model trénován na milionech obrázků, stále má potíže se složitými prvky, jako jsou ruce. Postupem času, jak jsou modely trénovány na stále větších datasetech, tyto problémy ubývají a kvalita obrázků je stále realističtější.

Jednou z účinných metod, jak řešit problém s rukama, je využití negativních promptů. Přidáním frází jako (-bad anatomy) nebo (-bad hands -unnatural hands) ke svým promptům můžete AI instruovat, aby se vyhnula deformovaným rysům. Dávejte však pozor, abyste negativní prompty nepoužívali příliš často, protože mohou omezit kreativitu modelu.

Další technikou je použití referenčních obrázků pro navedení AI. Zahrnutím tagu {image} s odkazem na referenční obrázek do promptu poskytnete AI vizuální šablonu pro přesné vykreslení rukou. To je obzvlášť užitečné pro zachování správných proporcí a pozic rukou.

Pro nejkvalitnější výsledek zkombinujte negativní prompty i referenční obrázky. Tento dvojí přístup zajistí, že AI se vyhne běžným chybám a zároveň se bude držet kvalitních příkladů.

(-bent fingers) nebo (realistic perspectives), abyste ještě více vylepšili vykreslení rukou.Ovládnutím těchto technik můžete výrazně zlepšit vykreslení rukou ve svých výtvorech Stable Diffusion a dosáhnout uměleckého díla s precizností zkušeného umělce. Připravte si referenční obrázky, tvořte přesné prompty a sledujte, jak se vaše AI umění vyvíjí!

Základní princip Stable Diffusion spočívá v převodu textových promptů na vizuální reprezentace prostřednictvím řady výpočetních procesů. Porozumění jeho funkčnosti zahrnuje koncepty difuzních modelů, latentních prostorů a neuronových sítí.

Difuzní modely jsou třída generativních modelů ve strojovém učení, které se učí vytvářet data obrácením procesu difuze. Tento proces spočívá v postupném přidávání šumu do dat – například obrázků – až jsou k nerozeznání od náhodného šumu. Model se pak učí tento proces obrátit, tedy krok za krokem šum odstraňovat, až obnoví původní data. Tento reverzní difuzní proces je klíčový pro generování nových, koherentních dat z náhodného šumu.

Stable Diffusion konkrétně využívá latentní difuzní model. Na rozdíl od tradičních difuzních modelů, které pracují přímo v obrazovém prostoru s vysokou dimenzionalitou, latentní difuzní modely fungují v komprimovaném latentním prostoru. Tento prostor je nižší dimenzionální reprezentací dat, která zachycuje podstatné rysy a zároveň snižuje výpočetní náročnost. Prací v latentním prostoru dokáže Stable Diffusion generovat obrázky ve vysokém rozlišení efektivněji.

Jádrem Stable Diffusion je reverzní proces difuze v latentním prostoru. Začíná se náhodným šumem v latentním vektoru, model tento vektor iterativně zpřesňuje tím, že v každém kroku odhaduje a odstraňuje šum. Toto zpřesňování je řízeno textovým popisem zadaným uživatelem. Proces pokračuje, dokud se latentní vektor neustálí do stavu, z něhož dekodér vytvoří obrázek odpovídající textovému promptu.

Architektura Stable Diffusion kombinuje několik klíčových komponent, které společně převádí textové prompty na obrázky.

VAE slouží jako enkodér-dekodér, který komprimuje obrázky do latentního prostoru a rekonstruuje je zpět. Enkodér převede obrázek do jeho latentní reprezentace, která v sobě nese základní rysy v zjednodušené podobě. Dekodér tuto latentní reprezentaci převádí zpět na detailní obrázek.

Tento postup je zásadní, protože modelu umožňuje pracovat s daty nižší dimenze a výrazně tak snižuje výpočetní náročnost oproti práci v plném obrazovém prostoru.

U-Net je speciální architektura neuronové sítě používaná ve Stable Diffusion pro úlohy zpracování obrazu. Skládá se z enkodovací a dekodovací větve se skip spojeními mezi zrcadlovými vrstvami. V kontextu Stable Diffusion U-Net slouží jako prediktor šumu během reverzního difuzního procesu.

V každém kroku difuzního procesu U-Net předpovídá množství šumu v latentní reprezentaci. Tento odhad se pak použije k upřesnění latentního vektoru odečtením odhadovaného šumu, čímž se latentní prostor postupně odšumuje směrem k obrázku odpovídajícímu textovému promptu.

Pro zapojení textových informací využívá Stable Diffusion textový enkodér založený na modelu CLIP (Contrastive Language-Image Pretraining). CLIP je navržen tak, aby porozuměl a propojil textová a vizuální data tím, že je mapuje do společného latentního prostoru.

Když uživatel zadá textový prompt, textový enkodér jej převede na embeddingy – číselné reprezentace textových dat. Tyto embeddingy podmiňují U-Net během reverzního difuzního procesu a řídí generování obrázku tak, aby odrážel obsah textového promptu.

Stable Diffusion nabízí všestrannost v generování obrázků a lze jej využít různými způsoby podle potřeb uživatelů.

Primárním využitím Stable Diffusion je generování obrázků z textových promptů. Uživatel zadá popisný text a model vytvoří obrázek, který tento popis reprezentuje. Například uživatel může zadat „Poklidná pláž při západu slunce s palmami“ a získat obrázek této scény.

Tato schopnost je zvlášť cenná v kreativních odvětvích, tvorbě obsahu a designu, kde je rychlá vizualizace konceptů klíčová.

Kromě tvorby obrázků od nuly dokáže Stable Diffusion také upravovat existující obrázky na základě textových instrukcí. Zadáním původního obrázku a textového promptu vytvoří model nový obrázek, který zahrnuje změny popsané v textu.

Například uživatel zadá obrázek denního městského panoramatu s promptem „změnit na noční scénu s neonovými světly“ a výsledkem je obrázek s těmito úpravami.

Inpainting znamená vyplnění chybějících nebo poškozených částí obrázku. Stable Diffusion je v této oblasti velmi schopný a využívá textové prompty k navádění rekonstrukce konkrétních oblastí obrázku. Uživatelé mohou zamaskovat část obrázku a popsat textem, co by mělo být do prostoru doplněno.

Tato funkce je užitečná při restaurování fotografií, odstraňování nežádoucích objektů nebo úpravě konkrétních prvků při zachování celkové soudržnosti.

Generováním sekvencí obrázků s drobnými variacemi lze Stable Diffusion rozšířit i na tvorbu animací nebo video obsahu. Nástroje jako Deforum rozšiřují schopnosti Stable Diffusion pro tvorbu dynamického vizuálního obsahu řízeného textovými prompty v čase.

Otevírá to možnosti v animaci, vizuálních efektech a dynamické tvorbě obsahu bez nutnosti tradiční snímkové animace.

Schopnost Stable Diffusion generovat obrázky z textových popisů z něj činí mocný nástroj ve vývoji AI automatizace a chatbotů.

Začleněním Stable Diffusion do chatbotů lze generovat vizuální obsah v reakci na dotazy uživatelů. Například v zákaznické podpoře může chatbot na míru generovat vizuální návody nebo ilustrace.

Textové prompty jsou převáděny na embeddingy pomocí textového enkodéru CLIP. Tyto embeddingy jsou zásadní pro podmínění procesu generování obrázku a zajišťují, že výstup odpovídá textovému popisu uživatele.

Reverzní difuzní proces zahrnuje opakované zpřesňování latentní reprezentace odebíráním předpokládaného šumu. V každém kroku model zohledňuje textové embeddingy a aktuální stav latentního vektoru k přesné predikci šumové složky.

Schopnost modelu pracovat s šumem pramení z jeho tréninku na velkých datasetech, kde se naučil rozpoznávat a efektivně odšumovat obrázky. Díky tomu dokáže generovat čisté obrázky i z náhodného šumu.

Práce v latentním prostoru je výpočetně efektivní. Protože latentní prostor má méně rozměrů než obrazový prostor, jsou operace méně náročné na zdroje. Díky tomu dokáže Stable Diffusion generovat obrázky ve vysokém rozlišení bez přehnaných výpočetních nároků.

Umělci a designéři mohou Stable Diffusion využít pro rychlý prototyp vizuálů podle konceptuálních popisů, což urychluje kreativní proces a zkracuje cestu od nápadu k vizualizaci.

Marketingové týmy mohou generovat vlastní obrázky pro kampaně, sociální sítě a reklamy bez nutnosti rozsáhlých grafických zdrojů.

Vývojáři her mohou vytvářet assety, prostředí i koncept arty zadáváním popisných promptů, což zjednodušuje pipeline tvorby assetů.

Obchodníci mohou generovat obrázky produktů v různých prostředích či konfiguracích, což zlepšuje vizualizaci produktů a zákaznický zážitek.

Učitelé a tvůrci obsahu mohou vytvářet ilustrace a schémata pro vysvětlení složitých konceptů a zatraktivnit studijní materiály.

Výzkumníci v umělé inteligenci a počítačovém vidění mohou Stable Diffusion využít k dalšímu zkoumání možností difuzních modelů a latentních prostorů.

Pro efektivní využití Stable Diffusion je třeba vzít v úvahu určité technické aspekty.

Pro začátek práce se Stable Diffusion postupujte následovně:

Pro vývojáře budující AI automatizační systémy a chatboty lze Stable Diffusion integrovat pro rozšíření funkcionality.

Při používání Stable Diffusion je důležité myslet na etické souvislosti.

Stable diffusion je významné téma v oblasti generativních modelů, zejména pro augmentaci dat a syntézu obrázků. Nedávné studie zkoumají různé aspekty stable diffusion a poukazují na jeho aplikace a efektivitu.

Diffusion Least Mean P-Power Algorithms for Distributed Estimation in Alpha-Stable Noise Environments od Fuxi Wen (2013):

Představuje difuzní algoritmus nejmenších středních p-mocnin (LMP) pro distribuované odhady v prostředích s alfa-stabilním šumem. Studie srovnává difuzní LMP metodu s algoritmem nejmenších čtverců (LMS) a prokazuje lepší výkonnost v alfa-stabilních šumových podmínkách. Tento výzkum je klíčový pro vývoj robustních odhadovacích technik v šumových prostředích. Více zde

Stable Diffusion for Data Augmentation in COCO and Weed Datasets od Boyang Deng (2024):

Zkoumá využití stable diffusion modelů pro generování syntetických obrázků ve vysokém rozlišení a zlepšení malých datasetů. Využitím technik jako Image-to-image translation, Dreambooth a ControlNet hodnotí efektivitu stable diffusion pro úlohy klasifikace a detekce. Výsledky naznačují slibné aplikace stable diffusion v různých oborech. Více zde

Diffusion and Relaxation Controlled by Tempered α-stable Processes od Aleksander Stanislavsky, Karina Weron, a Aleksander Weron (2011):

Odvozuje vlastnosti anomální difuze a neexponenciální relaxace pomocí temperovaných α-stabilních procesů. Řeší problém nekonečných momentů spojených s α-stabilním operačním časem a poskytuje model, který zahrnuje subdifuzi jako speciální případ. Více zde

Evaluating a Synthetic Image Dataset Generated with Stable Diffusion od Andreas Stöckl (2022):

Hodnotí syntetické obrázky generované modelem Stable Diffusion pomocí taxonomie Wordnet. Posuzuje schopnost modelu generovat správné obrázky pro různé koncepty a ilustruje rozdíly v přesnosti reprezentace. Tato hodnocení jsou zásadní pro pochopení úlohy stable diffusion v augmentaci dat. Více zde

Comparative Analysis of Generative Models: Enhancing Image Synthesis with VAEs, GANs, and Stable Diffusion od Sanchayan Vivekananthan (2024):

Zkoumá tři generativní frameworky: VAEs, GANs a Stable Diffusion modely. Výzkum zdůrazňuje silné i slabé stránky jednotlivých modelů a konstatuje, že zatímco VAEs a GANs mají své výhody, stable diffusion vyniká v určitých úlohách syntézy. Více zde

Podívejme se, jak implementovat Stable Diffusion model v Pythonu pomocí knihovny Hugging Face Diffusers.

Nainstalujte požadované knihovny:

pip install torch transformers diffusers accelerate

pip install xformers # Volitelné

Knihovna Diffusers poskytuje jednoduchý způsob načtení předtrénovaných modelů:

from diffusers import StableDiffusionPipeline

import torch

# Načtěte Stable Diffusion model

model_id = "stabilityai/stable-diffusion-2-1"

pipe = StableDiffusionPipeline.from_pretrained(model_id, torch_dtype=torch.float16)

pipe = pipe.to("cuda") # Přesuňte model na GPU pro rychlejší inference

Pro generování obrázku jednoduše zadejte textový prompt:

prompt = "Poklidná krajina s horami a jezerem, fotorealistické, 8K rozlišení"

image = pipe(prompt).images[0]

# Uložení nebo zobrazení obrázku

image.save("generated_image.png")

model_id.torch.float16 šetří paměť.Můžete upravovat různé parametry:

image = pipe(

prompt=prompt,

num_inference_steps=50, # Počet kroků odšumování

guidance

Stable Diffusion je pokročilý AI model určený pro generování vysoce kvalitních, fotorealistických obrázků z textových promptů. Využívá latentní difuzi a hluboké učení k převodu textových popisů na vizuály.

Stable Diffusion převádí textové prompty na embeddingy obrázků pomocí CLIP textového enkodéru, poté iterativně odšumuje latentní reprezentaci řízenou promptem, což vede ke koherentnímu obrazovému výstupu.

Stable Diffusion se používá pro kreativní generování obsahu, marketingové materiály, tvorbu herních assetů, vizualizaci produktů v e-commerce, vzdělávací ilustrace a AI chatbota.

Ano, Stable Diffusion podporuje převod obrázku na obrázek i doplňování obrázků (inpainting), což uživatelům umožňuje měnit existující obrázky nebo vyplňovat chybějící části na základě textových promptů.

Pro efektivní generování obrázků pomocí Stable Diffusion je doporučen počítač s moderním GPU. Model také vyžaduje Python a knihovny jako PyTorch a Diffusers.

Ano, Stable Diffusion je vydán pod permisivní open-source licencí, což podporuje přispívání komunity, přizpůsobení a širokou dostupnost.

Popusťte uzdu své kreativitě se Stable Diffusion a sledujte, jak AI promění vaše nápady v úchvatné vizuály.

Generujte vysoce kvalitní obrázky z textových zadání pomocí komponenty Generátor obrázků Stability AI. Poháněno modely Stable Diffusion, tento nástroj nabízí na...

Prozkoumejte naši podrobnou recenzi Stability AI SD3 Large. Analyzujte jeho silné a slabé stránky a kreativní výstupy napříč různorodými textovými zadáními. Obj...

Flux AI Model od Black Forest Labs je pokročilý systém pro převod textu na obrázky, který mění přirozené jazykové podněty na vysoce detailní, fotorealistické sn...