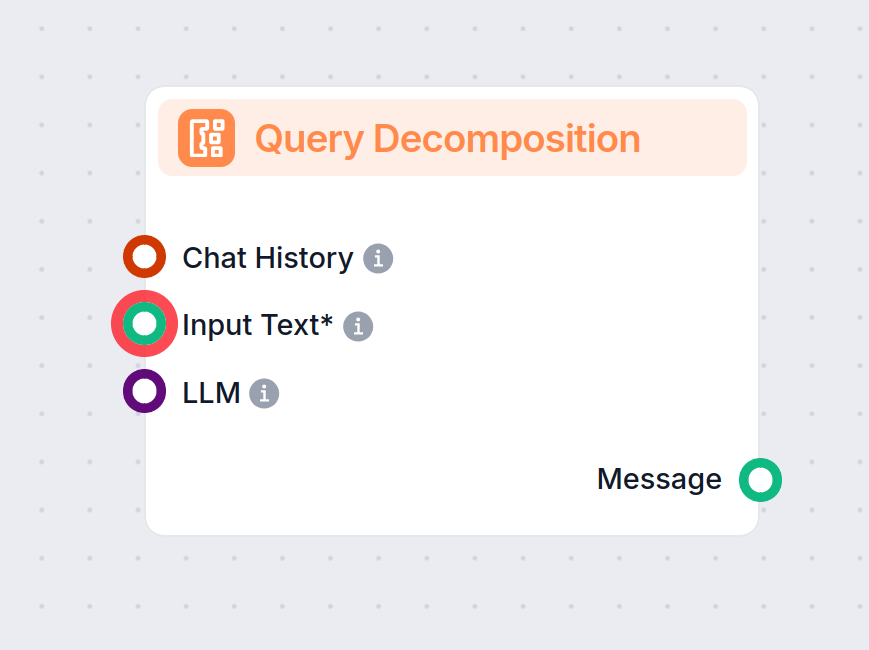

Forespørgselsopdelingskomponent

Forespørgselsopdeling er en flow-komponent, der er designet til at øge præcisionen og effektiviteten i AI-drevne arbejdsgange ved at bryde komplekse inputforespørgsler ned i adskilte, håndterbare underforespørgsler. Denne proces sikrer, at alle aspekter af en brugers oprindelige spørgsmål bliver adresseret, hvilket fører til mere grundige og præcise svar.

Hvad gør denne komponent?

Den primære funktion for Forespørgselsopdelingskomponenten er at tage en inputtekst—typisk et komplekst eller flerleddet spørgsmål—og opdele det i flere alternative eller underforespørgsler. Disse underforespørgsler repræsenterer de enkelte informationsdele, der skal løses for at kunne besvare den oprindelige forespørgsel fuldt ud. Denne tilgang er især nyttig i situationer, hvor et spørgsmål er bredt, tvetydigt eller sammensat af flere sammenflettede elementer.

Nøglefunktioner og input

| Inputnavn | Type | Påkrævet | Beskrivelse |

|---|---|---|---|

| Inputtekst | Besked | Ja | Den vigtigste tekst eller det spørgsmål, du vil opdele i flere alternative forespørgsler. |

| Chat-historik | InMemoryChatMessageHistory | Nej | Tidligere chatbeskeder til at give kontekst for mere præcise underforespørgsler. |

| LLM (Model) | BaseChatModel | Nej | Sprogsmodellen der anvendes til at generere alternative forespørgsler. |

| Inkludér oprindelig forespørgsel | Boolean | Nej | Mulighed for at inkludere den oprindelige forespørgsel i listen over alternative forespørgsler. |

| Systembesked | String | Nej | Yderligere systeminstruktion, der kan tilføjes prompten for at tilpasse adfærden. |

- Inputtekst (påkrævet): Teksten der skal analyseres og opdeles. Dette er selve brugerens spørgsmål.

- Chat-historik: (valgfrit) Hvis tilgængelig, kan den tidligere samtalekontekst tilføjes for at øge relevansen og præcisionen af de genererede underforespørgsler.

- LLM (Model): (valgfrit) Angiv hvilken stor sprogmodel (LLM) der skal bruges til opdelingsprocessen og muliggør fleksibel integration med forskellige AI-modeller.

- Inkludér oprindelig forespørgsel: (avanceret, valgfrit) Kontroller om outputtet også skal indeholde den oprindelige forespørgsel sammen med de genererede underforespørgsler.

- Systembesked: (avanceret, valgfrit) Giver mulighed for at tilføje en brugerdefineret systembesked, der kan styre output eller give yderligere instruktioner til modellen.

Output

- Besked: Komponenten leverer et beskedobjekt med en liste over alternative forespørgsler eller underspørgsmål. Dette kan bruges som input til efterfølgende AI-processer, såsom separat besvarelse, informationssøgning eller yderligere analyse.

Hvorfor er dette nyttigt?

Forespørgselsopdeling er værdifuld i komplekse AI-arbejdsgange, hvor enkelte forespørgsler kan dække flere emner eller kræve trinvis ræsonnement. Ved at opdele forespørgsler kan du:

- Sikre at alle dele af et komplekst spørgsmål bliver adresseret.

- Muliggøre mere præcis søgning eller informationsindsamling.

- Understøtte modulær, trinvis behandling i AI-pipelines.

- Forbedre gennemsigtigheden og forklarligheden af AI-genererede svar.

Eksempler på anvendelse

- Kundesupport: Opdeling af en lang kundehenvendelse i individuelle problemstillinger for mere målrettede svar.

- Forskningsassistance: Opdeling af et bredt forskningsspørgsmål i specifikke underemner for mere fokuserede litteratursøgninger.

- Trinvis ræsonnement: Forberedelse af spørgsmål til AI-agenter, der kræver sekventiel problemløsning eller planlægning.

Oversigtstabel

| Funktion | Beskrivelse |

|---|---|

| Input | Kompleks brugerforespørgsel (tekst) |

| Output | Liste over alternative/underforespørgsler (som beskedobjekt) |

| Kontekstsupport | Ja (via chat-historik) |

| Modvalg | Ja (brugerdefineret LLM kan angives) |

| Avancerede muligheder | Inkludér oprindelig forespørgsel, brugerdefineret systembesked |

Ved at integrere Forespørgselsopdeling i din AI-arbejdsgang muliggør du smartere og mere detaljeret håndtering af komplekse forespørgsler, hvilket fører til bedre resultater og en forbedret brugeroplevelse.