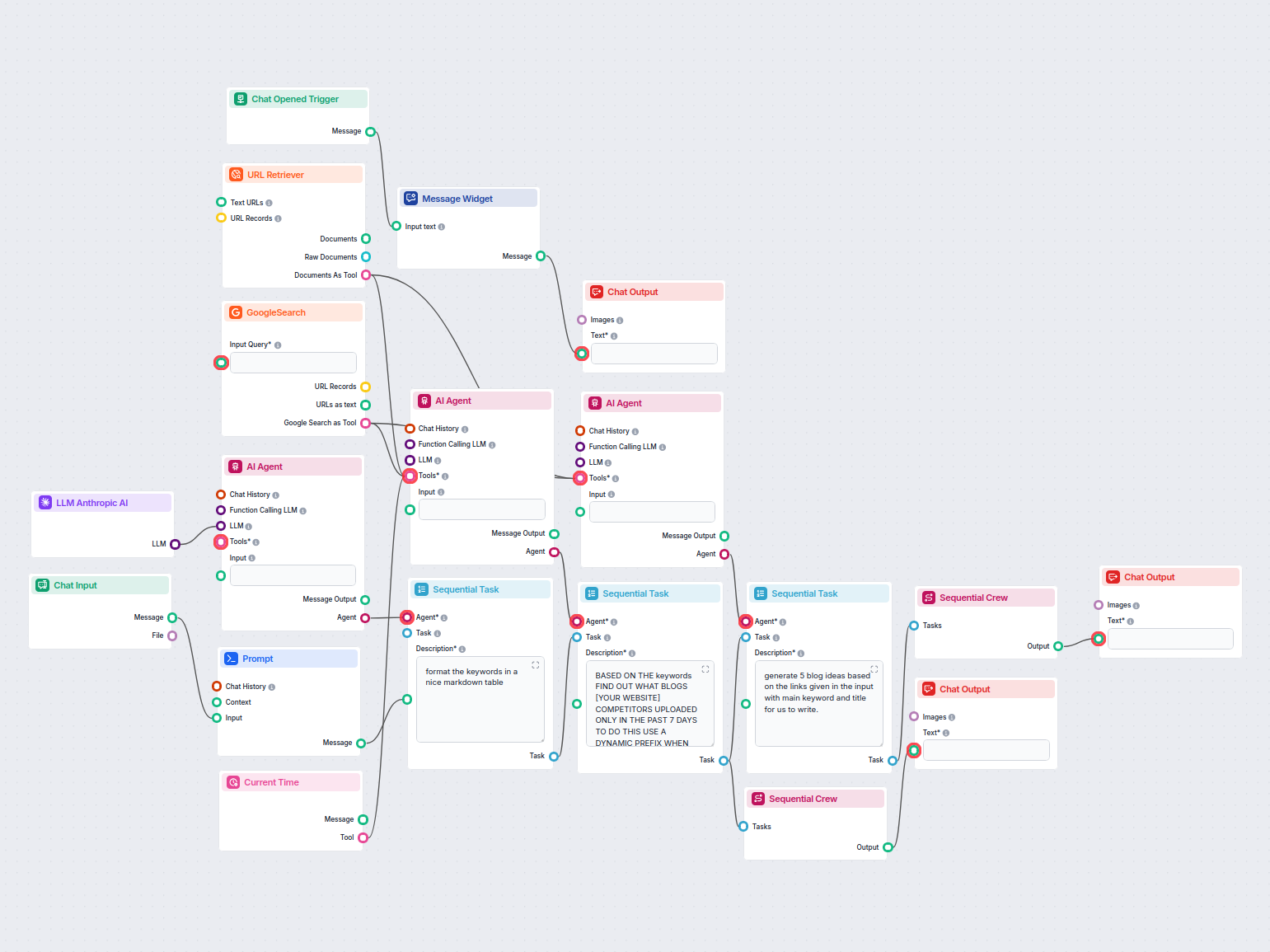

AI Blog Idégenerator til Konkurrent- & Trendanalyse

Dette AI-drevne workflow undersøger konkurrenter og trends for at generere virkningsfulde, SEO-optimerede blogideer til FlowHunt.io. Ved at bruge Google-søgning...

Forbind Anthropics Claude-modeller til dit FlowHunt-dashboard for fleksibel AI-tekstgenerering og chatbot-løsninger med kontrol over tokens, temperatur og modelvalg.

Komponentbeskrivelse

Forskellige opgaver kræver forskellige modeller, og FlowHunt er dedikeret til at give dig det bedste fra AI uden behov for at tilmelde dig et utal af abonnementer. I stedet får du dusinvis af tekst- og billedgenerator-modeller i ét enkelt dashboard. LLM-typen af komponenter rummer tekstgenerering og deres forskellige anvendelser i AI, indholdsskabelse og automatisering") modeller grupperet efter udbyder, så du kan skifte AI-modeller undervejs.

LLM Anthropic AI-komponenten forbinder Claude-familien af modeller til dit flow. Selvom det er Generatorer og Agenter, hvor den egentlige magi sker, gør LLM-komponenter det muligt at styre, hvilken model der anvendes. Alle komponenter leveres som standard med ChatGPT-4. Du kan forbinde denne komponent, hvis du ønsker at ændre modellen eller få mere kontrol over den.

Husk, at det er valgfrit at forbinde en LLM-komponent. Alle komponenter, der bruger en LLM, kommer som standard med ChatGPT-4o. LLM-komponenterne gør det muligt at ændre modellen og styre modelindstillinger.

Tokens repræsenterer de individuelle enheder af tekst, som modellen behandler og genererer. Token-forbrug varierer mellem modeller, og et enkelt token kan være alt fra ord eller underord til ét enkelt tegn. Modeller prissættes normalt i millioner af tokens.

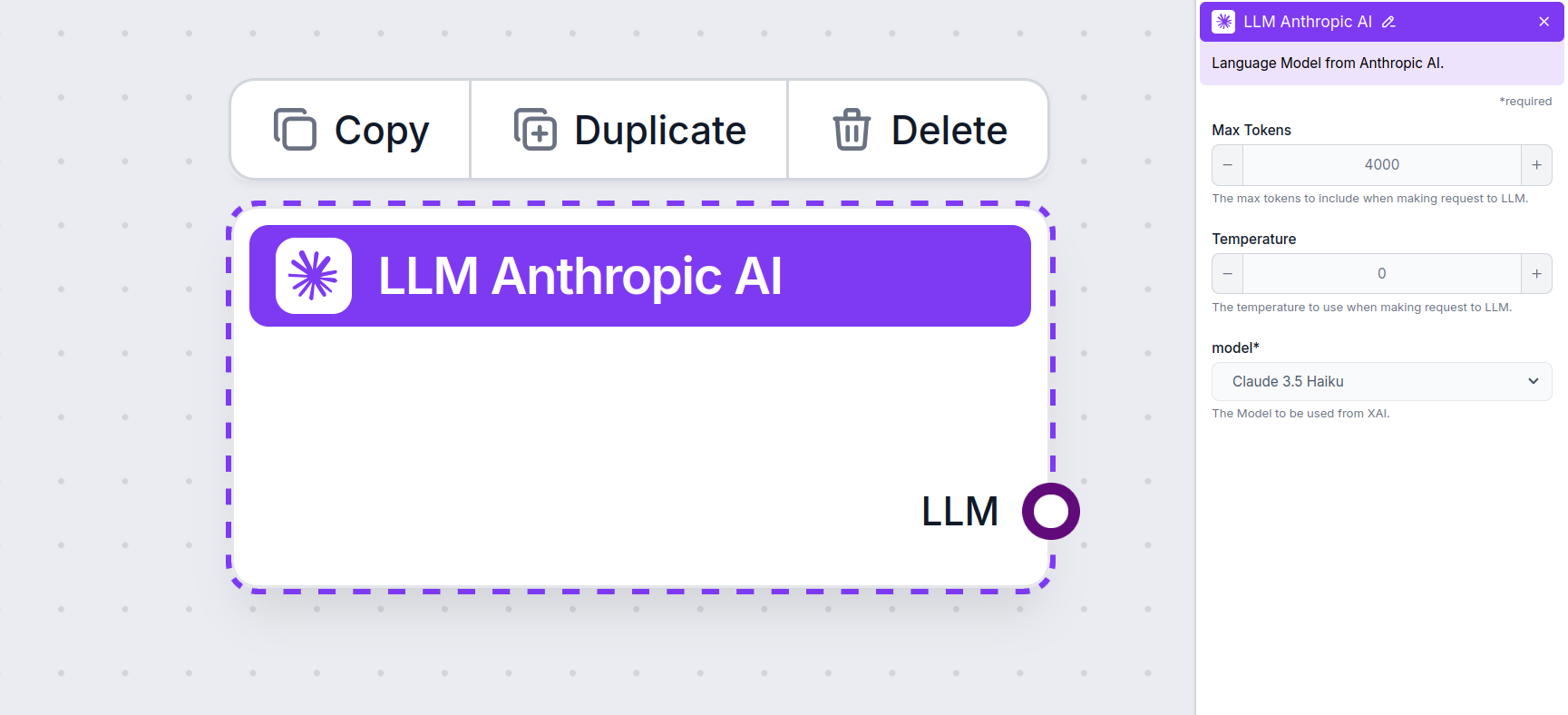

Indstillingen for maks. tokens begrænser det samlede antal tokens, der kan behandles i en enkelt interaktion eller forespørgsel, så svarene genereres inden for rimelige rammer. Standardgrænsen er 4.000 tokens, hvilket er den optimale størrelse til at opsummere dokumenter og flere kilder for at generere et svar.

Temperatur styrer variationen i svarene og spænder fra 0 til 1.

For eksempel anbefales en temperatur mellem 0,2 og 0,5 til en kundeservicebot. Dette niveau holder svarene relevante og til manuskriptet, samtidig med at det tillader naturlig variation.

Dette er modelvælgeren. Her finder du alle de understøttede modeller fra Anthropic. Vi understøtter i øjeblikket alle de nyeste modeller fra Claude-familien:

Du vil bemærke, at alle LLM-komponenter kun har et output-håndtag. Input går ikke gennem komponenten, da den kun repræsenterer modellen, mens selve genereringen sker i AI Agenter og Generatorer.

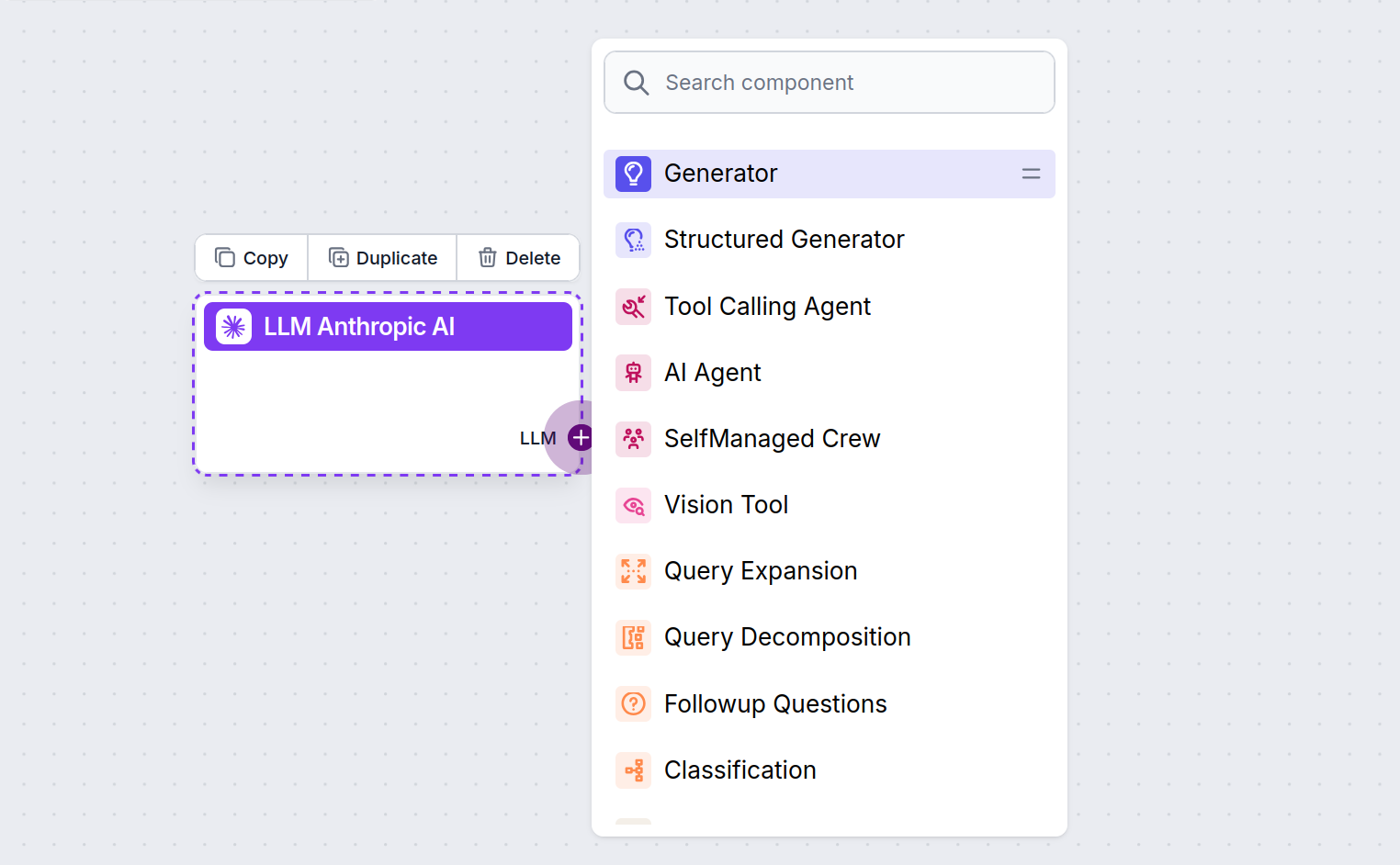

LLM-håndtaget er altid lilla. LLM-inputhåndtaget findes på enhver komponent, der bruger AI til at generere tekst eller behandle data. Du kan se mulighederne ved at klikke på håndtaget:

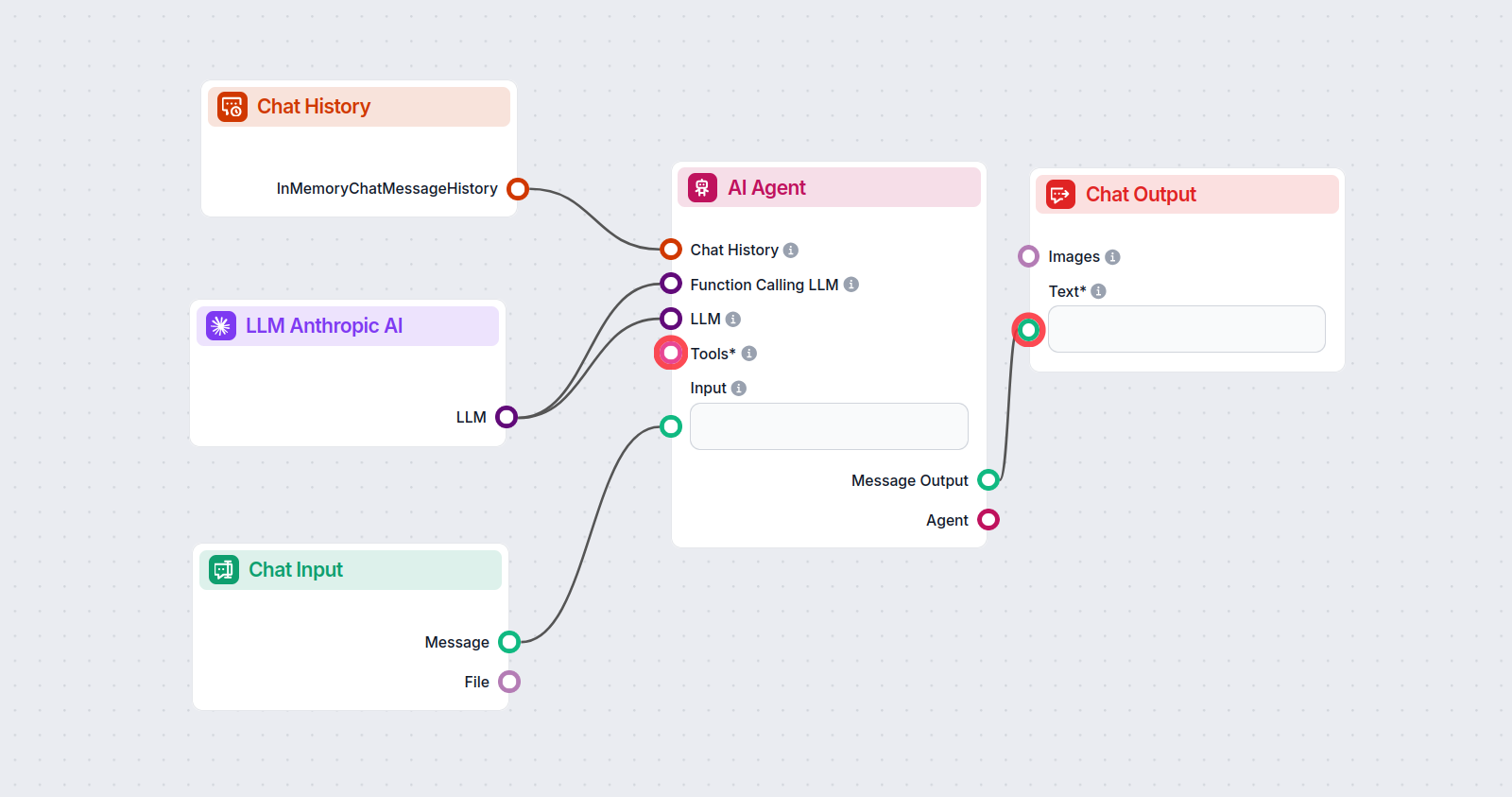

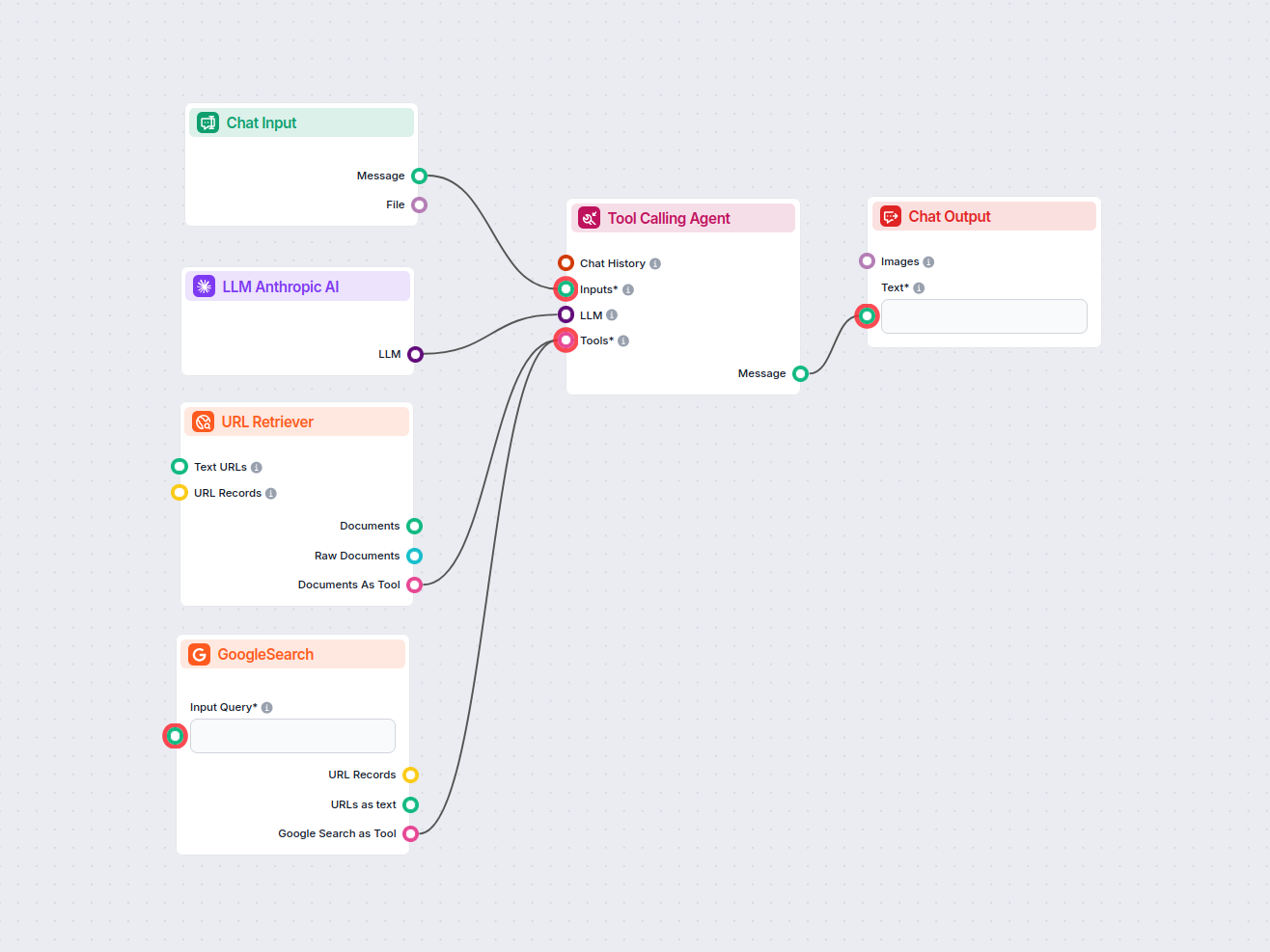

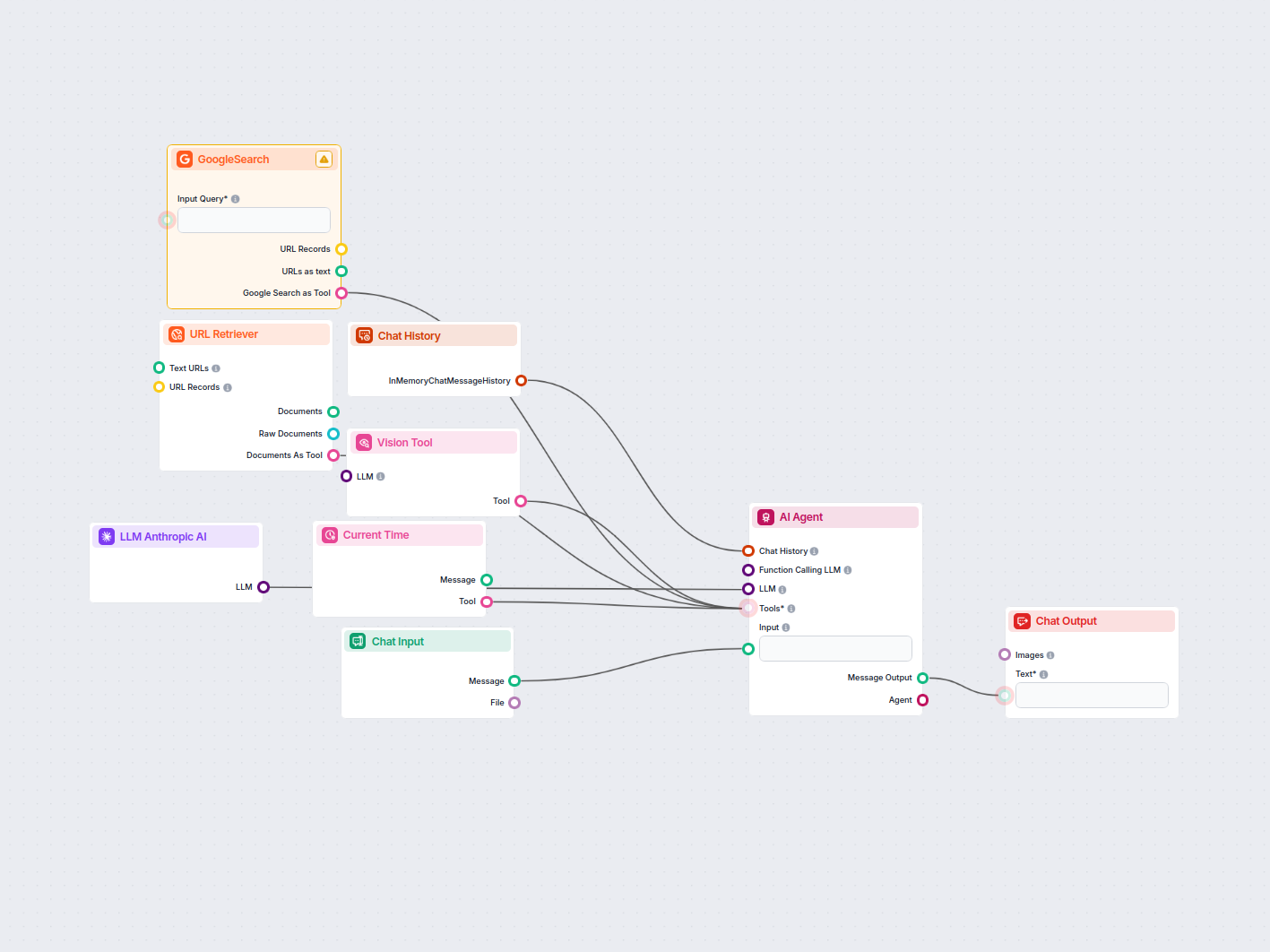

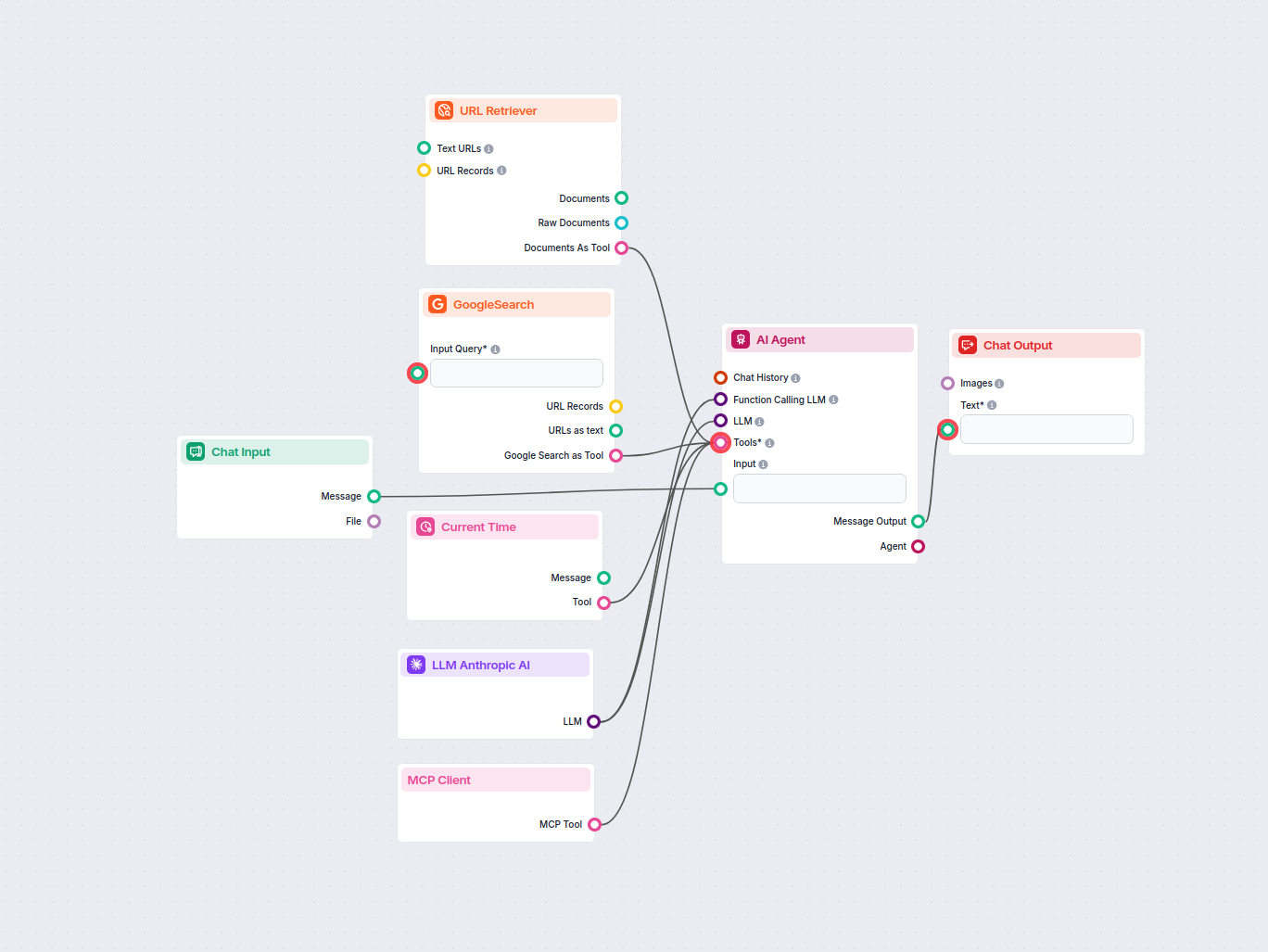

Dette giver dig mulighed for at skabe alle slags værktøjer. Lad os se komponenten i aktion. Her er et simpelt AI Agent chatbot-flow, der bruger Anthropics Claude 3.5 Sonnet til at generere svar. Du kan tænke på det som en grundlæggende Anthropic-chatbot.

Dette simple Chatbot-flow inkluderer:

For at hjælpe dig med at komme hurtigt i gang, har vi forberedt flere eksempel-flow-skabeloner, der demonstrerer, hvordan du bruger LLM Anthropic AI-komponenten effektivt. Disse skabeloner viser forskellige brugssituationer og bedste praksis, hvilket gør det lettere for dig at forstå og implementere komponenten i dine egne projekter.

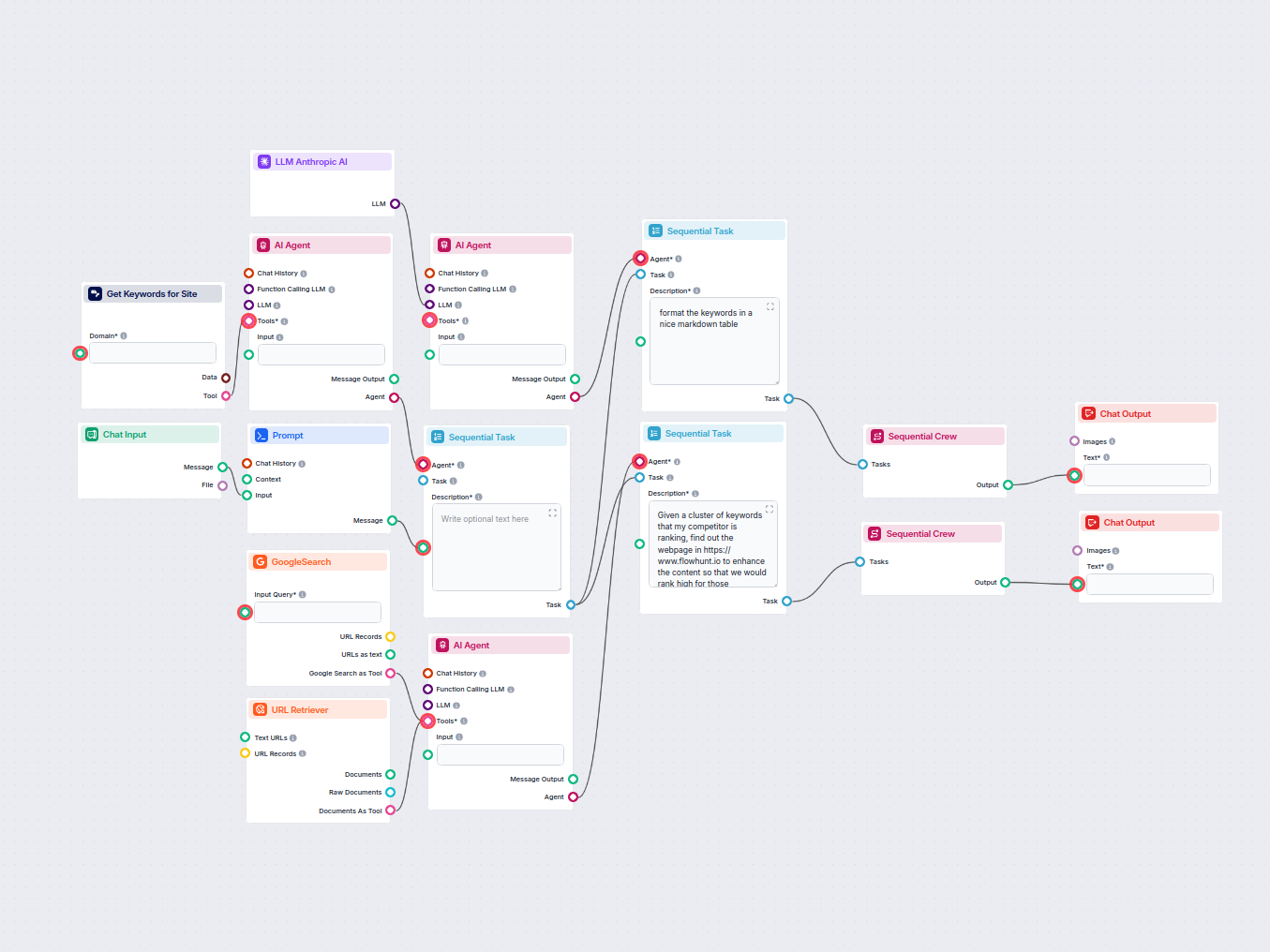

Dette AI-drevne workflow undersøger konkurrenter og trends for at generere virkningsfulde, SEO-optimerede blogideer til FlowHunt.io. Ved at bruge Google-søgning...

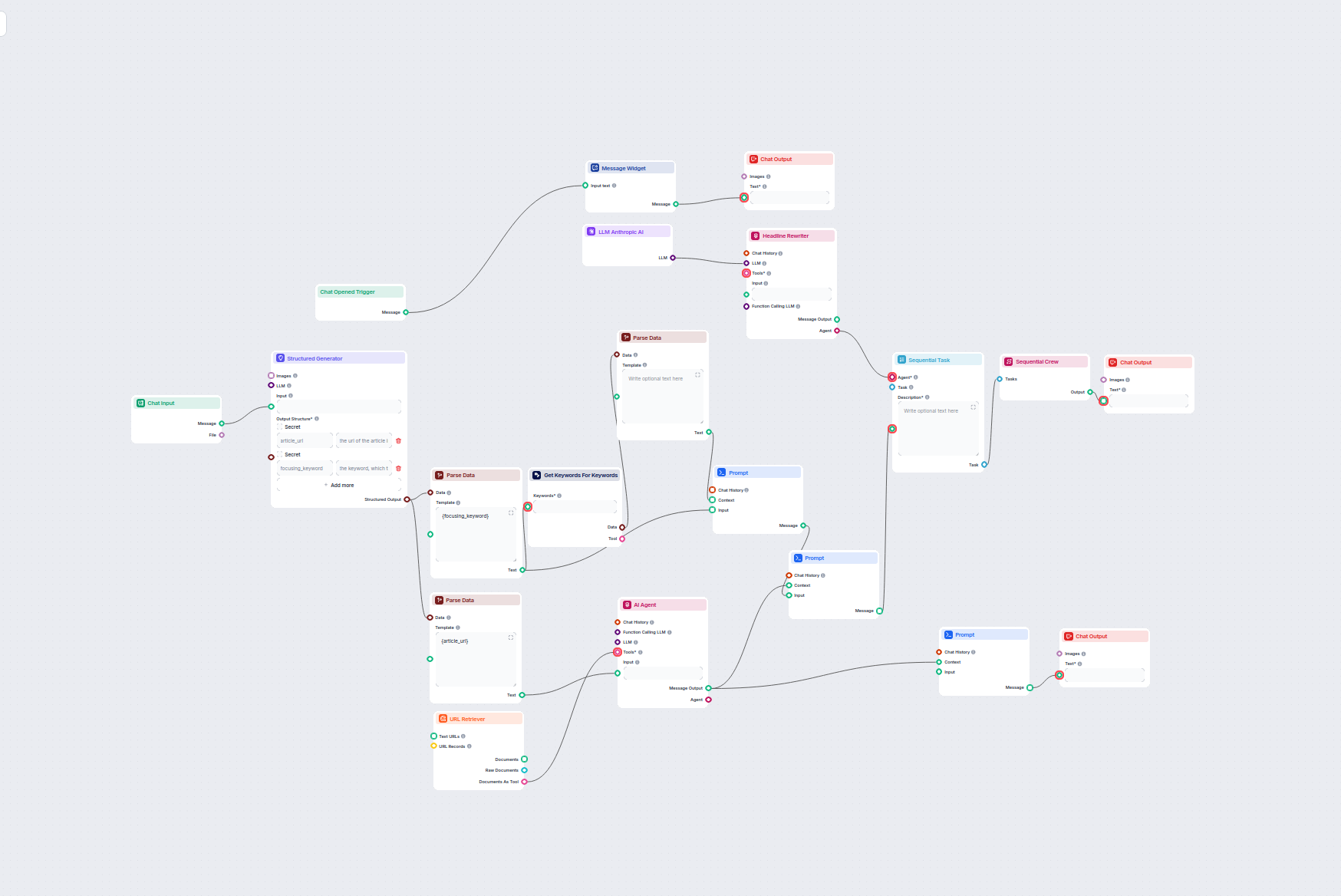

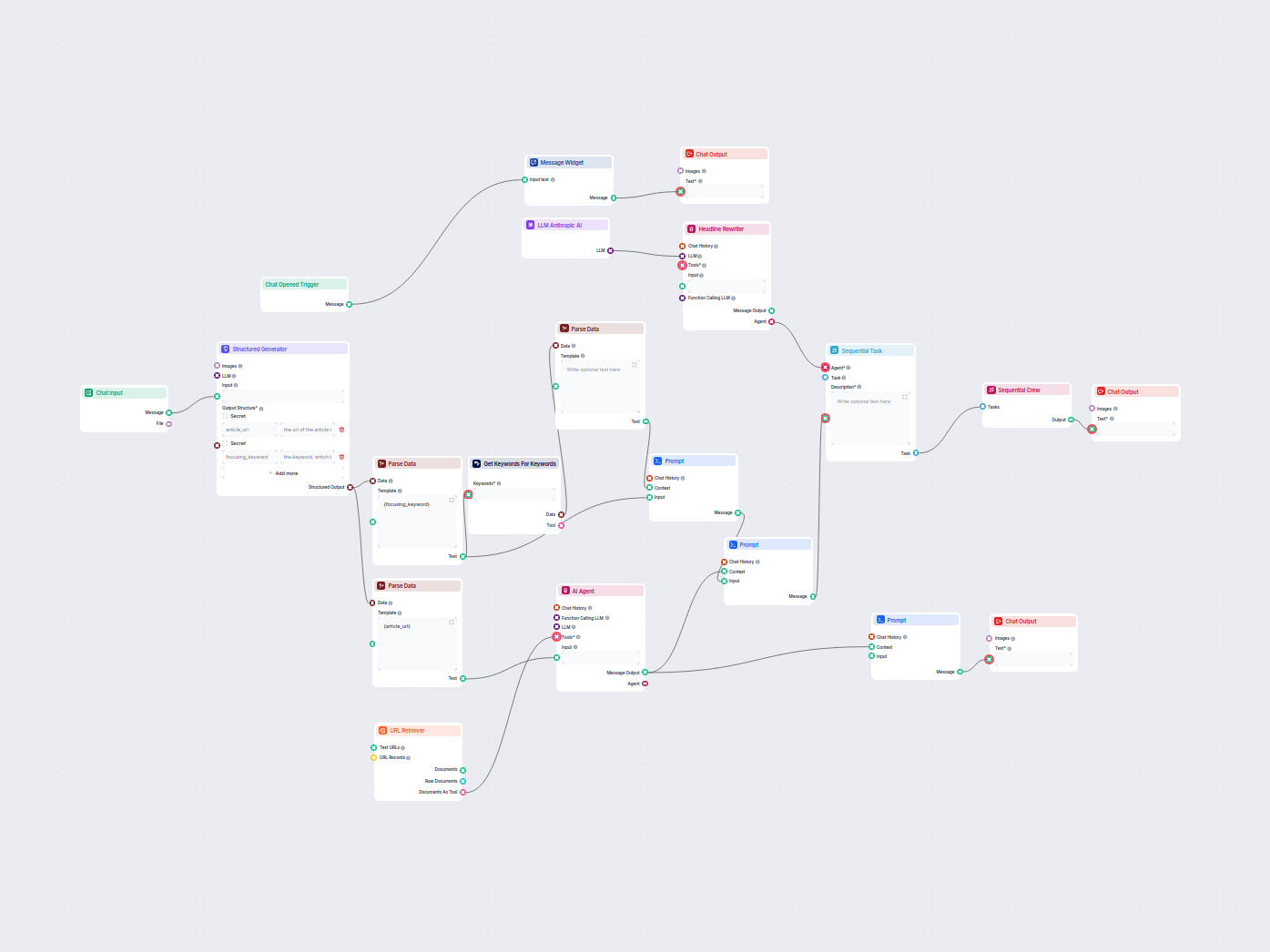

Dette AI-drevne workflow finder de bedste SEO-søgeord til din blogartikel og omskriver automatisk overskrifterne, så de målretter disse søgeord, hvilket forbedr...

Generer automatisk SEO-optimerede beskrivelser til e-handelskategori-sider ved hjælp af AI. Angiv blot en kategori-URL, og arbejdsgangen undersøger kategorien, ...

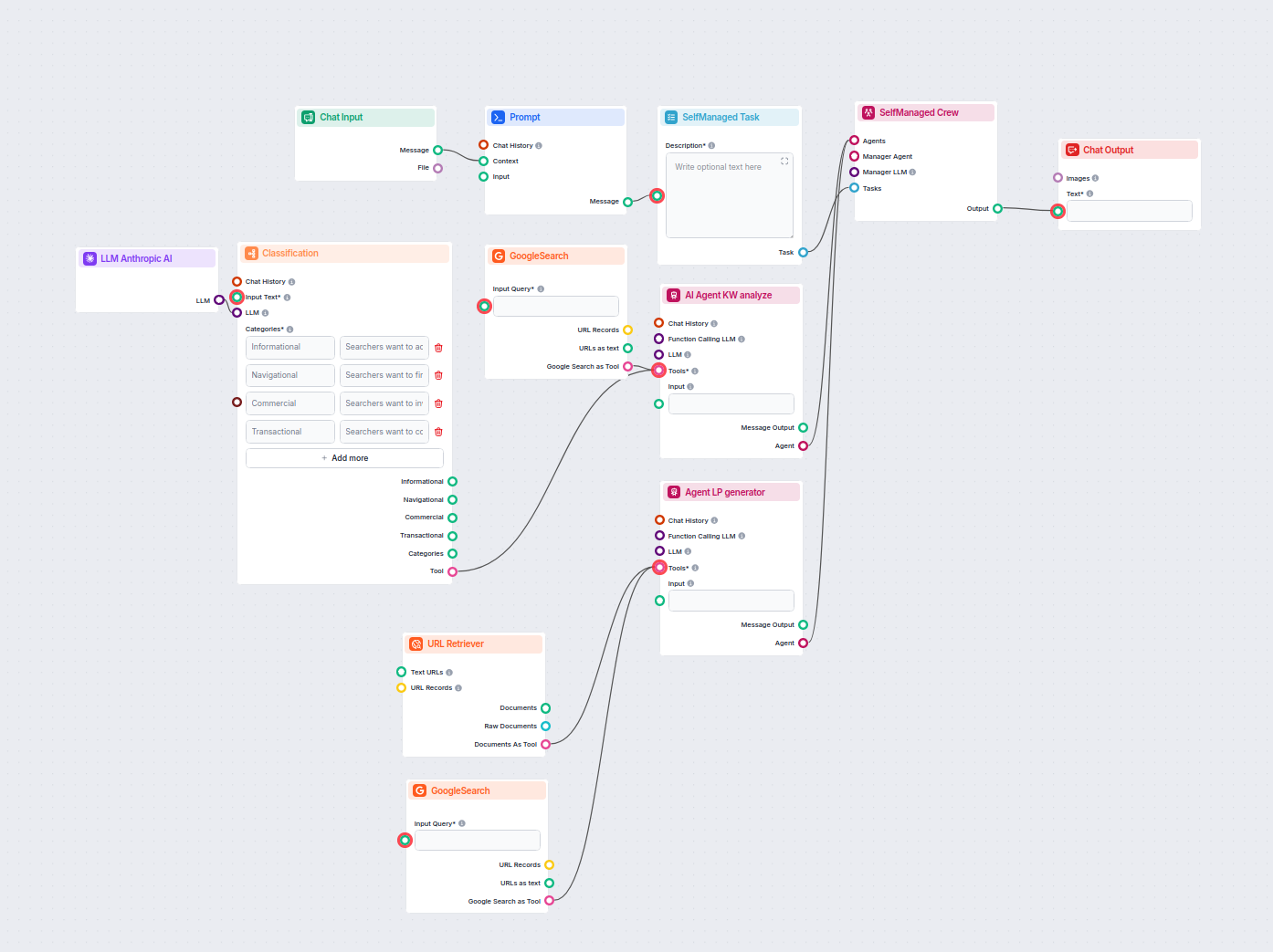

Analysér automatisk din konkurrents hjemmeside-URL for at opdage deres højest rangerende nøgleord, indsamle nøgleordsdata fra Google og modtag handlingsrettede ...

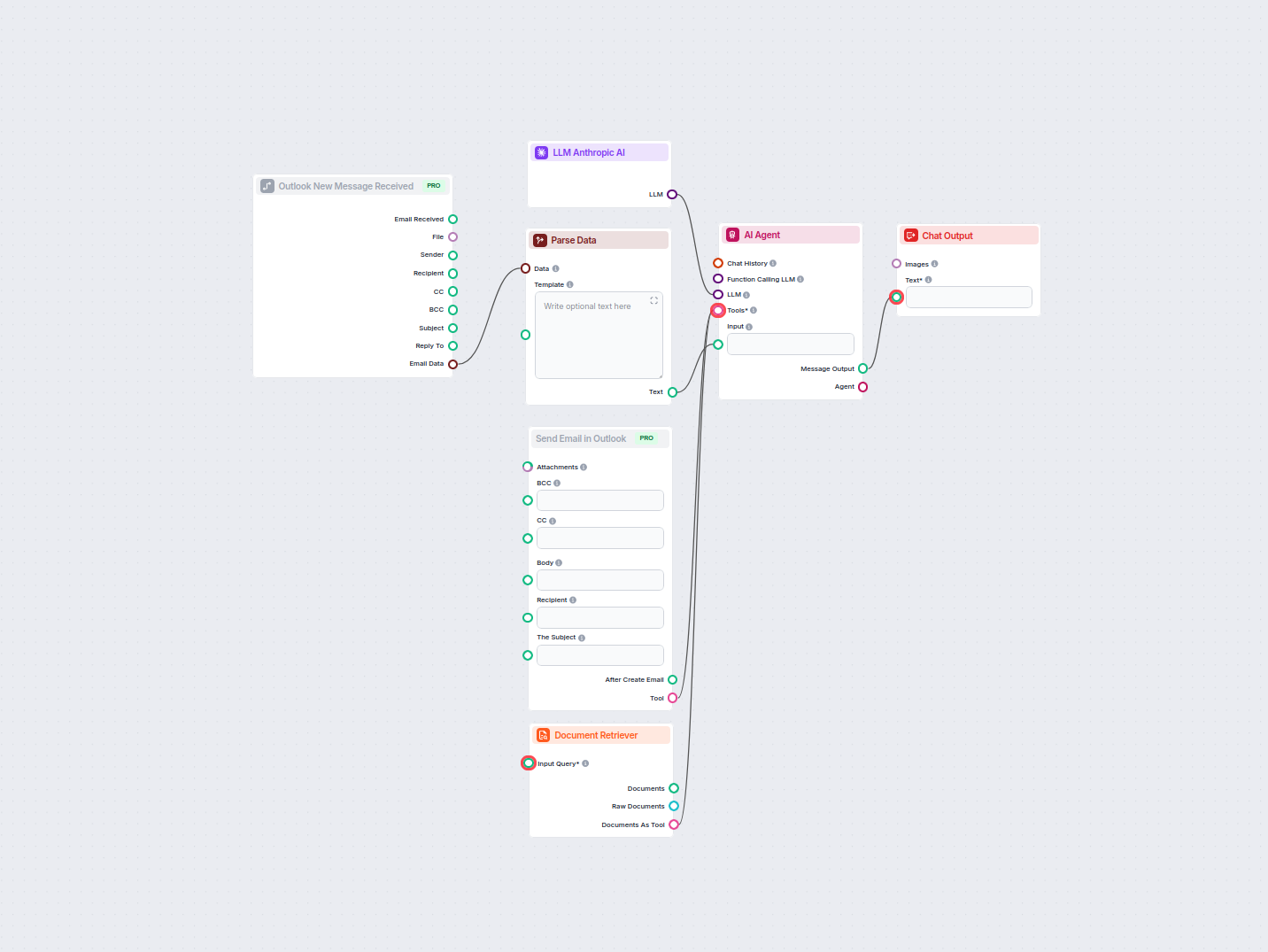

Automatiser professionelle e-mailsvar i Outlook ved hjælp af en AI-agent, der udnytter organisatoriske videnskilder. Indgående e-mails modtages, parses og besva...

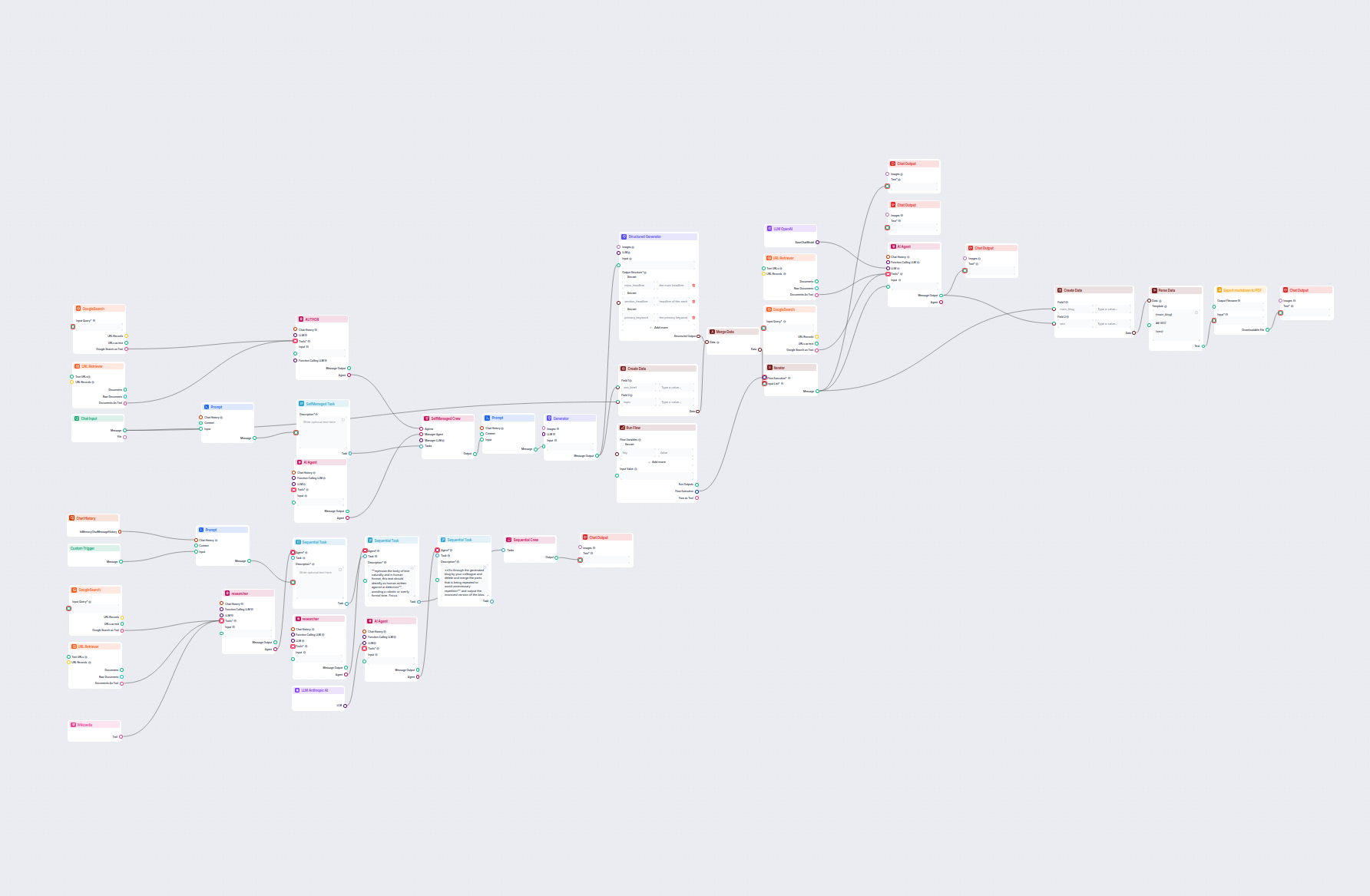

Generer omfattende, SEO-optimerede blogindlæg med avanceret struktur og højt ordantal ved at bruge flere AI-agenter. Workflowet inkluderer automatiseret researc...

Analyser automatisk topplacerede konkurrentblogs fra den seneste uge og generér nye blogidéer til dit website. Dette AI-workflow undersøger konkurrentindhold, f...

Dette workflow automatiserer LinkedIn annoncer markedsundersøgelser ved at identificere de førende konkurrenter for et nøgleord, analysere deres annoncematerial...

Optimer automatisk dine artiklers overskrifter og titel for et specifikt nøgleord eller nøgleordsklynge for at forbedre SEO-ydelsen. Dette workflow analyserer d...

Dette AI-drevne workflow forbedrer Shopify-produktbeskrivelser baseret på produktnavn eller URL, som brugeren angiver. Det udnytter LLM'er, henter produktindhol...

Dette AI-drevne workflow klassificerer søgeforespørgsler efter intention, undersøger top-rangerende URL'er og genererer en højt optimeret landingpage til PPC- o...

LLM Anthropic AI-komponenten forbinder Anthropics Claude-modeller til dine FlowHunt-flows, så du kan tilpasse, hvilken model der bruges til tekstgenerering og styre indstillinger som maks. tokens og temperatur.

FlowHunt understøtter alle de nyeste modeller fra Claude-familien, herunder Claude 3.5 Sonnet, Claude 3 Sonnet, Claude 3 Haiku og Claude 2.

Maks. tokens sætter længdegrænsen for hvert svar, mens temperatur styrer tilfældigheden—lavere værdier gør output fokuseret, højere værdier øger kreativiteten.

Nej, det er valgfrit at forbinde LLM Anthropic AI-komponenten. Som standard bruger komponenter ChatGPT-4o, men du kan tilføje denne komponent for at skifte til Claude-modeller og finjustere indstillinger.

Begynd at bygge tilpassede AI-værktøjer og chatbots ved hjælp af Anthropics Claude-modeller med nem flow-integration og kraftfuld konfiguration.

FlowHunt understøtter dusinvis af tekstgenereringsmodeller, herunder modeller fra OpenAI. Her er, hvordan du bruger ChatGPT i dine AI-værktøjer og chatbots.

FlowHunt understøtter dusinvis af tekstgenereringsmodeller, inklusive Metas Llama-modeller. Lær, hvordan du integrerer Llama i dine AI-værktøjer og chatbots, ti...

FlowHunt understøtter dusinvis af tekstgenereringsmodeller, inklusive modeller fra xAI. Her kan du se, hvordan du bruger xAI-modeller i dine AI-værktøjer og cha...