LLM Gemini

FlowHunt understøtter dusinvis af AI-modeller, herunder Google Gemini. Lær, hvordan du bruger Gemini i dine AI-værktøjer og chatbots, skifter mellem modeller og...

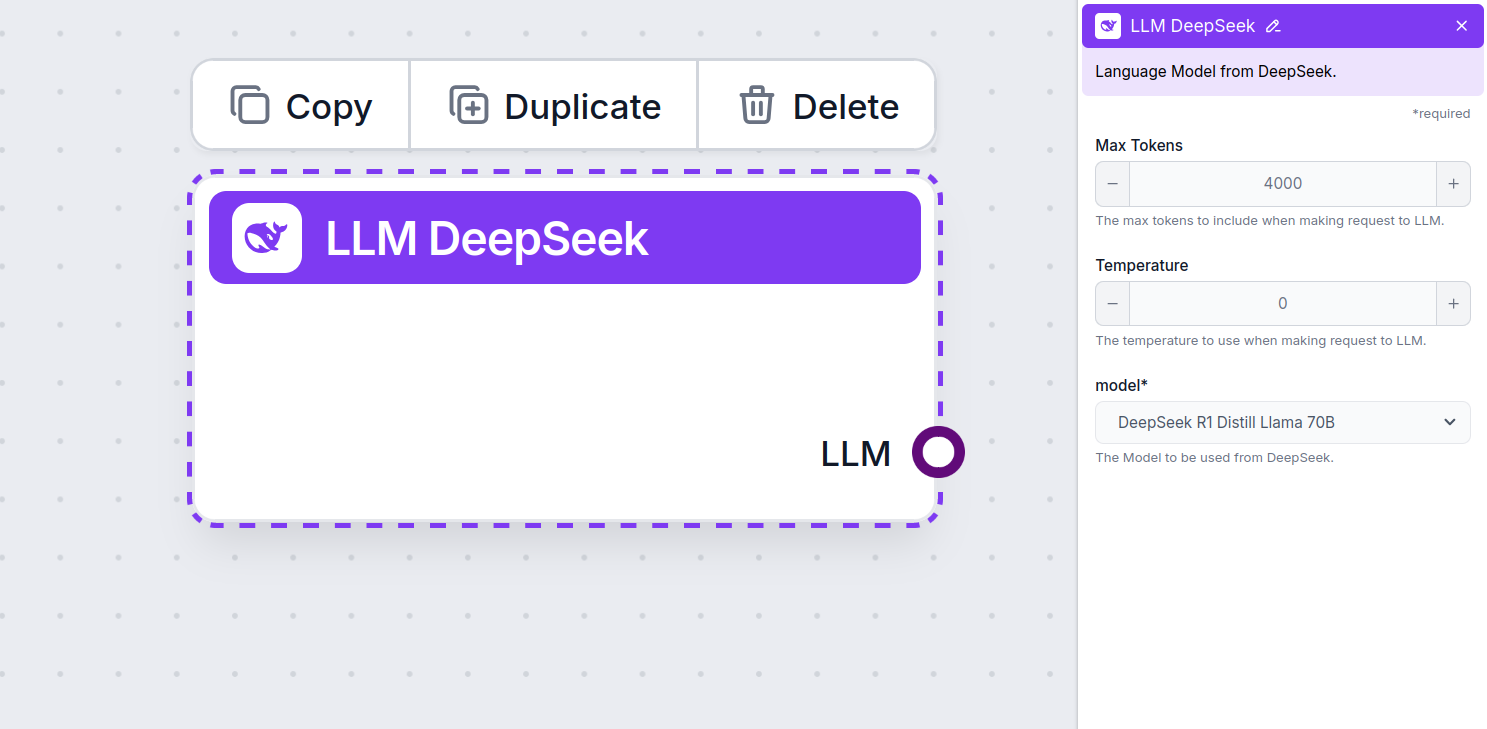

LLM DeepSeek fra FlowHunt giver dig adgang til og mulighed for at tilpasse top AI-modeller som DeepSeek R1 til tekst- og billedgenerering i dine chatbots og AI-værktøjer – alt sammen fra ét dashboard.

Komponentbeskrivelse

LLM DeepSeek-komponenten forbinder DeepSeek-modellerne til dit Flow. Mens Generatorer og Agenter er der, hvor magien sker, gør LLM-komponenter det muligt at skifte og styre den anvendte model.

Husk, at det er valgfrit at forbinde en LLM-komponent. Alle komponenter, der bruger en LLM, leveres med ChatGPT-4o som standard. LLM-komponenterne gør det muligt at ændre modellen og styre modelindstillingerne.

Tokens repræsenterer de enkelte tekst-enheder, som modellen behandler og genererer. Token-forbrug varierer mellem modeller, og en enkelt token kan være alt fra ord eller delord til et enkelt tegn. Modeller prissættes normalt i millioner af tokens.

Indstillingen for maksimalt antal tokens begrænser det samlede antal tokens, der kan behandles i en enkelt interaktion eller forespørgsel, hvilket sikrer, at svarene genereres inden for rimelige grænser. Standardgrænsen er 4.000 tokens, hvilket er en optimal størrelse til at opsummere dokumenter og flere kilder for at generere et svar.

Temperatur styrer variationen i svarene og spænder fra 0 til 1.

En temperatur på 0,1 gør svarene meget præcise, men potentielt gentagende og mangelfulde.

En høj temperatur på 1 tillader maksimal kreativitet i svarene, men øger risikoen for irrelevante eller endda hallucinerede svar.

For eksempel anbefales en temperatur mellem 0,2 og 0,5 til en kundeservicebot. Dette niveau holder svarene relevante og i overensstemmelse med scriptet, men tillader naturlig variation i svarene.

Dette er modelvælgeren. Her finder du alle de understøttede DeepSeek-modeller. Vi understøtter alle de nyeste Gemini-modeller:

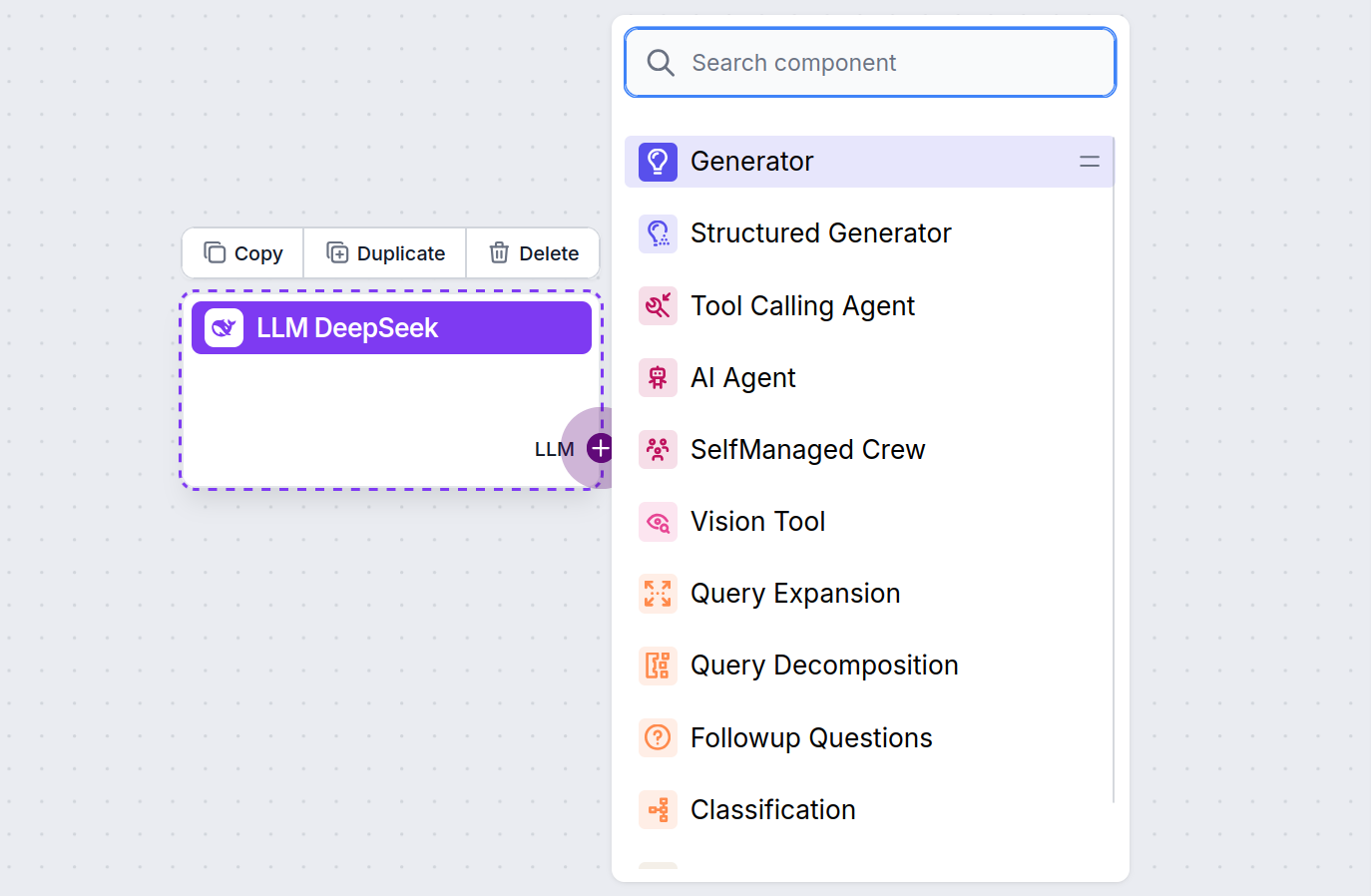

Du vil bemærke, at alle LLM-komponenter kun har et output-håndtag. Input passerer ikke igennem komponenten, da den kun repræsenterer modellen, mens selve genereringen sker i AI-agenter og generatorer.

LLM-håndtaget er altid lilla. LLM-inputhåndtaget findes på alle komponenter, der bruger AI til at generere tekst eller behandle data. Du kan se mulighederne ved at klikke på håndtaget:

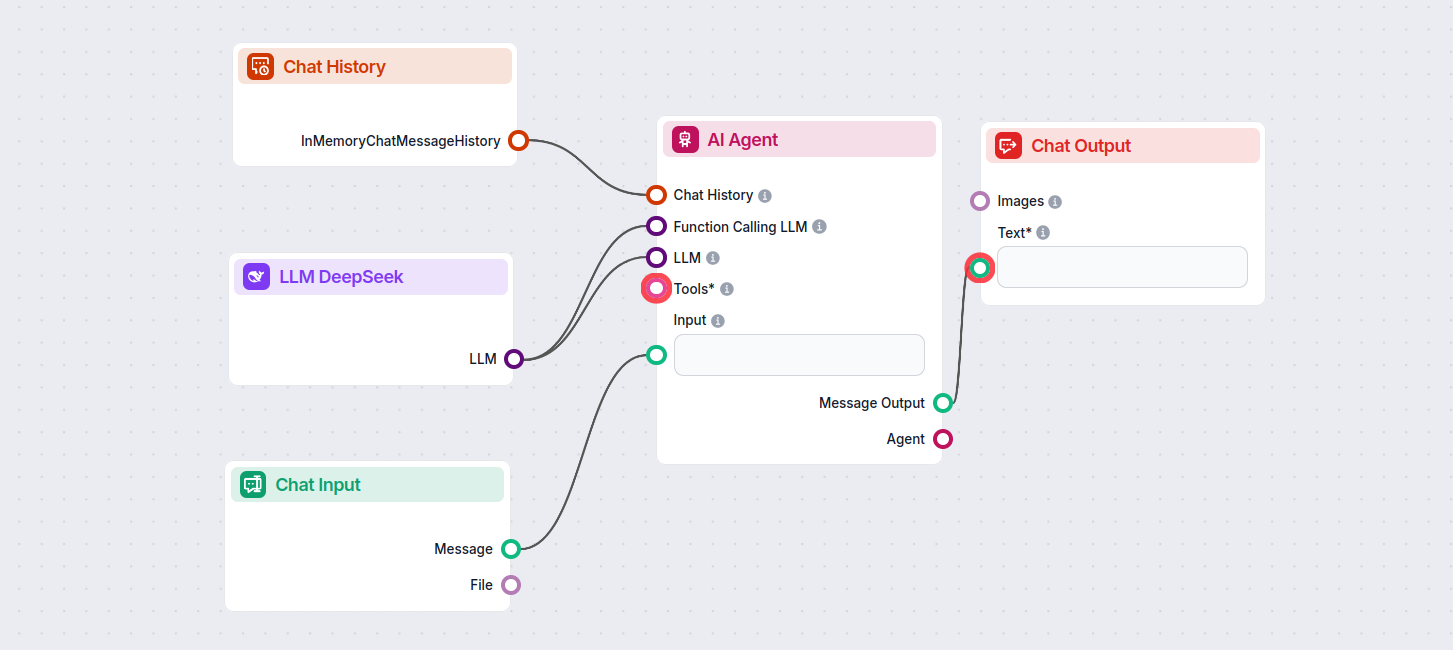

Dette gør det muligt at oprette alle slags værktøjer. Lad os se komponenten i aktion. Her er et simpelt AI Agent chatbot-flow, der bruger DeepSeek R1 til at generere svar. Du kan betragte det som en grundlæggende DeepSeek-chatbot.

Dette simple chatbot-flow inkluderer:

LLM DeepSeek er en komponent i FlowHunt, der gør det muligt at forbinde og styre DeepSeek AI-modeller til tekst- og billedgenerering, hvilket muliggør kraftfulde chatbots og automatiserede flows.

FlowHunt understøtter alle de nyeste DeepSeek-modeller, herunder DeepSeek R1, som er kendt for sin hastighed og ydeevne, især sammenlignet med andre førende AI-modeller.

Du kan justere maksimalt antal tokens for svarelængde og temperatur for svar-kreativitet samt skifte mellem tilgængelige DeepSeek-modeller direkte i dit FlowHunt-dashboard.

Nej, det er valgfrit at forbinde en LLM-komponent. Som standard anvender FlowHunt ChatGPT-4o, men ved at tilføje LLM DeepSeek kan du skifte og styre, hvilken AI-model der driver dine flows.

Begynd at bygge smartere AI-chatbots og automatiseringsværktøjer ved hjælp af avancerede DeepSeek-modeller – helt uden kompleks opsætning eller flere abonnementer.

FlowHunt understøtter dusinvis af AI-modeller, herunder Google Gemini. Lær, hvordan du bruger Gemini i dine AI-værktøjer og chatbots, skifter mellem modeller og...

FlowHunt understøtter dusinvis af tekstgenereringsmodeller, inklusive Metas Llama-modeller. Lær, hvordan du integrerer Llama i dine AI-værktøjer og chatbots, ti...

FlowHunt understøtter dusinvis af AI-tekstmodeller, inklusive modeller fra Mistral. Her er hvordan du bruger Mistral i dine AI-værktøjer og chatbots.