AI Virksomhedsanalyse til Google Sheets

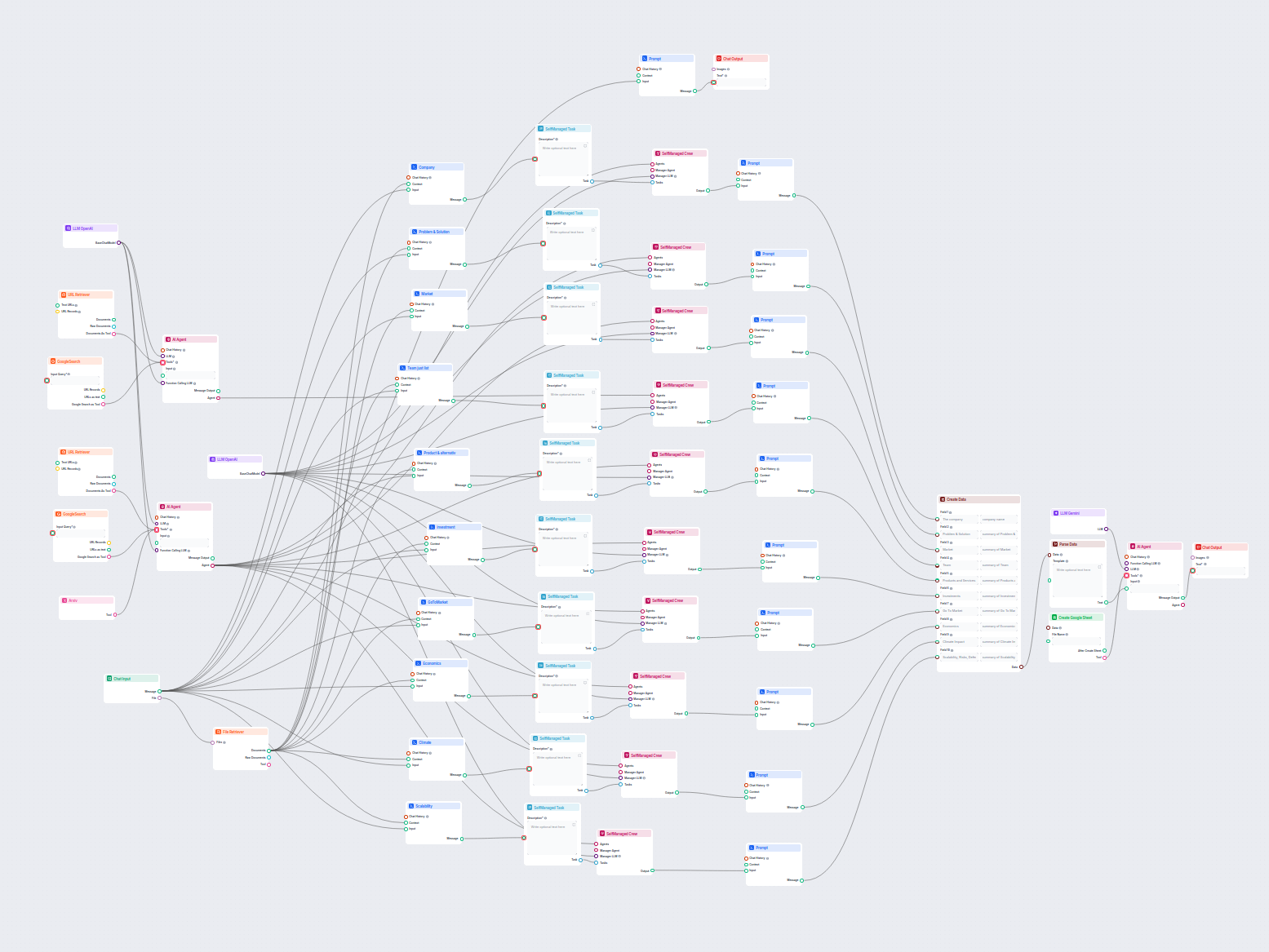

Dette AI-drevne workflow leverer en omfattende, datadrevet virksomhedsxadanalyse. Den indsamler information om virksomhedens baggrund, markedslandskab, team, pr...

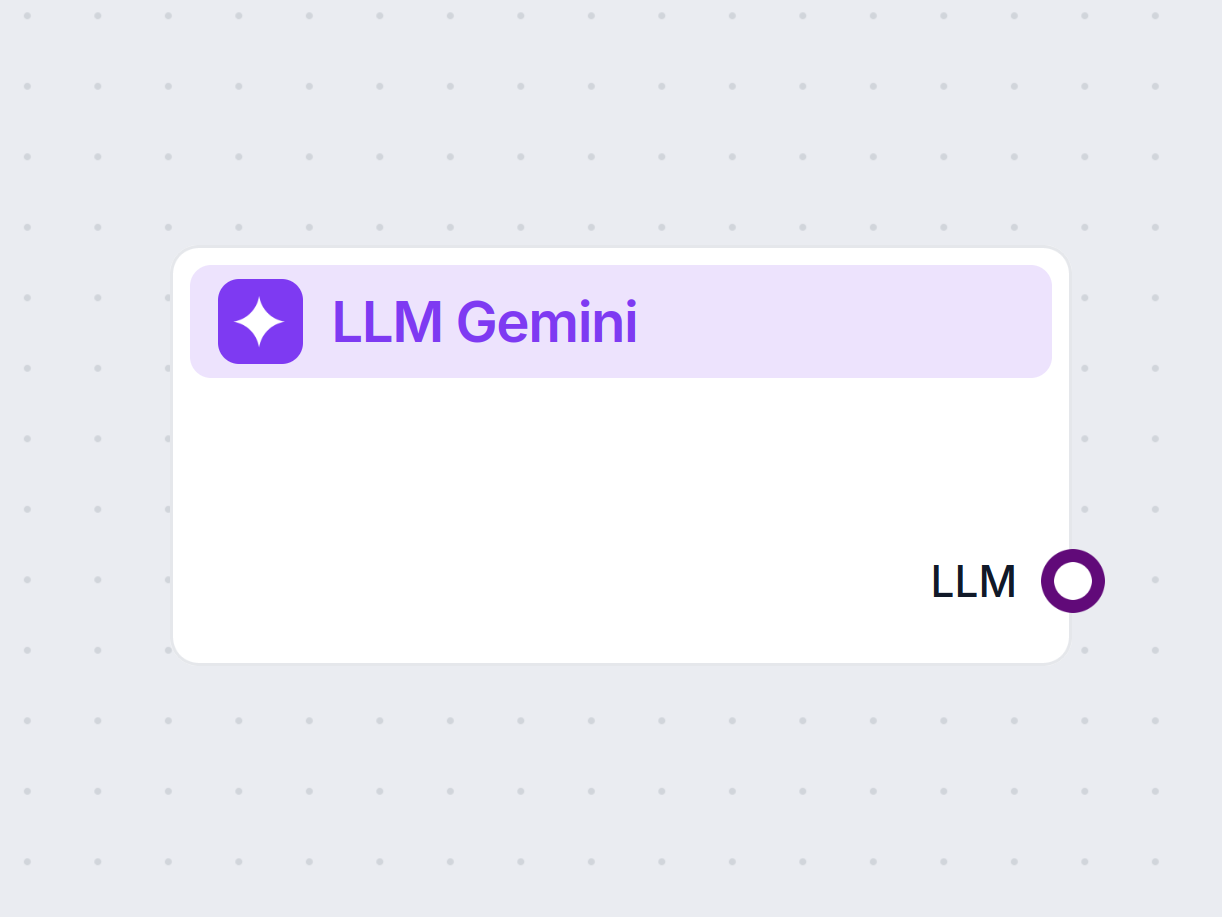

Lås op for kraften i Googles Gemini-modeller i FlowHunt—skift AI-modeller, styr indstillinger, og byg smartere AI-chatbots med lethed.

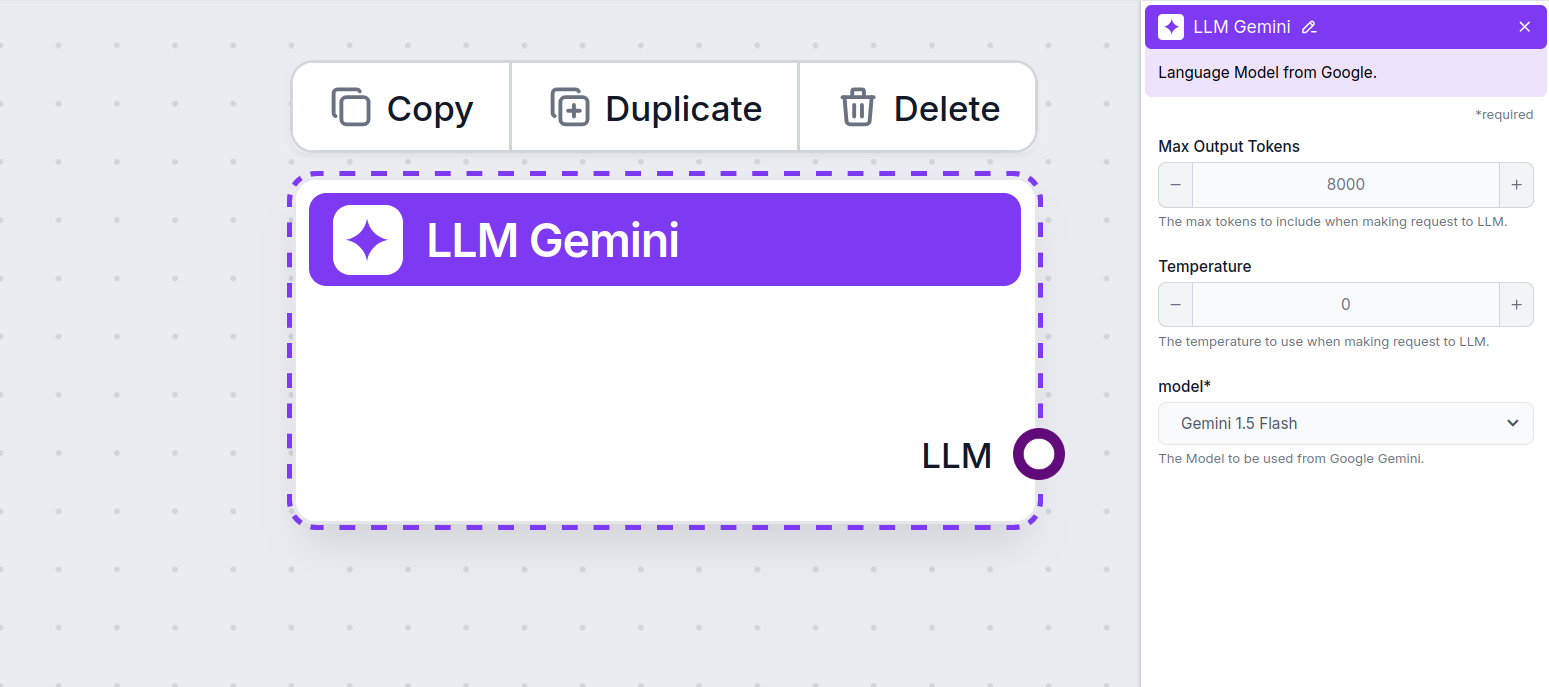

Komponentbeskrivelse

LLM Gemini-komponenten forbinder Gemini-modellerne fra Google til dit flow. Selvom Generatorer og Agenter er der, hvor magien sker, giver LLM-komponenter dig mulighed for at styre, hvilken model der bruges. Alle komponenter kommer med ChatGPT-4 som standard. Du kan tilkoble denne komponent, hvis du ønsker at ændre modellen eller få mere kontrol over den.

Husk, at tilkobling af en LLM-komponent er valgfrit. Alle komponenter, der bruger en LLM, kommer med ChatGPT-4o som standard. LLM-komponenterne giver dig mulighed for at ændre modellen og styre modelindstillingerne.

Tokens repræsenterer de enkelte tekstdele, som modellen behandler og genererer. Tokenforbrug varierer mellem modeller, og en enkelt token kan være alt fra ord eller dele af ord til et enkelt tegn. Modeller prissættes normalt pr. million tokens.

Indstillingen for max tokens begrænser det samlede antal tokens, der kan behandles i en enkelt interaktion eller forespørgsel, og sikrer, at svarene genereres inden for rimelige grænser. Standardgrænsen er 4.000 tokens, hvilket er den optimale størrelse til at opsummere dokumenter og flere kilder for at generere et svar.

Temperatur styrer variationen i svarene og går fra 0 til 1.

En temperatur på 0,1 vil gøre svarene meget præcise, men potentielt gentagende og mangelfulde.

En høj temperatur på 1 tillader maksimal kreativitet i svarene, men øger risikoen for irrelevante eller endda hallucinerede svar.

For eksempel er den anbefalede temperatur for en kundeservicebot mellem 0,2 og 0,5. Dette niveau bør holde svarene relevante og til manuskriptet, samtidig med at der gives plads til naturlig variation.

Dette er modelvælgeren. Her finder du alle de understøttede Gemini-modeller fra Google. Vi understøtter alle de nyeste Gemini-modeller:

Du vil bemærke, at alle LLM-komponenter kun har et output-håndtag. Input går ikke gennem komponenten, da den kun repræsenterer modellen, mens selve genereringen sker i AI-agenter og generatorer.

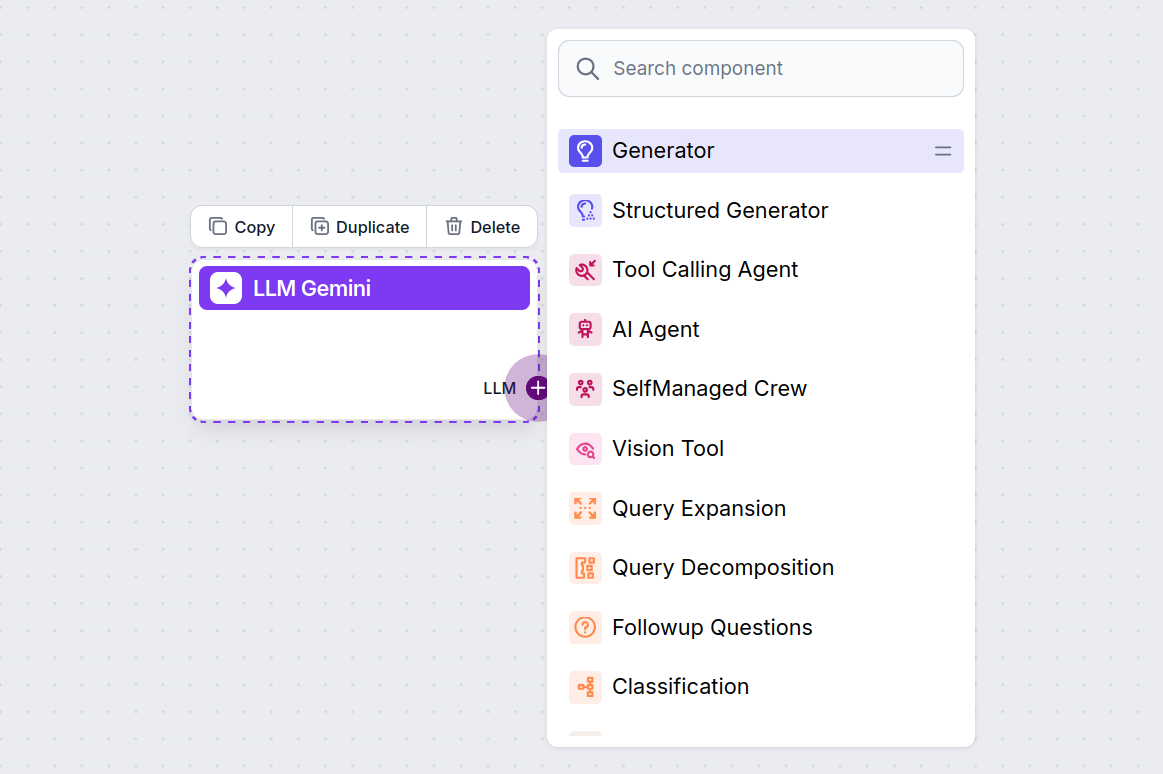

LLM-håndtaget er altid lilla. LLM-inputhåndtaget findes på enhver komponent, der bruger AI til at generere tekst eller behandle data. Du kan se mulighederne ved at klikke på håndtaget:

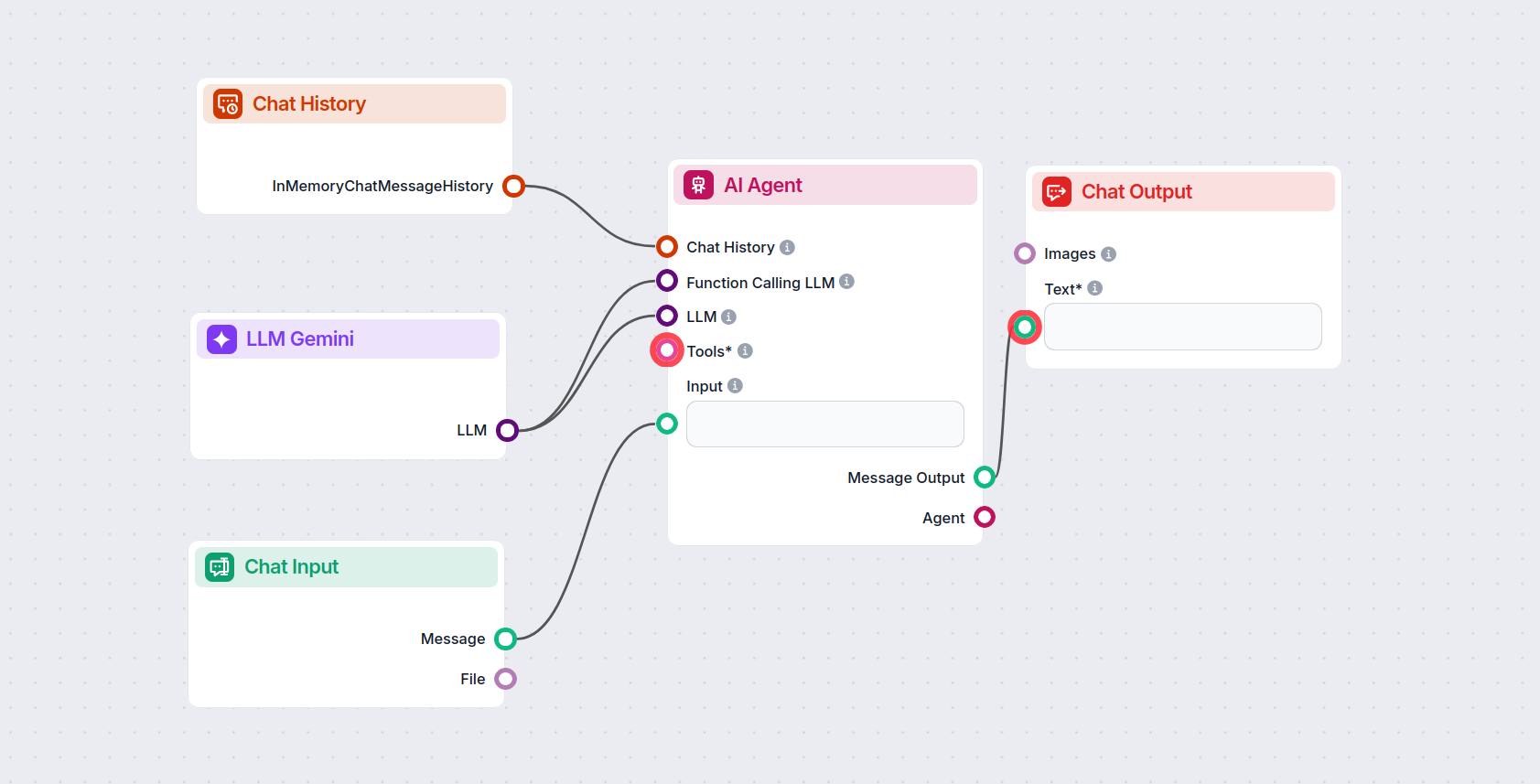

Dette giver dig mulighed for at skabe alle slags værktøjer. Lad os se komponenten i aktion. Her er et simpelt AI Agent chatbot-flow, der bruger Gemini 2.0 Flash Experimental til at generere svar. Du kan tænke på det som en basal Gemini-chatbot.

Dette simple Chatbot-flow inkluderer:

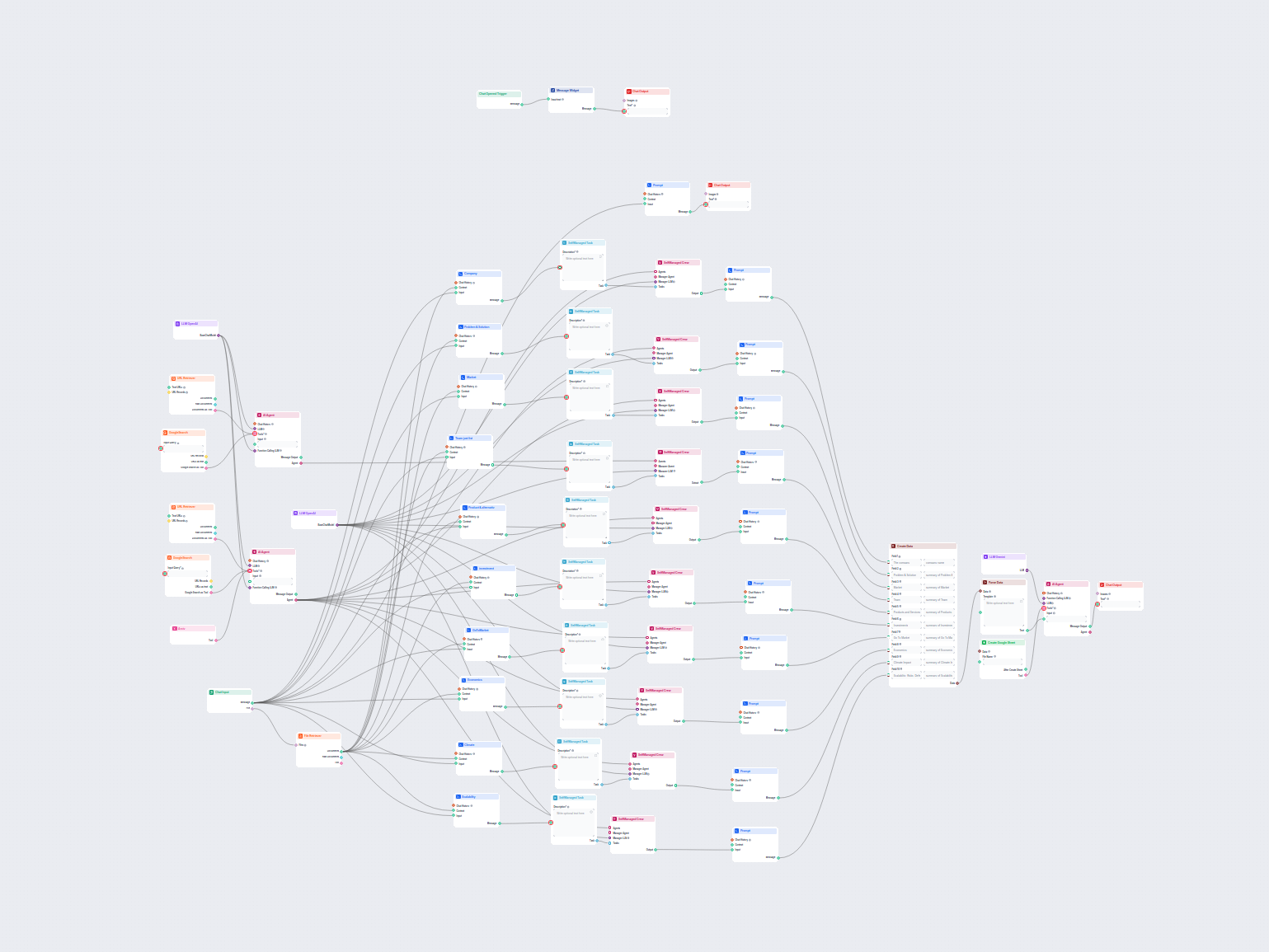

For at hjælpe dig med at komme hurtigt i gang, har vi forberedt flere eksempel-flow-skabeloner, der demonstrerer, hvordan du bruger LLM Gemini-komponenten effektivt. Disse skabeloner viser forskellige brugssituationer og bedste praksis, hvilket gør det lettere for dig at forstå og implementere komponenten i dine egne projekter.

Dette AI-drevne workflow leverer en omfattende, datadrevet virksomhedsxadanalyse. Den indsamler information om virksomhedens baggrund, markedslandskab, team, pr...

Dette AI-workflow analyserer enhver virksomhed i dybden ved at undersøge offentlige data og dokumenter, herunder marked, team, produkter, investeringer og mere....

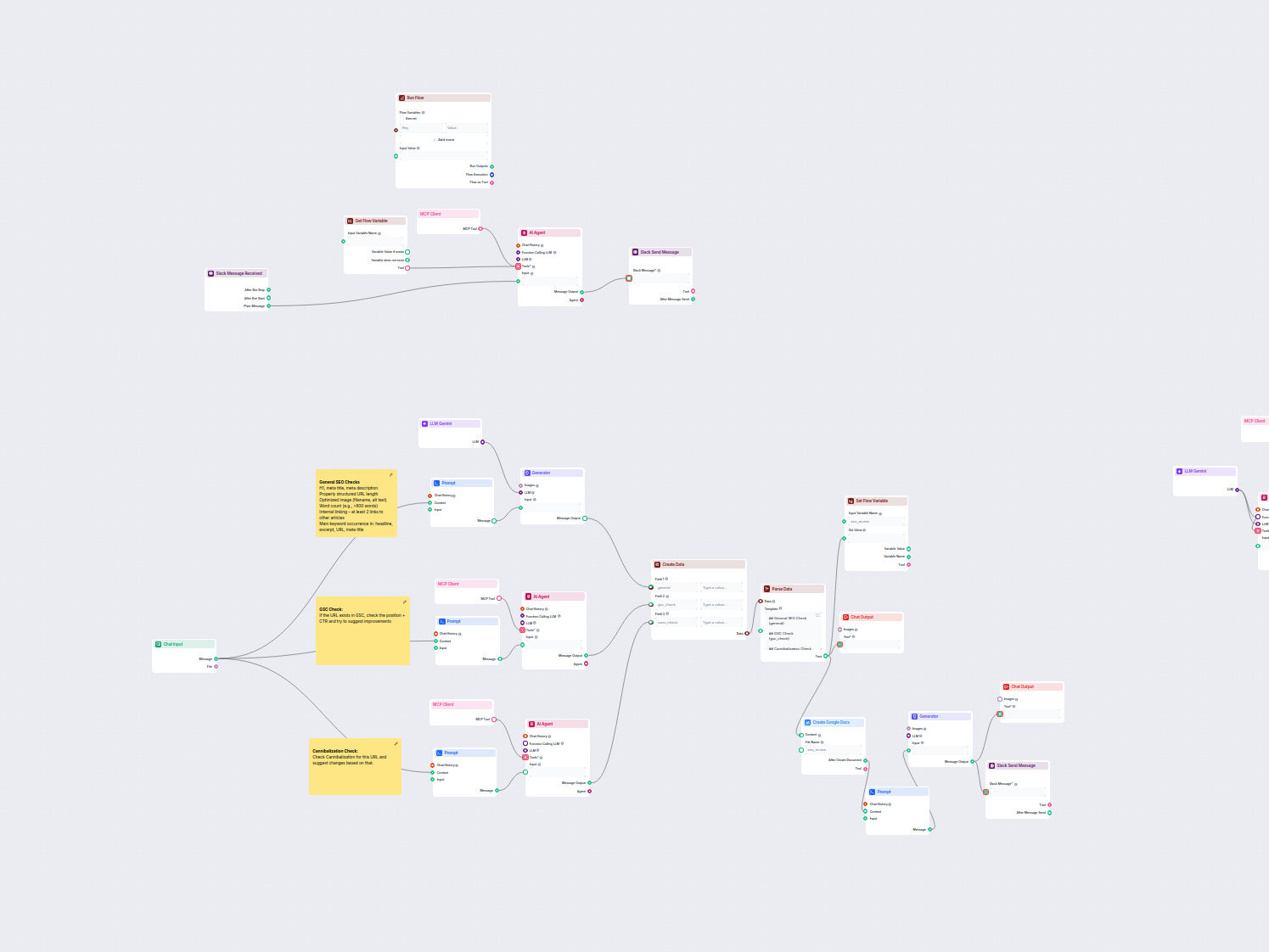

Denne arbejdsgang automatiserer SEO-gennemgang og auditproces for website-sider. Den analyserer sideindhold for SEO-best practices, udfører Google Search Consol...

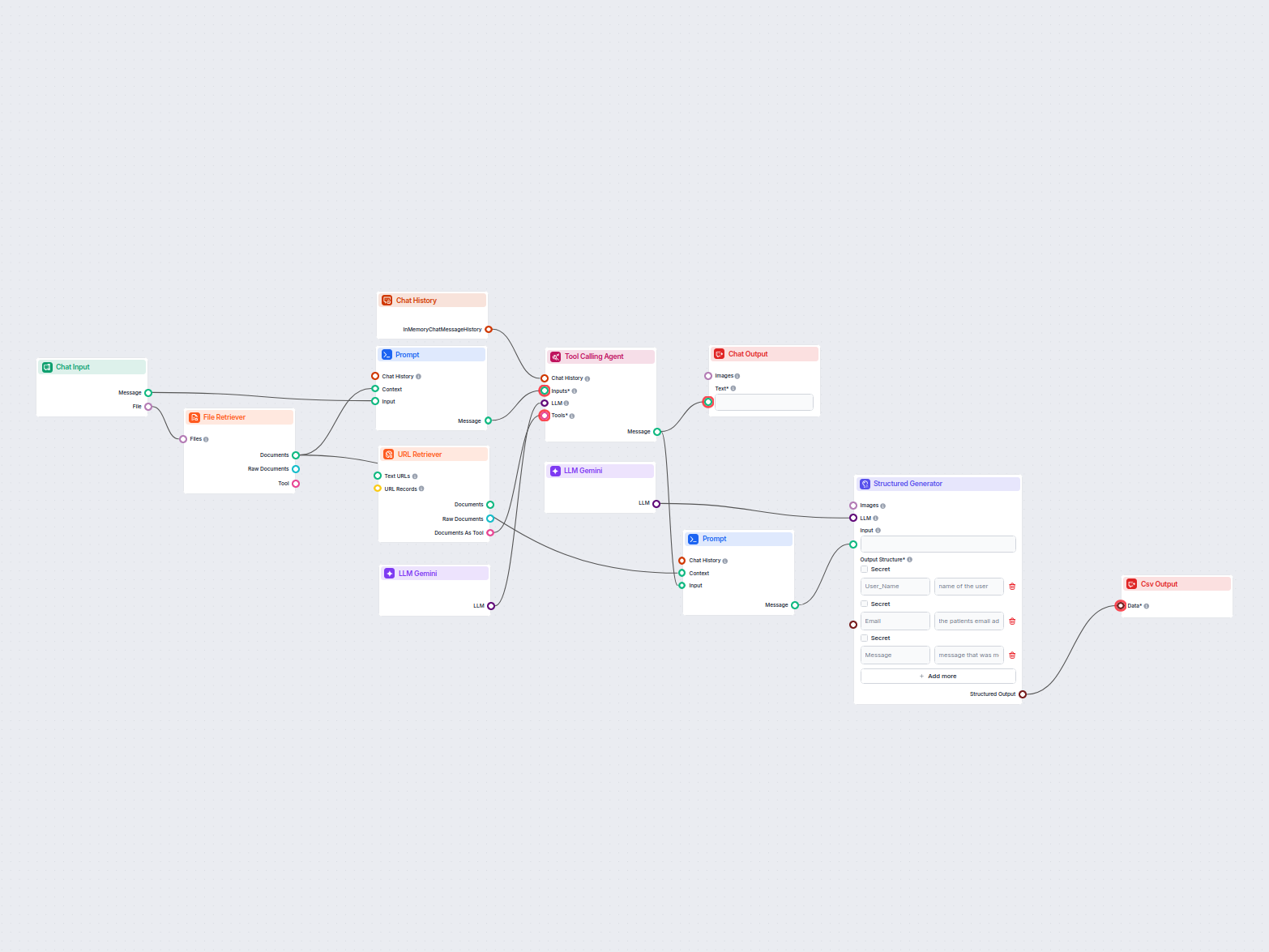

Dette workflow udtrækker og organiserer nøgleinformation fra e-mails og vedhæftede filer, benytter AI til at behandle og strukturere dataene og leverer resultat...

LLM Gemini forbinder Googles Gemini-modeller med dine FlowHunt AI-flows, så du kan vælge mellem de nyeste Gemini-varianter til tekstgenerering og tilpasse deres opførsel.

FlowHunt understøtter Gemini 2.0 Flash Experimental, Gemini 1.5 Flash, Gemini 1.5 Flash-8B og Gemini 1.5 Pro—hver tilbyder unikke funktioner til tekst, billede, lyd og video input.

Max Tokens begrænser svarets længde, mens Temperatur styrer kreativiteten—lavere værdier giver fokuserede svar, højere værdier tillader mere variation. Begge kan indstilles pr. model i FlowHunt.

Nej, brug af LLM-komponenter er valgfrit. Alle AI-flows kommer med ChatGPT-4o som standard, men ved at tilføje LLM Gemini kan du skifte til Google-modeller og finjustere deres indstillinger.

Begynd at bygge avancerede AI-chatbots og værktøjer med Gemini og andre topmodeller—alt sammen i ét dashboard. Skift mellem modeller, tilpas indstillinger, og effektiviser dine arbejdsgange.

FlowHunt understøtter dusinvis af AI-modeller, inklusive de banebrydende DeepSeek-modeller. Her kan du se, hvordan du bruger DeepSeek i dine AI-værktøjer og cha...

FlowHunt understøtter dusinvis af AI-tekstmodeller, inklusive modeller fra Mistral. Her er hvordan du bruger Mistral i dine AI-værktøjer og chatbots.

FlowHunt understøtter dusinvis af tekstgenereringsmodeller, inklusive Metas Llama-modeller. Lær, hvordan du integrerer Llama i dine AI-værktøjer og chatbots, ti...