LLM xAI

FlowHunt understøtter dusinvis af tekstgenereringsmodeller, inklusive modeller fra xAI. Her kan du se, hvordan du bruger xAI-modeller i dine AI-værktøjer og cha...

FlowHunt’s LLM Meta AI samler Metas Llama-modeller og dusinvis af andre AI-modeller i ét, nemt kontrollerbart dashboard til fleksibel tekst- og billedgenerering.

Komponentbeskrivelse

LLM Meta AI-komponenten forbinder Claude-familien af modeller til dit Flow. Selvom Generatorer og Agenter er der, hvor magien sker, giver LLM-komponenter dig mulighed for at styre den anvendte model. Alle komponenter leveres med ChatGPT-4 som standard. Du kan forbinde denne komponent, hvis du ønsker at ændre modellen eller få mere kontrol over den.

Husk, at det er valgfrit at forbinde en LLM-komponent. Alle komponenter, der bruger en LLM, leveres med ChatGPT-4o som standard. LLM-komponenterne giver dig mulighed for at ændre modellen og styre modelindstillinger.

Tokens repræsenterer de individuelle enheder af tekst, som modellen behandler og genererer. Tokenforbrug varierer mellem modeller, og en enkelt token kan være alt fra ord eller delord til et enkelt tegn. Modeller afregnes normalt i millioner af tokens.

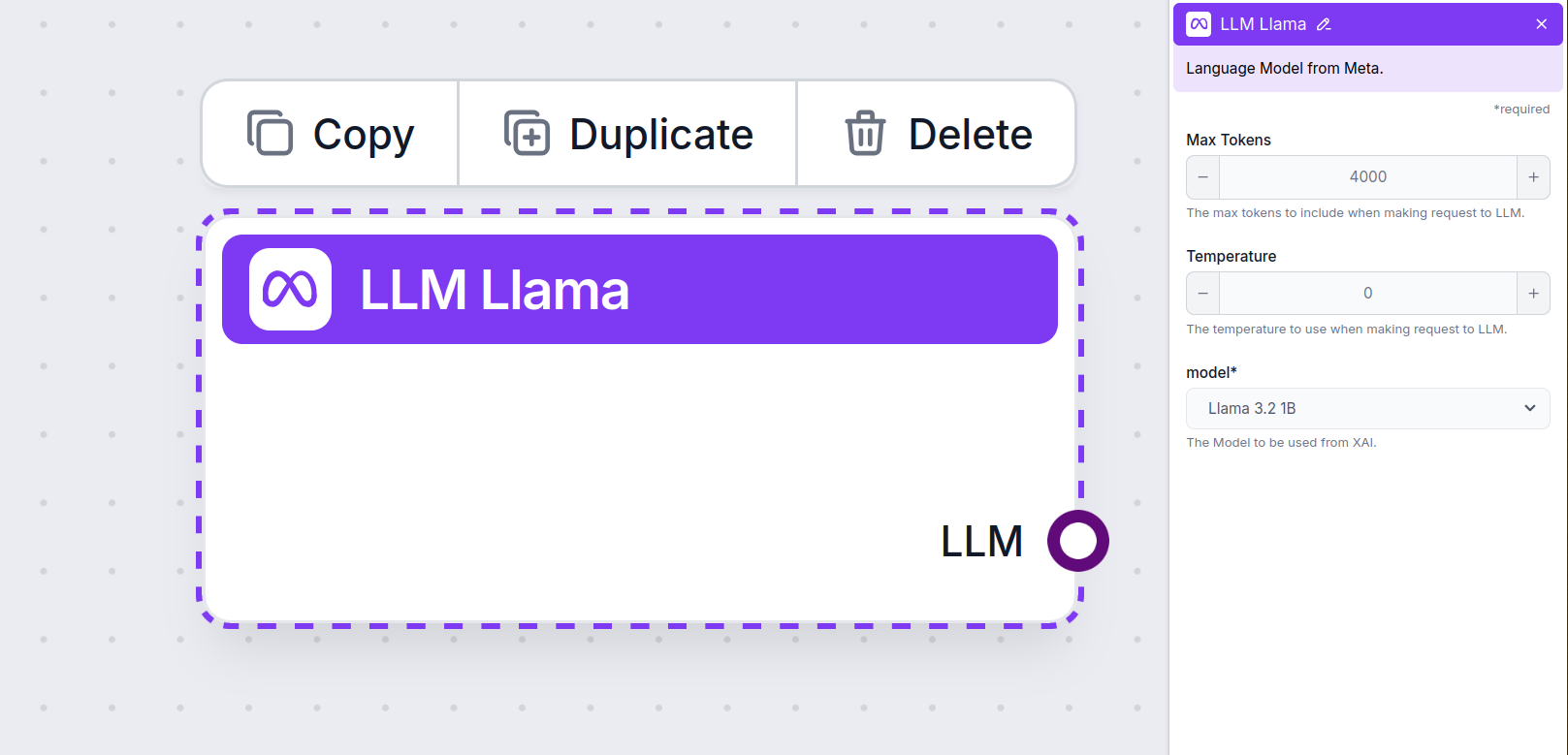

Indstillingen for maks. tokens begrænser det samlede antal tokens, der kan behandles i en enkelt interaktion eller anmodning, hvilket sikrer, at svarene genereres inden for rimelige grænser. Standardgrænsen er 4.000 tokens, hvilket er den optimale størrelse til at opsummere dokumenter og flere kilder for at generere et svar.

Temperatur styrer variationen i svarene og spænder fra 0 til 1.

En temperatur på 0,1 gør svarene meget præcise, men potentielt gentagende og mangelfulde.

En høj temperatur på 1 giver maksimal kreativitet i svarene, men indebærer risiko for irrelevante eller endda hallucinerende svar.

For eksempel anbefales en temperatur mellem 0,2 og 0,5 til en kundeservicebot. Dette niveau holder svarene relevante og til manuskriptet, samtidig med at der er mulighed for naturlig variation.

Dette er modelvælgeren. Her finder du alle de understøttede modeller fra Meta AI. Vi understøtter Metas open source, letvægts Llama-modeller. Disse modeller er designet til effektiv on-device og edge deployment:

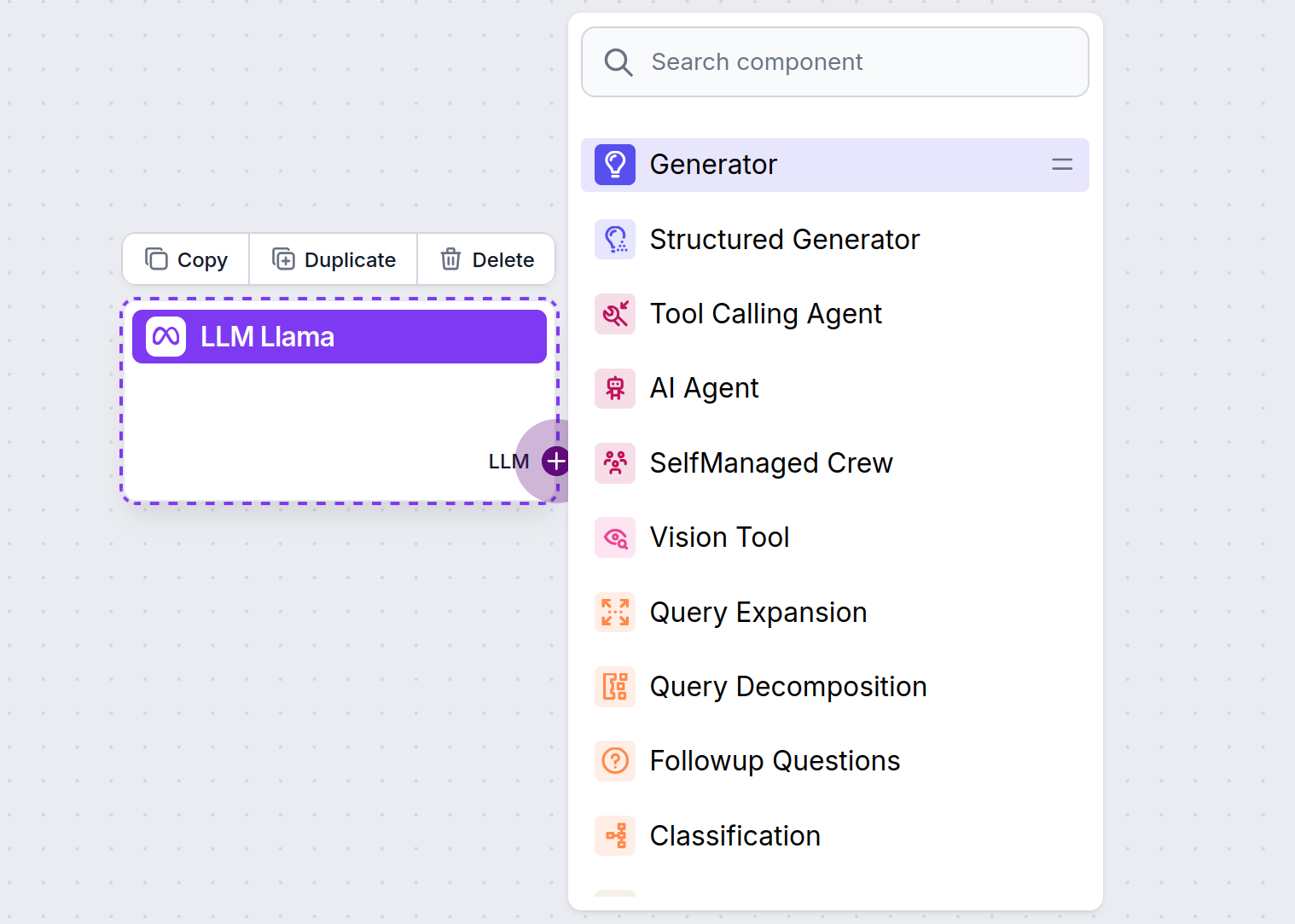

Du vil bemærke, at alle LLM-komponenter kun har et output-handle. Input går ikke gennem komponenten, da den kun repræsenterer modellen, mens selve genereringen sker i AI-agenter og generatorer.

LLM-handlet er altid lilla. LLM-input-handlet findes på enhver komponent, der bruger AI til at generere tekst eller behandle data. Du kan se mulighederne ved at klikke på handlet:

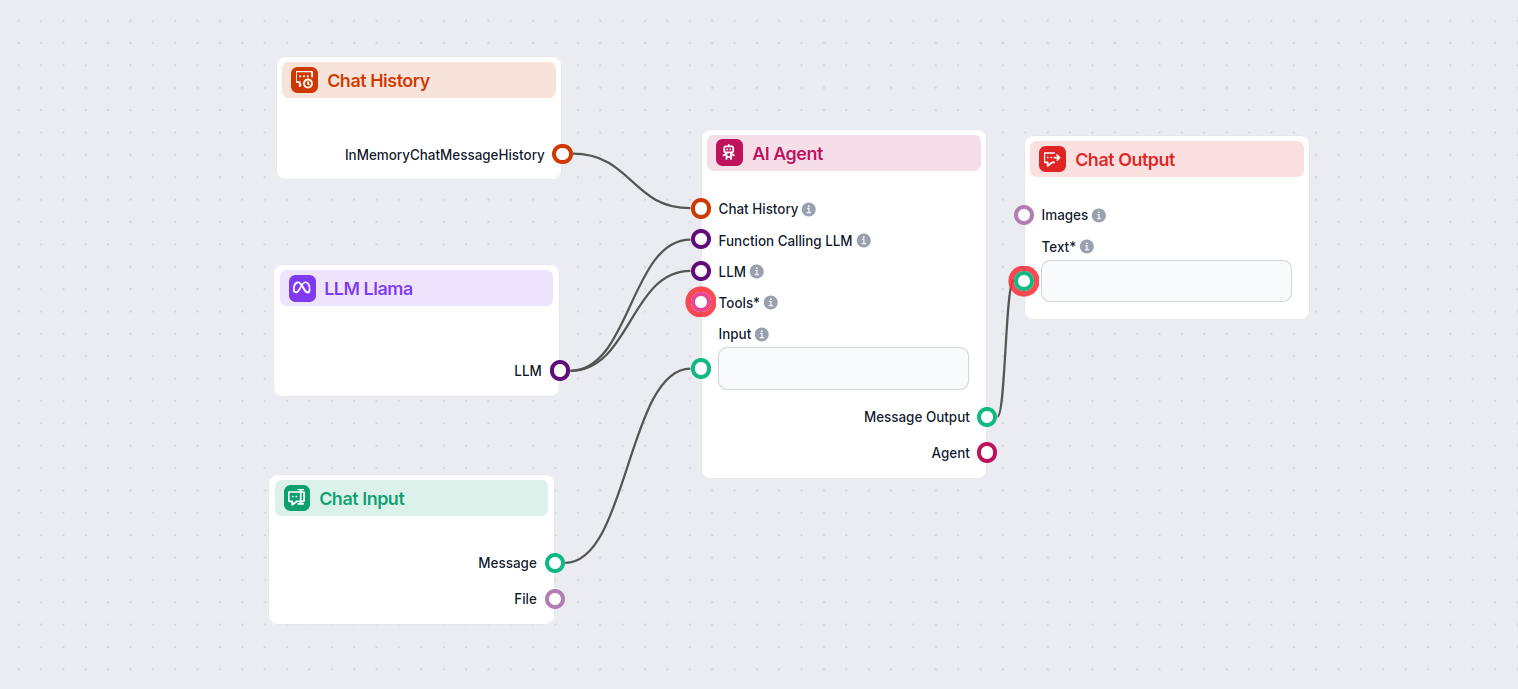

Dette giver dig mulighed for at skabe alle mulige værktøjer. Lad os se komponenten i aktion. Her er et simpelt AI Agent chatbot Flow, der bruger Meta AI’s Llama 3.2 1B til at generere svar. Du kan tænke på det som en grundlæggende Llama-chatbot.

Dette simple Chatbot Flow inkluderer:

LLM Meta AI-komponenten gør det muligt at forbinde Metas Llama-modeller og andre tekst-/billedgeneratorer til dine flows, hvilket muliggør nem modelvalg og avanceret konfiguration som maks. tokens og temperatur.

FlowHunt understøtter Metas open source Llama-modeller, inklusive Llama 3.2 1B og 3B, optimeret til effektivitet, opsummering og on-device deployments.

Du kan justere indstillinger som maks. tokens (begrænser svarets længde), temperatur (styrer svarenes kreativitet) og modelvalg direkte fra FlowHunt-dashboardet for hver komponent.

Nej, det er valgfrit at tilføje LLM Meta AI-komponenten. Som standard bruger komponenterne ChatGPT-4o, men du kan skifte til Llama eller andre modeller for mere kontrol eller specifikke anvendelsestilfælde.

Begynd at bygge smartere chatbots og AI-værktøjer med Metas Llama-modeller og dusinvis af andre AI-generatorer – alt sammen på én platform.

FlowHunt understøtter dusinvis af tekstgenereringsmodeller, inklusive modeller fra xAI. Her kan du se, hvordan du bruger xAI-modeller i dine AI-værktøjer og cha...

FlowHunt understøtter dusinvis af AI-tekstmodeller, inklusive modeller fra Mistral. Her er hvordan du bruger Mistral i dine AI-værktøjer og chatbots.

FlowHunt understøtter dusinvis af tekstgenereringsmodeller, herunder modeller fra OpenAI. Her er, hvordan du bruger ChatGPT i dine AI-værktøjer og chatbots.