Neurale Netværk

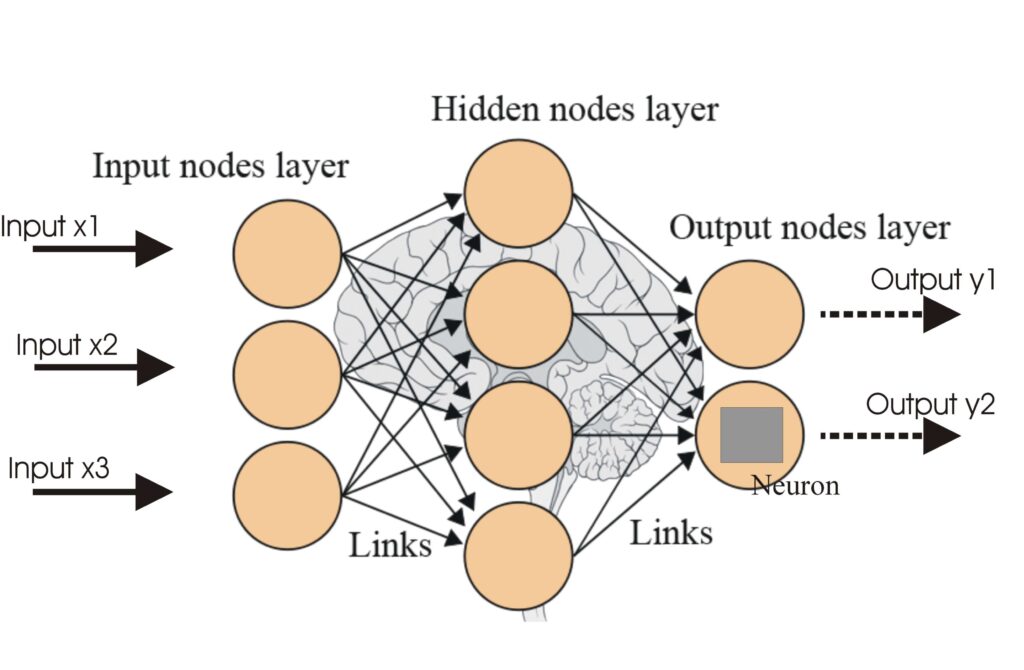

Et neuralt netværk, eller kunstigt neuralt netværk (ANN), er en beregningsmodel inspireret af den menneskelige hjerne, essentiel i AI og maskinlæring til opgave...

Aktiveringsfunktioner introducerer non-linearitet i neurale netværk og gør dem i stand til at lære komplekse mønstre, hvilket er essentielt for AI- og dybdelæringsapplikationer.

Aktiveringsfunktioner er fundamentale for arkitekturen i kunstige neurale netværk (ANNs) og har stor indflydelse på netværkets evne til at lære og udføre indviklede opgaver. Denne ordlisteartikel dykker ned i aktiveringsfunktionernes kompleksitet og undersøger deres formål, typer og anvendelser, især inden for AI, dybdelæring og neurale netværk.

En aktiveringsfunktion i et neuralt netværk er en matematisk operation, der anvendes på outputtet fra en neuron. Den afgør, om en neuron skal aktiveres eller ej, og introducerer non-linearitet i modellen, hvilket muliggør, at netværket kan lære komplekse mønstre. Uden disse funktioner ville et neuralt netværk i bund og grund opføre sig som en lineær regressionsmodel, uanset dets dybde eller antal lag.

Sigmoid-funktion

Tanh-funktion

ReLU (Rectified Linear Unit)

Leaky ReLU

Softmax-funktion

Swish-funktion

Aktiveringsfunktioner er integrerede i forskellige AI-applikationer, herunder:

En aktiveringsfunktion er en matematisk operation, der anvendes på outputtet fra en neuron, hvilket introducerer non-linearitet og gør det muligt for neurale netværk at lære komplekse mønstre ud over simple lineære sammenhænge.

Aktiveringsfunktioner gør det muligt for neurale netværk at løse komplekse, non-lineære problemer ved at muliggøre læring af indviklede mønstre, hvilket gør dem afgørende for opgaver som billedklassificering, sprogbehandling og automatisering.

Almindelige typer inkluderer Sigmoid, Tanh, ReLU, Leaky ReLU, Softmax og Swish, som hver har unikke egenskaber og anvendelser i forskellige lag af neurale netværk.

Almindelige udfordringer inkluderer det forsvindende gradientproblem (især med Sigmoid og Tanh), døde ReLU og beregningsmæssig omkostning for funktioner som Softmax i realtidsapplikationer.

Smarte chatbots og AI-værktøjer samlet ét sted. Forbind intuitive blokke for at forvandle dine ideer til automatiserede flows.

Et neuralt netværk, eller kunstigt neuralt netværk (ANN), er en beregningsmodel inspireret af den menneskelige hjerne, essentiel i AI og maskinlæring til opgave...

Kunstige neurale netværk (ANNs) er en undergruppe af maskinlæringsalgoritmer, der er modelleret efter den menneskelige hjerne. Disse beregningsmodeller består a...

Transformere er en revolutionerende neuralt netværksarkitektur, der har transformeret kunstig intelligens, især inden for naturlig sprogbehandling. Introduceret...