Vinduer (Windowing)

Vinduer (windowing) i kunstig intelligens refererer til behandling af data i segmenter eller “vinduer” for effektivt at analysere sekventiel information. Det er...

En indlejringsvektor repræsenterer data numerisk i et multidimensionelt rum og gør det muligt for AI-systemer at indfange semantiske relationer til opgaver som klassificering, klyngeanalyse og anbefalinger.

En indlejringsvektor er en tæt numerisk repræsentation af data, hvor hvert datapunkt mappes til et punkt i et multidimensionelt rum. Denne mapping er designet til at indfange semantisk information og kontekstuelle relationer mellem forskellige datapunkter. Lignende datapunkter placeres tættere på hinanden i dette rum, hvilket letter opgaver som klassificering, klyngeanalyse og anbefaling.

Indlejringsvektorer er i bund og grund arrays af tal, der indkapsler de indre egenskaber og relationer for de data, de repræsenterer. Ved at oversætte komplekse datatyper til disse vektorer kan AI-systemer udføre forskellige operationer mere effektivt.

Indlejringsvektorer er grundlæggende for mange AI- og ML-applikationer. De forenkler repræsentationen af høj-dimensionelle data, hvilket gør det lettere at analysere og fortolke.

Oprettelse af indlejringsvektorer involverer flere trin:

Huggingface’s Transformers-bibliotek tilbyder avancerede transformer-modeller som BERT, RoBERTa og GPT-3. Disse modeller er prætrænede på store datasæt og leverer indlejringer af høj kvalitet, som kan finjusteres til specifikke opgaver og dermed er ideelle til robuste NLP-applikationer.

Sørg først for, at du har transformers-biblioteket installeret i dit Python-miljø. Du kan installere det med pip:

pip install transformers

Dernæst indlæs en prætrænet model fra Huggingface modelhub. I dette eksempel bruger vi BERT.

from transformers import BertModel, BertTokenizer

model_name = 'bert-base-uncased'

tokenizer = BertTokenizer.from_pretrained(model_name)

model = BertModel.from_pretrained(model_name)

Tokeniser din inputtekst for at forberede den til modellen.

inputs = tokenizer("Hello, Huggingface!", return_tensors='pt')

Send den tokeniserede tekst gennem modellen for at få indlejringer.

outputs = model(**inputs)

embedding_vectors = outputs.last_hidden_state

Her er et komplet eksempel, der demonstrerer de ovenstående trin:

from transformers import BertModel, BertTokenizer

# Indlæs prætrænet BERT-model og tokenizer

model_name = 'bert-base-uncased'

tokenizer = BertTokenizer.from_pretrained(model_name)

model = BertModel.from_pretrained(model_name)

# Tokeniser inputtekst

text = "Hello, Huggingface!"

inputs = tokenizer(text, return_tensors='pt')

# Generér indlejringsvektorer

outputs = model(**inputs)

embedding_vectors = outputs.last_hidden_state

print(embedding_vectors)

SNE er en tidlig metode til dimensionalitetsreduktion, udviklet af Geoffrey Hinton og Sam Roweis. Den fungerer ved at beregne parvise ligheder i det høj-dimensionelle rum og forsøger at bevare disse ligheder i et lavere dimensionelt rum.

En forbedring af SNE, t-SNE bruges bredt til at visualisere høj-dimensionelle data. Den minimerer divergensen mellem to fordelinger: én, der repræsenterer parvise ligheder i det oprindelige rum, og én i det reducerede rum, ved hjælp af en tunghalet Student-t-fordeling.

UMAP er en nyere teknik, der tilbyder hurtigere beregning og bedre bevarelse af globale datastrukturer sammenlignet med t-SNE. Den konstruerer en høj-dimensionel graf og optimerer en lav-dimensionel graf til at være så strukturelt ens som muligt.

Flere værktøjer og biblioteker gør det lettere at visualisere indlejringsvektorer:

En indlejringsvektor er en tæt numerisk repræsentation af data, hvor hvert datapunkt mappes til en position i et multidimensionelt rum for at indfange semantiske og kontekstuelle relationer.

Indlejringsvektorer er grundlæggende i AI til at forenkle komplekse data og muliggøre opgaver som tekstklassificering, billedgenkendelse og personlige anbefalinger.

Indlejringsvektorer kan genereres ved hjælp af prætrænede modeller som BERT fra Huggingface Transformers-biblioteket. Ved at tokenisere dine data og sende dem gennem sådanne modeller, opnår du indlejringer af høj kvalitet til videre analyse.

Dimensionalitetsreduktionsteknikker som t-SNE og UMAP bruges ofte til at visualisere høj-dimensionelle indlejringsvektorer og hjælper med at fortolke og analysere dataprofiler.

Begynd at bygge dine egne AI-værktøjer og chatbots med FlowHunt’s no-code platform. Gør dine idéer til automatiserede flows nemt.

Vinduer (windowing) i kunstig intelligens refererer til behandling af data i segmenter eller “vinduer” for effektivt at analysere sekventiel information. Det er...

En inkorporeret AI-agent er et intelligent system, der opfatter, fortolker og interagerer med sit miljø gennem en fysisk eller virtuel krop. Lær hvordan disse a...

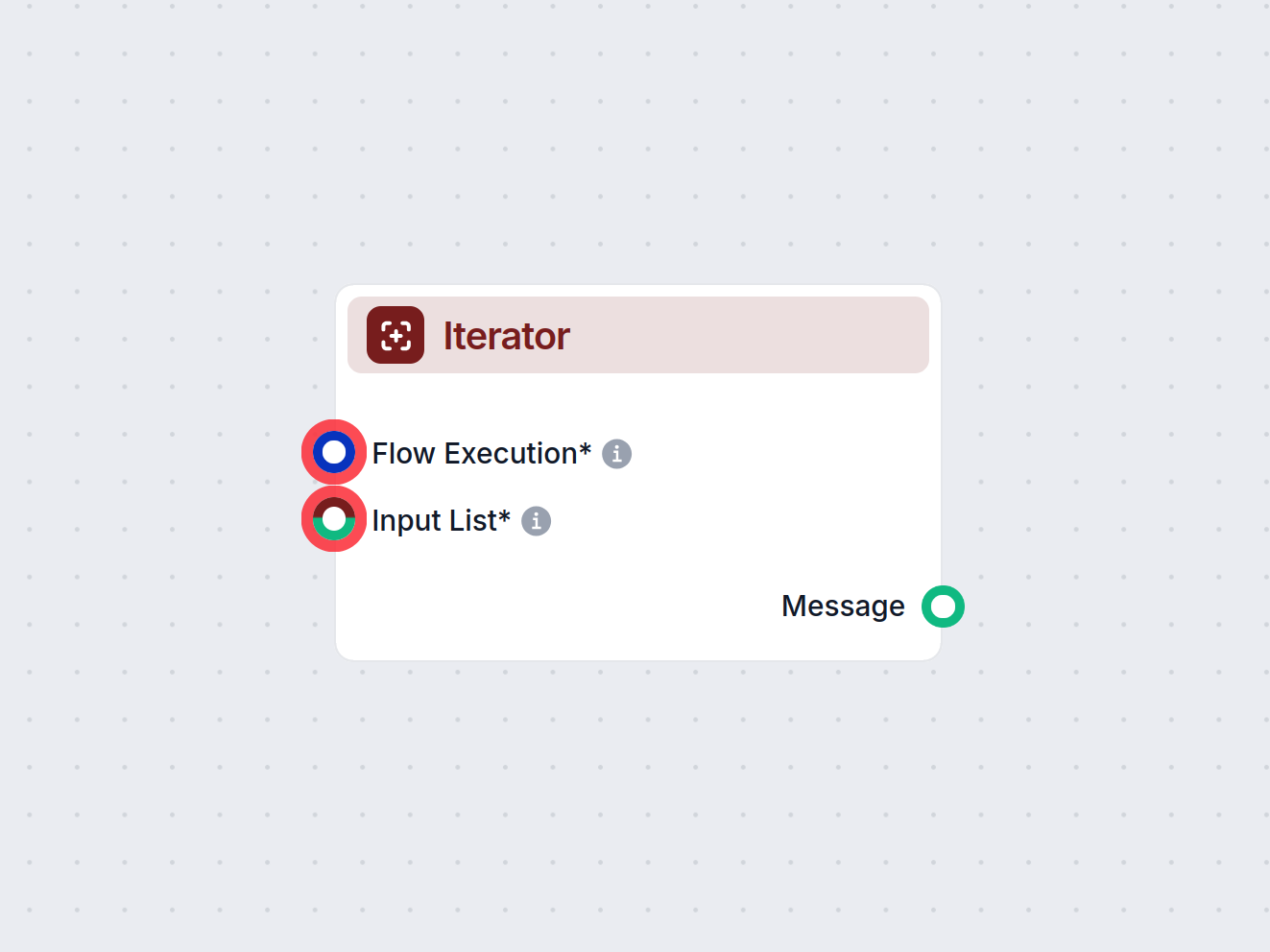

Iterator-komponenten i FlowHunt automatiserer gentagne opgaver ved at udføre et subflow eller eksternt flow for hvert element i en liste. Ideel til batchbehandl...