Find den bedste LLM til indholdsforfatning: Testet og rangeret

Vi har testet og rangeret skriveevnerne hos 5 populære modeller, der er tilgængelige i FlowHunt, for at finde den bedste LLM til indholdsforfatning.

llms.txt er en Markdown-fil, der forenkler websiteindhold for LLM’er og forbedrer AI-drevne interaktioner ved at levere et struktureret, maskinlæsbart indeks.

Filen llms.txt er en standardiseret tekstfil i Markdown-format, designet til at forbedre, hvordan Large Language Models (LLM’er) tilgår, forstår og behandler information fra websites. Placeret i roden af et website (f.eks. /llms.txt) fungerer denne fil som et kurateret indeks, der giver struktureret og opsummeret indhold, specifikt optimeret til maskinforbrug under inferens. Hovedformålet er at omgå kompleksiteten i traditionelt HTML-indhold—såsom navigationsmenuer, annoncer og JavaScript—ved at præsentere klare, læsbare data for både mennesker og maskiner.

I modsætning til andre webstandarder som robots.txt eller sitemap.xml er llms.txt eksplicit skræddersyet til reasoning engines såsom ChatGPT, Claude eller Google Gemini, snarere end søgemaskiner. Den hjælper AI-systemer med kun at hente den mest relevante og værdifulde information inden for begrænsningerne af deres kontekstvinduer, som ofte er for små til at håndtere hele indholdet af et website.

Konceptet blev foreslået af Jeremy Howard, medstifter af Answer.AI, i september 2024. Det opstod som en løsning på de ineffektiviteter, LLM’er oplever, når de interagerer med komplekse websites. Traditionelle metoder til behandling af HTML-sider fører ofte til spild af computerressourcer og fejlfortolkning af indhold. Ved at skabe en standard som llms.txt kan website-ejere sikre, at deres indhold parses nøjagtigt og effektivt af AI-systemer.

Filen llms.txt tjener flere praktiske formål, primært inden for kunstig intelligens og LLM-drevne interaktioner. Dens strukturerede format muliggør effektiv hentning og behandling af websiteindhold af LLM’er og overvinder begrænsninger i kontekstvinduestørrelse og proceseffektivitet.

Filen llms.txt følger et specifikt Markdown-baseret skema for at sikre kompatibilitet med både mennesker og maskiner. Strukturen omfatter:

Eksempel:

# Eksempel Website

> En platform til deling af viden og ressourcer om kunstig intelligens.

## Dokumentation

- [Quick Start Guide](https://example.com/docs/quickstart.md): En begynder-venlig guide til at komme i gang.

- [API Reference](https://example.com/docs/api.md): Detaljeret API-dokumentation.

## Politikker

- [Vilkår for brug](https://example.com/terms.md): Juridiske retningslinjer for brug af platformen.

- [Privatlivspolitik](https://example.com/privacy.md): Information om datahåndtering og brugerens privatliv.

## Optional

- [Virksomhedens historie](https://example.com/history.md): En tidslinje over vigtige milepæle og resultater.

llms.txt til at dirigere AI-systemer til produkttaksonomier, returpolitikker og størrelsesguider.FastHTML, et Python-bibliotek til at opbygge server-renderede webapplikationer, bruger llms.txt til at forenkle adgang til sin dokumentation. Filen indeholder links til quickstart-guides, HTMX-referencer og eksempler på applikationer, så udviklere hurtigt kan finde specifikke ressourcer.

Eksempeludsnit:

# FastHTML

> Et Python-bibliotek til at skabe server-renderede hypermedia-applikationer.

## Docs

- [Quick Start](https://fastht.ml/docs/quickstart.md): Oversigt over nøglefunktioner.

- [HTMX Reference](https://github.com/bigskysoftware/htmx/blob/master/www/content/reference.md): Fuld oversigt over HTMX-attributter og -metoder.

En e-handelsgigant som Nike kunne bruge en llms.txt-fil til at give AI-systemer information om deres produktlinjer, bæredygtighedsinitiativer og kundesupportpolitikker.

Eksempeludsnit:

# Nike

> Global leder inden for sportssko og -beklædning med fokus på bæredygtighed og innovation.

## Produktlinjer

- [Løbesko](https://nike.com/products/running.md): Detaljer om React-skum og Vaporweave-teknologier.

- [Bæredygtighedsinitiativer](https://nike.com/sustainability.md): Mål for 2025 og miljøvenlige materialer.

## Kundesupport

- [Returpolitik](https://nike.com/returns.md): 60-dages returret og undtagelser.

- [Størrelsesguider](https://nike.com/sizing.md): Skemaer for skostørrelser og beklædning.

Selvom alle tre standarder er designet til at hjælpe automatiserede systemer, adskiller deres formål og målgrupper sig betydeligt.

llms.txt:

robots.txt:

sitemap.xml:

robots.txt og sitemap.xml er llms.txt designet til reasoning engines, ikke traditionelle søgemaskiner.llms.txt og llms-full.txt for hostet dokumentation.llms.txt.https://example.com/llms.txt).llms_txt2ctx for at sikre overholdelse af standarden.llms.txt eller llms-full.txt direkte (f.eks. Claude eller ChatGPT).llms.txt har vundet indpas blandt udviklere og mindre platforme, er den endnu ikke officielt understøttet af store LLM-udbydere som OpenAI eller Google.llms-full.txt overstige kontekstvinduets størrelse for visse LLM’er.På trods af disse udfordringer repræsenterer llms.txt en fremadskuende tilgang til at optimere indhold for AI-drevne systemer. Ved at adoptere denne standard kan organisationer sikre, at deres indhold er tilgængeligt, nøjagtigt og prioriteret i en AI-først-verden.

Forskning: Large Language Models (LLM’er)

Large Language Models (LLM’er) er blevet en dominerende teknologi inden for naturlig sprogbehandling og driver applikationer som chatbots, indholdsmoderering og søgemaskiner. I “Lost in Translation: Large Language Models in Non-English Content Analysis” af Nicholas og Bhatia (2023) giver forfatterne en klar teknisk forklaring på, hvordan LLM’er fungerer, fremhæver datatilgængelighedsgabet mellem engelsk og andre sprog, og diskuterer bestræbelserne på at bygge bro over dette gennem flersprogede modeller. Artiklen beskriver udfordringerne ved indholdsanalyse med LLM’er, især i flersprogede sammenhænge, og giver anbefalinger til forskere, virksomheder og beslutningstagere vedrørende implementering og udvikling af LLM’er. Forfatterne understreger, at der på trods af fremskridt stadig er betydelige begrænsninger for ikke-engelske sprog. Læs artiklen

Artiklen “Cedille: A large autoregressive French language model” af Müller og Laurent (2022) introducerer Cedille, en storskala franskspecifik sprogmodel. Cedille er open source og demonstrerer overlegen ydeevne på franske zero-shot benchmarks sammenlignet med eksisterende modeller, og matcher endda GPT-3 på flere opgaver. Studiet evaluerer også sikkerheden af Cedille og viser forbedringer i toksicitet gennem omhyggelig datasætsfiltrering. Dette arbejde understreger vigtigheden og effekten af at udvikle LLM’er, der er optimeret til specifikke sprog. Artiklen fremhæver behovet for sprogspecifikke ressourcer i LLM-landskabet. Læs artiklen

I “How Good are Commercial Large Language Models on African Languages?” af Ojo og Ogueji (2023) vurderer forfatterne ydeevnen af kommercielle LLM’er på afrikanske sprog for både oversættelse og tekstopgave-klassifikation. Resultaterne viser, at disse modeller generelt underpræsterer på afrikanske sprog, med bedre resultater i klassifikation end i oversættelse. Analysen dækker otte afrikanske sprog fra forskellige sprogfamilier og regioner. Forfatterne opfordrer til større repræsentation af afrikanske sprog i kommercielle LLM’er i takt med deres stigende udbredelse. Studiet fremhæver de nuværende mangler og behovet for mere inkluderende sprogmodeludvikling. Læs artiklen

“Goldfish: Monolingual Language Models for 350 Languages” af Chang et al. (2024) undersøger ydeevnen af monolinguale versus flersprogede modeller for sprog med få ressourcer. Forskningen viser, at store flersprogede modeller ofte underpræsterer i forhold til simple bigrammodeller for mange sprog, målt ved FLORES perplexity. Goldfish introducerer monolingvale modeller trænet til 350 sprog og forbedrer markant ydeevnen for sprog med få ressourcer. Forfatterne opfordrer til mere målrettet modeludvikling for mindre repræsenterede sprog. Dette arbejde bidrager med værdifuld indsigt i begrænsningerne ved nuværende flersprogede LLM’er og potentialet i monolingvale alternativer. Læs artiklen

llms.txt er en standardiseret Markdown-fil, der er placeret i roden af et website (f.eks. /llms.txt), og som giver et kurateret indeks over indhold optimeret til Large Language Models, hvilket muliggør effektive AI-drevne interaktioner.

I modsætning til robots.txt (til søgemaskine-crawling) eller sitemap.xml (til indeksering) er llms.txt designet til LLM'er og tilbyder en forenklet, Markdown-baseret struktur, der prioriterer indhold med høj værdi for AI-reasoning.

Den indeholder en H1-overskrift (websitetitel), et blokcitat-resumé, detaljerede afsnit til kontekst, H2-opdelte ressourcelister med links og beskrivelser samt en valgfri sektion til sekundære ressourcer.

llms.txt blev foreslået af Jeremy Howard, medstifter af Answer.AI, i september 2024 for at adressere ineffektivitet i, hvordan LLM'er behandler komplekst websiteindhold.

llms.txt forbedrer LLM-effektiviteten ved at reducere støj (f.eks. annoncer, JavaScript), optimere indhold til kontekstvinduer og muliggøre præcis parsing til applikationer som teknisk dokumentation eller e-handel.

Den kan manuelt skrives i Markdown eller genereres med værktøjer som Mintlify eller Firecrawl. Valideringsværktøjer som llms_txt2ctx sikrer overholdelse af standarden.

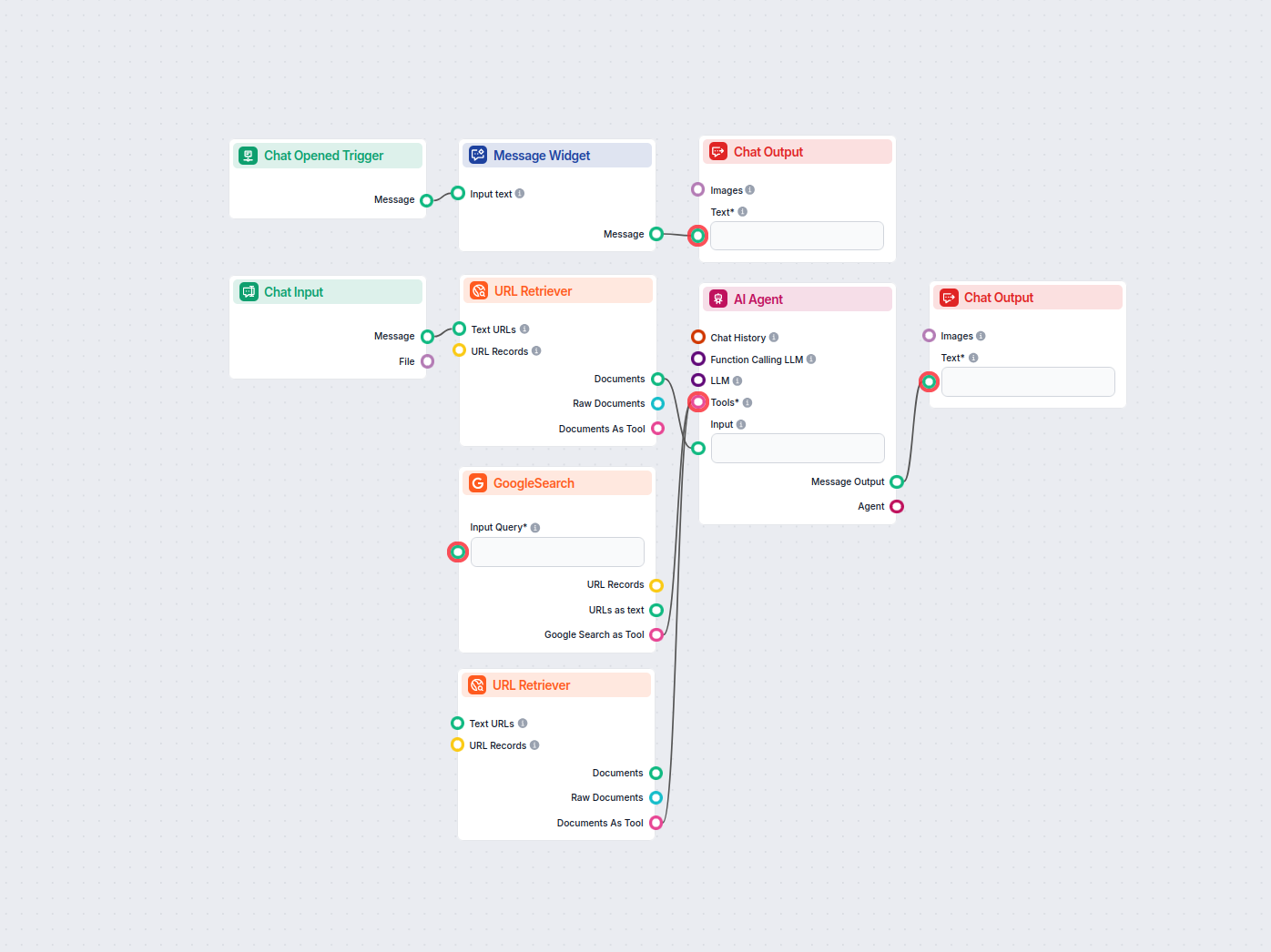

Lær hvordan du implementerer llms.txt med FlowHunt for at gøre dit indhold AI-klar og forbedre interaktionen med Large Language Models.

Vi har testet og rangeret skriveevnerne hos 5 populære modeller, der er tilgængelige i FlowHunt, for at finde den bedste LLM til indholdsforfatning.

Omdan din hjemmesides sitemap.xml til LLM-venligt dokumentationsformat automatisk. Denne AI-drevne konverter udtrækker, behandler og strukturerer dit webindhold...

Omdan enhver sitemap.xml til et velstruktureret llms.txt-format ved hjælp af AI. Dette workflow henter URL'er fra et sitemap, indsamler og behandler deres indho...