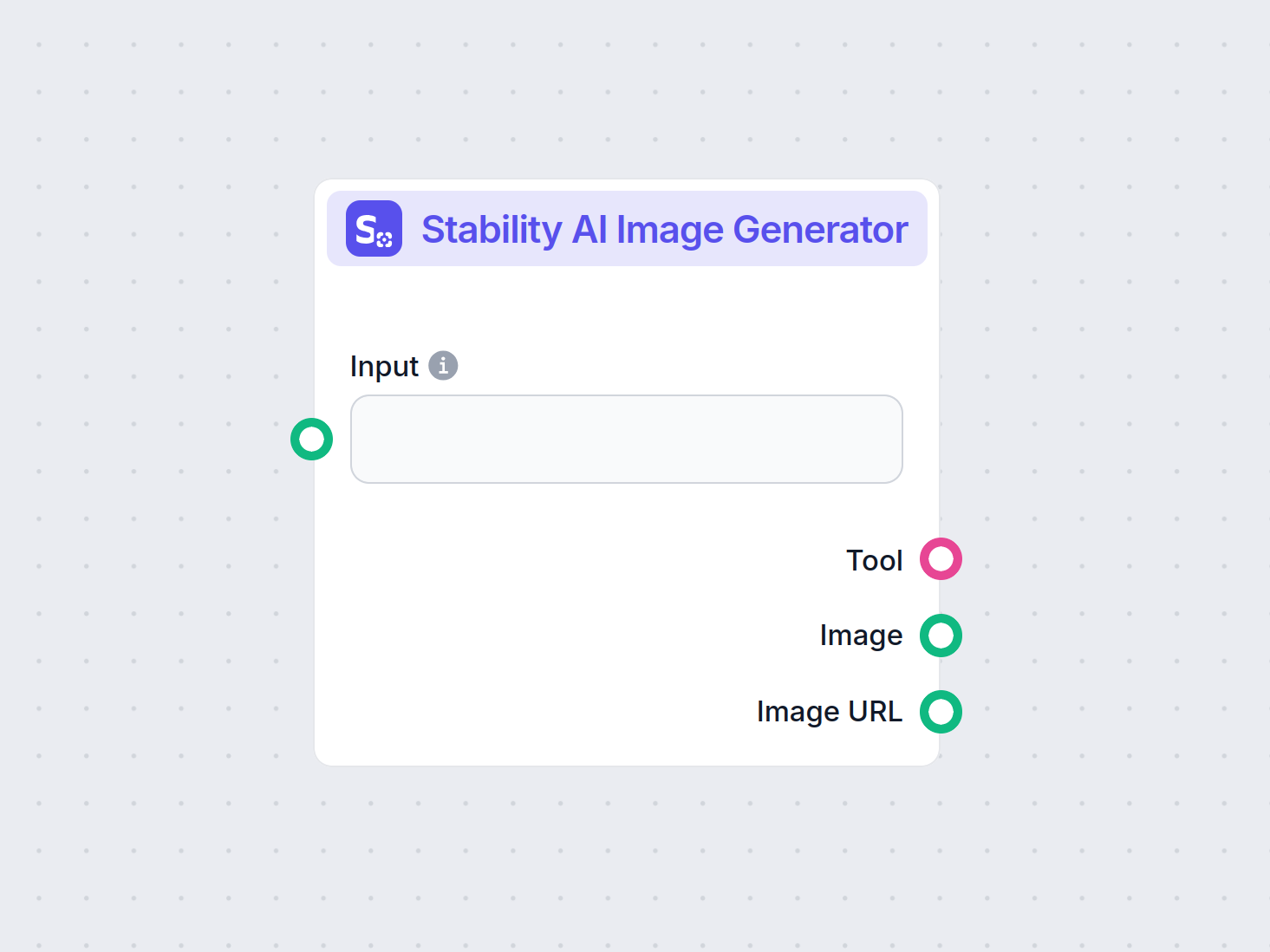

Stability AI Billedgenerator

Generer billeder i høj kvalitet ud fra tekstprompter med Stability AI Billedgenerator-komponenten. Drevet af Stable Diffusion-modeller tilbyder dette værktøj ti...

Stable Diffusion er en førende tekst-til-billede AI-model, der gør det muligt for brugere at generere fotorealistiske visuelle billeder ud fra prompts ved hjælp af avancerede latent diffusion- og dyblæringsteknikker.

Stable Diffusion er en tekst-til-billede AI-model, der skaber billeder i høj kvalitet ud fra beskrivelser ved hjælp af dyb læring. Den anvender teknikker som negative prompts og referencebilleder for bedre resultater, især med komplekse elementer som hænder.

Stable Diffusion er en avanceret tekst-til-billede-genereringsmodel, der udnytter dyblæringsteknikker til at producere billeder i høj kvalitet og fotorealistisk stil baseret på tekstbeskrivelser. Udviklet som en latent diffusonsmodel repræsenterer den et væsentligt gennembrud inden for generativ kunstig intelligens, hvor principper fra diffusionmodeller og maskinlæring kombineres for at skabe billeder, der nøje matcher givne tekstprompter.

Stable Diffusion bruger dyb læring og diffusionmodeller til at generere billeder ved at forfine tilfældig støj for at skabe sammenhængende visuelle billeder. På trods af sin omfattende træning på millioner af billeder har den udfordringer med komplekse elementer som hænder. Over tid, efterhånden som modellerne trænes på større og større datasæt, mindskes disse problemer, og billedkvaliteten bliver mere og mere realistisk.

En effektiv metode til at tackle håndproblemet er at bruge negative prompts. Ved at tilføje sætninger som (-dårlig anatomi) eller (-dårlige hænder -unaturlige hænder) til dine prompts kan du instruere AI’en i at undgå forvrængede træk. Vær opmærksom på ikke at overdrive brugen af negative prompts, da det kan begrænse modellens kreative output.

En anden teknik indebærer brug af referencebilleder til at guide AI’en. Ved at inkludere et {image}-tag med et link til et referencebillede i din prompt, giver du AI’en en visuel skabelon for nøjagtig gengivelse af hænder. Dette er især nyttigt for at opretholde korrekte proportioner og positurer for hænder.

For de bedste resultater bør du kombinere både negative prompts og referencebilleder. Denne dobbelte tilgang sikrer, at AI’en undgår almindelige fejl og samtidig følger eksempler i høj kvalitet.

(-bøjede fingre) eller (realistiske perspektiver) for yderligere at forbedre håndkvaliteten.Ved at mestre disse teknikker kan du markant forbedre håndgengivelsen i dine Stable Diffusion-kreationer og opnå kunstværker med en erfaren kunstners finesse. Saml dine referencebilleder, lav præcise prompts, og se din AI-kunst udvikle sig!

Kernen i Stable Diffusion er transformationen af tekstprompter til visuelle repræsentationer gennem en række beregningsprocesser. Forståelsen af dens funktionalitet involverer diffusionmodeller, latente rum og neurale netværk.

Diffusionsmodeller er en klasse af generative modeller inden for maskinlæring, der lærer at skabe data ved at omvende en diffusionsproces. Diffusionsprocessen indebærer gradvist at tilføje støj til data—f.eks. billeder—indtil de ikke kan skelnes fra tilfældig støj. Modellen lærer derefter at omvende denne proces ved trin for trin at fjerne støj for at genskabe de oprindelige data. Denne omvendte diffusionsproces er nøglen til at generere nye, sammenhængende data ud fra tilfældig støj.

Stable Diffusion bruger specifikt en latent diffusionsmodel. I modsætning til traditionelle diffusionsmodeller, der arbejder direkte i billeders højdimensionelle pixelrum, arbejder latente diffusionsmodeller i et komprimeret latent rum. Dette latente rum er en lavere-dimensionel repræsentation af dataene, som indfanger væsentlige træk og reducerer den beregningsmæssige kompleksitet. Ved at arbejde i det latente rum kan Stable Diffusion generere billeder i høj opløsning mere effektivt.

Den centrale mekanisme i Stable Diffusion involverer den omvendte diffusionsproces i det latente rum. Ud fra en tilfældig støjvektor forfiner modellen denne latente repræsentation ved at forudsige og fjerne støj trin for trin. Denne forfining styres af den tekstbeskrivelse, som brugeren angiver. Processen fortsætter, indtil den latente vektor konvergerer til en tilstand, som ved dekodning producerer et billede, der stemmer overens med tekstprompten.

Stable Diffusions arkitektur integrerer flere centrale komponenter, der arbejder sammen om at omdanne tekstprompter til billeder.

VAE fungerer som et encoder-decoder-system, der komprimerer billeder til det latente rum og rekonstruerer dem tilbage til billeder. Encoderen transformerer et billede til dets latente repræsentation og indfanger de grundlæggende træk i en reduceret form. Decoderen tager denne latente repræsentation og rekonstruerer den til det detaljerede billede.

Denne proces er afgørende, fordi den gør det muligt for modellen at arbejde med data i lavere dimensioner og dermed reducere ressourceforbruget betydeligt sammenlignet med at arbejde i hele pixelrummet.

U-Net er en specialiseret neural netværksarkitektur, der bruges i Stable Diffusion til billedbehandling. Den består af en encode-sti og en decode-sti med skip-connections mellem spejlvendte lag. I Stable Diffusion fungerer U-Net som støjforudsigeren under den omvendte diffusionsproces.

Ved hvert tidssteg i diffusionsprocessen forudsiger U-Net mængden af støj i den latente repræsentation. Denne forudsigelse bruges derefter til at forfine den latente vektor ved at trække den estimerede støj fra og gradvist denoise det latente rum mod et billede, der stemmer overens med tekstprompten.

For at inkorporere tekstinformation benytter Stable Diffusion en tekstencoder baseret på CLIP (Contrastive Language-Image Pretraining). CLIP er designet til at forstå og relatere tekstuel og visuel information ved at kortlægge dem til et fælles latent rum.

Når en bruger angiver en tekstprompt, konverterer tekstencoderen denne prompt til en række embeddings—numeriske repræsentationer af tekstdataene. Disse embeddings conditionerer U-Net under den omvendte diffusionsproces, så billedgenereringen afspejler indholdet af tekstprompten.

Stable Diffusion tilbyder alsidighed i generering af billeder og kan anvendes på forskellige måder afhængigt af brugerens behov.

Den primære anvendelse af Stable Diffusion er generering af billeder ud fra tekstprompter. Brugere indtaster beskrivende tekst, og modellen genererer et billede, der repræsenterer beskrivelsen. For eksempel kan en bruger indtaste “En fredelig strand ved solnedgang med palmer” og få et billede, der viser denne scene.

Denne mulighed er særligt værdifuld inden for kreative brancher, indholdsproduktion og design, hvor hurtig visualisering af koncepter er afgørende.

Ud over at generere billeder fra bunden kan Stable Diffusion også ændre eksisterende billeder baseret på tekstinstruktioner. Ved at levere et udgangsbillede og en tekstprompt kan modellen skabe et nyt billede, der indarbejder de ændringer, teksten beskriver.

For eksempel kan en bruger indtaste et billede af et bylandskab om dagen med prompten “ændr til nat med neonlys”, hvilket resulterer i et billede, der afspejler disse ændringer.

Inpainting indebærer udfyldning af manglende eller ødelagte dele af et billede. Stable Diffusion udmærker sig på dette område ved at bruge tekstprompter til at guide rekonstruktionen af specifikke billedområder. Brugere kan maskere dele af et billede og angive med tekst, hvad der skal udfylde pladsen.

Denne funktion er nyttig ved fotorestaurering, fjernelse af uønskede objekter eller ændring af specifikke elementer i et billede, mens den overordnede sammenhæng bevares.

Ved at generere sekvenser af billeder med små variationer kan Stable Diffusion udvides til at skabe animationer eller videomateriale. Værktøjer som Deforum udvider Stable Diffusions muligheder for at producere dynamisk visuelt indhold styret af tekstprompter over tid.

Dette åbner op for nye muligheder inden for animation, visuelle effekter og dynamisk indholdsgenerering uden behov for traditionelle frame-by-frame-animationsteknikker.

Stable Diffusions evne til at generere billeder ud fra tekstbeskrivelser gør den til et stærkt værktøj i AI-automatisering og chatbot-udvikling.

Ved at integrere Stable Diffusion i chatbots kan man generere visuelt indhold som svar på brugerforespørgsler. For eksempel kan en chatbot i kundeservice give visuelle vejledninger eller illustrationer, der genereres på stedet for at hjælpe brugere.

Tekstprompter konverteres til embeddings ved hjælp af CLIP-tekstencoderen. Disse embeddings er afgørende for at conditionere billedgenereringsprocessen, så det genererede billede stemmer overens med brugerens tekstbeskrivelse.

Den omvendte diffusionsproces indebærer iterativ forfining af den latente repræsentation ved at fjerne forudsagt støj. Ved hvert tidssteg tager modellen højde for tekstembeddings og den aktuelle tilstand af den latente vektor for nøjagtigt at forudsige støjkomponenten.

Modellens evne til at håndtere støjfyldte billeder skyldes dens træning på store datasæt, hvor den lærer at skelne og denoise billeder effektivt. Denne træning gør den i stand til at generere klare billeder, selv når den starter fra tilfældig støj.

Arbejdet i det latente rum giver beregningsmæssig effektivitet. Da det latente rum har færre dimensioner end pixelrummet, er operationerne mindre ressourcekrævende. Denne effektivitet gør det muligt for Stable Diffusion at generere billeder i høj opløsning uden store beregningskrav.

Kunstnere og designere kan bruge Stable Diffusion til hurtigt at prototype visuelle billeder ud fra konceptuelle beskrivelser, hvilket hjælper den kreative proces og reducerer tiden fra idé til visualisering.

Markedsføringsteams kan generere brugerdefinerede billeder til kampagner, sociale medier og annoncer uden behov for omfattende grafiske ressourcer.

Spiludviklere kan skabe assets, miljøer og konceptkunst ved at give beskrivende prompts, hvilket effektiviserer asset-skabelsesprocessen.

Forhandlere kan generere billeder af produkter i forskellige miljøer eller konfigurationer, hvilket forbedrer produktvisualiseringen og kundeoplevelsen.

Undervisere og indholdsproducenter kan skabe illustrationer og diagrammer til at forklare komplekse emner og gøre undervisningsmaterialer mere engagerende.

Forskere inden for kunstig intelligens og computervision kan bruge Stable Diffusion til at udforske diffusionmodellers og latente rums muligheder yderligere.

For at bruge Stable Diffusion effektivt skal visse tekniske overvejelser tages i betragtning.

For at komme i gang med Stable Diffusion skal du følge disse trin:

For udviklere, der bygger AI-automatiseringssystemer og chatbots, kan Stable Diffusion integreres for at øge funktionaliteten.

Når du bruger Stable Diffusion, er det vigtigt at være opmærksom på etiske implikationer.

Stable diffusion er et væsentligt emne inden for generative modeller, især til dataforøgelse og billedsyntese. Nyere studier har udforsket forskellige aspekter af stable diffusion og fremhævet dets anvendelser og effektivitet.

Diffusion Least Mean P-Power Algorithms for Distributed Estimation in Alpha-Stable Noise Environments af Fuxi Wen (2013):

Introducerer en diffusion least mean p-power (LMP) algoritme designet til distribueret estimering i miljøer karakteriseret ved alpha-stabil støj. Studiet sammenligner diffusion LMP-metoden med diffusion least mean squares (LMS) algoritmen og demonstrerer forbedret ydeevne under alpha-stabil støj. Denne forskning er vigtig for udvikling af robuste estimeringsteknikker i støjfyldte miljøer. Læs mere

Stable Diffusion for Data Augmentation in COCO and Weed Datasets af Boyang Deng (2024):

Undersøger brugen af stable diffusion-modeller til at generere syntetiske billeder i høj opløsning for at forbedre små datasæt. Ved at udnytte teknikker som billede-til-billede-oversættelse, Dreambooth og ControlNet vurderer forskningen effektiviteten af stable diffusion i klassificerings- og detektionsopgaver. Resultaterne peger på lovende anvendelser af stable diffusion på flere områder. Læs mere

Diffusion and Relaxation Controlled by Tempered α-stable Processes af Aleksander Stanislavsky, Karina Weron og Aleksander Weron (2011):

Udleder egenskaber af anomal diffusion og ikke-eksponentiel afslapning ved brug af tempererede α-stabile processer. Artiklen adresserer problemer med uendelige momenter forbundet med α-stabil tilfældig operationel tid og giver en model, der inkluderer subdiffusion som et særtilfælde. Læs mere

Evaluating a Synthetic Image Dataset Generated with Stable Diffusion af Andreas Stöckl (2022):

Evaluerer syntetiske billeder genereret af Stable Diffusion-modellen ved hjælp af Wordnet-taksonomi. Den undersøger modellens evne til at producere korrekte billeder for forskellige koncepter og illustrerer forskelle i repræsentationsnøjagtighed. Disse evalueringer er vigtige for at forstå stable diffusions rolle i dataforøgelse. Læs mere

Comparative Analysis of Generative Models: Enhancing Image Synthesis with VAEs, GANs, and Stable Diffusion af Sanchayan Vivekananthan (2024):

Udforsker tre generative frameworks: VAE’er, GAN’er og Stable Diffusion-modeller. Forskningen fremhæver styrker og begrænsninger ved hver model og noterer, at mens VAE’er og GAN’er har deres fordele, udmærker stable diffusion sig på visse synteseopgaver. Læs mere

Lad os se på, hvordan man implementerer en Stable Diffusion Model i Python ved hjælp af Hugging Face Diffusers-biblioteket.

Installer de nødvendige biblioteker:

pip install torch transformers diffusers accelerate

pip install xformers # Valgfrit

Diffusers-biblioteket tilbyder en nem måde at indlæse prætrænede modeller på:

from diffusers import StableDiffusionPipeline

import torch

# Indlæs Stable Diffusion-modellen

model_id = "stabilityai/stable-diffusion-2-1"

pipe = StableDiffusionPipeline.from_pretrained(model_id, torch_dtype=torch.float16)

pipe = pipe.to("cuda") # Flyt modellen til GPU for hurtigere inferens

For at generere billeder skal du blot angive en tekstprompt:

prompt = "Et fredfyldt landskab med bjerge og en sø, fotorealistisk, 8K opløsning"

image = pipe(prompt).images[0]

# Gem eller vis billedet

image.save("generated_image.png")

model_id.torch.float16 reducerer hukommelsesforbruget.Du kan tilpasse forskellige parametre:

image = pipe(

prompt=prompt,

num_inference_steps=50, # Antal denoising-trin

guidance

Stable Diffusion er en avanceret AI-model designet til at generere billeder i høj kvalitet og fotorealistisk stil ud fra tekstprompter. Den bruger latent diffusion og dyb læring til at omdanne tekstbeskrivelser til visuelle billeder.

Stable Diffusion fungerer ved at omdanne tekstprompter til billedembeddings ved hjælp af en CLIP-tekstencoder, og derefter iterativt fjerne støj fra en latent repræsentation styret af prompten, hvilket resulterer i et sammenhængende billedoutput.

Stable Diffusion bruges til kreativ indholdsgenerering, markedsføringsmaterialer, oprettelse af spilelementer, e-handels produktvisualisering, undervisningsillustrationer og AI-drevne chatbots.

Ja, Stable Diffusion understøtter billede-til-billede-oversættelse og inpainting, så brugerne kan ændre eksisterende billeder eller udfylde manglende dele baseret på tekstprompter.

Det anbefales at have en computer med et moderne GPU til effektiv billedgenerering med Stable Diffusion. Modellen kræver også Python og biblioteker som PyTorch og Diffusers.

Ja, Stable Diffusion er udgivet under en tilladende open source-licens, hvilket tilskynder til bidrag fra fællesskabet, tilpasning og bred tilgængelighed.

Slip din kreativitet løs med Stable Diffusion og se, hvordan AI kan forvandle dine idéer til fantastiske visuelle billeder.

Generer billeder i høj kvalitet ud fra tekstprompter med Stability AI Billedgenerator-komponenten. Drevet af Stable Diffusion-modeller tilbyder dette værktøj ti...

Udforsk vores dybdegående anmeldelse af Stability AI SD3 Large. Analysér dens styrker, svagheder og kreative output på tværs af forskellige tekst-til-billede-pr...

Flux AI Model fra Black Forest Labs er et avanceret tekst-til-billede-genereringssystem, der omdanner naturlige sprog-prompter til meget detaljerede, fotorealis...