Brugerdefineret OpenAI LLM

Lås op for kraften i brugerdefinerede sprogmodeller med komponenten Custom OpenAI LLM i FlowHunt. Integrer problemfrit dine egne OpenAI-kompatible modeller—incl...

OpenAI Whisper er et open-source ASR-system, der nøjagtigt konverterer tale til tekst på 99 sprog, med understøttelse af transskription, oversættelse og sprogidentifikation til robust AI-automatisering.

OpenAI Whisper kan betragtes som både en model og et system, afhængigt af konteksten.

Whispers primære funktion er at transskribere tale til tekst-output. Det udmærker sig ved:

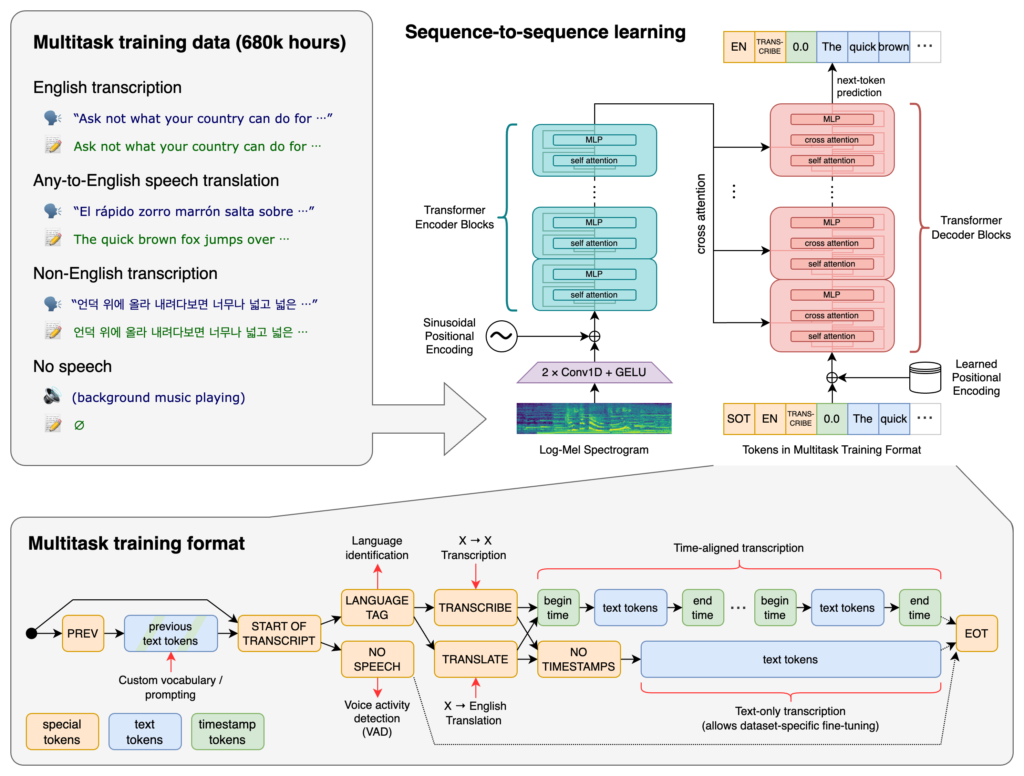

Kernen i Whisper er Transformer-arkitekturen, specifikt en encoder-decoder-model. Transformere er neurale netværk, der er fremragende til at behandle sekventielle data og forstå kontekst over lange sekvenser. Transformer-arkitekturen blev introduceret i “Attention is All You Need”-artiklen i 2017 og er blevet grundlaget for mange NLP-opgaver.

Whispers proces involverer:

Whisper blev trænet på et enormt datasæt af 680.000 timers superviseret data indsamlet fra nettet. Dette inkluderer:

Med understøttelse af 99 sprog udmærker Whisper sig ved at kunne håndtere forskellige sproglige input. Denne flersprogede kapacitet gør det velegnet til globale applikationer og tjenester, der retter sig mod internationale brugere.

Takket være omfattende superviseret data opnår Whisper høje nøjagtigheder i transskriptionsopgaver. Dets robusthed over for forskellige accenter, dialekter og baggrundsstøj gør det pålideligt i mange virkelighedsscenarier.

Ud over transskription kan Whisper udføre:

Whisper er udgivet som open-source software, hvilket gør det muligt for udviklere at:

Ved at integrere Whisper i chatbots og AI-assistenter kan udviklere muliggøre:

Whisper er implementeret som et Python-bibliotek, hvilket muliggør problemfri integration i Python-baserede projekter. Brug af Whisper i Python indebærer opsætning af det rette miljø, installation af nødvendige afhængigheder og anvendelse af bibliotekets funktioner til at transskribere eller oversætte lydfiler.

Før du bruger Whisper, skal du forberede dit udviklingsmiljø ved at installere Python, PyTorch, FFmpeg og selve Whisper-biblioteket.

Hvis du ikke har Python installeret, kan du hente det fra den officielle hjemmeside. For at installere PyTorch, brug pip:

pip install torch

Alternativt kan du besøge PyTorchs hjemmeside for specifikke installationsvejledninger til dit styresystem og Python-version.

Whisper kræver FFmpeg for at behandle lydfiler. Installér FFmpeg med den relevante pakkehåndtering til dit styresystem.

Ubuntu/Debian:

sudo apt update && sudo apt install ffmpeg

MacOS (med Homebrew):

brew install ffmpeg

Windows (med Chocolatey):

choco install ffmpeg

Installér Whisper Python-pakken med pip:

pip install -U openai-whisper

For at installere den nyeste version direkte fra GitHub:

pip install git+https://github.com/openai/whisper.git

Sørg for, at Udviklertilstand er aktiveret:

Whisper tilbyder flere modeller, der varierer i størrelse og evner. Modellerne spænder fra tiny til large, hvor hver især balancerer hastighed og nøjagtighed forskelligt.

| Størrelse | Parametre | Kun engelsk model | Flersproget model | Påkrævet VRAM | Relativ hastighed |

|---|---|---|---|---|---|

| tiny | 39 M | tiny.en | tiny | ~1 GB | ~32x |

| base | 74 M | base.en | base | ~1 GB | ~16x |

| small | 244 M | small.en | small | ~2 GB | ~6x |

| medium | 769 M | medium.en | medium | ~5 GB | ~2x |

| large | 1550 M | N/A | large | ~10 GB | 1x |

.en): Optimeret til engelsk transskription og giver forbedret ydeevne for engelske lydfiler.Når dit miljø er sat op, og de nødvendige komponenter er installeret, kan du begynde at bruge Whisper i dine Python-projekter.

Start med at importere Whisper-biblioteket og indlæse en model:

import whisper

# Indlæs den ønskede model

model = whisper.load_model("base")

Erstat "base" med navnet på den model, der passer til dit formål.

Whisper tilbyder en enkel transcribe-funktion til at konvertere lydfiler til tekst.

Eksempel: Transskribering af en engelsk lydfil

# Transskriber lydfilen

result = model.transcribe("path/to/english_audio.mp3")

# Udskriv transskriptionen

print(result["text"])

model.transcribe(): Behandler lydfilen og returnerer et dictionary med transskriptionen og andre metadata.result["text"]: Giver adgang til den transskriberede tekst fra resultatet.Whisper kan oversætte lyd fra forskellige sprog til engelsk.

Eksempel: Oversæt spansk lyd til engelsk

# Transskriber og oversæt spansk lyd til engelsk

result = model.transcribe("path/to/spanish_audio.mp3", task="translate")

# Udskriv den oversatte tekst

print(result["text"])

task="translate": Instruerer modellen i at oversætte lyden til engelsk i stedet for at transskribere ordret.Selv om Whisper automatisk kan registrere sproget, kan det forbedre nøjagtigheden og hastigheden at angive sproget.

Eksempel: Transskriber fransk lyd

# Transskriber fransk lyd med angivet sprog

result = model.transcribe("path/to/french_audio.wav", language="fr")

# Udskriv transskriptionen

print(result["text"])

Whisper kan identificere sproget i en lydfil ved at bruge detect_language-metoden.

Eksempel: Sprogdetektion

# Indlæs og forbehandl lyden

audio = whisper.load_audio("path/to/unknown_language_audio.mp3")

audio = whisper.pad_or_trim(audio)

# Konvertér til log-Mel-spektrogram

mel = whisper.log_mel_spectrogram(audio).to(model.device)

# Registrér sproget

_, probs = model.detect_language(mel)

language = max(probs, key=probs.get)

print(f"Detected language: {language}")

whisper.load_audio(): Indlæser lydfilen.whisper.pad_or_trim(): Justerer lydlængden til modellens inputkrav.whisper.log_mel_spectrogram(): Konverterer lyd til det format, modellen forventer.model.detect_language(): Returnerer sandsynligheder for hvert sprog og identificerer det mest sandsynlige.For mere kontrol over transskriptionsprocessen kan du bruge lavere-niveau funktioner og tilpasse afkodningsmuligheder.

decode-funktionendecode-funktionen gør det muligt at angive indstillinger som sprog, opgave og om tidsstempler skal medtages.

Eksempel: Tilpassede afkodningsindstillinger

# Angiv afkodningsindstillinger

options = whisper.DecodingOptions(language="de", without_timestamps=True)

# Afkod lyden

result = whisper.decode(model, mel, options)

# Udskriv den genkendte tekst

print(result.text)

Du kan integrere Whisper til at transskribere live-lydinput fra en mikrofon.

Eksempel: Transskribering af live-mikrofoninput

import whisper

import sounddevice as sd

# Indlæs modellen

model = whisper.load_model("base")

# Optag lyd fra mikrofonen

duration = 5 # sekunder

fs = 16000 # Samplingsrate

print("Optager...")

audio = sd.rec(int(duration * fs), samplerate=fs, channels=1, dtype='float32')

sd.wait

OpenAI Whisper er et avanceret automatisk talegenkendelsessystem (ASR) udviklet af OpenAI, designet til at transskribere talt sprog til skreven tekst ved hjælp af dyb læring. Det understøtter 99 sprog og udmærker sig inden for transskription, oversættelse og sprogidentifikation.

Whisper bruger en transformer-baseret encoder-decoder-arkitektur, behandler lyd til log-Mel-spektrogrammer, og genererer tekst via en sprogmodel. Det blev trænet på 680.000 timers flersproget, multitask-data for høj nøjagtighed og robusthed.

Whisper understøtter flersproget talegenkendelse, taleoversættelse, automatisk sprogidentifikation, robusthed over for accenter og støj, og tilbyder open-source adgang til tilpasning og integration.

Hardwarekravene afhænger af modellens størrelse: mindre modeller som 'tiny' kræver ~1GB VRAM, mens den største kræver ~10GB. Whisper kører hurtigere på GPU'er, men kan også køre på CPU'er med længere behandlingstid.

Ja, Whisper er implementeret som et Python-bibliotek og kan installeres via pip. Det muliggør nem integration i Python-projekter til taletransskription, oversættelse og realtids stemmeapplikationer.

Almindelige anvendelser inkluderer automatiseret møde-transskription, stemmeaktiverede chatbots, live oversættelse, tilgængelighedsværktøjer (undertekster og hjælpemidler), callcenter-automatisering og stemmeaktiverede automationssystemer.

Ja, alternativer inkluderer open-source motorer som Mozilla DeepSpeech, Kaldi, Wav2vec, samt kommercielle API'er såsom Google Cloud Speech-to-Text, Microsoft Azure AI Speech og AWS Transcribe.

Ja, OpenAI Whisper er open-source, hvilket giver udviklere mulighed for at tilpasse, finjustere og integrere det i egne produkter og tjenester uden licensbegrænsninger.

Integrer avancerede speech-to-text-funktioner i dine applikationer, automatiser arbejdsgange, og forbedr brugeroplevelsen med OpenAI Whisper og FlowHunt.

Lås op for kraften i brugerdefinerede sprogmodeller med komponenten Custom OpenAI LLM i FlowHunt. Integrer problemfrit dine egne OpenAI-kompatible modeller—incl...

Find ud af mere om Opus-modellen af Claude fra Anthropic. Opdag dens styrker og svagheder, og hvordan den sammenlignes med andre modeller.

En stor sprogmodel (LLM) er en type AI, der er trænet på enorme tekstmængder for at forstå, generere og manipulere menneskesprog. LLM'er bruger dyb læring og tr...