Tekstgenerering

Tekstgenerering med store sprogmodeller (LLM'er) refererer til den avancerede brug af maskinlæringsmodeller til at producere menneskelignende tekst ud fra promp...

Vinduer i AI opdeler data i håndterbare segmenter, hvilket forbedrer konteksthåndtering og effektivitet i NLP, chatbots, oversættelse og tidsserieanalyse.

Vinduer (windowing) i kunstig intelligens refererer til metoden, hvor data behandles i segmenter eller “vinduer” for at analysere og generere indsigt fra sekventiel information. Inden for naturlig sprogbehandling (NLP) er vinduer særligt vigtige, da det gør det muligt for modeller at betragte et delmængde af data ad gangen og dermed forstå og generere tekst ud fra kontekstuelle signaler. Ved at undersøge data i bidder kan AI-systemer håndtere beregningsressourcer effektivt og samtidig fastholde evnen til at opfange relevante mønstre i dataene.

I forbindelse med NLP og store sprogmodeller (LLM’er) relaterer vinduer ofte til begrebet kontekstvinduer. Disse er faste intervaller af tokens, som modellen kan behandle samtidigt. Tokens repræsenterer tekststykker, såsom ord eller delord, og antallet af tokens, modellen kan håndtere på én gang, definerer dens kontekstvinduestørrelse. Denne tilgang gør det muligt for AI-modeller at fokusere på bestemte tekstdele og dermed generere svar baseret på relevant kontekstuel information.

Vinduer bruges i AI til effektivt at styre og behandle sekventielle data. I naturlig sprogbehandling gør det modeller i stand til at håndtere lange tekster ved at opdele dem i håndterbare segmenter. Hvert vindue indeholder et antal tokens, som giver kontekst for, at AI-modellen kan analysere og generere svar. Denne metode er essentiel for opgaver, der kræver forståelse og generering af menneskesprog, da det tillader modeller at betragte nødvendig kontekst uden at blive overvældet af hele datastrømmen.

I praksis hjælper vinduer modeller med at fokusere på relevante tekstdele, mens unødvendig information ignoreres. Dette er særligt nyttigt i applikationer som maskinoversættelse, sentimentanalyse og samtale-AI, hvor forståelse af den umiddelbare kontekst er afgørende for at generere præcise og sammenhængende resultater. Ved at anvende vinduer kan AI-systemer fastholde ydeevne og effektivitet, selv når de arbejder med lange eller komplekse data.

I naturlig sprogbehandling anvendes vinduer til at analysere og forstå tekstdata. For eksempel kan en AI-model i sentimentanalyse bruge vinduer til at undersøge et fast antal ord omkring en målsætning for at bestemme den udtrykte stemning. Ved at fokusere på et specifikt tekstvindue kan modellen opfange den umiddelbare kontekst, der påvirker stemningen, såsom negationer eller forstærkere.

Maskinoversættelsessystemer bruger vinduer til at oversætte tekst fra et sprog til et andet. Modellen behandler segmenter af kildeteksten inden for et kontekstvindue, hvilket sikrer, at oversættelsen tager højde for den relevante sproglige sammenhæng. Denne tilgang hjælper med at bevare betydningen og den grammatiske korrekthed i den oversatte tekst, især når der arbejdes med sprog, der har forskellige sætningsstrukturer.

Chatbots anvender vinduer til at styre samtaleforløbet. Ved at fokusere på de seneste interaktioner inden for et kontekstvindue kan chatbotten generere svar, der er relevante og sammenhængende. Dette er afgørende for at opretholde en naturlig og engagerende dialog med brugerne. For eksempel kan en kundeservice-chatbot bruge vinduer til at huske tidligere kundeforespørgsler og give nøjagtig hjælp baseret på den løbende samtale.

I tidsserieanalyse bruges vinduer til at behandle datapunkter indsamlet over tid ved at analysere segmenter inden for et glidende vindue. Denne teknik gør det muligt for AI-modeller at opdage tendenser, mønstre eller afvigelser inden for specifikke tidsrammer. For eksempel kan et AI-system i finansiel prognose bruge vinduer til at analysere aktiekurser inden for et rullende tidsvindue for at forudsige fremtidige markedsbevægelser.

Det gør det muligt for AI-systemer at fokusere på relevante tekstdele, hvilket er essentielt for opgaver, der kræver kontekstuel forståelse. Ved at behandle data inden for et kontekstvindue kan modeller opfange de nuancer og afhængigheder i sproget, der er nødvendige for præcis fortolkning og generering.

Desuden hjælper vinduer med at styre beregningsressourcer ved at begrænse mængden af data, der behandles ad gangen. Dette er afgørende for at skalere NLP-modeller til at håndtere store datasæt eller fungere i realtidsapplikationer. Vinduer sikrer, at modeller forbliver effektive og responsive, selv når de arbejder med omfattende eller komplekse sprogdata.

I store sprogmodeller refererer et kontekstvindue til den sekvens af tokens, som modellen tager i betragtning, når den behandler inputdata. Størrelsen på kontekstvinduet bestemmer, hvor meget tekst modellen kan analysere ad gangen. Større kontekstvinduer gør det muligt for modeller at betragte mere omfattende tekstdele, opfange langtrækkende afhængigheder og forbedre sammenhængen i genererede svar.

Kontekstvinduets størrelse påvirker direkte LLM’ers præstation. Med et større kontekstvindue kan modeller håndtere længere input og generere mere kontekstafhængige output. Dette er især vigtigt for opgaver som dokumentopsummering eller generering af længere indhold, hvor forståelse af den bredere kontekst er essentiel.

Dog medfører en forøgelse af kontekstvinduets størrelse også udfordringer. Større vinduer kræver flere beregningsressourcer, og der kan være faldende udbytte i forhold til præstationsforbedring. At balancere kontekstvinduets størrelse med effektivitet er en central overvejelse ved design og implementering af LLM’er.

Forskellige LLM’er har varierende kontekstvinduestørrelser. For eksempel:

Tokenisering er processen, hvor tekst opdeles i mindre enheder kaldet tokens. I NLP er dette et grundlæggende trin, der gør det muligt for AI-modeller at behandle og analysere tekstdata. Tokens kan være ord, delord eller endda enkelte tegn afhængigt af sproget og den anvendte tokeniseringsalgoritme.

For eksempel kan sætningen “The quick brown fox jumps over the lazy dog” tokeniseres til enkelte ord eller delord, hvilket gør det muligt for modellen at behandle hvert element sekventielt. Tokenisering hjælper med at standardisere inputdata og gøre det håndterbart for beregning.

Positionel kodning er en teknik, der bruges i transformerbaserede modeller til at indarbejde information om tokenpositionen i sekvensen. Da transformere behandler tokens parallelt frem for sekventielt, sikrer positionel kodning, at modellen er bevidst om rækkefølgen af tokens, hvilket er vigtigt for at forstå tekstens syntaks og betydning.

I Python-kode kan positionel kodning implementeres således:

import torch

import math

def positional_encoding(position, d_model):

pe = torch.zeros(position, d_model)

for pos in range(position):

for i in range(0, d_model, 2):

pe[pos, i] = math.sin(pos / (10000 ** ((2 * i)/d_model)))

pe[pos, i + 1] = math.cos(pos / (10000 ** ((2 * (i + 1))/d_model)))

return pe

Denne kode genererer en positionel kodningsmatrix, der kan lægges til token-embeddings og dermed give modellen information om hver tokens position.

I forbindelse med vinduer arbejder tokenisering og positionel kodning sammen om at gøre det muligt for modellen at behandle sekvenser af tokens inden for kontekstvinduet. Tokenisering opdeler teksten i enheder, modellen kan forstå, mens positionel kodning bevarer rækkefølgen af disse tokens. Denne kombination gør det muligt for AI-systemet at analysere teksten præcist inden for hvert vindue og opretholde den sammenhæng og kontekst, der er nødvendig for at generere meningsfulde svar.

En af de største udfordringer ved vinduer i AI er den beregningsmæssige kompleksitet, der er forbundet med at behandle store kontekstvinduer. Når vinduets størrelse øges, vokser de nødvendige beregningsressourcer ofte eksponentielt. Dette kan føre til øgede omkostninger og langsommere behandlingstid, hvilket måske ikke er praktisk i realtidsapplikationer eller på enheder med begrænsede ressourcer.

Selvom vinduer hjælper med at håndtere data effektivt, kan det også føre til tab af information. Ved kun at fokusere på data inden for kontekstvinduet kan modellen gå glip af vigtig information, der ligger udenfor. Dette kan påvirke nøjagtigheden af forudsigelser eller relevansen af genererede svar, især i opgaver, der kræver en bredere forståelse af dataene.

At finde den optimale balance mellem kontekstvinduestørrelse og beregningsmæssig effektivitet er en væsentlig udfordring. Et vindue, der er for lille, giver måske ikke tilstrækkelig kontekst for, at modellen kan præstere effektivt, mens et vindue, der er for stort, kan være ressourcekrævende og langsomt. Dette kræver nøje overvejelse og optimering under modeldesign og implementering.

Vinduer kan gøre det vanskeligt for modeller at opfange langtidsholdbare afhængigheder i sekventielle data. I sprogbehandling er forståelse af forholdet mellem fjerne ord eller sætninger vigtigt for opgaver som diskursanalyse eller narrativ forståelse. Vinduer begrænser modellens udsyn til et fast interval, hvilket kan hindre dens evne til at opfange disse langtrækkende relationer.

Vinduer i AI er processen med at opdele data i segmenter, eller vinduer, for at analysere sekventiel information effektivt. Det hjælper modeller med at håndtere kontekst og beregningsressourcer, især i NLP og store sprogmodeller.

Vinduer gør det muligt for NLP og LLM'er at behandle håndterbare tekstsegmenter, optimere ressourceforbrug og muliggøre kontekstbevidst analyse. Dette er afgørende for opgaver som oversættelse, sentimentanalyse og samtale-AI.

Vinduer bruges i NLP til tekstanalyse, maskinoversættelse, chatbots til at styre samtaler og tidsserieanalyse for at opdage tendenser og mønstre inden for specifikke tidsrammer.

Udfordringer inkluderer beregningsmæssig kompleksitet med større vinduer, risiko for informations-tab uden for vinduet, balancering af vinduestørrelse for kontekst og effektivitet samt sværhed ved at fange langtidsholdbare afhængigheder i sekventielle data.

Smarte chatbots og AI-værktøjer samlet ét sted. Forbind intuitive blokke for at gøre dine idéer til automatiserede flows.

Tekstgenerering med store sprogmodeller (LLM'er) refererer til den avancerede brug af maskinlæringsmodeller til at producere menneskelignende tekst ud fra promp...

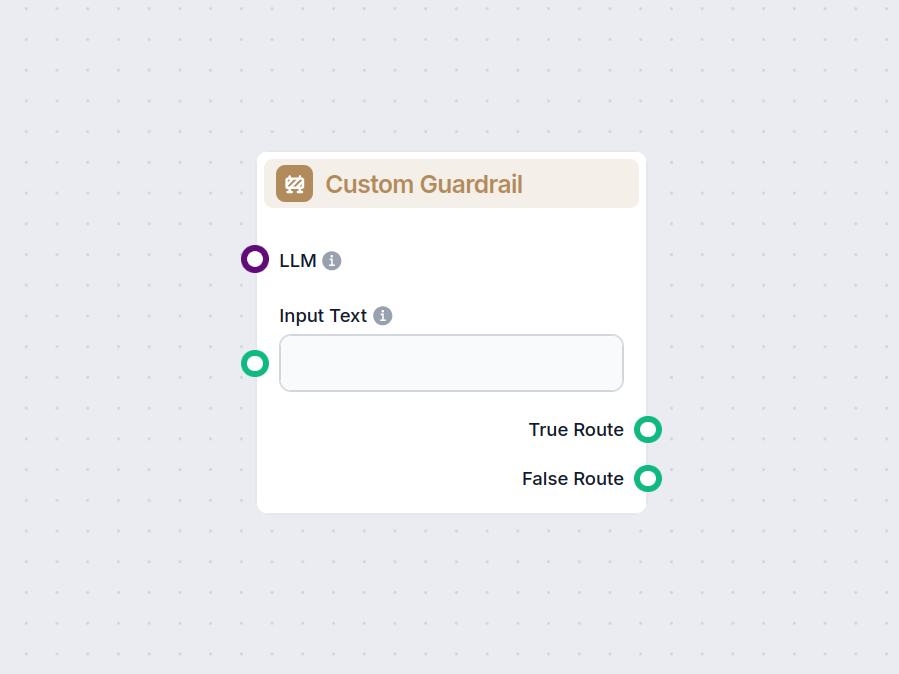

Brugerdefineret Værn-komponenten sikrer, at dit workflow kun fortsætter, hvis brugerinput matcher specifikke emner eller kriterier, ved hjælp af en LLM-baseret ...

Vi har testet og rangeret skriveevnerne hos 5 populære modeller, der er tilgængelige i FlowHunt, for at finde den bedste LLM til indholdsforfatning.