Prompt

Erstellen Sie eine Prompt-Vorlage mit dynamischen Variablen für das LLM, unterstützt Felder wie {input}, {human_input}, {context}, {chat_history}, {system_messa...

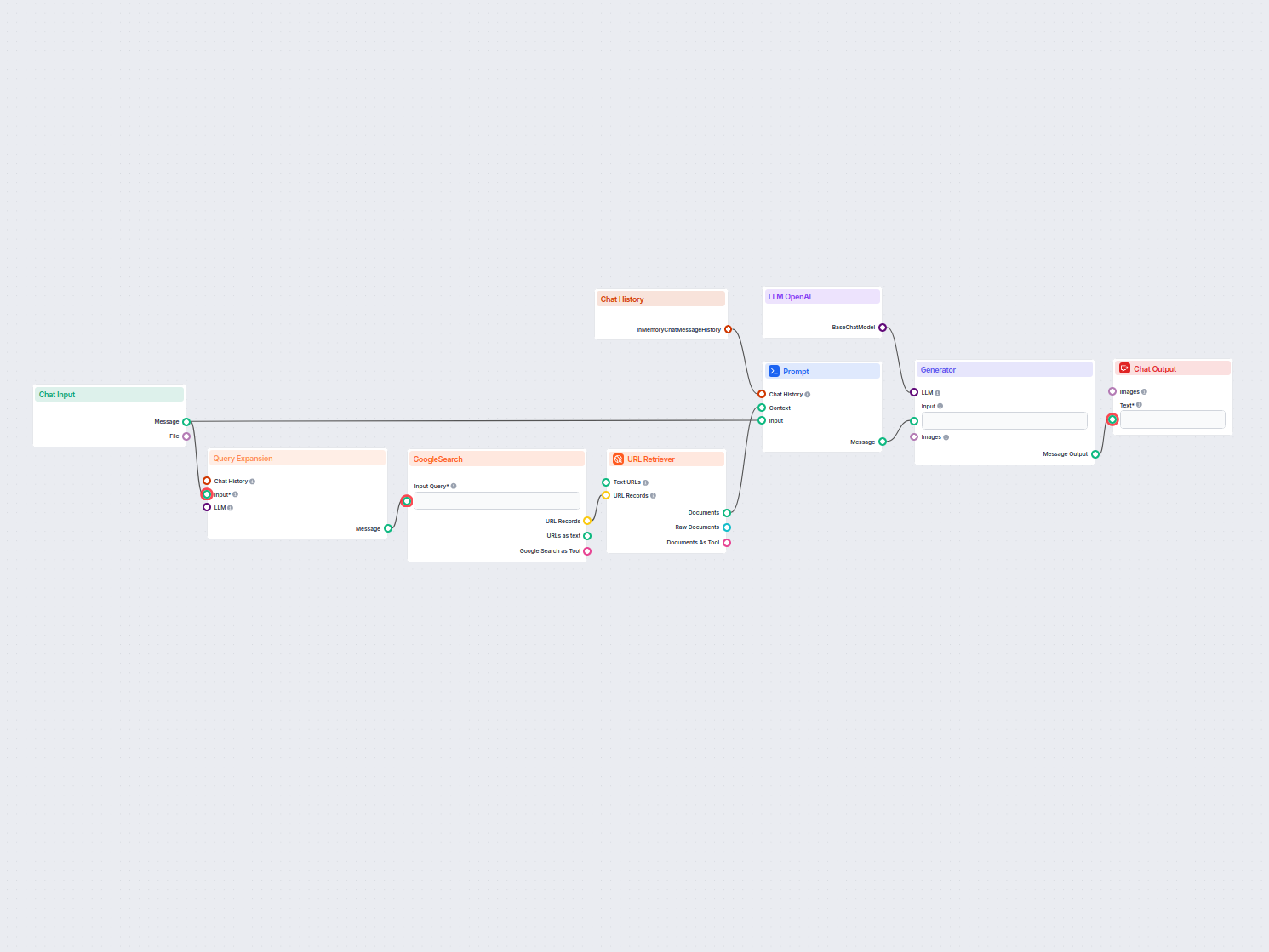

Ein Echtzeit-Chatbot, der Google Search auf Ihre eigene Domain beschränkt, relevante Webinhalte abruft und das OpenAI LLM nutzt, um Benutzeranfragen mit aktuellen Informationen zu beantworten. Ideal für genaue, domain-spezifische Antworten im Kundensupport oder in Informationsportalen.

Flows

Erstellen Sie eine Prompt-Vorlage mit dynamischen Variablen für das LLM, unterstützt Felder wie {input}, {human_input}, {context}, {chat_history}, {system_messa...

Nachfolgend finden Sie eine vollständige Liste aller Komponenten, die in diesem Flow verwendet werden, um seine Funktionalität zu gewährleisten. Komponenten sind die Bausteine jedes KI-Flows. Sie ermöglichen es Ihnen, komplexe Interaktionen zu erstellen und Aufgaben zu automatisieren, indem verschiedene Funktionalitäten verbunden werden. Jede Komponente dient einem bestimmten Zweck, wie z.B. der Verarbeitung von Benutzereingaben, der Datenverarbeitung oder der Integration mit externen Diensten.

Die Chat Input-Komponente in FlowHunt initiiert Benutzerinteraktionen, indem sie Nachrichten aus dem Playground erfasst. Sie dient als Startpunkt für Flows und ermöglicht die Verarbeitung von Text- und dateibasierten Eingaben im Workflow.

Entdecken Sie die Chat-Ausgabe-Komponente in FlowHunt – finalisieren Sie Chatbot-Antworten mit flexiblen, mehrteiligen Ausgaben. Unverzichtbar für nahtlose Flow-Abschlüsse und die Erstellung fortschrittlicher, interaktiver KI-Chatbots.

Die Button-Widget-Komponente in FlowHunt verwandelt Text oder Eingaben in interaktive, anklickbare Schaltflächen innerhalb Ihres Workflows. Perfekt für die Erstellung dynamischer Benutzeroberflächen, das Sammeln von Nutzerentscheidungen und die Steigerung des Engagements in KI-gesteuerten Chatbots oder automatisierten Prozessen.

Die Komponente Chat-Öffnungs-Trigger erkennt, wenn eine Chat-Sitzung beginnt, sodass Workflows sofort reagieren können, sobald ein Nutzer den Chat öffnet. Sie startet Abläufe mit der ersten Chat-Nachricht und ist somit unerlässlich für den Aufbau reaktionsschneller, interaktiver Chatbots.

Die Chatverlauf-Komponente in FlowHunt ermöglicht es Chatbots, sich an vorherige Nachrichten zu erinnern. So werden zusammenhängende Gespräche und ein verbessertes Kundenerlebnis gewährleistet, während Speicher und Token-Nutzung optimiert werden.

Erfahren Sie, wie die Prompt-Komponente von FlowHunt es ermöglicht, die Rolle und das Verhalten Ihres KI-Bots zu definieren und so relevante, personalisierte Antworten sicherstellt. Passen Sie Prompts und Vorlagen an, um effektive, kontextbewusste Chatbot-Flows zu erstellen.

Entdecken Sie die Komponente Generator in FlowHunt – leistungsstarke, KI-gesteuerte Textgenerierung mit Ihrem gewählten LLM-Modell. Erstellen Sie mühelos dynamische Chatbot-Antworten, indem Sie Prompts, optionale Systemanweisungen und sogar Bilder als Eingabe kombinieren. So wird es zu einem zentralen Werkzeug für den Aufbau intelligenter, konversationeller Workflows.

FlowHunt unterstützt Dutzende von Textgenerierungsmodellen, darunter Modelle von OpenAI. So verwenden Sie ChatGPT in Ihren AI-Tools und Chatbots.

Die Abfrageerweiterung in FlowHunt verbessert das Verständnis des Chatbots, indem Synonyme gefunden, Rechtschreibfehler korrigiert und konsistente, präzise Antworten auf Benutzeranfragen sichergestellt werden.

Die GoogleSearch-Komponente von FlowHunt verbessert die Genauigkeit von Chatbots durch Retrieval-Augmented Generation (RAG) und ermöglicht den Zugriff auf aktuelles Wissen von Google. Steuern Sie die Ergebnisse mit Optionen wie Sprache, Land und Abfrage-Präfixen für präzise und relevante Ausgaben.

Entsperren Sie Webinhalte in Ihren Workflows mit der URL-Retriever-Komponente. Extrahieren und verarbeiten Sie mühelos Text und Metadaten aus beliebigen URL-Listen – einschließlich Webartikeln, Dokumenten und mehr. Unterstützt erweiterte Optionen wie OCR für Bilder, selektive Metadatenextraktion und anpassbares Caching, was sie ideal für den Aufbau wissensreicher KI-Flows und Automatisierungen macht.

Flow-Beschreibung

Dieser Workflow implementiert einen einfachen Retrieval-Augmented Generation (RAG)-Chatbot, der die Echtzeit-Google-Suche nutzt, um aktuelle Informationen aus dem Internet abzurufen – insbesondere kann er so angepasst werden, dass alle Suchen auf eine bestimmte Domain beschränkt werden. Das Hauptziel ist die Erstellung eines Chatbots, der Benutzeranfragen mit den relevantesten und aktuellsten online verfügbaren Inhalten beantworten kann, was ihn besonders wertvoll für Szenarien macht, in denen statische Wissensdatenbanken nicht ausreichen.

Der Workflow besteht aus mehreren modularen Blöcken, die jeweils eine bestimmte Fähigkeit repräsentieren. Nachfolgend finden Sie eine Übersicht über die Struktur und Funktionalität des Workflows:

| Komponente | Rolle |

|---|---|

| Chat Input | Empfängt Benutzeranfragen und Chat-Nachrichten. |

| Chat History | Hält den Verlauf der Konversation für kontextbezogene Antworten fest. |

| Query Expansion | Paraphrasiert die Benutzereingabe in mehrere alternative Anfragen, um die Suchabdeckung zu erhöhen. |

| Google Search | Führt Google-Suchen durch, die durch ein anpassbares Domain-Präfix eingeschränkt sind. |

| URL Retriever | Extrahiert Inhalte aus den durch die Google-Suche zurückgegebenen URLs. |

| Prompt Template | Strukturiert Kontext, Benutzereingabe und Verlauf für das Sprachmodell. |

| OpenAI LLM | Generiert Antworten mit einem Sprachmodell (z.B. GPT-3/4). |

| Generator | Ruft das LLM mit Prompt und Kontext auf, um die Antwort zu erzeugen. |

| Chat Output | Zeigt Chatbot-Antworten dem Benutzer an. |

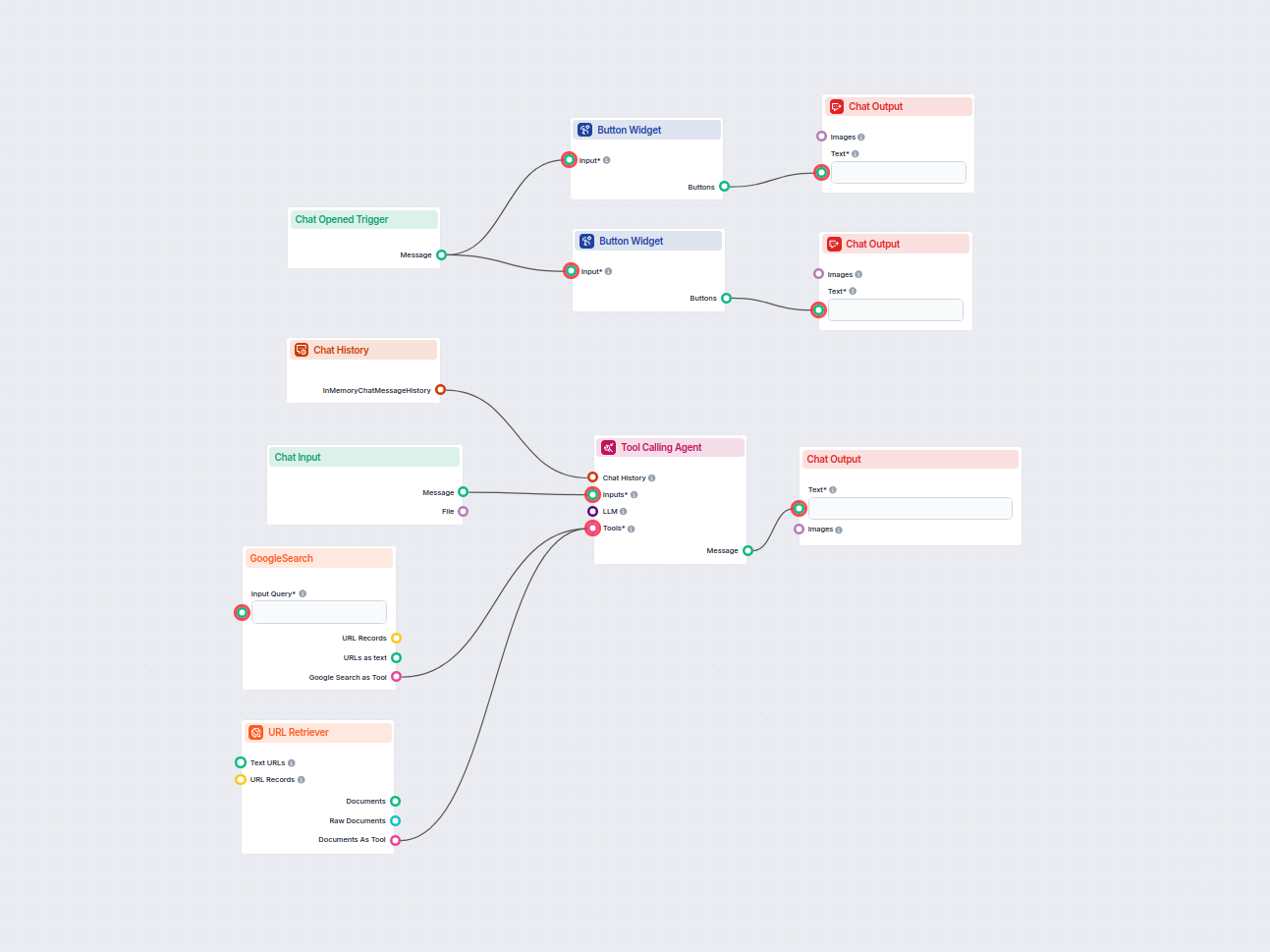

| Button Widgets | Bietet schnelle Beispielanfragen, die Benutzer mit einem Klick ausprobieren können. |

| Chat Opened Trigger | Initialisiert die Konversation und füllt Schnellstart-Schaltflächen. |

Wenn ein Benutzer den Chat öffnet, wird der Chat Opened Trigger aktiviert. Dies initialisiert die Chat-Oberfläche und präsentiert mehrere Button Widgets mit Beispielanfragen (z.B. „Welcher Dinosaurier hat 500 Zähne?“). Wenn ein Benutzer eine Schaltfläche anklickt oder eine eigene Nachricht über Chat Input eingibt, läuft der Workflow folgendermaßen ab:

Abfrageerweiterung: Die Eingabe des Benutzers wird in mehrere Varianten paraphrasiert, um die Wahrscheinlichkeit zu erhöhen, relevante Suchergebnisse zu erhalten.

Google-Suche: Die erweiterten Anfragen werden an die Google-Suche gesendet. Standardmäßig ist die Suche auf eine bestimmte Domain beschränkt (festgelegt durch das Feld query_prefix, z.B. site: www.IHREDOMAIN.com), sodass Sie das Wissen des Chatbots auf Ihre eigene Website oder eine beliebige vertrauenswürdige Quelle fokussieren können.

URL Retriever: Der Workflow ruft den Inhalt der obersten Suchergebnisse (URLs) als vollständige Dokumente ab.

Prompt-Zusammenstellung: Die abgerufenen Inhalte, die Benutzereingabe und der Chatverlauf werden mit dem Prompt Template-Komponenten zu einem reichhaltigen Kontext für die Antwort kombiniert.

Sprachmodell-Generierung: Das Prompt wird an das OpenAI LLM gesendet, das eine zusammenhängende und kontextuell relevante Antwort generiert.

Antwortausgabe: Die generierte Antwort wird dem Benutzer über den Chat Output angezeigt.

query_prefix können Sie sicherstellen, dass der Chatbot Informationen ausschließlich von Ihrer vertrauenswürdigen Website oder Wissensdatenbank bezieht, was die Verlässlichkeit der Antworten verbessert.| Schritt | Beschreibung |

|---|---|

| Benutzereingabe | Benutzer tippt eine Frage oder klickt auf eine Schnellstart-Schaltfläche |

| Abfrageerweiterung | Die Eingabe wird zur besseren Suchabdeckung paraphrasiert |

| Google-Suche | Suchen werden bei Google innerhalb einer bestimmten Domain durchgeführt |

| URL-Inhalt-Abruf | Inhalte der besten Suchergebnisse werden abgerufen |

| Prompt-Erstellung | Benutzereingabe, Suchergebnisse und Chatverlauf werden zu einem Prompt zusammengeführt |

| LLM-Generierung | OpenAI LLM generiert eine Antwort unter Einbeziehung des vollständigen Kontexts |

| Ausgabe | Antwort wird dem Benutzer angezeigt |

query_prefix in der Google Search-Komponente an (z.B. site: www.IHREDOMAIN.com).Durch die Automatisierung von Suche, Abruf und Antwortgenerierung spart dieser Workflow manuelle Recherchezeit und stellt sicher, dass Benutzer stets die aktuellsten und relevantesten verfügbaren Informationen erhalten.

Wir helfen Unternehmen wie Ihrem, intelligente Chatbots, MCP-Server, KI-Tools oder andere Arten von KI-Automatisierungen zu entwickeln, um Menschen bei sich wiederholenden Aufgaben in Ihrer Organisation zu ersetzen.

Entdecken Sie das Template für einen einfachen Chatbot mit Google-Suche, entwickelt für Unternehmen, um domänenspezifische Informationen effizient bereitzustell...

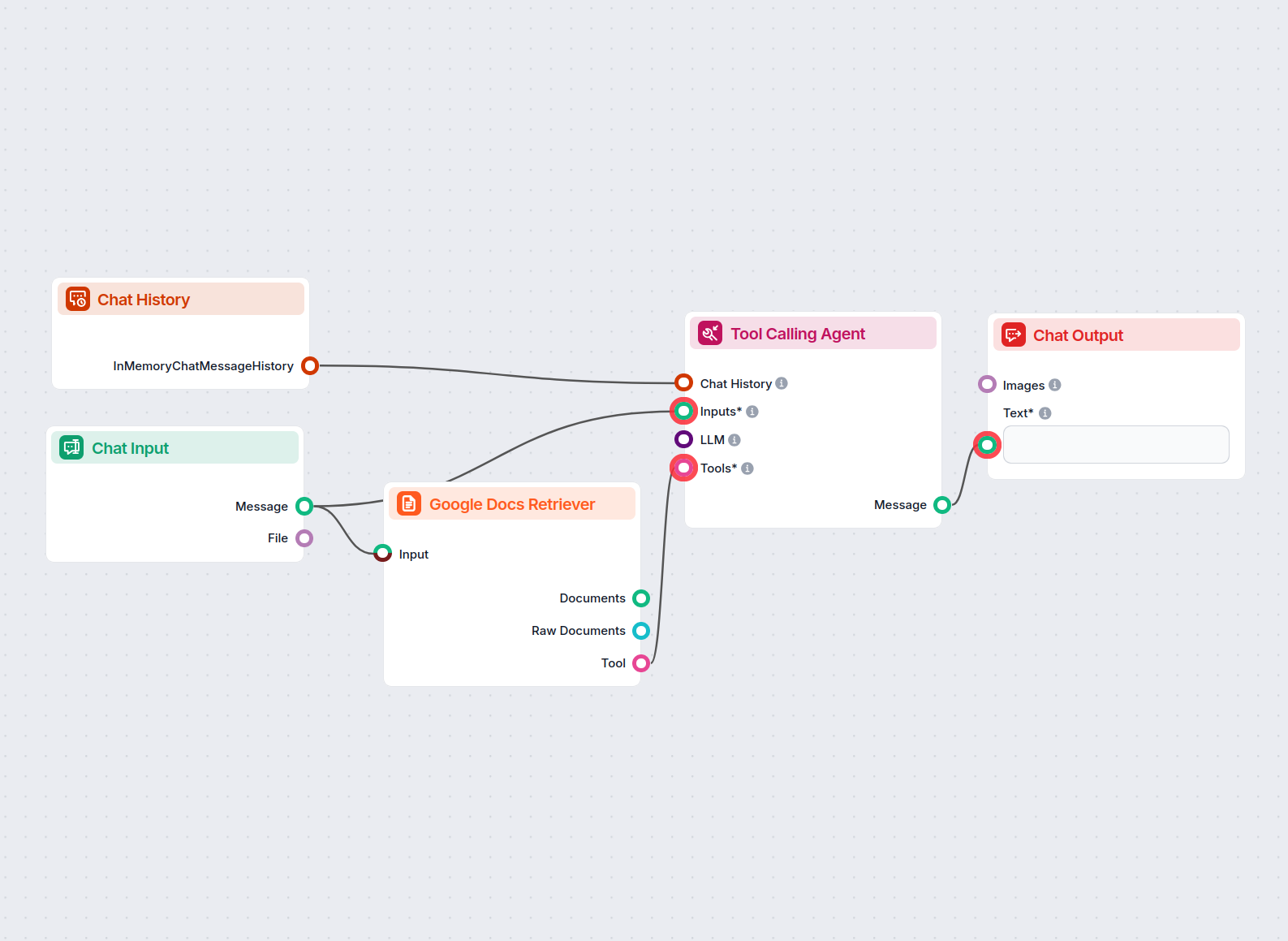

Ein KI-gestützter Chatbot, der präzise Antworten auf Benutzerfragen liefert, die sich ausschließlich auf den Inhalt eines bereitgestellten Google-Dokuments stüt...

Ein KI-Chatbot, der sofortige, aktuelle Antworten auf jede Frage liefert, indem er Google durchsucht und relevante Website-Inhalte abruft – stets mit Quellverwe...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.