Wo und wie man mit KI im E-Commerce beginnt: Ein praktischer Fahrplan

Ein praktisches Framework zur Implementierung von KI im E-Commerce vom CMO von Quality Unit. Erfahren Sie, wo Sie beginnen sollten, welche häufigen Herausforder...

Ein technischer Leitfaden für Gründer zur Implementierung von KI-Commerce-Protokollen (UCP, ACP, AP2), zur Beherrschung der technischen SEO-Grundlagen und zur Generierung von Inhalten, die sowohl für traditionelle Suchmaschinen als auch für KI-Zitationen optimiert sind.

Viktor Zeman hat Quality Unit vor über zwei Jahrzehnten mitbegründet und die Entwicklung und das globale Wachstum der Produktsuite, einschließlich FlowHunt, geleitet. Seit 2024 konzentriert er sich speziell auf FlowHunt und hilft Unternehmen bei der Implementierung praktischer KI-Lösungen, Automatisierung und moderner KI-gesteuerter Arbeitsumgebungen. Seine Präsentation beim E-commerce Mastermind ging tief in drei kritische Bereiche der technischen Implementierung von KI im E-Commerce ein.

Die Präsentation detaillierte spezifische Protokolle, technische Implementierungen und Content-Strategien, die über die Produkte und den Kundenstamm von Quality Unit getestet wurden. Was folgt, ist Viktors technische Roadmap, um E-Commerce-Websites durch KI-Systeme auffindbar, innerhalb des KI-vermittelten Commerce funktional und wettbewerbsfähig zu machen, während sich die Suche von Keywords zu KI-Zitationen verschiebt.

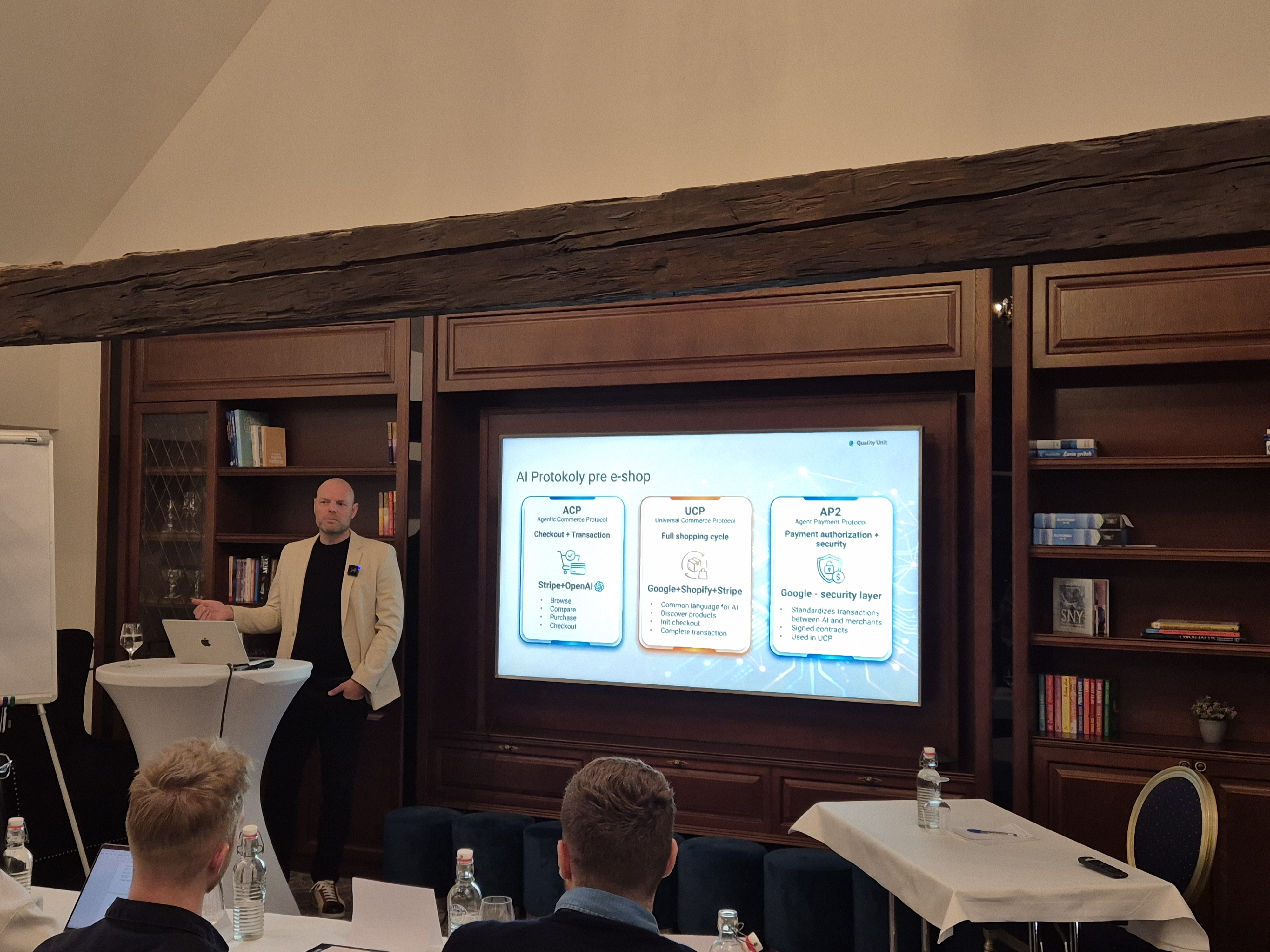

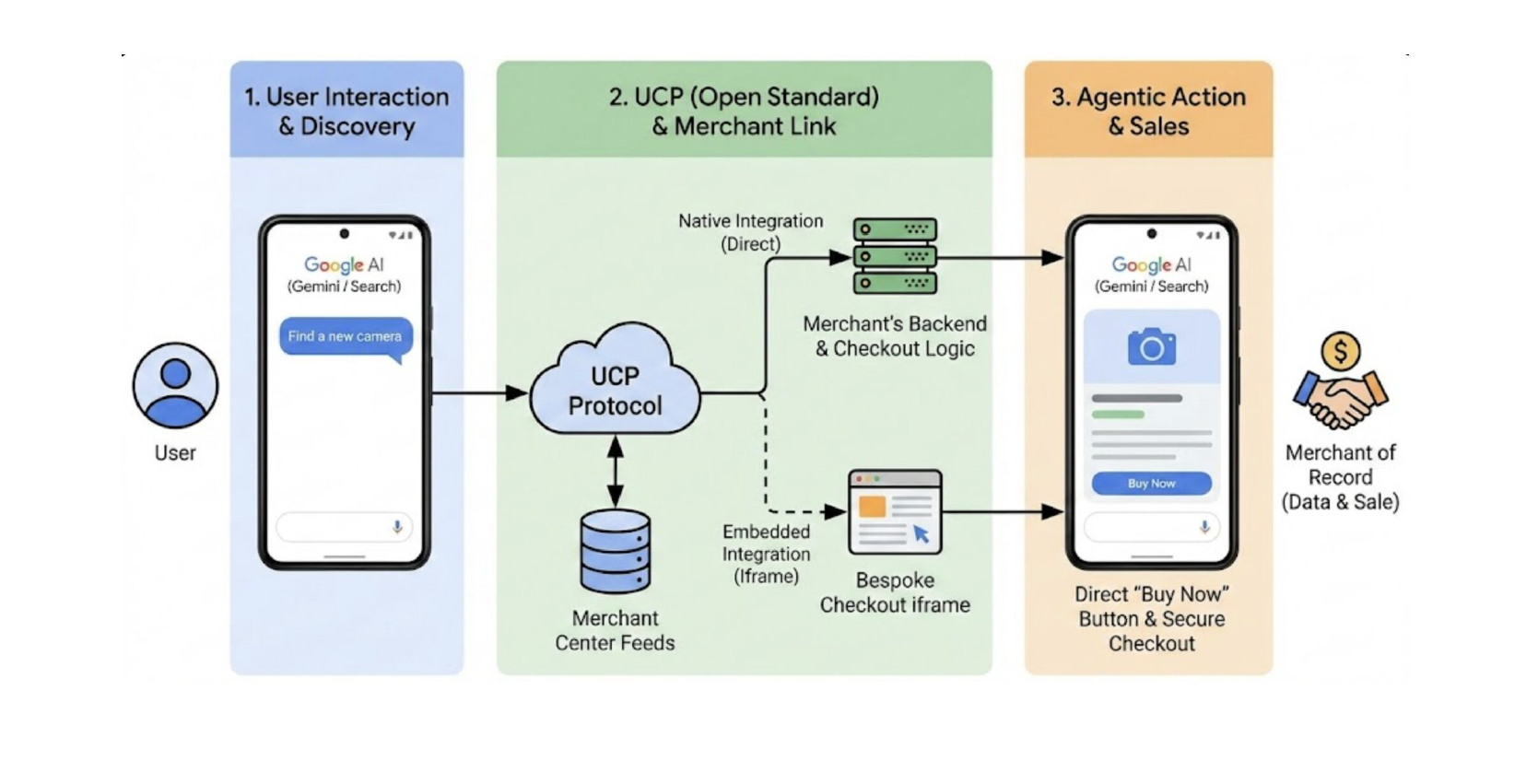

Viktor legte die Grundlagen, indem er die standardisierten Protokolle vorstellte, die es KI ermöglichen, im Namen der Nutzer mit E-Commerce-Systemen zu interagieren.

Große Plattformen wie Shopify, Salesforce Commerce Cloud oder BigCommerce haben bereits begonnen, Teile dieser Protokolle zu implementieren. Das Gleiche gilt für die Zahlungsabwickler Stripe, PayPal und Checkout.com. Dies zeigt deutlich, dass KI-Commerce-Kompatibilität zu einer Wettbewerbsgrundlage wird.

Universal Commerce Protocol (UCP) ermöglicht es KI-Assistenten, Produkte zu entdecken, Optionen zu vergleichen, den Checkout zu initiieren und Transaktionen abzuschließen, ohne dass Nutzer die KI-Oberfläche verlassen müssen. UCP ist bereits in Shopify, Salesforce Commerce Cloud, BigCommerce und großen Zahlungsabwicklern implementiert.

Agentic Commerce Protocol (ACP), eine Zusammenarbeit zwischen Stripe und OpenAI, konzentriert sich speziell auf Transaktionssicherheit und Einfachheit innerhalb von Konversationsschnittstellen. Während UCP den breiteren Shopping-Zyklus adressiert, spezialisiert sich ACP auf den Kaufprozess, da es den Checkout direkt innerhalb von Chat-Interfaces ermöglicht.

Agent Payment Protocol (AP2), entwickelt von Google, bietet das Sicherheitsframework, das KI-vermittelte Transaktionen vertrauenswürdig macht, durch Transaktionssignierung, Händlerauthentifizierung und Zahlungsautorisierung. AP2 integriert sich mit UCP, um die Vertrauensebene bereitzustellen, die autonomes KI-Kaufen zur Realität macht.

Damit Ihr E-Shop mit KI-gesteuertem Shopping kompatibel wird und somit von KI-Plattformen empfohlen wird, müssen Sie maschinenlesbare Daten auf mehreren Ebenen bereitstellen:

Produkte müssen mit Standards wie diesen beschrieben werden:

schema.org: Geben Sie der KI strukturierte Daten, die sie lesen und verstehen kannDies ermöglicht es KI-Systemen, Produkte ohne Mehrdeutigkeit zu interpretieren, einschließlich der Varianten, Preisgestaltung, Verfügbarkeit und Versandbeschränkungen. Es ist die Grundlage, die KI-Systeme verwenden, um zu verstehen, was Sie verkaufen.

KI-Agenten bewerten nicht nur die Produkte, sie bewerten auch, ob die Händler vertrauenswürdig und gut für den Nutzer geeignet sind. Deshalb müssen wichtige Informationen über Ihr Unternehmen explizit und zugänglich sein:

Viele dieser Daten existieren bereits in Systemen wie Google Merchant Center, müssen aber vollständig, genau und konsistent gepflegt werden.

Eine der weniger sichtbaren, aber kritischen Komponenten ist das Commerce-Manifest. Es ist typischerweise eine JSON-Datei, die auf der Domain des Händlers gehostet wird.

Dieses Manifest definiert unterstützte Protokollversionen, verfügbare Services, Zahlungshandler und Checkout-Fähigkeiten und hilft KI-Agenten zu verstehen, wie Ihr Shop funktioniert.

Implementieren Sie drei kritische Endpunkte:

Implementieren Sie das oben erwähnte Agent Payment Protocol für sichere Transaktionsabwicklung.

Für Plattformen ohne native UCP-Unterstützung bietet MCP einen Integrationspfad. Zeman betonte die wachsende Bedeutung von MCP als Verbindungsebene zwischen KI-Agenten und bestehenden Systemen.

Die Entwicklung eines benutzerdefinierten MCP-Servers ermöglicht es Ihnen, präzise Prompts zu erstellen, die auf Ihre spezifischen Anwendungsfälle zugeschnitten sind, und isolierte API-Aufrufe mit ordnungsgemäßer Rate-Limiting zu senden. Auf diese Weise können Sie sicher sein, dass Ihre KI-Implementierung sicher, kontrolliert und so kostengünstig wie möglich sein wird.

Beispiel: Ein Chatbot, der mit E-Commerce-MCP und einem Versanddienstleister (z. B. Chameleon) integriert ist, ermöglicht es Kunden, nicht nur den Bestellstatus abzufragen, sondern die Lieferung in Echtzeit zu verfolgen, alles innerhalb einer einzigen Konversation.

Das zweite Implementierungsthema, das Viktor behandelte, war technisches SEO. Er legte großen Wert darauf zu betonen, dass der Eckpfeiler von SEO nicht Keywords sind. Es ist “eine Infrastruktur, auf die sowohl Suchmaschinen als auch KI-Systeme zugreifen und der sie vertrauen können”. Denn langsame und unzuverlässige Websites werden sowohl von Nutzern als auch von Crawlern verlassen.

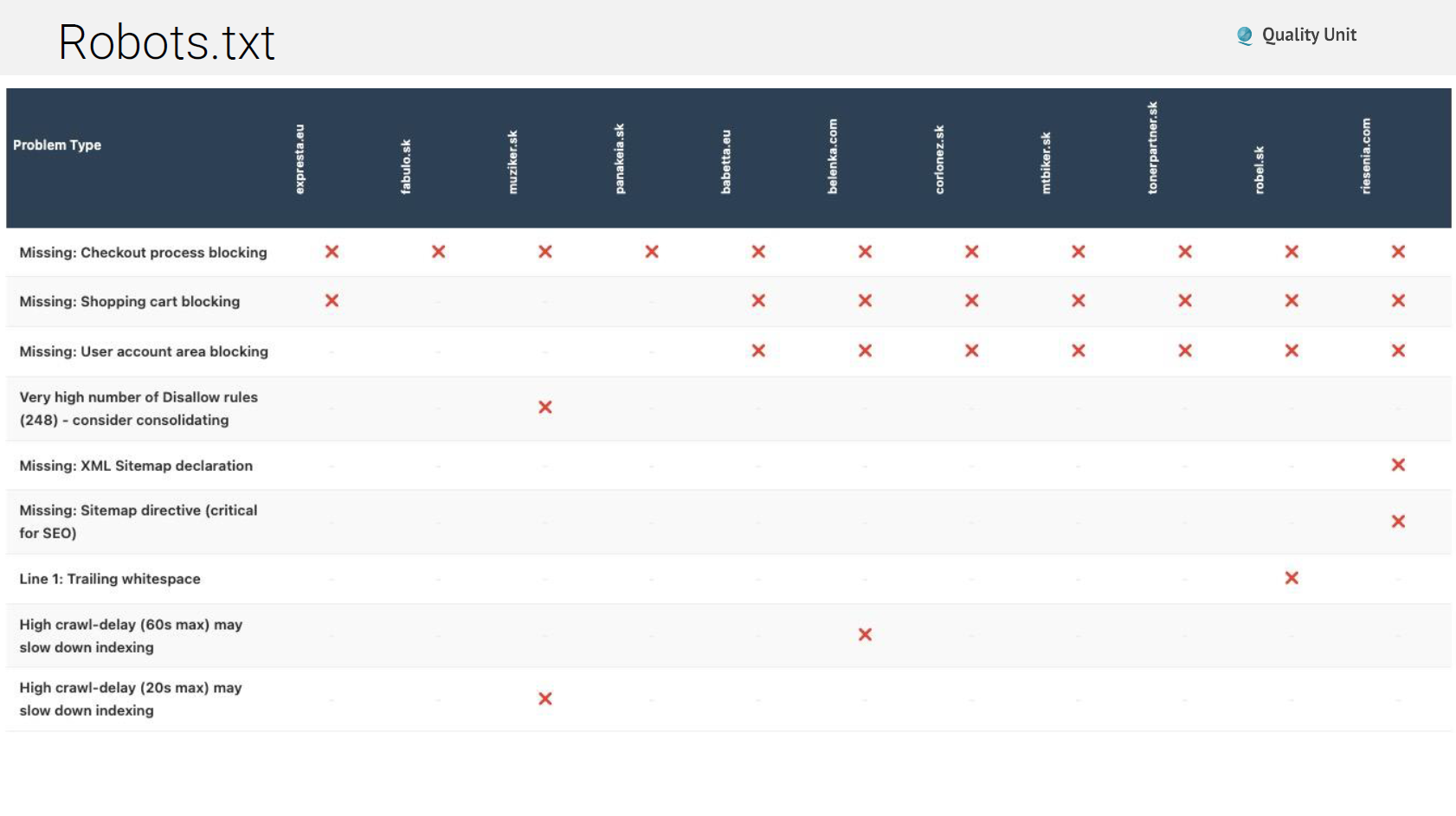

Trotz eines 30 Jahre alten Standards bleibt robots.txt häufig falsch konfiguriert. Zu den häufigen Problemen gehören:

Nicht vorhandene robots.txt: Einige Websites geben Fehlerseiten oder Wartungsmeldungen anstelle von ordnungsgemäßen robots.txt-Dateien zurück, was Crawler darüber verwirrt, was erlaubt ist.

Blockierte KI-Bots: Das Blockieren von KI-Crawlern verhindert, dass Ihre Inhalte in KI-Antworten zitiert werden. Während Sie möglicherweise einige Bots blockieren möchten, eliminiert pauschales Blockieren die KI-Sichtbarkeit.

Fehlende Sitemap-Direktiven: Robots.txt sollte auf Ihre XML-Sitemaps verweisen und Crawler zur vollständigen Content-Entdeckung führen.

Syntaxfehler: Nachgestellte Kommas in Wildcards (Disallow: /?pv=*,) verursachen Parsing-Fehler bei einigen Crawlern und führen zu unbeabsichtigtem Blockieren.

Blockierte wertvolle Inhalte: Manchmal blockieren Websites Inhalte, die sie tatsächlich indexiert haben möchten, normalerweise durch zu breite Wildcard-Regeln.

XML-Sitemaps teilen Suchmaschinen und KI-Systemen mit, welche Inhalte existieren und wie sie organisiert sind. Häufige Probleme in diesem Bereich sind:

Cache-Header-Probleme: Falsche Cache-Header können verhindern, dass Sitemaps ordnungsgemäß aktualisiert werden, wodurch Crawler mit veralteten Inhaltslisten zurückbleiben.

Unvollständige URL-Abdeckung: Plugin-generierte Sitemaps übersehen oft benutzerdefinierte Post-Typen, Taxonomien oder dynamische Seiten, wodurch bedeutende Inhalte unentdeckt bleiben.

Rate-Limiting-Probleme: Einige Websites implementieren aggressives Rate-Limiting, das das Abrufen von Sitemaps vollständig blockiert und nach nur 10 URLs 429-Fehler zurückgibt.

Links zu 404-Seiten: Sitemaps mit toten Links verschwenden Crawler-Budget und signalisieren schlechte Website-Wartung.

Ordnungsgemäße HTTP-Cache-Header verbessern die Leistung für wiederkehrende Besucher dramatisch und reduzieren die Serverlast. Dennoch konfigurieren viele Websites dies vollständig falsch. Cache-Control-Direktiven sind wichtig:

Viktor betonte die Überprüfung von Cache-Headern für alle Asset-Typen: HTML, CSS, JavaScript, Bilder, Schriftarten und API-Antworten.

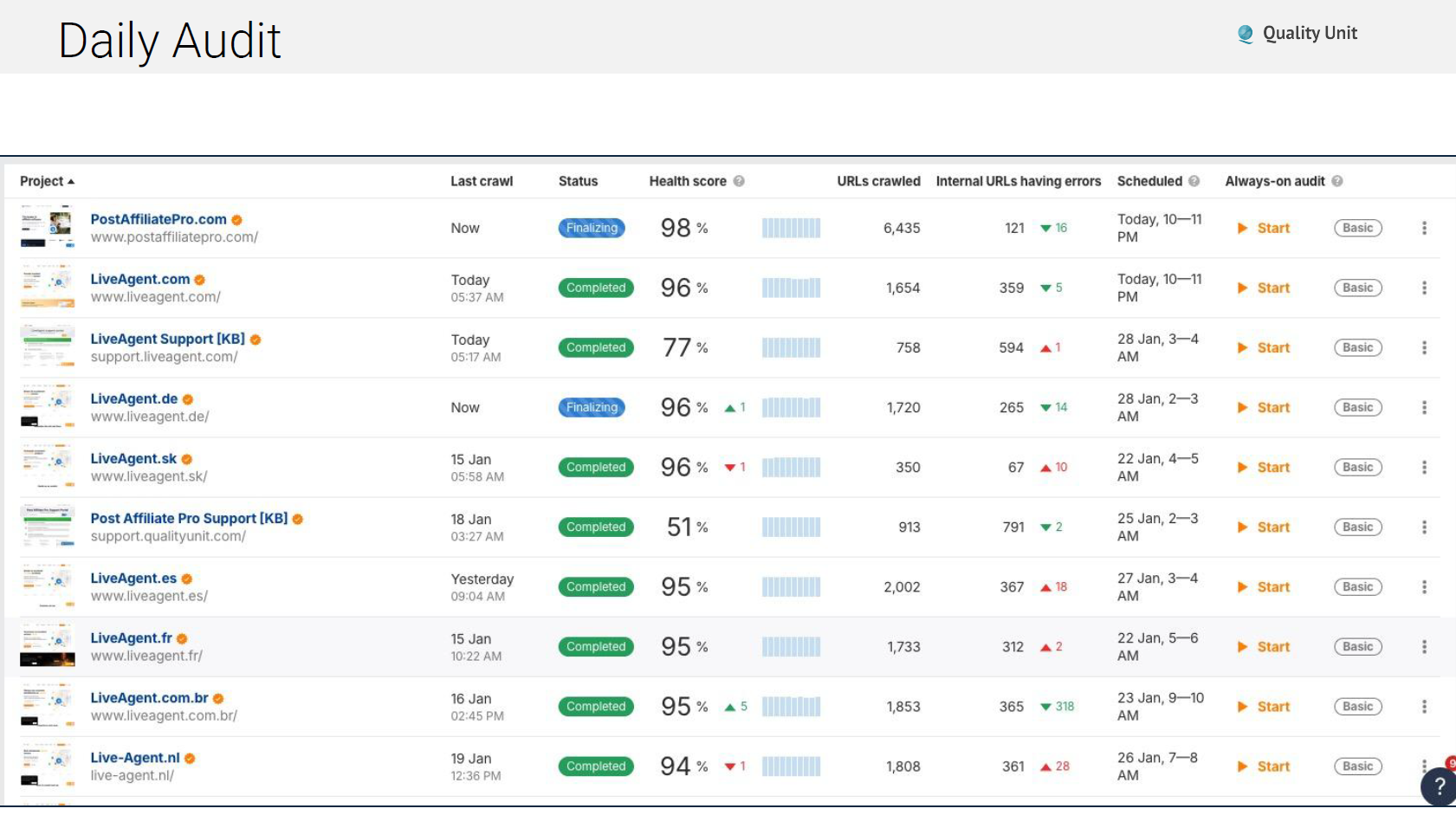

Technische Probleme tauchen ständig auf und deshalb führt unser Team automatisierte tägliche Audits durch, die Folgendes überprüfen:

Die Verwendung von Tools wie Ahrefs für automatisierte Überwachung stellt sicher, dass Probleme erkannt und behoben werden, bevor sie sich zu großen Traffic-Verlusten summieren:

Googles Core Web Vitals beeinflussen Rankings direkt. Sie sollten sich hauptsächlich auf diese zwei kritischen Tools konzentrieren: PageSpeed Insights liefert Labordaten, die potenzielle Leistung unter kontrollierten Bedingungen zeigen. Chrome User Experience Report (CrUX) liefert reale Daten von tatsächlichen Nutzern, die Ihre Website besuchen.

Die drei kritischen Metriken, auf die Sie achten sollten, sind:

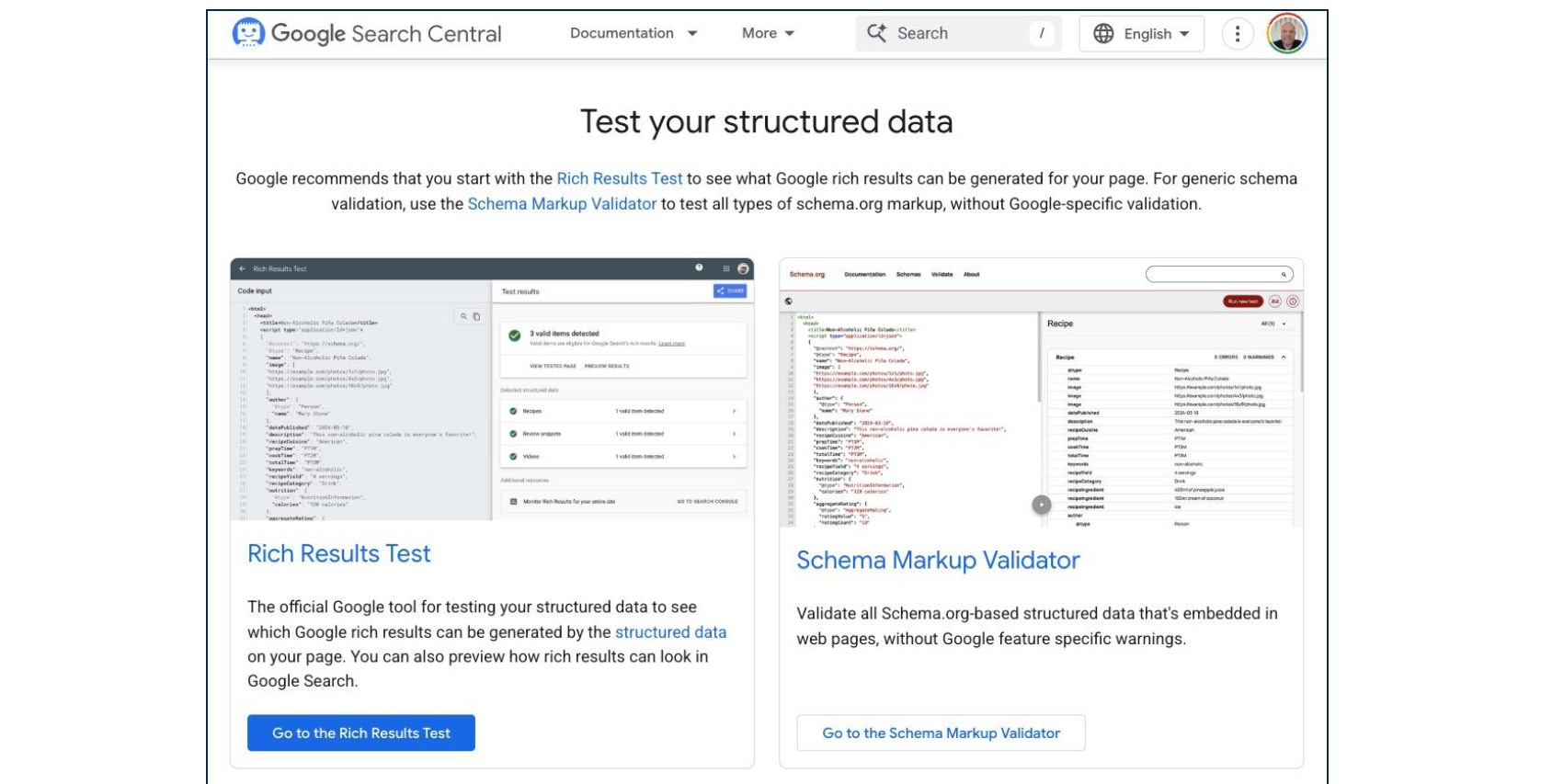

Schema.org-Markup verwandelt HTML in maschinenlesbare strukturierte Daten. Sowohl traditionelle Suchmaschinen als auch KI-Systeme verlassen sich auf Schema, um Inhaltskontext und Beziehungen zu verstehen.

Wesentliche Schema-Typen für E-Commerce:

Häufige Schema-Implementierungsfehler sind:

Regelmäßige Validierung durch Googles Rich Results Test stellt sicher, dass Schema ordnungsgemäß strukturiert und vollständig bleibt.

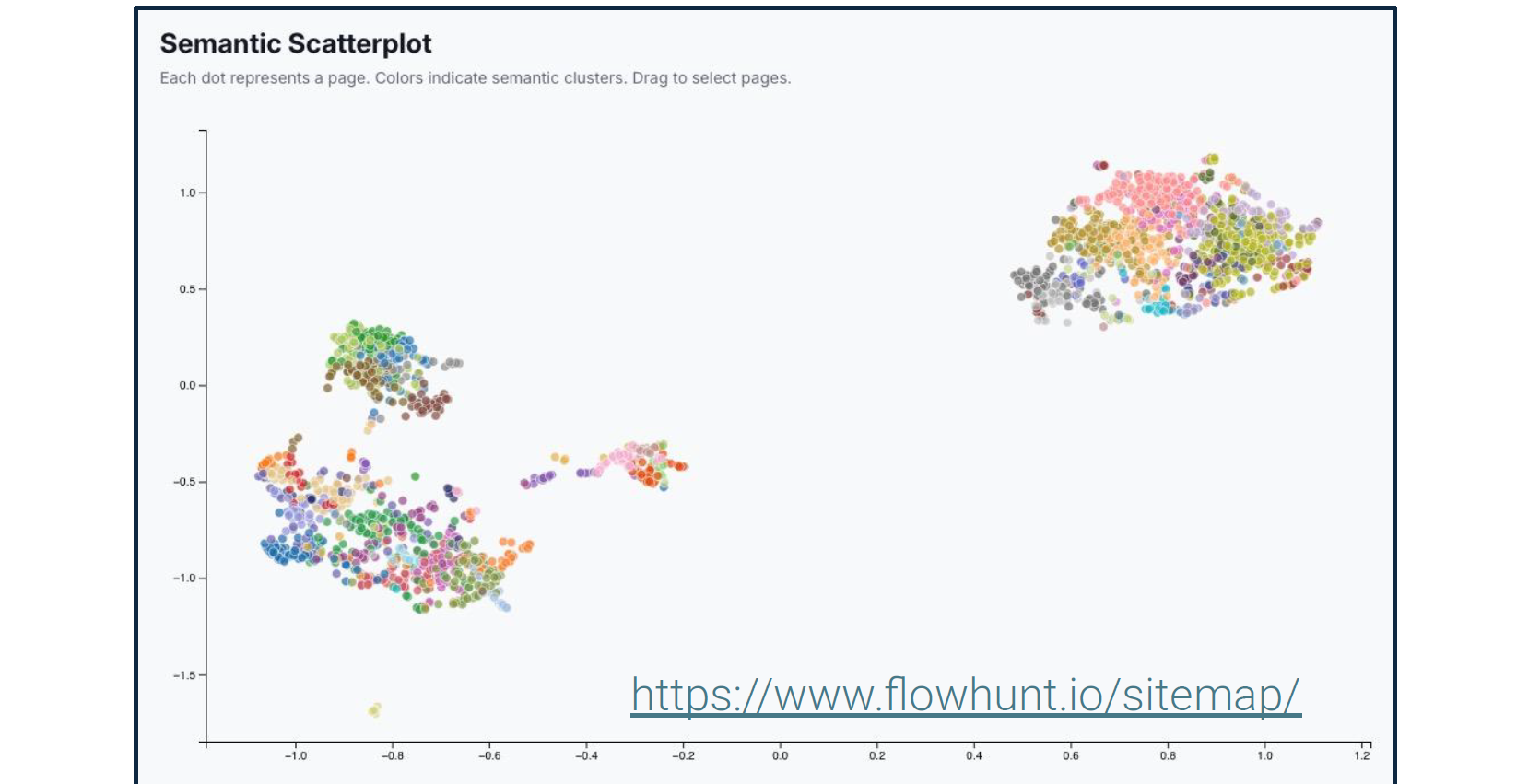

Viktor betonte wiederholt, dass es bei SEO nicht mehr um Keywords geht. Er erläuterte semantische Analyse-Tools, die zeigen, wie Suchmaschinen und KI-Systeme die Bedeutung Ihrer Inhalte verstehen, nicht nur die Wörter.

Diese Tools visualisieren Entitätsbeziehungen, Themenabdeckung und semantische Verbindungen innerhalb Ihrer Inhalte. KI-Systeme verwenden diese Beziehungen, um zu bestimmen, wann Ihre Inhalte bestimmte Anfragen beantworten, selbst wenn exakte Keywords nicht erscheinen.

Während traditionelles SEO fragte: “Enthält diese Seite die richtigen Keywords?” Fragt modernes SEO: “Zeigt diese Seite Expertise über relevante Entitäten und ihre Beziehungen?”

“Google kümmert es nicht, ob Sie sagen, Sie sind ‘Die schnellste Handy-Reparaturwerkstatt in Bratislava’. Es fragt, ob Ihre Website Expertise über die Entität ‘Handy’ in Bezug auf die Entitäten ‘Reparatur’ und ‘Bratislava’ zeigt. Validieren andere Quellen Expertise über diese Entitäten? Zum Beispiel Bewertungen oder native Anzeigen. Signalisiert das Nutzerverhalten, wie die auf der Website verbrachte Zeit, dass der Inhalt relevant ist?” - Viktor Zeman

Er unterstreicht weiter, dass Sie mit schnellen Erfolgen beginnen sollten, wie der Behebung einiger Ihrer technischen SEO-Probleme. Die Ergebnisse sollten sich bald zeigen. Erst wenn KI und Suchmaschinen Ihre Website richtig lesen und verstehen können, ist es an der Zeit, keyword-reiche Inhalte zu erstellen.

Viktor stellte die konventionelle Weisheit über Linkaufbau in Frage und argumentierte, dass die interne Link-Struktur weit mehr Aufmerksamkeit verdient, als die meisten Websites ihr geben.

PageRank-Verteilung: Google (und zunehmend KI-Systeme) fließen Autorität durch Links. Ihre interne Link-Struktur bestimmt, welche Seiten diese Autorität erhalten.

Link-Juice-Konzentration: Links von stark frequentierten Seiten haben mehr Wert als Links von selten besuchten Seiten. Strategische interne Verlinkung verstärkt die Wirkung Ihrer beliebtesten Inhalte.

Kontext durch Ankertext: Die in Links verwendeten Wörter signalisieren Themenbeziehungen sowohl für Suchmaschinen als auch für KI-Systeme.

Platzierungshierarchie: Links im Hauptinhalt haben mehr Gewicht als Footer- oder Navigationslinks.

Auf unseren Websites kämpfen wir nicht gegen Windmühlen, um manuelle interne Links zu skalieren und konsistent zu halten. Stattdessen haben wir eine automatisierte interne Verlinkung im großen Maßstab implementiert. Diese Automatisierung berücksichtigt:

Das Ergebnis ist eine umfassende interne Link-Struktur, die manuell unmöglich zu pflegen wäre, während sichergestellt wird, dass jeder Inhalt logisch mit verwandten Themen verbunden ist.

Viktors Ansatz zur KI-Content-Generierung konzentriert sich auf systematische Struktur statt auf Ad-hoc-Artikelerstellung.

Bevor Sie Inhalte generieren, verstehen Sie, wie KI-Systeme derzeit über Ihre Branche sprechen: Schritt 1: Test-Prompts generieren - Erstellen Sie über 500 Fragen, die darstellen, wie Nutzer KI-Systeme über Themen in Ihrer Domäne abfragen könnten. Schritt 2: KI-Antworten analysieren - Verwenden Sie Tools wie AmICited.com, um zu sehen, welche Quellen KI-Systeme derzeit zitieren, wenn sie diese Prompts beantworten.

Dies wird offenbaren:

Schritt 3: Lücken identifizieren - Finden Sie Fragen, bei denen KI-Systeme schwache Antworten geben oder schlechte Quellen zitieren. Diese stellen Chancen dar, die maßgebliche Zitation zu werden.

KI-optimierte Produktbeschreibungen profitieren drei kritischen Kanälen:

Anstatt generischer “Blog-Inhalte” befürwortet Viktor die Erstellung spezialisierter KI-Agenten zur Generierung jedes einzelnen Post-Typs, jeweils mit definierten Elementen und Struktur. Zum Beispiel Glossar, Checklisten, Anleitungs-Posts, Feature-Dokumentation, aber auch wiederverwendbare Blog-Frameworks wie Analysen, Insights, Branchenkommentare.

Während ein allgemeiner KI-Agent mit einem wirklich guten Prompt beim ersten Versuch Gold treffen könnte, ist das nicht das, was Sie brauchen. Sie suchen nach Skalierung und wiederholbaren genauen Workflows. Jedes Mal neue Prompts für Agenten zu schreiben, zu hoffen, dass sie funktionieren, und dann die Prompts in einem Notizblock zu speichern, wird Ihnen das nicht geben. Das manuelle Kopieren desselben Prompts, um eine einzelne Ausgabe zu erhalten, wird nicht skalieren.

Was Sie tun müssen, ist einen hochspezialisierten KI-Agenten zu erstellen, der konsistent und im großen Maßstab fehlerfrei arbeitet. Jeder Post-Typ erfordert einen dedizierten KI-Agenten, der mit spezifischen Prompt-Vorlagen, Formatierungsregeln und strukturellen Anforderungen konfiguriert ist.

Dies beinhaltet die klare Definition jedes Abschnitts des Post-Typs. Zum Beispiel empfiehlt Viktor für das Titel-Element, diese Struktur zu Ihrem Prompt hinzuzufügen:

Viktor skizzierte kurz den exakten Prozess, den unser Team verwendet:

Prompt-Bibliothek generieren: Erstellen Sie über 500 Prompts, die Nutzeranfragen über Ihre Domäne repräsentieren, mit AmICited.com oder ähnlichen Tools.

Zitationsmuster analysieren: Verstehen Sie das aktuelle KI-Verhalten für diese Prompts und finden Sie Chancen. Finden Sie heraus, was zitiert wird, was fehlt, was schwach ist.

Spezialisierte Agenten erstellen: Erstellen Sie KI-Agenten in FlowHunt (oder ähnlichen Plattformen) für jeden Post-Typ mit definierten Elementen und Einschränkungen.

Systematisch generieren: Produzieren Sie Inhalte im großen Maßstab mit spezialisierten Agenten für jeden Post-Typ, wobei konsistente Struktur und Qualität beibehalten werden.

Semantische Verlinkung implementieren: Verwenden Sie semantische Ähnlichkeitsalgorithmen, um automatisch verwandte Artikelverbindungen vorzuschlagen und zu erstellen.

Überwachen und verfeinern: Verfolgen Sie, welche Inhalte von KI-Systemen zitiert werden, und verfeinern Sie Ihren Ansatz basierend auf echten Zitationsdaten.

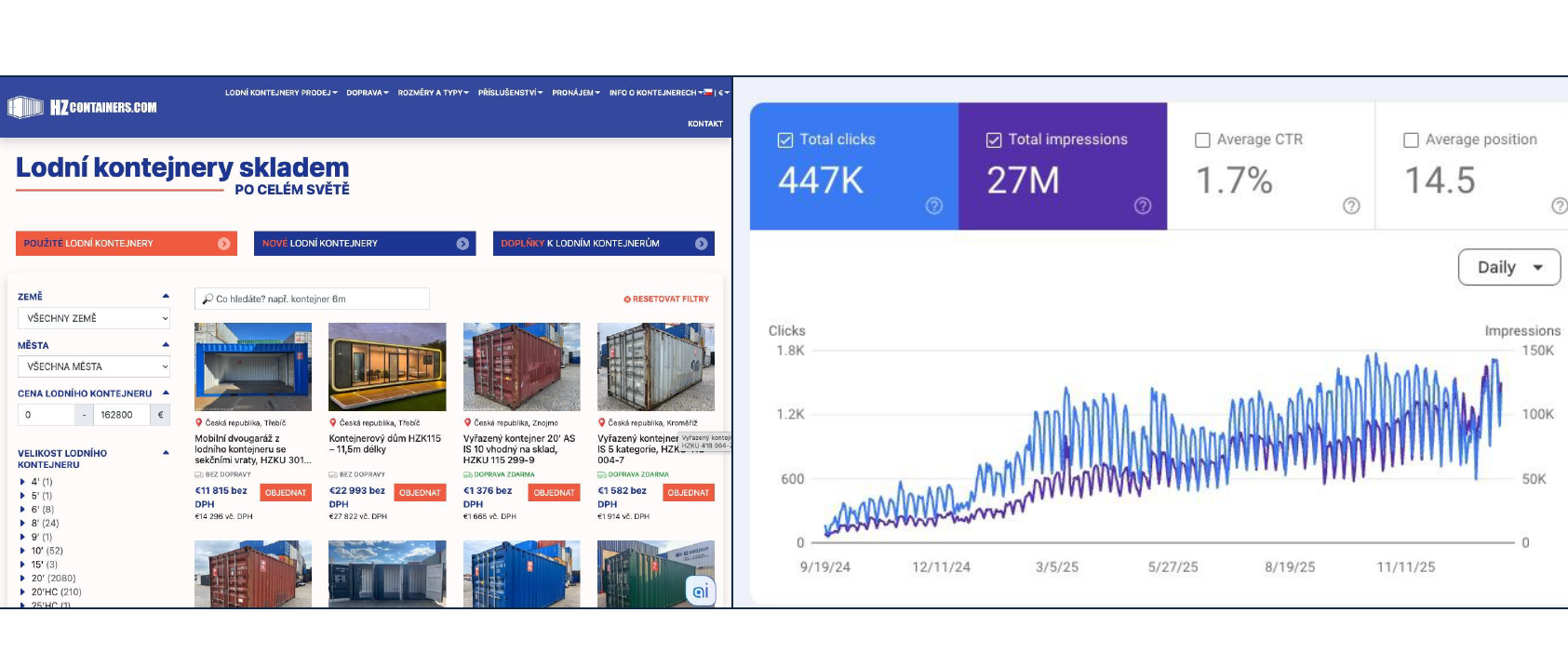

18.000% Traffic-Steigerung (180x) von Januar bis September 2025, mit der Lieferung von 2.000 Containern. Der Ansatz basiert auf technischen SEO-Grundlagen, umfassenden Inhalten, die alle Fragen beantworten, ordnungsgemäßem Schema-Markup, strukturierten Post-Typen und automatisierter interner Verlinkung. Kein Keyword-Stuffing oder Link-Schemata.

Viktor betonte einen fundamentalen Übergang, der in der Art und Weise stattfindet, wie Menschen Produkte online finden und bewerten. Google berücksichtigt Hunderte von Ranking-Faktoren. Hier ist nur eine Teilliste, um die Komplexität zu veranschaulichen:

Die Realität ist, dass jede Verbesserung nur Promille (Tausendstel) Gewinn beiträgt. Bedeutende Ranking-Verbesserungen zu erzielen, erfordert Monate kontinuierlicher Optimierung über Dutzende von Faktoren gleichzeitig. Traditionelles SEO bleibt wichtig, stellt aber einen mühsamen, inkrementellen Ansatz zur Sichtbarkeit dar.

Generative Engine Optimization konzentriert sich darauf, von KI-Systemen zitiert zu werden, wenn Nutzer Fragen stellen, die für Ihr Geschäft relevant sind.

Hauptunterschiede zum traditionellen SEO:

Hier ist ein kurzer Überblick über die wichtigsten Tools und die Implementierungs-Roadmap.

Viktor empfahl eine spezifische Sequenz für die Implementierung: Phase 1: Technische Grundlage (Wochen 1-4) • Infrastruktur-Audit und -Optimierung • Robots.txt- und Sitemap-Konfiguration • Cache-Header-Implementierung • Core Web Vitals-Verbesserung • Schema.org-Markup für bestehende Seiten Phase 2: Content-Struktur (Wochen 5-8) • Post-Typen und ihre Elemente definieren • Spezialisierte KI-Agenten für jeden Typ erstellen • Automatisierung der internen Verlinkung etablieren • Semantische Ähnlichkeitssysteme implementieren Phase 3: Content-Generierung (Wochen 9-16) • Prompt-Bibliothek generieren (über 500 Prompts) • Aktuelle Zitationsmuster analysieren • Systematische Content-Erstellung beginnen • KI-Zitations-Performance überwachen • Basierend auf Daten verfeinern Phase 4: Protokoll-Implementierung (Laufend) • UCP/ACP/AP2 implementieren, falls zutreffend • Benutzerdefinierte MCP-Server für Integrationen entwickeln • KI-Commerce-Funktionalität testen • Basierend auf Adoption erweitern

Dies ist keine Quick-Win-Strategie. Technisches SEO, umfassende Inhalte und KI-Protokoll-Implementierung erfordern nachhaltige Investitionen über Monate.

Die Ergebnisse summieren sich jedoch. Jeder ordnungsgemäß strukturierte Inhalt erhöht Ihre Autorität. Jede technische Verbesserung steigert die Effektivität all Ihrer Inhalte. Jede Zitation durch KI-Systeme erhöht die Wahrscheinlichkeit zukünftiger Zitationen. Die Frage ist nicht, ob man in diese Infrastruktur investieren soll – es ist, ob man den Übergang anführen oder später folgen möchte, wenn Konkurrenten bereits Autorität in KI-vermittelter Entdeckung etabliert haben.

Für technische E-Commerce-Führungskräfte bietet dieses Framework Klarheit. Sie müssen damit beginnen, ordnungsgemäße technische Grundlagen aufzubauen, KI-Commerce-Protokolle zu implementieren, Inhalte systematisch zu strukturieren und gleichzeitig für traditionelle Suche und KI-Zitationen zu optimieren. Die Infrastruktur, die Sie heute aufbauen, bestimmt die Auffindbarkeit, wenn Nutzer morgen KI-Systeme nach Empfehlungen fragen.

Viktors technische Präsentation ergänzt die strategischen und operativen Perspektiven von früher in der Konferenzserie.

Michal Lichners Implementierungs-Roadmap etablierte, wo KI-Implementierung fokussiert werden sollte und wie Inhalte systematisch vorbereitet werden. Zemans Präsentation bietet die technische Infrastruktur, die diese Inhalte auffindbar und funktional macht.

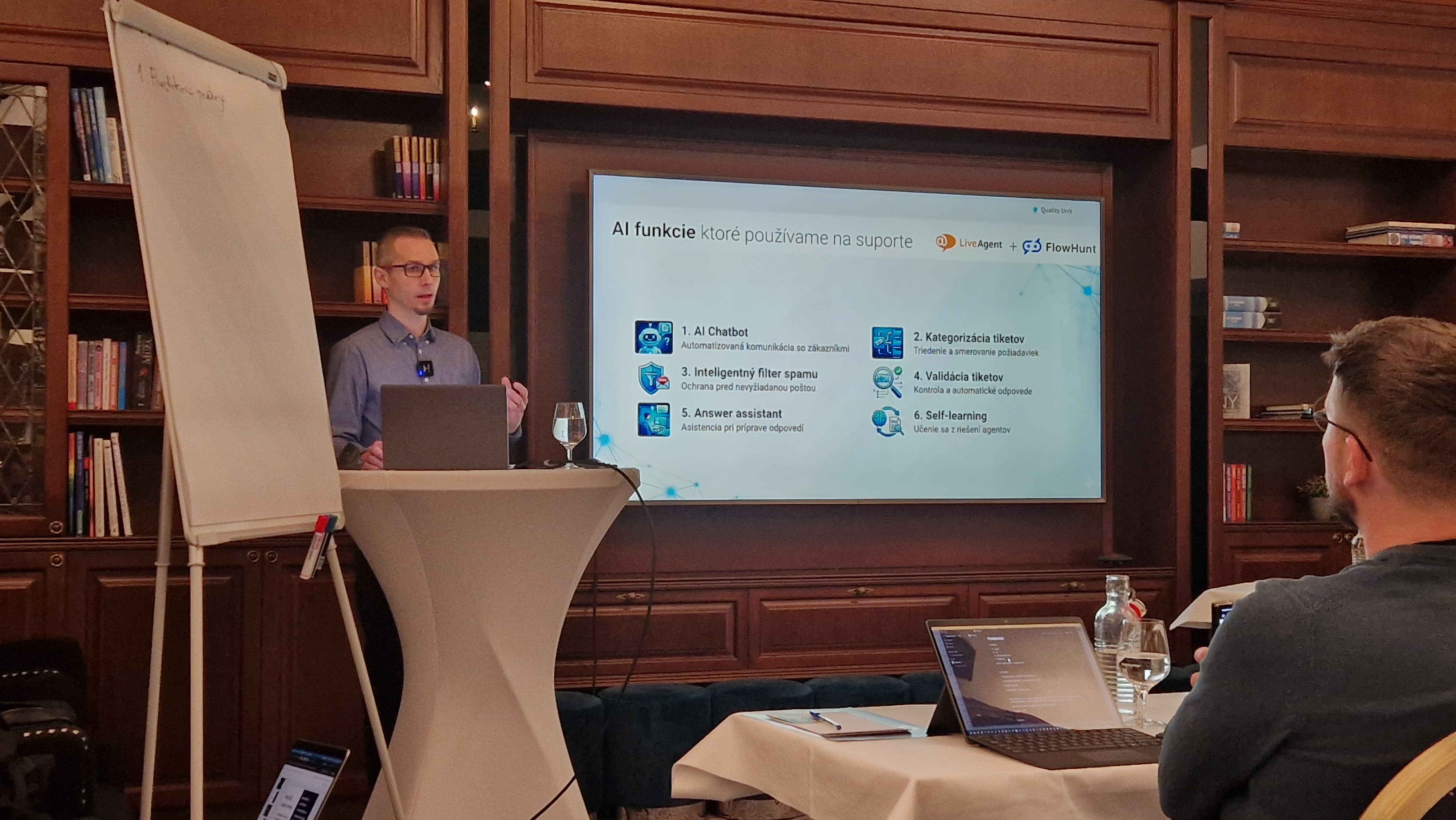

Jozef Štofiras Support-Automatisierung zeigt das exakte Set von Tools, das wir verwenden, um Support-Routinearbeit zu automatisieren, vom Filtern und Kategorisieren über Datenanreicherung bis hin zu Antwort-Assistenten und menschlicher Übergabe.

Zusammen bilden diese drei Perspektiven ein vollständiges Bild: strategische Planung, technische Infrastruktur und operative Ausführung für E-Commerce in einer KI-vermittelten Commerce-Umgebung.

KI-Commerce-Protokolle wie UCP (Universal Commerce Protocol), ACP (Agentic Commerce Protocol) und AP2 (Agent Payment Protocol) standardisieren, wie KI-Systeme mit E-Commerce-Plattformen interagieren. Sie ermöglichen es KI-Assistenten, Produkte zu durchsuchen, Optionen zu vergleichen, den Checkout zu initiieren und Transaktionen im Namen der Nutzer abzuschließen, wodurch Ihr Shop über KI-vermittelte Shopping-Erlebnisse zugänglich wird.

SEO (Search Engine Optimization) konzentriert sich auf das Ranking in traditionellen Suchmaschinen wie Google durch Keyword-Optimierung und Backlinks. GEO (Generative Engine Optimization) konzentriert sich darauf, von KI-Systemen wie ChatGPT und Perplexity zitiert zu werden, durch strukturierte Inhalte, klare Entitätsdefinitionen und umfassende Antworten. Moderner E-Commerce benötigt beides: SEO für aktuellen Traffic, GEO für zukünftige KI-vermittelte Auffindbarkeit.

Zu den prioritären Grundlagen gehören: schnelle, sichere Infrastruktur mit CDN; korrekt konfigurierte robots.txt und Sitemaps; korrekte Cache-Header; regelmäßige technische Audits; Core Web Vitals-Optimierung; umfassendes schema.org-Markup für Entitäten; semantische Content-Struktur; und automatisierte interne Verlinkung. Diese schaffen die Grundlage, die sowohl traditionelle Suchmaschinen als auch KI-Systeme benötigen, um Ihre Inhalte richtig zu verstehen und zu indexieren.

Beginnen Sie damit, über 500 Prompts mit Tools wie AmICited.com zu generieren, um zu verstehen, wie KI-Systeme derzeit über Ihre Branche sprechen. Erstellen Sie spezialisierte KI-Agenten für jeden Content-Typ (Glossar, Anleitungen, Checklisten, Produktbeschreibungen) mit definierten Elementen und Formatierungsregeln. Verwenden Sie semantische Ähnlichkeit für Vorschläge verwandter Artikel. Generieren Sie Inhalte, die alle potenziellen Besucherfragen umfassend beantworten, anstatt sich auf enge Keywords zu konzentrieren.

Arshia ist eine AI Workflow Engineerin bei FlowHunt. Mit einem Hintergrund in Informatik und einer Leidenschaft für KI spezialisiert sie sich darauf, effiziente Arbeitsabläufe zu entwickeln, die KI-Tools in alltägliche Aufgaben integrieren und so Produktivität und Kreativität steigern.

Erstellen Sie KI-Agenten, die SEO-optimierte Inhalte generieren, technische SEO-Verbesserungen implementieren und KI-Protokoll-Integrationen erstellen – alles innerhalb des visuellen Workflow-Builders von FlowHunt.

Ein praktisches Framework zur Implementierung von KI im E-Commerce vom CMO von Quality Unit. Erfahren Sie, wo Sie beginnen sollten, welche häufigen Herausforder...

Eine technische Aufschlüsselung von sechs KI-Funktionen, die die Support-Arbeitslast um 48,5% reduzierten. Erfahren Sie die spezifischen Probleme, die jede Funk...

FlowHunt ermöglicht mühelose KI-Automatisierung mit einer No-Code-Plattform und befähigt Nutzer, individuelle Tools zu erstellen. Gegründet von QualityUnit, den...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.