Beispiele für MCP-Server: Intelligente Integrationen für KI-Agenten entwickeln

Entdecken Sie umfassende Beispiele für MCP-Server und erfahren Sie, wie Sie Model Context Protocol Server aufbauen, bereitstellen und integrieren, um die Fähigk...

Erfahren Sie, wie Sie einen Model Context Protocol (MCP) Server entwickeln, der sich nahtlos mit der OpenAI-API integriert und leistungsstarke, KI-basierte Tool-Ausführungen sowie intelligente Automatisierung ermöglicht.

Das Model Context Protocol (MCP) stellt einen Paradigmenwechsel dar, wie KI-Systeme mit externen Tools und Datenquellen interagieren. Kombiniert mit den leistungsfähigen Sprachmodellen von OpenAI wird ein MCP-Server zum Tor für intelligente Automatisierung: KI-Systeme können komplexe Operationen ausführen, Echtzeitdaten abrufen und sich nahtlos in Ihre bestehende Infrastruktur einfügen. Dieser umfassende Guide führt Sie durch den gesamten Entwicklungsprozess eines MCP-Servers mit OpenAI-Anbindung – von den Grundkonzepten bis zur produktionsreifen Implementierung.

Ob Sie eine Kundenservice-Automatisierung, ein intelligentes Datenverarbeitungssystem oder ein anspruchsvolles Business-Intelligence-Tool bauen: Zu wissen, wie Sie einen MCP-Server konzipieren und umsetzen, ist essenziell für moderne KI-Entwicklung. Die Integration von MCP-Servern und OpenAI schafft ein starkes Ökosystem, in dem KI-Modelle Probleme verstehen, die richtigen Tools auswählen und diese präzise ausführen – und das bei voller Sicherheit, Zuverlässigkeit und Skalierbarkeit.

Das Model Context Protocol ist ein offener Standard, der definiert, wie KI-Modelle externe Tools, Services und Datenquellen entdecken und nutzen können. Anstatt sämtliche Funktionalitäten direkt ins KI-Modell einzubauen, ermöglicht MCP es Entwicklern, spezialisierte Server zu erstellen, die Fähigkeiten über eine standardisierte Schnittstelle bereitstellen. Diese Trennung sorgt für bessere Modularität, Sicherheit und Skalierbarkeit von KI-Anwendungen.

Im Kern funktioniert MCP nach einem einfachen Prinzip: Das KI-Modell (hier OpenAI’s GPT) agiert als intelligenter Orchestrator, der versteht, welche Tools verfügbar sind, wann diese eingesetzt werden sollten und wie deren Resultate zu interpretieren sind. Der MCP-Server stellt diese Tools bereit und exponiert sie über eine klar definierte API, die das KI-Modell entdecken und aufrufen kann. So entsteht ein sauberer Vertrag zwischen KI-System und Ihrer individuellen Business-Logik.

Das Besondere an MCP ist seine Flexibilität. Ihr Server kann beliebige Tools bereitstellen – etwa für Datenbankabfragen, API-Aufrufe, Datei- oder Datenverarbeitung, Berechnungen oder das Starten komplexer Workflows. Das KI-Modell lernt diese Fähigkeiten kennen und setzt sie intelligent im Dialog ein: Es entscheidet, welches Tool zur Nutzeranfrage und zum Gesprächskontext passt.

Die Integration von MCP-Servern mit OpenAI überwindet eine grundlegende Einschränkung großer Sprachmodelle: Sie besitzen ein Wissens-Cutoff und können nicht direkt mit Echtzeitsystemen oder proprietären Daten interagieren. Mit einem MCP-Server erweitern Sie die Möglichkeiten von OpenAI weit über das Basistraining hinaus – Ihr Modell greift auf aktuelle Informationen zu, führt Business-Logik aus und integriert sich in Ihre bestehenden Systeme.

Praktische Szenarien, in denen MCP-Server unverzichtbar sind:

Auch für Entwicklungsteams ergeben sich große Vorteile: Mehrere Teams können eigene MCP-Server unabhängig entwickeln und pflegen, welche dann zu komplexen KI-Anwendungen zusammengesetzt werden. Dieses modulare Vorgehen skaliert mit Ihrem Unternehmen und wachsender KI-Komplexität.

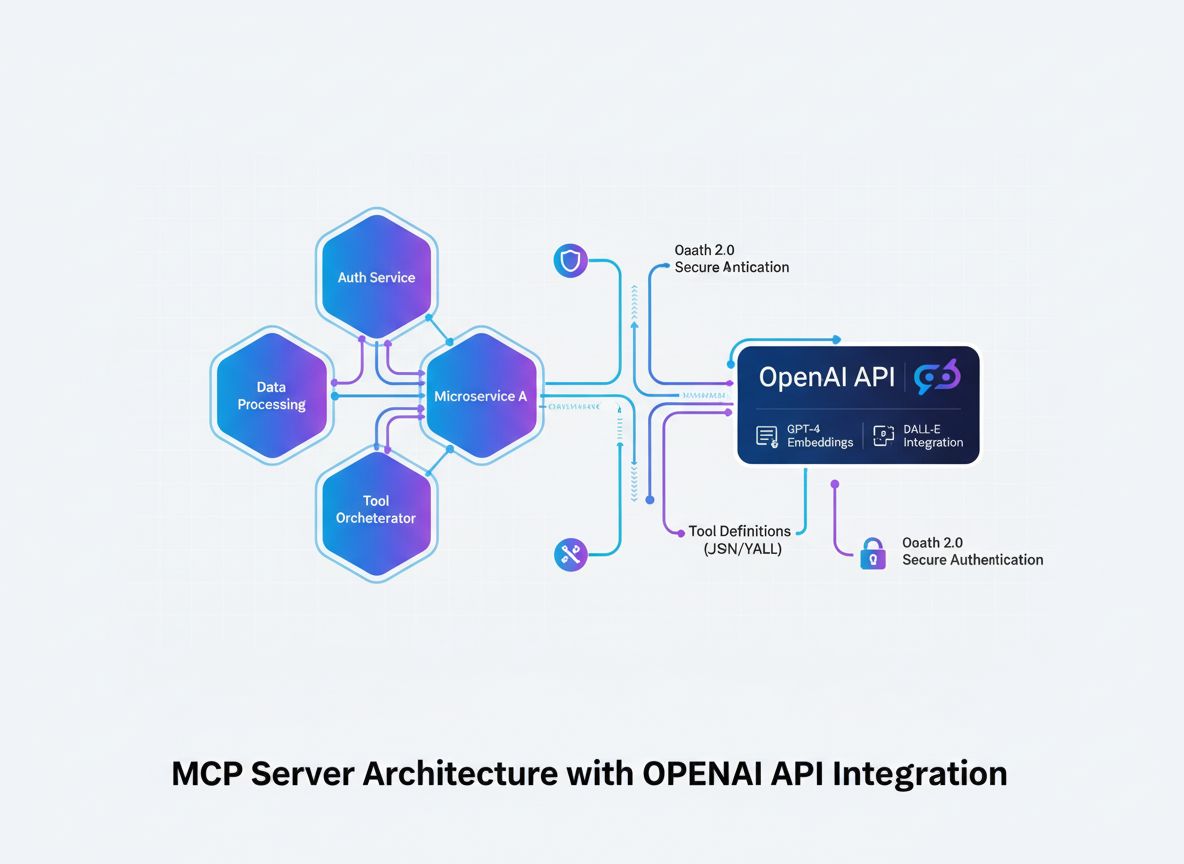

Vor der Implementierung ist es wichtig, den Architekturfluss einer MCP-Server-Integration mit OpenAI zu verstehen. Mehrere wichtige Komponenten arbeiten hierbei zusammen:

Das KI-Modell (OpenAI) startet Konversationen und entscheidet, welche Tools aufgerufen werden. Erkennt das Modell, dass ein Tool benötigt wird, erzeugt es eine strukturierte Anfrage mit Tool-Namen und Parametern.

Der MCP-Client dient als Übersetzer und Vermittler. Er empfängt Tool-Aufrufe von OpenAI, wandelt sie ins vom MCP-Server erwartete Format um, leitet die Anfrage weiter und gibt das Ergebnis im passenden Format an OpenAI zurück.

Der MCP-Server ist Ihre individuelle Anwendung, die Tools und Fähigkeiten bereitstellt. Er empfängt Anfragen vom MCP-Client, führt die gewünschten Operationen aus (z. B. Datenbankabfragen, API-Calls, Berechnungen) und liefert strukturierte Ergebnisse.

Tool-Definitionen sind Verträge, die festlegen, welche Tools existieren, welche Parameter sie benötigen und was sie zurückliefern. Diese Definitionen werden vom MCP-Client entdeckt und bei OpenAI registriert, damit das Modell die verfügbaren Tools kennt.

Diese Architektur schafft eine klare Trennung der Verantwortlichkeiten: OpenAI übernimmt Reasoning und Entscheidungsfindung, Ihr MCP-Server die domänenspezifische Logik und den Datenzugriff, und der MCP-Client regelt die Kommunikation zwischen beiden.

Die Basis jedes erfolgreichen MCP-Servers ist eine klare Definition der bereitzustellenden Tools. Das ist mehr als eine technische Übung – es ist eine strategische Entscheidung darüber, welche Fähigkeiten Ihr KI-System für seine Ziele benötigt.

Starten Sie damit, die konkreten Probleme zu identifizieren, die Ihr KI-System lösen soll. Entwickeln Sie einen Kundenservice-Chatbot, der Bestellungen nachschlagen können muss? Einen Datenanalyse-Assistenten für Datenbankabfragen? Ein Content-Tool, das auf die Wissensbasis Ihres Unternehmens zugreift? Jedes Einsatzszenario hat andere Tool-Anforderungen.

Für jedes Tool definieren Sie:

get_customer_order_history, search_knowledge_base, execute_sql_query)Beispiel für sauber definierte Tool-Spezifikationen:

| Tool-Name | Zweck | Input-Parameter | Output-Format | Anwendungsfall |

|---|---|---|---|---|

get_customer_info | Kundendetails abrufen | customer_id (string) | JSON-Objekt mit Name, E-Mail, Account-Status | Kundenservice-Anfragen |

search_orders | Bestellungen finden | customer_id, date_range, status | Array von Bestellobjekten | Bestellabfrage und -historie |

create_support_ticket | Supportfall eröffnen | customer_id, issue_description, priority | Ticket-Objekt mit ID und Bestätigung | Eskalation von Anfragen |

check_inventory | Produktverfügbarkeit prüfen | product_id, warehouse_location | Bestand und Lagerdetails | Lageranfragen |

process_refund | Rückerstattung auslösen | order_id, amount, reason | Transaktionsbestätigung mit Referenznummer | Rückerstattungsabwicklung |

Mit dieser tabellarischen Herangehensweise denken Sie das gesamte Tool-Ökosystem durch, bevor Sie auch nur eine Zeile Code schreiben. So stellen Sie Konsistenz, Klarheit und Vollständigkeit sicher.

Für die Erstellung eines MCP-Servers benötigen Sie ein solides Entwicklungsfundament. MCP-Server können in vielen Sprachen gebaut werden – wir fokussieren uns auf die populärsten: TypeScript/Node.js und Python, da dafür die ausgereiftesten MCP-Bibliotheken und Community-Support existieren.

Für TypeScript/Node.js:

Starten Sie ein neues Node.js-Projekt und installieren Sie die benötigten Abhängigkeiten:

mkdir mcp-server-openai

cd mcp-server-openai

npm init -y

npm install @modelcontextprotocol/sdk openai dotenv express cors

npm install --save-dev typescript @types/node ts-node

Erstellen Sie eine tsconfig.json zur Konfiguration von TypeScript:

{

"compilerOptions": {

"target": "ES2020",

"module": "commonjs",

"lib": ["ES2020"],

"outDir": "./dist",

"rootDir": "./src",

"strict": true,

"esModuleInterop": true,

"skipLibCheck": true,

"forceConsistentCasingInFileNames": true

}

}

Für Python:

Virtuelle Umgebung anlegen und Abhängigkeiten installieren:

python -m venv venv

source venv/bin/activate # Unter Windows: venv\Scripts\activate

pip install mcp openai python-dotenv fastapi uvicorn

Unabhängig von der Sprache benötigen Sie:

.env-Datei für sichere Speicherung sensibler Zugangsdaten anlegenDas Herzstück Ihres MCP-Servers ist die Serveranwendung, die Ihre Tools gemäß MCP-Protokoll bereitstellt. Dazu gehören Endpunkte für Tool-Discovery und Tool-Ausführung.

TypeScript/Node.js Beispiel:

import { Server } from "@modelcontextprotocol/sdk/server/index.js";

import { StdioServerTransport } from "@modelcontextprotocol/sdk/server/stdio.js";

import {

CallToolRequestSchema,

ListToolsRequestSchema,

} from "@modelcontextprotocol/sdk/types.js";

const server = new Server({

name: "openai-mcp-server",

version: "1.0.0",

});

// Tools definieren

const tools = [

{

name: "get_customer_info",

description: "Kundeninformationen anhand der ID abrufen",

inputSchema: {

type: "object",

properties: {

customer_id: {

type: "string",

description: "Die eindeutige Kundenkennung",

},

},

required: ["customer_id"],

},

},

// Weitere Tools hier ergänzen

];

// Handler für Tool-Liste

server.setRequestHandler(ListToolsRequestSchema, async () => {

return { tools };

});

// Handler für Tool-Ausführung

server.setRequestHandler(CallToolRequestSchema, async (request) => {

const { name, arguments: args } = request.params;

if (name === "get_customer_info") {

// Tool-Logik hier implementieren

const customerId = args.customer_id;

// Datenbank- oder API-Abfrage

return {

content: [

{

type: "text",

text: JSON.stringify({

id: customerId,

name: "John Doe",

email: "john@example.com",

}),

},

],

};

}

return {

content: [{ type: "text", text: `Unbekanntes Tool: ${name}` }],

isError: true,

};

});

// Server starten

const transport = new StdioServerTransport();

server.connect(transport);

Python Beispiel:

from mcp.server import Server

from mcp.types import Tool, TextContent, ToolResult

import json

app = Server("openai-mcp-server")

# Tools definieren

TOOLS = [

Tool(

name="get_customer_info",

description="Kundeninformationen anhand der ID abrufen",

inputSchema={

"type": "object",

"properties": {

"customer_id": {

"type": "string",

"description": "Die eindeutige Kundenkennung"

}

},

"required": ["customer_id"]

}

)

]

@app.list_tools()

async def list_tools():

return TOOLS

@app.call_tool()

async def call_tool(name: str, arguments: dict):

if name == "get_customer_info":

customer_id = arguments.get("customer_id")

# Tool-Logik implementieren

result = {

"id": customer_id,

"name": "John Doe",

"email": "john@example.com"

}

return ToolResult(

content=[TextContent(type="text", text=json.dumps(result))]

)

return ToolResult(

content=[TextContent(type="text", text=f"Unbekanntes Tool: {name}")],

isError=True

)

if __name__ == "__main__":

import uvicorn

uvicorn.run(app, host="0.0.0.0", port=8000)

Die eigentliche Stärke Ihres MCP-Servers liegt in der konkreten Tool-Implementierung: Hier binden Sie Datenbanken, externe APIs, Datenverarbeitung und Business-Logik ein.

Beispiel: Datenbankintegration

import { Pool } from "pg"; // Beispiel PostgreSQL

const pool = new Pool({

connectionString: process.env.DATABASE_URL,

});

async function getCustomerInfo(customerId: string) {

try {

const result = await pool.query(

"SELECT id, name, email, account_status FROM customers WHERE id = $1",

[customerId]

);

if (result.rows.length === 0) {

return {

error: "Kunde nicht gefunden",

status: 404,

};

}

return result.rows[0];

} catch (error) {

return {

error: "Datenbankabfrage fehlgeschlagen",

details: error.message,

status: 500,

};

}

}

Beispiel: Externe API-Integration

import axios from "axios";

async function searchExternalDatabase(query: string) {

try {

const response = await axios.get(

"https://api.external-service.com/search",

{

params: { q: query },

headers: {

Authorization: `Bearer ${process.env.EXTERNAL_API_KEY}`,

},

}

);

return response.data;

} catch (error) {

return {

error: "Externer API-Aufruf fehlgeschlagen",

details: error.message,

};

}

}

Fehlerbehandlung und Validierung

Robuste Fehlerbehandlung ist für produktive MCP-Server unerlässlich. Implementieren Sie umfassende Validierung und Fehlerbehandlung:

function validateInput(args: any, schema: any): { valid: boolean; error?: string } {

// Pflichtfelder prüfen

for (const required of schema.required || []) {

if (!(required in args)) {

return { valid: false, error: `Fehlender Pflichtparameter: ${required}` };

}

}

// Feldtypen prüfen

for (const [key, property] of Object.entries(schema.properties || {})) {

if (key in args) {

const value = args[key];

const expectedType = (property as any).type;

if (typeof value !== expectedType) {

return {

valid: false,

error: `Parameter ${key} muss vom Typ ${expectedType} sein`,

};

}

}

}

return { valid: true };

}

Der MCP-Client ist die Brücke zwischen OpenAI und Ihrem MCP-Server. Er übersetzt zwischen OpenAIs Function-Calling-Format und dem MCP-Protokoll.

TypeScript/Node.js MCP-Client:

import { Client } from "@modelcontextprotocol/sdk/client/index.js";

import { StdioClientTransport } from "@modelcontextprotocol/sdk/client/stdio.js";

import OpenAI from "openai";

class MCPOpenAIBridge {

private mcpClient: Client;

private openaiClient: OpenAI;

private availableTools: any[] = [];

constructor() {

this.openaiClient = new OpenAI({

apiKey: process.env.OPENAI_API_KEY,

});

}

async initialize() {

// Verbindung zum MCP-Server

const transport = new StdioClientTransport({

command: "node",

args: ["dist/server.js"],

});

this.mcpClient = new Client({

name: "openai-mcp-client",

version: "1.0.0",

});

await this.mcpClient.connect(transport);

// Tools entdecken

const toolsResponse = await this.mcpClient.listTools();

this.availableTools = toolsResponse.tools;

}

async executeWithOpenAI(userMessage: string) {

const messages = [{ role: "user" as const, content: userMessage }];

// MCP-Tools ins OpenAI-Function-Format umwandeln

const tools = this.availableTools.map((tool) => ({

type: "function" as const,

function: {

name: tool.name,

description: tool.description,

parameters: tool.inputSchema,

},

}));

let response = await this.openaiClient.chat.completions.create({

model: "gpt-4",

messages,

tools,

});

// Tool-Calls in Schleife behandeln

while (response.choices[0].finish_reason === "tool_calls") {

const toolCalls = response.choices[0].message.tool_calls || [];

for (const toolCall of toolCalls) {

const toolName = toolCall.function.name;

const toolArgs = JSON.parse(toolCall.function.arguments);

// Tool auf MCP-Server ausführen

const toolResult = await this.mcpClient.callTool({

name: toolName,

arguments: toolArgs,

});

// Tool-Ergebnis zu Nachrichten hinzufügen

messages.push({

role: "assistant",

content: response.choices[0].message.content || "",

});

messages.push({

role: "tool",

content: JSON.stringify(toolResult),

tool_call_id: toolCall.id,

});

}

// Nächste Antwort von OpenAI holen

response = await this.openaiClient.chat.completions.create({

model: "gpt-4",

messages,

tools,

});

}

return response.choices[0].message.content;

}

}

// Nutzung

const bridge = new MCPOpenAIBridge();

await bridge.initialize();

const result = await bridge.executeWithOpenAI(

"Was ist die Bestellhistorie von Kunde 12345?"

);

console.log(result);

Sicherheit ist essenziell, wenn MCP-Server mit sensiblen Daten und externen APIs interagieren. Setzen Sie mehrere Schutzebenen ein:

API-Key-Management:

import crypto from "crypto";

class APIKeyManager {

private validKeys: Set<string> = new Set();

constructor() {

// Gültige API-Keys aus Umgebung oder sicherem Speicher laden

const keys = process.env.VALID_API_KEYS?.split(",") || [];

this.validKeys = new Set(keys);

}

validateRequest(apiKey: string): boolean {

return this.validKeys.has(apiKey);

}

generateNewKey(): string {

return crypto.randomBytes(32).toString("hex");

}

}

Anfrage-Signierung und Verifikation:

import crypto from "crypto";

function signRequest(payload: any, secret: string): string {

return crypto

.createHmac("sha256", secret)

.update(JSON.stringify(payload))

.digest("hex");

}

function verifySignature(payload: any, signature: string, secret: string): boolean {

const expectedSignature = signRequest(payload, secret);

return crypto.timingSafeEqual(

Buffer.from(signature),

Buffer.from(expectedSignature)

);

}

Rate Limiting:

import rateLimit from "express-rate-limit";

const limiter = rateLimit({

windowMs: 15 * 60 * 1000, // 15 Minuten

max: 100, // max. 100 Anfragen pro IP/Fenster

message: "Zu viele Anfragen von dieser IP, bitte später erneut versuchen.",

});

app.use("/api/", limiter);

Input-Sanitizing:

function sanitizeInput(input: string): string {

// Potenziell gefährliche Zeichen entfernen

return input

.replace(/[<>]/g, "")

.trim()

.substring(0, 1000); // Maximale Länge begrenzen

}

function validateCustomerId(customerId: string): boolean {

// Nur alphanumerisch und Bindestriche erlauben

return /^[a-zA-Z0-9-]+$/.test(customerId);

}

Umfassendes Testing stellt sicher, dass Ihr MCP-Server korrekt arbeitet und auch Randfälle sauber behandelt.

Unit-Tests Beispiel (Jest):

import { getCustomerInfo } from "../tools/customer";

describe("Customer Tools", () => {

test("liefert Kundendaten bei gültiger ID", async () => {

const result = await getCustomerInfo("cust_123");

expect(result).toHaveProperty("id");

expect(result).toHaveProperty("name");

expect(result).toHaveProperty("email");

});

test("liefert Fehler bei ungültiger ID", async () => {

const result = await getCustomerInfo("invalid");

expect(result).toHaveProperty("error");

});

test("behandelt Datenbankfehler korrekt", async () => {

// Datenbankfehler simulieren

const result = await getCustomerInfo("cust_error");

expect(result).toHaveProperty("error");

expect(result.status).toBe(500);

});

});

Integrationstests:

describe("MCP Server Integration", () => {

let server: Server;

beforeAll(async () => {

server = new Server({ name: "test-server", version: "1.0.0" });

// Server initialisieren

});

test("listet alle verfügbaren Tools", async () => {

const tools = await server.listTools();

expect(tools.length).toBeGreaterThan(0);

expect(tools[0]).toHaveProperty("name");

expect(tools[0]).toHaveProperty("description");

});

test("führt Tool aus und liefert Ergebnis", async () => {

const result = await server.callTool({

name: "get_customer_info",

arguments: { customer_id: "cust_123" },

});

expect(result).toBeDefined();

});

});

FlowHunt bietet eine umfassende Plattform zur Automatisierung des gesamten Lebenszyklus von MCP-Server-Entwicklung, Testing und Deployment. Statt jeden Schritt manuell zu steuern, ermöglichen intelligente FlowHunt-Automationsflüsse die effiziente, konsistente Entwicklung Ihres MCP-Servers.

Automatisiertes Testing und Validierung:

FlowHunt orchestriert Ihre Testpipeline, führt Unit-, Integrations- und End-to-End-Tests automatisch bei jedem Commit aus und stellt so sicher, dass Ihre MCP-Tools immer korrekt funktionieren, bevor sie produktiv gehen.

Continuous Integration und Deployment:

Richten Sie FlowHunt-Workflows ein, um Ihren MCP-Server bei jedem Push automatisch zu bauen, zu testen und zu deployen. Das spart manuelle Deployments und minimiert Fehlerquellen.

Monitoring und Benachrichtigung:

FlowHunt überwacht die Gesundheit Ihres MCP-Servers, misst API-Antwortzeiten und benachrichtigt Sie bei Problemen. So werden Tool-Ausfälle oder Performanceverluste sofort erkannt.

Dokumentations-Generierung:

Generieren Sie automatisch API-Dokumentation zu Ihren Tools, die stets synchron zur Implementierung bleibt. Entwickler haben so immer aktuelle Infos zu verfügbaren Tools.

Performance-Optimierung:

Mit FlowHunt-Analytics erkennen Sie Engpässe in der Tool-Ausführung: Welche Tools werden am häufigsten genutzt? Wo gibt es Latenzen? Wo lohnt sich Optimierung am meisten?

Für das Produktiv-Deployment eines MCP-Servers ist sorgfältige Planung notwendig. Folgende Strategien sind empfehlenswert:

Docker-Containerisierung:

Erstellen Sie ein Dockerfile für Ihren MCP-Server:

FROM node:18-alpine

WORKDIR /app

COPY package*.json ./

RUN npm ci --only=production

COPY dist ./dist

EXPOSE 8000

CMD ["node", "dist/server.js"]

Build und Push ins Container-Registry:

docker build -t my-mcp-server:1.0.0 .

docker push myregistry.azurecr.io/my-mcp-server:1.0.0

Kubernetes-Deployment:

Deployment Ihres containerisierten MCP-Servers auf Kubernetes:

apiVersion: apps/v1

kind: Deployment

metadata:

name: mcp-server

spec:

replicas: 3

selector:

matchLabels:

app: mcp-server

template:

metadata:

labels:

app: mcp-server

spec:

containers:

- name: mcp-server

image: myregistry.azurecr.io/my-mcp-server:1.0.0

ports:

- containerPort: 8000

env:

- name: OPENAI_API_KEY

valueFrom:

secretKeyRef:

name: openai-secrets

key: api-key

- name: DATABASE_URL

valueFrom:

secretKeyRef:

name: db-secrets

key: connection-string

resources:

requests:

memory: "256Mi"

cpu: "250m"

limits:

memory: "512Mi"

cpu: "500m"

Umgebungskonfiguration:

Nutzen Sie für alle Einstellungen Umgebungsvariablen:

# .env.production

OPENAI_API_KEY=sk-...

DATABASE_URL=postgresql://user:pass@host:5432/db

MCP_SERVER_PORT=8000

LOG_LEVEL=info

ENABLE_METRICS=true

Mit wachsender Komplexität Ihres MCP-Servers sollten Sie folgende Muster in Erwägung ziehen:

Tool-Komposition:

Erstellen Sie High-Level-Tools, die mehrere Low-Level-Tools kombinieren:

async function processCustomerRefund(customerId: string, orderId: string, amount: number) {

// Kundendaten holen

const customer = await getCustomerInfo(customerId);

// Bestelldetails holen

const order = await getOrderDetails(orderId);

// Prüfen, ob Bestellung zum Kunden gehört

if (order.customerId !== customerId) {

throw new Error("Bestellung gehört nicht zum Kunden");

}

// Rückerstattung ausführen

const refund = await createRefund(orderId, amount);

// Benachrichtigung senden

await sendNotification(customer.email, `Rückerstattung über ${amount} € ausgeführt`);

return refund;

}

Caching-Strategie:

Implementieren Sie Caching zur Reduzierung von Latenzen und API-Aufrufen:

import NodeCache from "node-cache";

const cache = new NodeCache({ stdTTL: 600 }); // 10 Minuten TTL

async function getCustomerInfoWithCache(customerId: string) {

const cacheKey = `customer_${customerId}`;

// Erst im Cache suchen

const cached = cache.get(cacheKey);

if (cached) {

return cached;

}

// Ansonsten aus Datenbank holen

const customer = await getCustomerInfo(customerId);

// Im Cache speichern

cache.set(cacheKey, customer);

return customer;

}

Asynchrone Job-Verarbeitung:

Für langlaufende Operationen asynchrones Job-Processing nutzen:

import Bull from "bull";

const jobQueue = new Bull("mcp-jobs");

jobQueue.process(async (job) => {

const { toolName, arguments: args } = job.data;

// Tool ausführen

const result = await executeTool(toolName, args);

return result;

});

async function executeToolAsync(toolName: string, args: any) {

const job = await jobQueue.add(

{ toolName, arguments: args },

{ attempts: 3, backoff: { type: "exponential", delay: 2000 } }

);

return job.id;

}

Produktive MCP-Server brauchen umfassendes Monitoring und Logging:

Strukturiertes Logging:

import winston from "winston";

const logger = winston.createLogger({

format: winston.format.json(),

transports: [

new winston.transports.File({ filename: "error.log", level: "error" }),

new winston.transports.File({ filename: "combined.log" }),

],

});

logger.info("Tool ausgeführt", {

toolName: "get_customer_info",

customerId: "cust_123",

duration: 145,

status: "success",

});

Metrik-Erfassung:

import prometheus from "prom-client";

const toolExecutionDuration = new prometheus.Histogram({

name: "mcp_tool_execution_duration_ms",

help: "Dauer der Tool-Ausführung in Millisekunden",

labelNames: ["tool_name", "status"],

});

const toolExecutionCounter = new prometheus.Counter({

name: "mcp_tool_executions_total",

help: "Gesamtanzahl der Tool-Ausführungen",

labelNames: ["tool_name", "status"],

});

async function executeToolWithMetrics(toolName: string, args: any) {

const startTime = Date.now();

try {

const result = await executeTool(toolName, args);

const duration = Date.now() - startTime;

toolExecutionDuration.labels(toolName, "success").observe(duration);

toolExecutionCounter.labels(toolName, "success").inc();

return result;

} catch (error) {

const duration = Date.now() - startTime;

toolExecutionDuration.labels(toolName, "error").observe(duration);

toolExecutionCounter.labels(toolName, "error").inc();

throw error;

}

}

Der Aufbau eines MCP-Servers mit OpenAI-Anbindung ist ein entscheidender Schritt für intelligente, integrierte KI-Anwendungen. Wenn Sie den in diesem Leitfaden beschriebenen Architekturmustern, Implementierungsstrategien und Best Practices folgen, erschaffen Sie robuste, skalierbare MCP-Server, die die OpenAI-Fähigkeiten weit über das Basistraining hinaus erweitern.

Der Schlüssel zum Erfolg liegt in der sorgfältigen Planung Ihrer Tool-Definitionen, der gründlichen Umsetzung von Sicherheitsmaßnahmen, umfassenden Tests und dem kontinuierlichen Monitoring im Betrieb. Starten Sie mit einem überschaubaren Set an Tools, testen Sie deren Zusammenspiel mit OpenAI und erweitern Sie Ihr Angebot schrittweise, sobald Sie Erfahrung und Vertrauen gewonnen haben.

Bedenken Sie: Ihr MCP-Server ist kein statisches Artefakt, sondern ein lebendiges System, das sich mit Ihren Geschäftsanforderungen weiterentwickelt und neue Potenziale für KI-getriebene Innovation eröffnet. Bauen Sie modular und erweiterbar, dokumentieren Sie Ihre Tools umfassend und trennen Sie klar zwischen Business-Logik und MCP-Protokoll-Implementierung.

Die Kombination aus MCP-Servern und den leistungsstarken Sprachmodellen von OpenAI eröffnet ungeahnte Möglichkeiten für Automatisierung, Intelligenz und Integration. Wenn Sie diese Technologie meistern, positionieren Sie sich und Ihr Unternehmen an der Spitze der KI-Innovation.

Automatisieren Sie Entwicklung, Testing und Deployment Ihrer MCP-Server-Workflows. Von Continuous Integration bis Produktionsmonitoring – FlowHunt optimiert jeden Schritt Ihres KI-Entwicklungszyklus.

Das Model Context Protocol ist ein standardisiertes Framework, das KI-Modelle wie OpenAI's GPT befähigt, Tools und Funktionen externer Server zu entdecken, zu verstehen und auszuführen. Es dient als Brücke zwischen KI-Modellen und individueller Business-Logik.

Sie benötigen einen gültigen OpenAI-API-Schlüssel mit den entsprechenden Berechtigungen. Der MCP-Server selbst benötigt keine speziellen Berechtigungen von OpenAI – er kommuniziert über Standard-API-Aufrufe. Sie sollten jedoch auf dem MCP-Server eine geeignete Authentifizierung und Autorisierung implementieren.

MCP-Server können in jeder Sprache entwickelt werden, die HTTP/REST-APIs oder WebSocket-Verbindungen unterstützt. Beliebte Optionen sind Python, TypeScript/Node.js, Java, C#/.NET und Go. Die Wahl der Sprache hängt von Ihrer vorhandenen Infrastruktur und der Expertise Ihres Teams ab.

Implementieren Sie Rate Limiting auf der Seite Ihres MCP-Servers, cachen Sie häufig angefragte Ergebnisse, verwenden Sie exponentielles Backoff für Wiederholungen und überwachen Sie die OpenAI-API-Nutzung. Ziehen Sie ein Queue-System für Tool-Anfragen in Betracht, um die Last effektiv zu steuern.

Arshia ist eine AI Workflow Engineerin bei FlowHunt. Mit einem Hintergrund in Informatik und einer Leidenschaft für KI spezialisiert sie sich darauf, effiziente Arbeitsabläufe zu entwickeln, die KI-Tools in alltägliche Aufgaben integrieren und so Produktivität und Kreativität steigern.

Optimieren Sie Entwicklung, Testing und Deployment Ihres MCP-Servers mit der intelligenten Automatisierungsplattform von FlowHunt.

Entdecken Sie umfassende Beispiele für MCP-Server und erfahren Sie, wie Sie Model Context Protocol Server aufbauen, bereitstellen und integrieren, um die Fähigk...

Erfahren Sie, was MCP (Model Context Protocol) Server sind, wie sie funktionieren und warum sie die AI-Integration revolutionieren. Entdecken Sie, wie MCP die V...

Erfahren Sie, wie Sie einen Model Context Protocol (MCP)-Server erstellen und bereitstellen, um KI-Modelle mit externen Tools und Datenquellen zu verbinden. Sch...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.