Crew.ai vs Langchain: Ein gründlicher Blick auf Multi-Agenten-Frameworks

Entdecken Sie die Multi-Agenten-Frameworks Crew.ai und Langchain. Crew.ai überzeugt durch Zusammenarbeit und Aufgabenverteilung und ist ideal für komplexe Simul...

Erfahren Sie, wie Sie mit Strands, dem Open-Source-Framework von AWS, produktionsreife Multi-Agenten-KI-Systeme entwickeln. Entdecken Sie, wie spezialisierte Agenten zusammenarbeiten, um Business-Intelligence-Berichte zu erstellen und komplexe Workflows zu automatisieren.

Die Landschaft der künstlichen Intelligenz hat sich grundlegend gewandelt – mit dem Aufkommen fortschrittlicher Multi-Agenten-Systeme, die zusammenarbeiten, um komplexe Geschäftsprobleme zu lösen. Statt sich auf ein einziges, monolithisches KI-Modell zu verlassen, entdecken Unternehmen zunehmend die Stärke spezialisierter Agenten, die im Zusammenspiel jeweils einzigartige Fähigkeiten und Expertise einbringen. Dieser Ansatz markiert einen Paradigmenwechsel im Denken über KI-Automatisierung: weg von einfachen Frage-Antwort-Systemen hin zu koordinierten Teams intelligenter Agenten, die recherchieren, analysieren, zusammenfassen und Lösungen mit bemerkenswerter Raffinesse empfehlen können. In diesem umfassenden Leitfaden zeigen wir, wie Sie mit Strands, dem Open-Source-Framework von Amazon Web Services, produktionsreife Multi-Agenten-Systeme aufbauen – einfach, flexibel und leistungsstark. Ob Sie Business-Intelligence-Berichte automatisieren, operative Workflows optimieren oder intelligente Forschungssysteme schaffen möchten: Das Verständnis, wie man mehrere spezialisierte Agenten orchestriert, wird für moderne Entwicklungsteams zur Schlüsselkompetenz.

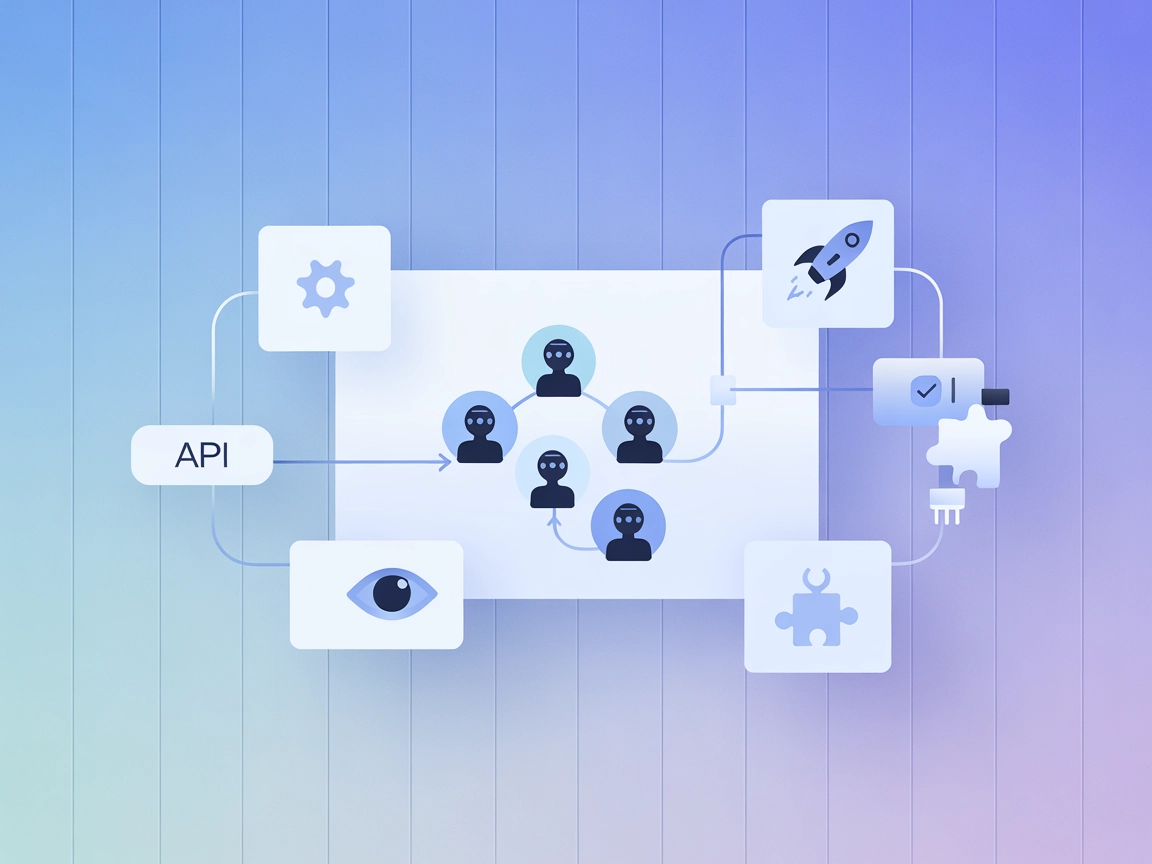

Multi-Agenten-KI-Systeme stellen einen grundlegenden Bruch mit klassischen Single-Model-Ansätzen dar. Statt von einem KI-Modell zu verlangen, jeden Aspekt einer komplexen Aufgabe zu übernehmen, zerlegen Multi-Agenten-Systeme Probleme in spezialisierte Teilgebiete – jeder Agent wird Experte in seinem Bereich. Diese Architektur spiegelt die Arbeitsweise menschlicher Teams in Organisationen wider: Ein Marketing-Team, ein Forschungsteam, ein Finanzteam und ein Operationsteam bringen jeweils spezielles Wissen und Tools ein, um verschiedene Aspekte einer größeren Herausforderung zu lösen. Im Kontext der KI bedeutet das: Ein Agent könnte auf das Sammeln und Verarbeiten von Echtzeit-Informationen aus Nachrichtenquellen spezialisiert sein, ein anderer auf Sentimentanalyse und Social-Media-Trends, ein dritter auf Wettbewerbsrecherche und Marktanalyse, und ein weiterer auf das Zusammenführen aller Informationen in strategische Empfehlungen. Die Stärke dieses Ansatzes liegt darin, Komplexität durch Spezialisierung zu bewältigen, Genauigkeit durch verschiedene Perspektiven zu verbessern, Aufgaben parallel zu verarbeiten und wartbare, skalierbare Systeme zu schaffen. Richtig umgesetzt, erledigen Multi-Agenten-Systeme in Minuten, wofür menschliche Teams Stunden oder Tage bräuchten – und bewahren dabei jene Nuancen und Kontexte, die Business Intelligence wirklich wertvoll machen.

Der Weg zu modernen Agenten-Frameworks wie Strands spiegelt die enormen Fortschritte großer Sprachmodelle in den letzten Jahren wider. In den Anfangstagen der KI-Agenten, etwa um 2023 mit Veröffentlichung des ReAct-Papers (Reasoning and Acting), mussten Entwickler extrem komplexe Orchestrierungen bauen, damit Sprachmodelle Tools zuverlässig nutzen und logisch denken konnten. Die Modelle selbst waren nicht als Agenten trainiert – sie waren primär für natürliche Sprachinteraktion konzipiert. Entwickler mussten daher ausführliche Prompt-Anweisungen verfassen, eigene Parser zum Extrahieren von Tool-Calls aus Modell-Ausgaben bauen und aufwändige Orchestrierungslogik implementieren, um grundlegende Agenten-Funktionalität zu erhalten. Selbst das zuverlässige Produzieren von syntaktisch korrektem JSON oder das Einhalten vorgegebener Formate war eine Herausforderung. Teams investierten Monate ins Feintuning ihrer Agenten – und jede Modelländerung brachte umfangreiche Überarbeitungen mit sich. Doch die Landschaft hat sich grundlegend gewandelt: Moderne Sprachmodelle wie Claude, GPT-4 und andere haben native Tool-Nutzung und logisches Denken direkt ins Training integriert. Sie wissen, wie man Funktionen aufruft, welche Tools wann zu nutzen sind und wie man komplexe Aufgaben mit minimaler Anleitung löst. Dadurch wurden die zuvor notwendigen, komplexen Orchestrierungs-Frameworks überflüssig. Strands wurde mit dieser Erkenntnis im Kern entwickelt: Warum komplexe Workflows bauen, wenn moderne Modelle Planung und Logik selbst übernehmen? Dieser Wandel von komplexer Orchestrierung hin zu modellgetriebener Einfachheit macht Strands so leistungsfähig und zu einem Vertreter der Zukunft der Agentenentwicklung.

Strands Agents ist ein Open-Source-SDK von AWS, das einen grundlegend anderen Ansatz beim Bau von KI-Agenten verfolgt. Entwickler müssen keine komplexen Workflows, Zustandsmaschinen oder Orchestrierungslogik mehr definieren – Strands nutzt die Fähigkeiten moderner Sprachmodelle für autonome Planung, logisches Denken und Tool-Auswahl. Die Grundidee ist einfach und zugleich mächtig: Ein Agent ist die Kombination aus drei Komponenten – Modell, Tools und Prompt. Das war’s. Sie wählen das gewünschte Modell (etwa Claude, GPT-4, Llama oder ein anderes), geben an, auf welche Tools der Agent Zugriff hat (eingebaute Tools, eigene Python-Funktionen oder MCP-Server) und formulieren einen klaren Prompt, was der Agent tun soll. Das Modell nutzt dann seine logischen Fähigkeiten für alles Weitere. Besonders revolutionär ist die vollständige Modell- und Anbieterunabhängigkeit von Strands: Sie sind nicht an AWS Bedrock gebunden – können OpenAI-Modelle, Anthropic’s Claude via API, Llama-Modelle von Meta, lokale Modelle via Ollama oder nahezu jeden LLM-Anbieter über LiteLLM verwenden. Diese Flexibilität erlaubt rasche Entwicklung mit lokalen Modellen, den Wechsel zu leistungsstärkeren Modellen für die Produktion oder auch einen kompletten Anbieterwechsel ohne Änderung des Agenten-Codes. Das Framework lässt sich zudem nahtlos mit anderen Agenten-Frameworks wie CrewAI und LangGraph integrieren und unterstützt nativ Model Context Protocol (MCP)-Server, sodass Sie auf ein Ökosystem vorgefertigter Tools und Integrationen zugreifen können. Außerdem bietet Strands integrierte Unterstützung für Gesprächsspeicher und Sitzungsmanagement und ist somit für einfache wie komplexe, mehrstufige Interaktionen geeignet.

Der Einstieg in Strands ist bemerkenswert unkompliziert – eine der größten Stärken des Frameworks. Die Einrichtung erfordert nur wenige Schritte, die jeder Python-Entwickler in Minuten erledigen kann. Zunächst legen Sie ein neues Projektverzeichnis an und richten Ihre Python-Umgebung ein. Erstellen Sie eine requirements.txt-Datei und tragen Sie die benötigten Abhängigkeiten ein – mindestens strands und strands-agents, je nach gewünschten Tools eventuell weitere Pakete. Legen Sie anschließend eine .env-Datei an, in der Sie Ihre Umgebungsvariablen speichern – vor allem die Zugangsdaten Ihres LLM-Anbieters. Für AWS Bedrock müssen Sie IAM-Berechtigungen in Ihrem AWS-Konto einrichten. Gehen Sie zur IAM-Konsole, wählen Sie Ihren Benutzer, fügen Sie die Bedrock-Policy hinzu, generieren Sie Zugriffsschlüssel für den programmgesteuerten Zugriff und speichern Sie diese als AWS_ACCESS_KEY_ID und AWS_SECRET_ACCESS_KEY sicher in Ihrer .env-Datei. Nutzen Sie einen anderen Anbieter wie OpenAI, hinterlegen Sie dort Ihren API-Key. Dann erstellen Sie Ihre Haupt-Python-Datei, beispielsweise strands_demo.py. Hier importieren Sie die nötigen Komponenten aus Strands, instanziieren einen Agenten mit gewünschtem Modell und Tools und geben ihm eine Aufgabe. Das Beeindruckende: Dieser gesamte Ablauf – von der Projekterstellung bis zum Start Ihres ersten Agenten – gelingt in unter fünf Minuten. Das Framework übernimmt die Verwaltung der Agentenschleife, das Parsen von Modell-Ausgaben, das Aufrufen von Tools und das Management des Kontexts. Sie definieren lediglich, was Sie wollen – und das Modell übernimmt die Logik.

Um Strands praktisch kennenzulernen, betrachten wir das einfachste Beispiel – einen Agenten mit einem Taschenrechner-Tool. Dieses Beispiel verdeutlicht die zentralen Konzepte, die Sie auch in komplexeren Systemen nutzen. Sie importieren die Agent-Klasse aus der Strands-Bibliothek und das Taschenrechner-Tool. Dann erstellen Sie ein Agent-Objekt, übergeben ihm das Tool, formulieren einen Prompt („Berechne die Quadratwurzel von 1764“), weisen das Ergebnis einer Variablen zu und geben es aus. Das sind vier Codezeilen. Beim Ausführen erhält der Agent Ihren Prompt, erkennt, dass er das Taschenrechner-Tool nutzen muss, ruft es mit dem passenden Input auf, erhält das Ergebnis (42) und gibt es zurück. Hinter den Kulissen läuft Erstaunliches ab: Das Modell analysiert Ihre natürliche Sprache, entscheidet, welches Tool angemessen ist, formatiert den Tool-Aufruf korrekt, führt ihn aus und fasst das Ergebnis wieder in natürlicher Sprache zusammen. Für Sie als Entwickler sind es aber nur vier Zeilen Code. Genau diese Einfachheit prägt das Design von Strands: Das Framework übernimmt Orchestrierung, Parsing und Management – Sie konzentrieren sich darauf, WAS Ihre Agenten tun sollen, nicht WIE.

Neben eingebauten Tools wie dem Taschenrechner entfaltet Strands seine volle Kraft, wenn Sie eigene, auf Ihre Anforderungen zugeschnittene Tools erstellen. Das geht denkbar einfach: Schreiben Sie eine Python-Funktion, versehen Sie sie mit dem @tool-Decorator und einem Docstring, der beschreibt, was die Funktion macht. Der Docstring ist entscheidend – er ist die Informationsquelle für den Agenten, um das Tool zu verstehen und gezielt einzusetzen. Möchten Sie z. B. ein Tool zum Addieren zweier Zahlen erstellen, schreiben Sie eine Funktion add_numbers mit dem Docstring „Addiere zwei Zahlen“, implementieren die Logik – und der Agent wird dieses Tool automatisch nutzen, wenn er eine Addition benötigt. Sie können Tools für alles entwickeln, was Sie in Python abbilden können: Daten von APIs abrufen, Datenbanken abfragen, Dateien verarbeiten, externe Services ansprechen oder komplexe Berechnungen durchführen. Der @tool-Decorator übernimmt die Registrierung und Integration ins Agenten-Framework. Auch MCP-Server können als Tools genutzt werden, was Ihnen ein Ökosystem an vorgefertigten Integrationen eröffnet. Strands bringt bereits eine Sammlung eingebauter Tools mit – von Memory-Management über Dateioperationen bis zu AWS-Services. Die Kombination aus eigenen Tools und vorgefertigten Integrationen ermöglicht Ihnen, schnell leistungsstarke Agentenfähigkeiten zusammenzustellen, ohne das Rad neu zu erfinden.

Die wahre Stärke von Strands entfaltet sich, wenn Sie über Einzelagenten hinausgehen und Teams spezialisierter Agenten bilden, die zusammenarbeiten. Damit lassen sich hochentwickelte Systeme bauen, die komplexe Geschäftsprobleme lösen. Das Vorgehen ist einfach: Sie erstellen mehrere Agenten, jeder mit eigener Rolle, eigenen Tools und eigener Expertise. Ein Agent könnte auf das Sammeln von Nachrichten spezialisiert sein, ein anderer auf Sentimentanalyse von Social Media, ein dritter auf Wettbewerbsrecherche und ein vierter auf das Synthese aller Informationen in strategische Empfehlungen. Jeder Agent hat Zugriff auf für seine Rolle passende Tools: Der Nachrichten-Agent auf Scraping- und Parsing-Tools, der Sentiment-Agent auf Textverarbeitungstools für Emotionsanalysen, der Research-Agent auf Datenbank-Query-Tools und der Synthese-Agent auf Tools zum Formatieren und Strukturieren der Berichte. Die Orchestrierung erfolgt, indem Aufgaben zwischen den Agenten weitergegeben werden – jeder bringt seine Spezialkompetenz ein. Das Schöne: Dieses Muster entspricht menschlichen Teams – niemand übernimmt alles, sondern Spezialisten bringen ihre Ergebnisse zusammen. Mit Strands lässt sich dieses Muster im Code abbilden – für intelligentere, wartbarere und skalierbarere Systeme als klassische monolithische Einzelagenten.

Um die Leistungsfähigkeit von Multi-Agenten-Systemen praktisch zu zeigen, betrachten wir ein Beispiel: den Bau eines automatisierten Business-Intelligence-Systems, das umfassende Berichte zu beliebigen Themen generiert. Hier arbeiten mehrere spezialisierte Agenten zusammen, um anspruchsvolle Analysen zu erstellen. Das System umfasst einen Content-Agenten, der aktuelle Nachrichten von Quellen wie TechCrunch sammelt, relevante Artikel extrahiert und Kernaussagen zusammenfasst. Ein Social-Media-Analyst simuliert die Analyse von Online-Konversationen, identifiziert Stimmungstrends und Diskussionsthemen. Ein Research-Agent sammelt Hintergrundinformationen, recherchiert wichtige Akteure und erstellt Zeitachsen. Ein Strategie-Experte analysiert Marktdynamiken, Wettbewerb und Chancen. Ein Sentiment-Analyst bewertet die emotionale Tonalität verschiedener Quellen und liefert psychologische Einblicke. Ein Recommendations-Agent erstellt umsetzbare strategische Ratschläge mit konkreten Schritten. Schließlich fasst ein Executive-Synthesizer alle Erkenntnisse der anderen Agenten zu einem präsentationsreifen Bericht zusammen. Jeder Agent hat eine klar definierte Rolle, passende Tools und präzise Anweisungen. Stellen Sie dem System eine Frage wie „Was passiert aktuell bei OpenAI?“, beginnt die Kette: Der Content-Agent holt aktuelle Artikel, der Research-Agent liefert Hintergrundinfos, der Sentiment-Agent analysiert die Tonalität, der Strategie-Agent bewertet die Marktauswirkungen, der Synthese-Agent bringt alles zusammen. Binnen Minuten entsteht eine Analyse, für die ein menschliches Team Stunden bräuchte. Das ist die Stärke gut orchestrierter Multi-Agenten-Systeme.

Erleben Sie, wie FlowHunt Ihre KI-Content- und SEO-Workflows automatisiert – von Recherche und Content-Erstellung bis Publishing und Analytics – alles an einem Ort.

Ein besonders praxisnaher Aspekt beim Aufbau von Multi-Agenten-Systemen ist das Erstellen eigener Tools, die Ihre Agenten mit realen Datenquellen verbinden. Ein Beispiel: Sie entwickeln ein Tool, das KI-News-Überschriften von TechCrunch abruft – genutzt durch den Content-Agenten Ihres Business-Intelligence-Systems. Das Tool beginnt mit einem klaren Docstring, der exakt beschreibt, was es tut: „Rufe KI-News-Überschriften von TechCrunch ab.“ Diese Beschreibung ist essenziell, denn der Agent nutzt sie, um das Tool zu verstehen und gezielt einzusetzen. Das Tool definiert seine Argumente – etwa eine Suchanfrage oder ein Topic – und gibt an, was es zurückliefert: eine durch Pipes getrennte Zeichenkette mit Überschriften. Die Implementierung umfasst das Definieren der zu scrapenden URL, das Setzen von HTTP-Headern, das Ausführen der Anfrage, die Prüfung des Response-Codes, das Parsen des HTML zur Extraktion der Überschriften und das Rückgeben im gewünschten Format. Fehlerbehandlung ist hier besonders wichtig: Netzwerkfehler, Parsing-Probleme oder andere Störungen müssen elegant abgefangen werden. Logging hilft bei der Fehlersuche und Einsicht, was beim Tool-Einsatz passiert. Ist das Tool mit @tool dekoriert, kann der Agent es jederzeit nutzen, um Nachrichteninformationen zu sammeln – ohne wissen zu müssen, wie Webscraping oder HTML-Parsing funktioniert. Diese Trennung macht das System wartbar und erlaubt das Aktualisieren von Datenquellen ohne Änderung der Agentenlogik.

Eine der größten Stärken von Strands ist die Flexibilität bei der Modellauswahl und Anbieter-Konfiguration. Sie sind an keinen bestimmten Anbieter gebunden und können das für Ihren Anwendungsfall und Ihr Budget passendste Modell wählen. Standardmäßig sucht Strands nach AWS-Zugangsdaten und nutzt Amazon Bedrock, das Zugriff auf mehrere Modelle wie Claude, Llama u.a. bietet. Möchten Sie lieber OpenAI-Modelle nutzen, ist der Wechsel einfach: Sie importieren die OpenAI-Modellklasse aus Strands, instanziieren sie mit dem gewünschten Modell-ID (wie „gpt-3.5-turbo“ oder „gpt-4“) und übergeben sie Ihrem Agenten. Der Agenten-Code bleibt identisch – Sie ändern nur die Modell-Konfiguration. Diese Flexibilität gilt auch für andere Anbieter: Sie können Anthropic’s Claude direkt via API nutzen, Llama über Llama API, lokale Modelle über Ollama für Entwicklung und Tests oder nahezu jeden anderen Anbieter via LiteLLM. Sie können also mit einem schnellen, günstigen lokalen Modell entwickeln und für die Produktion nahtlos zu einem leistungsstärkeren Modell wechseln – ohne Codeänderung. Ebenso können Sie verschiedene Modelle ausprobieren, um das beste für Ihren Anwendungsfall zu finden: Manche sind besser im logischen Denken, andere befolgen Anweisungen präziser oder sind in spezifischen Domänen stark. Das einfache Austauschen von Modellen ohne Code-Refactoring ist ein bedeutender Vorteil von Strands gegenüber starren Frameworks.

Mit zunehmender Komplexität Ihrer Multi-Agenten-Systeme werden fortgeschrittene Muster wie Agent-zu-Agent-Kommunikation und Aufgabenübergaben wichtig. Dadurch können Agenten Aufgaben an andere Agenten delegieren und so hierarchische oder vernetzte Systeme schaffen. Im Übergabe-Muster erkennt ein Agent, dass eine Aufgabe außerhalb seiner Expertise liegt, und reicht sie an einen anderen, besser geeigneten Agenten weiter. Beispiel: Im Business-Intelligence-System sammelt der Content-Agent Rohartikel, gibt sie zur Sentimentanalyse an den Sentiment-Agenten weiter, dieser analysiert und gibt seine Bewertung zurück, die dann im Bericht des Content-Agenten aufgegriffen wird. Dieses Muster entspricht menschlichen Teams – niemand übernimmt alles, sondern reicht Aufgaben an Spezialisten weiter. Strands unterstützt solche Muster durch die Agent-as-Tool-Fähigkeit: Ein Agent kann als Tool eines anderen Agenten genutzt werden – so entstehen mächtige Hierarchien, in denen übergeordnete Agenten ihre Spezialisten koordinieren. Auch Schwarmmuster, bei denen mehrere Agenten parallel an Teilaufgaben arbeiten und die Ergebnisse zusammengeführt werden, sind möglich. Diese fortgeschrittenen Muster erlauben Systeme beliebiger Komplexität – vom einfachen Zwei-Agenten-Übergabe bis zum Netzwerk mit Dutzenden Spezialisten, die gemeinsam ein Ziel verfolgen.

Die Integration von Strands mit AWS-Services ist besonders für Unternehmen im AWS-Ökosystem stark. Sie können Tools bauen, die mit AWS-Services wie S3 (Dateispeicherung), DynamoDB (Datenbank), Lambda (Serverless Computing) u.v.m. interagieren. So können Ihre Agenten nicht nur Informationen sammeln und analysieren, sondern auch direkt in Ihrer AWS-Infrastruktur handeln: z. B. Berichte generieren und automatisch in S3 ablegen oder Daten aus DynamoDB abfragen und für Analysen nutzen. Auch die Anbindung an externe APIs ist durch eigene Tools möglich: Sie können REST-APIs ansprechen, Webhooks nutzen, Drittanbieter-Services integrieren oder beliebige externe Systeme Ihres Unternehmens anbinden. So wird Strands zur zentralen Steuerzentrale Ihrer Automatisierungsinfrastruktur und koordiniert Aktivitäten über Ihren gesamten Tech-Stack hinweg. Die Kombination aus AWS-Integration und Unterstützung externer APIs macht Strands zur idealen Plattform für den Bau von Enterprise-Systemen, die mit komplexen, heterogenen Technologielandschaften interagieren.

Auch wenn Strands die Entwicklung einfach macht, erfordert der produktive Einsatz von Agenten sorgfältige Überlegungen. Zuerst: Wo sollen Ihre Agenten laufen? Strands läuft überall, wo Python läuft – lokal zur Entwicklung, auf EC2-Instanzen, in Lambda-Functions (serverless), auf EKS (Kubernetes) oder jeder beliebigen Compute-Plattform. Jede Option hat eigene Anforderungen an Skalierung, Kosten und Management. Außerdem: Wie werden Ihre Agenten ausgelöst? Nach Zeitplan? Durch API-Aufrufe? Als Reaktion auf Events? Strands lässt sich mit unterschiedlichen Triggern integrieren – die Gestaltung hängt vom Use Case ab. Sicherheit ist ein weiterer kritischer Punkt: Ihre Agenten benötigen Zugang zu Anmeldedaten, API-Keys und potenziell sensiblen Daten. Verwenden Sie Umgebungsvariablen oder AWS Secrets Manager und vermeiden Sie Hardcoding. Logging und Monitoring sind wichtig, um das Verhalten Ihrer Agenten zu verstehen und Fehler schnell zu identifizieren. Fehlerbehandlung ist in der Produktion unerlässlich – Agenten sollten Fehler elegant abfangen, Wiederholungen einbauen und Sie bei Problemen benachrichtigen. Schließlich sollten Sie Rate-Limiting und Kostenkontrollen einführen, um unerwartete Ausgaben durch API-Aufrufe oder Modellinferenz zu vermeiden.

Obwohl Strands leistungsstark und elegant ist, lohnt der Vergleich mit anderen populären Frameworks wie CrewAI und LangGraph. CrewAI setzt auf teamorientierte Agenten-Orchestrierung mit rollen- und hierarchiebasierter Strukturierung. Das bietet mehr Struktur für komplexe Systeme, kann aber auch die Komplexität erhöhen. LangGraph, aufbauend auf LangChain, nutzt einen graphenbasierten Ansatz und erlaubt das explizite Definieren von Zustandsmaschinen und Workflows – das gibt mehr Kontrolle über das Agentenverhalten, erfordert aber mehr Designarbeit. Strands verfolgt einen anderen Weg: Es vertraut dem Modell für Logik und Planung und verlangt weniger explizite Workflow-Definition. Das macht die Entwicklung schneller, ist aber eventuell weniger geeignet für Systeme, die sehr deterministisches Verhalten brauchen. Die gute Nachricht: Die Frameworks schließen sich nicht aus – Strands kann mit CrewAI und LangGraph kombiniert werden, sodass Sie für jede Systemkomponente das beste Tool wählen. Für schnelle Entwicklung und modellgetriebene Systeme ist Strands führend. Für explizite Workflow-Kontrolle kann LangGraph besser passen, für teambasierte Strukturen mit klaren Hierarchien CrewAI. Das Verständnis der Stärken und Grenzen hilft Ihnen, die richtige Architektur für Ihren Einsatzzweck zu wählen.

Effektive Multi-Agenten-Systeme entstehen nicht allein durch das technische Framework – sondern durch durchdachtes Systemdesign. Definieren Sie zunächst die Rolle und Expertise jedes Agenten klar: Wofür ist dieser Agent verantwortlich? Welche Tools braucht er? Welchen Fokus soll er haben? Klare Rollendefinition macht Agenten effektiver und leichter zu debuggen. Zweitens: Formulieren Sie klare, präzise Prompts. Der Prompt ist Ihre Kommunikation mit dem Agenten – investieren Sie Zeit, ihn klar und umfassend zu machen. Beschreiben Sie die Rolle, den Fokus, was vermieden werden soll und das gewünschte Ausgabeformat. Drittens: Geben Sie Agenten die passenden Tools. Mit zu vielen Tools besteht die Gefahr der Verwirrung, mit zu wenigen können Aufgaben nicht erfüllt werden. Überlegen Sie genau, was wirklich gebraucht wird. Viertens: Testen Sie Agenten einzeln, bevor Sie sie ins System integrieren. Erst wenn jeder Agent isoliert funktioniert, sollten Sie die Koordination starten. Fünftens: Implementieren Sie Fehlerbehandlung und Logging. Bei Problemen müssen Sie die Ursache schnell finden können. Sechstens: Starten Sie einfach und steigern Sie die Komplexität schrittweise. Bauen Sie zuerst ein funktionierendes Zwei-Agenten-System, bevor Sie mit zehn Agenten starten. Siebtens: Überwachen Sie Agenten im Produktivbetrieb – tracken Sie Verhalten, Laufzeiten, Fehler und Zielerreichung. Diese Daten sind für Optimierung und Troubleshooting unverzichtbar.

Das Feld der Multi-Agenten-KI entwickelt sich rasant, und Strands steht an der Spitze dieser Entwicklung. Mit der Verbesserung der Sprachmodelle werden Agenten immer fähiger, verlässlicher und autonomer. Wir werden branchenübergreifend mehr Multi-Agenten-Systeme sehen, da Unternehmen die Vorteile spezialisierter, koordinierter Agenten gegenüber monolithischen Einzellösungen erkennen. Die Integration von Agenten in Geschäftsprozesse wird tiefer gehen – Agenten werden nicht nur analysieren, sondern aktiv Entscheidungen treffen und in Business-Systemen handeln. Wir werden ausgefeiltere Kommunikationsmuster zwischen Agenten sehen, mit Verhandlung, Zusammenarbeit und Konkurrenz. Die Zahl der verfügbaren Tools wird mit der Verbreitung von APIs und MCP stark wachsen. Agenten werden aus Erfahrung lernen und ihr Verhalten anpassen. Sie werden ihre Logik erklären können, was sie vertrauenswürdiger und leichter zu debuggen macht. Die Kombination aus besseren Modellen, Frameworks wie Strands und wachsender Verbreitung wird dazu führen, dass Multi-Agenten-Systeme so alltäglich werden wie Webanwendungen heute. Wer jetzt Multi-Agenten-Entwicklung beherrscht, verschafft sich einen entscheidenden Wettbewerbsvorteil für den Mainstream der Zukunft.

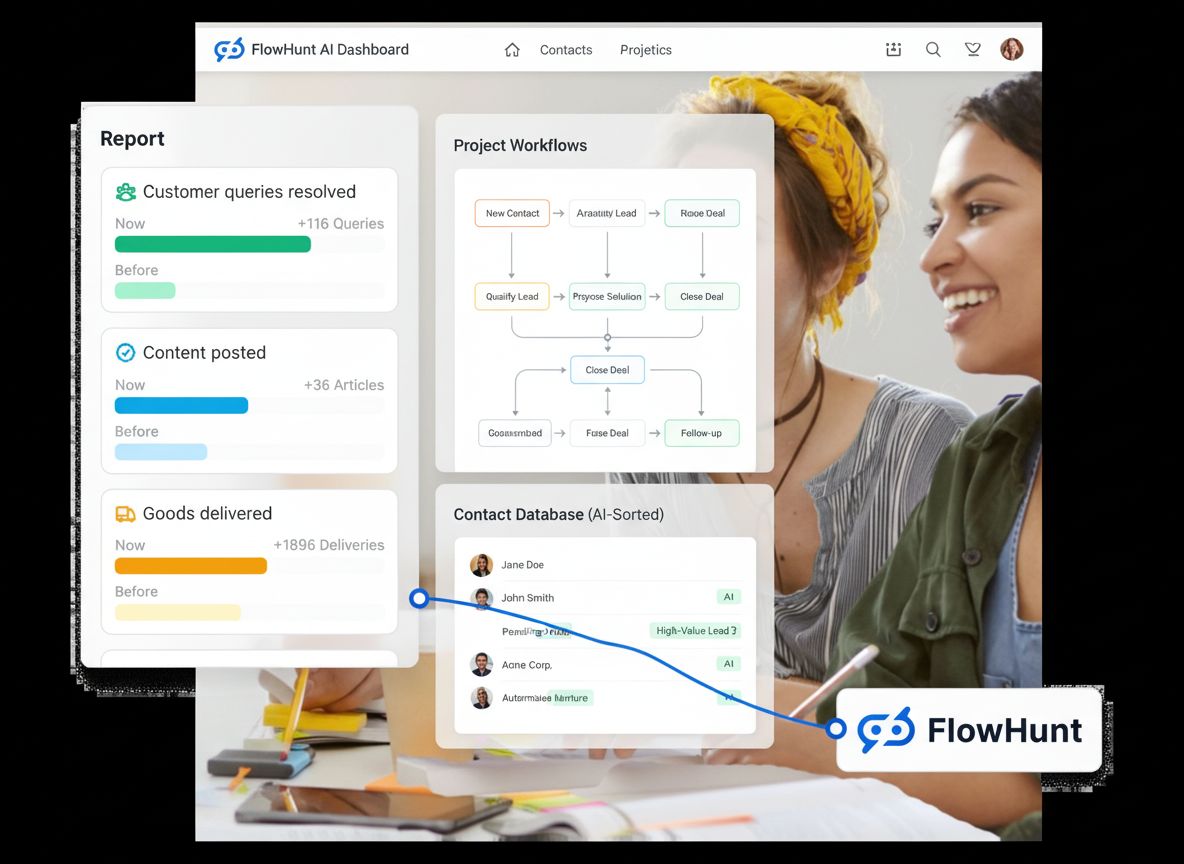

Während Strands das Framework für den Aufbau und Betrieb von Multi-Agenten-Systemen liefert, ergänzt FlowHunt diese Systeme mit Workflow-Automatisierung und Orchestrierung. FlowHunt kann die Planung und Auslösung der Agenten steuern, sodass diese zur richtigen Zeit und bei passenden Events laufen. FlowHunt übernimmt den Datenfluss zwischen Agenten, transformiert Ausgaben eines Agenten zu Eingaben für andere. FlowHunt ermöglicht Transparenz über die Performance der Agenten – etwa durch Metriken zu Laufzeit, Erfolgsrate und Ressourcenverbrauch. Fehlerbehandlung und Wiederholungen werden zentral gesteuert, sodass temporäre Probleme nicht den ganzen Workflow stoppen. FlowHunt kann in bestehende Unternehmenssysteme integriert werden, Agenten durch Business-Events auslösen und deren Ergebnisse zurückspielen. Gemeinsam bilden Strands und FlowHunt ein starkes Duo: Strands liefert die intelligente Logik und Entscheidungsfindung, FlowHunt übernimmt die Orchestrierung, Planung und Systemintegration. Diese Kombination ermöglicht den Aufbau intelligenter End-to-End-Automatisierungssysteme, die leistungsfähig und zugleich wartbar sind.

Multi-Agenten-KI-Systeme markieren einen grundlegenden Wandel in der Automatisierung und Intelligenz von Unternehmen. Statt monolithischer Modelle, die alles übernehmen, bauen wir jetzt Teams spezialisierter Agenten, die komplexe Aufgaben gemeinsam und effizient lösen. Strands, das Open-Source-Framework von AWS, macht diese Systeme für jeden Entwickler zugänglich und bietet zugleich die Flexibilität und Leistung, die produktive Systeme erfordern. Der modellunabhängige Ansatz, die einfache API und die Unterstützung für eigene Tools und Integrationen machen Strands zur ausgezeichneten Wahl für Unternehmen, die das Potenzial von Multi-Agenten-Systemen nutzen wollen. Ob für Business Intelligence, automatisierte Workflows oder intelligente Rechercheassistenten – die in diesem Leitfaden beschriebenen Muster und Techniken bilden eine belastbare Grundlage. Starten Sie mit einfachen Agenten und wachsen Sie schrittweise zu komplexeren Multi-Agenten-Systemen. Investieren Sie in klare Rollendefinition und effektive Prompts. Testen Sie gründlich vor der Produktion. Überwachen und optimieren Sie auf Basis realer Daten. Mit wachsender Erfahrung werden Sie neue Anwendungsmöglichkeiten entdecken, die Ihr Unternehmen transformieren können. Die Zukunft der KI liegt nicht in immer größeren Einzelmodellen – sondern in intelligenten, spezialisierten Teams von Agenten, die gemeinsam erreichen, was kein Einzelagent allein könnte.

Strands ist ein quelloffenes, modellunabhängiges SDK für KI-Agenten, das von AWS entwickelt wurde. Es vereinfacht die Agenten-Entwicklung, indem es moderne LLM-Fähigkeiten für logisches Denken und Tool-Nutzung nutzt. Im Gegensatz zu komplexen Orchestrierungs-Frameworks verfolgt Strands einen modellgetriebenen Ansatz, bei dem Agenten mit nur drei Komponenten definiert werden: einem Modell, Tools und einem Prompt. Es unterstützt jeden LLM-Anbieter, darunter Amazon Bedrock, OpenAI, Anthropic und lokale Modelle, und lässt sich nahtlos mit anderen Frameworks wie CrewAI und LangGraph integrieren.

Um mit Strands zu starten, legen Sie eine requirements.txt-Datei mit den erforderlichen Abhängigkeiten an, richten eine .env-Datei mit Ihren AWS-Anmeldedaten (oder anderen LLM-Anbieter-Anmeldedaten) ein und erstellen Ihre Haupt-Python-Datei. Sie müssen IAM-Berechtigungen für Bedrock in Ihrem AWS-Konto konfigurieren, Zugriffsschlüssel generieren und dann können Sie einen Agenten mit Modell, Tools und Prompt in nur wenigen Codezeilen instanziieren.

Ja, Strands ist vollständig modellunabhängig. Sie können Modelle von Amazon Bedrock, OpenAI, Anthropic, Metas Llama über die Llama API, Ollama für lokale Entwicklung und viele andere Anbieter über LiteLLM nutzen. Sie können zwischen den Anbietern wechseln, ohne Ihren Agenten-Code ändern zu müssen, was es flexibel für verschiedene Anwendungsfälle und Vorlieben macht.

Multi-Agenten-Systeme ermöglichen es Ihnen, komplexe Aufgaben in spezialisierte Rollen mit jeweils eigener Expertise und eigenen Tools zu unterteilen. Dieser Ansatz ermöglicht parallele Verarbeitung, besseres Fehlermanagement, verbesserte Genauigkeit durch verschiedene Blickwinkel und wartbareren Code. Für Business Intelligence können spezialisierte Agenten gleichzeitig Nachrichten sammeln, Stimmungen analysieren, Wettbewerber recherchieren und Erkenntnisse zu umsetzbaren Berichten zusammenfassen.

FlowHunt bietet Workflow-Automatisierungsfunktionen, die Multi-Agenten-Systeme ergänzen, indem komplexe Prozesse orchestriert, der Datenfluss zwischen Agenten verwaltet, Planung und Überwachung übernommen und Transparenz in die Agentenleistung gebracht wird. Gemeinsam ermöglichen FlowHunt und Multi-Agenten-Frameworks wie Strands End-to-End-Intelligenzautomatisierungssysteme, die anspruchsvolle Geschäftsprozesse bewältigen können.

Arshia ist eine AI Workflow Engineerin bei FlowHunt. Mit einem Hintergrund in Informatik und einer Leidenschaft für KI spezialisiert sie sich darauf, effiziente Arbeitsabläufe zu entwickeln, die KI-Tools in alltägliche Aufgaben integrieren und so Produktivität und Kreativität steigern.

Kombinieren Sie die Leistungsfähigkeit von Multi-Agenten-KI-Systemen mit der Workflow-Automatisierung von FlowHunt, um intelligente, selbstkoordinierende Geschäftsprozesse zu schaffen, die skalierbare Einblicke generieren.

Entdecken Sie die Multi-Agenten-Frameworks Crew.ai und Langchain. Crew.ai überzeugt durch Zusammenarbeit und Aufgabenverteilung und ist ideal für komplexe Simul...

Integrieren Sie FlowHunt mit dem PAIML MCP Agent Toolkit, um fortschrittliche Multi-Agenten-Orchestrierung, zentrales Management und dynamische Aufgabenkoordina...

Erfahren Sie, wie Sie KI-Agenten erstellen, die Ihre gesamten Bexio-Geschäftsprozesse verwalten – von Kontaktmanagement bis Projektautomatisierung – und mit Flo...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.