Einführung

Kontext-Engineering hat sich als eine der wichtigsten Disziplinen beim Aufbau leistungsfähiger KI-Agenten herauskristallisiert. Da Sprachmodelle immer leistungsfähiger werden und Agenten zunehmend komplexe, mehrstufige Aufgaben übernehmen, besteht die Herausforderung nicht mehr nur darin, ein fähiges Modell zu haben – sondern darin, strategisch zu steuern, welche Informationen dem Modell bereitgestellt werden. Jeder Token zählt. In diesem umfassenden Leitfaden erfahren Sie, was Kontext-Engineering ist, warum es für die Leistung von KI-Agenten unerlässlich ist und welche speziellen Techniken führende KI-Forschungsorganisationen und Plattformen nutzen, um optimale Agenten zu bauen. Ganz gleich, ob Sie Kundendienst-Bots, Datenanalyse-Agenten oder autonome Workflows entwickeln – mit dem richtigen Verständnis von Kontext-Engineering verbessern Sie grundlegend die Performance Ihrer KI-Systeme.

Was ist Kontext-Engineering?

Kontext-Engineering steht für einen grundlegenden Wandel in der Herangehensweise an den Umgang mit großen Sprachmodellen. Anstatt das LLM als Blackbox zu betrachten, die nur gute Anweisungen benötigt, behandelt Kontext-Engineering das Modell als ein System mit begrenzten kognitiven Ressourcen, die sorgfältig verwaltet werden müssen. Im Kern ist Kontext-Engineering die Praxis, ganz genau zu wissen, welchen Kontext man einem KI-Agenten bereitstellt – und dabei jeden einzelnen Token, der bei jedem LLM-Aufruf durchläuft, gezielt zu betrachten, um optimale Bedingungen für den Erfolg des Agenten zu schaffen.

Dieses Konzept wurde von Forschern wie Andrej Karpathy popularisiert und ist mit der Entwicklung von KI-Agenten, die von einfachen Chatbots zu hochentwickelten Systemen mit autonomen Entscheidungsfähigkeiten wurden, immer wichtiger geworden. Die zentrale Erkenntnis: LLMs haben – ähnlich wie Menschen – ein begrenztes Arbeitsgedächtnis und eine begrenzte Aufmerksamkeitsspanne. So wie ein Mensch sich nur auf eine bestimmte Menge an Informationen gleichzeitig konzentrieren kann, bevor er den Überblick verliert, verschlechtern sich die Schlussfolgerungsfähigkeiten von Sprachmodellen, wenn sie mit zu viel Kontext konfrontiert werden. Die Qualität des Kontexts ist also wesentlich wichtiger als die Quantität.

Kontext-Engineering geht über klassisches Prompt-Engineering hinaus, das sich hauptsächlich auf das perfekte Prompting oder Systemanweisungen konzentrierte. Stattdessen umfasst es das gesamte Ökosystem an Informationen, das einem Agenten über mehrere Interaktionsrunden hinweg zur Verfügung steht – einschließlich Systemprompts, Tool-Definitionen, Beispielen, Nachrichtenhistorie, abgerufenen Daten und dynamisch geladenen Informationen. Ziel ist es, ein schlankes, signalstarkes Kontextfenster zu erhalten, das dem Agenten genau das liefert, was er für gute Entscheidungen braucht, ohne ihn mit irrelevanten Informationen zu überfrachten.

Bereit, Ihr Geschäft zu erweitern?

Starten Sie heute Ihre kostenlose Testversion und sehen Sie innerhalb weniger Tage Ergebnisse.

Warum Kontext-Engineering für leistungsfähige KI-Agenten entscheidend ist

Die Bedeutung von Kontext-Engineering kann beim Aufbau von produktionsreifen KI-Agenten nicht überschätzt werden. Studien zeigen immer wieder, dass LLMs unter dem sogenannten „Context Rot“ leiden – einer messbaren Leistungsverschlechterung, je größer das Kontextfenster wird. Untersuchungen mit „Needle-in-a-Haystack“-Benchmarks haben gezeigt: Steigt die Anzahl der Tokens im Kontext, sinkt die Fähigkeit des Modells, diese Informationen korrekt zu erinnern und schlüssig zu verarbeiten. Dies ist kein marginaler Effekt, sondern eine grundlegende architektonische Grenze von Transformer-basierten Sprachmodellen.

Die Ursache für diese Verschlechterung liegt in der Architektur der Transformer selbst. In Transformern kann jeder Token auf jeden anderen im Kontext „achten“, was für n Tokens n² paarweise Beziehungen erzeugt. Mit zunehmender Kontextlänge wird der Aufmerksamkeitsmechanismus des Modells immer stärker beansprucht, um diese Beziehungen aufrechtzuerhalten. Außerdem werden Sprachmodelle überwiegend mit kürzeren Sequenzen trainiert, sodass sie für sehr große Kontextfenster weniger Erfahrung und spezialisierte Parameter haben. Daraus entsteht ein Spannungsfeld zwischen Kontextgröße und Schlussfolgerungsfähigkeit – Modelle bleiben bei längeren Kontexten funktionsfähig, zeigen aber bei Informationsabruf und Langzeit-Reasoning reduzierte Präzision im Vergleich zu kürzeren Kontexten.

Neben diesen architektonischen Grenzen gibt es einen ganz praktischen Aspekt: LLMs haben ein „Aufmerksamkeitsbudget“, das mit jedem neuen Token weiter beansprucht wird. Jede Information, die Sie dem Kontext hinzufügen, verbraucht einen Teil dieses Budgets und erhöht die kognitive Last für das Modell. Daher ist durchdachtes Kontext-Engineering unerlässlich. Mit einer sorgfältigen Auswahl der dem Modell bereitgestellten Informationen optimieren Sie nicht nur die Effizienz – Sie verbessern direkt die Qualität der Schlussfolgerungen und Entscheidungen des Agenten. Ein Agent mit einem schlanken, gut organisierten Kontextfenster trifft bessere Entscheidungen, kann sich schneller von Fehlern erholen und bleibt auch bei längeren Interaktionssequenzen konsistent leistungsfähig, während ein Agent mit einem Kontext-Überangebot in irrelevanten Informationen untergeht.

Kontext-Engineering vs. Prompt-Engineering

Obwohl Kontext-Engineering und Prompt-Engineering verwandte Konzepte sind, stehen sie für unterschiedliche Abstraktionsebenen beim Arbeiten mit Sprachmodellen. Prompt-Engineering, das die frühe Ära der LLM-Anwendungen dominierte, konzentriert sich darauf, wie man effektive Prompts und Systemanweisungen schreibt. Das Hauptziel ist, die richtigen Worte und Formulierungen zu finden, um ein gewünschtes Verhalten des Modells bei einer bestimmten Aufgabe hervorzurufen. Dieser Ansatz funktioniert gut für klar abgrenzbare, einmalige Aufgaben wie Klassifikation, Zusammenfassung oder einmalige Textgenerierung.

Kontext-Engineering hingegen ist die natürliche Weiterentwicklung des Prompt-Engineerings für die Ära der mehrstufigen, autonomen Agenten. Während das Prompt-Engineering fragt: „Wie schreibe ich die perfekte Anweisung?“, stellt das Kontext-Engineering die weitergehende Frage: „Welche optimale Konfiguration aller verfügbaren Informationen erzeugt das gewünschte Verhalten?“ Das umfasst nicht nur den Systemprompt, sondern auch die dem Agenten zur Verfügung stehenden Tools, bereitgestellte Beispiele, Nachrichtenhistorie, abgerufene Daten und Metadaten, die dem Agenten helfen, seine Umgebung zu verstehen.

Der Wechsel vom Prompt- zum Kontext-Engineering spiegelt einen grundlegenden Wandel im Bau von KI-Anwendungen wider. Während in der Anfangszeit die meisten Anwendungsfälle außerhalb von Chatbots für Einzelaufgaben optimierte Prompts benötigten, bewegen wir uns heute auf immer leistungsfähigere Agenten zu, die über mehrere Inferenzrunden und längere Zeiträume hinweg arbeiten. Diese Agenten generieren immer mehr Daten, die für zukünftige Entscheidungen relevant sein könnten, und diese Informationen müssen zyklisch verfeinert und kuratiert werden. Kontext-Engineering ist die Disziplin, dieses gesamte, sich entwickelnde Informationsökosystem zu managen und dabei sicherzustellen, dass dem Agenten in jedem Schritt genau die richtigen Informationen zur Verfügung stehen, um gute Entscheidungen zu treffen.

Abonnieren Sie unseren Newsletter

Erhalten Sie die neuesten Tipps, Trends und Angebote kostenlos.

Die vier Kernttechniken des Kontext-Engineerings

Führende KI-Forschungsorganisationen und Plattformen haben vier zentrale Techniken für effektives Kontext-Engineering identifiziert. Jede adressiert einen anderen Aspekt der Herausforderung, begrenzte Kontextfenster zu managen und gleichzeitig die Leistungsfähigkeit des Agenten zu erhalten. Das Verständnis dieser Techniken und ihrer Anwendung ist grundlegend für den Aufbau produktionsreifer KI-Agenten.

Technik 1: Offloading – Zusammenfassung und Referenzmanagement

Offloading ist die Praxis, Informationen zusammenzufassen und vollständige Daten in externen Referenzen zu speichern, sodass der Agent auf Detailinformationen nur bei Bedarf zugreift. Wenn ein KI-Agent beispielsweise einen Tool-Aufruf macht – etwa eine Datenbankabfrage oder den Aufruf einer externen API –, erhält er oft eine sehr umfangreiche Antwort. Statt die gesamte Antwort in das Kontextfenster zu laden, wird beim Offloading der Schlüsselinhalt zusammengefasst und ein Verweis gespeichert, über den der Agent bei Bedarf auf die vollständigen Daten zugreifen kann.

Ein praktisches Beispiel stammt von Manus AI, einer Forschungsorganisation für fortgeschrittene KI-Agenten. Dort wird nach einem Tool-Aufruf dem Agenten nicht die gesamte Antwort in den Kontext gegeben. Stattdessen erhält er eine prägnante Zusammenfassung und die vollständige Antwort wird mit Referenz in einer Datei oder Datenbank abgelegt. Sollte der Agent später mehr Details aus diesem Tool-Aufruf benötigen, kann er über die Referenz auf die Daten zugreifen, ohne zusätzliche Tokens im Hauptkontext zu verbrauchen. Dieses Vorgehen spiegelt das menschliche Arbeiten wider – wir merken uns nicht jedes Detail eines Gesprächs, sondern halten Notizen und Referenzen bereit, auf die wir bei Bedarf zurückgreifen.

Auch Cognition, eine weitere führende KI-Forschungsorganisation, setzt auf diese Methode, jedoch mit eigens entwickelten Zusammenfassungssystemen. Statt auf generische Zusammenfassungen zu setzen, wurde dort eine spezialisierte Logik entwickelt, die die für die jeweilige Aufgabe relevantesten Informationen extrahiert. Das zeigt: Die beste Offloading-Strategie ist oft aufgabenspezifisch. Was eine nützliche Zusammenfassung ist, hängt vom Ziel des Agenten ab. Durch maßgeschneiderte Zusammenfassungen für die jeweilige Domäne und Aufgabe kann ein signalstarker Kontext bei gleichzeitig deutlich reduziertem Tokenverbrauch aufrechterhalten werden.

Technik 2: Reduktion – Komprimierung des Kontexts über die Zeit

Reduktion ist die Technik, den Kontextverlauf zu verdichten und zu komprimieren, um die Gesamtanzahl der Tokens zu reduzieren und dennoch die wesentlichen Informationen zu bewahren. Mit jeder Interaktionsrunde wächst die Konversationshistorie des Agenten. Ohne aktives Management kann diese Historie schnell das gesamte Kontextfenster ausfüllen, sodass kaum Platz für neue Informationen oder Reasoning bleibt. Reduktion begegnet diesem Problem, indem die Konversation regelmäßig in eine kompaktere Form zusammengefasst wird.

Anthropic setzt dies durch eine Methode um, die sie als „Compacting“ der Konversation bezeichnen. Statt die vollständige Nachrichtenhistorie zu behalten, werden regelmäßig Zusammenfassungen oder Komprimierungen des bisherigen Gesprächs erstellt. Dies ist besonders wichtig, denn Studien zeigen, dass ein zu langer Kontext die Reasoning-Fähigkeit von KI-Agenten tatsächlich verschlechtern kann. Zu viel Kontext kann zu sogenanntem „Context Poisoning“ führen – einem Phänomen, bei dem der Reasoning-Prozess des Agenten durch irrelevante Informationen im Kontext entgleist und vom optimalen Pfad abweicht.

Die Reduktions-Technik basiert auf einer grundlegenden Erkenntnis zur Funktionsweise von Sprachmodellen: Sie schließen nicht automatisch besser mit mehr Informationen. Im Gegenteil – ein schlanker, gut organisierter Kontext mit nur den relevantesten Informationen sorgt meist für besseres Reasoning und zuverlässigeres Agentenverhalten. Deshalb arbeiten viele Organisationen gezielt daran, die Kontextgröße über die Zeit zu verkleinern, selbst wenn theoretisch mehr Informationen verfügbar wären. Ein fokussiertes Kontextfenster erhält die Fähigkeit des Agenten, klar zu schlussfolgern und gute Entscheidungen zu treffen.

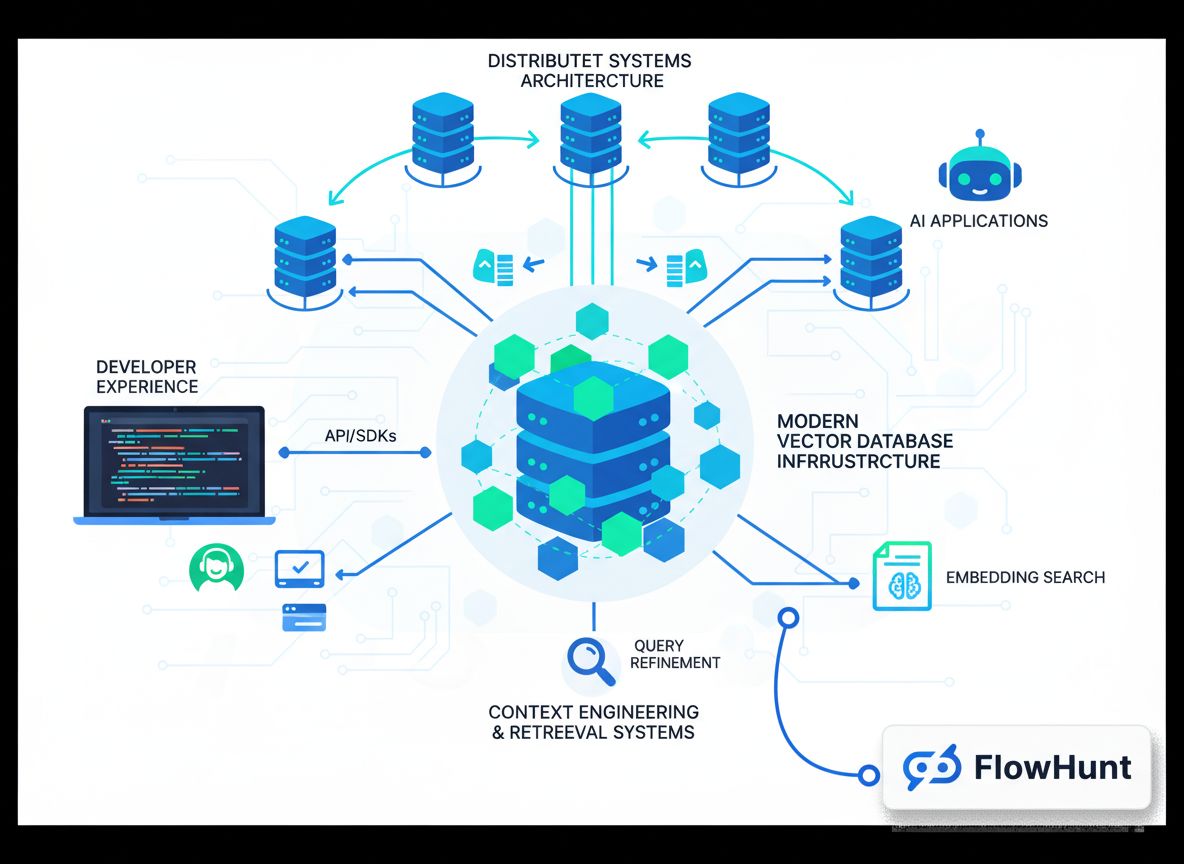

Technik 3: Retrieval (RAG) – Dynamisches Laden des Kontexts

Retrieval-Augmented Generation (RAG) ist eine Technik, bei der relevante Informationen zur Laufzeit dynamisch abgerufen und in den Kontext geladen werden, anstatt sie im Voraus zu laden. Dieser Ansatz gewinnt an Bedeutung, je ausgefeilter Agenten werden. Statt alle potenziell benötigten Informationen vorab zu laden, ermöglichen RAG-Systeme Agenten, gezielt nach Informationen zu suchen und sie bei Bedarf abzurufen.

Der Vorteil dieses Ansatzes ist erheblich: Erstens wird die anfängliche Kontextlast drastisch reduziert – der Agent startet mit einem schlanken Kontextfenster und zieht Informationen nur bei Bedarf hinzu. Zweitens ermöglicht er eine schrittweise Kontexterschließung, bei der der Agent relevante Informationen durch Exploration fortlaufend entdeckt. Jede Interaktion liefert neue Informationen, die die nächste Entscheidung beeinflussen. Ein Agent könnte beispielsweise zunächst nach relevanten Dateien suchen, herausfinden, dass bestimmte Dateien wichtiger sind (z. B. anhand von Namen oder Zeitstempeln), und dann gezielt diese Dateien für eine Detailanalyse abrufen. Dieser gestufte Ansatz zur Kontexterschließung ist weit effizienter als das Laden aller Informationen im Voraus.

Anthropics Claude Code ist ein hervorragendes Beispiel für RAG in der Praxis. Statt einen gesamten Codebestand in den Kontext zu laden, hält Claude Code leichtgewichtige Identifikatoren wie Dateipfade vor und nutzt Tools wie grep und glob, um relevante Dateien bei Bedarf dynamisch abzurufen. Der Agent kann gezielte Abfragen schreiben, Ergebnisse speichern und Kommandozeilentools verwenden, um große Datenmengen zu analysieren, ohne jemals die gesamten Datenobjekte in den Kontext zu laden. Auch hier orientiert sich der Ansatz am menschlichen Denken – wir merken uns keine kompletten Informationsbestände, sondern nutzen Organisationssysteme wie Dateisysteme und Suchtools, um bei Bedarf relevante Informationen abzurufen.

Technik 4: Isolation – Sub-Agenten und Aufgaben-Trennung

Isolation steht für den Einsatz von Sub-Agenten, um spezifische Aufgaben zu bearbeiten, sodass verschiedene Agenten an separaten Problemen arbeiten, ohne sich im Kontext zu überschneiden. Diese Technik erkennt an, dass es manchmal am effektivsten ist, komplexe Probleme in kleinere, fokussierte Teilaufgaben zu zerlegen, die jeweils von einem dedizierten Agenten mit eigenem Kontextfenster bearbeitet werden.

Hier gibt es zwei Hauptparadigmen: Cognition beispielsweise rät vom Einsatz von Sub-Agenten ab, es sei denn, die Aufgaben sind vollständig getrennt und überschneiden sich nicht. Ihrer Ansicht nach erhöhen Sub-Agenten die Komplexität und potenzielle Fehlerquellen und sollten nur bei absoluter Notwendigkeit eingesetzt werden. Andere Organisationen wie Cloud Code hingegen nutzen Sub-Agenten als integralen Bestandteil ihrer Architektur. In Cloud Code können Sub-Agenten für verschiedene Aspekte einer größeren Aufgabe erstellt werden, wobei ein Manager-Agent die Koordination übernimmt.

Der entscheidende Punkt bei Isolation ist der Abwägungsprozess: Einerseits hilft der Einsatz von Sub-Agenten beim Kontextmanagement, indem der Problemraum aufgeteilt wird – jeder Agent arbeitet mit einem auf seine Aufgabe zugeschnittenen Kontextfenster. Andererseits führen Sub-Agenten zu Koordinationsaufwand und potenziellen Fehlerstellen beim Informationsaustausch zwischen Agenten. Der richtige Ansatz hängt vom individuellen Anwendungsfall ab: Für hochkomplexe Aufgaben mit klar abgegrenzten Teilproblemen kann Isolation sehr effektiv sein, bei eng verzahnten Aufgaben ist ein einzelner Agent mit gut gemanagtem Kontext oft besser geeignet.

Umsetzung des Kontext-Engineerings in FlowHunt

FlowHunt bietet eine umfassende No-Code-Plattform zur Umsetzung all dieser Kontext-Engineering-Techniken. Anstatt dass Entwickler individuelle Lösungen bauen müssen, können Teams mit FlowHunt anspruchsvolle Kontextmanagement-Strategien über eine intuitive visuelle Oberfläche implementieren. Das demokratisiert Kontext-Engineering und macht es auch Teams ohne tiefe Machine-Learning-Expertise zugänglich.

In FlowHunt können Sie Isolation durch selbstverwaltete Crews umsetzen. Eine selbstverwaltete Crew besteht aus mehreren KI-Agenten mit einem Manager-Agenten, der die Koordination übernimmt. Der Manager-Agent erhält die Anfangsaufgabe, zerlegt sie in Teilaufgaben und delegiert diese an spezialisierte Agenten weiter. Jeder Sub-Agent arbeitet mit einem auf seine Aufgabe zugeschnittenen Kontextfenster. Nach Abschluss der Teilaufgaben fasst der Manager-Agent die Ergebnisse zusammen. Dieser Ansatz ermöglicht die Bearbeitung komplexer Probleme durch Zerlegung in überschaubare Einheiten, die jeweils mit optimiertem Kontext arbeiten.

FlowHunt unterstützt außerdem sequentielle Aufgabenflüsse, bei denen mehrere Agenten eine Aufgabe nacheinander bearbeiten und die Ausgabe eines Agenten zum Input des nächsten wird. Das ist besonders für Workflows mit klaren Abhängigkeiten zwischen Aufgaben sinnvoll. In einem Content-Workflow könnte ein Agent beispielsweise ein Thema recherchieren, ein zweiter agent eine Gliederung erstellen und ein dritter den finalen Text verfassen. Jeder Agent arbeitet mit einem für seinen Schritt relevanten, fokussierten Kontextfenster.

Darüber hinaus können Sie in FlowHunt intelligente Retrieval-Systeme direkt in Ihre Flows integrieren. Statt alle Informationen im Voraus zu laden, können Agenten so konfiguriert werden, dass sie relevante Daten bei Bedarf dynamisch abrufen – sei es durch Datenbankabfragen, das Durchsuchen von Wissensbasen oder das Abrufen von Dateien basierend auf dem Reasoning des Agenten. Durch die Kombination dieser Möglichkeiten ermöglicht FlowHunt die Umsetzung von Enterprise-Grade-Kontext-Engineering – ganz ohne Programmierung.

Fortgeschrittene Strategien und reale Anwendungen

Über die vier Grundtechniken hinaus nutzen führende Organisationen weitere fortgeschrittene Strategien, um das volle Potenzial des Kontext-Engineerings auszuschöpfen. Diese Ansätze kombinieren meist mehrere Techniken und erfordern Feintuning für spezifische Anwendungsfälle.

Eine fortgeschrittene Strategie ist das hybride Kontextmanagement, bei dem eine Kombination aus vorab geladenem Kontext und Just-in-Time-Retrieval genutzt wird. Statt sich für das eine oder das andere zu entscheiden, werden kritische Informationen für Geschwindigkeit und Zuverlässigkeit im Voraus geladen, während zusätzliche Daten bei Bedarf dynamisch abgerufen werden. Claude Code nutzt diesen hybriden Ansatz – CLAUDE.md-Dateien werden upfront in den Kontext geladen, da sie typischerweise klein und wichtig für die Konfiguration sind, während größere Dateien und Daten bei Bedarf mit grep und glob abgerufen werden.

Eine weitere Strategie beruht auf metadatengetriebener Kontexterstellung. Statt nur auf den Inhalt zu achten, nutzen ausgefeilte Systeme Metadaten wie Dateinamen, Zeitstempel, Ordnerhierarchien und andere Organisationshinweise, um intelligent zu entscheiden, welche Informationen relevant sind. Ein Agent in einem Dateisystem kann zum Beispiel bereits aus dem Dateinamen test_utils.py im Ordner tests im Vergleich zu src/core_logic/ viel ableiten. Diese Metadaten helfen Agenten dabei, Informationen gezielt und effizient einzusetzen, ohne dass der gesamte Inhalt geladen und analysiert werden muss.

Ein weiterer wichtiger Punkt ist die Prävention von Context Poisoning. Wie bereits beschrieben, kommt es zu Context Poisoning, wenn irrelevante Informationen den Reasoning-Prozess des Agenten stören. Fortschrittliche Systeme erkennen und entfernen potenziell schädlichen Kontext aktiv – zum Beispiel, indem sie die Reasoning-Kette des Agenten analysieren, Abweichungen identifizieren und den auslösenden Kontext entfernen oder umformulieren. Dadurch entsteht ein Feedback-Loop, der die Kontextqualität kontinuierlich verbessert.

Die Zukunft des Kontext-Engineerings und der KI-Agentenentwicklung

Mit zunehmender Komplexität und Leistungsfähigkeit von KI-Agenten gewinnt Kontext-Engineering immer mehr an Bedeutung. Das Feld entwickelt sich rasant weiter und regelmäßig entstehen neue Techniken und Best Practices. Mehrere Trends werden die Zukunft des Kontext-Engineerings prägen.

Erstens werden wir wahrscheinlich immer ausgefeiltere automatisierte Systeme zur Kontextkuratierung sehen. Künftig entscheiden nicht mehr Menschen, welche Kontexte einbezogen werden, sondern maschinelles Lernen wird optimalen Kontext für jeden Agenten und jede Aufgabe bestimmen. Solche Systeme lernen anhand der Agentenleistung, welche Kontextteile wertvoll sind und welche zu Context Poisoning führen.

Zweitens wird Kontext-Engineering stärker mit der Agentenarchitektur verwoben. Künftige Agentensysteme werden von Grund auf mit Blick auf Kontext-Effizienz entwickelt – etwa durch neue Architekturen, die von Haus aus besser mit begrenzten Kontextfenstern umgehen können, oder neue Formen der Informationsrepräsentation, die token-effizienter sind.

Drittens wird Kontext-Engineering als eigenständige Disziplin mit spezialisierten Tools, Frameworks und Best Practices entstehen. Analog zur Entwicklung des Prompt-Engineerings von einer Ad-hoc-Praxis zur anerkannten Disziplin mit etablierten Methoden, folgt Kontext-Engineering einem ähnlichen Pfad. Organisationen investieren in spezialisierte Teams und Tools, die sich ausschließlich auf Kontextoptimierung konzentrieren.

{{ cta-dark-panel

heading=“Optimieren Sie Ihren Workflow mit FlowHunt”

description=“Erleben Sie, wie FlowHunt Ihre KI-Inhalte und SEO-Workflows automatisiert – von Recherche und Inhaltserstellung bis hin zu Veröffentlichung und Analyse – alles an einem Ort.”

ctaPrimaryText=“Demo buchen”

ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo"

ctaSecondaryText=“FlowHunt kostenlos testen”

ctaSecondaryURL=“https://app.flowhunt.io/sign-in"

gradientStartColor="#123456”

gradientEndColor="#654321”

gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217”

}}

Praktische Umsetzung: Ihren ersten kontext-optimierten Agenten bauen

Um den Einstieg ins Kontext-Engineering zu erleichtern, gehen wir ein praktisches Beispiel für einen kontext-optimierten Agenten durch: Recherche und Inhaltserstellung. Das Beispiel zeigt die Anwendung der beschriebenen Techniken in einem realen Szenario.

Definieren Sie zunächst klar die Kernverantwortung Ihres Agenten – in diesem Fall soll der Agent ein Thema recherchieren und einen umfassenden Artikel generieren. Statt alles mit einem einzigen Agenten und riesigem Kontextfenster zu lösen, nutzen Sie Isolation und bauen ein Multi-Agenten-System. Der erste Agent ist ein Rechercheur, der Informationen sammelt. Der zweite Agent ist ein Autor, der auf Basis dieser Recherche den Artikel erstellt. Ein Manager-Agent koordiniert den Workflow.

Für den Recherche-Agenten setzen Sie Retrieval-basiertes Kontextmanagement um. Anstatt alle verfügbaren Informationen im Voraus zu laden, erhält dieser Agent Tools, um Datenbanken zu durchsuchen, APIs abzufragen und relevante Dokumente abzurufen. Gefundene Informationen werden zusammengefasst und mit Referenzen zu den vollständigen Quellen gespeichert. So bleibt das Kontextfenster schlank, aber alle nötigen Informationen sind zugänglich.

Für den Autoren-Agenten wird Offloading eingesetzt. Der Rechercheur übergibt eine Zusammenfassung der Ergebnisse samt Referenzen an den Autor. Das Kontextfenster des Autors enthält die Zusammenfassung und die Möglichkeit, bei Bedarf auf die vollständigen Quellen zuzugreifen – so arbeitet er effizient, ohne von Rohdaten überflutet zu werden.

Überwachen Sie während des Prozesses Context Poisoning. Wenn Sie bemerken, dass der Agent schlechte Entscheidungen trifft oder vom Thema abweicht, analysieren Sie das Reasoning und identifizieren Sie den auslösenden Kontext. Entfernen oder formulieren Sie diesen um und testen Sie erneut. Mit der Zeit entwickeln Sie ein Gespür für den optimalen Kontext bei Ihrer Anwendung.

Messen und Optimieren der Kontext-Engineering-Leistung

Effektives Kontext-Engineering erfordert Messung und kontinuierliche Optimierung. Sie benötigen Metriken, um zu erkennen, ob Ihre Maßnahmen die Agentenleistung tatsächlich verbessern. Folgende Schlüsselmetriken sollten Sie verfolgen:

Erstens: Token-Effizienz – das Verhältnis von nützlichem Output zu verbrauchten Tokens. Ein Agent, der hochwertige Ergebnisse bei weniger Token erzielt, ist effizienter. Verfolgen Sie diese Metrik über die Zeit, während Sie Offloading-, Reduktions- und Retrieval-Strategien einsetzen.

Zweitens: Reasoning-Qualität. Analysieren Sie die Argumentationsketten des Agenten auf Kohärenz und Logik oder vergleichen Sie die Qualität der Ergebnisse mit einem Goldstandard. Je besser Ihr Kontext-Engineering, desto klarer und logischer werden die Reasoning-Ketten.

Drittens: Fehlererholung. Wie gut kann sich der Agent nach Fehlern wieder fangen? Besseres Kontext-Engineering führt zu besserer Fehlererholung, weil der Agent klarere Hinweise bekommt, was schiefgelaufen ist und wie es weitergeht.

Viertens: Latenz und Kosten. Kontext-Engineering zielt zwar primär auf Qualitätssteigerung, bringt aber auch Effizienzgewinne. Agenten mit besser gemanagtem Kontextfenster sind schneller (weniger zu verarbeitende Tokens) und günstiger (weniger Tokenverbrauch). Überwachen Sie diese Werte, um den Gesamteffekt Ihrer Maßnahmen zu verstehen.

Häufige Fehler und wie Sie sie vermeiden

Beim Implementieren von Kontext-Engineering begegnen Teams oft typischen Fallstricken. Mit Bewusstsein für diese Fehler vermeiden Sie kostspielige Probleme:

Erstens: Überoptimierung. Es ist verlockend, jedes mögliche Token aus dem Kontextfenster zu streichen – doch ein zu schlanker Kontext kann unbrauchbar werden. Ziel ist das optimale Gleichgewicht – genügend Informationen für effektives Reasoning, aber nicht zu viel, um Verwirrung zu vermeiden. Starten Sie mit einer vernünftigen Menge Kontext und reduzieren Sie nur, wenn die Agentenleistung stimmt.

Zweitens: Ignorieren von aufgabenspezifischen Anforderungen. Kontext-Engineering ist nicht universell – was für einen Kundendienst-Agenten funktioniert, muss nicht für einen Datenanalyse-Agenten passen. Analysieren Sie Ihren Use Case und passen Sie die Strategie individuell an.

Drittens: Fehlende Überwachung und Iteration. Kontext-Engineering ist kein einmaliger Schritt. Da Ihre Agenten auf neue Situationen treffen und sich die Anforderungen ändern, müssen Sie die Leistung kontinuierlich überwachen und Ihre Strategie anpassen. Integrieren Sie Monitoring und Iteration von Anfang an in Ihren Entwicklungsprozess.

Viertens: Unterschätzung der Bedeutung von Metadaten. Viele Teams fokussieren sich ausschließlich auf den Inhalt, vergessen aber die Metadaten, die Agenten helfen, Inhalte zu verstehen und einzuordnen. Dateinamen, Zeitstempel, Ordnerstrukturen und andere Organisationshinweise sind oft wertvoller als gedacht. Achten Sie darauf, wie Sie Informationen organisieren und kennzeichnen.

Fazit

Kontext-Engineering steht für einen grundlegenden Wandel im Aufbau von KI-Agenten: weg vom reinen Schreiben perfekter Prompts, hin zum strategischen Management aller verfügbaren Informationen zur Leistungsoptimierung. Mit den vier Kernttechniken – Offloading, Reduktion, Retrieval und Isolation – sowie fortgeschrittenen Strategien wie hybridem Kontextmanagement und metadatengetriebener Auswahl schaffen Sie leistungsfähigere, zuverlässigere und effizientere Agenten. Plattformen wie FlowHunt machen diese anspruchsvollen Techniken über No-Code-Oberflächen für Teams jeder Größe zugänglich und demokratisieren so das Kontext-Engineering. Denken Sie daran: Kontext-Engineering ist ein iterativer Prozess, der kontinuierliche Messung und Optimierung verlangt. Beginnen Sie mit den Grundlagen, messen Sie Ihre Ergebnisse und integrieren Sie fortgeschrittene Techniken nach und nach, während Sie Erfahrung sammeln. Die Organisationen, die Kontext-Engineering meistern, werden die leistungsfähigsten und zuverlässigsten KI-Agenten bauen – und sich entscheidende Wettbewerbsvorteile in einer zunehmend KI-getriebenen Welt sichern.