Fastn Server

Integrieren Sie FlowHunt mit dem Fastn Server, um den API-Zugriff zu vereinheitlichen, KI-Workflows zu orchestrieren und Geschäftsprozesse über Plattformen wie ...

Ein umfassender Leitfaden zur Integration von Künstlicher Intelligenz mit externen Anwendungen über APIs und Webhooks, einschließlich Authentifizierung, Echtzeitkommunikation und praktischer Implementierungsstrategien.

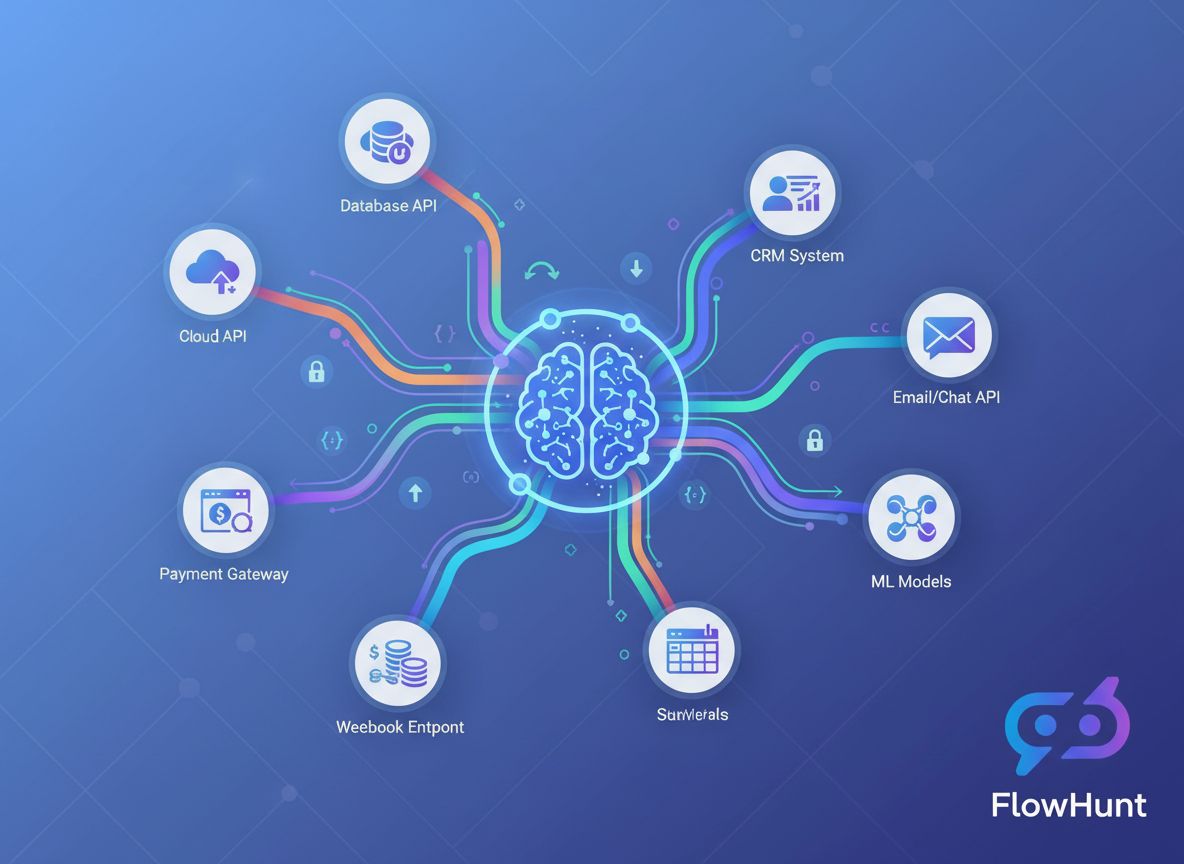

Die Konvergenz von Künstlicher Intelligenz und externen Anwendungen hat die Arbeitsweise von Unternehmen grundlegend verändert. Heutige Unternehmen arbeiten nicht mehr mit isolierten KI-Systemen – stattdessen orchestrieren sie ausgefeilte Integrationen, die KI-Modelle mit CRM-Plattformen, Zahlungs-Gateways, Kommunikationstools und unzähligen weiteren Diensten verbinden. Dieser umfassende Leitfaden beleuchtet die technischen und strategischen Ansätze zur Integration von KI mit externen Tools über APIs und Webhooks und gibt Ihnen das Wissen an die Hand, um robuste, skalierbare und sichere KI-gestützte Workflows zu erstellen.

Egal, ob Sie als Entwickler Ihre erste KI-Integration bauen oder als Enterprise-Architekt komplexe Automatisierungssysteme entwerfen: Das Verständnis der Feinheiten von API-basierter und webhook-gesteuerter KI-Integration ist unerlässlich. Dieser Artikel begleitet Sie durch den gesamten Prozess – von grundlegenden Konzepten bis hin zu fortgeschrittenen Implementierungsmustern – damit Sie KI-Fähigkeiten sicher mit Ihrem bestehenden Technologie-Stack verbinden können.

Vor der Entwicklung von Integrationsstrategien ist es wichtig, den grundlegenden Unterschied zwischen diesen beiden Kommunikationsparadigmen zu verstehen. Eine API (Application Programming Interface) ist eine Sammlung von Protokollen und Tools, die es verschiedenen Softwareanwendungen ermöglichen, miteinander zu kommunizieren. APIs arbeiten nach einem Pull-basierten Modell, d.h., Ihre Anwendung fordert aktiv Daten oder Dienste von einem externen System an. Wenn Sie Informationen benötigen, initiieren Sie die Anfrage, warten auf die Antwort und verarbeiten die zurückgegebenen Daten.

Im Gegensatz dazu arbeitet ein Webhook nach einem Push-basierten Modell. Anstatt dass Ihre Anwendung ständig nach Updates fragt, ermöglichen Webhooks externen Systemen, Ihrer Anwendung proaktiv Daten zu senden, wenn bestimmte Ereignisse eintreten. Man kann es sich vorstellen wie den Unterschied zwischen dem ständigen Nachsehen im Briefkasten und der Zustellung der Post direkt an die Tür, sobald sie eintrifft.

APIs werden typischerweise für bedarfsgesteuerte Operationen eingesetzt – zum Abrufen von Nutzerinformationen, Verarbeiten von Zahlungen, Generieren von KI-Vorhersagen oder Abrufen von Echtzeitdaten. Webhooks hingegen sind ideal für ereignisgesteuerte Szenarien, bei denen Sie sofort benachrichtigt werden müssen, wenn etwas passiert: Eine Zahlung wird verarbeitet, ein Formular wird eingereicht, eine Datei hochgeladen oder ein Nutzer führt eine bestimmte Aktion aus.

Die Wahl zwischen APIs und Webhooks hängt häufig vom Anwendungsfall ab. Viele anspruchsvolle Integrationen nutzen tatsächlich beide: APIs zur Datenabfrage und Webhooks für den Empfang von Echtzeitbenachrichtigungen. Dieser hybride Ansatz bietet die Flexibilität und Reaktionsschnelligkeit, die moderne Anwendungen verlangen.

Die geschäftlichen Vorteile der Integration von KI mit externen Tools sind überzeugend und vielfältig. Organisationen, denen diese Integrationen gelingen, verschaffen sich signifikante Wettbewerbsvorteile in mehreren Bereichen.

Betriebliche Effizienz und Kostenreduktion: Wenn KI-Systeme isoliert von Ihren bestehenden Tools arbeiten, entstehen Datensilos und manuelle Übergabepunkte. Durch die direkte Integration von KI in Ihr CRM, Ihre E-Mail-Plattform, Projektmanagement-Tools und andere Anwendungen beseitigen Sie diese Reibungspunkte. Anstatt Daten manuell zwischen Systemen zu übertragen, kann KI Informationen automatisch verarbeiten, Einblicke generieren und Aktionen über den gesamten Technologie-Stack hinweg auslösen. Diese Automatisierung senkt die Betriebskosten, minimiert menschliche Fehler und entlastet Ihr Team für strategische Aufgaben mit höherem Mehrwert.

Echtzeit-Entscheidungen: Webhooks ermöglichen es KI-Systemen, sofort auf Geschäftsvorfälle zu reagieren. Wenn ein Kunde ein Support-Ticket einreicht, kann ein KI-System sofort die Stimmung analysieren und es an das passende Team weiterleiten. Wird der Umsatz aktualisiert, kann KI umgehend Prognosen neu berechnen. Sinkt der Lagerbestand unter einen Schwellenwert, kann KI automatisch Bestellungen auslösen. Diese Echtzeit-Reaktionsfähigkeit verändert, wie schnell Organisationen auf Marktveränderungen und Kundenbedürfnisse reagieren können.

Verbessertes Kundenerlebnis: Integrierte KI-Systeme bieten nahtlose, personalisierte Erlebnisse. Ein KI-Chatbot, integriert in Ihr CRM, kann auf Kundendaten zugreifen und kontextbezogene Antworten liefern. Eine KI-Empfehlungsmaschine, gekoppelt mit Ihrer E-Commerce-Plattform, kann personalisierte Produktempfehlungen ausspielen. Ein KI-Terminassistent, verbunden mit Ihrem Kalender, findet automatisch passende Termine. Solche Integrationen schaffen reibungslose Abläufe, die Kunden schätzen und die Loyalität fördern.

Datengetriebene Erkenntnisse im großen Maßstab: Durch die Verbindung von KI mit mehreren Datenquellen über APIs können Unternehmen umfassende Analysesysteme aufbauen, die Informationen aus dem gesamten Betrieb verarbeiten. Dieser einheitliche Blick ermöglicht genauere Prognosen, bessere Mustererkennung und Erkenntnisse, die mit isolierten Daten unmöglich wären.

Zu den wichtigsten Vorteilen zählen:

APIs bilden das Rückgrat der meisten KI-Integrationen. Um KI effektiv mit externen Tools zu verbinden, müssen Sie verstehen, wie APIs funktionieren und wie man programmatisch mit ihnen interagiert.

Moderne APIs gibt es in verschiedenen Ausprägungen, jede mit spezifischen Eigenschaften. REST (Representational State Transfer) APIs sind am weitesten verbreitet. Sie nutzen gängige HTTP-Methoden (GET, POST, PUT, DELETE), um Operationen an Ressourcen durchzuführen, die über URLs identifiziert werden. REST-APIs sind zustandslos – jede Anfrage enthält alle Informationen, die zu deren Verarbeitung nötig sind, was sie einfach verständlich und implementierbar macht.

GraphQL APIs bieten eine flexiblere Alternative, da Clients genau die Daten anfordern können, die sie benötigen, statt feste Antwortstrukturen zu erhalten. Das ist bei komplexen Abfragen effizienter, erfordert aber eine anspruchsvollere Client-Implementierung.

SOAP (Simple Object Access Protocol) APIs sind ältere, XML-basierte Protokolle, die in Unternehmensumgebungen noch immer genutzt werden. Sie sind komplexer als REST, bieten aber umfangreiche Features für Unternehmensintegrationen.

RPC (Remote Procedure Call) APIs ermöglichen es, Funktionen auf entfernten Servern aufzurufen, als wären sie lokal. Einige Blockchain- und Kryptowährungs-APIs nutzen dieses Muster.

Für die meisten KI-Integrationen arbeiten Sie mit REST-APIs, die einen ausgezeichneten Kompromiss aus Einfachheit und Funktionalität bieten.

Jede API-Interaktion erfordert Authentifizierung, um sicherzustellen, dass Ihre Anwendung berechtigt ist, auf den Dienst zuzugreifen. Das Verständnis der Authentifizierungsmechanismen ist entscheidend für eine sichere KI-Integration.

API-Schlüssel sind die einfachste Authentifizierungsmethode. Sie erhalten einen eindeutigen Schlüssel bei der Registrierung für einen API-Dienst und fügen diesen Ihren Anfragen bei. Die Implementierung ist einfach, aber API-Schlüssel haben Einschränkungen – sie laufen nicht automatisch ab und bieten meist uneingeschränkten Zugriff. Für Entwicklung und weniger sensible Vorgänge geeignet, sollten sie in produktiven Systemen nicht die einzige Sicherheitsmaßnahme sein.

OAuth 2.0 ist der Industriestandard für delegierte Autorisierung. Anstatt Ihre Zugangsdaten direkt weiterzugeben, können Nutzer Ihrer Anwendung erlauben, in ihrem Namen auf Daten zuzugreifen. Das sehen Sie, wenn eine Anwendung um Erlaubnis bittet, “auf Ihr Google-Konto zuzugreifen” oder “sich mit Ihrem Slack-Workspace zu verbinden”. OAuth ist komplexer zu implementieren, bietet aber bessere Sicherheit und Nutzerkontrolle.

Bearer Tokens und JWT (JSON Web Tokens) vereinen die Einfachheit von API-Schlüsseln mit zusätzlichen Sicherheitsfunktionen. JWTs sind kryptografisch signierte Tokens, die Informationen über Nutzer oder Anwendung enthalten. Sie können Ablaufzeiten, spezifische Berechtigungen und weitere Metadaten enthalten und sind ideal für Microservices und verteilte Systeme.

Mutual TLS (mTLS) nutzt Zertifikate für die Authentifizierung von Client und Server und bietet das höchste Sicherheitsniveau. Es wird häufig in Unternehmensumgebungen und für besonders sensible Vorgänge verwendet.

Die Interaktion mit APIs erfordert das Erstellen von HTTP-Anfragen mit passenden Headern, Parametern und Inhalten. Hier ein praktisches Beispiel für einen Aufruf einer KI-API:

import requests

import json

# Authentifizierung einrichten

headers = {

'Authorization': 'Bearer YOUR_API_KEY',

'Content-Type': 'application/json',

}

# Anfrage-Payload vorbereiten

data = {

'model': 'gpt-4',

'messages': [

{

'role': 'user',

'content': 'Analysiere dieses Kundenfeedback auf Stimmung'

}

],

'temperature': 0.7,

'max_tokens': 500,

}

# API-Aufruf durchführen

response = requests.post(

'https://api.openai.com/v1/chat/completions',

headers=headers,

json=data

)

# Antwort verarbeiten

if response.status_code == 200:

result = response.json()

ai_response = result['choices'][0]['message']['content']

print(f"KI-Analyse: {ai_response}")

else:

print(f"Fehler: {response.status_code} - {response.text}")

Dieses Beispiel zeigt das grundlegende Muster: Authentifizieren, Anfrage erstellen, an den API-Endpunkt senden und die Antwort verarbeiten. Die meisten KI-API-Integrationen folgen dieser Struktur, auch wenn die genauen Parameter und Antwortformate je nach Dienst variieren.

Während APIs Daten bedarfsgerecht abrufen, ermöglichen Webhooks die push-basierte Kommunikation in Echtzeit. Das Verständnis der Webhook-Architektur ist für reaktive KI-Systeme unerlässlich.

Ein Webhook ist im Wesentlichen ein Callback-Mechanismus. Sie registrieren eine URL bei einem externen Dienst, und wenn bestimmte Ereignisse eintreten, sendet dieser Dienst eine HTTP-POST-Anfrage mit den Ereignisdaten an Ihre URL. Ihre Anwendung empfängt diese Daten, verarbeitet sie und führt entsprechende Aktionen aus.

Der Ablauf sieht so aus:

Der Bau eines Webhook-Receivers erfordert das Bereitstellen eines HTTP-Endpunkts, der POST-Anfragen akzeptieren kann. Hier ein praktisches Beispiel mit Flask:

from flask import Flask, request, jsonify

import hmac

import hashlib

import json

app = Flask(__name__)

WEBHOOK_SECRET = 'your_webhook_secret_key'

def verify_webhook_signature(payload, signature):

"""Überprüfen, ob das Webhook von der erwarteten Quelle stammt"""

expected_signature = hmac.new(

WEBHOOK_SECRET.encode(),

payload,

hashlib.sha256

).hexdigest()

return hmac.compare_digest(signature, expected_signature)

@app.route('/webhook/payment', methods=['POST'])

def handle_payment_webhook():

# Raw Payload für Signaturprüfung holen

payload = request.get_data()

signature = request.headers.get('X-Signature')

# Überprüfung der Echtheit

if not verify_webhook_signature(payload, signature):

return jsonify({'error': 'Ungültige Signatur'}), 401

# JSON-Daten parsen

data = request.json

# Webhook-Event verarbeiten

try:

if data['event_type'] == 'payment.completed':

# KI-Analyse der Transaktion starten

analyze_transaction(data['transaction_id'], data['amount'])

# Datenbank aktualisieren

update_payment_status(data['transaction_id'], 'completed')

# Bestätigung senden

send_confirmation_email(data['customer_email'])

# Immer 200 zurückgeben, um Erhalt zu bestätigen

return jsonify({'status': 'received'}), 200

except Exception as e:

# Fehler protokollieren, aber zur Vermeidung von Retries trotzdem 200 senden

log_error(f"Fehler bei Webhook-Verarbeitung: {str(e)}")

return jsonify({'status': 'received'}), 200

if __name__ == '__main__':

app.run(port=5000)

Dieses Beispiel zeigt mehrere wichtige Webhook-Best-Practices: Signaturprüfung für Authentizität, sauberes Fehlerhandling und stets erfolgreiche Rückmeldung zur Vermeidung von Wiederholungen durch den externen Dienst.

Webhooks bringen spezielle Sicherheitsanforderungen mit sich, da externe Dienste Daten an Ihre Anwendung senden. Folgende Maßnahmen sind essenziell:

Signaturprüfung: Die meisten Webhook-Anbieter schicken eine Signatur im Header, berechnet mit einem gemeinsamen Geheimnis. Prüfen Sie diese Signatur immer, um sicherzugehen, dass das Webhook von der erwarteten Quelle stammt und nicht manipuliert wurde.

Nur HTTPS: Verwenden Sie immer HTTPS für Webhook-Endpunkte. Dadurch werden die Daten auf dem Transportweg verschlüsselt und Man-in-the-Middle-Angriffe verhindert.

IP-Whitelisting: Sofern möglich, beschränken Sie die zugelassenen IP-Adressen für Webhooks auf die des externen Anbieters. Das verhindert unbefugte Zugriffe auf Ihren Endpunkt.

Rate-Limiting: Implementieren Sie Rate-Limiting auf Ihren Webhook-Endpunkten, um Missbrauch oder versehentliche Überlastung zu vermeiden.

Idempotenz: Gestalten Sie Ihre Webhook-Handler idempotent – das mehrfache Verarbeiten desselben Webhooks sollte stets dasselbe Ergebnis liefern. Das ist wichtig, da Anbieter fehlgeschlagene Lieferungen erneut senden können.

Nachdem wir die Grundlagen verstanden haben, sehen wir uns an, wie KI-Modelle mit externen Diensten integriert werden. Hier entfaltet KI-Integration ihre eigentliche Wirkung.

Das KI-Ökosystem bietet zahlreiche Optionen mit unterschiedlichen Fähigkeiten, Preismodellen und Integrationsmöglichkeiten. OpenAIs API bietet Zugang zu GPT-4, GPT-3.5 und weiteren Modellen für Sprachverarbeitung, Codegenerierung und Reasoning. Google Cloud AI stellt Dienste wie Vertex AI, Document AI und Vision AI bereit. AWS bietet SageMaker für eigene Modelle und diverse vorkonfigurierte KI-Services. Anthropics Claude API spezialisiert sich auf sichere, interpretierbare KI. Hugging Face bietet Open-Source-Modelle und einen Modell-Hub.

Die Auswahl hängt von mehreren Faktoren ab: spezifische KI-Funktionen, Budget, Latenzanforderungen, Datenschutz und ob Sie Managed Services oder selbst gehostete Lösungen bevorzugen.

Eine typische KI-Integrationspipeline umfasst mehrere Stufen: Datensammlung von externen Quellen via API, Vorverarbeitung und Anreicherung, KI-Inferenz, Ergebnisverarbeitung und das Auslösen von Aktionen. Hier ein praktisches Beispiel mit mehreren Komponenten:

import requests

import json

from datetime import datetime

import logging

class AIIntegrationPipeline:

def __init__(self, ai_api_key, crm_api_key):

self.ai_api_key = ai_api_key

self.crm_api_key = crm_api_key

self.logger = logging.getLogger(__name__)

def fetch_customer_data(self, customer_id):

"""Kundendaten über CRM-API holen"""

headers = {'Authorization': f'Bearer {self.crm_api_key}'}

response = requests.get(

f'https://api.crm.example.com/customers/{customer_id}',

headers=headers

)

return response.json()

def analyze_with_ai(self, text_content):

"""Inhalt an KI-API zur Analyse senden"""

headers = {

'Authorization': f'Bearer {self.ai_api_key}',

'Content-Type': 'application/json'

}

payload = {

'model': 'gpt-4',

'messages': [

{

'role': 'system',

'content': 'Du bist ein Kundenservice-Analyst. Analysiere die folgende Kundeninteraktion und gib Erkenntnisse aus.'

},

{

'role': 'user',

'content': text_content

}

],

'temperature': 0.5,

'max_tokens': 1000

}

response = requests.post(

'https://api.openai.com/v1/chat/completions',

headers=headers,

json=payload

)

if response.status_code == 200:

return response.json()['choices'][0]['message']['content']

else:

self.logger.error(f"KI-API-Fehler: {response.status_code}")

raise Exception("KI-Analyse fehlgeschlagen")

def update_crm_with_insights(self, customer_id, insights):

"""CRM mit KI-generierten Erkenntnissen aktualisieren"""

headers = {

'Authorization': f'Bearer {self.crm_api_key}',

'Content-Type': 'application/json'

}

payload = {

'ai_insights': insights,

'last_analyzed': datetime.now().isoformat(),

'analysis_status': 'completed'

}

response = requests.put(

f'https://api.crm.example.com/customers/{customer_id}',

headers=headers,

json=payload

)

return response.status_code == 200

def process_customer(self, customer_id):

"""Komplette Pipeline: abrufen, analysieren, aktualisieren"""

try:

# Kundendaten holen

customer_data = self.fetch_customer_data(customer_id)

# Inhalt für KI-Analyse vorbereiten

content_to_analyze = f"""

Kunde: {customer_data['name']}

Letzte Interaktionen: {customer_data['recent_interactions']}

Kaufhistorie: {customer_data['purchase_history']}

"""

# KI-Analyse durchführen

insights = self.analyze_with_ai(content_to_analyze)

# CRM mit Erkenntnissen aktualisieren

success = self.update_crm_with_insights(customer_id, insights)

if success:

self.logger.info(f"Kunde {customer_id} erfolgreich verarbeitet")

return {'status': 'success', 'insights': insights}

else:

self.logger.error(f"CRM-Update für Kunde {customer_id} fehlgeschlagen")

return {'status': 'error', 'message': 'CRM-Update fehlgeschlagen'}

except Exception as e:

self.logger.error(f"Pipeline-Fehler: {str(e)}")

return {'status': 'error', 'message': str(e)}

Dieses Beispiel zeigt eine vollständige Integrationspipeline, die Daten aus einem CRM holt, an ein KI-Modell zur Analyse sendet und das CRM mit den Ergebnissen aktualisiert. Dieses Muster lässt sich für unzählige Geschäftsszenarien anpassen.

Verschiedene Integrationsszenarien verlangen unterschiedliche Architekturen. Das Verständnis der jeweiligen Vor- und Nachteile hilft bei der Auswahl der passenden Strategie.

| Ansatz | Am besten für | Vorteile | Nachteile | Latenz |

|---|---|---|---|---|

| Synchrone API-Aufrufe | Echtzeit-Operationen, Nutzerfunktionen | Einfach, sofortiges Feedback, leicht zu debuggen | Langsamer bei langsamen KI-Modellen, blockiert Ausführung | Niedrig bis mittel |

| Asynchron mit Webhooks | Ereignisgesteuerte Workflows, hohe Volumina | Nicht blockierend, skalierbar, reaktionsschnell | Komplexer, Eventual Consistency | Mittel bis hoch |

| Message Queues | Entkoppelte Systeme, Batch-Processing | Zuverlässige Lieferung, Lastverteilung, Retry-Logik | Zusätzliche Infrastruktur, Eventual Consistency | Mittel bis hoch |

| Geplante Jobs | Periodische Analysen, Batch-Processing | Einfach, planbare Ressourcen | Nicht in Echtzeit, evtl. werden dringende Ereignisse verpasst | Hoch |

| Streaming-Integration | Echtzeit-Datenverarbeitung, kontinuierliche Analyse | Sofortige Erkenntnisse, hohe Datenvolumina | Komplexe Infrastruktur, spezialisierte Tools nötig | Sehr niedrig |

Jeder Ansatz hat seine Stärken. Ein Kundensupportsystem könnte synchrone API-Aufrufe für sofortige Chatbot-Antworten, aber asynchrone Verarbeitung für tiefere Stimmungsanalysen nutzen. Eine E-Commerce-Plattform könnte Webhooks für Bestellereignisse und geplante Jobs für nächtliche Inventuranalysen einsetzen.

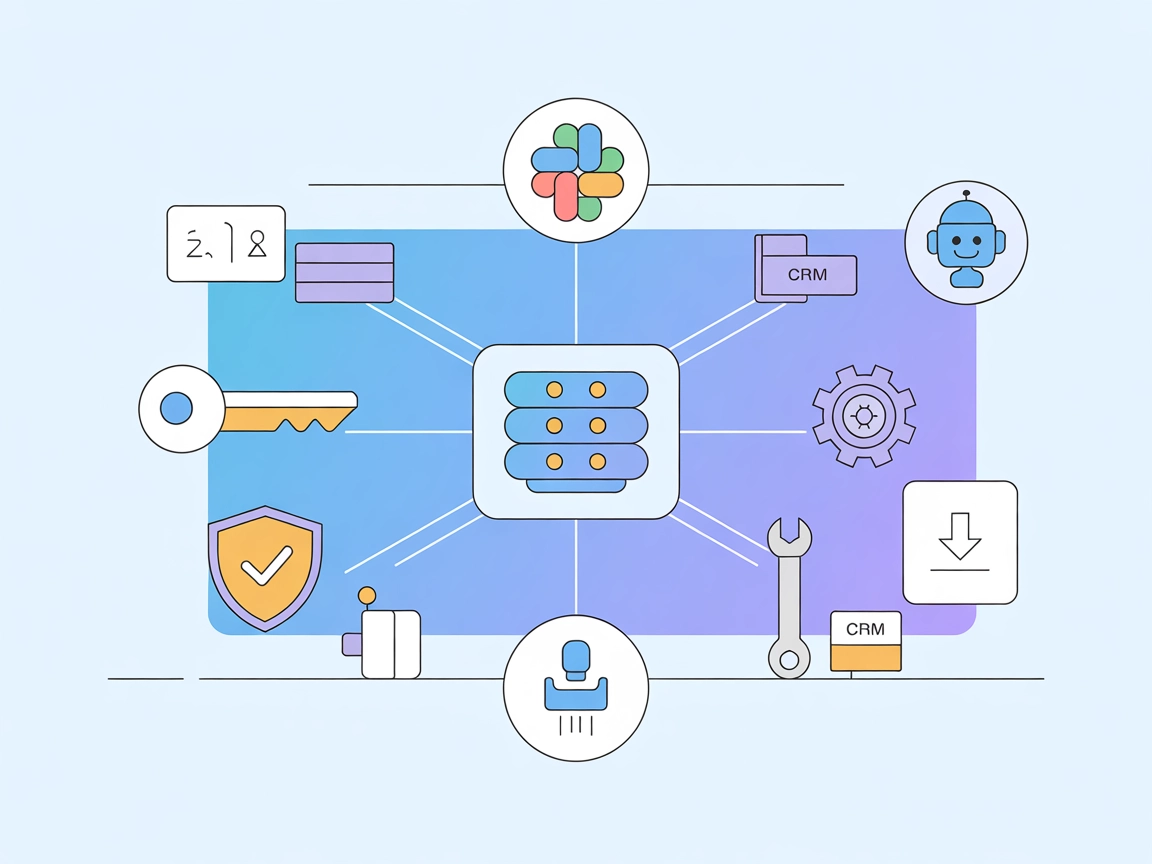

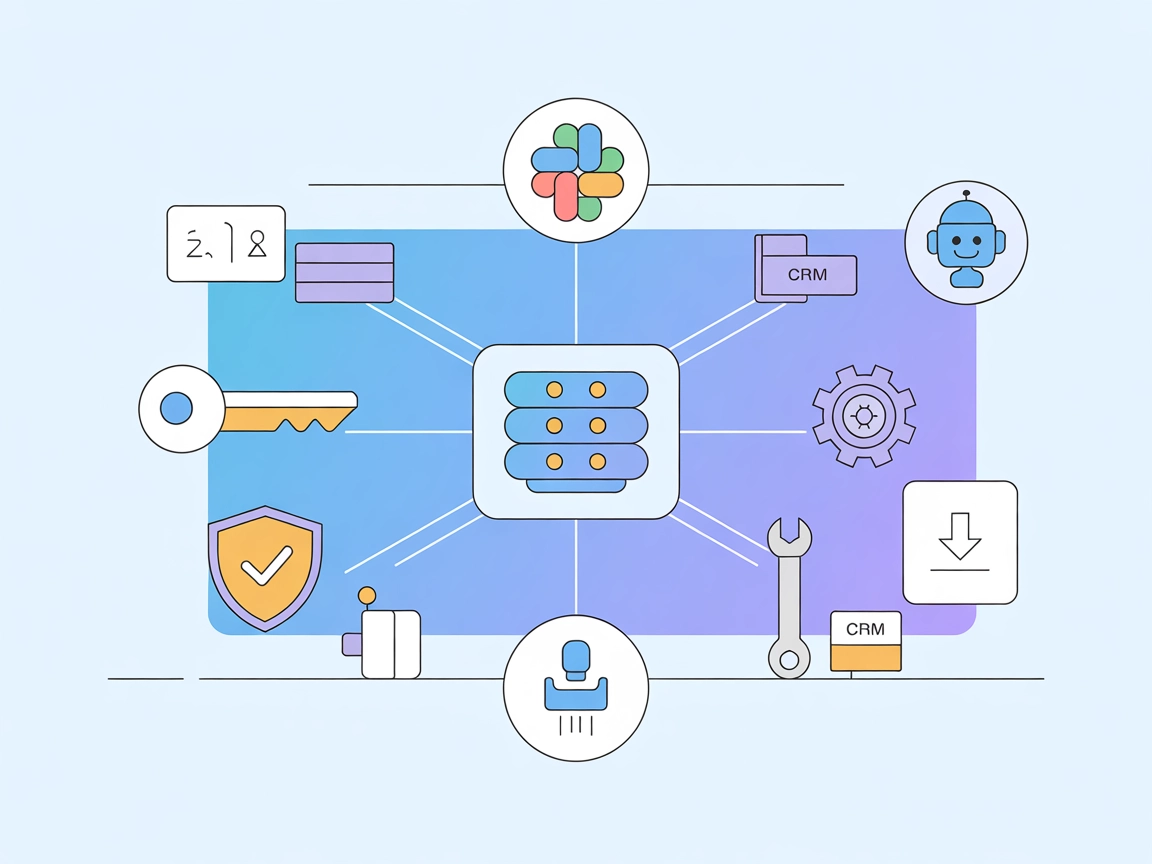

Das manuelle Management mehrerer API-Integrationen und Webhooks wird mit wachsendem Systemumfang schnell unübersichtlich. Hier setzt FlowHunt an und revolutioniert Ihre Integrationsstrategie.

FlowHunt ist eine umfassende Workflow-Automatisierungsplattform, die speziell für KI-basierte Integrationen entwickelt wurde. Anstatt individuelle Integrationscodes zu schreiben und zu pflegen, bietet FlowHunt eine visuelle Oberfläche zum Verbinden von KI-Modellen mit externen Tools, zum Verwalten von Authentifizierung, Fehlerhandling und Performance-Monitoring.

Visueller Workflow-Builder: Entwerfen Sie komplexe Integrations-Workflows ganz ohne Programmierung. Verbinden Sie KI-Modelle, APIs und Webhooks per Drag & Drop. FlowHunt übernimmt HTTP-Requests, Authentifizierung und Datenumwandlung.

Vorgefertigte Konnektoren: FlowHunt bietet Konnektoren für gängige KI-Dienste (OpenAI, Google Cloud AI, Anthropic) und hunderte externe Tools (Salesforce, HubSpot, Slack, Stripe u.v.m.). Diese übernehmen Authentifizierung und API-spezifische Details, sodass Sie sich auf die Geschäftslogik konzentrieren können.

Webhook-Management: FlowHunt vereinfacht die Einrichtung und Verwaltung von Webhooks. Registrieren Sie Webhooks bei externen Diensten, empfangen Sie Ereignisse und starten Sie KI-Analysen – alles über die FlowHunt-Oberfläche. Kein eigener Webhook-Receiver nötig.

Fehlerbehandlung und Wiederholungen: Fehlgeschlagene API-Aufrufe werden automatisch mit exponentiellem Backoff erneut versucht. Sie können Fehlerbenachrichtigungen und Fallback-Workflows definieren. FlowHunt sorgt für robuste und zuverlässige Integrationen.

Daten-Transformation: Wandeln Sie Daten zwischen verschiedenen Formaten und Strukturen um. Ordnen Sie Felder aus Ihrem CRM den KI-Inputs zu, transformieren Sie KI-Ausgaben für Ihre anderen Tools.

Monitoring und Logging: Verfolgen Sie jeden API-Aufruf, jedes Webhook-Event und jede Workflow-Ausführung. Erkennen Sie Engpässe, debuggen Sie Probleme und optimieren Sie die Performance mit umfassender Protokollierung und Analyse.

Rate-Limiting und Throttling: FlowHunt steuert API-Rate-Limits automatisch, queued Anfragen und verteilt sie, um die Service-Limits einzuhalten.

Angenommen, Sie möchten Kundenfeedback aus Ihrem Supportsystem automatisch analysieren, Stimmung kategorisieren und Ihr CRM aktualisieren. In FlowHunt könnte dieser Workflow so aussehen:

Was in einer Eigenentwicklung viele Codezeilen und aufwendiges Fehlerhandling erfordert, wird in FlowHunt zu einem visuellen Workflow. Sie können den Ablauf ändern, Schritte hinzufügen oder KI-Modelle austauschen – ganz ohne Code.

Mit wachsendem Integrationsbedarf werden fortgeschrittene Muster und bewährte Vorgehensweisen immer wichtiger.

Die meisten APIs setzen Rate-Limits – z.B. maximale Anfragen pro Minute oder Stunde. Bei Überschreitung drohen Fehler und ggf. Sperrungen. Effektives Management von Limits ist essenziell für zuverlässige Integrationen.

Implementieren Sie exponentielles Backoff: Beim Erreichen eines Limits wird vor dem nächsten Versuch gewartet, wobei sich die Wartezeit mit jedem Versuch erhöht. Die meisten APIs geben Rate-Limit-Informationen in den Headern zurück, sodass Sie Ihre Anfragerate proaktiv steuern können.

import time

import requests

def call_api_with_backoff(url, headers, data, max_retries=5):

"""API-Aufruf mit exponentiellem Backoff bei Rate-Limiting"""

for attempt in range(max_retries):

try:

response = requests.post(url, headers=headers, json=data)

# Rate-Limit erreicht?

if response.status_code == 429:

# Retry-After-Header auslesen, falls vorhanden

retry_after = int(response.headers.get('Retry-After', 2 ** attempt))

print(f"Rate-Limit. Warte {retry_after} Sekunden ...")

time.sleep(retry_after)

continue

# Andere Fehler prüfen

response.raise_for_status()

return response.json()

except requests.exceptions.RequestException as e:

if attempt == max_retries - 1:

raise

wait_time = 2 ** attempt

print(f"Anfrage fehlgeschlagen: {e}. Neuer Versuch in {wait_time} Sekunden ...")

time.sleep(wait_time)

raise Exception("Maximale Anzahl von Versuchen überschritten")

Manche KI-Operationen benötigen längere Verarbeitungszeit. Anstatt Ihre Anwendung blockieren zu lassen, nutzen Sie asynchrone Muster, bei denen der KI-Dienst eine Job-ID zurückgibt und Sie später das Ergebnis abfragen oder per Webhook über Abschluss informiert werden.

def submit_async_ai_job(content):

"""Inhalt für asynchrone KI-Verarbeitung einreichen"""

headers = {'Authorization': f'Bearer {AI_API_KEY}'}

response = requests.post(

'https://api.ai.example.com/async-analyze',

headers=headers,

json={'content': content}

)

job_data = response.json()

return job_data['job_id']

def check_job_status(job_id):

"""Status eines asynchronen Jobs prüfen"""

headers = {'Authorization': f'Bearer {AI_API_KEY}'}

response = requests.get(

f'https://api.ai.example.com/jobs/{job_id}',

headers=headers

)

job_data = response.json()

if job_data['status'] == 'completed':

return {'status': 'completed', 'result': job_data['result']}

elif job_data['status'] == 'failed':

return {'status': 'failed', 'error': job_data['error']}

else:

return {'status': 'processing'}

Wiederholte KI-API-Aufrufe mit identischen Eingaben verschwenden Ressourcen und erhöhen die Kosten. Implementieren Sie ein Caching, um Ergebnisse häufiger Abfragen zu speichern.

import hashlib

import json

from functools import wraps

import redis

# Verbindung zum Redis-Cache herstellen

cache = redis.Redis(host='localhost', port=6379, db=0)

def cache_ai_result(ttl=3600):

"""Decorator zum Caching von KI-API-Ergebnissen"""

def decorator(func):

@wraps(func)

def wrapper(content, *args, **kwargs):

# Cache-Key aus Content-Hash generieren

content_hash = hashlib.md5(content.encode()).hexdigest()

cache_key = f"ai_result:{content_hash}"

# Cache prüfen

cached_result = cache.get(cache_key)

if cached_result:

return json.loads(cached_result)

# KI-API aufrufen

result = func(content, *args, **kwargs)

# Im Cache speichern

cache.setex(cache_key, ttl, json.dumps(result))

return result

return wrapper

return decorator

@cache_ai_result(ttl=86400) # 24 Stunden cachen

def analyze_sentiment(text):

"""Stimmungsanalyse mit Caching"""

# KI-API-Aufruf hier

pass

Produktivsysteme benötigen umfassendes Monitoring. Verfolgen Sie API-Antwortzeiten, Fehlerquoten und Webhook-Erfolgsraten. Richten Sie Alarme für Anomalien ein.

import logging

from datetime import datetime

import json

class IntegrationMonitor:

def __init__(self, log_file='integration.log'):

self.logger = logging.getLogger(__name__)

handler = logging.FileHandler(log_file)

formatter = logging.Formatter(

'%(asctime)s - %(name)s - %(levelname)s - %(message)s'

)

handler.setFormatter(formatter)

self.logger.addHandler(handler)

def log_api_call(self, service, endpoint, status_code, response_time, error=None):

"""API-Call-Metriken protokollieren"""

log_entry = {

'timestamp': datetime.now().isoformat(),

'service': service,

'endpoint': endpoint,

'status_code': status_code,

'response_time_ms': response_time,

'error': error

}

self.logger.info(json.dumps(log_entry))

def log_webhook_event(self, event_type, source, success, processing_time):

"""Webhook-Event protokollieren"""

log_entry = {

'timestamp': datetime.now().isoformat(),

'event_type': event_type,

'source': source,

'success': success,

'processing_time_ms': processing_time

}

self.logger.info(json.dumps(log_entry))

Sehen wir uns ein praktisches Fallbeispiel an, wie diese Konzepte im Unternehmensalltag zusammenspielen.

Die Herausforderung: Ein E-Commerce-Unternehmen wollte das Kundenerlebnis durch personalisierte Produktempfehlungen verbessern, Kundenrezensionen automatisch kategorisieren und betrügerische Bestellungen erkennen. Es gab mehrere Systeme: einen Shopify-Shop, eine eigene Bewertungsplattform, einen Zahlungsanbieter und eine Kundendatenbank. Diese Systeme kommunizierten nicht effektiv, die manuelle Analyse war zeitaufwändig.

Die Lösung: Sie bauten ein integriertes KI-System auf Basis von APIs und Webhooks:

Produktempfehlungs-Engine: Wenn ein Kunde ein Produkt ansieht (Webhook von Shopify), werden Kaufhistorie per API geholt, an ein KI-Modell geschickt und personalisierte Empfehlungen erstellt. Das Modell berücksichtigt Produktmerkmale, Kundenpräferenzen und Trends.

Review-Analyse-Pipeline: Bei einer neuen Bewertung (Webhook) wird diese an ein KI-Modell zur Stimmungsanalyse, Themenextraktion und Qualitätsbewertung geschickt. Ergebnisse werden via API in der Bewertungsplattform gespeichert – für großflächiges Stimmungsmonitoring.

Betrugserkennung: Bei jeder Bestellung (Webhook) werden Kundendaten und Bestelldetails per API geholt, an ein KI-Betrugsmodell geschickt und die Bestellung automatisch genehmigt oder zur Prüfung markiert.

Ergebnisse: Das Unternehmen steigerte den durchschnittlichen Bestellwert um 23 % dank besserer Empfehlungen, reduzierte die Bearbeitungszeit für Bewertungen um 85 % und senkte betrügerische Bestellungen um 67 %. Das System verarbeitet täglich tausende Events bei 99,9 % Verfügbarkeit.

Eingesetzte Technologien: Shopify API für Produkt- und Bestelldaten, eigene Webhook-Receiver für Event-Handling, OpenAI API für NLP-Aufgaben, eigenes Betrugsmodell auf AWS, Redis für Caching und umfassendes Logging für Monitoring.

Das Beispiel zeigt, wie durchdachte API- und Webhook-Integration echten Geschäftswert generiert.

Die Integration von KI mit externen Tools über APIs und Webhooks ist kein

APIs sind Pull-basierte Systeme, bei denen Sie Daten von einem externen Dienst anfordern, während Webhooks Push-basierte Systeme sind, bei denen externe Dienste Daten an Ihre Anwendung senden, wenn bestimmte Ereignisse eintreten. APIs eignen sich ideal für die bedarfsgerechte Datenabfrage, während Webhooks bei Echtzeit-Benachrichtigungen über Ereignisse glänzen.

Speichern Sie API-Schlüssel in Umgebungsvariablen, verwenden Sie dedizierte Geheimnisverwaltungs-Tools wie HashiCorp Vault oder AWS Secrets Manager, geben Sie Schlüssel niemals in die Versionskontrolle, rotieren Sie Schlüssel regelmäßig und setzen Sie das Prinzip der geringsten Rechte um, indem Sie die Schlüsselberechtigungen auf das Notwendige beschränken.

Gängige Authentifizierungsmethoden sind API-Schlüssel (einfache tokenbasierte Methode), OAuth 2.0 (delegierte Autorisierung), Bearer-Tokens (JWT-basiert) und Mutual TLS (zertifikatsbasiert). Die Wahl hängt von den Sicherheitsanforderungen des API-Anbieters und den Bedürfnissen Ihrer Anwendung ab.

Implementieren Sie exponentielle Backoff-Retry-Strategien, überwachen Sie Rate-Limit-Header in API-Antworten, verwenden Sie Request-Queueing-Systeme, cachen Sie Antworten, wenn möglich, und ziehen Sie ein Upgrade auf höhere API-Tarife in Betracht, falls Sie regelmäßig an die Grenzen stoßen. Viele Bibliotheken bieten eingebaute Retry-Mechanismen.

Arshia ist eine AI Workflow Engineerin bei FlowHunt. Mit einem Hintergrund in Informatik und einer Leidenschaft für KI spezialisiert sie sich darauf, effiziente Arbeitsabläufe zu entwickeln, die KI-Tools in alltägliche Aufgaben integrieren und so Produktivität und Kreativität steigern.

FlowHunt vereinfacht die KI-Integration mit externen Tools, automatisiert API-Aufrufe, Webhook-Management und Datenverarbeitung auf einer einheitlichen Plattform.

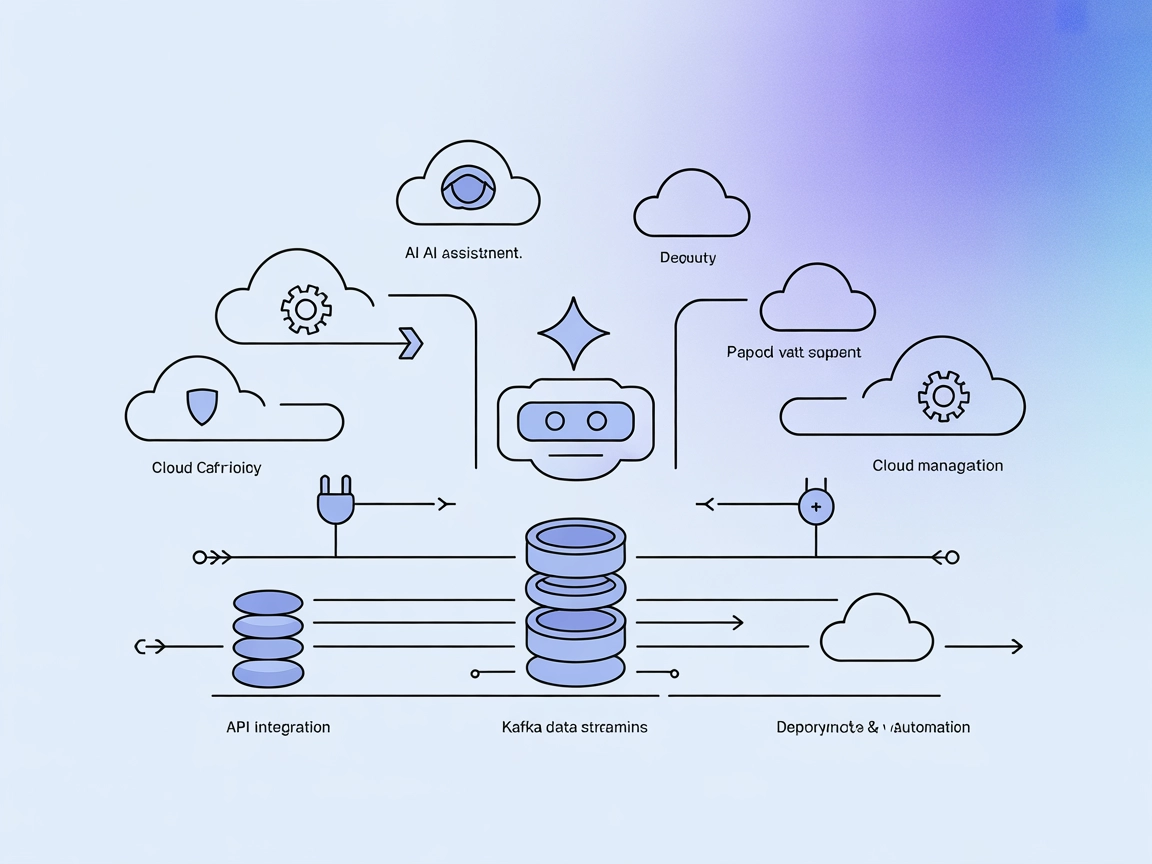

Integrieren Sie FlowHunt mit dem Fastn Server, um den API-Zugriff zu vereinheitlichen, KI-Workflows zu orchestrieren und Geschäftsprozesse über Plattformen wie ...

Erfahren Sie, was MCP (Model Context Protocol) Server sind, wie sie funktionieren und warum sie die AI-Integration revolutionieren. Entdecken Sie, wie MCP die V...

Integrieren Sie FlowHunt mit Confluent Cloud, um KI-gestütztes Management von Kafka-, Flink- und Tableflow-Ressourcen zu ermöglichen. Nutzen Sie natürliche Spra...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.