Verstehen von KI-Reasoning: Typen, Bedeutung und Anwendungen

Erkunden Sie die Grundlagen des KI-Reasonings, einschließlich seiner Typen, Bedeutung und realen Anwendungen. Erfahren Sie, wie KI menschliches Denken nachahmt,...

Eine detaillierte Analyse von LGs EXAONE Deep 32B Reasoning-Modell im Vergleich mit DeepSeek R1 und Alibabas QwQ, mit Überprüfung der Behauptungen über überlegene Leistung und tatsächliche Reasoning-Fähigkeiten.

Das Feld der KI-Reasoning-Modelle wird immer wettbewerbsintensiver, da verschiedene Organisationen Durchbrüche bei komplexen mathematischen und logischen Aufgaben beanspruchen. LGs kürzliche Veröffentlichung von EXAONE Deep, einem Reasoning-Modell mit 32 Milliarden Parametern, sorgte mit dem Anspruch, etablierte Konkurrenten wie DeepSeek R1 zu übertreffen, für großes Aufsehen. Die Realitätstests zeigen jedoch ein differenzierteres Bild als es die Marketingaussagen vermuten lassen. Dieser Artikel bietet eine detaillierte Analyse der tatsächlichen Leistung von EXAONE Deep im Vergleich mit anderen führenden Reasoning-Modellen und beleuchtet die Lücke zwischen behaupteten Benchmarks und praktischer Funktionalität. Durch praktische Tests und genaue Vergleiche untersuchen wir, was diese Modelle wirklich leisten können, wie sie komplexe Reasoning-Aufgaben bewältigen und was das für Unternehmen bedeutet, die solche Tools im Produktivbetrieb einsetzen möchten.

Das Aufkommen von Reasoning-Modellen stellt einen grundlegenden Wandel im Ansatz der künstlichen Intelligenz für komplexe Problemlösungen dar. Im Gegensatz zu herkömmlichen Sprachmodellen, die Antworten in einem einzigen Durchgang erzeugen, nutzen Reasoning-Modelle eine Technik namens Test-Time Decoding, bei der während der Inferenz erhebliche Rechenressourcen zugewiesen werden, um Probleme schrittweise zu durchdenken. Dieser Ansatz spiegelt das menschliche Denken wider, bei dem wir oft verschiedene Blickwinkel eines Problems durchgehen, bevor wir eine Lösung finden. Das Konzept wurde mit dem o1-Modell von OpenAI bekannt und ist seitdem von mehreren Organisationen wie DeepSeek, Alibaba und nun LG übernommen worden. Diese Modelle erzeugen eine sogenannte “Thinking”- oder “Reasoning”-Token-Sequenz, die Benutzer im Endergebnis meist nicht sehen, die aber den internen Denkprozess des Modells repräsentiert. Diese Denktokens sind entscheidend, da sie dem Modell erlauben, verschiedene Lösungswege zu erkunden, Fehler zu erkennen und den Ansatz zu verfeinern, bevor eine endgültige Antwort gegeben wird. Das ist besonders wertvoll für mathematische Aufgaben, logisches Schlussfolgern und komplexe Szenarien mit mehreren Schritten, bei denen ein einziger Durchgang wichtige Details übersehen oder zu falschen Schlüssen führen könnte.

Für Unternehmen, die KI-Systeme implementieren, bedeuten Reasoning-Modelle einen großen Fortschritt in Zuverlässigkeit und Genauigkeit bei komplexen Aufgaben. Herkömmliche Sprachmodelle haben oft Schwierigkeiten mit mehrstufigen mathematischen Problemen, logischem Schlussfolgern und Szenarien, die eine sorgfältige Analyse von Bedingungen und Einschränkungen erfordern. Reasoning-Modelle adressieren diese Schwächen, indem sie ihre Arbeitsweise explizit zeigen – was auch Transparenz darüber schafft, wie das Modell zu seinem Schluss gekommen ist. Diese Nachvollziehbarkeit ist vor allem in Unternehmen wichtig, in denen auf KI-Empfehlungen basierende Entscheidungen überprüfbar und erklärbar sein müssen. Der Nachteil ist jedoch ein höherer Rechenaufwand und eine längere Antwortzeit. Da Reasoning-Modelle vor der Endausgabe viele Denktokens generieren, benötigen sie mehr Rechenleistung und reagieren langsamer als herkömmliche Sprachmodelle. Daher ist die Modellauswahl entscheidend – Unternehmen müssen nicht nur Benchmark-Ergebnisse kennen, sondern die tatsächliche Praxisleistung für ihre eigenen Anwendungsfälle prüfen. Die Vielzahl von Reasoning-Modellen verschiedener Anbieter mit jeweils eigenen Leistungsansprüchen macht unabhängige Tests und Vergleiche zur Voraussetzung für fundierte Entscheidungen.

LGs Einstieg in den Reasoning-Modell-Markt mit EXAONE Deep weckte großes Interesse, zumal das Unternehmen über erhebliche Forschungskapazitäten verfügt und das Modell mit 32 Milliarden Parametern vergleichsweise kompakt ist. In LGs Marketingmaterialien wurden beeindruckende Benchmarkergebnisse präsentiert: EXAONE Deep habe 90 % Genauigkeit bei der AIME (American Invitational Mathematics Examination) mit nur 64 Versuchen und 95 % bei MATH-500-Problemen erreicht. Wären diese Zahlen korrekt, entspräche das einer Performance, die DeepSeek R1 und Alibabas QwQ ebenbürtig oder überlegen wäre. Das Unternehmen veröffentlichte zudem mehrere Modellvarianten, darunter auch ein 2,4-Milliarden-Parameter-Modell, das als Entwurfsmodell für Speculative Decoding dienen soll – eine Technik, bei der kleinere Modelle Token vorhersagen, die das große Modell generieren wird, um die Inferenz zu beschleunigen. Doch praktische Tests bei Standard-Reasoning-Aufgaben offenbarten besorgniserregendes Verhalten, das den Benchmarks widerspricht: Das Modell zeigte die Tendenz, in ausgedehnte Denkloops zu geraten, ohne zu logischen Schlussfolgerungen zu kommen – es wurden tausende Token generiert, die eher repetitiv oder unsinnig als produktiv schienen. Dies deutet auf Probleme bei der Modellausbildung, der Benchmark-Bewertung oder der Behandlung bestimmter Prompts hin.

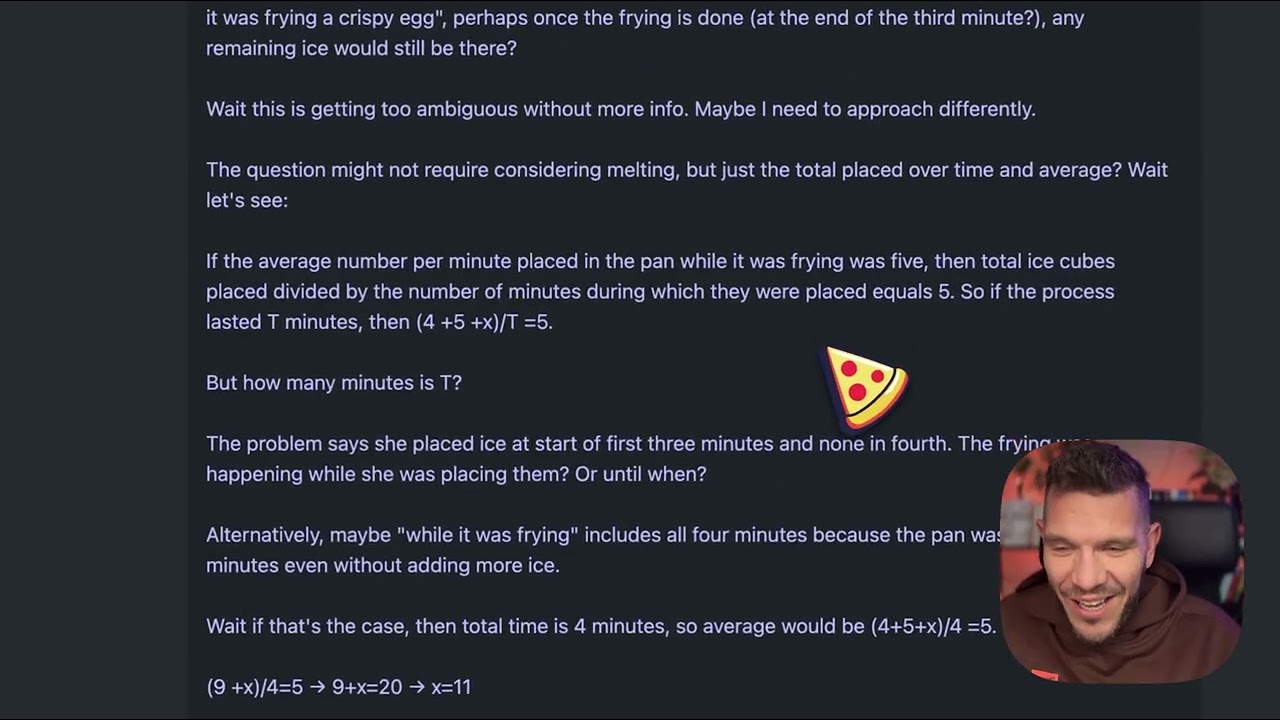

Um die praktischen Unterschiede zwischen Reasoning-Modellen zu verstehen, betrachten wir ein scheinbar einfaches Problem, das sich als Standardtest für die Qualität von Reasoning-Modellen etabliert hat: “Beth legt einige ganze Eiswürfel in eine Pfanne. Nach einer Minute sind es 20 Eiswürfel. Nach zwei Minuten sind es 10. Nach drei Minuten sind es 0. Wie viele ganze Eiswürfel befinden sich am Ende der dritten Minute in der Pfanne?” Die richtige Antwort ist null, da die Frage explizit nach ganzen Eiswürfeln am Ende der dritten Minute fragt und das Problem aussagt, dass es zu diesem Zeitpunkt null sind. Das Problem ist darauf ausgelegt, Modelle zu täuschen, die zu viel nachdenken oder sich von der Geschichte der schmelzenden Eiswürfel verwirren lassen. Einige Modelle versuchen, die Schmelzrate zu berechnen, und verlieren so den Bezug zur einfachen Lösung. EXAONE Deep generierte bei diesem Problem etwa 5.000 Denktokens, kam aber nie zu einer kohärenten Antwort. Der Reasoning-Prozess schien sich zu verlieren, der generierte Text wurde immer inkohärenter und zeigte kein logisches Problemlösen. Die Tokens enthielten unvollständige Gedanken, und das Modell formulierte nie einen klaren Lösungsweg oder eine Endantwort. Dieses Verhalten steht in deutlichem Gegensatz zum gewünschten Vorgehen: Ein Reasoning-Modell sollte den Trick erkennen, den Gedankengang klar durchlaufen und effizient zur Lösung gelangen.

Beim Test desselben Eiswürfel-Problems zeigten DeepSeek R1 und Alibabas QwQ-Modell deutlich bessere Ergebnisse. DeepSeek R1 stellte einen klaren Denkprozess dar, arbeitete die Aufgabe methodisch ab und kam zur richtigen Antwort: null. Die Argumentation war transparent und logisch, das Modell erkannte den Trick und entschied sich für die korrekte Lösung. Auch QwQ zeigte eine starke Leistung und generierte ebenfalls einen ausgedehnten Denkprozess. Interessanterweise überlegte QwQ zunächst, ob Eiswürfel Zeit zum Schmelzen brauchen und ob die Frage physikalisch oder mathematisch gemeint sei, kam aber dennoch zur richtigen Antwort. Entscheidend war, dass beide Modelle im gesamten Denkprozess kohärent blieben, selbst wenn sie verschiedene Ansätze prüften. Sie zeigten die Fähigkeit, zu erkennen, wann sie genug Informationen für die Antwort hatten, und legten sich dann fest. EXAONE Deep dagegen erreichte diesen Punkt nie – das Modell generierte weiterhin Token ohne erkennbaren Zweck, kam nie zu einer Antwort oder klaren logischen Entwicklung. Dies deutet auf grundlegende Schwächen im Umgang mit Reasoning-Aufgaben hin, trotz der beeindruckenden Benchmarks.

Ein interessanter technischer Aspekt bei der Veröffentlichung von EXAONE Deep ist die Einbindung mehrerer Modellgrößen, die gemeinsam via Speculative Decoding arbeiten. Die 2,4-Milliarden-Parameter-Version kann als Entwurfsmodell dienen, das Token vorhersagt, welche das größere 32-Milliarden-Modell generieren wird. Stimmen die Vorhersagen des Entwurfsmodells mit den tatsächlichen Ausgaben des Hauptmodells überein, kann auf die teure Hauptmodell-Berechnung verzichtet und die Entwurfsvorhersage genutzt werden – was die Inferenz effektiv beschleunigt. Dies ist eine fortschrittliche Optimierung, die Latenz und Rechenaufwand deutlich senken kann. Im Test zeigte die Speculative-Decoding-Implementierung grüne Tokens für erfolgreiche Entwurfsvorhersagen, was auf eine funktionierende Technik hindeutet. Allerdings behebt diese Optimierung nicht das Grundproblem der Qualität des Reasonings im Hauptmodell. Schnellere Inferenz bei schlechter Argumentation bleibt schlechte Argumentation. Die Existenz dieses Features wirft auch Fragen auf, ob LGs Benchmarkergebnisse vielleicht mit Konfigurationen oder Techniken erzielt wurden, die in der Praxis nicht übertragbar sind.

Für Unternehmen, die Schwierigkeiten haben, mehrere KI-Modelle zu vergleichen, bietet FlowHunt eine umfassende Automatisierungsplattform, um den Test- und Benchmark-Prozess zu vereinfachen. Statt Tests manuell auf verschiedenen Modellen durchzuführen und Ergebnisse zu vergleichen, ermöglicht FlowHunt Teams, automatisierte Workflows einzurichten, die die Modellleistung systematisch in mehreren Dimensionen bewerten. Das ist besonders wertvoll beim Vergleich von Reasoning-Modellen, deren Performance je nach Problemtyp, Komplexität und Prompt-Formulierung stark variieren kann. Mit den Automatisierungsfunktionen von FlowHunt können Teams Modelle mit standardisierten Problemsets testen, Leistungsmetriken über die Zeit verfolgen und umfassende Vergleichsberichte erstellen. Die Plattform lässt sich mit mehreren Modellanbietern und APIs integrieren, sodass Modelle unterschiedlicher Anbieter in einem einheitlichen Workflow bewertet werden können. Für Teams, die Reasoning-Modelle wie EXAONE Deep, DeepSeek R1 oder QwQ einsetzen möchten, bietet FlowHunt die Infrastruktur für faktenbasierte Entscheidungen auf Basis realer Leistung statt reiner Anbieterangaben. Die Automatisierung repetitiver Testaufgaben entlastet zudem die Entwickler, sodass sie sich auf Integration und Optimierung konzentrieren können.

Die Lücke zwischen den behaupteten Leistungen von EXAONE Deep und dem tatsächlichen Verhalten im Test unterstreicht eine zentrale Lektion für die KI-Nutzung: Anbieter-Benchmarks sollten immer durch unabhängige Tests überprüft werden. Benchmarks können durch viele Faktoren beeinflusst werden, darunter das verwendete Testset, die Bewertungsmethodik, die Hardware-Konfiguration und die Inferenzparameter des Modells. Ein Modell kann auf einem bestimmten Benchmark gut abschneiden, aber bei anderen Aufgaben oder realen Szenarien Schwierigkeiten haben. Deshalb spielen Organisationen wie Weights & Biases und unabhängige Forscher eine so wichtige Rolle im KI-Ökosystem – sie liefern objektive Tests und Analysen, die der Community helfen zu verstehen, was Modelle wirklich können. Bei der Bewertung von Reasoning-Modellen für den Produktiveinsatz sollten Unternehmen eigene Tests mit repräsentativen Problemsets aus ihrem Anwendungsbereich durchführen. Ein Modell, das bei mathematischem Reasoning glänzt, kann bei logischem Schlussfolgern oder Codegenerierung schwächeln. Das Eiswürfel-Problem mag einfach erscheinen, dient aber als nützlicher Diagnosetest, weil es zeigt, ob ein Modell Trickfragen bewältigt und Überdenken vermeidet. Modelle, die hier scheitern, werden auch bei komplexeren Reasoning-Aufgaben Probleme haben.

Die beobachteten Denkloops von EXAONE Deep könnten verschiedene Ursachen haben. Eine Möglichkeit ist, dass das Training nicht ausreichend vermittelt hat, wann das Modell das Denken beenden und eine Antwort geben soll. Reasoning-Modelle brauchen während des Trainings eine sorgfältige Kalibrierung, um das Gleichgewicht zwischen ausgedehntem Denken und dem Risiko des Überdenkens zu finden. Wenn im Training zu wenige Beispiele für einen Abbruch enthalten waren, generiert das Modell womöglich Token bis zum Maximum. Eine andere Möglichkeit sind Schwächen im Prompt-Handling, insbesondere, wie das Modell bestimmte Fragetypen oder Anweisungen interpretiert. Manche Modelle reagieren empfindlich auf bestimmte Prompt-Formulierungen und verhalten sich je nach Fragestellung unterschiedlich. Die Tatsache, dass EXAONE Deep inkohärente Token-Sequenzen erzeugte, deutet darauf hin, dass es in einen Zustand gerät, in dem Token ohne sinnvollen Inhalt generiert werden – was auf Probleme mit den Attention-Mechanismen oder der Token-Vorhersage hindeuten könnte. Eine dritte Möglichkeit ist, dass die Benchmark-Methodik andere Konfigurationen oder Prompt-Strategien verwendete als die realen Tests, was zu einer deutlichen Diskrepanz zwischen gemeldeter und tatsächlicher Leistung führt.

Die bei EXAONE Deep beobachteten Leistungsprobleme haben weitreichende Folgen für den Reasoning-Modellmarkt. Mit jeder neuen Veröffentlichung steigt das Risiko, dass der Markt mit Modellen überschwemmt wird, die zwar beeindruckende Benchmarks aufweisen, aber in der Praxis fragwürdig sind. Das erschwert Organisationen die Auswahl für den Produktiveinsatz. Die Lösung ist ein verstärkter Fokus auf unabhängige Tests, standardisierte Bewertungsmethoden und Transparenz über die Schwächen von Modellen. Der Reasoning-Modellbereich würde von branchenweiten Standards für Bewertung und Vergleich profitieren, ähnlich wie sich Benchmarks in anderen KI-Bereichen etabliert haben. Unternehmen sollten auch bei Modellen, die angeblich weit besser sind als etablierte Konkurrenten, vorsichtig sein – insbesondere, wenn der Vorsprung nicht zur Architektur oder zum Trainingsansatz passt. DeepSeek R1 und QwQ haben in mehreren Testszenarien konstante Leistungen gezeigt, was Vertrauen in ihre Fähigkeiten schafft. EXAONE Deeps inkonsistente Performance – exzellente Benchmarks, aber schwache Praxisergebnisse – lässt entweder auf Modellprobleme oder auf fragwürdige Benchmark-Methoden schließen.

Erleben Sie, wie FlowHunt Ihre KI-Content- und SEO-Workflows automatisiert – von Recherche und Content-Erstellung über Veröffentlichung bis zu Analytics – alles an einem Ort.

Unternehmen, die Reasoning-Modelle einsetzen möchten, sollten einen strukturierten Bewertungsprozess befolgen. Erstens: Erstellen Sie ein repräsentatives Testset mit Aufgaben aus Ihrem spezifischen Anwendungsbereich. Generische Benchmarks spiegeln nicht zwangsläufig die Praxistauglichkeit für Ihre Probleme wider. Zweitens: Testen Sie mehrere Modelle an denselben Aufgaben, um direkte Vergleiche zu ermöglichen – das setzt eine Standardisierung von Testumgebung, Hardware, Inferenzparametern und Prompt-Formulierung voraus. Drittens: Bewerten Sie nicht nur die Genauigkeit, sondern auch Effizienzmetriken wie Latenz und Token-Generierung. Ein Modell, das zwar richtige Antworten liefert, dafür aber 10.000 Denktokens braucht, ist für produktive Echtzeitanwendungen ungeeignet. Viertens: Untersuchen Sie den Reasoning-Prozess des Modells, nicht nur die Endantwort. Ein Modell, das zwar richtig antwortet, aber mit fehlerhafter Argumentation dorthin gelangt, wird bei ähnlichen, aber leicht veränderten Problemen versagen. Fünftens: Testen Sie Randfälle und Trickfragen, um zu sehen, wie das Modell mit verwirrenden Szenarien umgeht. Zuletzt: Berücksichtigen Sie die Gesamtkosten, also nicht nur Lizenz- oder API-Kosten, sondern auch den Rechenaufwand für die Inferenz sowie den Integrationsaufwand.

Mit 32 Milliarden Parametern ist EXAONE Deep deutlich kleiner als einige konkurrierende Reasoning-Modelle, was die Frage aufwirft, ob die Probleme auf zu geringe Kapazität zurückgehen. Allerdings bestimmt die Modellgröße allein nicht die Reasoning-Fähigkeit. QwQ, das in einer ähnlichen Größenordnung arbeitet, zeigt starke Reasoning-Qualitäten. Das spricht dafür, dass EXAONE Deeps Probleme eher mit Trainingsmethodik, Architekturdesign oder Inferenzkonfiguration zusammenhängen als mit der Modellgröße an sich. Die Integration eines 2,4-Milliarden-Parameter-Entwurfsmodells in die EXAONE-Deep-Veröffentlichung zeigt, dass LG das Thema Effizienz im Blick hat – das ist grundsätzlich lobenswert. Effizienzgewinne sind jedoch nur dann wertvoll, wenn das Grundmodell korrekte Ergebnisse liefert. Eine schnelle falsche Antwort ist für die meisten Einsätze schlechter als eine langsame richtige. Der Reasoning-Modellmarkt wird auch künftig Wert auf Effizienz legen, da Unternehmen diese Modelle skalieren möchten – diese Optimierung darf aber nicht auf Kosten der Reasoning-Qualität gehen.

Der Reasoning-Modellbereich steckt noch in den Kinderschuhen, und es ist mit erheblichen Entwicklungen in den kommenden Monaten und Jahren zu rechnen. Mit jeder neuen Veröffentlichung und mehr unabhängigen Tests wird sich der Markt auf Modelle mit konsistenter, zuverlässiger Leistung konzentrieren. Unternehmen wie DeepSeek und Alibaba haben sich durch konstante Performance Glaubwürdigkeit erarbeitet, während neuere Anbieter wie LG die beobachteten Leistungsprobleme adressieren müssen, um akzeptiert zu werden. Auch bei Training und Bewertung von Reasoning-Modellen ist mit Innovation zu rechnen. Das aktuelle Vorgehen, viele Denktokens zu generieren, ist zwar effektiv, aber rechenintensiv. Künftige Modelle könnten effizientere Reasoning-Mechanismen entwickeln, die mit weniger Token ähnliche Genauigkeit erreichen. Zudem ist mit einer stärkeren Spezialisierung zu rechnen – Reasoning-Modelle, die auf spezielle Bereiche wie Mathematik, Codegenerierung oder logisches Schlussfolgern optimiert sind. Die Integration von Reasoning-Modellen mit anderen KI-Techniken wie Retrieval-Augmented Generation oder Tool-Use wird ihre Fähigkeiten und Einsatzmöglichkeiten weiter ausbauen.

LGs EXAONE Deep ist ein ambitionierter Einstieg in den Reasoning-Modellmarkt, doch zeigen Praxistests deutliche Lücken zwischen den behaupteten Leistungen und den tatsächlichen Fähigkeiten. Während die Benchmarks eine konkurrenzfähige Performance mit DeepSeek R1 und Alibabas QwQ nahelegen, zeigen praktische Tests bei Standard-Reasoning-Problemen, dass EXAONE Deep bereits an Grundaufgaben scheitert – es werden zu viele Token generiert, ohne zu schlüssigen Ergebnissen zu kommen. DeepSeek R1 und QwQ zeigten bei denselben Aufgaben überlegene Leistungen und fanden durch klare, logische Gedankengänge zur richtigen Antwort. Für Unternehmen, die Reasoning-Modelle für den Produktiveinsatz evaluieren, unterstreicht diese Analyse die entscheidende Bedeutung unabhängiger Tests und Verifikationen. Anbieter-Benchmarks sollten als Ausgangspunkt für die Bewertung gesehen werden, nicht als endgültiges Maß für die Modelltauglichkeit. Der Reasoning-Modellmarkt wird von mehr Transparenz, standardisierten Bewertungsmethoden und kontinuierlichen unabhängigen Tests profitieren. Mit dem Fortschreiten der Technologie werden Unternehmen, die in eine rigorose Modellauswahl und Vergleichsprozesse investieren, besser in der Lage sein, Reasoning-Modelle auszuwählen und zu implementieren, die echten Mehrwert für ihre spezifischen Anwendungsfälle liefern.

EXAONE Deep ist ein Reasoning-Modell mit 32 Milliarden Parametern, das von LG entwickelt wurde und Test-Time Decoding verwendet, um komplexe Probleme zu lösen. Im Gegensatz zu Standard-Sprachmodellen teilt es während der Inferenz Rechenressourcen zu, um Probleme Schritt für Schritt zu durchdenken – ähnlich wie DeepSeek R1 und Alibabas QwQ-Modelle.

Bei praktischen Tests zu Reasoning-Aufgaben wie dem Eiswürfel-Problem zeigte EXAONE Deep erhebliche Probleme mit Überdenken und der Generierung übermäßiger Token, ohne zu logischen Schlussfolgerungen zu gelangen. DeepSeek R1 und QwQ schnitten beide besser ab und kamen effizienter zu korrekten Antworten.

Test-Time Decoding ist eine Technik, bei der KI-Modelle während der Inferenz mehr Rechenressourcen zuweisen, um komplexe Probleme zu durchdenken. So zeigen Modelle ihren Denkprozess und gelangen zu genaueren Antworten – allerdings erfordert dies eine sorgfältige Kalibrierung, um Überdenken zu vermeiden.

FlowHunt automatisiert den Workflow zur Prüfung, zum Vergleich und zur Bewertung mehrerer KI-Modelle. Teams können so die Performance systematisch benchmarken, Metriken verfolgen und datenbasierte Entscheidungen darüber treffen, welche Modelle für bestimmte Anwendungsfälle eingesetzt werden sollen.

Arshia ist eine AI Workflow Engineerin bei FlowHunt. Mit einem Hintergrund in Informatik und einer Leidenschaft für KI spezialisiert sie sich darauf, effiziente Arbeitsabläufe zu entwickeln, die KI-Tools in alltägliche Aufgaben integrieren und so Produktivität und Kreativität steigern.

Nutzen Sie FlowHunt, um Ihre KI-Modell-Tests, Vergleiche und Performance-Tracking-Workflows mit intelligenter Automatisierung zu optimieren.

Erkunden Sie die Grundlagen des KI-Reasonings, einschließlich seiner Typen, Bedeutung und realen Anwendungen. Erfahren Sie, wie KI menschliches Denken nachahmt,...

Erkunden Sie die Welt der KI-Agentenmodelle mit einer umfassenden Analyse von 20 fortschrittlichen Systemen. Erfahren Sie, wie sie denken, schlussfolgern und be...

Benchmarking von KI-Modellen ist die systematische Bewertung und der Vergleich von Modellen der künstlichen Intelligenz anhand standardisierter Datensätze, Aufg...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.