Einleitung

Der Weg von einem funktionierenden KI-Prototypen bis hin zu einem produktionsreifen System gehörte schon immer zu den größten Herausforderungen bei der Entwicklung künstlicher Intelligenz. Was in Demos oft als geradliniger Prozess erscheint – relevante Informationen abrufen, Prompts anreichern und Antworten generieren – wird in produktiven Umgebungen exponentiell komplexer. Diese Komplexität führte dazu, dass viele in der Branche eher von „Alchemie“ als von Ingenieurskunst sprechen: Ein geheimnisvoller Prozess, bei dem Entwickler Konfigurationen anpassen, Parameter verändern und hoffen, dass ihre Systeme weiterhin zuverlässig funktionieren. Das Aufkommen des Context Engineering als Disziplin markiert einen grundlegenden Wandel im Ansatz zum Bau von KI-Systemen – weg von Versuch-und-Irrtum hin zu einer systematischen, ingenieurmäßigen Herangehensweise. In dieser umfassenden Analyse untersuchen wir, wie moderne Vektordatenbanken und Prinzipien des Context Engineering die Entwicklung von KI-Anwendungen transformieren – und Teams ermöglichen, Systeme zu bauen, die nicht nur funktionieren, sondern auch im großen Maßstab wirklich zuverlässig und wartbar sind.

Was ist Context Engineering und warum ist es wichtig?

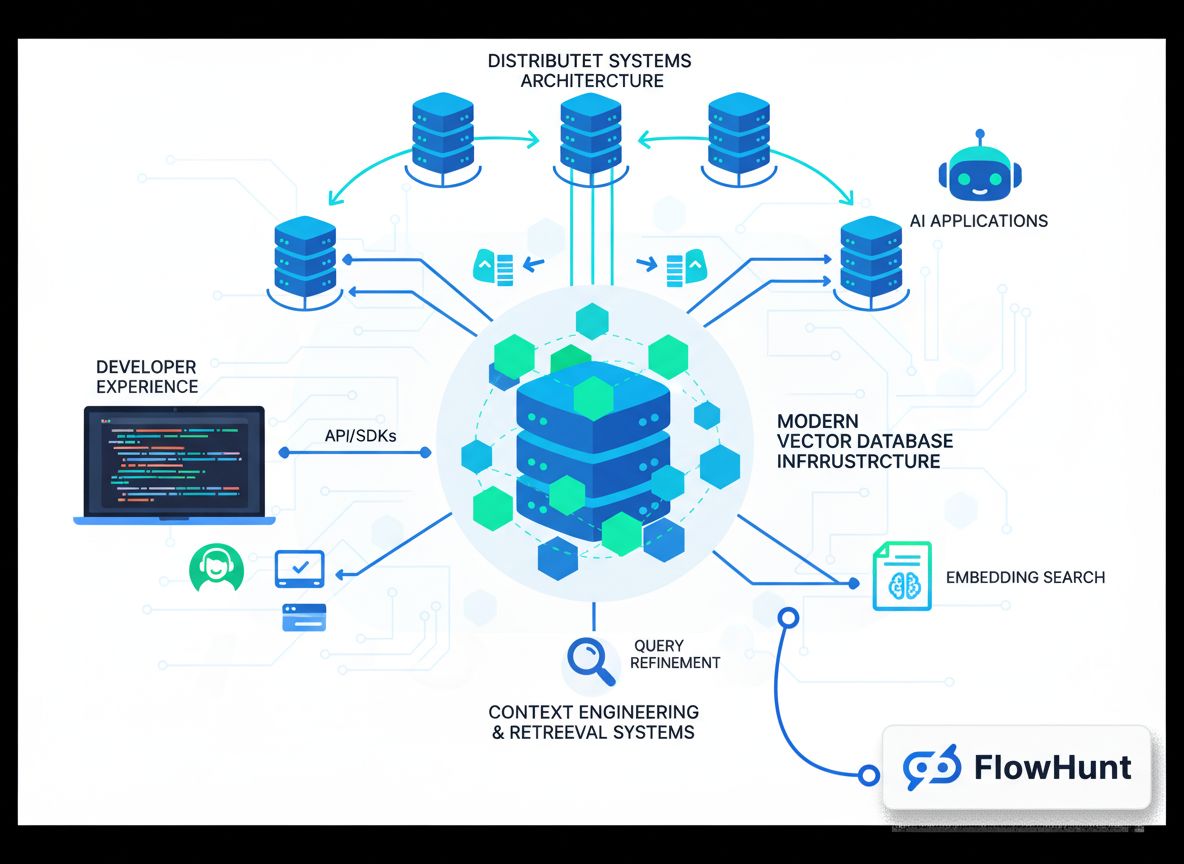

Context Engineering hat sich zu einer der wichtigsten Disziplinen in der modernen KI-Entwicklung entwickelt, wird von vielen neuen Entwicklern jedoch weiterhin wenig verstanden. Im Kern ist Context Engineering die systematische Verwaltung, Organisation und Optimierung jener kontextuellen Informationen, die KI-Systeme für Entscheidungen und die Generierung von Ergebnissen verwenden. Anders als das traditionelle Retrieval-Augmented Generation (RAG), das sich eng darauf konzentriert, relevante Dokumente zur Anreicherung eines Prompts abzurufen, bevor dieser an ein Sprachmodell gesendet wird, betrachtet Context Engineering die gesamte Pipeline umfassend. Es umfasst, wie Daten durchs System fließen, wie Informationen gespeichert und indexiert werden, wie das Retrieval geschieht, wie Ergebnisse gerankt und gefiltert werden und letztlich, wie dieser Kontext dem Modell präsentiert wird. Diese ganzheitliche Perspektive erkennt, dass die Qualität der Ausgabe eines KI-Systems grundlegend durch die Qualität und Relevanz des gelieferten Kontexts begrenzt ist. Wird Kontext schlecht verwaltet – wenn irrelevante Informationen abgerufen werden, wichtige Details fehlen oder dieselben Informationen mehrfach verarbeitet werden – leidet das gesamte System. Context Engineering begegnet diesen Herausforderungen, indem das Kontextmanagement als erstklassiges Ingenieursproblem betrachtet wird, das der gleichen Sorgfalt und Aufmerksamkeit bedarf wie andere kritische Infrastrukturen.

Die Bedeutung von Context Engineering wird sofort deutlich, wenn man das Ausmaß betrachtet, in dem moderne KI-Systeme operieren. Ein Sprachmodell kann gebeten werden, Hunderttausende Dokumente zu verarbeiten, Informationen aus verschiedenen Quellen zu synthetisieren und darauf basierende, kohärente Antworten zu generieren. Ohne korrektes Context Engineering wird dieser Prozess chaotisch. Irrelevante Dokumente verstopfen das Kontextfenster, wichtige Informationen gehen im Rauschen unter und die Modellleistung sinkt. Zudem steigen die Risiken schlechter Kontextverwaltung, je mehr KI-Systeme in kritische Anwendungen wie Kundenservice, medizinische Diagnosen oder Finanzanalysen eingesetzt werden. Ein System, das gelegentlich irrelevante Informationen liefert, mag im Unterhaltungsbereich akzeptabel sein – nicht aber, wenn es um lebenswichtige oder wirtschaftlich relevante Entscheidungen geht. Context Engineering stellt sicher, dass Informationen im System nicht nur reichlich vorhanden, sondern wirklich relevant, richtig organisiert und für die jeweilige Aufgabe optimiert sind.

Bereit, Ihr Geschäft zu erweitern?

Starten Sie heute Ihre kostenlose Testversion und sehen Sie innerhalb weniger Tage Ergebnisse.

Die Entwicklung von der Demo bis zur Produktion: Das Alchemie-Problem

Eine der hartnäckigsten Herausforderungen in der KI-Entwicklung wird von Brancheninsidern als „Demo-to-Production Gap“ bezeichnet. Einen funktionierenden Prototypen zu bauen, der die Fähigkeiten von KI demonstriert, ist relativ einfach. Ein Entwickler kann schnell ein Sprachmodell mit einem einfachen Retrieval-System koppeln und etwas Beeindruckendes in einer kontrollierten Umgebung zeigen. Doch sobald dieses System reale Daten im großen Maßstab verarbeiten, über längere Zeit zuverlässig funktionieren und sich an wandelnde Anforderungen anpassen muss, wird alles dramatisch schwieriger. Diese Lücke wurde historisch mit dem überbrückt, was nur als Alchemie bezeichnet werden kann – eine geheimnisvolle Mischung aus Konfigurationstricks, Parameteranpassungen und empirischem Versuch-und-Irrtum, die irgendwie zu einem funktionierenden System führt. Das Problem bei diesem Ansatz: Er ist weder reproduzierbar noch skalierbar oder wartbar. Wenn in der Produktion etwas ausfällt, ist oft unklar, warum – und die Korrektur erfordert denselben undurchsichtigen Prozess erneut.

Die Ursache dieses Alchemie-Problems liegt darin, dass die meisten KI-Infrastrukturen ursprünglich nicht für produktive Umgebungen konzipiert wurden. Frühe Vektordatenbanken und Retrieval-Systeme sollten vor allem die Machbarkeit von semantischer Suche und Embedding-basiertem Retrieval demonstrieren. Sie funktionierten gut in kontrollierten Umgebungen mit kleinen Datensätzen und vorhersehbaren Abfragen. Doch im großtechnischen Maßstab – Millionen von Dokumenten, Tausende gleichzeitige Nutzer, unvorhersehbare Abfragen – brechen sie oft zusammen. Datenkonsistenz wird zum Problem, die Abfrageperformance sinkt, das System ist schwer zu debuggen und zu überwachen. Entwickler sehen sich eher als Betreiber eines fragilen Artefakts denn als Ingenieure eines Systems – das Funktionieren basiert auf Glück und ständiger Intervention. Hier setzt modernes Context Engineering und speziell entwickelte Infrastruktur an: Die Reise von der Demo bis zur Produktion wird als echte ingenieurmäßige Herausforderung betrachtet, Systeme werden gezielt für Produktions-Workloads gebaut und Alchemie wird durch Ingenieurskunst ersetzt.

Moderne Suchinfrastruktur für KI verstehen

Traditionelle Suchinfrastruktur – wie sie z. B. Google & Co. nutzen – wurde mit klaren Annahmen über die Nutzung gebaut. Diese Systeme waren für schlagwortbasierte Suchanfragen menschlicher Nutzer konzipiert, die die Ergebnisse betrachten und entscheiden, welchen Link sie anklicken. Die Infrastruktur wurde entsprechend optimiert: schnelle Keyword-Suche, Ranking-Algorithmen für menschliche Relevanzbewertungen und Ergebnisdarstellung als „zehn blaue Links“, die Menschen schnell überblicken können. KI-Systeme hingegen haben komplett andere Anforderungen. Wenn ein Sprachmodell Suchergebnisse konsumiert, betrachtet es nicht zehn Links – es kann Größenordnungen mehr Informationen verarbeiten. Es braucht keine für Menschen aufbereitete Ergebnisse, sondern strukturierte Daten, mit denen es weiterarbeiten kann. Die Abfragen sind nicht schlagwortbasiert, sondern semantisch, basieren auf Embeddings und Vektorähnlichkeit. All diese Unterschiede machen klassische Suchinfrastruktur für KI-Anwendungen ungeeignet.

Moderne Suchinfrastruktur für KI begegnet diesen Unterschieden auf mehreren Ebenen. Erstens sind die Tools und Technologien grundlegend verschieden: Statt Keyword-Indizes und für Menschen optimierten Algorithmen werden Embeddings und semantische Ähnlichkeitsmaße verwendet. Anstelle expliziter Schlagwörter wird die Bedeutung und Intention hinter einer Anfrage verstanden. Zweitens sind die Arbeitslastmuster andere: Klassische Suchsysteme bearbeiten einfache Abfragen mit wenigen Treffern, KI-Systeme müssen oft Hunderte oder Tausende Dokumente abrufen und komplex verarbeiten. Drittens haben die Entwickler andere Anforderungen: KI-Entwickler brauchen einfach zu integrierende Systeme mit guter Developer Experience, die keine tiefen Such-Infrastruktur-Kenntnisse erfordern. Schließlich ist der Konsument der Suchergebnisse ein anderer: Während bei klassischer Suche Menschen die Relevanz bewerten und Informationen synthetisieren, übernimmt bei KI-Systemen das Sprachmodell diese Arbeit – und kann dabei um ein Vielfaches mehr Informationen verarbeiten als ein Mensch. Diese fundamentale Änderung beeinflusst das Design der gesamten Infrastruktur.

Abonnieren Sie unseren Newsletter

Erhalten Sie die neuesten Tipps, Trends und Angebote kostenlos.

FlowHunt und die Zukunft der automatisierten KI-Workflows

Da Unternehmen zunehmend die Bedeutung von Context Engineering und moderner Suchinfrastruktur erkennen, stellt sich die Herausforderung, diese Fähigkeiten in bestehende Workflows und Entwicklungsprozesse zu integrieren. An dieser Stelle kommen Plattformen wie FlowHunt ins Spiel: Sie bieten eine einheitliche Umgebung für den Bau, das Testen und die Bereitstellung von KI-Anwendungen, die auf fortgeschrittenem Kontextmanagement und Retrieval-Systemen basieren. FlowHunt erkennt an, dass Context Engineering nicht nur die richtige Datenbank erfordert, sondern die passenden Tools und Workflows, um Kontext während des gesamten KI-Entwicklungszyklus zu verwalten. Von der Datenaufnahme und -indexierung über das Retrieval und Ranking bis hin zur Modellausgabe muss jeder Schritt orchestriert und überwacht werden. FlowHunt automatisiert diese Orchestrierung und ermöglicht es Entwicklern, sich auf die eigentliche KI-Anwendung zu konzentrieren, statt auf Infrastrukturdetails.

Gerade für Teams, die mehrere KI-Anwendungen entwickeln oder komplexe, mehrstufige Retrieval-Pipelines verwalten müssen, ist der Automatisierungsansatz von FlowHunt wertvoll. Statt für jede Anwendung individuelle Infrastruktur zu bauen, können Teams auf vorgefertigte Komponenten und Workflows von FlowHunt zurückgreifen und so die Entwicklung beschleunigen. Die Plattform übernimmt die mühsame Arbeit von Datenaufnahme, Embedding-Erstellung, Indexmanagement und Retrieval-Orchestrierung – Entwickler können sich auf die Einzigartigkeit ihrer Anwendung konzentrieren. Darüber hinaus bietet FlowHunt Transparenz und Monitoring, sodass der Kontextfluss im System nachvollziehbar und Optimierungen einfach möglich sind. Diese Kombination aus Automatisierung und Sichtbarkeit macht aus Context Engineering eine systematische, messbare Disziplin.

Die Architektur produktionsreifer Vektordatenbanken

Eine Vektordatenbank, die in einer Demo funktioniert, aufzubauen ist das eine – eine, die produktive Workloads zuverlässig bedient, das andere. Produktionsreife Vektordatenbanken müssen mehrere gleichzeitige Nutzer unterstützen, Datenkonsistenz wahren, zuverlässige Persistenz bieten und mit wachsendem Datenvolumen skalieren. Sie müssen bei Problemen debuggt, überwacht und gewartet werden können, sodass Teams die Systeme weiterentwickeln können. Diese Anforderungen führten zur Entwicklung moderner Architekturen, die Prinzipien verteilter Systeme übernehmen, die sich über Jahrzehnte in der Praxis bewährt haben.

Eines der wichtigsten Prinzipien ist die Trennung von Speicher und Rechenleistung. In klassischen monolithischen Datenbanken sind Speicherung und Verarbeitung eng gekoppelt – derselbe Server speichert Daten und beantwortet Anfragen. Das führt im großen Maßstab zu Problemen: Mehr Rechenleistung erfordert mehr Speicher und umgekehrt, was ineffizient und teuer ist. Durch die Trennung von Speicher und Compute können moderne Vektordatenbanken beides unabhängig skalieren. Speicher wird über günstigen Objektspeicher wie Amazon S3 verwaltet, Compute-Ressourcen werden je nach Bedarf skaliert. Das sorgt für Flexibilität und Kosteneffizienz. Ein weiteres zentrales Prinzip ist Multi-Tenancy: Eine Instanz kann sicher mehrere unabhängige Anwendungen oder Teams bedienen – vorausgesetzt, Daten und Abfragen sind sauber isoliert. Richtig umgesetzt, verbessert das die Ressourcenauslastung und senkt die Betriebskomplexität massiv.

Moderne Vektordatenbanken setzen auch weitere Prinzipien verteilter Systeme um, wie Lese-/Schreib-Trennung (jeweils optimierte Komponenten für Lesen und Schreiben), asynchrone Replikation (Datensicherheit ohne Performanceeinbußen beim Schreiben) und Konsensmechanismen zur Konsistenz über mehrere Knoten hinweg. In Kombination mit modernen Programmiersprachen wie Rust, die Performance und Sicherheit bieten, erreichen Vektordatenbanken die nötige Zuverlässigkeit und Geschwindigkeit für die Produktion. Das Resultat ist Infrastruktur, die sich wie Ingenieurskunst – nicht wie Alchemie – anfühlt.

Chromas Ansatz für Developer Experience

Als Chroma gegründet wurde, war das Team von einer klaren These überzeugt: Die Lücke zwischen Demo und Produktion fühlte sich mehr nach Alchemie als nach Ingenieurskunst an – und genau diese Lücke wollte man schließen. Der Ansatz: kompromisslose Fokussierung auf Developer Experience. Nicht das Feature-reichste oder skalierbarste System sollte gebaut werden, sondern eines, das Entwicklern den Einstieg in Vektordatenbanken und semantische Suche extrem einfach macht. So entstand eines der auffälligsten Features: Chroma kann mit einem einzigen pip-Befehl installiert und sofort ohne komplexe Konfiguration genutzt werden. Diese Einfachheit war revolutionär im Bereich der Vektordatenbanken – bei anderen Systemen musste erst aufwendig konfiguriert werden, bevor überhaupt eine Basisabfrage möglich war. Chroma beseitigte diese Reibung und ermöglichte Entwicklern, in Minuten statt Stunden oder Tagen mit Vektordatenbanken und semantischer Suche zu experimentieren.

Das Bekenntnis zur Developer Experience ging weit über das Onboarding hinaus. Das Chroma-Team investierte intensiv in die Zuverlässigkeit des Systems über verschiedene Architekturen und Deployment-Umgebungen hinweg. Nutzer berichteten, Chroma auf allem von Standard-Linux-Servern über Arduinos bis PowerPC-Architekturen einzusetzen. Diese Fälle wurden nicht als Randerscheinungen abgetan – das Team sorgte dafür, dass das System überall zuverlässig lief. Diese Haltung zu Kompatibilität und Zuverlässigkeit schuf Vertrauen in der Entwicklercommunity und trug zur schnellen Verbreitung bei. Developer Experience bedeutet hier nicht nur einfache Bedienung, sondern auch Zuverlässigkeit, Konsistenz und das Vertrauen, dass das System in allen Umgebungen wie erwartet funktioniert.

Mit der Weiterentwicklung von Chroma und dem Aufbau von Chroma Cloud stand das Team vor einer wichtigen Entscheidung: Man hätte eine gehostete Version des Single-Node-Produkts schnell veröffentlichen und vom Markttrend profitieren können – wie viele andere. Doch das Team entschied sich bewusst dagegen. Das reine Bereitstellen des Single-Node-Produkts als Service genügte nicht dem eigenen Anspruch an Developer Experience. Ein wirklich gutes Cloud-Produkt muss von Grund auf cloud-native gebaut sein und dieselbe Einfachheit und Zuverlässigkeit wie das Einzelprodukt bieten – ergänzt um die Skalierbarkeit und Zuverlässigkeit, die produktive Systeme benötigen. Diese Entscheidung bedeutete mehr Entwicklungszeit, führte aber zu einem Produkt, das den Anspruch, Context Engineering als Ingenieurskunst statt Alchemie zu ermöglichen, auch in der Cloud wirklich erfüllt.

Die vier Dimensionen von „KI“ in moderner Suchinfrastruktur

Beim Thema moderne Suchinfrastruktur für KI ist wichtig zu erkennen, dass „KI“ in unterschiedlichen Kontexten Unterschiedliches bedeutet. Tatsächlich gibt es vier Dimensionen, in denen sich moderne Suchinfrastruktur von klassischen Systemen unterscheidet – und das Verständnis dieser Dimensionen ist entscheidend für erfolgreiche KI-Anwendungen. Die erste Dimension ist die technologische: Die verwendeten Tools und Technologien unterscheiden sich grundlegend von traditionellen Systemen. Statt invertierter Indizes und Keyword-Matching kommen Vektor-Embeddings und semantische Ähnlichkeit zum Einsatz, statt TF-IDF-Algorithmen neuronale Netze und lernende Rankingfunktionen. Diese technologischen Unterschiede spiegeln die veränderte Problemstellung und die Fähigkeiten moderner KI wider.

Die zweite Dimension sind Arbeitslastmuster: Klassische Suchsysteme sind für einfache, zustandslose Anfragen mit wenigen Treffern gebaut. Moderne KI-Systeme müssen komplexe, mehrstufige Retrieval-Pipelines mit mehrfachen Runden von Ranking und Filterung bedienen – oft tausende Dokumente abrufen und verarbeiten. Das erfordert ganz anders konzipierte Infrastruktur. Die dritte Dimension ist der Entwickler: Während klassische Suchsysteme von spezialisierten Suchingenieuren mit tiefem Infrastrukturwissen gebaut wurden, sind moderne KI-Entwickler oft Generalisten, die zwar keine Experten für Suchinfrastruktur sind, aber dennoch anspruchsvolle Retrieval-Funktionen brauchen. Daher muss moderne Suchinfrastruktur einfach nutzbar und zugänglich sein, nicht nur leistungsfähig und flexibel.

Die vierte und vielleicht wichtigste Dimension ist der Konsument der Suchergebnisse. Früher waren das Menschen, die nur eine begrenzte Zahl von Treffern aufnehmen und die eigentliche Synthese leisten konnten. In modernen KI-Systemen sind Sprachmodelle die Konsumenten – sie können Hunderte oder Tausende Dokumente gleichzeitig verarbeiten und daraus Informationen synthetisieren. Diese grundlegende Änderung hat Einfluss auf das gesamte Design: Ranking-Algorithmen können auf Maschinen- statt Menschenkonsum optimiert werden, Ergebnisse werden für maschinelle Weiterverarbeitung statt menschliche Lesbarkeit aufbereitet, und die Pipeline kann so gestaltet werden, dass ein KI-System den letzten Schritt übernimmt.

Vision bewahren in einem lauten Markt

Der Markt für Vektordatenbanken war 2023 eine der heißesten Kategorien in der KI-Infrastruktur. Unternehmen sammelten enorme Summen, machten große Schlagzeilen und wetteiferten darum, die funktionsreichsten Systeme zu bauen. In diesem Umfeld wäre es für Chroma leicht gewesen, den Fokus zu verlieren und jedem Trend hinterherzulaufen. Stattdessen entschied sich das Team bewusst, die eigene Vision nicht aus den Augen zu verlieren: Einen Retrieval-Engine für KI-Anwendungen zu bauen, die eine außergewöhnliche Developer Experience bietet und wirklich die Lücke zwischen Demo und Produktion schließt. Diese Fokussierung erforderte Disziplin und Überzeugung, besonders als andere Unternehmen größere Finanzierungsrunden abschlossen und größere Ankündigungen machten.

Der Schlüssel dazu war eine klare, teils konträre These: Entscheidend ist nicht die Zahl der Features oder das aufgenommene Kapital, sondern die Qualität der Developer Experience und die Zuverlässigkeit des Systems. Das Team glaubte, dass echte Exzellenz in einem einzigen Bereich den Weg für weitere Entwicklungen erst ermöglicht. Diese Philosophie kompromissloser Fokussierung auf eine Kernkompetenz ist nicht einzigartig, aber im VC-getriebenen Startup-Umfeld selten. Das Festhalten daran – auch wenn es bedeutete, mit Chroma Cloud langsamer zu starten und kurzfristig Chancen zu verpassen – erwies sich letztlich als richtig.

Vision zu bewahren bedeutet auch, sorgfältig beim Teamaufbau vorzugehen. Die Mitarbeitenden prägen die Kultur, und diese Kultur bestimmt, was und wie gebaut wird. Das Chroma-Team stellte bewusst langsam und selektiv ein. Statt schnell zu wachsen, wurden nur Leute geholt, die die Vision teilten, Wert auf Qualität legten und eigenständig auf hohem Niveau arbeiten konnten. Dieses Vorgehen ließ das Team zwar langsamer wachsen, sorgte aber für echte Identifikation mit dem Ziel. Kulturelle Ausrichtung ist schwer zu erreichen, aber essenziell für langfristige Fokussierung und Vision.

Die Bedeutung von Handwerk und Qualität in Infrastruktur

Auffällig an Chromas Ansatz ist das Bekenntnis zu Handwerk und Qualität. Im Infrastruktur-Bereich ist es leicht, in die Falle zu tappen, dass mehr Features, mehr Performance oder mehr Skalierung immer besser seien. Doch das Chroma-Team erkannte, dass Zuverlässigkeit, einfache Nutzbarkeit und echte Problemlösung für Entwickler entscheidend sind. Das zeigt sich etwa in der Entscheidung, Chroma in Rust zu schreiben – für Performance und Sicherheit – statt in einer bequemeren, aber weniger zuverlässigen Sprache. Oder im Engagement, das System für ungewöhnliche oder exotische Deployment-Umgebungen lauffähig zu machen. Oder darin, sich Zeit zu nehmen, Chroma Cloud richtig zu bauen statt ein halbfertiges Produkt zu veröffentlichen.

Dieses Qualitätsbewusstsein zeigt sich auch im Problemverständnis: Context Engineering wird nicht als rein technisches Problem mit cleveren Algorithmen betrachtet, sondern als umfassende Herausforderung, die Developer Experience, Zuverlässigkeit, Skalierbarkeit und Wartbarkeit einschließt. Diese ganzheitliche Sicht führt zu besseren Lösungen, weil ein System immer nur so stark ist wie sein schwächstes Glied. Ein System mit ausgefeilten Retrieval-Algorithmen, das aber schwer zu nutzen oder unzuverlässig ist, löst das Problem nicht wirklich. Durch den Fokus auf Handwerk und Qualität in allen Bereichen hat Chroma etwas gebaut, das Entwicklern wirklich hilft und die Lücke zwischen Demo und Produktion überbrückt.

Praktische Implikationen für KI-Entwicklungsteams

Für Teams, die KI-Anwendungen entwickeln, ergeben sich aus Chromas Ansatz mehrere praxisrelevante Erkenntnisse: Erstens ist Context Engineering kein Nebenschauplatz – es ist zentral. Die Qualität Ihres KI-Systems ist grundlegend durch die Qualität des gelieferten Kontexts begrenzt, deshalb ist die Investition in entsprechende Infrastruktur unabdingbar. Zweitens sollte man Systemen, die alles versprechen, skeptisch begegnen. Die zuverlässigsten und effektivsten Systeme sind oft diejenigen, die eine Sache wirklich gut machen und darauf aufbauen. Achten Sie bei der Auswahl von Vektordatenbanken oder Retrieval-Systemen auf klare Fokussierung und den Anspruch, in diesem Bereich Weltklasse zu sein. Drittens zählt Developer Experience: Ein theoretisch mächtigeres, aber schwer zu bedienendes System ist am Ende weniger wert als eines, das einfach funktioniert – denn mit Letzterem werden Entwickler tatsächlich produktiv.

Viertens sind Zuverlässigkeit und Konsistenz wichtiger als gedacht. In frühen KI-Projekten ist es verlockend, Features und Performance über Stabilität zu stellen. Aber sobald die Systeme in Produktion gehen und reale Lasten bewältigen müssen, ist Zuverlässigkeit entscheidend. Ein System mit 95 % Zuverlässigkeit klingt akzeptabel, aber bei Millionen Anfragen pro Tag sind das Hunderttausende Ausfälle. In Zuverlässigkeit von Anfang an zu investieren ist günstiger, als später nachzurüsten. Schließlich sollte man den langfristigen Entwicklungspfad im Auge behalten: Die heute gewählte Infrastruktur bestimmt, was Sie morgen bauen können. Systeme, die von Beginn an auf Produktionssicherheit, Skalierbarkeit und Monitoring setzen, zahlen sich langfristig aus.

{{ cta-dark-panel

heading=“Beschleunigen Sie Ihren Workflow mit FlowHunt”

description=“Erleben Sie, wie FlowHunt Ihre KI-Content- und SEO-Workflows automatisiert – von Recherche und Content-Erstellung über Veröffentlichung bis zu Analytics – alles in einer Plattform.”

ctaPrimaryText=“Demo buchen”

ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo"

ctaSecondaryText=“FlowHunt kostenlos testen”

ctaSecondaryURL=“https://app.flowhunt.io/sign-in"

gradientStartColor="#123456”

gradientEndColor="#654321”

gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217”

}}

Eine der wichtigsten Entscheidungen des Chroma-Teams war die Open-Source-Stellung des Kernprodukts. Das hatte mehrere entscheidende Auswirkungen: Erstens baute es Vertrauen in der Entwickler-Community auf. Wenn Entwickler den Code sehen, verstehen und verbessern können, ist die Wahrscheinlichkeit der Akzeptanz und Nutzung viel höher. Open Source erzeugt zudem einen positiven Kreislauf: Community-Beiträge verbessern das Produkt, ziehen mehr Nutzer an und führen zu noch mehr Beiträgen. Zweitens entstand so eine starke Community rund um Chroma. Wer das Produkt verwendet, wird Teil des Erfolgs, trägt Feedback und Verbesserungen bei und empfiehlt es weiter – eine Community, die schwer nachzuahmen ist.

Drittens bietet Open Source einen natürlichen Weg zur Monetarisierung über gehostete Services. Durch die Offenlegung des Kerns können Entwickler das Produkt kostenlos und selbst gehostet nutzen – viele bevorzugen aber eine gemanagte, gehostete Version, die Betrieb, Skalierung und Wartung abnimmt. Dieses Modell verfolgt Chroma Cloud: Durch ein überlegenes gehostetes Erlebnis bei gleichzeitigem Open Source-Kern bedient Chroma sowohl die Self-Hosting-Community als auch den Managed-Service-Markt. Dieser Ansatz ist nachhaltiger und entspricht eher den Präferenzen der Entwickler als proprietäre, geschlossene Lösungen.

Erfolg messen: Die wirklich relevanten Kennzahlen

Für die Bewertung von Infrastruktur-Projekten wie Chroma zählen die Kennzahlen, die echten Mehrwert abbilden. Chroma hat beeindruckende Metriken erreicht: über 21.000 GitHub-Sterne, mehr als 5 Millionen monatliche Downloads und insgesamt 60-70 Millionen Downloads. Diese Zahlen zeigen die breite Akzeptanz in der Entwickler-Community. Doch wichtiger als Zahlen ist, ob das Projekt reale Probleme löst: Erleichtert es den Bau von KI-Anwendungen? Verkürzt es den Weg von der Demo zur Produktion? Ermöglicht es robustere Systeme? Die Community und die schnelle Verbreitung sprechen dafür, dass das zutrifft.

Ein weiterer wichtiger Indikator ist die Qualität der Community und der Beiträge: Chroma wird von Entwicklern aus der ganzen Branche weiterentwickelt, etwa durch Integrationen mit Frameworks wie LangChain oder Llama Index. Diese breite Integration im Ökosystem zeigt, dass Chroma echte Probleme löst und Mehrwert bietet. Dass Chroma die Standardwahl für Vektordatenbank-Funktionalität in vielen Frameworks geworden ist, belegt Produktqualität und die Stärke der Community. Solche qualitativen Kennzahlen – Community-Akzeptanz, Integration und Nutzerfeedback – sind oft aussagekräftiger als reine Downloadzahlen.

Die Zukunft von Context Engineering und KI-Infrastruktur

Mit zunehmender Verbreitung und Komplexität von KI-Systemen wird Context Engineering noch wichtiger werden. Die heute gebauten Systeme sind erst der Anfang: Zukünftig werden wir noch ausgefeiltere Ansätze für Kontextmanagement erleben, etwa dynamische Kontextanpassung je nach Aufgabe, lernende Retrieval-Systeme oder die nahtlose Verarbeitung verschiedener Datenmodalitäten (Text, Bild, Audio, Video). Die Infrastruktur dafür muss noch leistungsfähiger werden – die Prinzipien bleiben aber: Fokus auf Developer Experience, Zuverlässigkeit und Qualität, sowie eine klare Vision für die zu lösenden Probleme.

Auch die Rolle von Plattformen wie FlowHunt wird wachsen. Je zentraler Context Engineering in der KI-Entwicklung wird, desto wichtiger sind Tools, die den Bau, das Testen und die Auslieferung komplexer Kontextmanagement-Pipelines vereinfachen. FlowHunt positioniert sich mit Automatisierung und Sichtbarkeit über den gesamten KI-Lebenszyklus hinweg dafür hervorragend. Durch die Abstraktion der Infrastruktur-Komplexität und Bereitstellung leistungsstarker Tools für KI-Anwendungen können sich Entwickler auf Inhalte statt auf technische Details konzentrieren.

Fazit

Context Engineering markiert einen grundlegenden Wandel in der Entwicklung von KI-Systemen – weg von Versuch-und-Irrtum und Alchemie, hin zu einer systematischen Ingenieursdisziplin. Moderne Vektordatenbanken wie Chroma, die auf Prinzipien wie Trennung von Speicher und Compute, Multi-Tenancy und verteilter Systemarchitektur basieren, bilden das Fundament für diesen Wandel. Kombiniert mit Fokus auf Developer Experience, Zuverlässigkeit und Handwerkskunst können Teams KI-Systeme bauen, die produktiv funktionieren und zuverlässig skalieren. Die Lehren aus Chromas Ansatz – Fokussierung auf die Kernvision, kulturelle Passung beim Hiring, Betonung von Qualität statt Features und Community-Aufbau durch Open Source – bieten eine Orientierung für Infrastrukturprojekte und Teams, die KI-Anwendungen bauen. Mit der weiteren Entwicklung von KI wird die Bedeutung von Context Engineering weiter zunehmen – und damit zu einem der wichtigsten Schwerpunkte für alle, die KI-Systeme entwickeln.