Hugging Face Transformers

Hugging Face Transformers ist eine führende Open-Source-Python-Bibliothek, die die Implementierung von Transformermodelle für maschinelle Lernaufgaben in NLP, C...

Ein umfassender Leitfaden zu modernen Pretraining-Strategien für Sprachmodelle, Methoden zur Datenkuratierung und Optimierungsverfahren, die von HuggingFace zur Entwicklung effizienter, leistungsstarker Open-Source-Modelle eingesetzt werden.

Die Entwicklung von Sprachmodellen hat sich in den letzten Jahren grundlegend gewandelt. Während große Technologiekonzerne weiterhin an der Skalierung der Modelle arbeiten, hat die Open-Source-Community erkannt, dass außergewöhnliche Leistungen nicht zwangsläufig Billionen-Parameter-Modelle erfordern. Dieser umfassende Leitfaden beleuchtet die neuesten Techniken und Strategien, die von Forschern bei HuggingFace eingesetzt werden, um effiziente, leistungsstarke Sprachmodelle durch rigorose Pretraining-Methoden zu entwickeln. Wir untersuchen, wie SmolLM 3, FineWeb und FinePDF einen neuen Ansatz bei der Modellentwicklung darstellen – einen Ansatz, der darauf abzielt, die Leistung innerhalb praktischer Rechnergrenzen zu maximieren und dabei wissenschaftliche Strenge und Reproduzierbarkeit zu wahren. Die hier geteilten Erkenntnisse sind das Ergebnis monatelanger Forschung und Experimentierarbeit und stellen eine Masterclass dar, wie man Modell-Pretraining im modernen Zeitalter angehen sollte.

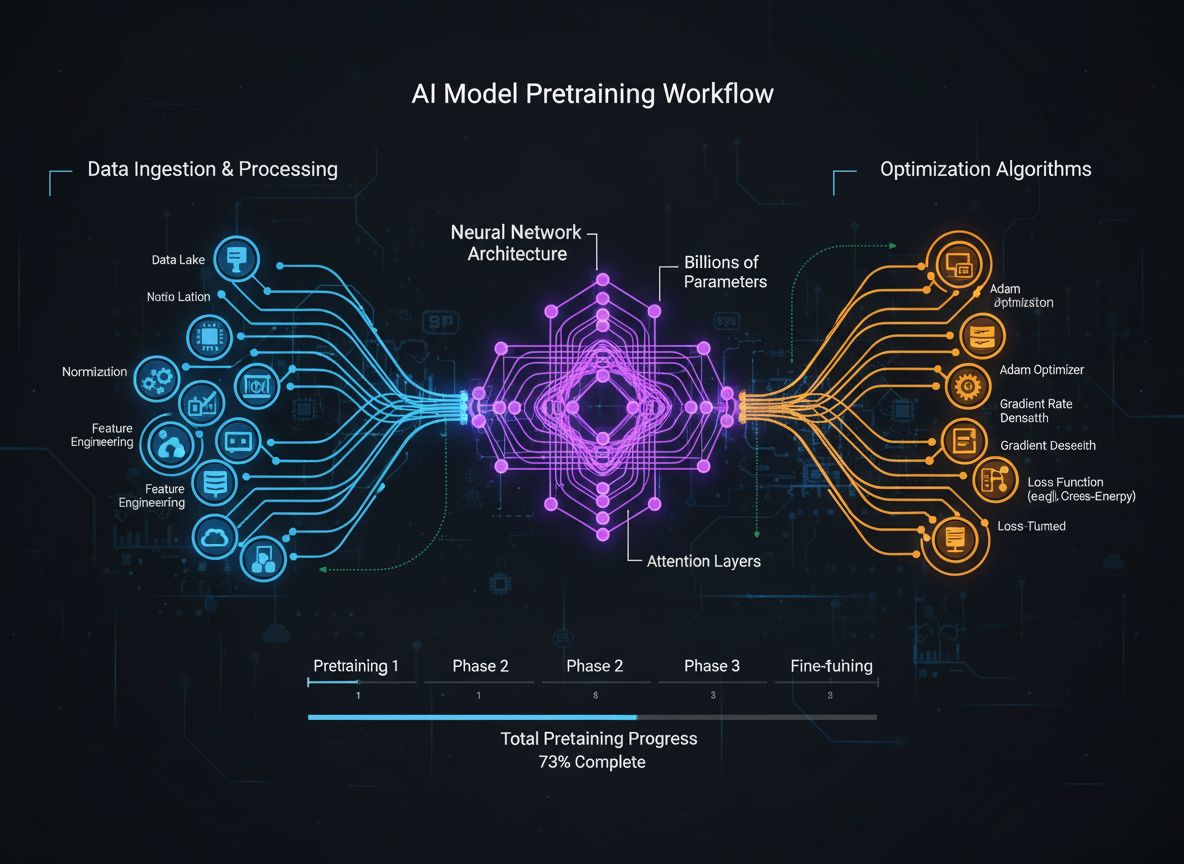

Das Pretraining von Sprachmodellen hat sich von einem relativ einfachen Prozess, bei dem rohe Textdaten in neuronale Netze eingespeist werden, zu einer ausgefeilten Disziplin mit mehreren, miteinander verbundenen Optimierungszielen entwickelt. Im Kern bedeutet Pretraining, dass ein Modell mit riesigen Mengen an Textdaten konfrontiert wird und durch selbstüberwachtes Lernen statistische Sprachmuster erlernt. Der moderne Ansatz erkennt jedoch, dass es nicht ausreicht, einfach Daten und Rechenleistung zu skalieren. Stattdessen müssen Forscher viele Aspekte des Trainingsprozesses sorgfältig steuern – von der Datenauswahl und -kuratierung über Architekturentscheidungen bis hin zu Optimierungsalgorithmen. Das Feld ist inzwischen so weit gereift, dass das Verständnis dieser Feinheiten den Unterschied zwischen State-of-the-Art-Modellen und mittelmäßigen Modellen ausmacht. Diese Entwicklung spiegelt ein tieferes Verständnis wider: Die Modellleistung wird nicht durch einen einzelnen Faktor bestimmt, sondern durch das sorgfältige Zusammenspiel mehrerer, teils orthogonaler Ziele, die parallel optimiert werden können. Die Forschungsgemeinschaft erkennt zunehmend, dass das „Geheimrezept“ erfolgreicher Modellentwicklung nicht in reiner Skalierung, sondern in intelligenten Designentscheidungen in jeder Schicht der Trainingspipeline liegt.

Eine der wichtigsten Erkenntnisse aktueller Forschung ist, dass die Qualität und Vielfalt der Trainingsdaten die Modellleistung stärker bestimmt als die bloße Menge der Daten. Dieses Prinzip, oft als „Garbage in, Garbage out“ zusammengefasst, wird durch empirische Forschung und praktische Erfahrung immer wieder bestätigt. Werden Modelle mit schlecht kuratierten, doppelt vorhandenen oder minderwertigen Daten trainiert, lernen sie unwesentliche Muster und können schlecht auf neue Aufgaben generalisieren. Umgekehrt ermöglichen sorgfältig ausgewählte, deduplizierte und gefilterte Datensätze ein effizienteres Lernen und bessere Ergebnisse bei weniger Trainingsschritten. Die Konsequenz dieser Einsicht ist tiefgreifend: Organisationen und Forscher sollten eher in Datenkuratierung und Qualitätssicherung investieren, als einfach nur mehr Rohdaten zu sammeln. Diese Perspektivverschiebung hat zur Entstehung spezialisierter Teams und Tools geführt, die sich ganz auf die Erstellung und Verfeinerung von Datensätzen konzentrieren. Der FineWeb-Datensatz, der über 18,5 Billionen Token an gereinigten und deduplizierten englischen Webdaten enthält, ist ein Paradebeispiel für diesen Ansatz. Anstatt rohe CommonCrawl-Daten zu verwenden, setzte das FineWeb-Team auf fortschrittliche Filter-, Deduplikations- und Qualitätsbewertungsverfahren, um einen Datensatz zu erstellen, der regelmäßig größere, unverarbeitete Alternativen übertrifft. Das ist eine grundlegende Erkenntnis im Feld: Der Weg zu besseren Modellen führt über bessere (nicht zwangsläufig mehr) Daten.

Modernes Modell-Pretraining lässt sich anhand von fünf miteinander verbundenen, aber teils orthogonalen Zielen beschreiben, die Forscher gleichzeitig optimieren müssen. Das Verständnis dieser Säulen bietet einen Rahmen, um den gesamten Trainingsprozess zu durchdenken und Verbesserungsbedarf zu erkennen. Die erste Säule beinhaltet die Maximierung der Relevanz und Qualität der Rohdaten im Training. Das umfasst sowohl die Qualität einzelner Datenpunkte als auch die Vielfalt des Gesamt-Datensatzes. Ein Modell, das mit hochwertigen, vielfältigen Daten trainiert wird, lernt generalisierbarere Muster als eines, das auf enge oder minderwertige Daten trainiert wird – unabhängig von anderen Optimierungen. Die zweite Säule bezieht sich auf das Design der Modellarchitektur, das festlegt, wie effizient ein Modell Informationen verarbeitet und mit welchen Rechenrestriktionen es umgehen kann. Architekturentscheidungen beeinflussen Geschwindigkeit, Speicherverbrauch, KV-Cache-Anforderungen und die Fähigkeit, auf bestimmten Hardwarekonfigurationen zu laufen. Die dritte Säule umfasst die Maximierung der Informationsgewinnung aus den Trainingsdaten bei jedem Schritt. Dazu gehören Techniken wie Wissensdistillation (bei der kleinere Modelle von größeren lernen) und Multi-Token-Vorhersage (bei der Modelle mehrere zukünftige Token gleichzeitig vorhersagen). Die vierte Säule betrifft Gradientenqualität und Optimierungsdynamik – also die Wahl des Optimierers, die Einstellung des Lernratenplans und Methoden zur Stabilisierung des Trainings. Die fünfte Säule betrifft Hyperparameter-Tuning und Skalierungsstrategien, die sicherstellen, dass das Training auch bei größeren Modellen stabil bleibt und Probleme wie Gradientenexplosion oder Aktivierungsdivergenz verhindert werden. Diese fünf Säulen sind nicht unabhängig – sie beeinflussen sich gegenseitig –, aber ihre getrennte Betrachtung erleichtert es Forschern, gezielt Verbesserungen vorzunehmen.

FineWeb markiert einen Wendepunkt bei der Datensatzerstellung für das Pretraining von Sprachmodellen. Anstatt sich mit den Rohdaten von Webcrawlern wie CommonCrawl zufrieden zu geben, implementierte das HuggingFace-Team eine umfassende Pipeline zur Bereinigung, Filterung und Deduplikation von Webdaten im großen Maßstab. Das Ergebnis ist ein Datensatz mit über 18,5 Billionen Tokens an hochwertigem englischen Text und damit einer der größten kuratierten Datensätze, die der Open-Source-Community zur Verfügung stehen. Die Erstellung von FineWeb umfasste mehrere Verarbeitungsschritte, die jeweils darauf ausgelegt waren, minderwertige Inhalte zu entfernen und wertvolle Informationen zu erhalten. Das Team setzte fortschrittliche Deduplikationsalgorithmen ein, um redundante Inhalte zu eliminieren, Qualitätsfilter zur Entfernung von Spam und schlechten Seiten sowie eine Spracherkennung, um einen überwiegend englischsprachigen Datensatz zu gewährleisten. Besonders wertvoll ist FineWeb nicht nur wegen seiner Größe, sondern auch, weil empirisch nachgewiesen wurde, dass er bessere Modellleistungen erzielt als größere, unverarbeitete Alternativen. In Kombination mit anderen Datensätzen übertrifft FineWeb regelmäßig viel größere Rohdatensätze, was zeigt, dass Qualität tatsächlich wichtiger ist als Quantität. Die Leistungskurven belegen, dass Modelle, die mit FineWeb trainiert wurden, auf Standard-Benchmarks besser abschneiden als Modelle, die auf ähnlich großen Datensätzen anderer Quellen trainiert wurden. Dieser Erfolg hat in der Forschungsgemeinschaft zu verstärkten Investitionen in die Datenkuratierung geführt, da hier erhebliche Leistungsgewinne zu erzielen sind. Der FineWeb-Datensatz ist frei verfügbar und demokratisiert den Zugang zu hochwertigen Trainingsdaten, sodass auch kleinere Organisationen und akademische Teams konkurrenzfähige Modelle trainieren können.

Während sich FineWeb auf Webdaten konzentrierte, erkannte das HuggingFace-Team eine weitere riesige, bislang wenig genutzte Quelle für hochwertige Texte: PDF-Dokumente. PDFs enthalten enorme Mengen an strukturierten, hochwertigen Informationen, darunter wissenschaftliche Veröffentlichungen, technische Dokumentationen, Bücher und Berichte. Das Extrahieren von Text aus PDFs ist technisch anspruchsvoll, und bisherige Ansätze hatten diese Quelle nicht im großen Maßstab erschlossen. FinePDF stellt den ersten umfassenden Versuch dar, PDF-Daten für das Pretraining von Sprachmodellen systematisch zu extrahieren, zu bereinigen und zu kuratieren. Das Team entwickelte eine ausgefeilte Pipeline, die die besonderen Herausforderungen der PDF-Verarbeitung adressiert – darunter komplexe Layouts, exakte Textextraktion aus mehrspaltigen Dokumenten sowie den Umgang mit eingebetteten Bildern und Tabellen. Ein besonders innovativer Schritt ist das „Refetch from internet“-Verfahren, das ein zentrales Problem löst: PDFs aus CommonCrawl sind oft schlecht extrahiert oder veraltet. Durch das erneute Herunterladen der PDFs aus den Originalquellen im Internet stellt das Team einen Zugang zu den bestmöglichen Versionen sicher. Die Ergebnisse sind eindrucksvoll: In Kombination mit anderen Datensätzen zeigt FinePDF sehr starke Leistungen im Vergleich zu aktuellen Baselines wie NeoTron B2. Der Datensatz bietet eine neue, hochwertige Trainingsdatenquelle, die Webdaten ergänzt und es Modellen ermöglicht, aus vielfältigeren, strukturierten Informationen zu lernen. Dieses Projekt öffnet neue Türen für die Datensatzerstellung und legt nahe, dass auch andere, bislang wenig untersuchte Datenquellen große Vorteile bringen könnten. Die FinePDF-Pipeline wird in Blogbeiträgen und technischer Dokumentation ausführlich beschrieben, sodass andere Forschende darauf aufbauen oder ähnliche Verfahren auf andere Quellen anwenden können.

SmolLM 3 verkörpert die Anwendung dieser Datenkuratierungs- und Trainingsoptimierungstechniken zur Entwicklung eines besonders effizienten Sprachmodells. Mit 3 Milliarden Parametern ist SmolLM 3 deutlich kleiner als viele zeitgenössische Modelle, erzielt aber durch gezielte Optimierung über alle fünf Trainingssäulen hinweg eine konkurrenzfähige Leistung. Das Modell unterstützt Dual-Mode-Reasoning, Mehrsprachigkeit in sechs Sprachen und das Verständnis langer Kontexte – und bleibt dabei überraschend vielseitig trotz seiner kompakten Größe. Die Entwicklung von SmolLM 3 beinhaltete sorgfältig gewählte Architekturentscheidungen zur maximalen Effizienz. Das Team wählte eine Transformer-Architektur, die Recheneffizienz und Modellierungskapazität balanciert, und implementierte Techniken wie Grouped Query Attention, um Speicherbedarf und Inferenz-Latenz zu reduzieren. Trainiert wurde das Modell in einem dreistufigen Pretraining, das die Leistung in unterschiedlichen Domänen schrittweise steigert und so gezielt bestimmte Fähigkeiten fördert. Besonders bedeutsam ist SmolLM 3, weil es zeigt, dass die Open-Source-Community nun Modelle entwickeln kann, die in vielen Aufgaben mit weit größeren proprietären Modellen konkurrieren. Das widerlegt die Annahme, dass „größer immer besser“ ist, und lässt vermuten, dass die Vorteile reiner Skalierung inzwischen ausgereizt sind. Der Fokus verschiebt sich stattdessen auf Effizienz, Interpretierbarkeit und praktische Einsatzmöglichkeiten. SmolLM 3 läuft auf Consumer-Hardware, Edge-Geräten und in ressourcenbeschränkten Umgebungen und macht fortschrittliche KI so für viel mehr Nutzer zugänglich. Die Mehrsprachigkeit und das Verständnis langer Kontexte belegen: Effizienz muss nicht auf Kosten wichtiger Eigenschaften gehen.

Wissensdistillation ist eine wirkungsvolle Technik, mit der kleinere Modelle von dem Wissen profitieren, das größere Modelle erworben haben. Anstatt ein kleines Modell von Grund auf mit Rohdaten zu trainieren, lernt es bei der Wissensdistillation, die Ausgaben eines größeren, leistungsfähigeren Modells zu imitieren. Besonders im Pretraining ist dieses Verfahren wertvoll, weil das kleine Modell Muster übernehmen kann, die das große Modell bereits erkannt hat. So wird das Lernen beschleunigt und die Endleistung verbessert. Mechanisch bedeutet Wissensdistillation, dass das Schüler-Modell (klein) darauf trainiert wird, die Wahrscheinlichkeitsverteilungen des Lehrer-Modells (groß) nachzuahmen. Typischerweise minimiert man dabei die Divergenz beider Ausgaben, etwa mittels KL-Divergenz. Der Temperatur-Parameter steuert, wie „weich“ die Verteilungen sind – höhere Werte glätten die Verteilung und liefern mehr Informationen über die relative Sicherheit einzelner Vorhersagen. Wissensdistillation hat sich speziell beim Pretraining von Sprachmodellen bewährt, da so Wissen von großen auf kleinere, effizientere Modelle übertragen werden kann. Das ist besonders für Organisationen wertvoll, die Modelle auf Edge-Geräten oder in ressourcenarmen Umgebungen einsetzen möchten, aber dennoch von den Fähigkeiten größerer Modelle profitieren wollen. Die Technik wird immer ausgefeilter: So erforscht man zum Beispiel Attention-Transfer (Schüler lernen auch die Aufmerksamkeitsmuster des Lehrers) oder Feature-basierte Distillation (Zwischenschichten werden zusätzlich angepasst).

Klassisches Sprachmodelltraining basiert auf der Vorhersage des nächsten Tokens – das Modell lernt, das folgende Token aus vorangehenden Tokens zu prognostizieren. Neue Forschung zeigt aber: Wird das Modell darauf trainiert, mehrere zukünftige Tokens gleichzeitig vorherzusagen, verbessert das die Leistung deutlich, vor allem bei Programmieraufgaben und Aufgaben mit komplexen Abhängigkeiten. Multi-Token-Vorhersage zwingt das Modell, längere Zusammenhänge zu lernen und ein tieferes Verständnis für zugrunde liegende Muster zu entwickeln. Dafür werden dem Modell mehrere Vorhersageköpfe hinzugefügt, von denen jeder ein Token mehrere Positionen voraus vorhersagt. Im Training erhält das Modell von allen Köpfen gleichzeitig Verlustsignale, was zu Repräsentationen führt, die für mehrere Schritte in die Zukunft nützlich sind. Das ist anspruchsvoller als klassische Next-Token-Vorhersage, führt aber zu besseren internen Repräsentationen. Die Vorteile gehen über bessere Leistungen beim Trainingsziel hinaus: Modelle mit Multi-Token-Vorhersage zeigen oft auch bessere Ergebnisse bei nachgelagerten Aufgaben, eine bessere Generalisierung und ausgeprägtere Fähigkeiten beim logischen Schließen. Besonders effektiv ist die Technik bei Codegenerierung, wo das Erkennen längerer Zusammenhänge entscheidend ist. Studien zeigen, dass Multi-Token-Vorhersage die Modellleistung auf Benchmarks um 5–15 % steigern kann – eine der wirkungsvollsten Trainingsmethoden der letzten Jahre. Die Implementierung ist relativ einfach, erfordert aber eine sorgfältige Abstimmung der Kopfanzahl und der Gewichtung der einzelnen Verluste.

Lange Zeit war AdamW der Standard-Optimierer für große Sprachmodelle. AdamW kombiniert momentum-basierte Gradientenupdates mit Weight Decay und sorgt so für stabiles Training und gute Konvergenz. Neuere Forschung zeigt jedoch: AdamW ist nicht in allen Szenarien optimal, vor allem nicht beim Training sehr großer Modelle. Neue Optimierer wie Muon und King K2 verfolgen alternative Ansätze und können das Training verbessern. Der Kern dieser Innovationen: Die Hesse-Matrix – sie enthält Informationen über die Krümmung der Verlustlandschaft – kann durch Methoden wie Newton-Schulz besser approximiert werden. Durch eine bessere Näherung der Hesse-Matrix liefern diese Optimierer informativere Gradienten, was zu schnellerer Konvergenz und besserer Endleistung führt. Muon etwa nutzt Newton-Schulz-Iterationen, um die Gradientenmatrix zu orthogonalisieren, was das Lernen auf mehr Dimensionen verteilt als klassische momentum-basierte Ansätze. Das Ergebnis: stabileres Training und eine größere Erkundung des Parameterraums. King K2 verfolgt einen anderen Ansatz, indem zum Beispiel pro Kopf das maximale Loggetrackert wird und so Lernrate und Gradient Clipping adaptiv anpasst. Die Bedeutung dieser Innovationswelle ist groß: Viele Praktiker nutzen AdamW weiterhin mit Hyperparametern, die für viel kleinere Modelle optimiert wurden, selbst beim Training viel größerer Modelle. Hier könnten durch aktualisierte Optimierer und besseres Hyperparameter-Tuning erhebliche Leistungsgewinne erzielt werden. Die Forschung erkennt zunehmend, dass die Wahl des Optimierers noch nicht gelöst ist und weitere Innovationen in diesem Bereich das Modelltraining deutlich verbessern können.

Eine hohe Qualität der Gradienten während des gesamten Trainings ist entscheidend für gute Modellleistungen. Je größer Modelle werden (Milliarden- oder Billionenparameter), desto instabiler wird das Training; Gradienten neigen zu Explosion oder Verschwinden. Um diese Probleme zu vermeiden, ist größte Sorgfalt bei der Gradientenqualität und die Implementierung stabilisierender Techniken nötig. Ein Ansatz ist Gradient Clipping, das verhindert, dass Gradienten zu groß werden und das Training destabilisieren. Allerdings kann zu aggressives Clipping wertvolle Information vernichten. Fortschrittlichere Methoden normalisieren die Gradienten so, dass sie Information erhalten und trotzdem Stabilität gewährleisten. Ebenfalls entscheidend ist die Wahl von Aktivierungsfunktionen und Layer-Normalisierung. Unterschiedliche Aktivierungen haben verschiedene Eigenschaften beim Gradientenfluss, und die richtige Wahl kann das Training stark beeinflussen. Layer-Normalisierung, die Aktivierungen über die Feature-Dimension hinweg normalisiert, ist in Transformer-Modellen Standard, weil sie den Gradientenfluss besser begünstigt als Batch-Normalisierung. Auch der Lernratenplan ist entscheidend: Ist die Lernrate zu hoch, explodieren Gradienten, ist sie zu niedrig, verlangsamt sich das Training oder es bleibt in lokalen Minima stecken. Moderne Trainings setzen meist auf Lernraten-Schedules mit Warm-up-Phase, gefolgt von einer Absenkung, um das Modell zunächst in einen guten Bereich zu bringen und dann feiner zu optimieren. Das Verständnis und die Optimierung dieser Aspekte sind essenziell für das erfolgreiche Training großer Modelle – und bleiben weiterhin Gegenstand intensiver Forschung.

Die Komplexität des modernen Modell-Pretrainings – mit seinen vielen Optimierungszielen, ausgefeilten Datenpipelines und sorgfältigem Hyperparameter-Tuning – stellt Teams vor große Herausforderungen. FlowHunt begegnet diesen Herausforderungen mit einer Plattform zur Automatisierung und Orchestrierung komplexer Trainings-Workflows. Anstatt Datenverarbeitung, Modelltraining und Evaluation manuell zu verwalten, können Teams mit FlowHunt Workflows definieren, die diese Aufgaben automatisiert übernehmen – das reduziert Fehler und erhöht die Reproduzierbarkeit. Besonders wertvoll ist die Automatisierung bei der Datenkuratierung und -verarbeitung, die für die Modellleistung so entscheidend sind. Die Plattform kann automatisch komplexe Datenpipelines wie bei FineWeb und FinePDF implementieren – inklusive Deduplikation, Qualitätsfiltern und Formatkonvertierung. So können Teams sich auf die inhaltlichen Entscheidungen (welche Daten, wie verarbeiten) konzentrieren, statt sich in Details zu verlieren. Darüber hinaus unterstützt FlowHunt beim Hyperparameter-Tuning und bei Experimenten: Unterschiedliche Trainingsläufe mit verschiedenen Hyperparametern können automatisch durchgeführt und die Ergebnisse gesammelt werden – so lassen sich optimale Konfigurationen schneller finden. Die Plattform bietet außerdem Tools zur Überwachung des Trainingsfortschritts, zur Erkennung von Problemen wie Gradientenexplosion und zur automatischen Anpassung von Trainingsparametern zur Wahrung der Stabilität. Für Organisationen, die eigene Sprachmodelle entwickeln oder bestehende Modelle feinabstimmen, kann FlowHunt den Zeit- und Arbeitsaufwand erheblich senken und die Ergebnisqualität steigern.

Eine der größten Herausforderungen beim Modelltraining ist das Verständnis, wie man von kleinen auf große Modelle skaliert und dabei Stabilität und Leistung erhält. Die Beziehung zwischen Modellgröße und optimalen Hyperparametern ist nicht trivial – was für kleine Modelle funktioniert, muss für große oft angepasst werden. Besonders gilt das für Lernraten, die mit wachsender Modellgröße meist gesenkt werden müssen. Das Verständnis von Skalierungsgesetzen ist entscheidend, um die Leistung für verschiedene Modellgrößen vorherzusagen und Ressourcen sinnvoll einzusetzen. Studien zeigen, dass die Modellleistung bestimmten Skalierungsgesetzen folgt, wobei die Leistung als Potenzgesetz von Modellgröße, Datensatzgröße und Rechenbudget steigt. Solche Gesetze erlauben es Forschern, den zu erwartenden Leistungsgewinn durch größere Modelle oder Datensätze abzuschätzen und Investitionen gezielter zu planen. Allerdings gelten diese Gesetze nicht universell, sondern hängen von Architektur, Trainingsverfahren und Datensatz ab. Teams müssen daher eigene Skalierungsexperimente durchführen, um das Verhalten ihres spezifischen Setups zu verstehen. Beim Skalieren kommt es außerdem verstärkt zu Trainingsinstabilitäten wie Gradientenexplosion oder Divergenz. Um das zu verhindern, sind Techniken wie Gradient Clipping, sorgfältiges Lernenraten-Scheduling und ggf. Änderungen an Architektur oder Optimierer nötig. Die Forschung erkennt zunehmend: Skalierung bedeutet nicht nur größere Modelle, sondern das sorgfältige Beherrschen des Trainingsprozesses, damit diese auch effektiv trainiert werden können.

Feature Learning bezeichnet den Prozess, in dem Modelle während des Trainings nützliche Merkmale aus Rohdaten extrahieren. Beim Pretraining von Sprachmodellen lernt das Modell, linguistische Konzepte, semantische Beziehungen und syntaktische Muster in seinen internen Repräsentationen abzubilden. Maximales Feature Learning – also das Extrahieren möglichst vieler nützlicher Informationen aus den Trainingsdaten bei jedem Schritt – ist ein zentrales Ziel des modernen Modelltrainings. Man kann Feature Learning daran messen, wie stark sich die internen Repräsentationen des Modells durch Gradientenupdates verändern: Bei effektivem Lernen sollten Updates zu sinnvollen Veränderungen führen, die die Vorhersage verbessern. Bleibt die Veränderung aus oder verbessert sich die Leistung nicht, lernt das Modell ineffektiv. Techniken zur Verbesserung des Feature Learnings sind unter anderem die sorgfältige Initialisierung der Modellgewichte, die das frühe Erlernen wesentlicher Merkmale fördern kann. Wichtig ist auch der Einsatz von Lernraten-Schedules, die zu Beginn ein schnelles Lernen grundlegender Features ermöglichen und später das Verfeinern subtilerer Muster erlauben. Eng verbunden ist das mit dem Konzept des „Feature Collapse“, bei dem Modelle bestimmte Merkmale oder Dimensionen ignorieren – oft, weil sie Abkürzungen finden, die gute Leistungen erlauben, ohne alle Features zu lernen. Methoden wie Regularisierung und durchdachtes Design der Verlustfunktion helfen, Feature Collapse zu verhindern und zu gewährleisten, dass Modelle vielfältige, nützliche Merkmale lernen.

{{ cta-dark-panel heading=“Beschleunigen Sie Ihren Workflow mit FlowHunt” description=“Erleben Sie, wie FlowHunt Ihre KI- und SEO-Workflows automatisiert – von Recherche und Inhaltserstellung über Veröffentlichung bis hin zu Analysen – alles an einem Ort.” ctaPrimaryText=“Demo buchen” ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo" ctaSecondaryText=“FlowHunt kostenlos testen” ctaSecondaryURL=“https://app.flowhunt.io/sign-in" gradientStartColor="#123456” gradientEndColor="#654321” gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217” }}

Jahrelang lautete die gängige Meinung in der KI-Forschung: Größere Modelle sind bessere Modelle. Das führte zu einem Wettlauf um immer größere Modelle mit immer mehr Parametern. Doch aktuelle Entwicklungen deuten auf einen Kurswechsel hin. Der Erfolg von SmolLM 3 und anderen effizienten Modellen zeigt: Herausragende Leistungen sind mit Modellen möglich, die um Größenordnungen kleiner sind als die größten Modelle. Das spiegelt ein tieferes Verständnis wider: Die Modellleistung hängt von vielen Faktoren ab, nicht nur von der Anzahl der Parameter. Ein Modell mit 3 Milliarden Parametern, das mit hochwertigen Daten und ausgefeilten Optimierungstechniken trainiert wurde, kann ein viel größeres Modell übertreffen, das auf minderwertigen Daten und weniger sorgfältig optimiert wurde. Diese Erkenntnis hat weitreichende Folgen: Sie legt nahe, dass die wirkungsvollste Forschung nicht im Bau immer größerer Modelle liegt, sondern in der Verbesserung der Datenqualität, der Entwicklung besserer Trainingstechniken und effizienterer Architekturen. Sie demokratisiert die KI-Entwicklung, denn nun können kleinere Organisationen und akademische Teams konkurrenzfähige Modelle entwickeln, ohne Zugriff auf das immense Rechenpotenzial, das Billionen-Parameter-Modelle benötigen. Der Abschied von der reinen Skalierung hat auch praktische Folgen für die Nutzung: Kleinere Modelle laufen auf Edge-Geräten, in ressourcenarmen Umgebungen und mit geringer Latenz und Energieverbrauch. So werden fortschrittliche KI-Funktionen für ein breites Spektrum an Anwendungen und Nutzern zugänglich. Die Forschung erkennt zunehmend, dass die Zukunft der KI-Entwicklung in einem Portfolio unterschiedlich großer Modelle liegt, die jeweils für bestimmte Anwendungsfälle und Einsatzszenarien optimiert sind – und nicht in einem reinen Wettlauf um die meisten Parameter.

Das Abstimmen der Hyperparameter – also der Parameter, die den Trainingsprozess steuern, wie Lernrate, Batchgröße oder Weight Decay – hat einen entscheidenden Einfluss auf die Modellleistung. Dennoch wird das Tuning oft eher als Kunst denn als Wissenschaft betrieben, viele verlassen sich auf Intuition und Trial-and-Error. Moderne Ansätze gehen systematischer vor: Bayesian Optimization kann den Hyperraum möglicher Werte effizient erkunden und gezielt vielversprechende Bereiche untersuchen. Grid Search und Random Search sind einfachere, aber oft ebenfalls effektive Alternativen, besonders wenn sie mit parallelem Training kombiniert werden. Eine wichtige Erkenntnis aktueller Forschung ist: Optimale Hyperparameter hängen stark vom jeweiligen Modell, Datensatz und Setup ab. Was für ein Modell funktioniert, kann für ein anderes – selbst mit ähnlicher Größe und Architektur – ungeeignet sein. Deshalb werden heute für jedes neue Modell oder jeden neuen Datensatz Hyperparameter-Sweeps durchgeführt – das ist rechenaufwändig, aber oft unerlässlich für optimale Leistung. Das Verständnis der Beziehungen zwischen Hyperparametern und Modellleistung ist auch für das Debugging hilfreich. Ist das Training instabil oder verläuft langsam, liegt das Problem oft an suboptimalen Hyperparametern und nicht am Modell oder den Daten. Wer den Hyperraum systematisch untersucht, kann solche Probleme meist schnell identifizieren und beheben.

Die Erkenntnisse aus der modernen Modell-Pretraining-Forschung haben große praktische Bedeutung für Organisationen, die eigene Sprachmodelle entwickeln oder bestehende Modelle feinabstimmen. An erster Stelle sollte eine Investition in Datenqualität und Kuratierung stehen – die Evidenz ist eindeutig: Hochwertige Daten sind wertvoller als große Mengen minderwertiger Daten. Dazu gehören deduplizierende, qualitätsfilternde und formatangleichende Datenpipelines. Zweitens sollten Organisationen ihre Optimierungsziele klar definieren und sicherstellen, dass sie auf die richtigen Metriken optimieren. Unterschiedliche Anwendungen erfordern unterschiedliche Kompromisse zwischen Modellgröße, Inferenzgeschwindigkeit und Genauigkeit. Durch eine klare Definition dieser Kompromisse können Architektur- und Trainingsentscheidungen gezielter getroffen werden. Drittens sollten Organisationen über aktuelle Fortschritte in Trainingstechniken und Optimierer-Design informiert bleiben. Das Feld entwickelt sich schnell, und Methoden, die vor einem Jahr noch Stand der Technik waren, können inzwischen überholt sein. Wer regelmäßig neue Forschungsliteratur liest und neue Methoden testet, bleibt wettbewerbsfähig. Viertens lohnt sich die Investition in Tools und Infrastruktur, die die Implementierung komplexer Trainingsverfahren erleichtern – etwa Plattformen wie FlowHunt zur Automatisierung von Datenverarbeitung und Trainings-Workflows oder eigene Lösungen für effiziente Experimente und Hyperparameter-Tuning. Schließlich sollten Organisationen erkennen: Modellentwicklung bedeutet nicht nur Training, sondern auch Evaluation, Debugging und Iteration. Gute Modelle entstehen durch einen systematischen Ansatz mit regelmäßigen Benchmarks, Fehleranalysen und stetigen Verbesserungen.

Das Feld des Modell-Pretrainings entwickelt sich rasant, regelmäßig kommen neue Techniken und Erkenntnisse hinzu. Mehrere Trends zeichnen sich ab: Erstens wird der Fokus weiterhin auf Datenqualität und -kuratierung liegen. Da erkannt wird, dass Qualität über Quantität steht, sind immer ausgefeiltere Datenpipelines und mehr Forschung darüber zu erwarten, was „gute“ Daten für das Modelltraining ausmacht. Zweitens wird die Innovation bei Optimierern und Trainingsdynamik anhalten. Der Erfolg neuer Optimierer wie Muon und King K2 zeigt, dass hier noch viel Potenzial für Fortschritte steckt. Drittens rückt Effizienz und praktische Nutzbarkeit immer stärker in den Mittelpunkt. Mit steigenden Modellfähigkeiten wächst das Interesse, Modelle kleiner, schneller und effizienter zu machen – unter anderem durch Kompression, Quantisierung und Distillation. Viertens wird das Verständnis und die Verbesserung der Interpretierbarkeit der Modelle wichtiger. Je mächtiger Modelle werden, desto wichtiger wird es, zu verstehen, wie sie funktionieren und warum sie bestimmte Entscheidungen treffen. Schließlich wird die Demokratisierung der Modellentwicklung weiter voranschreiten, mit immer mehr Tools und Methoden, die es auch kleineren Organisationen und akademischen Teams ermöglichen, konkurrenzfähige Modelle zu bauen.

Der moderne Ansatz beim Pretraining von Sprachmodellen stellt eine bedeutende Weiterentwicklung gegenüber früheren, einfacheren Methoden dar. Erfolgreiche Modellentwicklung beruht nicht mehr nur auf größerem Daten- und Rechenaufwand, sondern auf dem sorgfältigen Zusammenspiel mehrerer Optimierungsziele, ausgefeilten Datenkuratierungsverfahren und kontinuierlicher Innovation bei Trainingsmethoden und Optimierern. SmolLM 3, FineWeb und FinePDF verkörpern dieses neue Paradigma und zeigen, dass außergewöhnliche Modellleistungen durch konsequenten Fokus auf Datenqualität, architektonische Effizienz und Trainingsoptimierung erreichbar sind. Die Abkehr von reiner Skalierung hin zu Effizienz und Qualität steht für eine Reifung des Feldes und eröffnet neue Möglichkeiten zur Demokratisierung der KI-Entwicklung. Organisationen, die diese Prinzipien verstehen und anwenden, sind besser gerüstet, konkurrenzfähige Modelle zu bauen – sei es bei der Entwicklung neuer Modelle oder beim Fein-Tuning bestehender Modelle. Die Forschungsgemeinschaft lotet weiterhin die Grenzen des Machbaren aus; laufend entstehen neue Techniken und Erkenntnisse. Wer diese Entwicklungen verfolgt und in die richtigen Werkzeuge und Infrastruktur investiert, stellt sicher, dass die entwickelten Modelle den Stand der Technik repräsentieren.

SmolLM 3 ist ein Modell mit 3 Milliarden Parametern, das maximale Effizienz bei gleichzeitig starker Leistung über mehrere Sprachen und Aufgaben mit langen Kontexten bietet. Im Gegensatz zu größeren Modellen konzentriert sich SmolLM 3 auf optimale Leistung unter Rechenrestriktionen und eignet sich ideal für den Einsatz auf Edge-Geräten und in ressourcenbeschränkten Umgebungen.

Das Prinzip 'Garbage in, Garbage out' ist grundlegend für maschinelles Lernen. Hochwertige, vielfältige Daten wirken sich deutlich stärker auf die Modellleistung aus als einfach nur mehr Daten. FineWeb und FinePDF zeigen, dass sorgfältige Kuratierung, Deduplikation und Filterung der Trainingsdaten zu deutlich besseren Ergebnissen führen als rohe, unverarbeitete Datensätze.

Wissensdistillation ist ein Verfahren, bei dem ein kleineres Modell von einem größeren, leistungsfähigeren Modell lernt. Während des Pretrainings kann das kleinere Modell dadurch maximale Informationen aus den Trainingsdaten ziehen, indem es Muster übernimmt, die das große Modell bereits erkannt hat. So erzielt es mit weniger Parametern eine bessere Leistung.

Bei der Multi-Token-Vorhersage werden Modelle darauf trainiert, mehrere zukünftige Token gleichzeitig vorherzusagen, anstatt nur das nächste Token. Dies ist besonders effektiv für Programmieraufgaben und verbessert die Fähigkeit des Modells, längere Abhängigkeiten zu erkennen. So erzielt es bessere Leistungen bei komplexen Aufgabenstellungen.

Moderne Optimierer wie Muon gehen über den klassischen AdamW hinaus, indem sie zum Beispiel Newton-Schulz-Methoden einsetzen, um die Hesse-Matrix besser zu approximieren. Das sorgt für stabileres Training, bessere Gradientenqualität und verbesserte Lernprozesse – insbesondere beim Skalieren auf größere Modelle.

Arshia ist eine AI Workflow Engineerin bei FlowHunt. Mit einem Hintergrund in Informatik und einer Leidenschaft für KI spezialisiert sie sich darauf, effiziente Arbeitsabläufe zu entwickeln, die KI-Tools in alltägliche Aufgaben integrieren und so Produktivität und Kreativität steigern.

FlowHunt hilft Teams dabei, Modell-Pretraining, Datenverarbeitung und Optimierungs-Pipelines mit intelligenter Automatisierung zu optimieren.

Hugging Face Transformers ist eine führende Open-Source-Python-Bibliothek, die die Implementierung von Transformermodelle für maschinelle Lernaufgaben in NLP, C...

Entdecken Sie, wie Jamba 3B von AI21 die Transformer-Attention mit State Space Models kombiniert, um beispiellose Effizienz und Langkontext-Fähigkeiten auf Edge...

Parameter-Efficient Fine-Tuning (PEFT) ist ein innovativer Ansatz in der KI und NLP, der es ermöglicht, große vortrainierte Modelle an spezifische Aufgaben anzu...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.