Sora 2: KI-Videogenerierung für Content Creators

Entdecken Sie Sora 2s bahnbrechende Fähigkeiten in der KI-Videogenerierung – von realitätsnaher Charakterwiedergabe bis hin zu Physiksimulation – und erfahren S...

Entdecken Sie die bahnbrechenden Möglichkeiten von Sora 2 in der KI-Videogenerierung – von realistischer Charakterwiedergabe bis hin zu Physiksimulation – und erfahren Sie, wie diese Technologie die Content-Erstellung und Automatisierung revolutioniert.

Sora 2 stellt einen bedeutenden Fortschritt in der künstlichen Intelligenz für die Videogenerierung dar. Die neueste Version des Videogenerierungsmodells von OpenAI bietet Content Creators, Marketingexperten und Unternehmen beispiellose Möglichkeiten zur Optimierung ihrer Videoproduktions-Workflows. Dieser umfassende Leitfaden beleuchtet die bemerkenswerten Funktionen von Sora 2, seine praktischen Anwendungen und die Auswirkungen auf die Zukunft der Content-Erstellung. Von der Reproduktion beliebter fiktiver Charaktere bis hin zur Erzeugung realistischer menschlicher Darstellungen zeigt Sora 2 das transformative Potenzial generativer KI in der visuellen Medienproduktion. Ob Sie sich für technische Fähigkeiten, kreative Möglichkeiten oder geschäftliche Anwendungen interessieren – dieser Artikel bietet eine tiefgehende Analyse dessen, was Sora 2 zu einer bahnbrechenden Technologie macht.

Künstliche Intelligenz in der Videogenerierung zählt zu den spannendsten Bereichen der generativen KI-Technologie. Im Gegensatz zur traditionellen Videoproduktion, bei der Kameras, Schauspieler, Lichtequipment und aufwändige Nachbearbeitung nötig sind, erstellt die KI-Videogenerierung Videos direkt aus Textbeschreibungen oder Prompts. Die Technologie nutzt Deep-Learning-Modelle, die auf riesigen Datenmengen von Videos trainiert wurden, um die Beziehung zwischen Sprachbeschreibungen und visuellen Inhalten zu verstehen. Diese Modelle lernen, Muster zu erkennen – wie sich Objekte bewegen, wie Licht auf Oberflächen trifft, wie Menschen gestikulieren und Emotionen ausdrücken oder wie Szenen natürlich ineinander übergehen. Gibt ein Nutzer einen Textprompt ein, verarbeitet das KI-Modell diese Information und generiert das Video Bild für Bild, wobei es Einheitlichkeit im Aussehen von Figuren, Bewegungen und Umgebungsdetails während der gesamten Sequenz sicherstellt. Die zugrunde liegende Technologie umfasst Diffusionsmodelle und Transformer-Architekturen, die speziell für die Videogenerierung angepasst wurden und zeitliche Kohärenz ermöglichen – also, dass Objekte und Charaktere sich von Bild zu Bild natürlich und konsistent bewegen, statt zu „teleportieren“ oder zu flackern.

Die Bedeutung der KI-Videogenerierung reicht weit über den bloßen Neuheitswert hinaus. Diese Technologie adressiert grundlegende Herausforderungen der Content-Produktion: Zeit, Kosten und Skalierbarkeit. Traditionelle Videoproduktion kann Wochen oder Monate dauern und verlangt Teams von Fachleuten wie Regisseuren, Kameraleuten, Cuttern und VFX-Spezialisten. KI-Videogenerierung liefert vergleichbare Ergebnisse in Minuten und macht professionelle Videoproduktion auch für kleine Unternehmen, unabhängige Kreative und Firmen erschwinglich, die sich dies bisher nicht leisten konnten. Die Demokratisierung der Videoproduktion durch KI hat tiefgreifende Auswirkungen auf Marketing, Bildung, Entertainment und Unternehmenskommunikation. Mit zunehmender Raffinesse und Zugänglichkeit dieser Systeme verändern sie die Strategien und Workflows von Organisationen rund um visuelle Inhalte grundlegend.

Das Geschäftsargument für KI-Videogenerierung ist überzeugend und vielschichtig. In der heutigen digitalen Welt dominieren Videoinhalte sämtliche Engagement-Metriken auf allen Plattformen. Laut Branchendaten erzielen Videos deutlich höhere Interaktionsraten als Bilder oder Text – Plattformen wie TikTok, YouTube und Instagram bevorzugen Videos in ihren Algorithmen. Die Produktion hochwertiger Videos in großem Umfang war jedoch bisher für die meisten Unternehmen zu teuer. KI-Videogenerierung löst dieses Problem, indem sie Unternehmen befähigt, unbegrenzte Video-Varianten für A/B-Tests, Personalisierung und schnelle Iteration zu erstellen. Marketingteams können Dutzende Produktdemonstrationsvideos in verschiedenen Stilen und Formaten generieren – ohne erneut zu filmen. Bildungseinrichtungen erstellen personalisierte Lerninhalte im großen Maßstab. Kundenservice-Abteilungen produzieren Trainingsvideos für neue Prozesse in Echtzeit. Die wirtschaftlichen Auswirkungen sind enorm: Unternehmen können Videoproduktionskosten um 70–90 % reduzieren und gleichzeitig das Produktionsvolumen um ein Vielfaches steigern.

Über die Kostenreduzierung hinaus ermöglicht KI-Videogenerierung neue Formen von Kreativität und Experimentierfreude. Content Creators können ausgefallene Ideen testen, ohne große Ressourcen zu binden. Sie erstellen verschiedene Versionen eines Konzepts, um herauszufinden, was beim Publikum ankommt, und können Inhalte in unterschiedlichen Stilen, Tonalitäten und Formaten produzieren – passend zu Zielgruppen oder Plattformen. Dadurch wird Video von einer knappen, sorgfältig geplanten Ressource zu einem experimentellen Massenmedium. Das hat große Auswirkungen auf Content-Strategien: Statt weniger, sorgfältig geplanter Video-Produktionen pro Quartal können Organisationen einen kontinuierlichen Content-Creation-Ansatz verfolgen, bei dem Videos so alltäglich werden wie Blogbeiträge. Dieser Wandel ermöglicht reaktionsschnellere, individuellere und zielgruppenorientierte Inhalte, die Bedürfnisse und Geschäftsziele besser bedienen. Zudem entstehen neue Möglichkeiten für interaktive und dynamische Inhalte, die sich an einzelne Zuschauer anpassen und damit neue Formen von Engagement und Conversion schaffen.

Sora 2 baut auf früheren Videogenerierungsmodellen auf und bietet in mehreren Bereichen erhebliche Verbesserungen. Am auffälligsten ist die dramatische Steigerung der visuellen Qualität und Realitätsnähe. Von Sora 2 generierte Videos zeigen deutlich bessere Lichtstimmungen, natürlichere Farbgebung, detailreichere Texturen und überzeugendere Materialeigenschaften. Die Bildqualität nähert sich in vielen Fällen professionellen Standards der Filmkunst an. Das Modell meistert komplexe Szenen mit mehreren Objekten, hält konsistente Lichtverhältnisse im gesamten Bild und erzeugt realistische Spiegelungen und Schatten. Diese hohe visuelle Qualität ist für professionelle Anwendungen entscheidend, da minderwertige Ergebnisse Glaubwürdigkeit und Markenwahrnehmung schmälern würden.

Ein weiterer großer Fortschritt von Sora 2 ist die Physiksimulation. Frühere Modelle hatten oft Schwierigkeiten mit physikalischer Konsistenz – Objekte bewegten sich unnatürlich, die Schwerkraft verhielt sich widersprüchlich oder Kollisionen wurden nicht korrekt abgebildet. Sora 2 zeigt ein wesentlich besseres Verständnis physikalischer Gesetze und der Interaktion von Objekten mit ihrer Umgebung. Wird beispielsweise ein Ball geworfen, folgt er einer realistischen Flugbahn. Geht eine Person, wirken Gangbild und Gewichtsverlagerung natürlich. Kollisionen erscheinen physikalisch plausibel. Dies ist besonders relevant für Produktpräsentationen, Bildungsinhalte oder Unterhaltung, wo unrealistische Physik sofort auffallen würde. Das verbesserte Physikverständnis erlaubt zudem dynamischere und komplexere Szenen, die zuvor unmöglich waren.

Zeitliche Konsistenz und Kohärenz wurden ebenfalls entscheidend verbessert, sodass Sora-2-Videos wie echte Aufnahmen und nicht wie Aneinanderreihungen einzelner Bilder wirken. Das Modell hält die Identität von Charakteren über das gesamte Video hinweg konstant – Menschen sehen vom Anfang bis zum Ende gleich aus und verändern nicht ihre Erscheinung. Auch Umgebungsdetails bleiben stabil: Steht eine Pflanze zu Beginn im Hintergrund, bleibt sie über die ganze Sequenz hinweg am selben Ort und sieht gleich aus. Diese Konsistenz ist essenziell für professionelle Anwendungen und sorgt für ein natürliches, immersives Seherlebnis. Auch Bewegungs- und Actionszenen werden flüssig und glaubwürdig generiert, statt ruckartig oder unnatürlich zu wirken.

Eine der beeindruckendsten Funktionen von Sora 2 ist die Fähigkeit, menschliche Gesichter und Erscheinungsbilder per Gesichtsscan-Technologie präzise zu reproduzieren. Nutzer berichten, dass das Modell etwa 90 % Genauigkeit bei der Nachbildung ihrer Gesichtszüge, Mimik und feinen Details wie Hautstruktur und Lichtreflexen erreicht. Diese Präzision eröffnet Möglichkeiten, die bislang Science-Fiction waren. Betrachtet man ein von Sora 2 generiertes Video von sich selbst, ist das Erlebnis verblüffend – es ist eindeutig die eigene Person, aber in Situationen, die man nie erlebt hat, bei Handlungen, die man nie ausgeführt hat. Das Modell fängt nicht nur statische Gesichtszüge ein, sondern auch dynamische Aspekte wie Mimik und Emotionen. Die Lichtverhältnisse im Gesicht wirken realistisch, Reflexionen erscheinen in den Augen, Details wie Hautstruktur oder Haarbewegungen werden glaubwürdig wiedergegeben.

Die Auswirkungen dieser Technologie sind sowohl spannend als auch bedenklich. Positiv ist, dass Content Creators sich selbst ohne physische Anwesenheit für Aufnahmen inszenieren können. Ein YouTuber könnte Dutzende Videovarianten ohne mehrere Takes generieren. Ein Lehrer erstellt personalisierte Lerninhalte mit sich selbst als Dozent. Ein Geschäftsführer erzeugt Trainingsvideos oder Ansprachen, ohne einen Drehtermin zu benötigen. Zeit- und Kostenersparnis sind beträchtlich. Gleichzeitig wirft die Funktion Fragen zu Einwilligung, Authentizität und möglichem Missbrauch auf. Die Technologie könnte theoretisch für Deepfakes oder irreführende Inhalte mit echten Personen ohne deren Zustimmung genutzt werden. OpenAI hat Schutzmechanismen wie die Steuerung der eigenen Nutzungsrechte implementiert, aber das Missbrauchspotenzial bleibt ein gesellschaftlich relevantes Thema für Regulierung und Gesetzgebung.

Sora 2 ermöglicht kreative Anwendungen, die zuvor unmöglich oder unerschwinglich waren. Besonders unterhaltsam ist das Reanimieren beliebter fiktiver Charaktere in neuen Szenarien. Nutzer haben erfolgreich Videos von SpongeBob Schwammkopf generiert, der Drill-Rap performt – inklusive akkuratem Charakterdesign, Animationsstil und Stimmensynthese. Das Modell erfasst den unverwechselbaren visuellen Stil und hält ihn im gesamten Video konsistent. Ebenso wurden klassische Videospielszenen mit beeindruckender Genauigkeit rekreiert, etwa das ikonische Halo-Spiel mit charakteristischem Look, UI-Elementen und Erzählerstimme. Diese Anwendungen zeigen, wie Sora 2 spezifische Stilrichtungen, Charakterdesigns und ästhetische Konventionen versteht und nachbildet.

Die Unterhaltungsmöglichkeiten gehen noch weiter: Nutzer haben komplette SpongeBob-Episoden erzeugt, indem sie mehrere Sora-2-Clips aneinanderreihten und so konsistente Handlungsstränge und visuelle Stile über längere Sequenzen hinweg schufen. Das deutet auf eine Zukunft hin, in der KI Animationsproduktionen unterstützt – etwa durch das Generieren von Schlüsselszenen, die menschliche Animator:innen weiter verfeinern. Dadurch könnte die Animation demokratisiert werden, sodass auch unabhängige Kreative ohne große Teams animierte Inhalte produzieren können. Die Nachbildung von Videospielen ist ein weiteres spannendes Feld: Charaktere wurden erfolgreich in Minecraft-Umgebungen oder klassische Spiele wie Mario Kart in fotorealistischem Stil transferiert. Diese Anwendungen zeigen die Flexibilität des Modells und seine Fähigkeit, sich an verschiedene visuelle Stile und Kontexte anzupassen.

So fortschrittlich Sora 2 ist, gibt es dennoch Einschränkungen und Verbesserungsbedarf. Tests zeigen: Während die Gesichtswiedergabe im Allgemeinen sehr genau ist, gibt es Situationen, in denen das Modell inkonsistent arbeitet. Werden mehrere Videos mit demselben Prompt generiert, variiert das Ergebnis teils deutlich. Manchmal ist das Gesicht nahezu perfekt, ein anderes Mal treten subtile Morphing-Effekte oder Unterschiede in den Gesichtszügen auf. Diese Varianz deutet darauf hin, dass die Ausgabegenauigkeit noch nicht vollständig deterministisch ist – Nutzer müssen oft mehrere Versionen generieren, um die beste zu finden. Besonders in Randfällen oder komplexen Szenarien fällt diese Inkonsistenz auf.

Die Darstellung von Handbewegungen und Objektmanipulation ist derzeit eine wesentliche Einschränkung. Bei Videos mit detaillierten Handbewegungen oder Objektinteraktionen wirken Hände oft unnatürlich, Finger bewegen sich nicht realistisch oder Objekte werden nicht glaubhaft gehalten. Dies ist besonders auffällig bei feinmotorischen Tätigkeiten oder komplexen Gesten. Das Modell hat noch Schwierigkeiten, die komplexe Biomechanik menschlicher Bewegung – insbesondere der Hände und Finger – korrekt darzustellen. Die Verbesserung der Handdarstellung und -bewegung ist ein aktives Forschungsfeld.

Auch Physikfehler treten gelegentlich auf, besonders in komplexen Szenen mit mehreren Objekten oder Kräften. In manchen Videos fahren Autos rückwärts, obwohl sie vorwärts fahren sollten, Objekte schweben statt zu fallen oder Kollisionen werden nicht korrekt abgebildet. Diese Fehler sind seltener als bei früheren Modellen, aber immer noch sichtbar – vor allem in Randfällen oder bei komplexen physikalischen Interaktionen, die im Trainingsdatensatz selten vorkamen. Auch die Sprachsynthese ist nicht immer perfekt – manchmal wirken generierte Stimmen künstlich oder enthalten digitale Artefakte. Die Qualität variiert je nach Stimme und Komplexität der gesprochenen Inhalte.

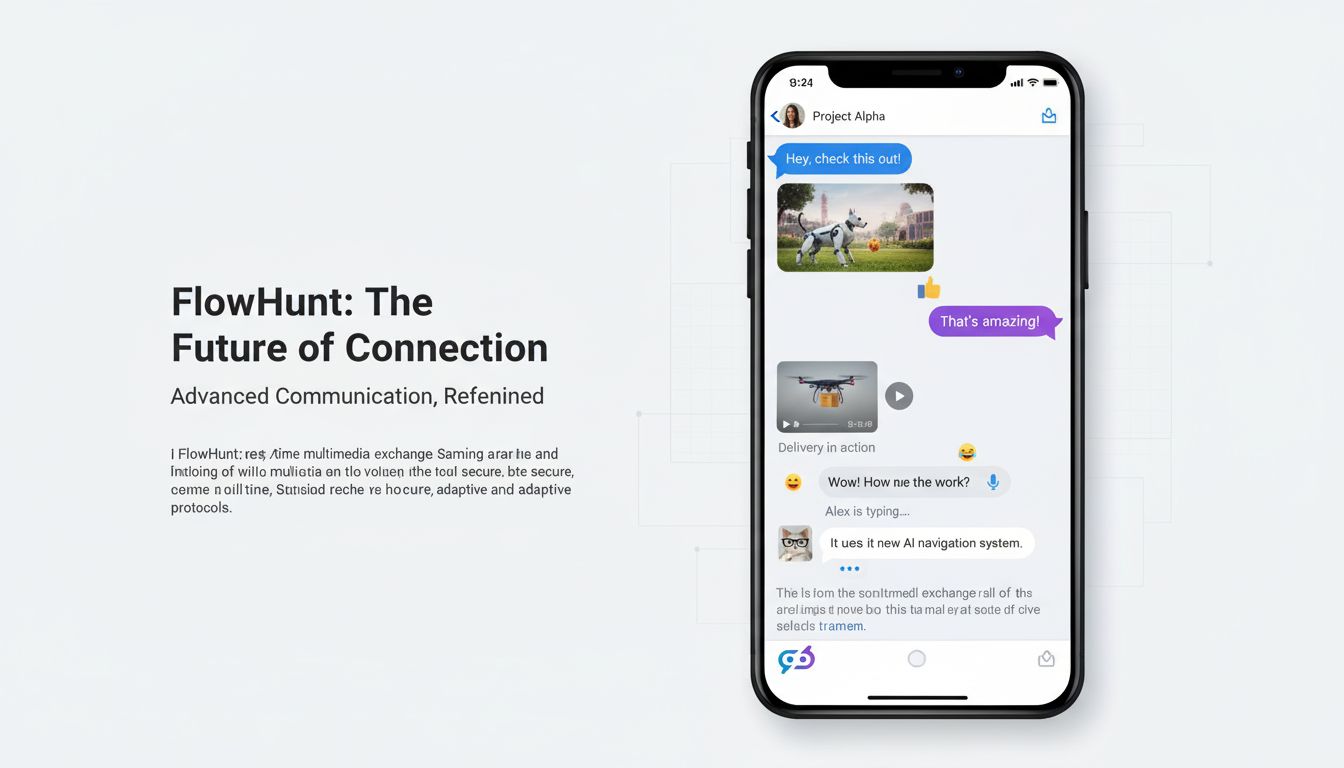

FlowHunt erkennt das transformative Potenzial der KI-Videogenerierung und integriert diese Fähigkeiten in seine Automatisierungsplattform, um Unternehmen bei der Optimierung ihrer Content-Workflows zu unterstützen. Statt Videogenerierung als isoliertes Werkzeug zu betrachten, positioniert FlowHunt KI-Videogenerierung als Teil eines umfassenden Content-Automatisierungs-Ökosystems. Dadurch können Unternehmen End-to-End-Workflows schaffen, die Videogenerierung mit anderen Content-Erstellungs-, Distributions- und Analysefunktionen kombinieren. Zum Beispiel kann ein Marketingteam einen Workflow aufsetzen, der Produktvideos erstellt, automatisch Untertitel und Branding einfügt, auf mehreren Plattformen veröffentlicht und Engagement-Metriken auswertet – alles ohne manuelle Eingriffe.

Die Integration von Sora 2 und ähnlichen Videogenerierungsmodellen in die FlowHunt-Plattform ermöglicht zahlreiche Automatisierungsszenarien. Content-Teams können wiederkehrende Aufgaben für die regelmäßige Videoproduktion einrichten. E-Commerce-Unternehmen generieren automatisch Produktvideos für neue Artikel. Marketingabteilungen erstellen personalisierte Videovarianten für verschiedene Zielgruppen. Bildungseinrichtungen produzieren Trainingsinhalte auf Abruf. Kundendienstabteilungen erstellen Anleitungs-Videos zu häufigen Anliegen. Mit der Kombination aus Videogenerierung und Workflow-Automatisierung von FlowHunt erreichen Organisationen eine nie dagewesene Skalierbarkeit und Effizienz in der Videoproduktion. Die Plattform übernimmt Orchestrierung, Terminierung und Integration in andere Systeme, sodass Teams sich auf Strategie und Kreativität statt auf manuelle Produktionsaufgaben konzentrieren können.

Die praktischen Anwendungen von Sora 2 erstrecken sich über nahezu jede Branche und jeden Unternehmensbereich. Im Marketing und in der Werbung ermöglicht Sora 2 die Erstellung von Produktpräsentationen, Testimonial-Videos und Werbeinhalten im großen Stil. Marken können mehrere Anzeigenvarianten mit unterschiedlichen Botschaften, visuellen Stilen und Calls-to-Action generieren. E-Commerce-Unternehmen erstellen Produktvideos für Tausende Artikel ohne Einzelaufnahmen. Immobilienmakler generieren virtuelle Besichtigungen, Reiseunternehmen Zielortvideos. Die Kosten- und Zeitersparnis transformiert Marketingabteilungen, die bisher unter Produktionsengpässen litten.

Im Bildungs- und Trainingsbereich ermöglicht Sora 2 personalisierte Lerninhalte, Erklärvideos und Trainingsmaterialien. Bildungseinrichtungen erstellen Videos mit Lehrkräften in verschiedenen Szenarien, erklären Inhalte auf unterschiedliche Weise oder demonstrieren Verfahren. Unternehmen produzieren Onboarding-, Sicherheits- und Weiterbildungsinhalte. Dank On-Demand-Generierung können Trainingsmaterialien bei Prozessänderungen oder neuen Informationen rasch aktualisiert werden. Personalisierung ist im großen Maßstab möglich – Lernende erhalten Videos, die auf ihren Lernstil, ihr Tempo und ihr Vorwissen zugeschnitten sind.

In der Unterhaltungs- und Medienproduktion eröffnet Sora 2 neue Möglichkeiten für Animation, visuelle Effekte und Content-Erstellung, die zuvor durch Budget oder Zeit begrenzt waren. Unabhängige Kreative produzieren animierte Inhalte ohne große Animationsteams, Film- und Fernsehproduktionen nutzen KI-generierte Inhalte für VFX, Hintergrundelemente oder ganze Szenen. Musikvideos können zu Songs generiert werden, Streaming-Plattformen produzieren effizienter originäre Inhalte. Die Technologie demokratisiert die Unterhaltungsproduktion und ermöglicht auch Kreativen mit begrenztem Budget professionelle Ergebnisse.

In der Unternehmenskommunikation und internen Organisation erzeugt Sora 2 persönliche Managementansprachen, Firmenankündigungen, Trainingsvideos und interne Dokumentation. Führungskräfte generieren individuelle Botschaften für Mitarbeitende, ohne Drehs zu organisieren. HR-Abteilungen erstellen Schulungsinhalte zu neuen Richtlinien, IT-Abteilungen Anleitungen für Softwaresysteme. Durch die schnelle und kostengünstige Produktion können Organisationen häufiger und effektiver mit Mitarbeitenden und Stakeholdern kommunizieren.

Die aktuelle Landschaft der KI-Videogenerierung gleicht vielfach einem „Urheberrechtlichen Wilden Westen“. Sora 2 kann Videos mit urheberrechtlich geschützten Charakteren, Prominenten und geistigem Eigentum generieren, ohne explizite Genehmigung der Rechteinhaber. Nutzer erstellen Videos von SpongeBob, Mario, Zelda und anderen Markencharakteren oder mit Prominenten und öffentlichen Persönlichkeiten. Dies wirft erhebliche rechtliche und ethische Fragen zu Urheberrechten, Einwilligung und zulässiger Nutzung von KI-generierten Inhalten auf. Da die Technologie Charaktere und Personen so präzise nachbilden kann, ist das Missbrauchspotenzial erheblich.

OpenAI hat gewisse Schutzmechanismen eingeführt, etwa die Möglichkeit, über Cameo-Einstellungen zu steuern, ob das eigene Abbild durch andere genutzt werden darf. Diese Maßnahmen sind jedoch begrenzt und adressieren nicht die grundsätzliche Frage, ob KI-Systeme Inhalte mit urheberrechtlich geschützten Figuren oder Prominenten ohne Erlaubnis generieren sollten. Die Rechtslage befindet sich im Wandel – Gerichte und Regulierungsbehörden ringen mit Fragen zu Fair Use, Urheberrechtsverletzung und den zulässigen Grenzen KI-generierter Inhalte. Manche vertreten, dass die private Nutzung von geschützten Figuren unter Fair Use fällt, während andere jede kommerzielle Nutzung genehmigungspflichtig sehen. Die Situation wird dadurch erschwert, dass in verschiedenen Ländern unterschiedliche Urheberrechtsgesetze und Fair-Use-Definitionen gelten.

Die ethischen Überlegungen reichen über das Urheberrecht hinaus – es geht um Authentizität, Einwilligung und möglichen Missbrauch. Zuschauer könnten Videos mit Prominenten oder öffentlichen Personen für authentisch halten, sofern nicht explizit darauf hingewiesen wird, dass es sich um KI-generierte Inhalte handelt. Das birgt Risiken für Täuschung und Desinformation. Die Technologie könnte für Deepfakes genutzt werden, die Rufschädigung oder Falschinformationen verbreiten. Zwar erschweren aktuelle Limitierungen mitunter völlig überzeugende Deepfakes, doch die Technologie entwickelt sich rasch weiter. Gesellschaft und Politik müssen Normen, Gesetze und technische Schutzmaßnahmen entwickeln, um Missbrauch zu verhindern und legitime Vorteile zu bewahren.

Die Verbesserungen von Sora 2 gegenüber früheren Modellen spiegeln Fortschritte in mehreren technischen Bereichen wider. Das Modell verwendet weiterentwickelte, auf Diffusion basierende Architekturen, die das Verhältnis zwischen Textbeschreibung und Bildinhalt besser erfassen. Das Training umfasst vielfältigere und qualitativ hochwertigere Videodaten, sodass das Modell feinere Muster im Weltgeschehen lernt. Die Modellierung von Physik, Licht und Materialeigenschaften wurde durch bessere Trainingsdaten und Loss-Funktionen verbessert, die physikalisch unrealistische Ausgaben bestrafen. Die zeitliche Konsistenz wurde durch neue Mechanismen zur Statuswahrung über Frames hinweg und verbesserte Aufmerksamkeitsmechanismen erreicht, die das Verständnis für Zusammenhänge in längeren Videosequenzen stärken.

Für die Gesichtsscan- und Charakterwiedergabe nutzt das Modell spezialisierte Komponenten, die Gesichtszüge und Identitätsmerkmale so kodieren, dass sie während der Videogenerierung erhalten bleiben. Wahrscheinlich kommen Techniken zum Einsatz, die aus Gesichtserkennungssystemen bekannt sind, aber für Videogenerierung angepasst wurden. Das Modell lernt, Identitätsinformationen mit spezifischen visuellen Mustern zu verknüpfen und diese über den gesamten Prozess beizubehalten. Die besseren Ergebnisse in der Sprachsynthese basieren auf fortschrittlicheren Text-to-Speech-Modellen und einer verbesserten Integration zwischen Video- und Audiogenerierung. So entsteht Audio, das Lippenbewegungen und Mimik der generierten Videos besser folgt und überzeugendere Gesamtergebnisse liefert.

Obwohl Sora 2 einen bedeutenden Fortschritt darstellt, lohnt sich der Vergleich mit anderen Modellen am Markt. Modelle wie Runway, Synthesia oder verschiedene Open-Source-Alternativen haben jeweils ihre eigenen Stärken und Schwächen. Runway etwa fokussiert sich auf zugängliche Tools für Kreative und eine starke Community. Synthesia spezialisiert sich auf avatarbasierte Videogenerierung für Unternehmenskommunikation. Open-Source-Modelle wie Stable Video Diffusion bieten Flexibilität und Anpassungsmöglichkeiten für Entwickler. Sora 2 hebt sich durch überlegene Bildqualität, bessere Physiksimulation und präzisere Charakterwiedergabe hervor. Auch die Erzeugung längerer Videos und die Handhabung komplexer Szenen sind Vorteile für viele Anwendungsfälle.

Sora 2 hat jedoch auch im Vergleich zu manchen Alternativen Einschränkungen. Einige Modelle bieten bessere Echtzeitgenerierung oder benötigen weniger Rechenleistung. Andere ermöglichen detailliertere Steuerung bestimmter Videoaspekte oder eine bessere Integration in spezielle Plattformen und Workflows. Die Wahl des passenden Videogenerierungsmodells hängt letztlich von Anforderungen, Use Case und Rahmenbedingungen ab. Wo maximale Bildqualität und Realismus im Vordergrund stehen, ist Sora 2 wahrscheinlich die beste Wahl. Für Anwendungen mit Echtzeitanforderungen oder spezifischen Anpassungswünschen können andere Modelle besser passen. Mit dem Fortschritt im Feld werden alle Modelle kontinuierlich besser und neue, spezialisierte Modelle für individuelle Anwendungsfälle entstehen.

Erleben Sie, wie FlowHunt Ihre KI-Content- und Videogenerierungs-Workflows automatisiert – von Recherche und Content-Erstellung bis zu Veröffentlichung und Analyse – alles an einem Ort.

Die Entwicklung der KI-Videogenerierung steht erst am Anfang dessen, was möglich ist. Zukünftige Versionen von Sora und Konkurrenzmodellen werden aktuelle Schwächen wie Handbewegungen, Physiksimulation und Konsistenz adressieren. Verbesserungen bei Videolänge, Auflösung und der Fähigkeit, noch komplexere Szenen zu handhaben, sind zu erwarten. Die Modelle werden effizienter, benötigen weniger Rechenleistung. Die Integration mit anderen KI-Systemen wird ausgefeiltere Workflows ermöglichen, in denen Videogenerierung mit anderen Formen der Contenterstellung und -analyse kombiniert wird.

Die Auswirkungen auf die Content-Erstellung sind tiefgreifend. Mit zunehmender Leistungsfähigkeit und Zugänglichkeit der KI-Videogenerierung wird Video im digitalen Raum so alltäglich wie Text. Organisationen werden Videos nicht mehr als knappe, aufwändig geplante Ressource betrachten, sondern als experimentelles Massenmedium. Das ermöglicht reaktionsschnellere, individuellere und ansprechendere Inhalte. Gleichzeitig entstehen Herausforderungen in Bezug auf Authentizität, Desinformation und die Notwendigkeit neuer Normen und Regularien für KI-generierte Inhalte. Die Technologie wird Veränderungen in kreativen Branchen auslösen, manche Rollen verdrängen, aber auch neue Chancen für diejenigen schaffen, die KI-generierte Inhalte steuern und kuratieren können.

Organisationen, die Sora 2 für Content-Erstellung nutzen möchten, können mit einigen Best Practices optimale Ergebnisse erzielen. Erstens: Verstehen Sie die Stärken und Grenzen des Modells. Sora 2 überzeugt bei realistischen Szenen mit guter Licht- und Physikdarstellung, hat aber Schwierigkeiten mit komplexen Handbewegungen und produziert teils inkonsistente Ergebnisse. Gestalten Sie Prompts, die diese Stärken nutzen. Zweitens: Generieren Sie mehrere Varianten desselben Prompts und wählen Sie die besten Ergebnisse aus – die Ausgabe variiert, mehrfache Durchläufe bringen oft bessere Resultate als das erste Ergebnis zu akzeptieren. Drittens: Nutzen Sie den Gesichtsscan für Charakterwiedergabe, wenn Genauigkeit entscheidend ist. Die Gesichtsscan-Funktion verbessert die Präzision der Gesichtsdarstellung gegenüber reinen Textbeschreibungen erheblich.

Viertens: Zerlegen Sie komplexe Videos in mehrere Clips, die Sie verbinden, statt eine lange, komplexe Szene in einem Prompt zu generieren. Das gibt mehr Kontrolle und oft bessere Ergebnisse. Fünftens: Geben Sie detaillierte, spezifische Prompts an – nicht nur was passieren soll, sondern auch Stil, Lichtstimmung und gewünschte Atmosphäre. Vage Prompts führen zu mittelmäßigen Ergebnissen, detaillierte Anweisungen zu visuellen Details, Kameraperspektiven und Ästhetik liefern deutlich bessere Ausgaben. Sechstens: Integrieren Sie die Videogenerierung in umfassende Content-Workflows mit Tools wie FlowHunt, die den gesamten Prozess von der Generierung bis zur Veröffentlichung und Analyse automatisieren. So maximieren Sie Effizienz und skalieren die Videoproduktion auf ein neues Niveau.

Mit der Verbreitung von KI-Videogenerierung sind Sorgen um Authentizität, Desinformation und Arbeitsplatzverlust berechtigt und sollten ernst genommen werden. Organisationen, die KI-generierte Inhalte nutzen, sollten transparent damit umgehen – vor allem, wenn Zuschauer davon ausgehen könnten, dass Inhalte authentisch sind. Die Offenlegung, dass Inhalte von einer KI stammen, schafft Vertrauen und hilft dem Publikum, Inhalte richtig einzuordnen. Dies ist insbesondere relevant für Inhalte, die wichtige Entscheidungen oder Meinungen beeinflussen könnten. In regulierten Branchen wie Gesundheit, Finanzen oder Recht kann es sogar spezifische Vorschriften zur Kennzeichnung von KI-Inhalten geben.

Das Missbrauchspotenzial durch Deepfakes und Desinformation ist real und verlangt proaktive Maßnahmen. Technische Mittel wie Wasserzeichen für KI-generierte Inhalte können bei der Identifikation synthetischer Medien helfen. Richtlinien und Gesetze werden sich weiterentwickeln, um Missbrauch entgegenzuwirken. Medienkompetenz und Aufklärung helfen dem Publikum, KI-Inhalte zu verstehen und kritisch zu hinterfragen. Unternehmen sollten interne Richtlinien zum verantwortungsvollen Einsatz der KI-Videogenerierung erarbeiten. Ziel muss es sein, die legitimen Vorteile zu nutzen, Missbrauch zu verhindern und das Vertrauen in Medien und Kommunikation zu erhalten.

Sora 2 markiert einen Wendepunkt in der KI-Videogenerierung und bietet Fähigkeiten, die zuvor der Science-Fiction vorbehalten waren. Das Modell erzeugt realistische, physikalisch plausible Videos mit präziser Charakterwiedergabe und eröffnet damit Content Creators, Marketern, Lehrenden und Unternehmen aller Branchen völlig neue Möglichkeiten. Trotz aktueller Grenzen bei Handbewegungen, Physikkonsistenz und Ausgabeschwankungen ist der Entwicklungspfad klar: Die Technologie wird leistungsfähiger, effizienter und zugänglicher werden. Organisationen, die Sora 2 mit seinen Möglichkeiten und Grenzen verstehen und es in ihre Content-Workflows integrieren, sichern sich entscheidende Wettbewerbsvorteile – durch geringere Produktionskosten, mehr Output und die Möglichkeit, Inhalte im großen Maßstab zu testen. Doch diese Macht bringt Verantwortung mit sich: Die Missbrauchsgefahr verlangt eine durchdachte ethische Abwägung, transparente Kommunikation über KI-Inhalte und proaktive Schutzmaßnahmen. Während Sora 2 und ähnliche Technologien die Content-Erstellung revolutionieren, werden diejenigen erfolgreich sein, die die Stärken der Technologie nutzen und dabei Authentizität, Transparenz und ethische Standards wahren.

Sora 2 ist das neueste Videogenerierungsmodell von OpenAI, das realistische, physikalisch korrekte Videos aus Text-Prompts erstellt. Es verbessert bisherige Systeme durch bessere Physiksimulation, höhere Ausgabegenauigkeit, längere Videolängen und fortschrittlichere kreative Steuerungsmöglichkeiten für Nutzer.

Ja, Sora 2 kann das Aussehen realer Personen mithilfe von Gesichtsscan-Technologie mit hoher Genauigkeit nachbilden. Nutzer berichten, dass das Modell etwa 90 % Genauigkeit bei der Reproduktion von Gesichtszügen, Mimik und sogar Hintergrundeinflüssen erreicht, sofern entsprechende Referenzdaten bereitgestellt werden.

So beeindruckend Sora 2 auch ist, gibt es dennoch Einschränkungen wie gelegentliches Morphen zwischen mehreren Subjekten, inkonsistente Handbewegungen, Physikfehler in komplexen Szenen sowie schwankende Ausgabequalität bei mehrmaliger Generierung desselben Prompts. Auch die Sprachsynthese benötigt in manchen Fällen noch Verbesserungen.

Unternehmen können Sora 2 zur Erstellung von Marketingvideos, Produktpräsentationen, Trainingsinhalten, Social-Media-Clips und Entertainment nutzen. Die Technologie kann die Produktionszeit und -kosten erheblich reduzieren, indem sie die Videoproduktion aus Textbeschreibungen automatisiert – und ist so besonders wertvoll für Marketing-, Bildungs- und Unterhaltungsbranchen.

Arshia ist eine AI Workflow Engineerin bei FlowHunt. Mit einem Hintergrund in Informatik und einer Leidenschaft für KI spezialisiert sie sich darauf, effiziente Arbeitsabläufe zu entwickeln, die KI-Tools in alltägliche Aufgaben integrieren und so Produktivität und Kreativität steigern.

Integrieren Sie KI-Videogenerierung in Ihre Content-Pipeline und optimieren Sie die Produktion vom Konzept bis zur Veröffentlichung.

Entdecken Sie Sora 2s bahnbrechende Fähigkeiten in der KI-Videogenerierung – von realitätsnaher Charakterwiedergabe bis hin zu Physiksimulation – und erfahren S...

Erfahren Sie alles, was Sie über die Sora-2 App wissen müssen – ihre Funktionen, Anwendungsfälle und wie sie im Vergleich zu führenden KI-Videogeneratoren absch...

Entdecken Sie, wie KI-gestützte Gesichtstausch-Tools wie Wan 2.2 Animate die TikTok-Videoerstellung transformieren und es Creatorn ermöglichen, virale Inhalte i...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.