Beispiele für MCP-Server: Intelligente Integrationen für KI-Agenten entwickeln

Entdecken Sie umfassende Beispiele für MCP-Server und erfahren Sie, wie Sie Model Context Protocol Server aufbauen, bereitstellen und integrieren, um die Fähigk...

Erfahren Sie, was MCP (Model Context Protocol) Server sind, wie sie funktionieren und warum sie die AI-Integration revolutionieren. Entdecken Sie, wie MCP die Verbindung von KI-Agenten zu Tools, Datenquellen und APIs vereinfacht.

Die rasante Entwicklung der künstlichen Intelligenz hat eine nie dagewesene Nachfrage nach nahtloser Integration zwischen KI-Modellen und externen Systemen geschaffen. Entwickler und Unternehmen standen jedoch lange vor einer grundlegenden Herausforderung: Die Verbindung mehrerer Large Language Models (LLMs) mit zahlreichen Tools, APIs und Datenquellen erforderte den Aufbau und die Wartung unzähliger individueller Integrationen. Diese Komplexität bremste die Entwicklung wirklich leistungsfähiger KI-Agenten aus, die auf reale Informationen zugreifen und sinnvolle Aktionen ausführen können. Hier kommt das Model Context Protocol (MCP) ins Spiel – ein revolutionärer Open-Source-Standard, der grundlegend verändert, wie KI-Anwendungen mit ihrer Umgebung verbunden werden. In diesem umfassenden Leitfaden erfahren Sie, was MCP-Server sind, wie sie funktionieren, warum sie wichtig sind und wie sie die Landschaft der KI-Automatisierung und -Integration verändern.

Das Model Context Protocol stellt einen Paradigmenwechsel dar, wie KI-Systeme mit externen Daten und Tools interagieren. Im Kern ist MCP ein Open-Source-Standard, der einen einheitlichen, standardisierten Weg für KI-Anwendungen bietet, sich mit externen Systemen zu verbinden. Stellen Sie es sich wie einen universellen Adapter vor oder – wie viele in der Branche sagen – wie den „USB-C-Port für KI-Anwendungen“. So wie USB-C einen standardisierten Anschluss bietet, der herstellerübergreifend funktioniert, stellt MCP ein standardisiertes Protokoll zur Verfügung, das über verschiedene KI-Modelle und externe Systeme hinweg funktioniert. Diese Standardisierung beseitigt die Notwendigkeit individueller Integrationen zwischen jedem LLM und jedem Tool oder jeder Datenquelle. Vor MCP standen Entwickler vor einer exponentiell wachsenden Komplexität, je mehr KI-Modelle oder externe Systeme sie in ihre Anwendungen einbinden wollten. MCP vereinfacht diese Architektur grundlegend, indem es eine einzige, konsistente Schnittstelle schafft, über die alle KI-Anwendungen und externen Systeme miteinander kommunizieren können.

Das Protokoll wurde von Anthropic entwickelt und als Open-Source-Initiative veröffentlicht, um einen entscheidenden Engpass im KI-Ökosystem zu lösen. Statt Entwickler dazu zu zwingen, das Rad für jede neue Kombination aus KI-Modell und externem System neu zu erfinden, bietet MCP einen standardisierten Rahmen, der Entwicklungszeit, Wartungsaufwand und Integrationskomplexität drastisch reduziert. Dieser Ansatz findet in der Entwickler-Community großen Anklang, weil er eine grundlegende Wahrheit anerkennt: Die Zukunft der KI besteht nicht aus isolierten Chatbots, sondern aus intelligenten Agenten, die Informationen nahtlos abrufen, mit Systemen interagieren und Aktionen im gesamten Technologie-Stack eines Unternehmens ausführen können.

Bevor wir tiefer darauf eingehen, wie MCP funktioniert, ist es wichtig, das Problem zu verstehen, das damit gelöst wird – eine Herausforderung, die die KI-Entwicklung seit dem Aufkommen leistungsfähiger Sprachmodelle begleitet. Dieses Problem ist als „NxM-Problem“ bekannt, wobei N für die Anzahl der verfügbaren LLMs und M für die Anzahl der Tools, APIs und Datenquellen steht, die Unternehmen mit diesen Modellen verbinden wollen. Ohne ein standardisiertes Protokoll benötigt jedes LLM individuellen Integrationscode für jedes Tool – das ergibt N mal M Integrationspunkte. Das führt zu einer exponentiellen Komplexität, die mit zunehmender Skalierung der KI-Initiativen immer schwieriger zu verwalten ist.

Ein praktisches Beispiel: Ein Unternehmen möchte sowohl Claude als auch ChatGPT verwenden, um mit seiner WordPress-Seite, seinem Notion-Workspace, Google Kalender und einer internen Datenbank zu interagieren. Ohne MCP müssten Entwickler acht separate Integrationen erstellen – je eine für Claude zu WordPress, Claude zu Notion, Claude zu Google Kalender, Claude zur Datenbank und dasselbe nochmal für ChatGPT. Jede Integration erfordert individuellen Code, Tests und laufende Wartung. Entscheidet sich das Unternehmen später, ein drittes KI-Modell oder eine fünfte Datenquelle hinzuzufügen, wächst die Anzahl der Integrationen exponentiell. Diese Redundanz schafft mehrere Probleme: Entwicklungsteams lösen immer wieder die gleichen Integrationsherausforderungen, die Wartung wird mit der Weiterentwicklung von Tools und APIs zum Albtraum, und inkonsistente Implementierungen führen zu unvorhersehbarem Verhalten und schlechter Nutzererfahrung.

MCP löst dieses Problem, indem es die NxM-Beziehung aufbricht. Statt N×M Integrationen benötigt MCP nur N+M Verbindungen. Jedes LLM verbindet sich einmal mit dem MCP-Protokoll, und jedes Tool oder jede Datenquelle stellt sich einmal über einen MCP-Server zur Verfügung. Diese lineare Beziehung reduziert Komplexität und Wartungsaufwand drastisch. Wird ein neues KI-Modell verfügbar, muss es MCP nur einmal implementieren, um Zugriff auf alle bestehenden MCP-Server zu erhalten. Ebenso muss ein neues Tool oder eine neue Datenquelle nur noch eine MCP-Server-Schnittstelle bereitstellen, um für alle MCP-kompatiblen Anwendungen verfügbar zu sein. Diese elegante Lösung hat weitreichende Auswirkungen darauf, wie Unternehmen ihre KI-Infrastruktur aufbauen und skalieren können.

Ein MCP-Server ist im Grunde eine Sammlung von Tools, APIs und Wissensdatenbanken, die unter einer einzigen, standardisierten Schnittstelle gebündelt sind. Anstatt dass ein KI-Agent zwanzig verschiedene API-Endpunkte ansprechen und zwanzig verschiedene Authentifizierungsmethoden verwalten muss, konsolidiert ein MCP-Server all dies in einer einzigen Komponente. Dieser architektonische Ansatz vereinfacht den Integrationsprozess erheblich und macht KI-Agenten wesentlich effizienter darin, die benötigten Tools zu entdecken und zu nutzen.

Wie das in der Praxis aussieht, zeigt der WordPress-MCP-Server: Statt dass ein KI-Agent einzelne WordPress REST API-Endpunkte für Beiträge, Seiten, Medien, Nutzer, Kategorien, Tags, Kommentare und Plugins kennen und ansprechen muss, stellt der WordPress-MCP-Server all diese Funktionen über eine einzige Schnittstelle bereit. Der MCP-Server enthält verschiedene Tools – Beitrag erstellen, Beiträge auflisten, Beitrag abrufen, Beitrag löschen, Seite erstellen, Seiten auflisten usw. –, jeweils mit klarer Bezeichnung und Beschreibung. Wenn ein KI-Agent eine Aktion ausführen muss, fragt er beim MCP-Server an, der eine Liste verfügbarer Tools mit Beschreibungen zurückliefert. Der Agent kann dann intelligent das passende Tool auswählen und ausführen, ohne die zugrundeliegende API-Komplexität verstehen zu müssen.

Die Architektur von MCP besteht aus mehreren zentralen Komponenten, die zusammenarbeiten. Erstens gibt es den MCP-Client, meist die KI-Anwendung oder der Agent, der auf externe Tools und Daten zugreifen möchte. Der Client initiiert die Verbindungen und stellt Anfragen. Zweitens gibt es den MCP-Server, der Tools, Ressourcen und Fähigkeiten über die standardisierte MCP-Schnittstelle bereitstellt. Der Server übernimmt die eigentliche Integration mit externen Systemen und die Ausführung der Tools. Drittens gibt es das Protokoll selbst, das definiert, wie Clients und Server kommunizieren – inklusive Format von Anfragen, Antworten und Fehlern. Diese Dreiteilung sorgt für eine klare Trennung der Verantwortlichkeiten und macht das System wartbar und skalierbar.

Einer der elegantesten Aspekte des MCP-Designs ist die Handhabung von Tool-Discovery und -Ausführung. Jedes über einen MCP-Server bereitgestellte Tool enthält nicht nur das Tool selbst, sondern auch Metadaten – Name, Beschreibung, Parameter und erwartete Ausgaben. Verbindet sich ein KI-Agent mit einem MCP-Server, erhält er diese Metadaten und kann so verstehen, welche Tools verfügbar sind und wann sie eingesetzt werden sollten. Das unterscheidet sich grundlegend von traditionellen API-Integrationen, bei denen Entwickler jeden Endpunkt manuell konfigurieren und das KI-Modell über dessen Fähigkeiten unterrichten müssen. Mit MCP ist der Entdeckungsprozess automatisiert und standardisiert – so können KI-Agenten leichter passende Tools für jede Aufgabe finden und nutzen.

FlowHunt erkennt das transformative Potenzial von MCP-Servern im Bereich der KI-Automatisierung und hat umfassende Unterstützung für die MCP-Integration in seine Plattform integriert. Durch den Einsatz von MCP-Servern können Nutzer von FlowHunt komplexe KI-Workflows erstellen, die problemlos auf verschiedene Tools und Datenquellen zugreifen – und das ohne die übliche Komplexität manueller API-Konfiguration. Diese Integration stellt einen bedeutenden Fortschritt dar, wie Unternehmen Geschäftsprozesse mittels KI-Agenten automatisieren können.

Innerhalb von FlowHunt können Nutzer MCP-Server einfach zu ihren Workflows hinzufügen und erhalten sofort Zugriff auf alle von diesen Servern bereitgestellten Tools und Funktionen. Beispielsweise ermöglicht das Hinzufügen eines WordPress-MCP-Servers zu einem FlowHunt-Workflow die sofortige Nutzung von Beitrags- und Seitenverwaltung, Medienhandling, Nutzerverwaltung und dutzenden weiteren WordPress-Operationen – alles ohne manuelle Konfiguration einzelner API-Endpunkte. Das beschleunigt die Workflow-Entwicklung erheblich und senkt die technischen Hürden für leistungsstarke KI-Automatisierung. Der Ansatz von FlowHunt bei der MCP-Integration zeigt, wie das Protokoll eine neue Generation von KI-Automatisierungsplattformen ermöglicht, die Benutzerfreundlichkeit und schnelle Entwicklung in den Vordergrund stellen, ohne auf Leistungsfähigkeit oder Flexibilität zu verzichten.

Die Unterstützung von MCP-Servern in FlowHunt geht über einfachen Tool-Zugriff hinaus. Nutzer können mehrere MCP-Server zu komplexen Workflows verketten und so KI-Agenten Aktionen über verschiedene Systeme hinweg ausführen lassen – als Reaktion auf Nutzeranfragen oder automatische Auslöser. Das eröffnet neue Automatisierungsszenarien, etwa das automatische Erstellen von WordPress-Beiträgen auf Basis KI-generierter Inhalte, das Aktualisieren von Notion-Datenbanken mit Informationen aus mehreren Quellen oder die Synchronisierung von Daten in Echtzeit über mehrere Plattformen hinweg. Durch die Abstraktion der technischen Komplexität der MCP-Server-Integration können sich FlowHunt-Nutzer auf die Gestaltung intelligenter Workflows konzentrieren, statt sich mit technischen Integrationsdetails herumschlagen zu müssen.

Die theoretischen Vorteile von MCP-Servern schlagen sich in messbaren Verbesserungen bei realen Anwendungen nieder. Unternehmen, die MCP-basierte Architekturen nutzen, berichten von deutlich verkürzten Entwicklungszeiten – in manchen Teams sind Integrationszyklen 50–70 % schneller als bei herkömmlicher individueller API-Integration. Diese Beschleunigung resultiert aus der Beseitigung doppelter Entwicklungsarbeit und der Standardisierung von MCP-Implementierungen. Muss ein Entwickler ein neues Tool in einen KI-Workflow einbinden, beginnt er nicht mehr bei Null, sondern nutzt einen vorhandenen, von den Tool-Erstellern oder der Community gebauten, getesteten und dokumentierten MCP-Server.

Auch beim Wartungsaufwand liefert MCP erhebliche Vorteile. In traditionellen Architekturen müssen Entwickler bei Änderungen an einer API individuellen Integrationscode in potenziell mehreren Anwendungen und KI-Modellen anpassen. Mit MCP liegt der Wartungsaufwand vor allem bei den MCP-Server-Maintainern, die den Server einmal aktualisieren – alle Anwendungen, die diesen Server nutzen, profitieren automatisch von den Änderungen, ohne selbst Code anpassen zu müssen. Dieses zentralisierte Wartungsmodell reduziert die laufenden Betriebskosten für KI-Integrationen erheblich und erlaubt Entwicklerteams, sich auf neue Funktionen statt auf die Pflege bestehender Integrationen zu konzentrieren.

Aus Endnutzersicht ermöglichen MCP-Server leistungsfähigere und reaktionsschnellere KI-Anwendungen. Nutzer können KI-Agenten mit komplexen Aufgaben über mehrere Systeme hinweg beauftragen – „Erstelle einen neuen Blogbeitrag in WordPress basierend auf diesem Notion-Dokument und teile ihn in den sozialen Medien“ – und der Agent kann diese Aufgaben nahtlos ausführen, weil alle nötigen Tools über standardisierte MCP-Schnittstellen bereitstehen. So entsteht eine natürlichere und leistungsfähigere Nutzererfahrung, bei der KI-Agenten wie echte Assistenten agieren, die das gesamte Technologie-Ökosystem des Nutzers verstehen und bedienen können.

Für Entwickler, die eigene MCP-Server bauen möchten, liefert das Protokoll einen klaren, gut dokumentierten Rahmen zur Bereitstellung von Tools und Ressourcen. Der Bau eines MCP-Servers beinhaltet das Definieren der bereitgestellten Tools, das Festlegen von Parametern und Rückgabewerten sowie die Implementierung der Geschäftslogik, die bei Aufruf eines Tools ausgeführt wird. Die MCP-Spezifikation gibt detaillierte Vorgaben zur Strukturierung dieses Codes und zur Kommunikation mit MCP-Clients. Dank dieser Standardisierung müssen Entwickler keine neuen Muster für jeden Server erfinden, sondern können etablierte Best Practices nutzen und sich auf die spezifische Funktionalität konzentrieren.

Das Bereitstellungsmodell für MCP-Server ist flexibel und unterstützt verschiedene Architekturen. Server können als eigenständige Prozesse auf dem Entwicklerrechner laufen, in der Cloud bereitgestellt oder in größere Anwendungen eingebettet werden. So können Unternehmen Bereitstellungsstrategien wählen, die zu ihrer Infrastruktur und ihren Sicherheitsanforderungen passen. Manche betreiben MCP-Server lokal für Entwicklung und Tests, andere stellen sie produktiv in der Cloud bereit, wieder andere binden sie direkt in Anwendungen ein, um lokale Tool-Zugriffe ohne externe Netzwerkanfragen zu ermöglichen. Diese Flexibilität ist einer der Gründe für die schnelle Verbreitung von MCP in der Entwickler-Community.

Sicherheitsaspekte sind beim Bau und Betrieb von MCP-Servern besonders wichtig, vor allem wenn diese Zugriff auf sensible Systeme oder Daten bieten. Die MCP-Spezifikation enthält Empfehlungen zu Authentifizierung, Autorisierung und sicherer Kommunikation zwischen Client und Server. Entwickler müssen sorgfältig regeln, wer auf welche Tools zugreifen darf, und entsprechende Zugriffskontrollen umsetzen. So könnte ein WordPress-MCP-Server bestimmte Operationen wie das Löschen von Beiträgen oder das Ändern von Nutzerrechten nur authentifizierten Nutzern mit passenden Rollen erlauben. Ein Datenbank-MCP-Server wiederum kann Abfragefunktionen einschränken, um unbefugten Datenzugriff zu verhindern. Diese Sicherheitsüberlegungen sind nicht MCP-spezifisch, doch die Standardisierung des Protokolls erleichtert die konsistente Umsetzung bewährter Sicherheitspraktiken.

Das MCP-Ökosystem ist seit Einführung des Protokolls rasant gewachsen. Entwickler und Unternehmen haben MCP-Server für eine beeindruckende Vielfalt an Tools und Plattformen geschaffen. Das offizielle MCP-Register listet Server für populäre Plattformen wie WordPress, Notion, Google Kalender, GitHub, Slack und viele weitere. Dieses wachsende Ökosystem ermöglicht es Unternehmen oft, bereits fertige MCP-Server für ihre genutzten Tools zu finden, ohne eigene Integrationen von Grund auf bauen zu müssen. Wo noch kein MCP-Server existiert, macht die Standardisierung des Protokolls es Entwicklern leicht, selbst einen zu erstellen.

Die Vielfalt verfügbarer MCP-Server zeigt die Vielseitigkeit des Protokolls. Manche Server bieten einfachen, schreibgeschützten Datenzugriff – etwa einen Server, der KI-Agenten die Suche und den Abruf von Informationen aus einer Wissensdatenbank ermöglicht. Andere bieten vollständige CRUD-Operationen (Create, Read, Update, Delete), sodass KI-Agenten externe Systeme umfangreich steuern können. Wieder andere Server stellen spezialisierte Fähigkeiten wie Bildgenerierung, Datenanalyse oder Codeausführung bereit. Diese Vielfalt entspricht dem Bedarf unterschiedlicher Unternehmen – und MCPs flexible Architektur deckt diese Bandbreite ab, während die Schnittstelle konsistent bleibt.

Community-Beiträge waren entscheidend für den Ausbau des MCP-Ökosystems. Entwickler haben Server für Nischen-Tools und -Plattformen gebaut, weil bereits das Vorhandensein eines MCP-Servers die Integration dieses Tools mit KI-Anwendungen enorm erleichtert – auch wenn es nicht weit verbreitet ist. Dieser Community-getriebene Ansatz schafft einen positiven Kreislauf: Je mehr MCP-Server es gibt, desto mehr Unternehmen setzen MCP-basierte Architekturen ein, was wiederum mehr Entwickler motiviert, weitere Server zu bauen. So entsteht ein schnell wachsendes Ökosystem, das MCP mit jedem neuen Tool wertvoller macht.

Mit zunehmender Reife von KI-Nutzung in Unternehmen ermöglichen MCP-Server immer komplexere und leistungsfähigere Workflows. Ein spannender Anwendungsfall ist Multi-System-Orchestrierung: KI-Agenten koordinieren Aktionen über mehrere Plattformen hinweg, gesteuert durch Nutzeranfragen oder automatische Auslöser. Ein Marketingteam könnte etwa einen KI-Agenten nutzen, der Social-Media-Erwähnungen überwacht, basierend auf aktuellen Trends Blogbeiträge in WordPress erstellt, einen Notion-Content-Kalender aktualisiert und Beiträge auf mehreren Plattformen plant – alles gesteuert durch einen einzigen KI-Agenten, der auf mehrere MCP-Server zugreift.

Ein anderer fortgeschrittener Anwendungsfall ist die Datenaggregation und -analyse. Unternehmen können MCP-Server schaffen, die Daten aus mehreren internen Systemen bereitstellen, sodass KI-Agenten Informationen aus verschiedenen Quellen sammeln, analysieren und daraus Erkenntnisse gewinnen können. Ein Finanzdienstleister könnte beispielsweise MCP-Server für das Buchhaltungssystem, CRM und Marktdatenanbieter erstellen, damit ein KI-Agent Kundenprofitabilität, Markttrends und Finanzperformance integriert auswerten kann. So wird KI vom Tool für Einzeldaten zum echten Business-Intelligence-System, das Informationen unternehmensweit verknüpft.

Personalisierung und Kontextbewusstsein markieren ein weiteres Zukunftsfeld für MCP-Anwendungen. Indem Nutzerdaten, Präferenzen und Historien über MCP-Server bereitgestellt werden, können Anwendungen KI-Agenten mit reichhaltigem Kontext zu einzelnen Nutzern versorgen. So liefern KI-Agenten hochpersonalisierte Erlebnisse, merken sich Präferenzen, verstehen Ziele und passen ihre Antworten entsprechend an. Ein KI-Kundenservice-Agent könnte beispielsweise auf MCP-Server zugreifen, die Kaufhistorie, Support-Tickets und Präferenzen offenlegen, um personalisierte Unterstützung zu bieten, die die individuelle Situation des Kunden berücksichtigt.

Um den Wert von MCP voll zu erfassen, lohnt sich der Vergleich mit klassischen Integrationsansätzen für KI-Anwendungen. In traditionellen Architekturen konfigurieren Entwickler jede API-Integration einzeln, schreiben individuellen Code für Authentifizierung, Anfragen, Fehlerbehandlung und Antwortverarbeitung. Für einfache Integrationen funktioniert das, doch mit wachsender Zahl integrierter Systeme wird es unübersichtlich: Jede neue Integration verlangt vom Entwickler, sich in die jeweilige API-Dokumentation einzuarbeiten, Besonderheiten und Einschränkungen zu verstehen und passenden Code zu schreiben.

Auch beim Unterhalt entstehen in klassischen Architekturen erhebliche Herausforderungen. Ändert sich eine API, müssen Entwickler ihren Integrationscode anpassen. Kommt eine neue API-Version, müssen sie entscheiden, ob sie upgraden und eventuelle Breaking Changes handhaben. Will das Unternehmen ein neues KI-Modell hinzufügen, müssen alle API-Integrationen für dieses Modell neu geschaffen werden. Diese Herausforderungen summieren sich im Laufe der Zeit zu technischem Ballast, der Entwicklung verlangsamt und Kosten erhöht.

MCP begegnet diesen Herausforderungen durch Standardisierung und Abstraktion. Anstatt für jede API individuellen Code zu schreiben, implementieren Entwickler das MCP-Protokoll einmal pro Tool oder Datenquelle. Dadurch erhalten alle KI-Anwendungen automatisch Zugriff auf alle MCP-Server – ohne eigenen Integrationscode. Ändert sich eine API, passen die MCP-Server-Maintainer den Server an und alle angebundenen Anwendungen profitieren automatisch. Wird ein neues KI-Modell angebunden, muss es MCP nur einmal implementieren, um Zugriff auf alle vorhandenen MCP-Server zu erhalten. Dieser architektonische Ansatz verändert die Wirtschaftlichkeit der KI-Integration grundlegend – sie wird deutlich effizienter und skalierbarer.

Das MCP-Ökosystem entwickelt sich rasant weiter, mit laufender Arbeit an neuen Funktionen, besserer Performance und neuen Anwendungsfällen. Ein Fokus liegt auf der Erweiterung der Protokollunterstützung für Echtzeit-Datenströme und ereignisgetriebene Architekturen. Mit zunehmender Komplexität von KI-Anwendungen wird es immer wertvoller, wenn MCP-Server in Echtzeit Updates an Clients pushen können. So könnte ein KI-Agent sofort auf Ereignisse in externen Systemen reagieren, statt auf den nächsten Abfragezyklus zu warten. Diese Fähigkeit würde neue Möglichkeiten für reaktive, ereignisgetriebene KI-Workflows eröffnen.

Ein weiteres Entwicklungsfeld ist die Unterstützung komplexer, mehrstufiger Operationen. Während aktuelle MCP-Implementierungen Einzelfunktionsaufrufe gut handhaben, wächst das Interesse, MCP-Servern die Bereitstellung höherwertiger, mehrstufiger Operationen zu ermöglichen. So könnten KI-Agenten komplexe Abläufe anfordern wie „migriere diese WordPress-Seite zu einem neuen Hoster“ oder „konsolidiere diese drei Datenbanken zu einem Data Warehouse“, wobei der MCP-Server die gesamte Logik übernimmt. Diese Weiterentwicklung würde technische Details noch stärker abstrahieren und KI-Agenten auf höherer Ebene arbeiten lassen.

Sicherheit und Governance sind ein weiteres zentrales Thema für die MCP-Community. Da MCP-Server immer sensiblere Systeme und Daten anbinden, werden robuste Sicherheits-, Protokollierungs- und Governance-Funktionen immer wichtiger. Die Community arbeitet aktiv an Standards für Authentifizierung, Autorisierung, Verschlüsselung und Audit-Trails, um Unternehmen eine sichere MCP-Nutzung auch in regulierten Branchen wie Finanzen, Gesundheitswesen und öffentlichem Sektor zu ermöglichen. Diese Entwicklungen sind entscheidend für die MCP-Einführung in solchen Umgebungen.

Für Unternehmen, die MCP einführen möchten, gibt es mehrere praktische Überlegungen zur Strategie. Analysieren Sie zunächst Ihren aktuellen Technologie-Stack und identifizieren Sie, welche Tools und Systeme am meisten von einer MCP-Integration profitieren würden. Priorisieren Sie Systeme, die von mehreren Anwendungen genutzt werden oder besonders komplexe Integrationen erfordern – hier erzielen Sie mit MCP den größten Nutzen. Prüfen Sie als Nächstes, ob für Ihre wichtigsten Systeme bereits MCP-Server existieren. Falls ja, können Sie diese sofort nutzen; falls nicht, prüfen Sie, ob Sie mit Ihren Ressourcen eigene MCP-Server entwickeln können.

Weiterhin sollten Sie Ihre Bereitstellungsarchitektur und Sicherheitsanforderungen abwägen. Entscheiden Sie, ob MCP-Server lokal, in der Cloud oder als eingebettete Komponente laufen sollen. Klären Sie, wie Authentifizierung und Autorisierung gehandhabt werden, insbesondere wenn MCP-Server sensible Systeme oder Daten anbinden. Planen Sie außerdem eine schrittweise Einführung statt einer Komplettumstellung: Starten Sie mit einem Pilotprojekt, das MCP-Server für einen bestimmten Workflow oder Use Case einsetzt. So sammelt Ihr Team Erfahrungen, erkennt Herausforderungen und kann die Strategie vor der breiten Einführung anpassen.

Abschließend lohnt sich die Investition in Schulung und Dokumentation für Ihr Entwicklerteam. MCP ist zwar entwicklerfreundlich konzipiert, dennoch profitieren Teams vom Verständnis der Protokoll-Architektur, der Best Practices beim Bau von MCP-Servern und der Integration in eigene Anwendungen. Online finden Sie viele Ressourcen – von offizieller Dokumentation über Community-Tutorials bis zu Beispielimplementierungen. Der Aufbau dieses Know-hows wird die effektive MCP-Nutzung in Ihrem Unternehmen beschleunigen.

Das Model Context Protocol markiert einen grundlegenden Wandel darin, wie KI-Anwendungen mit externen Systemen und Datenquellen verbunden werden. Durch eine standardisierte, universelle Schnittstelle für KI-System-Integration beseitigt MCP die exponentielle Komplexität herkömmlicher, individueller API-Anbindungen. Das Protokoll löst das NxM-Problem, reduziert Entwicklungszeit und Wartungsaufwand erheblich und ermöglicht Unternehmen, leistungsfähigere KI-Anwendungen zu bauen, die das gesamte Technologie-Ökosystem nutzen können. Mit dem weiteren Wachstum und der Reifung des MCP-Ökosystems, einer stetig steigenden Zahl verfügbarer Server und laufenden Protokollverbesserungen wird MCP zum Standard für KI-Integration über Branchen hinweg. Unternehmen, die MCP frühzeitig einführen, verschaffen sich entscheidende Wettbewerbsvorteile bei der schnellen Entwicklung und Bereitstellung anspruchsvoller KI-Automatisierungslösungen. Ob Sie KI-Anwendungen bauen, Tools und Plattformen entwickeln oder IT-Infrastrukturen betreuen – das Verständnis und der Einsatz von MCP-Servern werden im KI-getriebenen Zeitalter immer wichtiger.

Erleben Sie, wie FlowHunt Ihre KI-Content- und SEO-Workflows automatisiert – von Recherche und Content-Generierung bis hin zu Veröffentlichung und Analyse – alles an einem Ort. Nutzen Sie MCP-Server, um Ihren gesamten Technologie-Stack nahtlos zu verbinden.

MCP steht für Model Context Protocol. Es handelt sich um einen Open-Source-Standard, der von Anthropic entwickelt wurde und eine standardisierte Möglichkeit bietet, KI-Anwendungen wie Claude und ChatGPT mit externen Systemen, Datenquellen und Tools zu verbinden.

Das NxM-Problem beschreibt die Komplexität, N verschiedene LLMs mit M verschiedenen Tools und Datenquellen zu integrieren. MCP löst dies durch einen universellen Standard und eliminiert die Notwendigkeit individueller Integrationen zwischen jedem LLM- und Tool-Paar. Statt N×M Integrationen benötigen Sie nur N+M Verbindungen.

MCP-Server reduzieren Entwicklungszeit und Komplexität, bieten Zugang zu einem Ökosystem von Datenquellen und Tools, vermeiden doppelte Integrationsarbeit, verringern den Wartungsaufwand und ermöglichen leistungsfähigere KI-Anwendungen, die auf Echtzeitdaten zugreifen und im Namen der Nutzer Aktionen ausführen können.

Ja, MCP ist modellunabhängig konzipiert. Es funktioniert mit verschiedenen KI-Anwendungen wie Claude, ChatGPT und anderen LLMs. Diese universelle Kompatibilität ist einer der Hauptvorteile des MCP-Standards.

MCP-Server können praktisch jedes externe System integrieren, darunter APIs, Datenbanken, Wissensdatenbanken, Dateisysteme, Webdienste und spezialisierte Tools. Häufige Beispiele sind WordPress, Google Kalender, Notion, Figma, Blender und Unternehmensdatenbanken.

Arshia ist eine AI Workflow Engineerin bei FlowHunt. Mit einem Hintergrund in Informatik und einer Leidenschaft für KI spezialisiert sie sich darauf, effiziente Arbeitsabläufe zu entwickeln, die KI-Tools in alltägliche Aufgaben integrieren und so Produktivität und Kreativität steigern.

Integrieren Sie MCP-Server nahtlos in Ihre KI-Automatisierungs-Workflows. Verbinden Sie Ihre Tools, Datenquellen und APIs ohne komplexe Konfigurationen.

Entdecken Sie umfassende Beispiele für MCP-Server und erfahren Sie, wie Sie Model Context Protocol Server aufbauen, bereitstellen und integrieren, um die Fähigk...

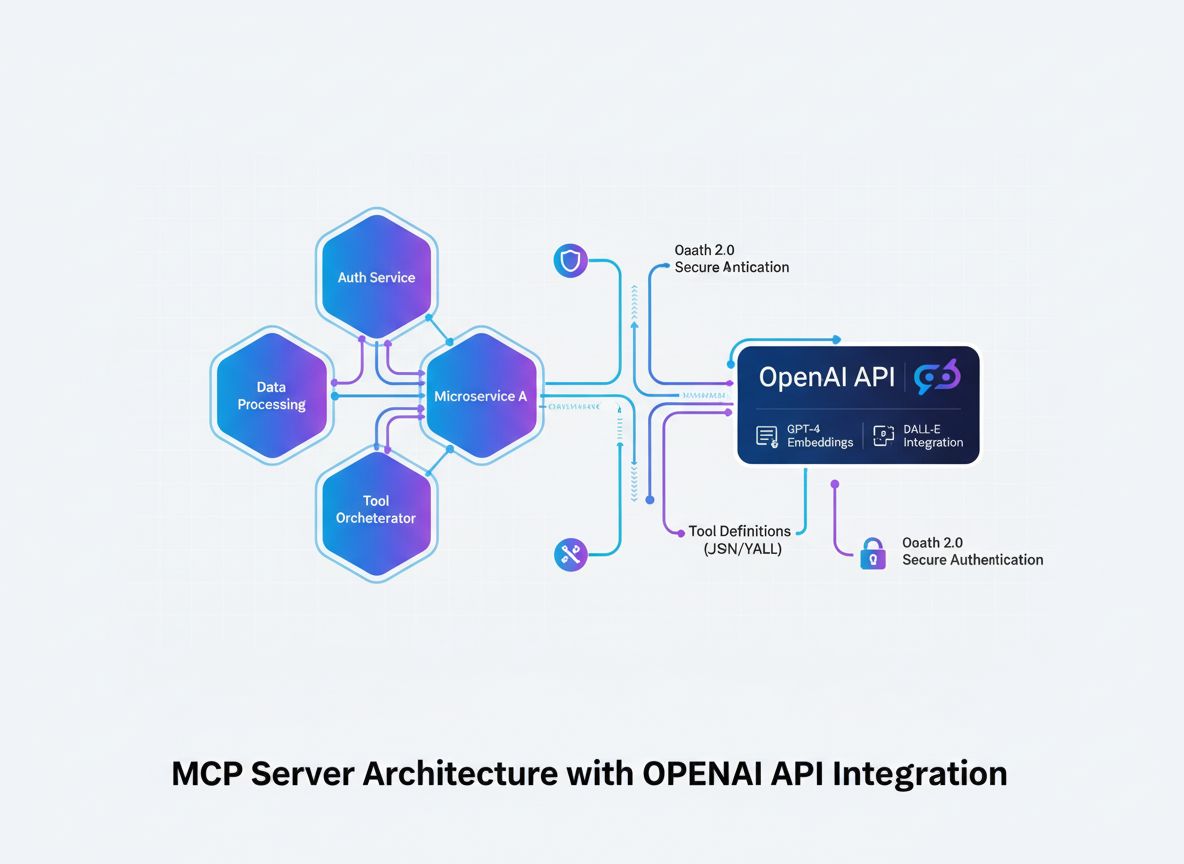

Erfahren Sie, wie Sie einen Model Context Protocol (MCP) Server entwickeln, der sich nahtlos mit der OpenAI-API integriert und leistungsstarke, KI-basierte Tool...

Erfahren Sie, wie Sie einen Model Context Protocol (MCP)-Server erstellen und bereitstellen, um KI-Modelle mit externen Tools und Datenquellen zu verbinden. Sch...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.