Was ist ein KI-Chatbot GPT? Umfassender Leitfaden zu ChatGPT und generativer KI

Erfahren Sie, was ein KI-Chatbot GPT ist, wie er funktioniert und warum ChatGPT die führende generative KI-Lösung ist. Entdecken Sie die Transformer-Architektur...

Entdecken Sie die verborgene Infrastruktur hinter KI-Systemen. Erfahren Sie, wie Rechenzentren funktionieren, welche Strombedürfnisse und Kühlsysteme sie haben, wie lange ihr Bau dauert und wie gewaltige Investitionen die globale Infrastruktur verändern.

Wenn Sie ChatGPT öffnen, einen Prompt eingeben und Enter drücken, verbinden Sie sich nicht einfach mit einer mysteriösen Cloud. Hinter dieser scheinbar simplen Interaktion verbirgt sich eine der komplexesten, teuersten und energieintensivsten Infrastrukturen, die die Menschheit je gebaut hat. Jede KI-Antwort, die Sie erhalten, wird von riesigen Rechenzentren angetrieben – milliardenschwere Anlagen, die mit Luft und Wasser gekühlt werden und genug Strom verbrauchen, um ganze Städte zu versorgen. Das sind keine abstrakten Konzepte irgendwo im Cyberspace; es handelt sich um physische Gebäude, gefüllt mit spezieller Hardware, ausgefeilten Kühlsystemen und einer Sicherheit wie eine Festung. Zu verstehen, was sich in diesen Rechenzentren befindet, ist entscheidend, um zu begreifen, wie moderne KI tatsächlich funktioniert und warum Unternehmen wie OpenAI, Google, Microsoft und Meta Billionen in deren Bau investieren. Dieser Artikel beleuchtet das verborgene Rückgrat der KI-Revolution – von der grundlegenden Architektur der Rechenzentren über die komplexen ingenieurtechnischen Herausforderungen, den enormen Strombedarf bis hin zum globalen Wettlauf um die Infrastruktur, die die nächste Generation künstlicher Intelligenz antreiben wird.

{{ < youtubevideo videoID=“WNt_1bSODIo” title=“What’s Inside an AI Data Center?” class=“rounded-lg shadow-md” > }}

Rechenzentren sind im Grunde Fabriken für Berechnungen. Obwohl der Begriff „Cloud“ in der Technologiewerbung allgegenwärtig ist, ist er irreführend – es gibt keine Cloud. Tatsächlich existieren riesige, physische Gebäude, gefüllt mit spezieller Computertechnik, Netzwerkinfrastruktur, Stromversorgung und Kühleinrichtungen. Ein Rechenzentrum kann man sich wie eine massiv vergrößerte Version eines Personal Computers vorstellen. So wie Ihr Laptop eine CPU, GPU, Speicher, Festplatte und ein Netzteil enthält, so verfügt ein Hyperscale-Rechenzentrum über dieselben Komponenten, jedoch in Milliardenfachem Maßstab. Die Anlage verwaltet und liefert Daten über miteinander verbundene Systeme aus Servern, KI-Beschleunigern, Speicherarrays und Netzwerktechnik. Diese Gebäude funktionieren wie kleine Städte, mit eigener Stromerzeugung und -verteilung, Notstromaggregaten, Sicherheitsinfrastruktur und Umweltkontrollen. Der grundsätzliche Zweck bleibt gleich, ob das Rechenzentrum CPUs für allgemeine Rechenaufgaben oder GPUs für KI-Workloads beherbergt – es verarbeitet, speichert und liefert Daten in gigantischem Umfang. Allerdings unterscheiden sich Design, Architektur und Betriebsanforderungen von KI-zentrierten Rechenzentren inzwischen dramatisch von traditionellen Rechenzentren, was völlig neue Ansätze für Energieversorgung, Kühlung und Infrastrukturplanung erfordert.

Das Aufkommen der generativen KI hat die Rechenzentrumsbranche auf eine Weise grundlegend verändert, die weit über eine bloße Skalierung bestehender Infrastruktur hinausgeht. Vor Ende 2022, als ChatGPT veröffentlicht wurde, konzentrierten sich Rechenzentren vor allem auf allgemeine Rechenaufgaben – das Hosten von Webseiten, das Verwalten von Datenbanken, das Ausführen von Unternehmensanwendungen und das Bereitstellen von Cloud-Diensten. Die Anforderungen an die Rechenleistung waren relativ vorhersehbar und beherrschbar. Doch das explosive Wachstum von Large Language Models und generativen KI-Systemen hat eine völlig neue Kategorie von Computing-Workloads geschaffen, die unter gänzlich anderen Bedingungen operiert. Diese KI-Systeme basieren auf Matrixmultiplikation – einer mathematisch simplen Operation, die jedoch Milliardenfach pro Sekunde ausgeführt werden muss. Das hat die gesamte Branche zu spezialisierter GPU-Hardware getrieben, insbesondere zu Nvidias fortschrittlichen Chips, die genau für diese Operationen effizient konzipiert sind. Der Wandel ist so drastisch, dass es zu einem echten Engpass bei GPUs gekommen ist – Unternehmen können nicht genug Hardware beschaffen, um die Nachfrage zu decken. Das hat einen regelrechten technologischen Wettlauf ausgelöst, bei dem alle großen Tech-Unternehmen Hunderte Milliarden investieren, um GPU-Kapazitäten zu sichern und KI-optimierte Rechenzentren auszubauen. Das Ausmaß dieser Entwicklung ist beispiellos – OpenAI, Oracle und SoftBanks Stargate-Projekt planen allein, Billionen Dollar in KI-Infrastruktur in den USA zu investieren. Es handelt sich hierbei nicht um ein inkrementelles Upgrade bestehender Systeme, sondern um eine grundlegende Umstrukturierung der weltweiten Computerinfrastruktur, um ein neues technologisches Paradigma zu ermöglichen.

Die größte Hürde beim Ausbau von KI-Rechenzentren ist der Strom. Während traditionelle Rechenzentren vielleicht 10–15 Kilowatt pro Rack verbrauchen, erreichen moderne KI-Rechenzentren heute Werte von 80–120 Kilowatt pro Rack, und Nvidias kommende Ruben-Generation wird voraussichtlich 600 Kilowatt pro Rack gegen Ende des Jahrzehnts erreichen. Das entspricht einer fünf- bis zehnfachen Steigerung der Leistungsdichte und stellt beispiellose Herausforderungen für Stromerzeugung, -verteilung und -management dar. Zum Vergleich: Das US-Energieministerium schätzt, dass Rechenzentren allein 2023 4,4 % des gesamten Stroms verbrauchten, mit Prognosen von 7–12 % bis 2028. Der Electric Reliability Council of Texas (ERCOT) und andere Netzbetreiber rechnen bis 2030 mit etwa 30 Gigawatt neuer Spitzenlast – hauptsächlich durch den Ausbau von Rechenzentren. Zur Einordnung: 30 Gigawatt entsprechen etwa dem Stromverbrauch von 25–30 Millionen Haushalten oder der Leistung von rund 30 großen Kernkraftwerken. Das stellt die Energieversorger und regionalen Netze vor gewaltige Herausforderungen, denn sie wurden für eine ganz andere Zeit und Nachfragestruktur gebaut. Hinzu kommt, dass der Stromverbrauch von KI-Rechenzentren weder räumlich noch zeitlich gleichmäßig verteilt ist. Diese Einrichtungen benötigen konstant hohe Leistungsdichten, konzentriert an bestimmten Umspannwerken, was die Infrastruktur lokal stark belastet. Unternehmen wie Google, Microsoft und OpenAI müssen den Standort ihrer Rechenzentren daher primär nach Stromverfügbarkeit wählen, nicht mehr nur nach Immobilienpreisen oder Nutzer-Nähe. Daraus resultiert eine geographische Konzentration in Regionen mit viel Stromerzeugung, etwa dem oberen Mittleren Westen, den Nordics oder Gebieten mit viel Wasser- oder Kernkraft. Die Stromfrage ist inzwischen der wichtigste limitierende Faktor beim Ausbau der KI-Infrastruktur – wichtiger als Grundstücke, Personal oder sogar GPU-Verfügbarkeit.

Ein modernes KI-Rechenzentrum besteht aus mehreren miteinander verbundenen Systemen, die jeweils eine zentrale Funktion erfüllen. Im Kern stehen die Racks – Metallrahmen, in denen die GPUs und spezialisierten KI-Beschleuniger für die eigentliche Berechnung sitzen. Diese Racks sind über Hochgeschwindigkeits-Netzwerk-Switches verbunden und können so mit enormer Bandbreite kommunizieren. Das Rechenzentrum enthält zudem Speicherarrays, die Petabytes an Daten halten – Trainingsdaten, Modellgewichte und Nutzerdaten, die die KI benötigt. Über die Rechentechnik hinaus braucht die Anlage eine ausgeklügelte Strominfrastruktur mit Transformatoren, Verteilerfeldern, unterbrechungsfreien Stromversorgungen (USV) und Notstromgeneratoren. Die Stromsysteme müssen nicht nur die Durchschnittslast, sondern auch die Spitzenlasten verkraften, die bei Volllast auftreten. Ebenso wichtig ist die Kühlinfrastruktur, die zu den kritischsten und komplexesten Aspekten moderner Rechenzentren zählt. Die Kühlsysteme müssen die durch die Rechentechnik erzeugte Wärme abführen und die optimale Betriebstemperatur der Hardware sicherstellen. Das erfolgt über eine Kombination von Luftbehandlungsgeräten, Flüssigkeitskreisläufen, Kaltwassersystemen und teilweise direkter Flüssigkühlung, bei der Kühlmittel direkt über die Chips fließt. Die Anlage benötigt zudem umfangreiche Sicherheitsinfrastruktur: physische Barrieren, Zugangskontrollsysteme, Überwachungskameras und IT-Sicherheitsmaßnahmen zum Schutz vor physischen und digitalen Angriffen. Schließlich braucht das Rechenzentrum redundante Systeme für zentrale Funktionen – Ersatzstrom, Ersatzkühlung, Ersatznetzwerk –, damit auch bei Ausfall einzelner Komponenten der Betrieb weiterläuft.

FlowHunt spezialisiert sich zwar auf die Automatisierung von KI-Inhaltsworkflows und nicht auf das Management physischer Infrastruktur, doch die Prinzipien von Effizienz und Optimierung, die das Design von Rechenzentren bestimmen, lassen sich direkt auf die Optimierung von KI-Workflows in Unternehmen übertragen. So wie Rechenzentren Stromverbrauch, Kühleffizienz und Rechenleistung maximieren, sollten Unternehmen ihre KI-Workflows so gestalten, dass sie den größtmöglichen Nutzen aus KI-Systemen ziehen und Ressourcenverschwendung minimieren. FlowHunt automatisiert Recherche, Content-Erstellung und Publishing-Prozesse, die ansonsten viel manuelle Koordination erfordern würden. Durch diese Automatisierung können Unternehmen den rechnerischen Overhead ihrer Content-Prozesse reduzieren – ganz ähnlich, wie Rechenzentren ihre Infrastruktur optimieren. Die Plattform hilft Teams dabei, die Effizienz ihrer KI-Workflows zu verstehen und zu verfolgen und zeigt auf, wie Ressourcen genutzt werden – ähnlich wie Rechenzentrumsbetreiber Stromverbrauch und Kühleffizienz überwachen. Für Unternehmen, die KI-gestützte Produkte oder Dienstleistungen entwickeln, ist das Verständnis der Infrastruktur-Anforderungen und -Beschränkungen von Rechenzentren entscheidend, um fundierte Entscheidungen zu Deployment, Skalierung und Kostenmanagement zu treffen. Mit FlowHunt können Teams effizienter unter diesen Rahmenbedingungen arbeiten, mehr Inhalte generieren, mehr recherchieren und häufiger veröffentlichen, ohne die eigenen Rechen- und Betriebskosten proportional zu erhöhen.

Einer der am meisten unterschätzten Aspekte des Betriebs von KI-Rechenzentren ist die Kühlung. Die enorme Dichte an Berechnungen in modernen KI-Rechenzentren erzeugt große Mengen an Wärme, die von den Chips abgeführt werden muss, um thermische Schäden zu verhindern und optimale Performance zu gewährleisten. Ohne effektive Kühlung würden die Siliziumchips buchstäblich schmelzen und das gesamte Rechenzentrum ausfallen. Diese Kühl-Herausforderung hat zu einem Paradigmenwechsel im Design von Rechenzentren geführt: weg von klassischer Luftkühlung hin zu fortschrittlichen Flüssigkühlsystemen. Luftkühlung – bei der Ventilatoren kalte Luft über die Geräte blasen – ist der traditionelle Ansatz in den meisten Rechenzentren. Allerdings hat Luft eine vergleichsweise schlechte Wärmeleitfähigkeit und ist daher weniger effizient bei der Abfuhr von Wärme aus dicht gepackter Technik. Mit steigender Leistungsdichte stößt Luftkühlung zunehmend an ihre Grenzen. Flüssigkühlsysteme, bei denen Wasser oder spezielle Kühlmittel direkt über oder nahe den Chips zirkulieren, sind deutlich effizienter bei der Wärmeabfuhr. Es gibt verschiedene Ansätze: geschlossene Kreisläufe, in denen das Kühlmittel ohne Kontakt zur Umgebung durch die Geräte und einen Kühler strömt, und offene Systeme, bei denen das Kühlmittel mit der Umgebungsluft in Kontakt kommen kann. Geschlossene Systeme sind wassersparender, verbrauchen jedoch meist mehr Strom für den Kühlprozess. Offene Systeme sind stromsparender, verbrauchen aber mehr Wasser. Die Wahl hängt von lokalen Wasserressourcen, Strompreisen, Klima und Umweltauflagen ab. Die Water Usage Effectiveness (WUE) ist eine zentrale Kennzahl für die Effizienz des Rechenzentrums und misst den Wasserverbrauch pro Kilowattstunde IT-Leistung. Branchendurchschnittlich liegt die WUE bei etwa 1,9 Litern pro Kilowattstunde, aber mit vollständig geschlossenen Systemen kann der Wasserverbrauch nahezu auf null sinken. Googles Rechenzentrum in Council Bluffs, Iowa, verbrauchte beispielsweise 2023 etwa eine Milliarde Gallonen Wasser – ein Hinweis auf den enormen Wasserbedarf großer KI-Anlagen. Manche innovative Einrichtungen testen alternative Ansätze, etwa die Nutzung von Abwärme für Fernwärmenetze (wie Meta in Dänemark, wo jährlich 100–165 Gigawattstunden Wärme ins lokale Netz eingespeist werden), Free Cooling aus Umgebungsluft in kalten Klimazonen oder sogar Wasserstoff-basierte Kühlsysteme. Die Kühltechnik macht einen bedeutenden Teil der Investitionen aus und ist oft die größte ingenieurtechnische Herausforderung im Designprozess.

Der Bau eines Hyperscale-KI-Rechenzentrums ist ein riesiges Unterfangen, das eine sorgfältige Planung, erhebliche Investitionen und die Koordination vieler Beteiligter erfordert. Der typische Zeitrahmen von der ersten Idee bis zur Inbetriebnahme beträgt 18 bis 30 Monate und gliedert sich in mehrere Phasen. Die erste Phase ist Planung und Machbarkeitsstudie (3–6 Monate): Standortsuche, Prüfung lokaler Strom- und Wasserversorgung, Regulatorik und Einbindung der Gemeinde. Geeignetes Land zu finden, ist nicht trivial – das Gelände braucht ausreichend Strom, schnellen Glasfaser-Internetanschluss, genügend Wasser für die Kühlung und die Unterstützung der lokalen Regierung. Die zweite Phase ist Entwurf und Technik (6–12 Monate): Detaillierte Pläne für Rack-Anordnung, Stromverteilung, Kühlung, Sicherheit und alle anderen Systeme entstehen. Umfangreiche Simulationen optimieren die Effizienz und das Zusammenspiel der Systeme. Die dritte Phase ist Genehmigungen (6–18 Monate, parallel zu Phase 2): Einholen von Baugenehmigungen, Umweltauflagen, Netzanschluss und weitere regulatorische Freigaben. Besonders in streng regulierten Regionen kann dies lange dauern. Die vierte Phase ist der eigentliche Bau (1–2 Jahre): Das Gebäude wird errichtet, Technik installiert, Strom- und Kühlsysteme verlegt und Sicherheitsinfrastruktur aufgebaut. Die letzte Phase ist Test und Inbetriebnahme (3–6 Monate): Alle Systeme werden geprüft, Software konfiguriert und die Anlage schrittweise hochgefahren. Die berühmte Ausnahme ist XAI’s Colossus-Projekt, das in nur 122 Tagen fertiggestellt wurde – eine beispiellose Leistung dank extremer Koordination und Vorplanung. Die meisten Projekte folgen jedoch dem 18–30-Monate-Plan. Die Investitionen sind gewaltig: Microsofts Fairwater Supercomputer Campus erstreckt sich über Hunderte Hektar, benötigt kilometerlange Fundamente und beherbergt Tausende GPUs mit High-End-Flüssigkühlung. Solche Projekte kosten leicht zehn Milliarden Dollar und mehr. Diese Summen spiegeln die strategische Bedeutung der KI-Infrastruktur und den Wettbewerbsdruck, möglichst schnell GPU-Kapazität und KI-Fähigkeiten aufzubauen.

Nach dem Bau werden KI-Rechenzentren mit Festungs-ähnlicher Sicherheit und komplexen Betriebsabläufen geführt. Die Anlagen beherbergen Technik im Wert von Milliarden und laufen für Unternehmen, deren Betrieb davon abhängt. Physische Sicherheit ist oberstes Gebot: Umzäunungen, Durchfahrtssperren, Zugangskontrollen, biometrische Scanner und Sicherheitskräfte sorgen dafür, dass Unbefugte keinen Zutritt haben. Besucher sind selten und müssen vorab genehmigt werden; Serverräume sind nur mit autorisierter Begleitung zugänglich. Überwachungskameras erfassen das gesamte Gelände. Die Sicherheitsinfrastruktur soll Diebstahl und Sabotage verhindern. Ebenso wichtig ist die IT-Sicherheit: In den Systemen stecken wertvolles geistiges Eigentum, Nutzerdaten und trainierte Modelle, die Milliarden wert sind. Die eingesetzten Cybersecurity-Maßnahmen gehören zu den fortschrittlichsten: Netzwerksegmentierung, Intrusion Detection, Verschlüsselung und fortlaufende Überwachung sind Standard. Jedes Rack ist meist in einem Käfig verschlossen, der Zugang zu kritischen Systemen ist auf autorisiertes Personal beschränkt. Die Betriebsführung ist enorm komplex: Stromverbrauch, Kühleffizienz, Anlagenzustand, Netzwerkperformance und Sicherheit müssen permanent überwacht werden. Die Auslastung muss so gesteuert werden, dass keine Bereiche überlastet werden. Wartungen werden so koordiniert, dass Ausfallzeiten minimiert werden. Bei Störungen muss schnell repariert werden. Große Anlagen beschäftigen Dutzende bis Hunderte Fachkräfte, wobei vollautomatisierte Anlagen auch von kleinen Teams gemanagt werden können. Die Betriebsabläufe sind hochstandardisiert und dokumentiert, mit klaren Protokollen für Regelfälle und Notfallplänen für besondere Ereignisse.

Der Standort von KI-Rechenzentren ist für große Technologieunternehmen eine strategische Entscheidung – vor allem vom Stromangebot, aber auch von Wasser, Klima, Glasfaseranbindung, Regulatorik und Gemeindefaktoren beeinflusst. Nord-Virginia ist heute der größte Rechenzentrumsmarkt der Welt, mit nahezu keiner Leerstandsquote und Gigawatt an neuer Kapazität im Bau. Der Bezirk Loudoun (Virginia) ist so abhängig von den Einnahmen durch Rechenzentren, dass diese rund 38 % des Haushalts ausmachen – was sogar zu niedrigeren Grundsteuern für die Einwohner führt. Dies zeigt, welchen wirtschaftlichen Nutzen Rechenzentren für Gemeinden bringen können. Auch andere Regionen werden zunehmend attraktiv: Phoenix, Chicago, Oregon und Ohio sehen große Investitionen dank günstiger Kombination aus Land, Strom und Wasser. Der obere Mittlere Westen, besonders in der Nähe von Wasserkraftwerken oder Kernkraftwerken, ist durch das reichliche Angebot an sauberem Strom besonders attraktiv. Die nordischen Länder, vor allem Island und Norwegen, haben sich wegen reichlicher Wasserkraft und kühlem Klima zu Daten-Hubs entwickelt, was die Kühlungskosten senkt. Die wirtschaftlichen Auswirkungen sind komplex: Während der Bauphase entstehen viele Arbeitsplätze, doch der Betrieb einer großen Anlage erfordert nur wenige Dutzend Mitarbeiter – weit weniger als in der Bauphase. Das müssen lokale Regierungen bei der Bewertung solcher Projekte bedenken. Die Steuereinnahmen sind beträchtlich, wie Loudoun County zeigt, die Beschäftigungseffekte aber begrenzt. Hinzu kommen Umweltfragen zu Wasser-, Stromverbrauch und Wärmeabgabe. Die besten Projekte sind transparent bezüglich ihrer Umweltauswirkungen, arbeiten mit Versorgern zusammen, setzen auf Wassereinsparung und integrieren sich in die Gemeinde statt isoliert zu sein.

Die Strominfrastruktur für KI-Rechenzentren ist genauso komplex wie die Computertechnik. Rechenzentren brauchen nicht nur ausreichend Strom, sondern auch eine zuverlässige und unterbrechungsfreie Versorgung, die auch Spitzenlasten aushält. Die meisten großen Rechenzentren sind ans regionale Netz angeschlossen, unterhalten aber auch Notstromaggregate, um bei Netzausfällen den Betrieb aufrechtzuerhalten. Fast alle großen US-Rechenzentren setzen massive Dieselgeneratoren als Notstrom ein, die genug Strom liefern, um die Anlage auch längere Zeit ohne Netzversorgung zu betreiben. Diese Generatoren laufen selten, verursachen aber bei Einsatz Emissionen. Der ökologische Fußabdruck hat dazu geführt, dass Betreiber alternative Backup-Lösungen testen: Grid-basierte Batteriesysteme, die Strom speichern und bei Ausfällen abgeben; gasbetriebene Turbinen, die sauberer sind als Diesel; und sogar Wasserstoff-Brennstoffzellen. In Zukunft wird auch die Onsite-Kernkraft diskutiert, ist aber noch weitgehend theoretisch. Die Beziehung zu Energieversorgern ist entscheidend: Rechenzentren sind riesige, konstante Lasten für das Netz, weshalb Versorger ihre Infrastruktur darauf ausrichten müssen. Unternehmen wie Google, Microsoft und OpenAI arbeiten eng mit Versorgern zusammen und schließen oft langfristige Lieferverträge ab. Manche investieren selbst in Erneuerbare – Solar-, Wind- oder Wasserkraftwerke – um unabhängiger zu werden. Die Entscheidungen der Betreiber haben Auswirkungen auf das regionale Stromsystem und können sogar Energiepolitik und Investitionen auf Landes- oder Bundesebene beeinflussen.

Der Trend im Ausbau von KI-Rechenzentren ist eindeutig: Die Entwicklung beschleunigt sich, getrieben durch das rasante Wachstum von KI-Anwendungen und den Wettbewerb der Tech-Konzerne um Rechenkapazität. Der Strombedarf wird weiter steigen und die Erzeugungs- und Verteilungsinfrastruktur vor Herausforderungen stellen. Die Kühlanforderungen treiben Innovationen im Thermomanagement. Die Sicherheitsanforderungen nehmen zu, da der Wert der Systeme und Daten in den Anlagen weiter steigt. Einige Trends werden die Zukunft prägen: Erstens, eine geografische Diversifizierung – neue Regionen mit ausreichend Strom, Wasser und Konnektivität werden erschlossen. Zweitens, Innovationen in Kühlsystemen – Flüssigkühlung wird Standard, neue Ansätze wie Immersionskühlung werden erprobt. Drittens, mehr Nachhaltigkeit: Betreiber reduzieren Wasserverbrauch, CO₂-Emissionen und integrieren erneuerbare Energien. Viertens, Spezialisierung und Konsolidierung: Manche Anlagen werden für Training, andere für Inferenz optimiert. Fünftens, mehr Automatisierung: KI steuert künftig selbst Stromverbrauch, Kühleffizienz und Hardware-Auslastung. Das Investitionsvolumen ist beispiellos und unterstreicht die strategische Bedeutung von KI für die Weltwirtschaft. Diese Anlagen sind das physische Rückgrat der KI-Revolution, die unsichtbare Basis für all die Anwendungen und Dienste, die Branchen und Gesellschaft verändern.

{{ < cta-dark-panel heading=“Steigern Sie Ihre Produktivität mit FlowHunt” description=“Erleben Sie, wie FlowHunt Ihre KI-Content- und SEO-Workflows automatisiert – von Recherche und Inhaltserstellung über Veröffentlichung bis zu Analysen – alles an einem Ort.” ctaPrimaryText=“Demo buchen” ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo" ctaSecondaryText=“FlowHunt kostenlos testen” ctaSecondaryURL=“https://app.flowhunt.io/sign-in" gradientStartColor="#123456” gradientEndColor="#654321” gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217”

}}

Das finanzielle Ausmaß der Investitionen in KI-Rechenzentren ist überwältigend und spiegelt den enormen Wert wider, den Unternehmen sich von KI versprechen. OpenAI, Oracle und das Stargate-Projekt von SoftBank planen, Billionen Dollar in den Ausbau der KI-Infrastruktur in den USA zu investieren. Nvidia hat zugesagt, 100 Milliarden Dollar beizusteuern. Google, Microsoft, Meta und andere große Tech-Konzerne investieren jeweils Hunderte Milliarden in den Ausbau ihrer eigenen Rechenzentren. Diese Investitionen erfolgen trotz erheblicher Unsicherheiten bezüglich der Rendite – ein Zeichen für die strategische Bedeutung von KI und den Konkurrenzdruck, sich Rechenkapazität zu sichern. Die Wirtschaftlichkeit von Rechenzentren ist komplex: Die Kapitalkosten sind enorm – ein großes Zentrum kostet leicht mehrere zehn Milliarden Dollar. Die laufenden Betriebskosten sind ebenfalls beträchtlich, vor allem durch den Stromverbrauch. Ein großes KI-Rechenzentrum kann dauerhaft 100–300 Megawatt verbrauchen, was bei typischen Strompreisen von 50–100 Dollar pro Megawattstunde jährliche Stromkosten von 50–300 Millionen Dollar bedeutet. Hinzu kommen Kühlung, Wartung, Sicherheit und Personal – die Betriebskosten können so über 500 Millionen Dollar pro Jahr betragen. Diese Kosten müssen durch die Einnahmen des Zentrums gedeckt werden – sei es durch den Verkauf von Rechenkapazität an Kunden oder durch den internen Einsatz zur Monetarisierung von KI-Diensten. Die Preise für GPU-Leistungen sind wettbewerbsintensiv und spiegeln die Kosten plus Gewinnmarge wider. Mit wachsender Kapazität steigt der Preisdruck, was die Margen senken und die Refinanzierung erschweren könnte. Die Nachfrage wächst jedoch derzeit schneller als das Angebot, weshalb die Preise wohl vorerst hoch bleiben. Die Rendite für Betreiber hängt davon ab, wie gut das Zentrum ausgelastet ist, wie effizient die Kosten kontrolliert werden und wie stark die eigene Preismacht im Markt ist. Unternehmen, die ihre Rechenzentren selbst für eigene KI-Dienste nutzen, haben dabei andere Kalkulationen als Anbieter, die Rechenleistung als Service verkaufen.

Die Umweltauswirkungen des Ausbaus von KI-Rechenzentren sind erheblich und vielfältig. Am offensichtlichsten ist der Stromverbrauch. Da Rechenzentren einen immer größeren Anteil an der Gesamtstromerzeugung beanspruchen, tragen sie (sofern nicht aus Erneuerbaren oder Kernkraft gespeist) zu CO₂-Emissionen bei und belasten die Stromnetze. Auch der Wasserverbrauch ist beträchtlich, insbesondere bei wassergekühlten Anlagen. Die erzeugte Wärme wird zwar in manchen Fällen weiterverwendet (wie bei Metas Anlage in Dänemark), aber meist einfach an die Umwelt abgegeben. Die Umweltfolgen haben den Fokus auf Nachhaltigkeit erhöht: Viele Betreiber verpflichten sich zu Klimaneutralität oder Netto-Null-Emissionen, kaufen erneuerbaren Strom oder investieren in eigene Projekte. Es werden Wassersparmaßnahmen ergriffen, etwa geschlossene Kühlsysteme oder Trockenkühlung, wo möglich. Einige Betreiber erkunden die Nutzung von Abwärme für Fernwärme oder andere Zwecke. Auch die Politik reagiert: Manche Regionen regulieren Wasserverbrauch, Emissionen oder verlangen Umweltprüfungen für neue Projekte; andere fördern Rechenzentren in Gebieten mit viel erneuerbarem Strom. Der Spagat zwischen wachsendem KI-Bedarf und Umweltschutz wird eine der größten Herausforderungen der nächsten Jahre. Wege zu finden, den steigenden Bedarf an KI-Leistung mit minimaler Umweltbelastung zu decken, ist eine Schlüsselaufgabe für die Branche.

KI-Rechenzentren gehören zu den bedeutendsten Infrastrukturprojekten der Menschheitsgeschichte – vergleichbar mit dem Bau von Stromnetzen, Telekommunikationsnetzen oder Verkehrssystemen. Diese riesigen Anlagen, finanziert durch Milliardeninvestitionen und modernste Technik, bilden das unsichtbare Rückgrat der KI-Revolution. In dem Moment, in dem Sie einen Prompt in ChatGPT eingeben und eine Antwort erhalten, findet in diesen Zentren ein hochkomplexes Zusammenspiel aus Berechnung, Stromverteilung, Kühlung und Datenfluss statt. Die Herausforderungen für die Branche sind gewaltig: ausreichend Strom zu sichern, mit extremer Wärme umzugehen, Anlagen in Rekordzeit zu bauen – und all das möglichst umweltschonend. Dennoch fließen weiter Investitionen, getrieben von der strategischen Bedeutung von KI und dem Wettbewerb um Rechenkapazität. Zu verstehen, was in diesen Rechenzentren steckt – die GPU-Racks, die ausgefeilten Kühlsysteme, die Strominfrastruktur, die Sicherheitsmaßnahmen – ist entscheidend, um zu begreifen, wie moderne KI wirklich funktioniert und warum die Anforderungen an die Infrastruktur so hoch sind. Mit dem weiteren Vormarsch von KI in der Weltwirtschaft werden diese Rechenzentren immer wichtiger – und die Herausforderungen beim Bau, Betrieb und Unterhalt immer komplexer.

KI-Rechenzentren sind speziell für Matrixmultiplikations-Operationen optimiert, wie sie von maschinellen Lernmodellen benötigt werden. Sie verfügen über eine höhere Leistungsdichte (bis zu 600 kW pro Rack), fortschrittliche Flüssigkühlsysteme und spezialisierte GPU-Infrastruktur – im Vergleich zu traditionellen Rechenzentren, die allgemeine Rechenaufgaben mit geringeren Leistungsanforderungen (10-15 kW pro Rack) abwickeln.

Im Jahr 2023 verbrauchten Rechenzentren 4,4 % des gesamten US-Stroms, mit Prognosen von 7–12 % bis 2028. Eine einzelne ChatGPT-Anfrage benötigt etwa 2,9 Wattstunden, während generative KI-Systeme 10- bis 30-mal mehr Strom als aufgabenspezifische KI verbrauchen. In den USA werden bis 2030 rund 30 Gigawatt neue Spitzenlast durch Rechenzentren erwartet.

Moderne KI-Rechenzentren setzen sowohl Luft- als auch Flüssigkühlsysteme ein. Direkte Flüssigkühlung ist effizienter und spart Strom, verbraucht aber Wasser. Geschlossene Flüssigkeitskreisläufe minimieren den Wasserverbrauch bei gleichbleibender Effizienz. Die Water Usage Effectiveness (WUE) liegt typischerweise bei 1,9 Litern pro Kilowattstunde; vollständig geschlossene Systeme nähern sich einem Wasserverbrauch von null an.

Der Bau eines Standard-Hyperscale-Rechenzentrums dauert von der Planung bis zur Inbetriebnahme 18–30 Monate, einschließlich Planung (3–6 Monate), Entwurf und Technik (6–12 Monate), Genehmigungen (6–18 Monate), Bau (1–2 Jahre) und Tests (3–6 Monate). Das schnellste Projekt war XAI's Colossus, das in nur 122 Tagen fertiggestellt wurde.

Arshia ist eine AI Workflow Engineerin bei FlowHunt. Mit einem Hintergrund in Informatik und einer Leidenschaft für KI spezialisiert sie sich darauf, effiziente Arbeitsabläufe zu entwickeln, die KI-Tools in alltägliche Aufgaben integrieren und so Produktivität und Kreativität steigern.

Erfahren Sie, wie FlowHunt die KI-Inhaltsgenerierung, Recherche und Veröffentlichung optimiert – basierend auf denselben Infrastrukturprinzipien, die moderne Rechenzentren antreiben.

Erfahren Sie, was ein KI-Chatbot GPT ist, wie er funktioniert und warum ChatGPT die führende generative KI-Lösung ist. Entdecken Sie die Transformer-Architektur...

Dieser umfassende Artikel erklärt, was 'GPT' in ChatGPT bedeutet, wie die Technologie funktioniert, ihre Entwicklung und beantwortet häufige Fragen zu 'chat gpb...

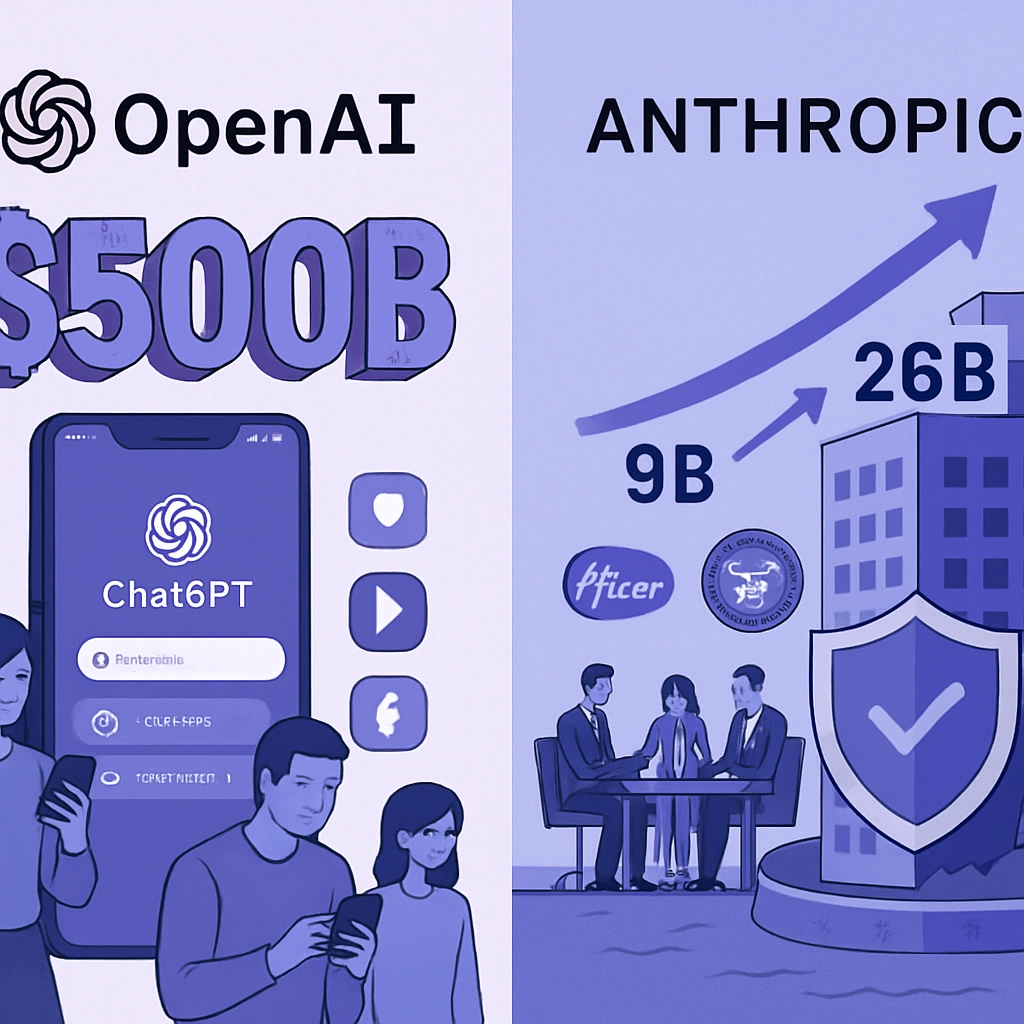

OpenAIs 500-Milliarden-Bewertung gerät unter Druck, da standardisierte KI-Modelle und Open-Source-Alternativen das Spielfeld ebnen. Entdecken Sie, warum Anthrop...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.