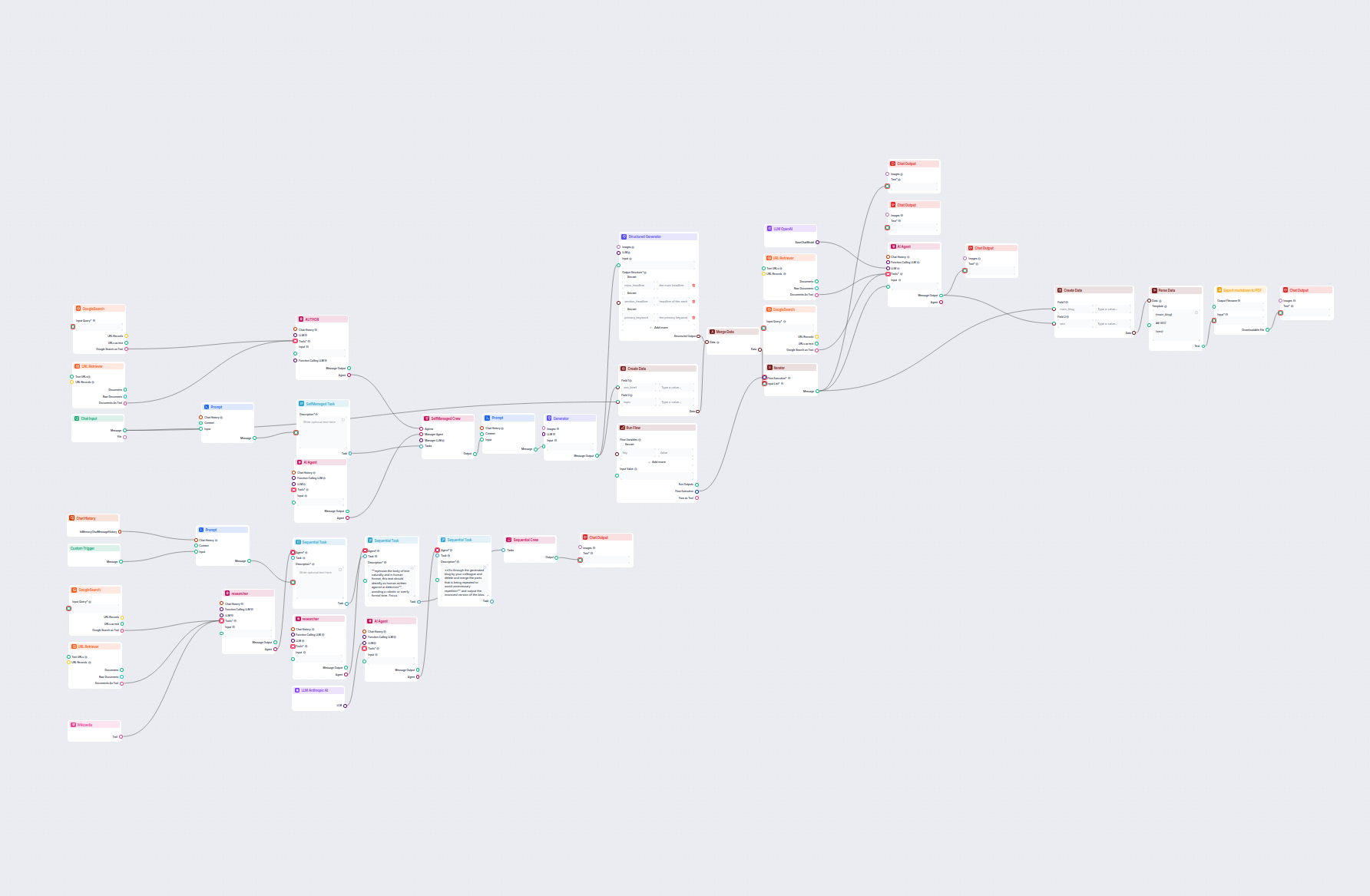

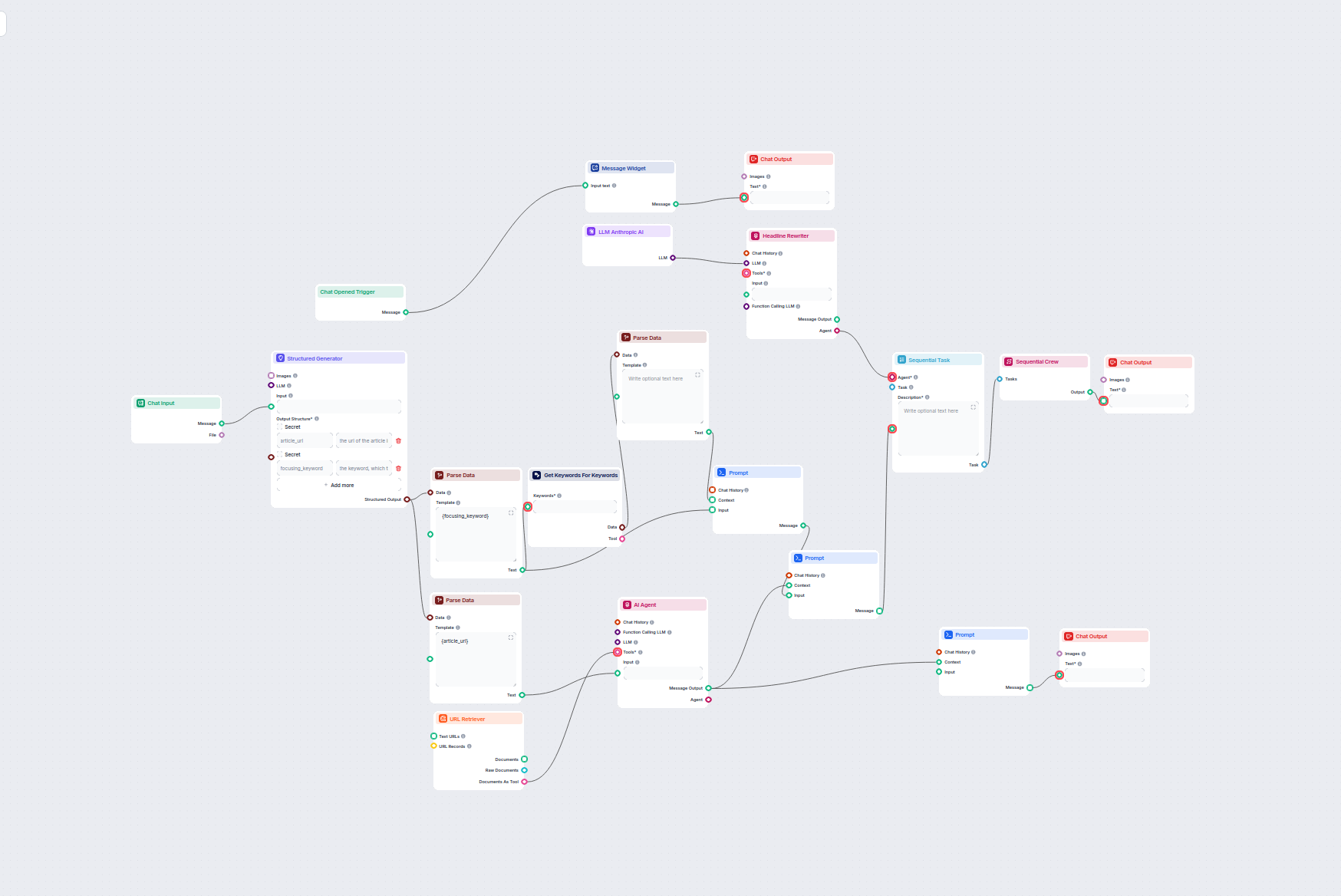

AI Blog-Überschrift- & Keyword-Optimierer

Dieser KI-gestützte Workflow findet die besten SEO-Keywords für Ihren Blogartikel und überarbeitet automatisch die Überschriften, um diese Keywords gezielt anzu...

Verbinden Sie die Claude-Modelle von Anthropic mit Ihrem FlowHunt-Dashboard für flexible KI-Textgenerierung und Chatbot-Lösungen – mit Kontrolle über Tokens, Temperatur und Modellauswahl.

Komponentenbeschreibung

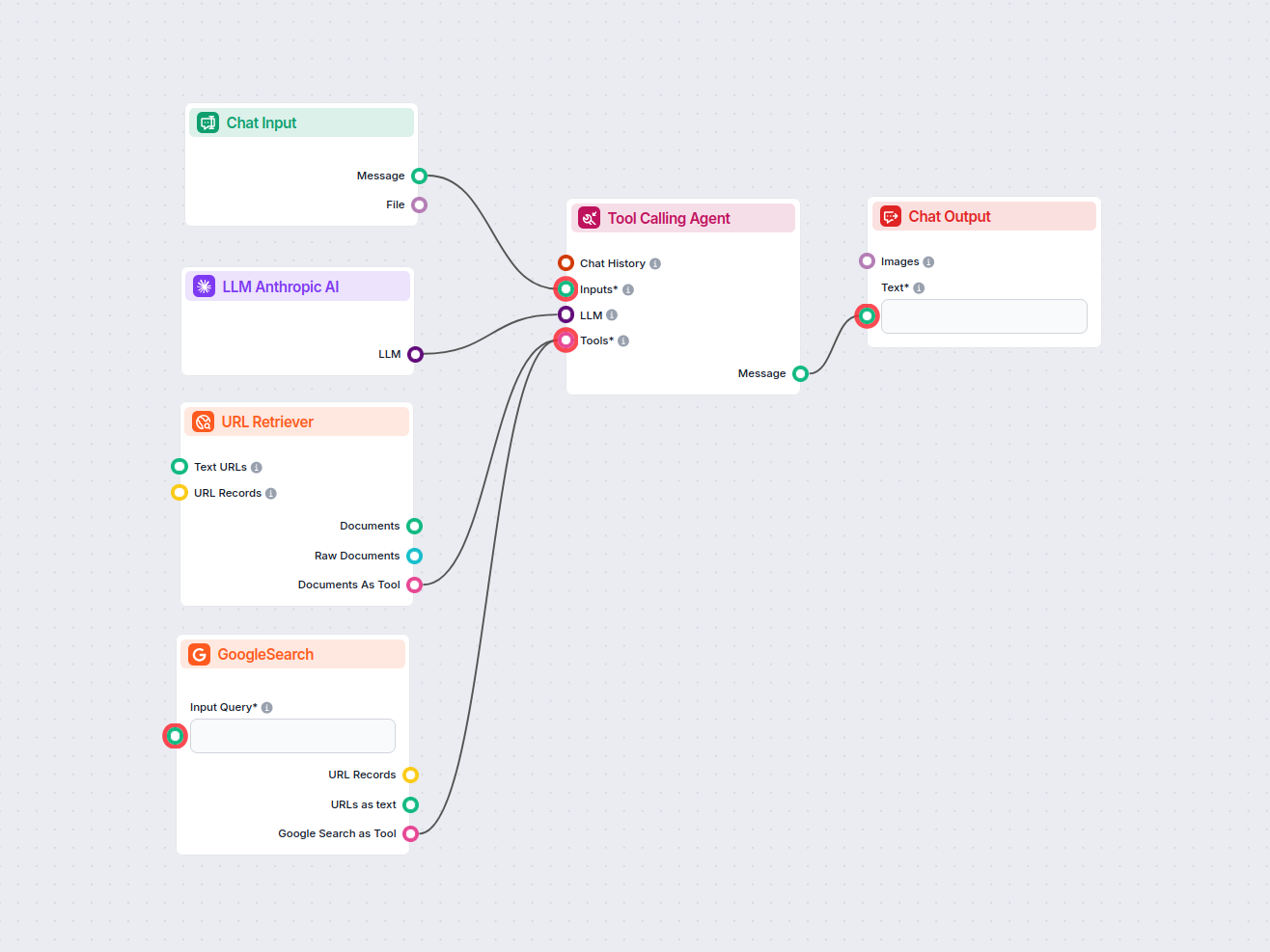

Different tasks call for different models, and FlowHunt is committed to giving you the best of AI without the need to sign up for countless subscriptions. Instead, you get dozens of text and image generator models in a single dashboard. The LLM type of components houses text generation and their diverse applications in AI, content creation, and automation.") models grouped by provider, allowing you to swap AI models on the fly.

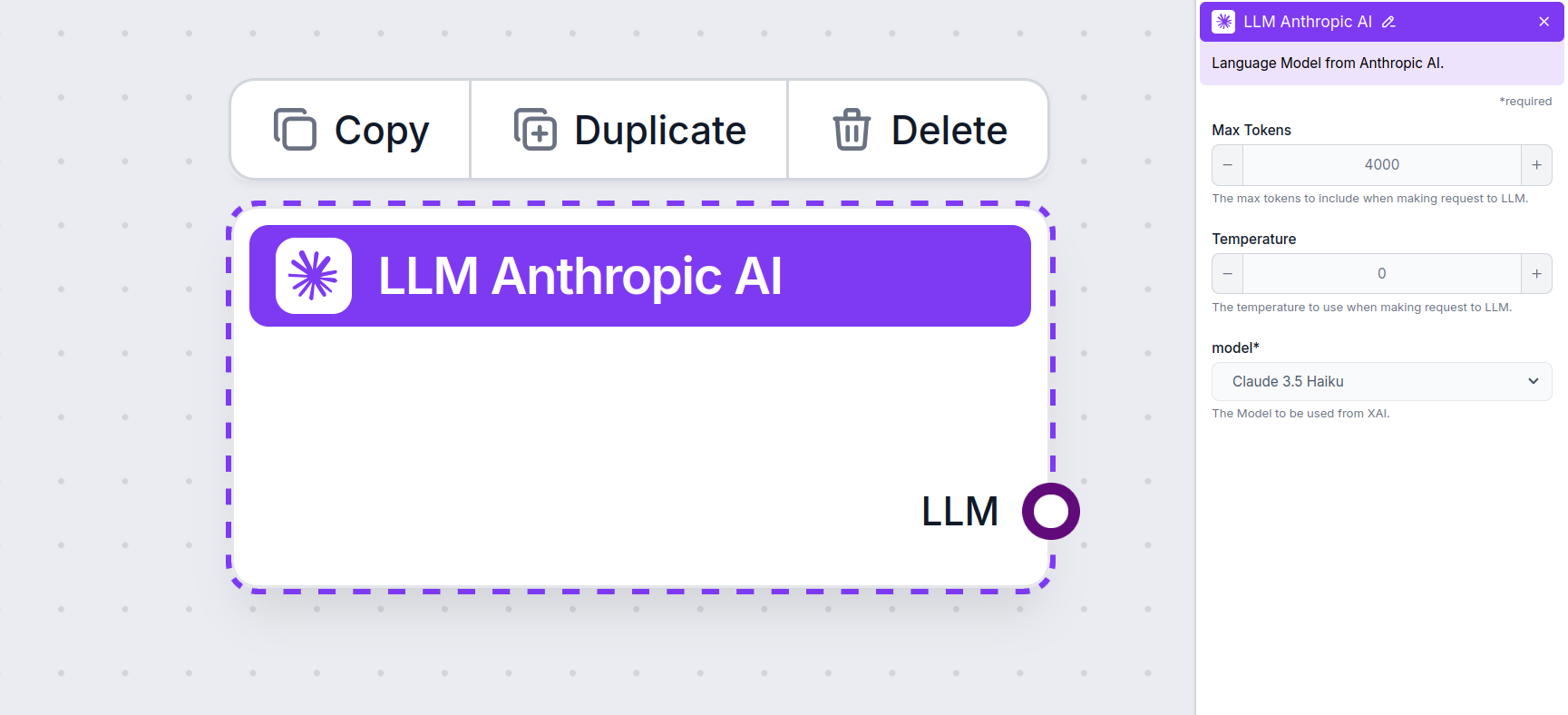

The LLM Anthropic AI component connects the Claude family of models to your flow. While the Generators and Agents are where the actual magic happens, LLM components allow you to control the model used. All components come with ChatGPT-4 by default. You can connect this component if you wish to change the model or gain more control over it.

Remember that connecting an LLM Component is optional. All components that use an LLM come with ChatGPT-4o as the default. The LLM components allow you to change the model and control model settings.

Tokens represent the individual units of text the model processes and generates. Token usage varies with models, and a single token can be anything from words or subwords to a single character. Models are usually priced in millions of tokens.

The max tokens setting limits the total number of tokens that can be processed in a single interaction or request, ensuring the responses are generated within reasonable bounds. The default limit is 4,000 tokens, which is the optimal size for summarizing documents and several sources to generate an answer.

Temperature controls the variability of answers, ranging from 0 to 1.

For example, the recommended temperature for a customer service bot is between 0.2 and 0.5. This level should keep the answers relevant and to the script while allowing for a natural response variation.

This is the model picker. Here, you’ll find all the supported models from Anthropic. We currently support all the latest models from the Claude family:

You’ll notice that all LLM components only have an output handle. Input doesn’t pass through the component, as it only represents the model, while the actual generation happens in AI Agents and Generators.

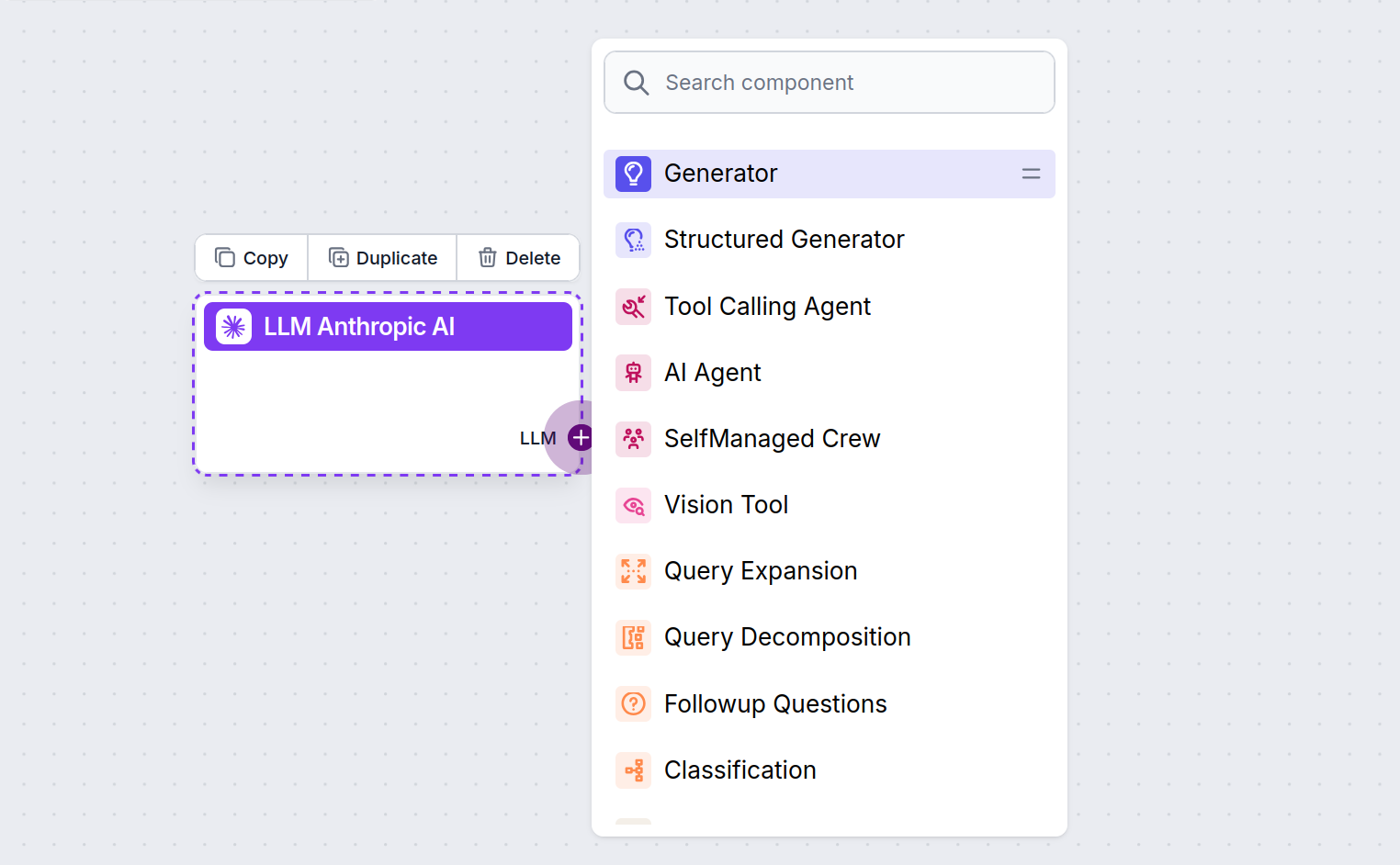

The LLM handle is always purple. The LLM input handle is found on any component that uses AI to generate text or process data. You can see the options by clicking the handle:

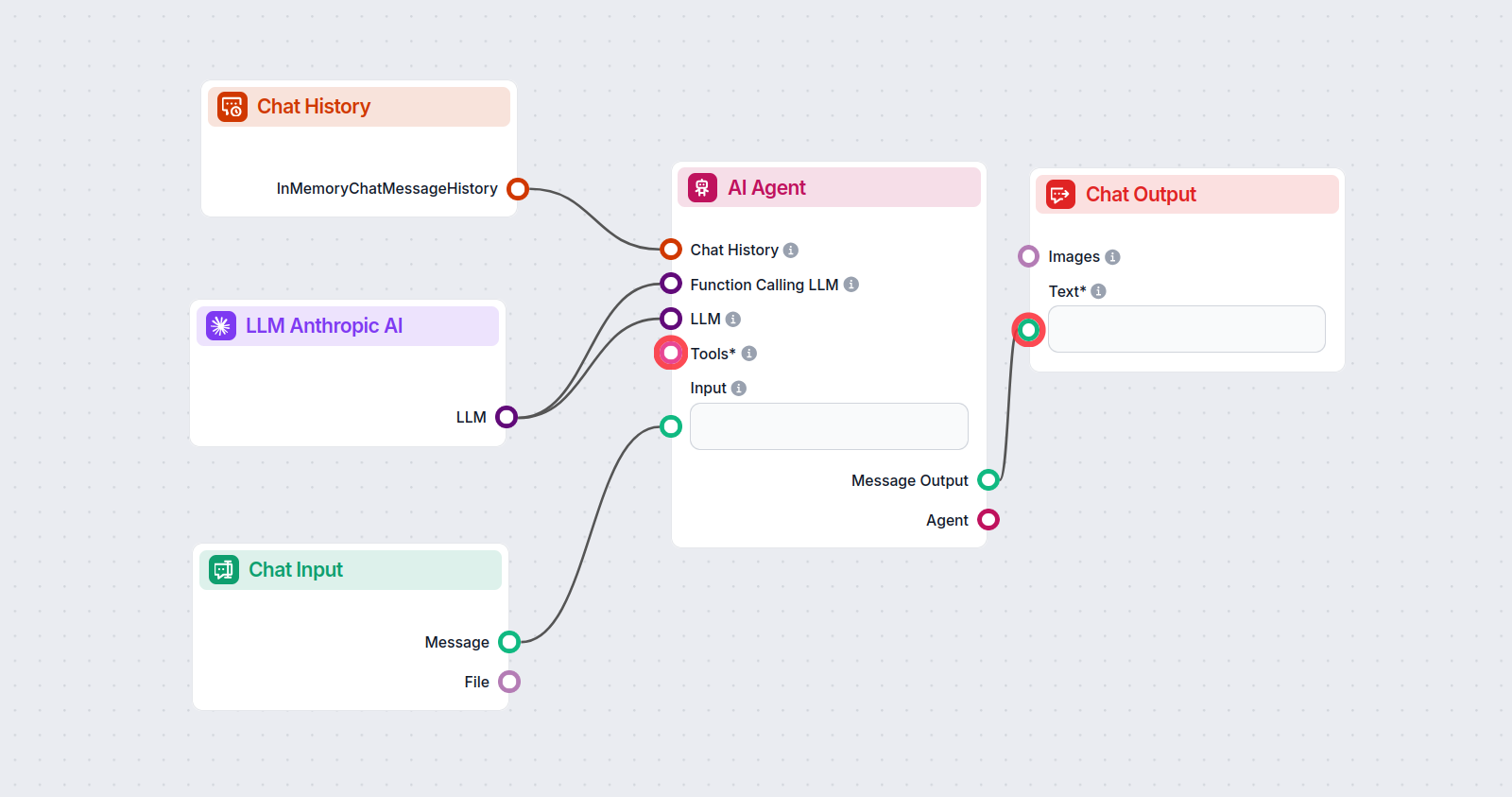

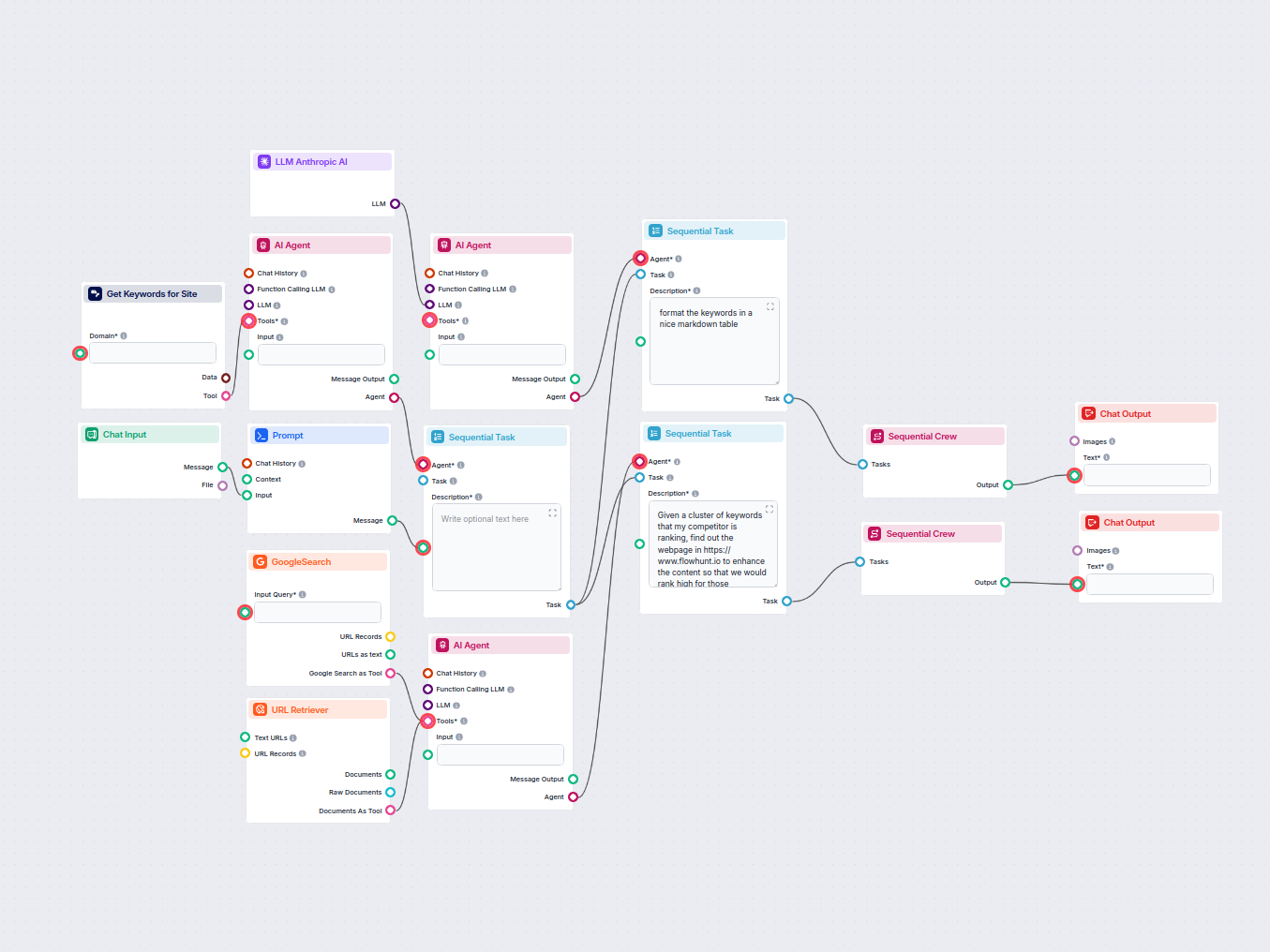

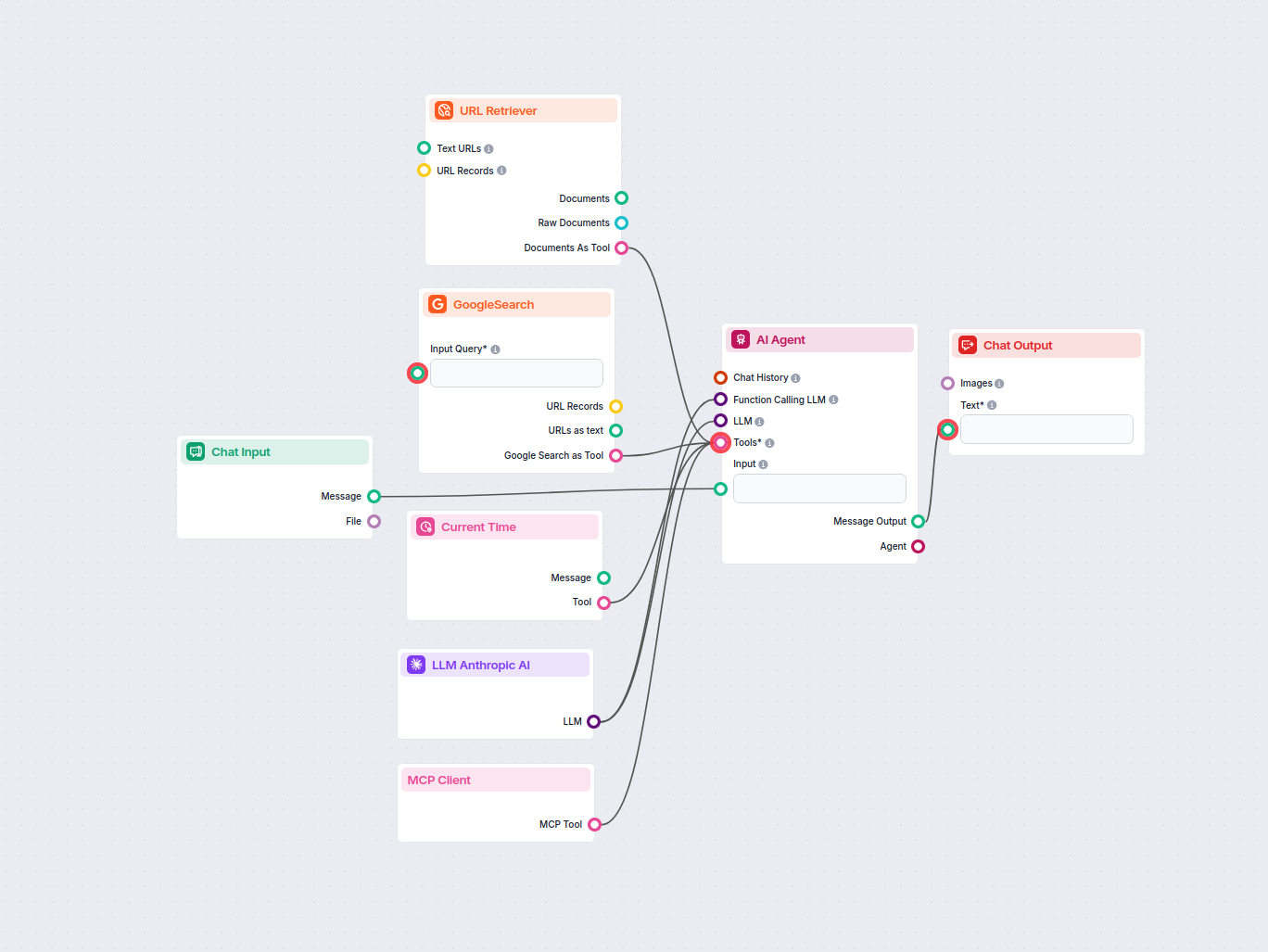

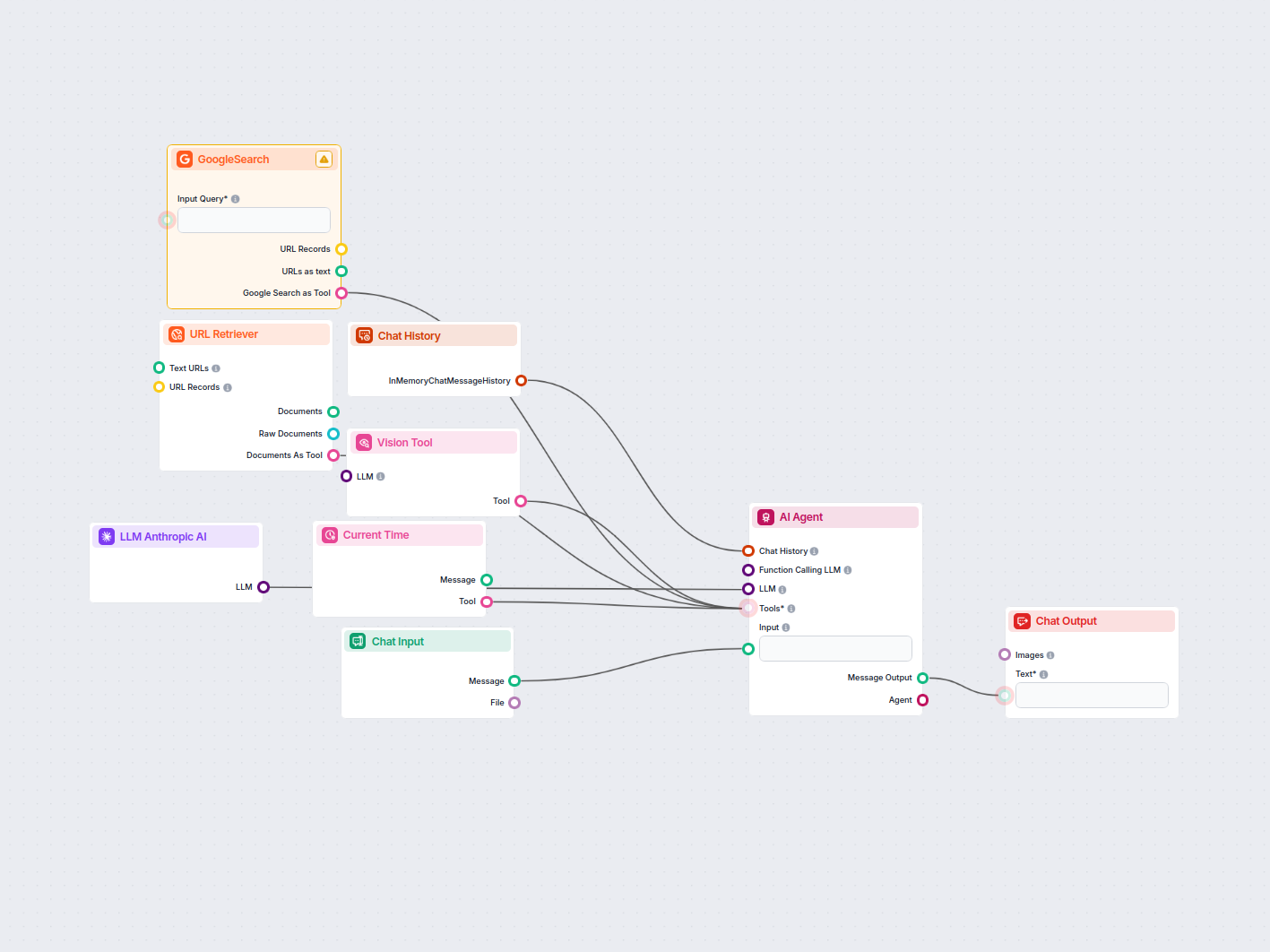

This allows you to create all sorts of tools. Let’s see the component in action. Here’s a simple AI Agent chatbot Flow that’s using Anthropic’s Claude 3.5 Sonnet to generate responses. You can think of it as a basic Anthropic chatbot.

This simple Chatbot Flow includes:

Um Ihnen den schnellen Einstieg zu erleichtern, haben wir mehrere Beispiel-Flow-Vorlagen vorbereitet, die zeigen, wie die LLM Anthropic KI-Komponente effektiv genutzt wird. Diese Vorlagen präsentieren verschiedene Anwendungsfälle und Best Practices und erleichtern Ihnen das Verständnis und die Implementierung der Komponente in Ihren eigenen Projekten.

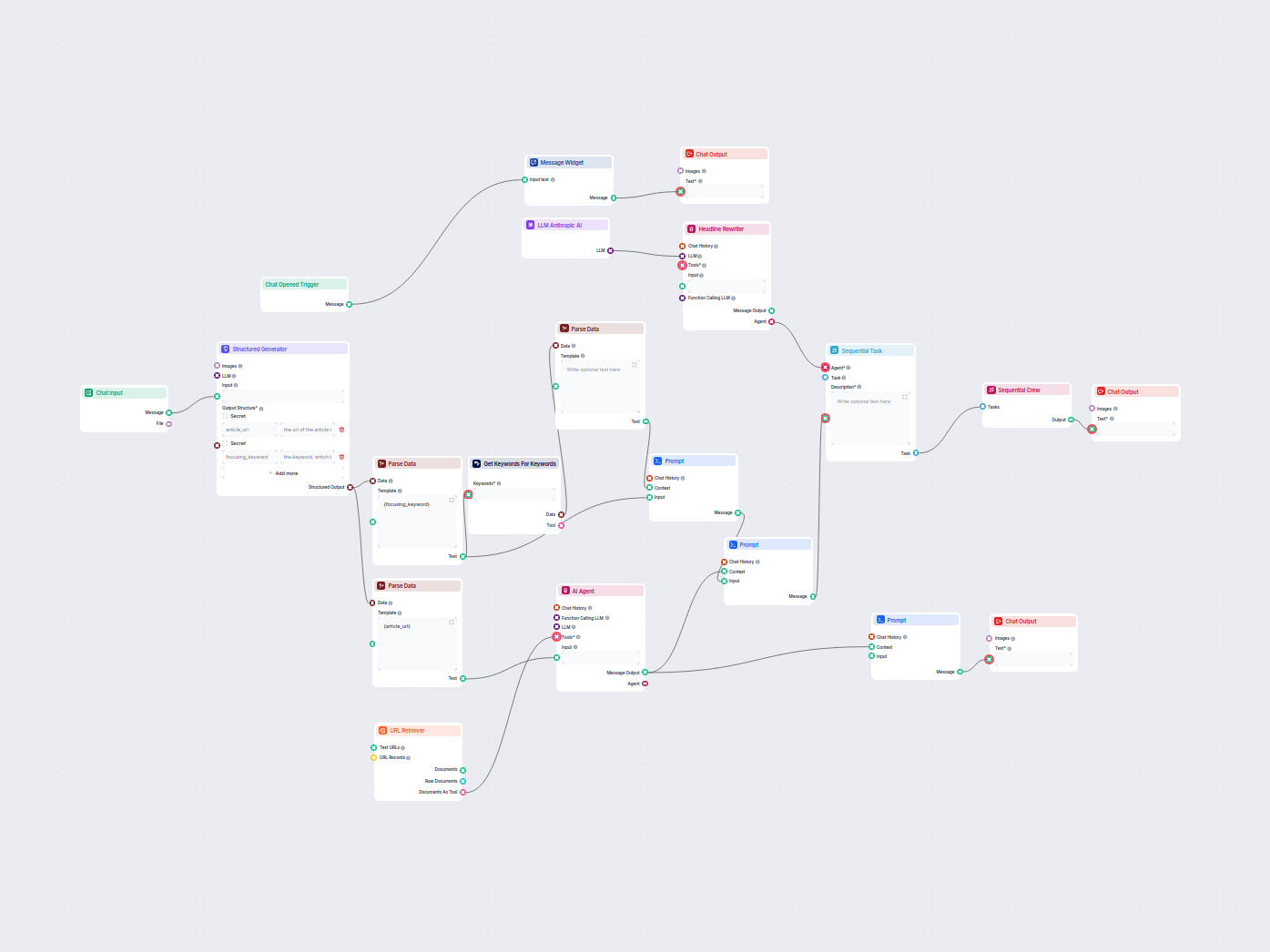

Dieser KI-gestützte Workflow findet die besten SEO-Keywords für Ihren Blogartikel und überarbeitet automatisch die Überschriften, um diese Keywords gezielt anzu...

Automatisches Erstellen von SEO-optimierten Beschreibungen für E-Commerce-Kategorieseiten mit KI. Geben Sie einfach eine Kategorie-URL an, und der Workflow rech...

Erstellen Sie umfassende, SEO-optimierte Blogposts mit fortschrittlicher Struktur und hoher Wortanzahl mithilfe mehrerer KI-Agenten. Der Workflow umfasst automa...

Analysiere automatisch die Homepage-URL deines Wettbewerbers, um dessen Top-Ranking-Keywords zu entdecken, Keyword-Daten von Google zu sammeln und umsetzbare Em...

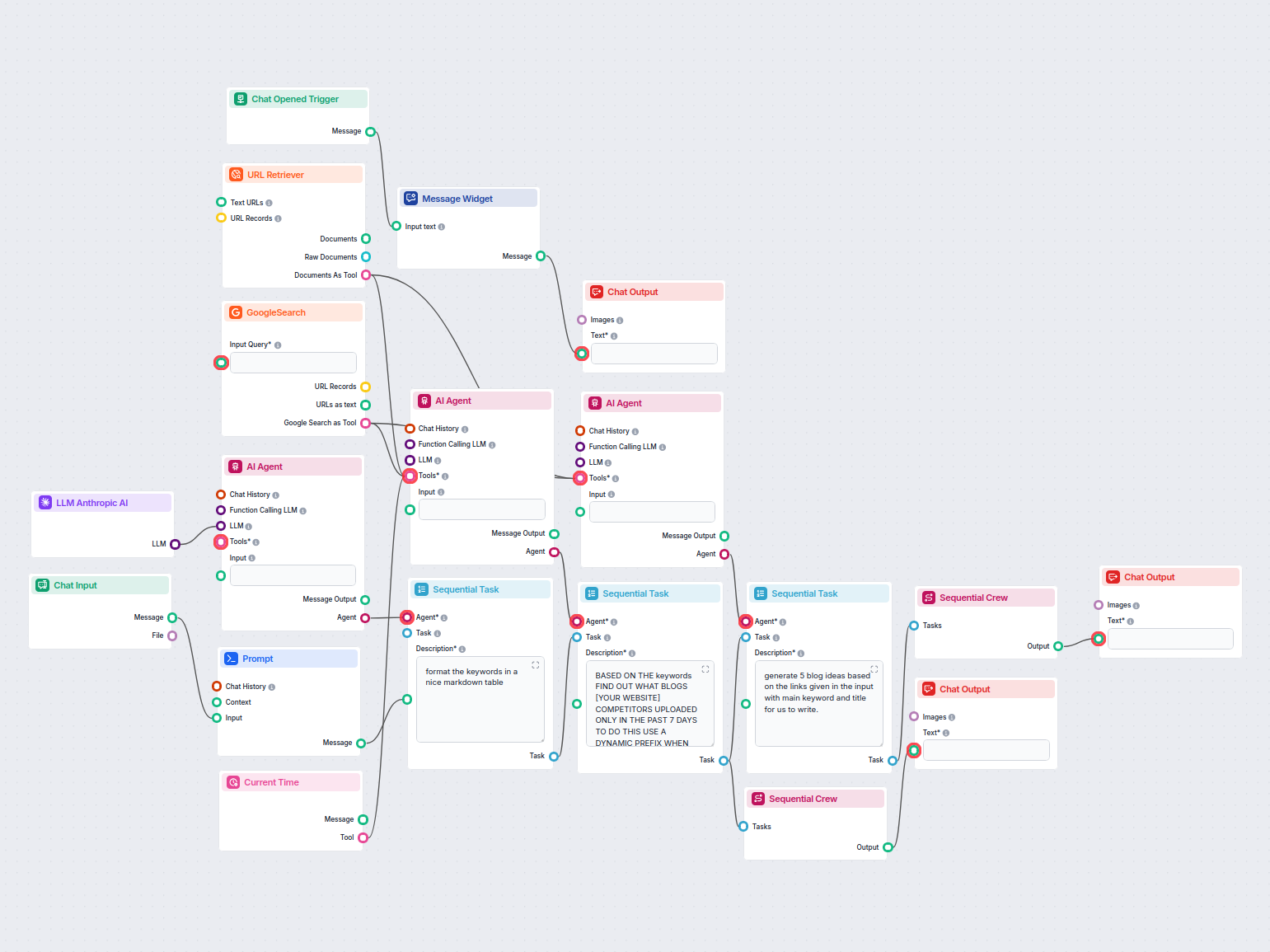

Dieser KI-gestützte Workflow recherchiert Wettbewerber und Trendthemen, um wirkungsstarke, SEO-optimierte Blog-Ideen für FlowHunt.io zu generieren. Mithilfe von...

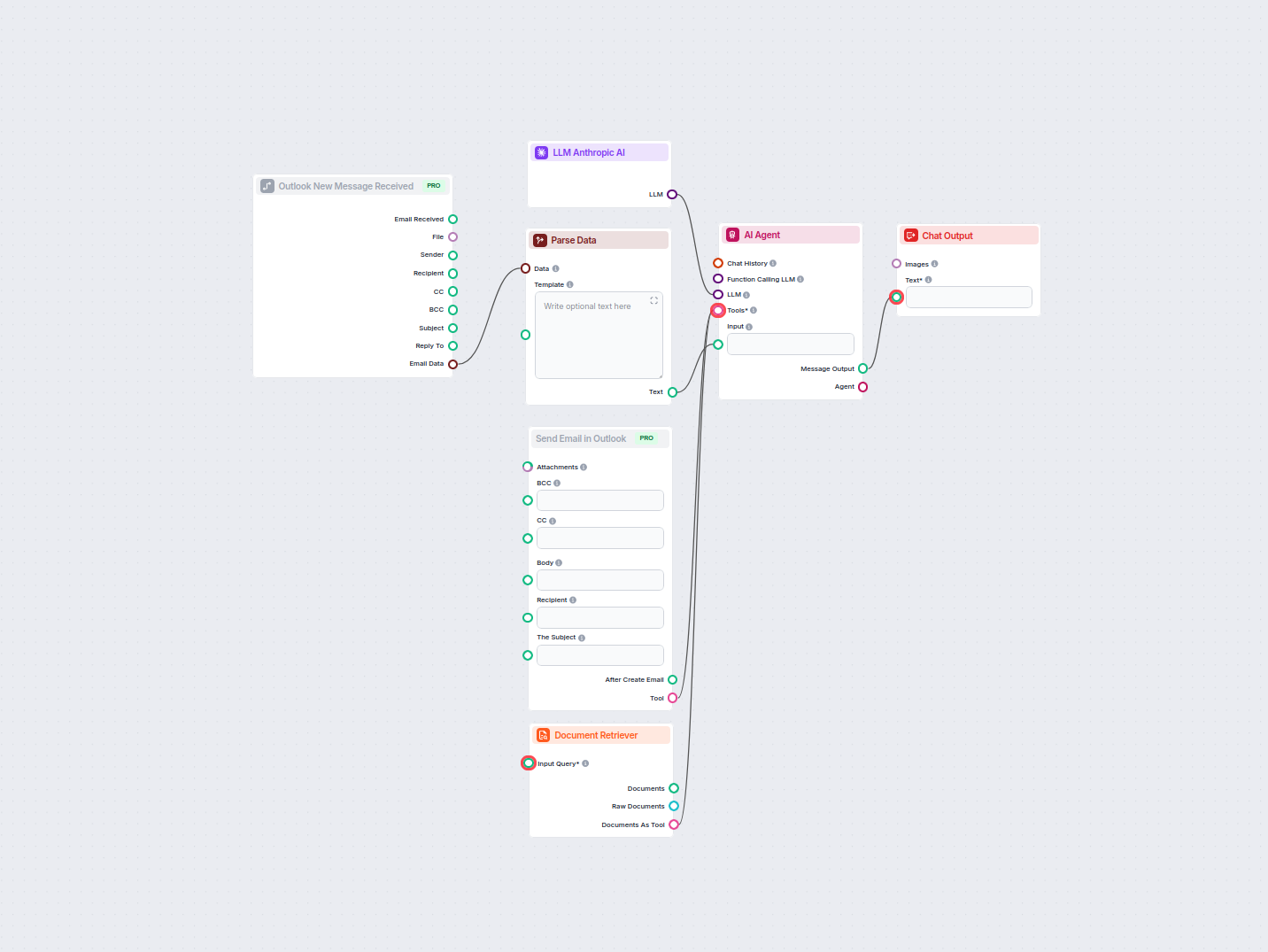

Automatisieren Sie professionelle E-Mail-Antworten in Outlook mit einem KI-Agenten, der auf unternehmensinternen Wissensquellen basiert. Eingehende E-Mails werd...

Analysieren Sie automatisch die bestplatzierten Konkurrenten-Blogs der vergangenen Woche und generieren Sie neue Blog-Ideen für Ihre Website. Dieser KI-Workflow...

Dieser Workflow automatisiert die LinkedIn-Anzeigen-Marktforschung, indem er Top-Wettbewerber für ein Keyword identifiziert, deren Anzeigentexte und -visuals an...

Optimieren Sie automatisch die Überschriften und den Titel Ihres Artikels für ein bestimmtes Keyword oder eine Keyword-Cluster, um die SEO-Leistung zu verbesser...

Dieser KI-gestützte Workflow optimiert Shopify-Produktbeschreibungen basierend auf dem vom Nutzer angegebenen Produktnamen oder der Produkt-URL. Er nutzt große ...

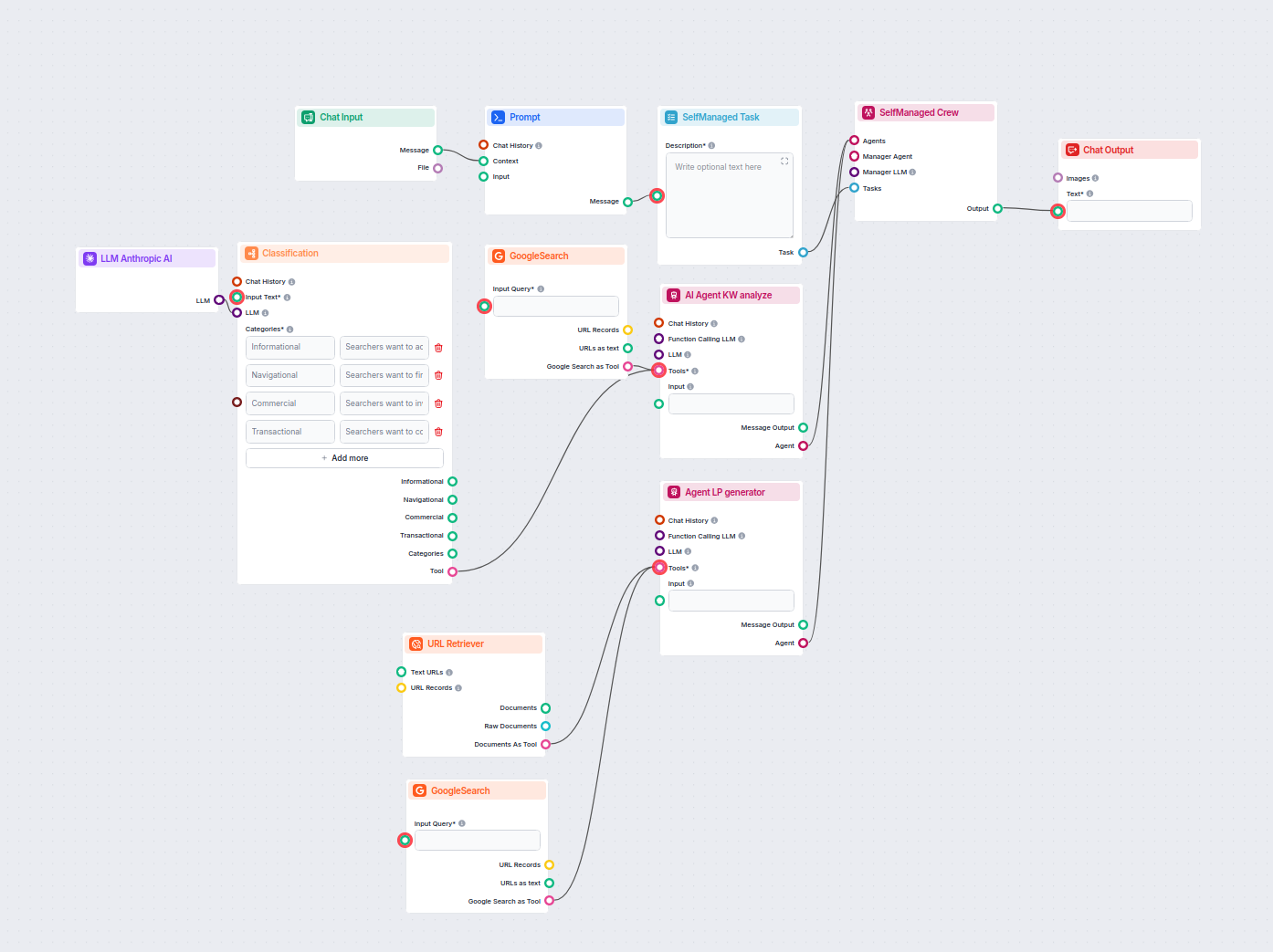

Dieser KI-gestützte Workflow klassifiziert Suchanfragen nach Intention, recherchiert Top-Ranking-URLs und generiert eine hochoptimierte Landingpage für PPC- und...

Die LLM Anthropic KI-Komponente verbindet die Claude-Modelle von Anthropic mit Ihren FlowHunt-Flows und ermöglicht es Ihnen, festzulegen, welches Modell für die Textgenerierung verwendet wird, und Einstellungen wie Max Tokens und Temperatur zu steuern.

FlowHunt unterstützt alle aktuellen Modelle der Claude-Familie, darunter Claude 3.5 Sonnet, Claude 3 Sonnet, Claude 3 Haiku und Claude 2.

Max Tokens legt das Längenlimit für jede Antwort fest, während die Temperatur die Zufälligkeit steuert – niedrigere Werte führen zu fokussierten Ausgaben, höhere Werte zu mehr Kreativität.

Nein, das Verbinden der LLM Anthropic KI-Komponente ist optional. Standardmäßig verwenden Komponenten ChatGPT-4o, aber Sie können diese Komponente hinzufügen, um auf Claude-Modelle umzuschalten und die Einstellungen zu verfeinern.

Beginnen Sie mit dem Erstellen benutzerdefinierter KI-Tools und Chatbots mit den Claude-Modellen von Anthropic – dank einfacher Flow-Integration und leistungsstarker Konfiguration.

FlowHunt unterstützt Dutzende von Textgenerierungsmodellen, darunter Modelle von OpenAI. So verwenden Sie ChatGPT in Ihren AI-Tools und Chatbots.

FlowHunt unterstützt Dutzende von Textgenerierungsmodellen, darunter Metas Llama-Modelle. Erfahren Sie, wie Sie Llama in Ihre KI-Tools und Chatbots integrieren,...

FlowHunt unterstützt Dutzende von Textgenerierungsmodellen, einschließlich der Modelle von xAI. Hier erfahren Sie, wie Sie die xAI-Modelle in Ihren KI-Tools und...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.