Wie Sie einen KI-Chatbot bauen: Komplette Schritt-für-Schritt-Anleitung

Erfahren Sie, wie Sie einen KI-Chatbot von Grund auf entwickeln – mit unserem umfassenden Leitfaden. Entdecken Sie die besten Tools, Frameworks und den Schritt-...

Erfahren Sie, wie KI-Chatbots natürliche Sprache verarbeiten, Benutzerabsichten erkennen und intelligente Antworten generieren. Lernen Sie NLP, maschinelles Lernen und Chatbot-Architektur mit technischem Tiefgang.

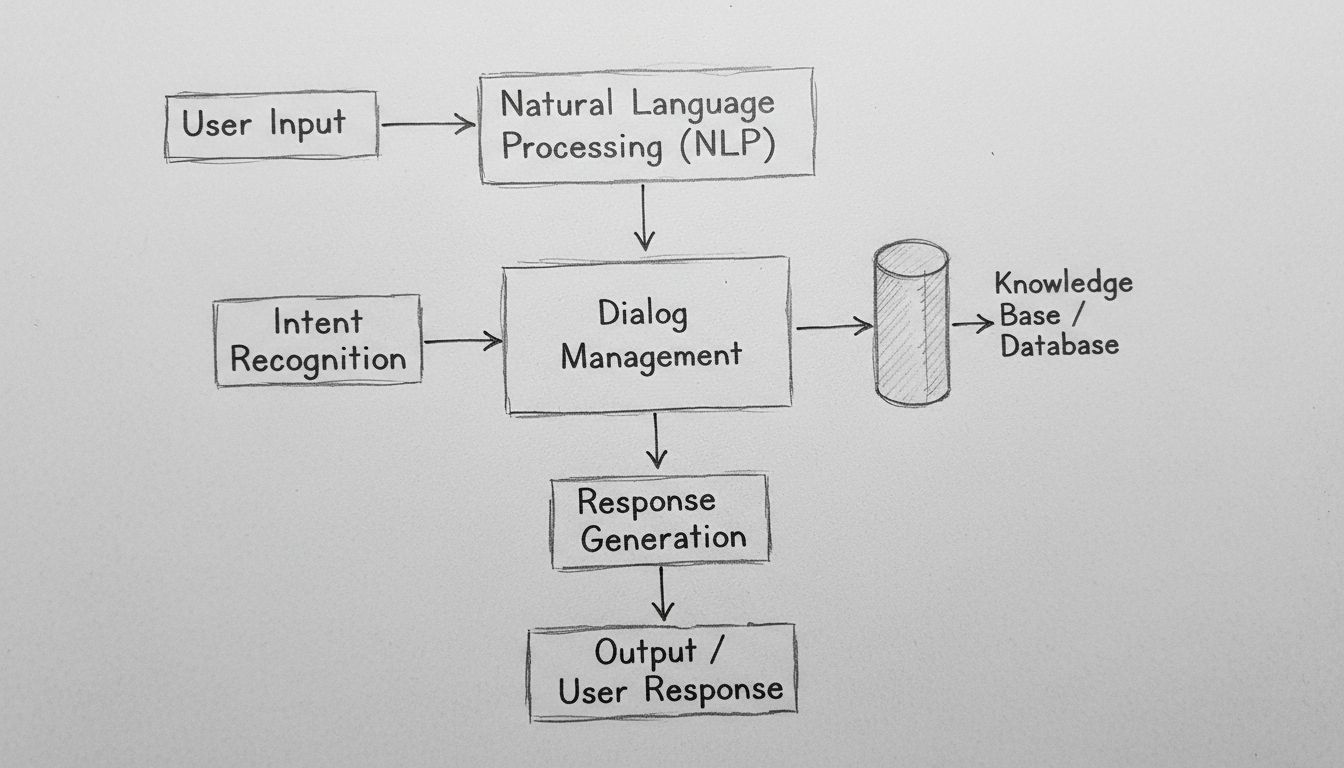

KI-Chatbots arbeiten, indem sie natürliche Spracheingaben mit NLP-Algorithmen verarbeiten, die Benutzerabsicht erkennen, auf Wissensdatenbanken zugreifen und mithilfe von maschinellen Lernmodellen kontextuell relevante Antworten generieren. Moderne Chatbots kombinieren Tokenisierung, Entitätsextraktion, Dialogmanagement und neuronale Netze, um menschenähnliche Konversationen in großem Maßstab zu simulieren.

KI-Chatbots stellen eine hochentwickelte Verbindung aus natürlicher Sprachverarbeitung, maschinellem Lernen und Dialogmanagementsystemen dar, die zusammenarbeiten, um menschliche Konversation zu simulieren. Wenn Sie mit einem modernen KI-Chatbot interagieren, kommunizieren Sie mit einem mehrschichtigen technologischen System, das Ihre Eingabe durch mehrere verschiedene Stufen verarbeitet, bevor es eine Antwort liefert. Die zugrunde liegende Architektur dieser Systeme hat sich von einfachen regelbasierten Entscheidungsbäumen zu komplexen neuronalen Netzwerken entwickelt, die Kontext, Nuancen und sogar Stimmungen verstehen können. Um zu verstehen, wie diese Systeme funktionieren, muss man jede Komponente der Pipeline betrachten und erkennen, wie sie miteinander interagieren, um nahtlose Konversationserlebnisse zu schaffen.

Die Reise jeder Benutzernachricht durch einen KI-Chatbot beginnt mit der Eingabeverarbeitung – einer entscheidenden Phase, in der Rohtext in strukturierte Daten umgewandelt wird, die das System analysieren kann. Wenn Sie eine Nachricht wie “Ich muss mein Passwort zurücksetzen” eingeben, versteht der Chatbot Ihre Absicht nicht sofort – stattdessen muss er Ihre Nachricht zunächst in handhabbare Komponenten zerlegen. Dieser Prozess, genannt Tokenisierung, teilt Ihren Satz in einzelne Wörter oder bedeutungstragende Einheiten, sogenannte Tokens, auf. Das System wandelt “Ich muss mein Passwort zurücksetzen” in Tokens um: [“Ich”, “muss”, “mein”, “Passwort”, “zurücksetzen”]. Dieser scheinbar einfache Schritt ist grundlegend, da er dem Chatbot ermöglicht, jedes Sprachelement unabhängig zu analysieren und gleichzeitig deren Beziehungen innerhalb der Satzstruktur im Auge zu behalten.

Nach der Tokenisierung wendet das System eine Normalisierung an, bei der der Text standardisiert wird, indem er in Kleinbuchstaben umgewandelt, Satzzeichen entfernt und häufige Rechtschreibvarianten korrigiert werden. Dadurch wird sichergestellt, dass “Passwort zurücksetzen”, “passwort zurücksetzen” und “paswort zurücksetzen” alle als dasselbe Konzept erkannt werden. Der Chatbot entfernt außerdem Stoppwörter – häufige Wörter wie “der”, “ist”, “und”, “zu”, die wenig semantische Bedeutung tragen. Durch das Herausfiltern dieser Wörter kann sich das System auf die wirklich bedeutungstragenden Elemente konzentrieren. Zusätzlich führt das System eine Wortartenerkennung (Part-of-Speech-Tagging) durch, bei der bestimmt wird, ob jedes Wort als Substantiv, Verb, Adjektiv oder eine andere grammatische Kategorie fungiert. Dieses grammatikalische Verständnis hilft dem Chatbot zu erkennen, dass “zurücksetzen” in Ihrer Nachricht ein Tätigkeitsverb ist – entscheidend dafür, was Sie eigentlich erreichen wollen.

Die natürliche Sprachverarbeitung (Natural Language Processing, NLP) bildet das technologische Fundament, das Chatbots befähigt, menschliche Sprache auf semantischer Ebene zu verstehen. NLP umfasst mehrere miteinander verbundene Techniken, die zusammenarbeiten, um Bedeutung aus Text zu extrahieren. Die Entitätenerkennung (Named Entity Recognition, NER) identifiziert bestimmte Entitäten in Ihrer Nachricht – Eigennamen, Daten, Orte, Produktnamen und andere wichtige Informationen. Im Beispiel zum Zurücksetzen des Passworts würde NER “Passwort” als relevante Systementität für die Wissensdatenbank des Chatbots identifizieren. Diese Fähigkeit wird in komplexeren Szenarien noch mächtiger: Wenn Sie schreiben “Ich möchte einen Flug von Berlin nach London am 15. Dezember buchen”, extrahiert NER die Abflugstadt, die Zielstadt und das Datum – alles entscheidende Informationen, um Ihre Anfrage zu erfüllen.

Sentiment-Analyse ist eine weitere wichtige NLP-Komponente, mit der Chatbots die emotionale Tonlage Ihrer Nachricht erkennen. Ein Kunde, der sagt: “Ich warte seit drei Stunden und habe meine Bestellung immer noch nicht erhalten”, drückt Frustration aus – was der Chatbot erkennen sollte, um den Ton seiner Antwort anzupassen und das Anliegen entsprechend zu priorisieren. Moderne Sentiment-Analysen nutzen maschinelle Lernmodelle, die an Tausenden Beispielen trainiert wurden, um Texte als positiv, negativ oder neutral zu klassifizieren und zunehmend auch feinere Emotionen wie Frustration, Verwirrung oder Zufriedenheit zu erkennen. Diese emotionale Intelligenz ermöglicht es Chatbots, mit angemessener Empathie und Dringlichkeit zu reagieren und verbessert die Kundenzufriedenheit erheblich.

Nach der Verarbeitung des Rohtexts muss der Chatbot bestimmen, was der Benutzer eigentlich will – seine Absicht (Intent). Die Intent-Erkennung ist eine der wichtigsten Funktionen in der Chatbot-Architektur, da sie die Brücke zwischen dem, was Benutzer sagen, und dem, was sie erreichen möchten, schlägt. Das System verwendet maschinelle Lernklassifikatoren, die an Tausenden von Beispielkonversationen trainiert wurden, um Benutzeräußerungen vordefinierten Intents zuzuordnen. Die Sätze “Ich habe mein Passwort vergessen”, “Wie setze ich mein Passwort zurück?”, “Ich kann mich nicht einloggen” und “Mein Konto ist gesperrt” könnten alle dem gleichen Intent “Passwort_zurücksetzen” zugeordnet werden, auch wenn sie unterschiedlich formuliert sind.

Gleichzeitig extrahiert das System Entitäten – also spezifische Datenpunkte in der Nachricht des Benutzers, die für die Bearbeitung seiner Anfrage relevant sind. Sagt ein Kunde: “Ich möchte meinen Tarif auf die Premium-Stufe upgraden”, extrahiert das System zwei wichtige Entitäten: die Aktion (“upgraden”) und das Ziel (“Premium-Stufe”). Diese extrahierten Entitäten werden zu Parametern, die die Antwortgenerierung des Chatbots steuern. Fortgeschrittene Chatbots nutzen Abhängigkeitsparsing (Dependency Parsing), um die grammatikalischen Beziehungen zwischen Wörtern zu verstehen, zu erkennen, welche Substantive Subjekte, welche Objekte sind und wie sie sich auf Verben und Modifikatoren beziehen. Dieses tiefere syntaktische Verständnis ermöglicht es dem Chatbot, komplexe, mehrteilige Sätze und mehrdeutige Formulierungen zu handhaben, die einfachere Systeme verwirren würden.

Das Dialogmanagement ist das “Gehirn” des Chatbots und dafür verantwortlich, den Gesprächskontext beizubehalten und angemessene Antworten zu bestimmen. Im Gegensatz zu einfachen Nachschlagesystemen halten ausgefeilte Dialogmanager einen Konversationsstatus aufrecht, der verfolgt, was bereits besprochen wurde, welche Informationen gesammelt wurden und was das aktuelle Ziel des Benutzers ist. Dieses Kontextbewusstsein ermöglicht natürliche, fließende Gespräche, in denen der Chatbot frühere Interaktionen “im Gedächtnis” behält und passend darauf Bezug nehmen kann. Wenn Sie fragen “Wie ist das Wetter in Berlin?” und danach “Und morgen?”, versteht der Dialogmanager, dass sich “morgen” auf die Wettervorhersage für Berlin bezieht und nicht auf einen anderen Ort.

Der Dialogmanager implementiert Kontextmanagement, indem er relevante Informationen während des Gesprächs in strukturierter Form speichert. Dazu können Benutzerdaten, vorherige Anfragen, Präferenzen und das aktuelle Gesprächsthema gehören. Fortgeschrittene Systeme verwenden Zustandsautomaten (State Machines) oder hierarchische Aufgaben-Netzwerke (Hierarchical Task Networks) zur Modellierung von Gesprächsverläufen, die definieren, welche Zustände von welchen anderen erreichbar sind und welche Übergänge gültig sind. Ein Kundenservice-Chatbot könnte beispielsweise Zustände für “Begrüßung”, “Problemerkennung”, “Problemlösung”, “Eskalation” und “Abschluss” haben. Der Dialogmanager stellt sicher, dass das Gespräch logisch durch diese Zustände fortschreitet und nicht willkürlich zwischen ihnen springt.

Moderne KI-Chatbots generieren ihre Antworten nicht nur aus Trainingsdaten – sie greifen auf Wissensbasen mit aktuellen, organisationsspezifischen Informationen zu. Diese Integration ist entscheidend für Genauigkeit und Relevanz. Wenn ein Kunde fragt “Wie hoch ist mein Kontostand?”, muss der Chatbot tatsächlich das Bankensystem abfragen, um den aktuellen Stand zu liefern, statt eine plausibel klingende Zahl zu generieren. Ebenso greift der Chatbot bei der Frage “Wie sind Ihre Öffnungszeiten?” auf die Unternehmensdatenbank zu, um aktuelle, korrekte Informationen zu liefern, anstatt sich auf möglicherweise veraltete Trainingsdaten zu verlassen.

Retrieval-Augmented Generation (RAG) ist ein fortgeschrittener Ansatz zur Wissensintegration, der 2025 immer wichtiger wird. RAG-Systeme rufen zunächst auf Basis der Benutzeranfrage relevante Dokumente oder Informationen aus einer Wissensbasis ab und nutzen diese dann, um eine kontextuell passende Antwort zu generieren. Dieser zweistufige Prozess verbessert die Genauigkeit erheblich gegenüber rein generativen Ansätzen. Fragt ein Kunde beispielsweise nach einer bestimmten Produkteigenschaft, ruft das RAG-System die Produktdokumentation ab, extrahiert den relevanten Abschnitt und erzeugt eine Antwort, die auf dieser tatsächlichen Dokumentation basiert – anstatt sich auf möglicherweise halluzinierte Informationen zu verlassen. Dieser Ansatz ist besonders im Unternehmensumfeld wertvoll, wo Genauigkeit und Compliance oberste Priorität haben.

Nachdem die Benutzerabsicht verstanden und alle notwendigen Informationen gesammelt wurden, muss der Chatbot eine passende Antwort generieren. Die Antwortgenerierung kann auf verschiedene Arten erfolgen, die jeweils eigene Vor- und Nachteile haben. Vorlagenbasierte Generierung nutzt vordefinierte Antwortvorlagen mit Variablenfeldern, die mit spezifischen Informationen gefüllt werden. Eine Vorlage könnte beispielsweise lauten: “Ihre Bestellung #[BESTELLNUMMER] wird am [LIEFERDATUM] zugestellt.” Dieser Ansatz ist sehr zuverlässig und vorhersehbar, aber in Flexibilität und Natürlichkeit eingeschränkt.

Regelbasierte Generierung verwendet spezifische sprachliche Regeln, um Antworten basierend auf erkanntem Intent und extrahierten Entitäten zu konstruieren. Diese Regeln können vorgeben, dass für den Intent “Passwort_zurücksetzen” die Antwort eine Bestätigung, einen Link zur Reset-Seite und weitere Anweisungen enthalten soll. Dieser Ansatz bietet mehr Flexibilität als Vorlagen und bleibt dabei zuverlässig, erfordert aber umfangreiche Regelentwicklung für komplexe Szenarien.

Neurale Generierung, angetrieben durch große Sprachmodelle (LLMs), steht an der Spitze der Antwortgenerierungstechnologie. Diese Systeme nutzen Deep-Learning-Architekturen wie Transformer, um neuartige, kontextuell passende Antworten zu generieren, die bemerkenswert menschlich klingen. Moderne LLMs werden mit Milliarden von Texttokens trainiert und lernen dabei statistische Muster der Sprache und die Zusammenhänge von Konzepten. Beim Generieren einer Antwort sagt das Modell das wahrscheinlichste nächste Wort basierend auf allen vorherigen Wörtern voraus und wiederholt diesen Prozess, bis vollständige Sätze entstehen. Der Vorteil der neurale Generierung ist ihre Flexibilität und Natürlichkeit; der Nachteil ist, dass diese Systeme gelegentlich “halluzinieren” – also plausibel klingende, aber faktisch falsche Informationen erzeugen.

Maschinelles Lernen ist der Mechanismus, durch den Chatbots im Laufe der Zeit besser werden. Statt statischer Systeme mit festen Regeln lernen moderne Chatbots aus jeder Interaktion und verfeinern schrittweise ihr Verständnis von Sprachmustern und Benutzerintentionen. Überwachtes Lernen (Supervised Learning) bedeutet, dass der Chatbot an annotierten Beispielen trainiert wird, bei denen Menschen für Tausende Benutzernachrichten die korrekte Absicht und Entitäten markiert haben. Der Lernalgorithmus erkennt Muster, die eine Absicht von einer anderen unterscheiden, und baut so ein Modell auf, das neue, unbekannte Nachrichten mit hoher Genauigkeit klassifizieren kann.

Bestärkendes Lernen (Reinforcement Learning) ermöglicht es Chatbots, ihre Antworten anhand von Benutzerfeedback zu optimieren. Wenn ein Benutzer eine Antwort positiv bewertet (durch explizites Feedback oder indem er das Gespräch fortsetzt), verstärkt das System die Muster, die zu dieser Antwort geführt haben. Zeigen Benutzer Unzufriedenheit oder brechen das Gespräch ab, lernt das System, ähnliche Muster in Zukunft zu vermeiden. Dieser Feedback-Loop schafft einen positiven Kreislauf, in dem die Chatbot-Leistung kontinuierlich steigt. Fortgeschrittene Systeme setzen Human-in-the-Loop-Learning ein, bei dem menschliche Agenten schwierige Gespräche überprüfen und Korrekturen liefern, aus denen das System lernt – das beschleunigt die Verbesserung erheblich gegenüber rein automatisiertem Lernen.

Große Sprachmodelle (LLMs) haben die Fähigkeiten von Chatbots seit 2023 grundlegend verändert. Diese Modelle, trainiert mit Hunderten Milliarden Texttokens, entwickeln ein ausgefeiltes Verständnis von Sprache, Kontext und domänenspezifischem Wissen. Modelle wie GPT-4, Claude und Gemini können nuancierte Konversationen führen, komplexe Anweisungen verstehen und kohärente, kontextuell passende Antworten zu unterschiedlichsten Themen generieren. Die Stärke der LLMs liegt in ihrer Transformer-Architektur, die mit Attention-Mechanismen Beziehungen zwischen weit entfernten Wörtern in einem Satz erfasst und so den Kontext über lange Konversationen hinweg aufrechterhält.

Allerdings haben LLMs auch Einschränkungen, die Unternehmen berücksichtigen müssen. Sie können halluzinieren – also selbstbewusst falsche, aber plausibel klingende Informationen erzeugen. Sie tun sich mit sehr aktuellen Informationen schwer, die nicht in ihren Trainingsdaten enthalten sind. Sie können Verzerrungen aus ihren Trainingsdaten aufweisen. Um diese Einschränkungen zu adressieren, setzen Unternehmen zunehmend auf Feinabstimmung (Fine-Tuning), um allgemeine LLMs an spezifische Domänen anzupassen, und auf Prompt Engineering, um Modelle in die gewünschte Richtung zu lenken. FlowHunts Ansatz zum Chatbot-Bau nutzt diese fortschrittlichen Modelle und bietet gleichzeitig Leitplanken und Wissensquellen-Integration, um Genauigkeit und Zuverlässigkeit sicherzustellen.

| Aspekt | Regelbasierte Chatbots | KI-gestützte Chatbots | LLM-basierte Chatbots |

|---|---|---|---|

| Technologie | Entscheidungsbäume, Musterabgleich | NLP, ML-Algorithmen, Intent-Erkennung | Große Sprachmodelle, Transformer |

| Flexibilität | Auf vordefinierte Regeln beschränkt | Passt sich Formulierungsvariationen an | Hoch flexibel, bewältigt neue Eingaben |

| Genauigkeit | Hoch bei definierten Szenarien | Gut bei richtiger Schulung | Exzellent, benötigt aber Leitplanken |

| Lernfähigkeit | Keine | Lernt aus Interaktionen | Lernt durch Feinabstimmung & Feedback |

| Halluzinationsrisiko | Keins | Minimal | Benötigt Gegenmaßnahmen |

| Implementierungsdauer | Schnell | Mittel | Schnell mit Plattformen wie FlowHunt |

| Wartung | Hoch (Regelupdates nötig) | Mittel | Mittel (Modell-Updates, Monitoring) |

| Kosten | Niedrig | Mittel | Mittel bis hoch |

| Beste Einsatzszenarien | Einfache FAQs, Basisrouting | Kundenservice, Lead-Qualifizierung | Komplexes Denken, Content-Generierung |

Moderne Chatbots nutzen die Transformer-Architektur – ein neuronales Netzwerkdesign, das die Verarbeitung natürlicher Sprache revolutioniert hat. Transformer verwenden Attention-Mechanismen, mit denen das Modell sich beim Generieren jedes Wortes auf relevante Teile der Eingabe konzentriert. Beim Verarbeiten von “Die Bankdirektorin sorgte sich um die Erosion des Flussufers” hilft der Attention-Mechanismus dem Modell zu verstehen, dass das erste “Bank” eine Finanzinstitution meint, das zweite hingegen ein Flussufer – und zwar anhand des Kontexts. Dieses Kontextverständnis ist älteren Ansätzen, die Text sequentiell und ohne Kontextverknüpfung bearbeiteten, weit überlegen.

Multi-Head Attention erweitert dieses Konzept, indem das Modell verschiedene Aspekte der Eingabe gleichzeitig betrachten kann. Ein Attention-Head könnte sich auf grammatische Beziehungen konzentrieren, ein anderer auf semantische, ein dritter auf Diskursstruktur. Diese parallele Verarbeitung unterschiedlicher sprachlicher Phänomene ermöglicht es dem Modell, reichhaltige, nuancierte Bedeutungsrepräsentationen aufzubauen. Dank Positional Encoding können Transformer die Wortreihenfolge verstehen, obwohl sie alle Wörter parallel verarbeiten – eine entscheidende Fähigkeit, da die Reihenfolge im Deutschen wie im Englischen Bedeutung trägt.

FlowHunt steht für einen modernen Ansatz der Chatbot-Entwicklung, der einen Großteil der technischen Komplexität abstrahiert und dennoch Zugang zu leistungsstarker KI bietet. Statt dass Teams Chatbot-Infrastruktur von Grund auf bauen, stellt FlowHunt einen visuellen Builder bereit, in dem auch Nicht-Techniker Gesprächsabläufe entwerfen, indem sie Komponenten für verschiedene Chatbot-Funktionen verbinden. Die Plattform übernimmt das zugrunde liegende NLP, die Intent-Erkennung und die Antwortgenerierung – so können sich Teams ganz auf das Konversationsdesign und die Integration mit ihren Geschäftssystemen konzentrieren.

Mit der Wissensquellen-Funktion von FlowHunt können Chatbots in Echtzeit auf Informationen aus Dokumenten, Websites und Datenbanken zugreifen und so RAG-Prinzipien anwenden, um Genauigkeit zu gewährleisten. Die KI-Agenten-Funktion der Plattform erlaubt es, autonome Systeme zu bauen, die weit mehr als nur Konversation bieten – etwa Datenbanken aktualisieren, E-Mails versenden, Termine planen oder Workflows auslösen. Das stellt eine bedeutende Weiterentwicklung gegenüber klassischen Chatbots dar, die nur Informationen liefern; mit FlowHunt betriebene Systeme können tatsächlich Aufgaben für Benutzer erledigen. Die Integrationsmöglichkeiten der Plattform verbinden Chatbots mit CRM-Systemen, Helpdesk-Software und Business-Anwendungen und ermöglichen so nahtlosen Datenfluss und Aktionsausführung.

Eine effektive Chatbot-Einführung erfordert die Überwachung wichtiger Leistungskennzahlen, die zeigen, ob das System die Geschäftsziele erfüllt. Intent-Erkennungsgenauigkeit misst, wie viele Benutzernachrichten korrekt in die richtige Kategorie eingeordnet werden. Entitätsextraktionsgenauigkeit zeigt, ob relevante Datenpunkte richtig erkannt werden. Benutzerzufriedenheitswerte, z. B. durch Nachbefragungen, geben Auskunft darüber, wie hilfreich die Interaktion empfunden wurde. Gesprächsabschlussrate misst, wie viele Konversationen ohne Übergabe an einen menschlichen Agenten gelöst werden.

Antwortlatenz misst, wie schnell der Chatbot antwortet – entscheidend für die Nutzererfahrung, da Verzögerungen von mehr als wenigen Sekunden die Zufriedenheit deutlich senken. Die Eskalationsrate gibt an, wie viele Gespräche an Menschen übergeben werden müssen – niedrigere Raten sprechen für eine bessere Chatbot-Leistung. Kosten pro Konversation misst die wirtschaftliche Effizienz des Chatbots, indem die KI-Verarbeitungskosten mit den Kosten für menschliche Bearbeitung verglichen werden. Unternehmen sollten vor der Einführung Basiswerte festlegen und diese Kennzahlen kontinuierlich überwachen, um Verbesserungsmöglichkeiten zu erkennen und den Wertbeitrag des Chatbots im Zeitverlauf sicherzustellen.

Chatbots verarbeiten häufig sensible Informationen wie personenbezogene Daten, Finanzinformationen und vertrauliche Geschäftsdaten. Datenverschlüsselung stellt sicher, dass Informationen zwischen Nutzern und Chatbot-Systemen vor dem Abhören geschützt sind. Authentifizierungsmechanismen überprüfen, ob Nutzer wirklich die sind, für die sie sich ausgeben, bevor Zugriff auf sensible Daten gewährt wird. Zugriffskontrollen sorgen dafür, dass Chatbots nur auf die Daten zugreifen, die sie für ihre Aufgabe benötigen – nach dem Prinzip der minimalen Rechtevergabe. Unternehmen müssen Audit-Logs führen, um alle Chatbot-Interaktionen für Compliance- und Sicherheitszwecke nachvollziehen zu können.

Privacy by Design sollte die Entwicklung leiten und sicherstellen, dass personenbezogene Datenerhebung minimiert, Aufbewahrungsfristen begrenzt und Nutzer über Art und Verwendung ihrer Daten informiert werden. Einhaltung von Vorschriften wie DSGVO, CCPA sowie branchenspezifischen Vorgaben (z. B. HIPAA, PCI-DSS) ist unerlässlich. Unternehmen sollten Sicherheitsaudits ihrer Chatbot-Systeme durchführen, um Schwachstellen zu erkennen und geeignete Schutzmaßnahmen zu ergreifen. Die Verantwortung für Sicherheit reicht dabei über die Chatbot-Plattform hinaus und schließt auch Wissensbasen, Integrationen und Backend-Systeme ein.

Die Entwicklung der Chatbot-Technologie beschleunigt sich weiter. Multimodale Chatbots, die Text, Sprache, Bilder und Videos gleichzeitig verarbeiten und generieren, sind das nächste große Thema. Statt reiner Texteingaben werden Nutzer zunehmend in ihrer bevorzugten Modalität mit Chatbots interagieren – Sprache für freihändige Szenarien, Bilder für visuelle Produktanfragen, Videos für komplexe Erklärungen. Emotionale Intelligenz wird sich über einfache Sentiment-Erkennung hinaus entwickeln und eine nuancierte Einschätzung der Gefühlslage und angemessene emotionale Reaktionen ermöglichen. Chatbots werden erkennen, ob Nutzer frustriert, verwirrt oder zufrieden sind und ihren Kommunikationsstil entsprechend anpassen.

Proaktive Unterstützung ist eine weitere neue Fähigkeit, bei der Chatbots die Bedürfnisse der Nutzer vorausahnen, noch bevor diese explizit um Hilfe bitten. Statt auf Anfragen zu warten, erkennen Chatbots Muster, die auf potenzielle Probleme hindeuten, und bieten proaktiv Unterstützung an. Personalisierung wird immer ausgefeilter, indem Chatbots ihren Kommunikationsstil, Empfehlungen und Hilfestellungen individuell an Nutzerpräferenzen, -historie und -kontext anpassen. Integration mit autonomen Systemen ermöglicht es Chatbots, mit Robotic Process Automation, IoT-Geräten und anderen automatisierten Systemen zu kooperieren, um komplexe Aufgaben zu erledigen, die mehrere Systeme umfassen und orchestriert werden müssen.

Wer versteht, wie KI-Chatbots funktionieren, erkennt, warum sie branchenübergreifend zu unverzichtbaren Business-Tools geworden sind. Das ausgefeilte Zusammenspiel aus Sprachverarbeitung, maschinellem Lernen, Dialogmanagement und Wissensintegration ermöglicht es Chatbots, immer komplexere Aufgaben zu übernehmen und dabei natürliche, menschenähnliche Interaktionen zu bieten. Unternehmen, die Chatbots effektiv einsetzen – etwa mit Plattformen wie FlowHunt, die technische Komplexität abstrahieren und dennoch leistungsstarke Funktionen bieten – erzielen erhebliche Wettbewerbsvorteile durch höhere Kundenzufriedenheit, geringere Betriebskosten und schnellere Reaktionszeiten.

Die Technologie entwickelt sich rasant weiter – Fortschritte bei großen Sprachmodellen, multimodalen Fähigkeiten und autonomen Agenten erweitern die Möglichkeiten ständig. Unternehmen sollten die Einführung von Chatbots nicht als einmaliges Projekt, sondern als fortlaufende Fähigkeit begreifen, die sich durch kontinuierliches Lernen, Optimierung und Ausbau stetig verbessert. Die erfolgreichsten Umsetzungen kombinieren leistungsfähige KI-Technologie mit durchdachtem Konversationsdesign, geeigneten Leitplanken zur Sicherstellung von Genauigkeit und Sicherheit sowie Integration in Geschäftssysteme, damit Chatbots tatsächlich sinnvolle Aktionen ausführen können. Im Jahr 2025 und darüber hinaus werden Chatbots immer mehr zur primären Schnittstelle für die Interaktion von Kunden und Mitarbeitern mit Unternehmen – Investitionen in diese Technologie sind damit strategisch entscheidend für den Geschäftserfolg.

Beenden Sie die manuelle Bearbeitung wiederkehrender Kundenanfragen. Mit dem No-Code-KI-Chatbot-Builder von FlowHunt erstellen Sie intelligente, autonome Chatbots, die Kundenservice, Lead-Generierung und Support rund um die Uhr übernehmen. Einsatzbereit in Minuten, nicht Wochen.

Erfahren Sie, wie Sie einen KI-Chatbot von Grund auf entwickeln – mit unserem umfassenden Leitfaden. Entdecken Sie die besten Tools, Frameworks und den Schritt-...

Lerne, wie du einen Discord AI-Chatbot mit Schritt-für-Schritt-Anleitung, API-Integrationsmethoden, Fehlerbehandlung, Sicherheits-Best-Practices und erweiterten...

Erfahren Sie die besten Methoden, um KI-Chatbot-Assistenten im Jahr 2025 anzusprechen. Entdecken Sie formelle, lockere und spielerische Kommunikationsstile, Nam...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.