Wofür steht GPT in ChatGPT? Ein vollständiger Leitfaden zu 'chat gpbt'

Dieser umfassende Artikel erklärt, was 'GPT' in ChatGPT bedeutet, wie die Technologie funktioniert, ihre Entwicklung und beantwortet häufige Fragen zu 'chat gpb...

Erfahren Sie, was ein KI-Chatbot GPT ist, wie er funktioniert und warum ChatGPT die führende generative KI-Lösung ist. Entdecken Sie die Transformer-Architektur, Trainingsmethoden und reale Anwendungsfälle.

Ein KI-Chatbot GPT (Generative Pre-trained Transformer) ist ein fortschrittliches konversationelles KI-System, das von OpenAI entwickelt wurde und natürliche Sprachverarbeitung sowie Deep Learning nutzt, um menschenähnliche Textantworten zu generieren. ChatGPT, der bekannteste GPT-basierte Chatbot, versteht Kontext, beantwortet Fragen, erstellt Inhalte, schreibt Code und erledigt komplexe Aufgaben durch dynamische Textgenerierung statt vorprogrammierter Antworten.

Künstliche Intelligenz-Chatbots, die auf GPT-Technologie basieren, stellen einen der bedeutendsten Durchbrüche in der Verarbeitung natürlicher Sprache und im maschinellen Lernen dar. GPT steht für „Generative Pre-trained Transformer“ – ein Name, der die drei Kernkomponenten dieser revolutionären Technologie zusammenfasst. „Generativ“ bezieht sich auf die Fähigkeit des Systems, neuen, originellen Text zu erzeugen, anstatt lediglich vorgefertigte Antworten aus einer Datenbank abzurufen. „Pre-trained“ bedeutet, dass das Modell vor seiner spezifischen Anwendung umfassend auf riesigen Datensätzen trainiert wurde. „Transformer“ beschreibt die zugrunde liegende neuronale Netzwerkarchitektur, die es dem System ermöglicht, Sprache mit beispielloser Raffinesse und Genauigkeit zu verarbeiten und zu verstehen.

ChatGPT, entwickelt von OpenAI und im November 2022 veröffentlicht, ist die bekannteste Umsetzung der GPT-Technologie. Im Gegensatz zu traditionellen Chatbots, die auf starren, regelbasierten Systemen oder einfacher Mustererkennung basieren, nutzt ChatGPT Deep Learning, um die Feinheiten menschlicher Sprache zu erfassen, Kontext über mehrere Gesprächsrunden hinweg zu bewahren und Antworten zu generieren, die natürlich und situationsgerecht wirken. Das System kann Dialog führen, komplexe Fragen beantworten, verschiedene Arten von Texten verfassen, Code debuggen und kreative Aufgaben unterstützen – und das alles, ohne für jeden speziellen Anwendungsfall explizit programmiert zu sein. Diese Vielseitigkeit verdankt sich der Transformer-Architektur, die es ermöglicht, ganze Textsequenzen gleichzeitig und nicht Wort für Wort zu verarbeiten, sodass komplexe Beziehungen und Abhängigkeiten innerhalb der Sprache erkannt werden.

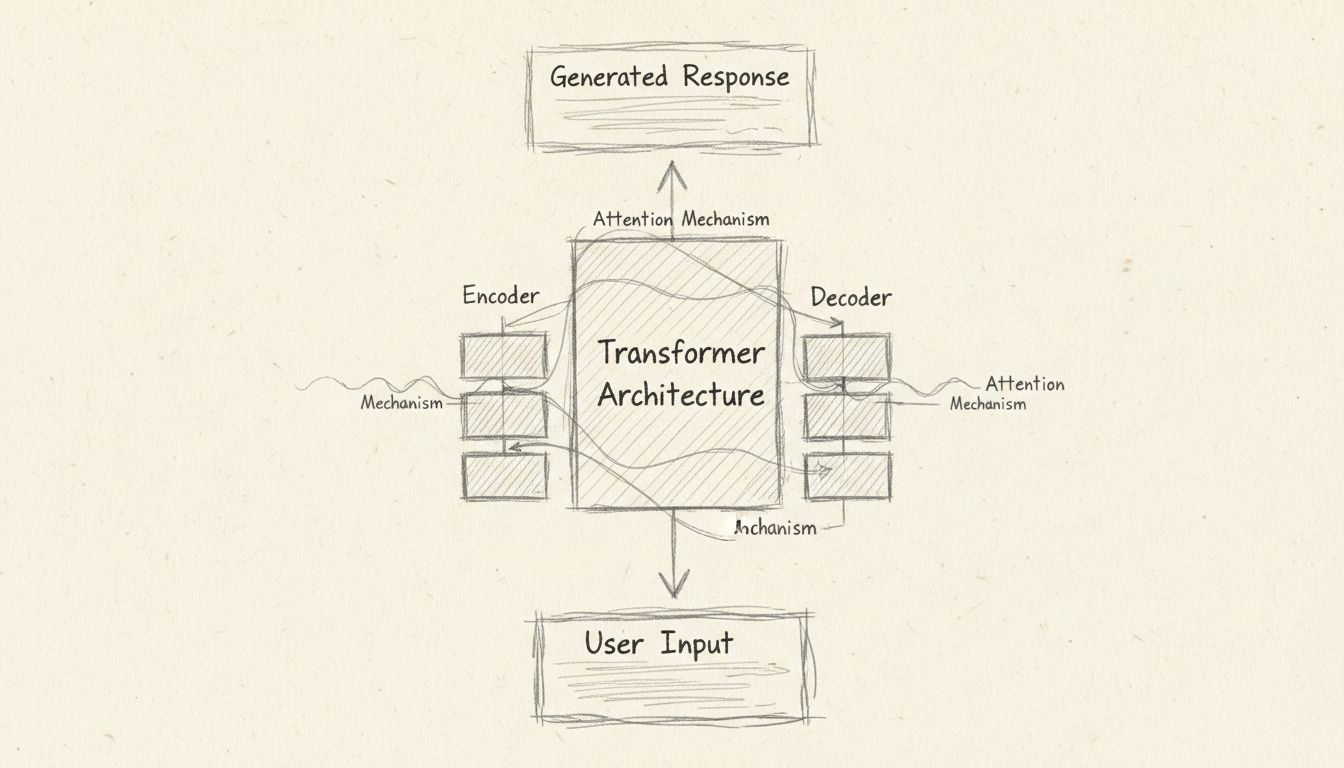

Die Transformer-Architektur stellt einen grundsätzlichen Wandel dar, wie KI-Systeme Sprache verarbeiten. Im Kern nutzt der Transformer einen Mechanismus namens „Self-Attention“, um zu bestimmen, welche Teile des Eingabetexts beim Erzeugen jedes einzelnen Wortes der Ausgabe am wichtigsten sind. Das unterscheidet sich grundlegend von früheren Ansätzen wie rekurrenten neuronalen Netzen, die Texte sequenziell verarbeiteten und Schwierigkeiten hatten, Kontext über längere Passagen hinweg zu bewahren. Die parallele Verarbeitung des Transformers macht ihn deutlich schneller und effizienter, während die Attention-Mechanismen es ermöglichen, komplexe Zusammenhänge zwischen weit auseinanderliegenden Wörtern zu verstehen.

Die Transformer-Architektur besteht aus zwei Hauptkomponenten: dem Encoder und dem Decoder. Der Encoder verarbeitet den Eingabetext und wandelt ihn in mathematische Repräsentationen, sogenannte Embeddings, um. Diese Embeddings sind Vektoren in einem hochdimensionalen Raum, in dem Wörter mit ähnlicher Bedeutung nahe beieinanderliegen. Der Encoder weist jedem Wort Gewichte zu, die seine Relevanz und Bedeutung im Kontext des gesamten Inputs anzeigen. Positionsembeddings werden eingesetzt, um Mehrdeutigkeiten zu vermeiden – zum Beispiel hilft es dem System zu verstehen, dass „Ein Hund jagt eine Katze“ etwas anderes bedeutet als „Eine Katze jagt einen Hund“, obwohl die gleichen Wörter in beiden Sätzen vorkommen. Der Decoder nimmt diese codierten Repräsentationen und generiert den Ausgabetext Wort für Wort, wobei er die gleichen Self-Attention-Mechanismen nutzt, um sich jeweils auf die wichtigsten Teile des Inputs zu konzentrieren.

| Komponente | Funktion | Hauptvorteil |

|---|---|---|

| Encoder | Verarbeitet Eingabetext und erstellt Embeddings | Erfasst semantische Bedeutung und Kontext |

| Decoder | Generiert Ausgabetext basierend auf Encodierung | Liefert kohärente, kontextgerechte Antworten |

| Self-Attention | Bestimmt Relevanz verschiedener Inputteile | Ermöglicht Verständnis langer Abhängigkeiten |

| Positionskodierung | Verfolgt Wortreihenfolge und Positionsangabe | Bewahrt grammatische Struktur und Bedeutung |

| Embeddings | Mathematische Wortrepräsentationen | Erlaubt semantische Ähnlichkeitsberechnung |

Die Entwicklung von GPT-Modellen umfasst einen ausgefeilten, mehrstufigen Trainingsprozess, der rohe Textdaten in ein intelligentes Sprachsystem verwandelt. GPT-3, das viele aktuelle ChatGPT-Implementierungen antreibt, wurde mit über 175 Milliarden Parametern und mehr als 45 Terabyte Daten aus unterschiedlichsten Quellen wie Webtexten, Common Crawl, Büchern und Wikipedia trainiert. Diese enorme Trainingsdatenmenge ist unerlässlich, da sie das Modell mit der Vielfalt menschlicher Sprache konfrontiert und es befähigt, Kontext, Redewendungen, Fachbegriffe und kulturelle Anspielungen aus praktisch allen Wissensgebieten zu verstehen.

Das Training beginnt mit unbeaufsichtigtem Lernen, bei dem das Modell lernt, das nächste Wort einer Sequenz auf Basis der vorherigen Wörter vorherzusagen. Diese scheinbar einfache Aufgabe zwingt das Modell, ein tiefes Verständnis für Sprachstruktur, Grammatik, Semantik und Weltwissen zu entwickeln. Das Modell lernt, dass bestimmte Wortkombinationen wahrscheinlicher sind als andere, dass einige Begriffe zusammengehören und dass Sprache Regeln und Muster folgt. Nach dieser initialen Pre-Training-Phase erfolgt das Feintuning mittels „Reinforcement Learning from Human Feedback“ (RLHF). In dieser Phase liefern menschliche Trainer Beispieldialoge und bewerten verschiedene Antworten nach Qualität, Nützlichkeit und Sicherheit. Diese Bewertungen bilden Belohnungsmodelle, die das System zu besseren Antworten leiten. Dieser Feedback-Loop ist entscheidend, um die Ausgaben des Modells mit menschlichen Werten und Erwartungen in Einklang zu bringen und die Wahrscheinlichkeit schädlicher, voreingenommener oder unsinniger Inhalte zu verringern.

Moderne KI-Chatbots, die auf GPT-Technologie basieren, zeigen bemerkenswerte Vielseitigkeit in zahlreichen Bereichen und Anwendungsfällen. Im Kundenservice können diese Systeme Routineanfragen beantworten, Produktinformationen bereitstellen, häufige Probleme beheben und komplexe Anliegen an menschliche Mitarbeiter weiterleiten – und das alles in einem natürlichen, hilfsbereiten Tonfall. In der Bildung dienen KI-Chatbots als virtuelle Tutoren, erklären komplexe Themen verständlich, beantworten Schülerfragen und bieten personalisierte Lernunterstützung. Inhaltsersteller nutzen GPT-gestützte Chatbots, um Ideen zu entwickeln, Artikel und Social-Media-Posts zu entwerfen, Texte für verschiedene Zielgruppen zu optimieren und Schreibblockaden zu überwinden. Softwareentwickler greifen auf diese Systeme zurück, um Code zu schreiben, Programme zu debuggen, Programmierkonzepte zu erklären und Entwicklungsprozesse zu beschleunigen.

Die Fähigkeit, verschiedene Arten von Inhalten zu verarbeiten und zu generieren, geht über reinen Text hinaus. Fortschrittliche GPT-Implementierungen können Bilder analysieren, visuelle Inhalte beschreiben, Fragen zu Fotos beantworten und sogar Bilder auf Basis von Textbeschreibungen erzeugen. Einige Systeme verarbeiten auch Audioeingaben, was sprachbasierte Interaktionen ermöglicht, die sich wie natürliche Gespräche anfühlen. Diese multimodalen Fähigkeiten machen KI-Chatbots zunehmend nützlich für Barrierefreiheit, indem sie es Menschen mit unterschiedlichen Fähigkeiten erlauben, auf für sie optimale Weise mit Technologie zu interagieren. Die Systeme können zudem das Internet nach aktuellen Informationen durchsuchen, sodass Antworten aktuelle Ereignisse und Entwicklungen widerspiegeln und nicht nur auf Trainingsdaten beruhen, die Monate oder Jahre alt sein können.

Obwohl ChatGPT zum meistgenutzten KI-Chatbot geworden ist, gibt es auf dem Markt mehrere andere fortschrittliche Alternativen mit jeweils eigenen Stärken und Besonderheiten. ChatGPT bleibt für die meisten Nutzer die erste Wahl – dank außergewöhnlichem Sprachverständnis, umfangreichem Wissensschatz und kontinuierlichen Verbesserungen durch regelmäßige Updates. Die Fähigkeit, Kontext über lange Gespräche hinweg zu bewahren, nuancierte Anfragen zu verstehen und hochwertige Inhalte in verschiedensten Bereichen zu generieren, macht ChatGPT zur führenden Lösung für allgemeine KI-Unterstützung.

Googles Gemini (ehemals Bard) bietet Echtzeit-Internetsuche und kann aktuelle Informationen zu Ereignissen, Nachrichten und Entwicklungen liefern. Dieser Vorteil ist besonders nützlich bei Anfragen, die aktuelle Informationen erfordern. Allerdings stand Gemini gelegentlich wegen Ungenauigkeiten und inkonsistenter Leistung im Vergleich zu ChatGPT in der Kritik. Microsofts Copilot, angetrieben von GPT-4-Technologie, ist tief in das Microsoft-Ökosystem einschließlich Bing-Suche, Office-Anwendungen und Windows integriert – besonders wertvoll für Nutzer, die bereits auf Microsoft-Produkte setzen. Claude von Anthropic legt besonderen Wert auf Sicherheit und konstitutionelle KI-Prinzipien und ist besonders stark in der Analyse langer Dokumente sowie bei konsistenter Argumentation bei komplexen Aufgaben. Perplexity AI konzentriert sich auf suchgestützte Antworten mit transparenten Quellenangaben und eignet sich daher besonders für forschungsorientierte Fragen.

| Chatbot | Stärken | Am besten geeignet für |

|---|---|---|

| ChatGPT | Vielseitigkeit, natürliches Sprachverständnis, breites Wissen | Allgemeine KI-Unterstützung |

| Google Gemini | Echtzeit-Suche, aktuelle Informationen | Anfragen zu aktuellen Ereignissen/Nachrichten |

| Microsoft Copilot | Integration ins Microsoft-Ökosystem | Office- und Windows-Nutzer |

| Claude | Analyse langer Dokumente, Fokus auf Sicherheit | Komplexe Argumentation und Analysen |

| Perplexity AI | Quellenangaben, suchgestützt | Recherche und Faktenprüfung |

Chatbots auf GPT-Basis bieten erhebliche Vorteile, die ihre schnelle Verbreitung über verschiedenste Branchen und Anwendungsfälle hinweg vorangetrieben haben. Die Systeme erfassen Kontext und führen zusammenhängende Gespräche über längere Dialoge hinweg, sodass Nutzer Folgefragen stellen und auf vorherige Antworten aufbauen können, ohne ihr Anliegen ständig erneut erklären zu müssen. Sie können Inhalte praktisch in jedem Stil oder Format generieren – von förmlicher Geschäftskorrespondenz über kreative Texte bis hin zu technischer Dokumentation. Die Fähigkeit, auf komplexe, mehrteilige Fragen zu antworten, demonstriert fortgeschrittene Argumentationsfähigkeiten. Zudem lassen sich die Systeme durch Feintuning oder „In-Context Learning“ anpassen, indem Nutzer Beispiele innerhalb des Gesprächs geben, um das Verhalten des Systems zu steuern.

Allerdings haben aktuelle GPT-Systeme auch beachtenswerte Grenzen, die Nutzer kennen sollten. Die Systeme können „halluzinieren“, also plausibel klingende, aber völlig erfundene Informationen, Statistiken oder Quellen erzeugen. Dieses Problem hat mit neueren Modellen abgenommen, bleibt aber für Anwendungen mit höchsten Genauigkeitsanforderungen relevant. GPT-Modelle haben ein Wissens-Stichtagsdatum – sie können keine Informationen jenseits der Trainingsdaten abrufen, auch wenn manche Implementierungen mittlerweile Internetsuche bieten, um diese Grenze zu umgehen. Die Systeme tun sich mit sehr aktuellen Ereignissen, hochspezialisiertem Fachwissen oder Aufgaben, die Echtzeitinformationen erfordern, oft schwer. Außerdem spiegeln GPT-Modelle mögliche Vorurteile aus den Trainingsdaten wider und können daher Antworten generieren, die Stereotype oder ungerechte Verallgemeinerungen enthalten. Sie können Ironie, Sarkasmus oder stark kontextabhängigen Humor nicht wirklich verstehen und nehmen bildhafte Sprache manchmal wörtlich. Schließlich können GPT-Systeme zwar Code schreiben, dieser kann jedoch subtile Fehler oder Sicherheitslücken enthalten, die menschlicher Kontrolle bedürfen.

Während eigenständige KI-Chatbots wie ChatGPT für einzelne Nutzer leistungsfähige Werkzeuge sind, benötigen Unternehmen, die KI in ihre Geschäftsprozesse integrieren wollen, umfassendere Lösungen. FlowHunt repräsentiert die nächste Evolutionsstufe der KI-Automatisierung und bietet eine Plattform, auf der KI-Chatbots nicht nur Fragen beantworten, sondern Aktionen im gesamten Geschäftssystem ausführen. Im Unterschied zu ChatGPT, das isoliert arbeitet, ermöglicht FlowHunt den Aufbau intelligenter Workflows, die KI mit tausenden Geschäftsanwendungen, Datenbanken und Diensten verbinden.

Mit FlowHunt können Sie KI-gestützte Chatbots erstellen, die automatisch Ihr CRM aktualisieren, wenn Kunden Daten angeben, Support-Tickets aus Kundenanfragen generieren, Lead-Daten aus verschiedenen Quellen anreichern, Benachrichtigungen an Teammitglieder senden und komplexe mehrstufige Prozesse ohne menschliches Zutun ausführen. Die Plattform ermöglicht es, maßgeschneiderte KI-Agenten zu bauen, die Ihre spezifischen Geschäftsprozesse verstehen, auf Ihre proprietären Daten zugreifen und Entscheidungen im Einklang mit Ihren Unternehmenszielen treffen. Beispielsweise könnten Sie einen KI-Chatbot einsetzen, der Kundenanfragen bearbeitet, sie nach Dringlichkeit kategorisiert, Tickets im Supportsystem anlegt, die Wissensdatenbank nach passenden Lösungen durchsucht und personalisierte Antworten entwirft – und das alles in Sekunden. Dieses Maß an Integration macht KI vom reinen Produktivitätstool zum strategischen Geschäftsvorteil, der Effizienz steigert, Kosten senkt und das Kundenerlebnis verbessert.

Der Vorteil von FlowHunt gegenüber eigenständigen Chatbots liegt in der Fähigkeit, KI über den gesamten Technologie-Stack hinweg zu orchestrieren. Anstatt Informationen manuell zwischen Systemen zu übertragen oder viele unverbundene Tools zu nutzen, schafft FlowHunt nahtlose Workflows, in denen KI intelligente Entscheidungen trifft und Aktionen auslöst, die sich durch die Organisation ziehen. Die Plattform unterstützt die Integration mit CRM-Systemen, Marketing-Automatisierung, Projektmanagementsoftware, Kommunikationsplattformen, Data Warehouses und Hunderten anderer Geschäftsanwendungen. Dieser umfassende Ansatz für KI-Automatisierung ermöglicht Unternehmen Effizienz und Intelligenz, die mit Einzelchatbots nicht zu erreichen sind.

Das Feld der KI-Chatbots und GPT-Technologie entwickelt sich rasant weiter, mit immer neuen Fähigkeiten und Verbesserungen. OpenAI hat immer leistungsfähigere Modelle veröffentlicht – von GPT-3 über GPT-4 bis hin zum aktuellen GPT-4o – die jeweils Fortschritte bei Geschwindigkeit, Genauigkeit, Argumentationsfähigkeit und multimodaler Verarbeitung bieten. Der Trend zu größeren Modellen mit mehr Parametern hält an, zugleich wächst jedoch das Interesse an effizienteren Modellen, die auch auf kleineren Geräten oder mit geringerem Rechenaufwand laufen können. Zukünftige Fähigkeiten umfassen bessere Argumentation bei komplexen, mehrstufigen Problemen, verbessertes Befolgen komplexer Anweisungen, höhere Sicherheit und bessere Ausrichtung auf menschliche Werte sowie einen besseren Umgang mit Randfällen und ungewöhnlichen Szenarien.

Die Integration von KI-Chatbots in Geschäftsprozesse wird sich wahrscheinlich beschleunigen, da immer mehr Unternehmen den Wert von KI-gestützter Automatisierung erkennen. Wir können mit noch ausgefeilteren KI-Agenten rechnen, die innerhalb definierter Parameter autonom agieren, Entscheidungen treffen und Aktionen ohne ständige menschliche Aufsicht ausführen. Die Kombination von KI-Chatbots mit anderen Zukunftstechnologien wie Wissensgraphen, Vektordatenbanken und „Retrieval-Augmented Generation“ ermöglicht Systeme, die auf riesige Mengen strukturierter und unstrukturierter Daten zugreifen und diese verarbeiten können. Mit dem Fortschreiten dieser Technologien wird die Grenze zwischen „Chatbots“ und „Geschäftsautomatisierungssystemen“ verschwimmen und KI zu einem integralen Bestandteil der Unternehmensorganisation werden.

Zu verstehen, was KI-Chatbots und GPT-Technologie sind, ist für alle, die diese mächtigen Werkzeuge effektiv nutzen wollen, unerlässlich. ChatGPT und ähnliche Systeme stellen einen echten Durchbruch in der künstlichen Intelligenz dar, indem sie Maschinen ermöglichen, menschliche Sprache mit bemerkenswerter Raffinesse zu verstehen und zu erzeugen. Die Wahl zwischen einem eigenständigen Chatbot und einer umfassenden KI-Automatisierungsplattform wie FlowHunt hängt jedoch von Ihren individuellen Anforderungen ab. Für Einzelanwender, die einen vielseitigen KI-Assistenten fürs Schreiben, Programmieren, Recherchieren und kreative Aufgaben suchen, bleibt ChatGPT eine exzellente Wahl. Für Unternehmen, die KI in ihre Geschäftsprozesse integrieren, Workflows automatisieren und messbare Geschäftsergebnisse erzielen wollen, bietet FlowHunt die umfassende Plattform, um KI vom Produktivitätstool zum strategischen Wettbewerbsvorteil zu machen.

FlowHunt ist die führende KI-Automatisierungsplattform, mit der Sie intelligente Chatbots und KI-Workflows erstellen, bereitstellen und verwalten können. Im Gegensatz zu eigenständigen Chatbots integriert FlowHunt KI in Ihr gesamtes Geschäftssystem, sodass eine nahtlose Automatisierung all Ihrer Tools und Prozesse möglich ist.

Dieser umfassende Artikel erklärt, was 'GPT' in ChatGPT bedeutet, wie die Technologie funktioniert, ihre Entwicklung und beantwortet häufige Fragen zu 'chat gpb...

Erfahren Sie, was ein GPT-Chatbot ist, wie die ChatbotGPT-Technologie funktioniert, welche Hauptvorteile und Praxisbeispiele es gibt und wie er sich von herkömm...

Erfahren Sie, wofür GPT in ChatGPT steht, wie Generative Pre-trained Transformer funktionieren und warum sie die fortschrittlichsten KI-Gespräche ermöglichen....

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.