Neuronale Netzwerke

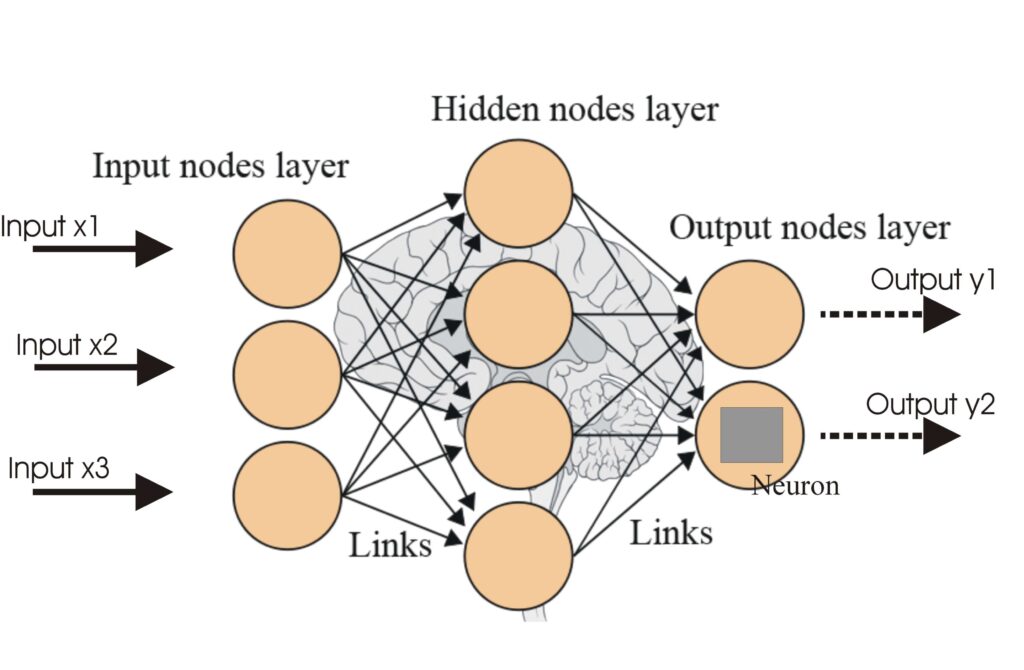

Ein neuronales Netzwerk, oder künstliches neuronales Netzwerk (KNN), ist ein vom menschlichen Gehirn inspiriertes Rechenmodell, das in KI und maschinellem Lerne...

Aktivierungsfunktionen führen Nichtlinearität in neuronale Netzwerke ein und ermöglichen es ihnen, komplexe Muster zu erlernen, die für KI- und Deep-Learning-Anwendungen unerlässlich sind.

Aktivierungsfunktionen sind grundlegend für die Architektur künstlicher neuronaler Netzwerke (ANNs) und beeinflussen maßgeblich die Fähigkeit des Netzwerks, zu lernen und komplexe Aufgaben auszuführen. Dieser Glossar-Artikel beleuchtet die Komplexität von Aktivierungsfunktionen, ihren Zweck, ihre Typen und Anwendungen – insbesondere in den Bereichen KI, Deep Learning und neuronale Netzwerke.

Eine Aktivierungsfunktion in einem neuronalen Netzwerk ist eine mathematische Operation, die auf die Ausgabe eines Neurons angewendet wird. Sie entscheidet, ob ein Neuron aktiviert wird oder nicht, und bringt Nichtlinearität in das Modell ein, was dem Netzwerk ermöglicht, komplexe Muster zu erlernen. Ohne diese Funktionen würde ein neuronales Netzwerk im Grunde wie ein lineares Regressionsmodell agieren, unabhängig von seiner Tiefe oder der Anzahl der Schichten.

Sigmoid-Funktion

Tanh-Funktion

ReLU (Rectified Linear Unit)

Leaky ReLU

Softmax-Funktion

Swish-Funktion

Aktivierungsfunktionen sind integraler Bestandteil verschiedener KI-Anwendungen, darunter:

Eine Aktivierungsfunktion ist eine mathematische Operation, die auf die Ausgabe eines Neurons angewendet wird. Sie führt Nichtlinearität ein und ermöglicht es neuronalen Netzwerken, komplexe Muster zu erlernen, die über einfache lineare Zusammenhänge hinausgehen.

Aktivierungsfunktionen ermöglichen es neuronalen Netzwerken, komplexe, nichtlineare Probleme zu lösen, indem sie das Erlernen komplizierter Muster erlauben. Dadurch sind sie entscheidend für Aufgaben wie Bildklassifikation, Sprachverarbeitung und Automatisierung.

Übliche Typen sind Sigmoid, Tanh, ReLU, Leaky ReLU, Softmax und Swish, die jeweils unterschiedliche Eigenschaften und Anwendungsfälle in verschiedenen Schichten von neuronalen Netzwerken haben.

Häufige Herausforderungen sind das Vanishing-Gradient-Problem (insbesondere bei Sigmoid und Tanh), das Dying-ReLU-Problem und der rechnerische Aufwand für Funktionen wie Softmax in Echtzeitanwendungen.

Intelligente Chatbots und KI-Tools unter einem Dach. Verbinden Sie intuitive Bausteine, um Ihre Ideen in automatisierte Flows zu verwandeln.

Ein neuronales Netzwerk, oder künstliches neuronales Netzwerk (KNN), ist ein vom menschlichen Gehirn inspiriertes Rechenmodell, das in KI und maschinellem Lerne...

Künstliche Neuronale Netze (ANNs) sind eine Untergruppe von Machine-Learning-Algorithmen, die dem menschlichen Gehirn nachempfunden sind. Diese Rechenmodelle be...

Rekurrente neuronale Netzwerke (RNNs) sind eine fortschrittliche Klasse künstlicher neuronaler Netzwerke, die zur Verarbeitung sequentieller Daten entwickelt wu...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.