Metoro MCP + FlowHunt

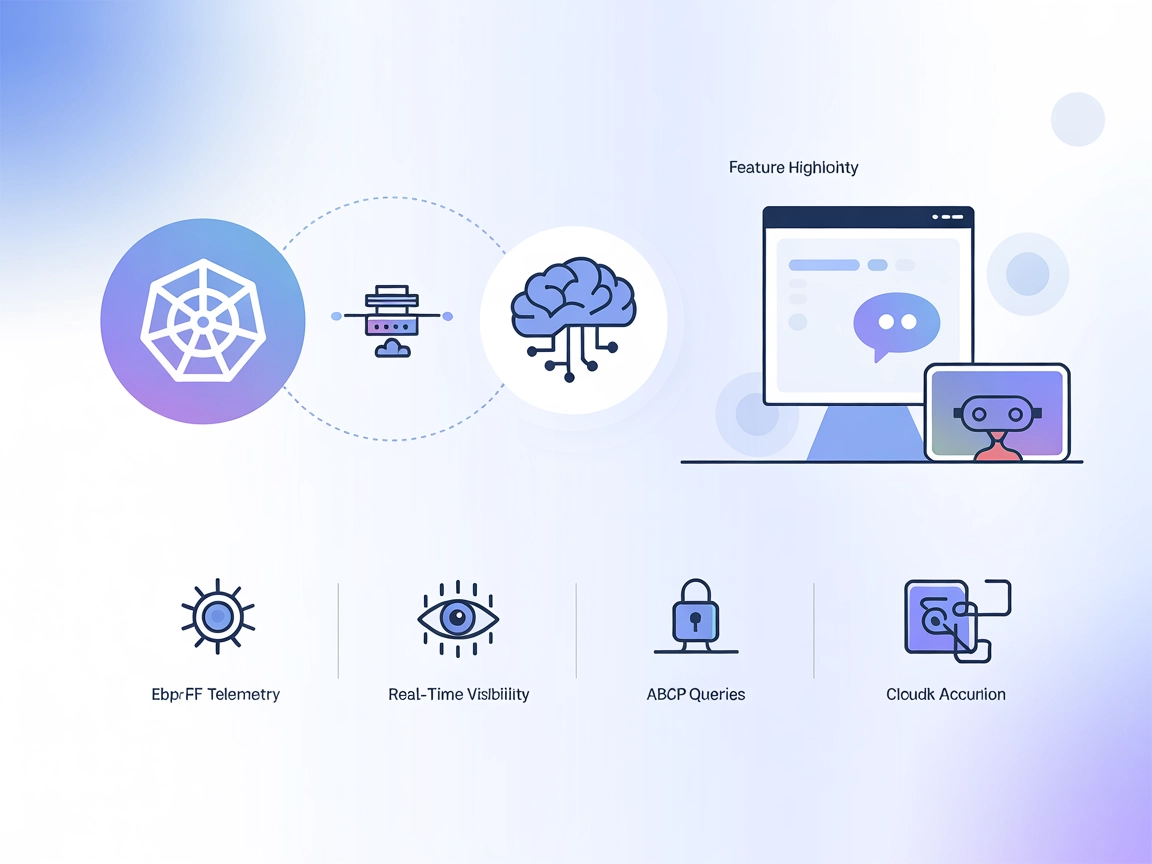

Integrieren Sie FlowHunt mit dem Metoro MCP Server, um KI-Agenten mit Echtzeit-Kubernetes-Observability auszustatten. Nutzen Sie eBPF-basierte Telemetrie, Model...

Kubeflow ist eine Open-Source-ML-Plattform auf Basis von Kubernetes, die die Bereitstellung, Verwaltung und Skalierung von Workflows für maschinelles Lernen über verschiedene Infrastrukturen hinweg vereinfacht.

Kubeflows Mission ist es, die Skalierung von ML-Modellen und deren Einsatz in der Produktion durch die Nutzung der Möglichkeiten von Kubernetes so einfach wie möglich zu gestalten. Dazu gehören einfache, wiederholbare und portable Deployments über verschiedene Infrastrukturen hinweg. Die Plattform begann als Methode, TensorFlow-Jobs auf Kubernetes auszuführen, und hat sich seitdem zu einem vielseitigen Framework entwickelt, das eine Vielzahl von ML-Frameworks und Tools unterstützt.

Kubeflow Pipelines ist eine Kernkomponente, mit der Nutzer ML-Workflows als gerichtete azyklische Graphen (DAGs) definieren und ausführen können. Sie bietet eine Plattform zum Aufbau portabler und skalierbarer Workflows für maschinelles Lernen mit Kubernetes. Die Pipelines-Komponente besteht aus:

Diese Funktionen ermöglichen es Data Scientists, den gesamten Prozess von Datenvorverarbeitung, Modelltraining, Evaluation und Deployment zu automatisieren und fördern so Reproduzierbarkeit und Zusammenarbeit in ML-Projekten. Die Plattform unterstützt die Wiederverwendung von Komponenten und Pipelines und optimiert so die Entwicklung von ML-Lösungen.

Das zentrale Dashboard von Kubeflow dient als Hauptschnittstelle für den Zugriff auf Kubeflow und sein Ökosystem. Es bündelt die Benutzeroberflächen verschiedener Tools und Services im Cluster und bietet einen zentralen Zugangspunkt zur Verwaltung von ML-Aktivitäten. Das Dashboard ermöglicht unter anderem Benutzerauthentifizierung, Multi-User-Isolation und Ressourcenmanagement.

Kubeflow integriert Jupyter Notebooks und bietet eine interaktive Umgebung für Datenexploration, Experimente und Modellentwicklung. Notebooks unterstützen verschiedene Programmiersprachen und ermöglichen es Nutzern, ML-Workflows gemeinsam zu erstellen und auszuführen.

Kubeflow Metadata ist ein zentrales Repository zur Nachverfolgung und Verwaltung von Metadaten, die mit ML-Experimenten, Abläufen und Artefakten verbunden sind. Es sorgt für Reproduzierbarkeit, Zusammenarbeit und Governance in ML-Projekten, indem es eine einheitliche Sicht auf ML-Metadaten bietet.

Katib ist eine Komponente für automatisiertes maschinelles Lernen (AutoML) innerhalb von Kubeflow. Sie unterstützt Hyperparameter-Optimierung, Early Stopping und Neural Architecture Search und optimiert die Leistung von ML-Modellen, indem die Suche nach optimalen Hyperparametern automatisiert wird.

Kubeflow wird von Unternehmen verschiedenster Branchen eingesetzt, um ihre ML-Abläufe zu optimieren. Typische Anwendungsfälle sind:

Spotify setzt Kubeflow ein, um seinen Data Scientists und Ingenieuren die Entwicklung und Bereitstellung von ML-Modellen im großen Maßstab zu ermöglichen. Durch die Integration von Kubeflow in die bestehende Infrastruktur hat Spotify seine ML-Workflows optimiert, die Markteinführungszeit neuer Funktionen verkürzt und die Effizienz seiner Empfehlungssysteme verbessert.

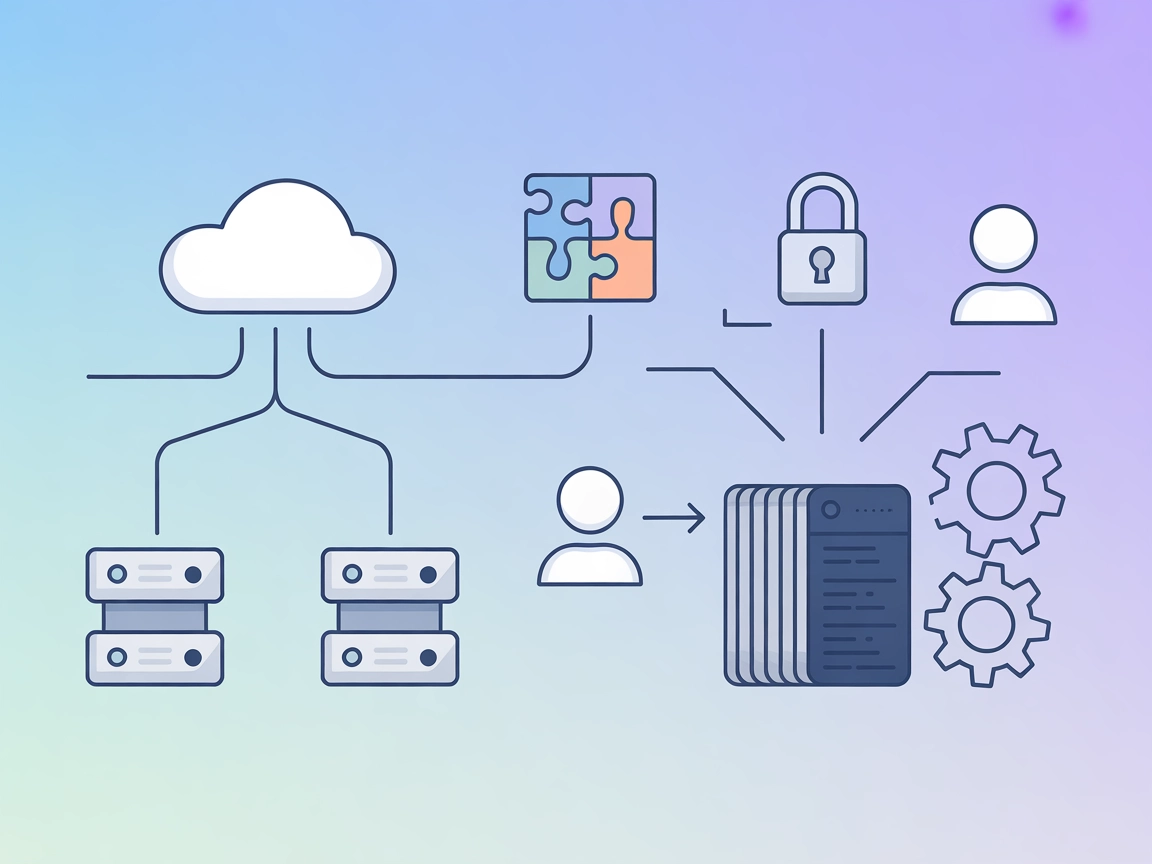

Mit Kubeflow können Unternehmen ihre ML-Workflows bedarfsgerecht skalieren und über verschiedene Infrastrukturen hinweg bereitstellen – einschließlich On-Premises, Cloud und hybriden Umgebungen. Diese Flexibilität hilft, Vendor-Lock-in zu vermeiden, und ermöglicht nahtlose Wechsel zwischen verschiedenen Rechenumgebungen.

Die komponentenbasierte Architektur von Kubeflow erleichtert die Reproduktion von Experimenten und Modellen. Es stehen Tools zur Versionierung und Nachverfolgung von Datensätzen, Code und Modellparametern zur Verfügung, was Konsistenz und Zusammenarbeit zwischen Data Scientists sicherstellt.

Kubeflow ist so konzipiert, dass es erweiterbar ist und die Integration mit diversen anderen Tools und Diensten, einschließlich cloud-basierter ML-Plattformen, ermöglicht. Unternehmen können Kubeflow mit zusätzlichen Komponenten anpassen und bestehende Tools und Workflows nutzen, um ihr ML-Ökosystem zu erweitern.

Durch die Automatisierung vieler Aufgaben rund um die Bereitstellung und Verwaltung von ML-Workflows entlastet Kubeflow Data Scientists und Ingenieure, sodass sie sich auf wertschöpfende Tätigkeiten wie Modellentwicklung und -optimierung konzentrieren können. Das führt zu Produktivitäts- und Effizienzgewinnen.

Dank der Integration mit Kubernetes ermöglicht Kubeflow eine effizientere Nutzung von Ressourcen, optimiert die Hardwareauslastung und senkt die Kosten für den Betrieb von ML-Workloads.

Um Kubeflow zu nutzen, kann es auf einem Kubernetes-Cluster – entweder lokal oder in der Cloud – installiert werden. Es stehen verschiedene Installationsanleitungen zur Verfügung, die sich an unterschiedliche Erfahrungsstufen und Infrastruktur-Anforderungen richten. Für Einsteiger in Kubernetes bieten Managed Services wie Vertex AI Pipelines einen einfachen Einstieg, da sie das Infrastrukturmanagement übernehmen und die Nutzer sich auf die Entwicklung und den Betrieb von ML-Workflows konzentrieren können.

Diese ausführliche Betrachtung von Kubeflow gibt einen Einblick in die Funktionalitäten, Vorteile und Anwendungsfälle und bietet Unternehmen eine umfassende Grundlage zur Verbesserung ihrer Fähigkeiten im Bereich maschinelles Lernen.

Kubeflow ist ein Open-Source-Projekt, das die Bereitstellung, Orchestrierung und Verwaltung von Modellen für maschinelles Lernen auf Kubernetes erleichtern soll. Es bietet einen umfassenden End-to-End-Stack für ML-Workflows und ermöglicht es Data Scientists und Ingenieuren, skalierbare Modelle für maschinelles Lernen einfacher zu entwickeln, bereitzustellen und zu verwalten.

Deployment von ML-Modellen mit Kubeflow auf verschiedenen Cloud-Anbietern

Autoren: Aditya Pandey et al. (2022)

Diese Arbeit untersucht die Bereitstellung von ML-Modellen mit Kubeflow auf verschiedenen Cloud-Plattformen. Die Studie bietet Einblicke in den Einrichtungsprozess, Bereitstellungsmodelle und Leistungskennzahlen von Kubeflow und dient als hilfreicher Leitfaden für Einsteiger. Die Autoren heben die Funktionen und Grenzen des Tools hervor und zeigen dessen Einsatz zur Erstellung durchgängiger ML-Pipelines. Das Papier soll Nutzern mit wenig Kubernetes-Erfahrung den Einsatz von Kubeflow für Modellbereitstellung erleichtern.

Mehr erfahren

CLAIMED, eine visuelle und skalierbare Komponentenbibliothek für Trusted AI

Autoren: Romeo Kienzler und Ivan Nesic (2021)

Diese Arbeit konzentriert sich auf die Integration vertrauenswürdiger KI-Komponenten mit Kubeflow. Sie adressiert Aspekte wie Erklärbarkeit, Robustheit und Fairness bei KI-Modellen. Das Papier stellt CLAIMED vor, ein wiederverwendbares Komponenten-Framework, das Tools wie AI Explainability360 und AI Fairness360 in Kubeflow-Pipelines integriert. Diese Integration erleichtert die Entwicklung produktionsreifer ML-Anwendungen mit visuellen Editoren wie ElyraAI.

Mehr erfahren

Jet-Energie-Kalibrierung mit Deep Learning als Kubeflow-Pipeline

Autoren: Daniel Holmberg et al. (2023)

Kubeflow wird genutzt, um eine ML-Pipeline zur Kalibrierung von Jet-Energie-Messungen beim CMS-Experiment zu erstellen. Die Autoren verwenden Deep-Learning-Modelle zur Verbesserung der Jet-Kalibrierung und zeigen, wie sich die Fähigkeiten von Kubeflow auf Anwendungen in der Hochenergiephysik übertragen lassen. Das Papier diskutiert die Effektivität der Pipeline bei der Skalierung von Hyperparameter-Optimierungen und dem effizienten Bereitstellen von Modellen in der Cloud.

Mehr erfahren

Kubeflow ist eine Open-Source-Plattform auf Basis von Kubernetes, die entwickelt wurde, um die Bereitstellung, Verwaltung und Skalierung von Workflows für maschinelles Lernen zu vereinfachen. Sie bietet eine umfassende Tool-Suite für den gesamten ML-Lebenszyklus.

Wichtige Komponenten sind Kubeflow Pipelines zur Workflow-Orchestrierung, ein zentrales Dashboard, Integration von Jupyter Notebooks, verteiltes Modelltraining und -bereitstellung, Metadatenverwaltung sowie Katib für Hyperparameter-Optimierung.

Durch die Nutzung von Kubernetes ermöglicht Kubeflow skalierbare ML-Workloads in verschiedenen Umgebungen und stellt Tools für Experiment-Tracking und die Wiederverwendung von Komponenten bereit, was Reproduzierbarkeit und effiziente Zusammenarbeit sicherstellt.

Unternehmen verschiedenster Branchen setzen Kubeflow zur Verwaltung und Skalierung ihrer ML-Aktivitäten ein. Bekannte Nutzer wie Spotify haben Kubeflow integriert, um die Modellentwicklung und -bereitstellung zu optimieren.

Um zu starten, deployen Sie Kubeflow auf einem Kubernetes-Cluster – entweder vor Ort oder in der Cloud. Installationsanleitungen und Managed Services erleichtern Anwendern aller Erfahrungsstufen den Einstieg.

Entdecken Sie, wie Kubeflow Ihre Workflows für maschinelles Lernen auf Kubernetes vereinfachen kann – von skalierbarem Training bis hin zu automatisierter Bereitstellung.

Integrieren Sie FlowHunt mit dem Metoro MCP Server, um KI-Agenten mit Echtzeit-Kubernetes-Observability auszustatten. Nutzen Sie eBPF-basierte Telemetrie, Model...

MLflow ist eine Open-Source-Plattform, die entwickelt wurde, um den Lebenszyklus des maschinellen Lernens (ML) zu optimieren und zu verwalten. Sie bietet Werkze...

Integrieren Sie FlowHunt mit dem KubeSphere MCP Server, um das Kubernetes-Ressourcenmanagement zu automatisieren, die Cluster-Operationen zu optimieren und DevO...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.