Instruction Tuning

Instruction Tuning ist eine Technik in der KI, bei der große Sprachmodelle (LLMs) anhand von Anweisungs-Antwort-Paaren feinabgestimmt werden, um deren Fähigkeit...

Parameter-Efficient Fine-Tuning (PEFT) passt große KI-Modelle an neue Aufgaben an, indem nur ein kleiner Teil der Parameter feinabgestimmt wird, was eine effiziente, skalierbare und kostengünstige Bereitstellung ermöglicht.

Parameter-Efficient Fine-Tuning (PEFT) ist ein innovativer Ansatz in der künstlichen Intelligenz (KI) und der Verarbeitung natürlicher Sprache (NLP), der es ermöglicht, große vortrainierte Modelle auf spezifische Aufgaben anzupassen, indem nur ein kleiner Teil ihrer Parameter aktualisiert wird. Anstatt das gesamte Modell neu zu trainieren, was rechenintensiv und ressourcenaufwändig sein kann, konzentriert sich PEFT auf die Feinabstimmung ausgewählter Parameter oder das Hinzufügen leichter Module zur Modellarchitektur. Diese Methode senkt die Rechenkosten, reduziert die Trainingszeit und den Speicherbedarf erheblich und macht es möglich, große Sprachmodelle (LLMs) in einer Vielzahl spezialisierter Anwendungen einzusetzen.

Da KI-Modelle immer größer und komplexer werden, wird der traditionelle Fine-Tuning-Ansatz zunehmend unpraktisch. PEFT begegnet diesen Herausforderungen durch:

PEFT umfasst mehrere Techniken, die das effiziente Aktualisieren oder Erweitern vortrainierter Modelle ermöglichen. Nachfolgend sind einige der wichtigsten Methoden aufgeführt:

Überblick:

Implementierung:

W_down).W_up).Vorteile:

Anwendungsbeispiel:

Überblick:

Mathematische Grundlage:

ΔW = A × B^TA und B sind niedrig-rangige Matrizen.r, der Rang, wird so gewählt, dass r << d, wobei d die ursprüngliche Dimensionalität ist.Vorteile:

Zu beachten:

Anwendungsbeispiel:

Überblick:

Mechanismus:

Vorteile:

Anwendungsbeispiel:

Überblick:

Mechanismus:

Vorteile:

Anwendungsbeispiel:

Überblick:

Mechanismus:

Vorteile:

Anwendungsbeispiel:

Überblick:

Vorteile:

Anwendungsbeispiel:

| Aspekt | Traditionelles Fine-Tuning | Parameter-Efficient Fine-Tuning |

|---|---|---|

| Parameter-Aktualisierung | Alle Parameter (Millionen/Milliarden) | Kleiner Teil (oft <1%) |

| Rechenaufwand | Hoch (benötigt viele Ressourcen) | Gering bis moderat |

| Trainingszeit | Länger | Kürzer |

| Speicherbedarf | Hoch | Reduziert |

| Überanpassungsrisiko | Höher (besonders bei wenig Daten) | Geringer |

| Modellgröße bei Bereitstellung | Groß | Kleiner (durch zusätzliche leichte Module) |

| Bewahrung des vortrainierten Wissens | Kann abnehmen (katastrophales Vergessen) | Besser erhalten |

Szenario:

Vorgehen:

Ergebnis:

Szenario:

Vorgehen:

Ergebnis:

Szenario:

Vorgehen:

Ergebnis:

Szenario:

Vorgehen:

Ergebnis:

Szenario:

Vorgehen:

Ergebnis:

Können PEFT-Methoden auf jedes Modell angewendet werden?

Obwohl sie hauptsächlich für transformerbasierte Modelle entwickelt wurden, lassen sich einige PEFT-Methoden mit Anpassungen auch auf andere Architekturen übertragen.

Erreichen PEFT-Methoden immer die Leistung von vollem Fine-Tuning?

PEFT erzielt oft vergleichbare Ergebnisse, aber bei hochspezialisierten Aufgaben kann volles Fine-Tuning leichte Vorteile bringen.

Wie wähle ich die richtige PEFT-Methode aus?

Berücksichtigen Sie die Anforderungen der Aufgabe, die verfügbaren Ressourcen und bisherige Erfolge bei ähnlichen Aufgaben.

Eignet sich PEFT für großflächige Bereitstellungen?

Ja, die Effizienz von PEFT macht es ideal, um Modelle über verschiedene Aufgaben und Domänen hinweg zu skalieren.

Forschung zu Parameter-Efficient Fine-Tuning

Aktuelle Fortschritte in parameter-effizienten Fine-Tuning-Techniken wurden in verschiedenen wissenschaftlichen Studien untersucht und beleuchten innovative Methoden zur Verbesserung des KI-Modelltrainings. Im Folgenden finden Sie Zusammenfassungen wichtiger Forschungsartikel, die zu diesem Bereich beitragen:

Keeping LLMs Aligned After Fine-tuning: The Crucial Role of Prompt Templates (Veröffentlicht: 2024-02-28)

Autoren: Kaifeng Lyu, Haoyu Zhao, Xinran Gu, Dingli Yu, Anirudh Goyal, Sanjeev Arora

Diese Arbeit untersucht die Sicherheit der Ausrichtung großer Sprachmodelle (LLMs) nach dem Fine-Tuning. Die Autoren weisen darauf hin, dass selbst harmloses Fine-Tuning zu unsicheren Verhaltensweisen führen kann. Durch Experimente mit Chat-Modellen wie Llama 2-Chat und GPT-3.5 Turbo zeigt die Studie die Wichtigkeit von Prompt-Vorlagen für die Aufrechterhaltung der Sicherheit. Sie schlagen das Prinzip „Pure Tuning, Safe Testing“ vor, bei dem das Fine-Tuning ohne Sicherheits-Prompts, aber die Tests mit solchen erfolgen, um Risiken zu minimieren. Die Ergebnisse zeigen deutliche Reduktionen unsicherer Verhaltensweisen und unterstreichen die Wirksamkeit dieses Ansatzes. Mehr erfahren

Tencent AI Lab – Shanghai Jiao Tong University Low-Resource Translation System for the WMT22 Translation Task (Veröffentlicht: 2022-10-17)

Autoren: Zhiwei He, Xing Wang, Zhaopeng Tu, Shuming Shi, Rui Wang

Diese Studie beschreibt die Entwicklung eines Übersetzungssystems für die WMT22-Aufgabe Englisch-Livisch für ressourcenarme Sprachen. Das System nutzt M2M100 mit innovativen Techniken wie Cross-Model-Word-Embedding-Ausrichtung und schrittweiser Anpassungsstrategie. Die Forschung zeigt deutliche Verbesserungen in der Übersetzungsgenauigkeit und adressiert frühere Fehleinschätzungen durch Inkonsistenzen in der Unicode-Normalisierung. Fine-Tuning mit Validierungssets und Online-Back-Translation steigern die Leistung weiter und führen zu hohen BLEU-Scores. Mehr erfahren

Towards Being Parameter-Efficient: A Stratified Sparsely Activated Transformer with Dynamic Capacity (Veröffentlicht: 2023-10-22)

Autoren: Haoran Xu, Maha Elbayad, Kenton Murray, Jean Maillard, Vedanuj Goswami

Die Arbeit befasst sich mit der Parameterineffizienz in Mixture-of-Experts-(MoE)-Modellen, die mit sparsamer Aktivierung arbeiten. Die Autoren schlagen Stratified Mixture of Experts (SMoE) Modelle vor, die unterschiedlichen Tokens dynamisch Kapazität zuweisen und so die Parameter-Effizienz steigern. Ihr Ansatz zeigt eine verbesserte Leistung bei mehrsprachigen maschinellen Übersetzungsbenchmarks und demonstriert das Potenzial für effizienteres Modelltraining mit reduziertem Rechenaufwand. Mehr erfahren

PEFT ist eine Sammlung von Techniken, die es ermöglichen, große vortrainierte KI-Modelle an spezifische Aufgaben anzupassen, indem nur ein kleiner Teil ihrer Parameter aktualisiert wird, anstatt das gesamte Modell neu zu trainieren. Das führt zu geringeren Rechen- und Ressourcenanforderungen.

PEFT senkt die Rechen- und Speicherkosten, ermöglicht eine schnellere Bereitstellung, bewahrt das Wissen vortrainierter Modelle und erlaubt es Organisationen, große Modelle effizient für mehrere Aufgaben anzupassen, ohne umfangreiche Ressourcen einzusetzen.

Beliebte PEFT-Methoden sind Adapter, Low-Rank Adaptation (LoRA), Prefix Tuning, Prompt Tuning, P-Tuning und BitFit. Jede Methode aktualisiert unterschiedliche Modellkomponenten, um eine effiziente Anpassung zu erreichen.

Beim traditionellen Fine-Tuning werden alle Modellparameter aktualisiert, was ressourcenintensiv ist. PEFT hingegen aktualisiert nur einen kleinen Teil, bietet geringere Rechenkosten, schnelleres Training, geringeres Überanpassungsrisiko und kleinere Bereitstellungsgrößen.

PEFT wird eingesetzt für spezialisierte Sprachverarbeitung (z. B. im Gesundheitswesen), mehrsprachige Modelle, Few-Shot-Learning, Bereitstellung auf Edge-Geräten und die schnelle Entwicklung neuer KI-Lösungen.

PEFT-Methoden sind in erster Linie für transformerbasierte Architekturen konzipiert, können aber mit entsprechenden Anpassungen auch für andere Modelltypen verwendet werden.

PEFT erzielt in der Regel vergleichbare Leistungen, insbesondere bei vielen praktischen Aufgaben. Volles Fine-Tuning kann jedoch bei sehr spezialisierten Anwendungsfällen leichte Verbesserungen bringen.

Die Auswahl hängt von der spezifischen Aufgabe, der Modellarchitektur, den verfügbaren Ressourcen und dem bisherigen Erfolg von PEFT-Techniken bei ähnlichen Problemen ab.

Beginnen Sie mit FlowHunt, intelligente Chatbots und KI-Tools zu erstellen – ganz ohne Programmierkenntnisse. Verbinden Sie intuitive Bausteine und automatisieren Sie Ihre Ideen noch heute.

Instruction Tuning ist eine Technik in der KI, bei der große Sprachmodelle (LLMs) anhand von Anweisungs-Antwort-Paaren feinabgestimmt werden, um deren Fähigkeit...

Die Feinabstimmung von Modellen passt vortrainierte Modelle für neue Aufgaben durch kleinere Anpassungen an und reduziert so den Bedarf an Daten und Ressourcen....

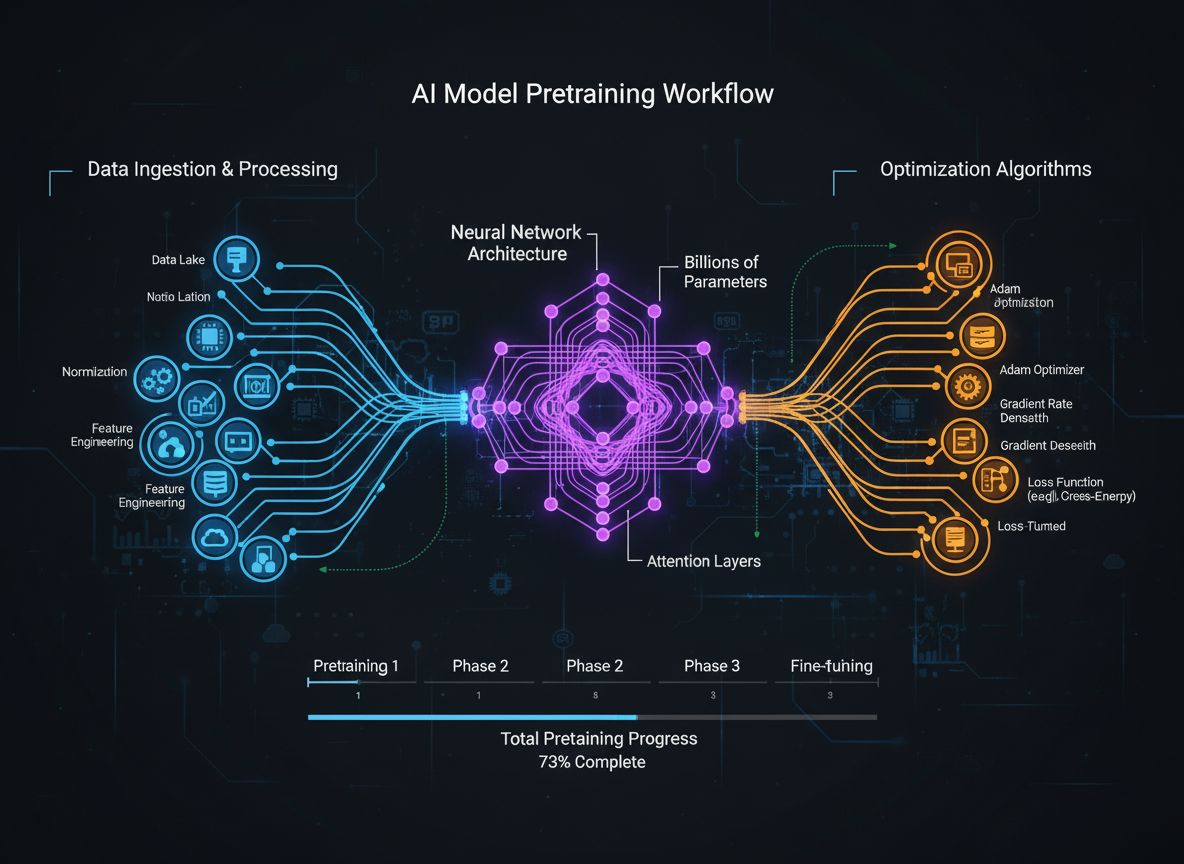

Ein umfassender Leitfaden zu modernen Pretraining-Strategien für Sprachmodelle, Methoden zur Datenkuratierung und Optimierungsverfahren, die von HuggingFace zur...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.