AllenNLP

AllenNLP ist eine robuste Open-Source-Bibliothek für NLP-Forschung, entwickelt von AI2 auf PyTorch. Sie bietet modulare, erweiterbare Werkzeuge, vortrainierte M...

Torch ist eine Open-Source-Machine-Learning-Bibliothek auf Lua-Basis, die umfassende Werkzeuge für neuronale Netze und Deep Learning bietet und den Weg für PyTorch ebnete.

Torch ist eine Open-Source-Machine-Learning-Bibliothek, ein wissenschaftliches Computing-Framework und eine Skriptsprache auf Basis von Lua, die speziell für Deep-Learning- und KI-Aufgaben optimiert wurde. Ursprünglich 2002 vom Idiap Research Institute an der EPFL entwickelt, stellt Torch eine umfassende Suite an Werkzeugen zum Aufbau und Training komplexer neuronaler Netze bereit. Sie war ein Vorläufer der PyTorch-Bibliothek, die mittlerweile in der Machine-Learning-Community größere Bedeutung erlangt hat. Trotz ihres frühen Einflusses und ihrer Fähigkeiten begrenzte die Abhängigkeit von Torch zu Lua, einer im Vergleich zu Python weniger verbreiteten Programmiersprache, die breite Akzeptanz.

N-dimensionale Arrays (Tensoren):

Torch basiert auf dem Konzept der Tensoren, mehrdimensionalen Arrays ähnlich den NumPy-Arrays. Diese Tensoren sind grundlegend für diverse mathematische Operationen im Machine Learning und wissenschaftlichen Rechnen. Sie ermöglichen effiziente numerische Berechnungen und unterstützen Operationen auf CPUs und GPUs durch optimierte Bibliotheken wie CUDA.

Automatische Differenzierung:

Ein zentrales Merkmal von Torch, das eine effiziente Berechnung von Gradienten ermöglicht – entscheidend für das Training tiefer neuronaler Netze. Die automatische Differenzierung von Torch ist über eine Modul-Schnittstelle implementiert und erlaubt die Berechnung von Gradienten erster Ordnung. Diese Fähigkeit vereinfacht das Training komplexer Modelle, indem sie die Ableitungsberechnung automatisiert.

Module für tiefe neuronale Netze:

Das nn-Paket von Torch ermöglicht den modularen Aufbau neuronaler Netze. Es unterstützt unter anderem Feedforward-, Convolutional- und Recurrent-Netze und enthält Module für Aktivierungsfunktionen, Verlustfunktionen und Optimierer. Dieses modulare Design erleichtert die Erstellung und Erprobung verschiedener Netzwerkarchitekturen.

GPU-Beschleunigung:

Torch nutzt GPU-Beschleunigung, um Berechnungen effizient durchzuführen, und ist somit ideal für groß angelegte Machine-Learning-Aufgaben geeignet. Die Integration mit CUDA ermöglicht deutliche Leistungssteigerungen und erlaubt es Forschern, komplexe Modelle schneller und effektiver zu trainieren.

Deep-Learning-Forschung:

Torch wurde umfassend in der akademischen und industriellen Forschung eingesetzt, insbesondere bei der Entwicklung neuer Deep-Learning-Algorithmen. Seine Flexibilität und Geschwindigkeit machen es ideal für die Prototypisierung komplexer Modelle. Forscher haben Torch genutzt, um mit neuartigen Architekturen und Lernalgorithmen zu experimentieren.

Computer Vision:

Torch bietet Werkzeuge für Bildverarbeitung und Computer-Vision-Anwendungen wie Objekterkennung und Bildklassifikation. Die Fähigkeit, große Datensätze zu verarbeiten und Echtzeit-Analysen durchzuführen, macht Torch zu einem wertvollen Werkzeug in der visuellen Datenanalyse.

Natural Language Processing (NLP):

Die Bibliothek unterstützt die Entwicklung von NLP-Modellen, darunter rekurrente neuronale Netze und Sprachmodelle, die für Aufgaben wie maschinelle Übersetzung und Sentiment-Analyse essenziell sind. Die dynamischen Rechenfähigkeiten von Torch ermöglichen eine effektive Verarbeitung sequentieller Daten und variabler Eingabelängen.

Reinforcement Learning:

Torch wird im Reinforcement Learning eingesetzt, um Modelle zu entwickeln, die durch Versuch und Irrtum optimale Aktionen erlernen – nützlich etwa in der Robotik und bei KI in Spielen. Die Fähigkeit, komplexe Umgebungen und Prozesse zu handhaben, unterstützt die Entwicklung intelligenter, adaptiver Systeme.

Aufbau neuronaler Netze:

Das nn-Paket in Torch erlaubt es, neuronale Netze über eine High-Level-Schnittstelle zu bauen. Zum Beispiel kann ein einfaches Mehrschicht-Perzeptron mit wenigen Codezeilen erstellt werden, indem Schichten und Aktivierungsfunktionen nahtlos definiert werden.

local nn = require 'nn'

local model = nn.Sequential()

model:add(nn.Linear(10, 25))

model:add(nn.Tanh())

model:add(nn.Linear(25, 1))

Computer Vision mit Torch:

Facebook AI Research hat Torch für verschiedene Computer-Vision-Projekte genutzt und dabei auf die leistungsfähigen Möglichkeiten zur effizienten Verarbeitung großer Datensätze gesetzt. Die GPU-Fähigkeiten von Torch ermöglichen Echtzeit-Bildverarbeitung und machen die Bibliothek zur bevorzugten Wahl für High-Performance-Vision-Aufgaben.

NLP-Modelle:

Die Unterstützung dynamischer neuronaler Netze macht Torch ideal für die Entwicklung fortschrittlicher NLP-Modelle, die Flexibilität bei der Verarbeitung von Textsequenzen benötigen. Die Fähigkeit, variable Eingabegrößen und dynamische Datentypen zu verarbeiten, ist zentral für anspruchsvolle Sprachverarbeitungsanwendungen.

Die Entwicklung von Torch ist weitgehend auf PyTorch übergegangen, eine Bibliothek, die die Kernfunktionen von Torch beibehält, aber auf der Popularität und Benutzerfreundlichkeit von Python aufbaut. PyTorch bietet eine intuitivere Schnittstelle und eine bessere Integration in das Python-Ökosystem, was es zur bevorzugten Wahl für moderne Machine-Learning-Praktiker macht. Der dynamische Rechengraph und die High-Level-API von PyTorch haben es zum Standard im Bereich gemacht und erleichtern die schnelle Entwicklung und den Einsatz von Deep-Learning-Modellen.

Torch und sein Nachfolger PyTorch sind maßgeblich bei der Entwicklung von KI-Anwendungen, darunter Chatbots. Die Fähigkeit, große Datenmengen dynamisch zu verarbeiten und daraus zu lernen, ist entscheidend für die Entwicklung intelligenter Systeme, die Benutzereingaben effektiv verstehen und beantworten können. Mit den Fortschritten im Bereich NLP und Deep Learning bleibt PyTorch ein zentrales Werkzeug zur Steigerung der Intelligenz und Effizienz von Chatbot-Systemen.

Die Torch-Bibliothek ist eine beliebte Machine-Learning-Bibliothek, die häufig zur Implementierung von Deep-Learning-Modellen verwendet wird. Nachfolgend eine Zusammenfassung wichtiger Forschungsarbeiten zur Torch-Bibliothek und ihren Anwendungen:

Torch-Struct: Deep Structured Prediction Library

Veröffentlicht 2020 von Alexander M. Rush, stellt diese Arbeit Torch-Struct vor, eine Bibliothek für strukturierte Vorhersagen im Deep-Learning-Framework. Sie integriert sich in vektorisierte, auf automatischer Differenzierung basierende Frameworks und bietet eine breite Sammlung probabilistischer Strukturen. Ziel der Bibliothek ist es, durch gebündelte, vektorisierte Operationen effizienten, testbaren und schnellen Code bereitzustellen. Die Experimente zeigen erhebliche Leistungssteigerungen gegenüber schnellen Baselines. Weitere Details finden Sie im Paper hier

.

rnn für sequentielle Aufgaben wie NLP, Spracherkennung und Zeitreihenprognose. Jetzt entdecken!"): Recurrent Library for Torch

Verfasst 2015 von Nicholas Léonard und anderen, behandelt diese Arbeit das rnn-Paket, das Komponenten für eine Vielzahl rekurrenter neuronaler Netze im Torch-Framework bereitstellt. Das Paket legt Wert auf umfassende Komponententests und Rückwärtskompatibilität. Es hat sich in drei Iterationen weiterentwickelt und seine Flexibilität sowie Leistungsfähigkeit gesteigert. Die Arbeit vergleicht das rnn-Paket mit bestehenden Implementierungen und gibt Einblicke in dessen Entwicklung und Einsatz.

cltorch: ein hardwareunabhängiges Backend für die Torch Deep Neural Network Library auf Basis von OpenCL

Verfasst von Hugh Perkins im Jahr 2016, stellt diese Arbeit cltorch vor, das das Training tiefer neuronaler Netze auf GPUs verschiedener Hersteller mit OpenCL ermöglicht. cltorch kann Modelle wie AlexNet und GoogleNet ausführen und konzentriert sich auf die Beschleunigung von Convolutional-Layern für bessere hardwareunabhängige Leistung. Die Arbeit diskutiert zudem technische Herausforderungen und Lösungen für eine schnelle Implementierung.

cito: Ein R-Paket zum Trainieren neuronaler Netze mit torch

Veröffentlicht 2024 von Christian Amesoeder und Kollegen, stellt diese Arbeit „cito“ vor, ein R-Paket, das die Spezifikation tiefer neuronaler Netze mit der aus R-Paketen vertrauten Formelsyntax vereinfacht. Es nutzt die Torch-Bibliothek für numerische Optimierung und möchte Deep Learning insbesondere im Bereich der Ökologie für R-Nutzer zugänglicher machen.

Torch ist eine Open-Source-Machine-Learning-Bibliothek und ein wissenschaftliches Computing-Framework auf Basis von Lua, optimiert für Deep Learning und künstliche Intelligenz. Sie stellt Werkzeuge zum Aufbau und Training komplexer neuronaler Netze bereit und war ein Vorläufer von PyTorch.

Torch bietet N-dimensionale Tensor-Berechnungen, automatische Differenzierung, modulare Komponenten für neuronale Netze sowie GPU-Beschleunigung für leistungsstarke Deep-Learning-Aufgaben.

Torch basiert auf Lua und war ein frühes Deep-Learning-Framework, während PyTorch der auf Python basierende Nachfolger ist, der eine intuitivere API, dynamische Rechen-Graphen und eine weite Verbreitung in der Machine-Learning-Community bietet.

Torch wurde für Deep-Learning-Forschung, Computer Vision, Natural Language Processing und Reinforcement Learning eingesetzt, insbesondere vor dem Aufstieg von PyTorch.

Der Wechsel erfolgte, weil Python weiter verbreitet ist als Lua und PyTorch eine verbesserte Benutzerfreundlichkeit, Integration mit dem Python-Ökosystem und fortschrittliche Funktionen für moderne Deep-Learning-Workflows bietet.

Entdecken Sie, wie Torch und andere KI-Tools Ihre Deep-Learning- und Machine-Learning-Projekte voranbringen können. Probieren Sie die FlowHunt-Plattform aus, um Ihre eigenen KI-Lösungen zu erstellen.

AllenNLP ist eine robuste Open-Source-Bibliothek für NLP-Forschung, entwickelt von AI2 auf PyTorch. Sie bietet modulare, erweiterbare Werkzeuge, vortrainierte M...

PyTorch ist ein Open-Source-Framework für maschinelles Lernen, entwickelt von Meta AI, das für seine Flexibilität, dynamische Rechen-Graphen, GPU-Beschleunigung...

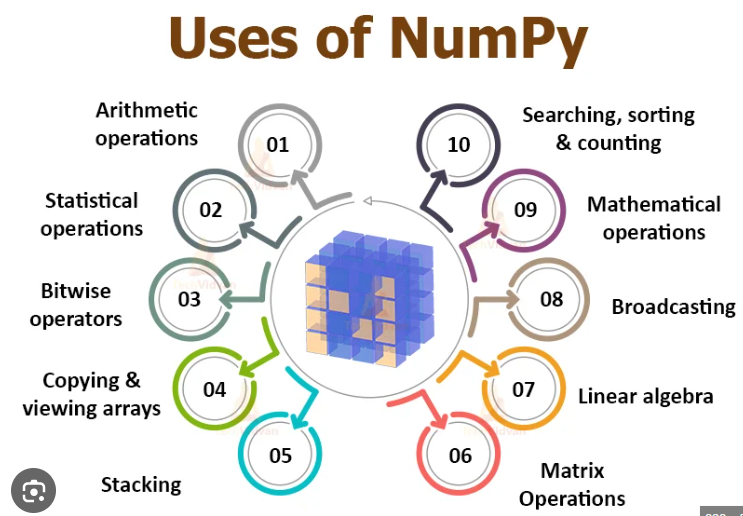

NumPy ist eine Open-Source-Python-Bibliothek, die für numerische Berechnungen unerlässlich ist und effiziente Array-Operationen und mathematische Funktionen ber...