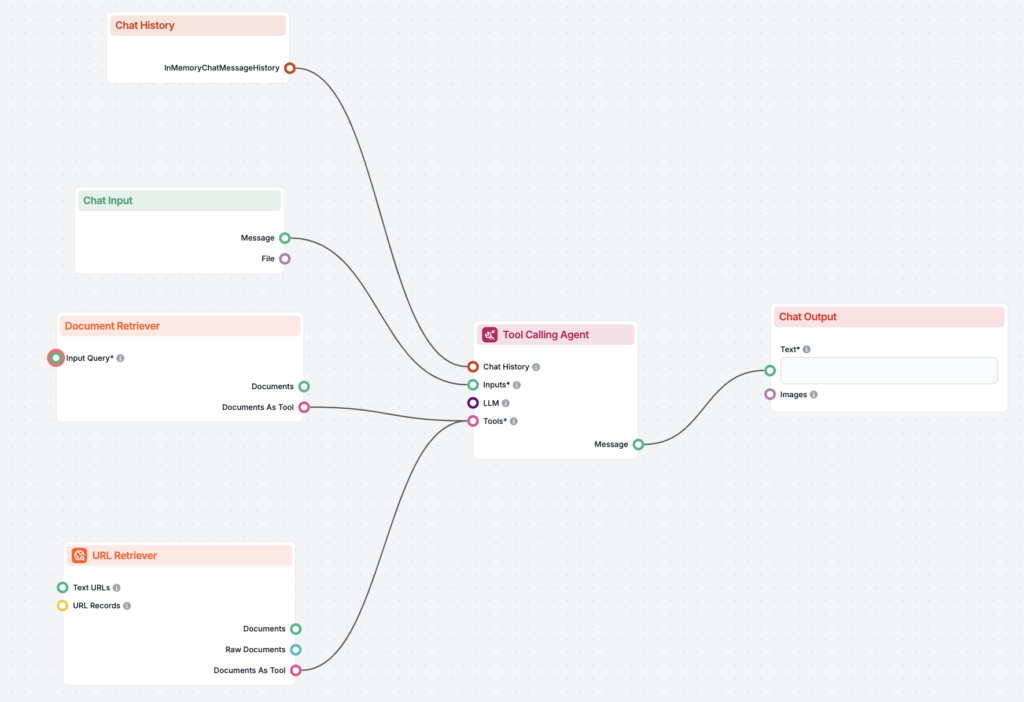

KI-OCR-Rechnungsdatenerfassung mit einem einfachen Python-Skript

Entdecken Sie eine skalierbare Python-Lösung zur Rechnungsdatenerfassung mit KI-basierter OCR. Lernen Sie, wie Sie PDFs konvertieren, Bilder zur FlowHunt-API ho...

Entdecken Sie eine skalierbare Python-Lösung zur Rechnungsdatenerfassung mit KI-basierter OCR. Lernen Sie, wie Sie PDFs konvertieren, Bilder zur FlowHunt-API ho...

KI-Projektmanagement in F&E bezeichnet die strategische Anwendung von Künstlicher Intelligenz (KI) und Machine Learning (ML)-Technologien zur Verbesserung des M...

Ein KI-Qualitätssicherungs-Spezialist stellt die Genauigkeit, Zuverlässigkeit und Leistung von KI-Systemen sicher, indem er Testpläne entwickelt, Tests durchfüh...

Erfahren Sie, was ein KI-SDR ist und wie künstliche intelligente Sales Development Representatives die Akquise, Lead-Qualifizierung, Ansprache und Nachverfolgun...

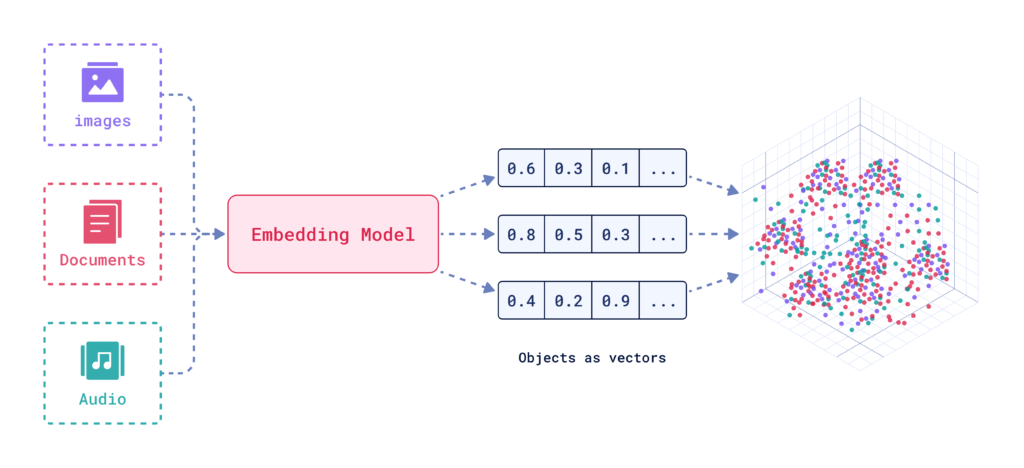

KI-Suche ist eine semantische oder vektorbasierte Suchmethode, die maschinelle Lernmodelle nutzt, um die Absicht und den kontextuellen Sinn hinter Suchanfragen ...

Entdecken Sie die Rolle eines KI-Systemingenieurs: Entwurf, Entwicklung und Wartung von KI-Systemen, Integration maschinellen Lernens, Verwaltung der Infrastruk...

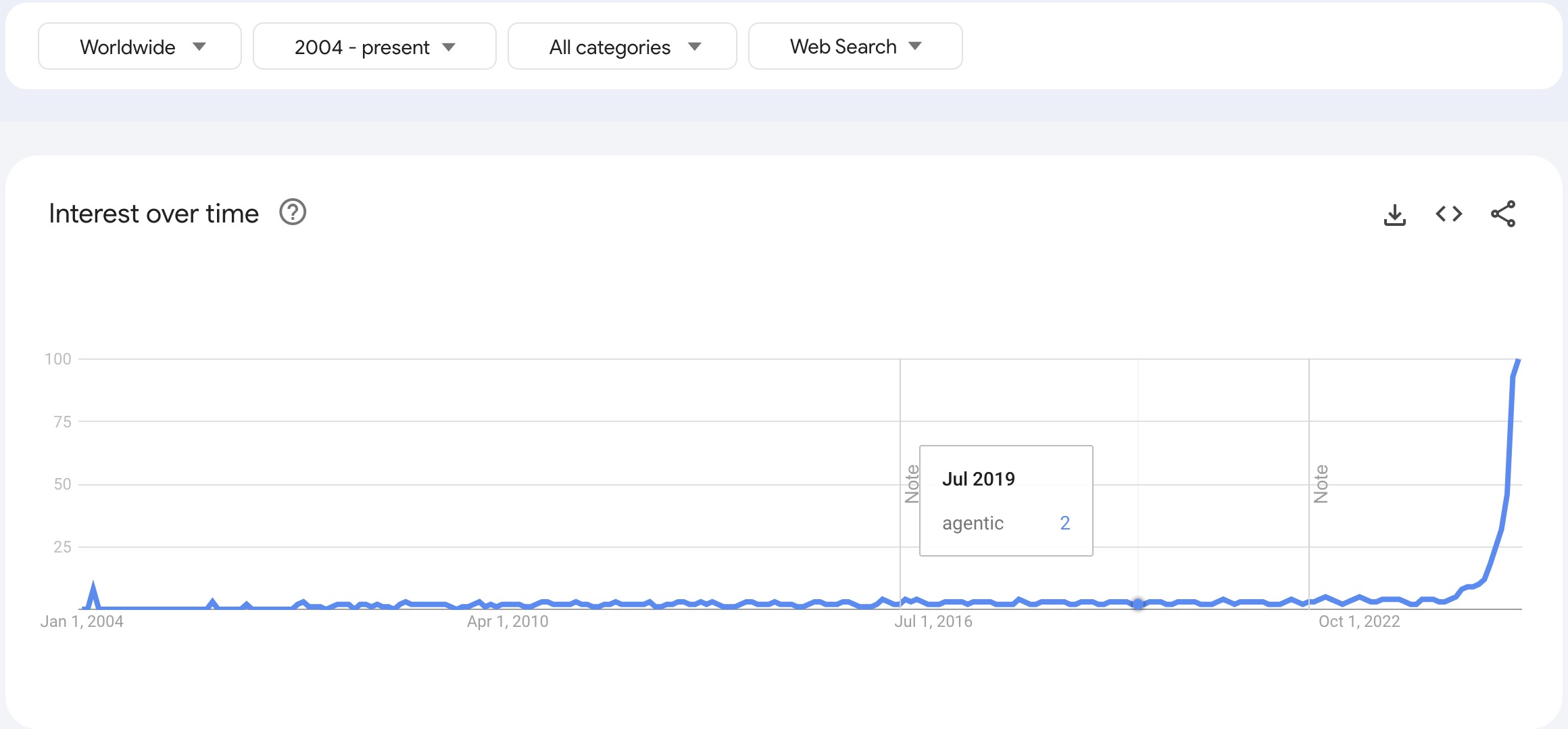

Entdecken Sie die wichtigsten KI-Trends für 2025, darunter den Aufstieg von KI-Agenten und KI-Teams, und erfahren Sie, wie diese Innovationen mit Automatisierun...

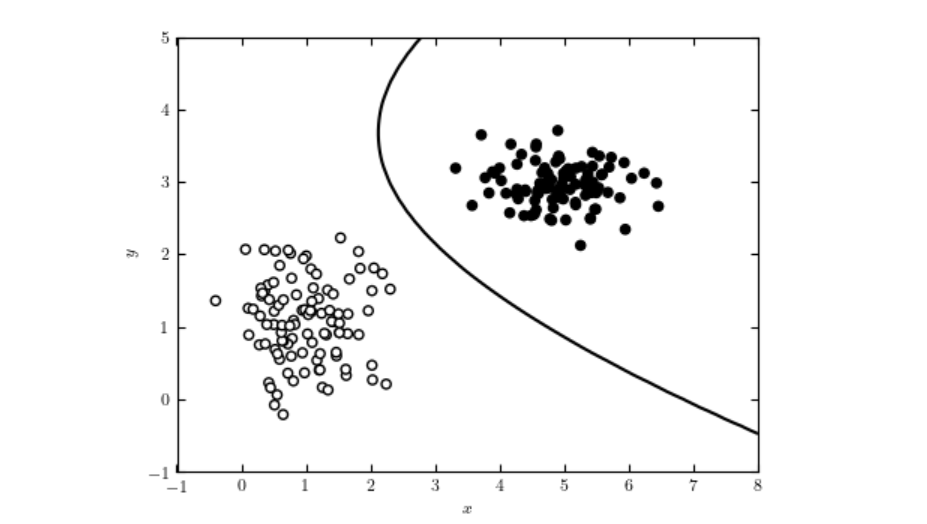

Ein KI-Klassifizierer ist ein Machine-Learning-Algorithmus, der Eingabedaten Klassenlabels zuweist und Informationen auf Basis von erlernten Mustern aus histori...

KNIME (Konstanz Information Miner) ist eine leistungsstarke Open-Source-Plattform für Datenanalysen, die visuelle Workflows, nahtlose Datenintegration, fortgesc...

Kognitives Computing stellt ein transformatives Technologiemodell dar, das menschliche Denkprozesse in komplexen Szenarien simuliert. Es integriert KI und Signa...

Eine Konfusionsmatrix ist ein Werkzeug im maschinellen Lernen zur Bewertung der Leistung von Klassifikationsmodellen. Sie stellt wahre/falsche Positive und Nega...

Konvergenz in der KI bezeichnet den Prozess, bei dem Maschinenlern- und Deep-Learning-Modelle durch iteratives Lernen einen stabilen Zustand erreichen, indem si...

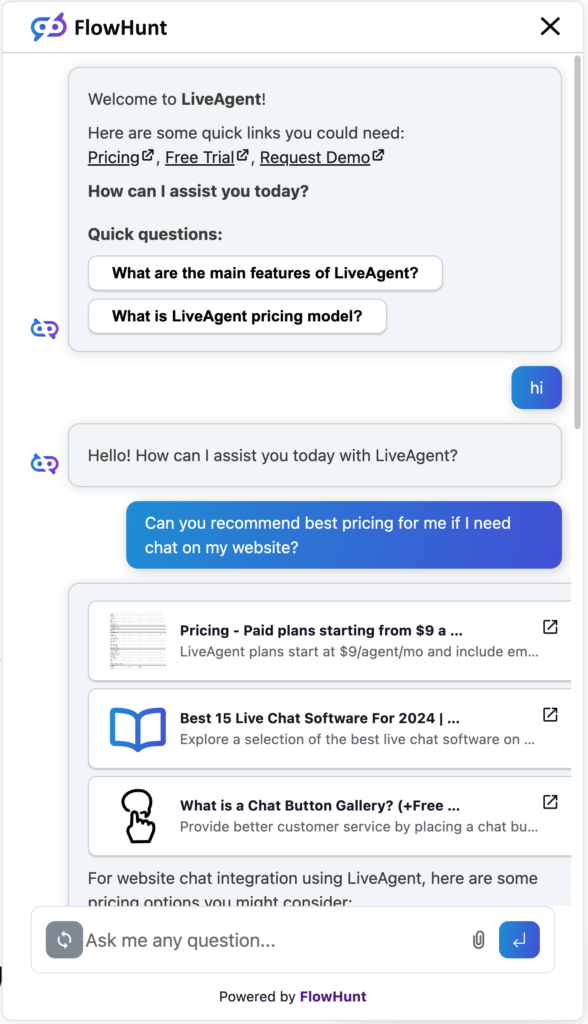

Konversationelle KI bezeichnet Technologien, die es Computern ermöglichen, menschliche Gespräche mithilfe von NLP, maschinellem Lernen und anderen Sprachtechnol...

Koreferenzauflösung ist eine grundlegende NLP-Aufgabe zur Identifizierung und Verknüpfung von Ausdrücken im Text, die sich auf dieselbe Entität beziehen – entsc...

Ein Korpus (Plural: Korpora) bezeichnet im Bereich der KI eine große, strukturierte Sammlung von Text- oder Audiodaten, die zum Trainieren und Evaluieren von KI...

Entdecken Sie die Kosten, die mit dem Training und der Bereitstellung von Large Language Models (LLMs) wie GPT-3 und GPT-4 verbunden sind, einschließlich Rechen...

Kreuzentropie ist ein zentrales Konzept sowohl in der Informationstheorie als auch im maschinellen Lernen und dient als Maß zur Bestimmung der Divergenz zwische...

Kreuzvalidierung ist eine statistische Methode zur Bewertung und zum Vergleich von Machine-Learning-Modellen, bei der Daten mehrfach in Trainings- und Validieru...

Kubeflow ist eine Open-Source-Plattform für maschinelles Lernen (ML) auf Kubernetes, die die Bereitstellung, Verwaltung und Skalierung von ML-Workflows vereinfa...

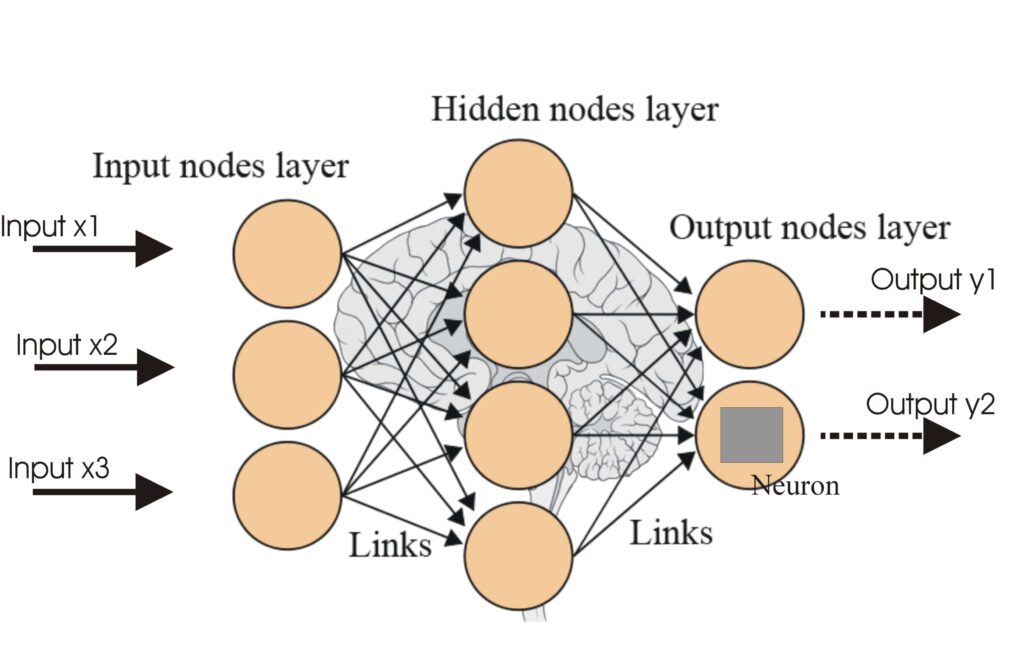

Künstliche Neuronale Netze (ANNs) sind eine Untergruppe von Machine-Learning-Algorithmen, die dem menschlichen Gehirn nachempfunden sind. Diese Rechenmodelle be...

Künstliche Superintelligenz (ASI) ist eine theoretische KI, die die menschliche Intelligenz in allen Bereichen übertrifft, mit selbstverbessernden, multimodalen...

Eine Lernkurve in der künstlichen Intelligenz ist eine grafische Darstellung, die die Beziehung zwischen der Lernleistung eines Modells und Variablen wie Datens...

LightGBM, oder Light Gradient Boosting Machine, ist ein fortschrittliches Gradient-Boosting-Framework, das von Microsoft entwickelt wurde. Es ist für leistungss...

Die lineare Regression ist eine grundlegende Analysetechnik in der Statistik und im maschinellen Lernen, die die Beziehung zwischen abhängigen und unabhängigen ...

Log Loss, oder logarithmischer/Cross-Entropy-Loss, ist eine wichtige Kennzahl zur Bewertung der Leistung von Machine-Learning-Modellen – insbesondere für binäre...

Die logistische Regression ist eine statistische und maschinelle Lernmethode zur Vorhersage binärer Ergebnisse aus Daten. Sie schätzt die Wahrscheinlichkeit, da...

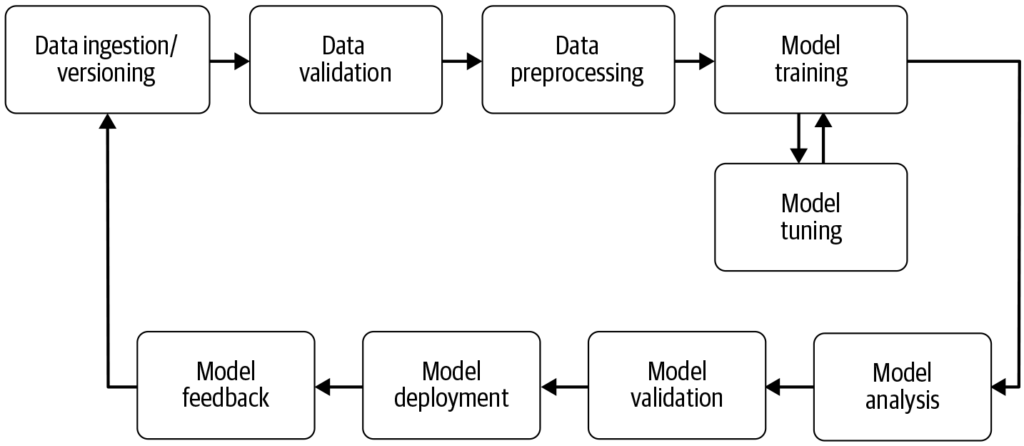

Eine Machine-Learning-Pipeline ist ein automatisierter Workflow, der die Entwicklung, das Training, die Evaluierung und den Einsatz von Machine-Learning-Modelle...

Maschinelles Lernen (ML) ist ein Teilgebiet der künstlichen Intelligenz (KI), das es Maschinen ermöglicht, aus Daten zu lernen, Muster zu erkennen, Vorhersagen ...

Erfahren Sie, wie 'Meinten Sie' (DYM) in der NLP Fehler in Benutzereingaben wie Tippfehler oder Rechtschreibfehler erkennt und korrigiert und Alternativen vorsc...

Human-in-the-Loop (HITL) ist ein Ansatz in der KI und dem maschinellen Lernen, bei dem menschliche Expertise in das Training, die Feinabstimmung und die Anwendu...

Die Merkmals-Extraktion wandelt Rohdaten in eine reduzierte Menge informativer Merkmale um und verbessert das maschinelle Lernen, indem sie Daten vereinfacht, d...

Entdecken Sie, wie KI das SEO revolutioniert, indem sie Keyword-Recherche, Content-Optimierung und Nutzerbindung automatisiert. Erkunden Sie zentrale Strategien...

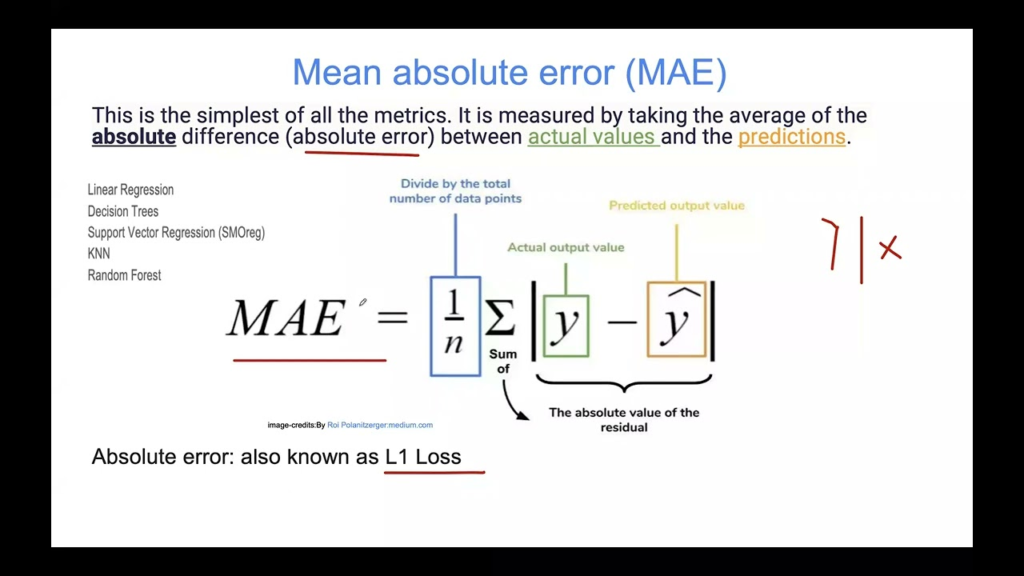

Der Mittlere Absolutfehler (MAE) ist eine grundlegende Kennzahl im maschinellen Lernen zur Bewertung von Regressionsmodellen. Er misst die durchschnittliche Grö...

MLflow ist eine Open-Source-Plattform, die entwickelt wurde, um den Lebenszyklus des maschinellen Lernens (ML) zu optimieren und zu verwalten. Sie bietet Werkze...

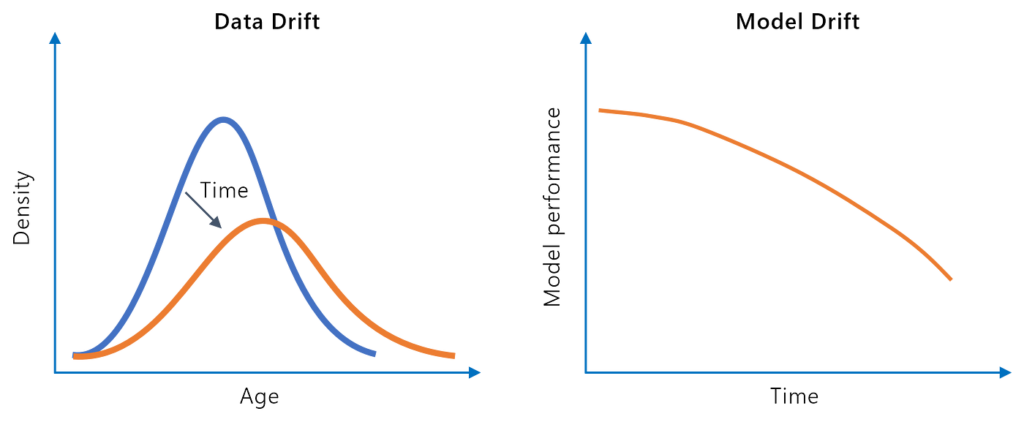

Model Drift, auch Modellverfall genannt, bezeichnet den Rückgang der Vorhersagegenauigkeit eines Machine-Learning-Modells im Laufe der Zeit aufgrund von Verände...

Modell-Kollaps ist ein Phänomen in der künstlichen Intelligenz, bei dem ein trainiertes Modell im Laufe der Zeit abbaut, insbesondere wenn es sich auf synthetis...

Die Modell-Verkettung ist eine Methode des maschinellen Lernens, bei der mehrere Modelle sequenziell miteinander verbunden werden, sodass die Ausgabe eines Mode...

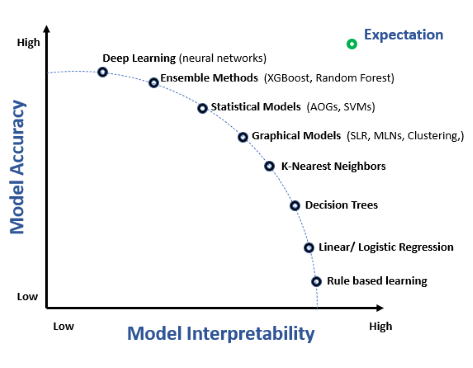

Modellinterpretierbarkeit bezeichnet die Fähigkeit, die Vorhersagen und Entscheidungen von Machine-Learning-Modellen zu verstehen, zu erklären und ihnen zu vert...

Modellrobustheit bezeichnet die Fähigkeit eines Machine-Learning-(ML)-Modells, trotz Variationen und Unsicherheiten in den Eingabedaten eine konsistente und gen...

Mustererkennung ist ein rechnergestützter Prozess zur Identifizierung von Mustern und Regelmäßigkeiten in Daten, der in Bereichen wie KI, Informatik, Psychologi...

Apache MXNet ist ein Open-Source-Deep-Learning-Framework, das für effizientes und flexibles Training sowie die Bereitstellung tiefer neuronaler Netze entwickelt...

Naive Bayes ist eine Familie von Klassifikationsalgorithmen, die auf dem Satz von Bayes basieren und bedingte Wahrscheinlichkeiten unter der vereinfachenden Ann...

Ein neuronales Netzwerk, oder künstliches neuronales Netzwerk (KNN), ist ein vom menschlichen Gehirn inspiriertes Rechenmodell, das in KI und maschinellem Lerne...

Natural Language Toolkit (NLTK) ist eine umfassende Suite von Python-Bibliotheken und Programmen für symbolische und statistische Verarbeitung natürlicher Sprac...

No-Code-AI-Plattformen ermöglichen es Nutzern, KI- und Machine-Learning-Modelle zu erstellen, bereitzustellen und zu verwalten, ohne Code zu schreiben. Diese Pl...

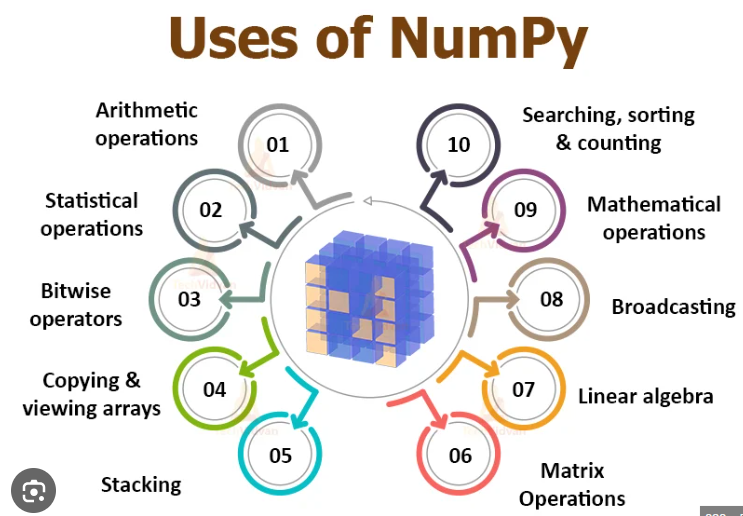

NumPy ist eine Open-Source-Python-Bibliothek, die für numerische Berechnungen unerlässlich ist und effiziente Array-Operationen und mathematische Funktionen ber...

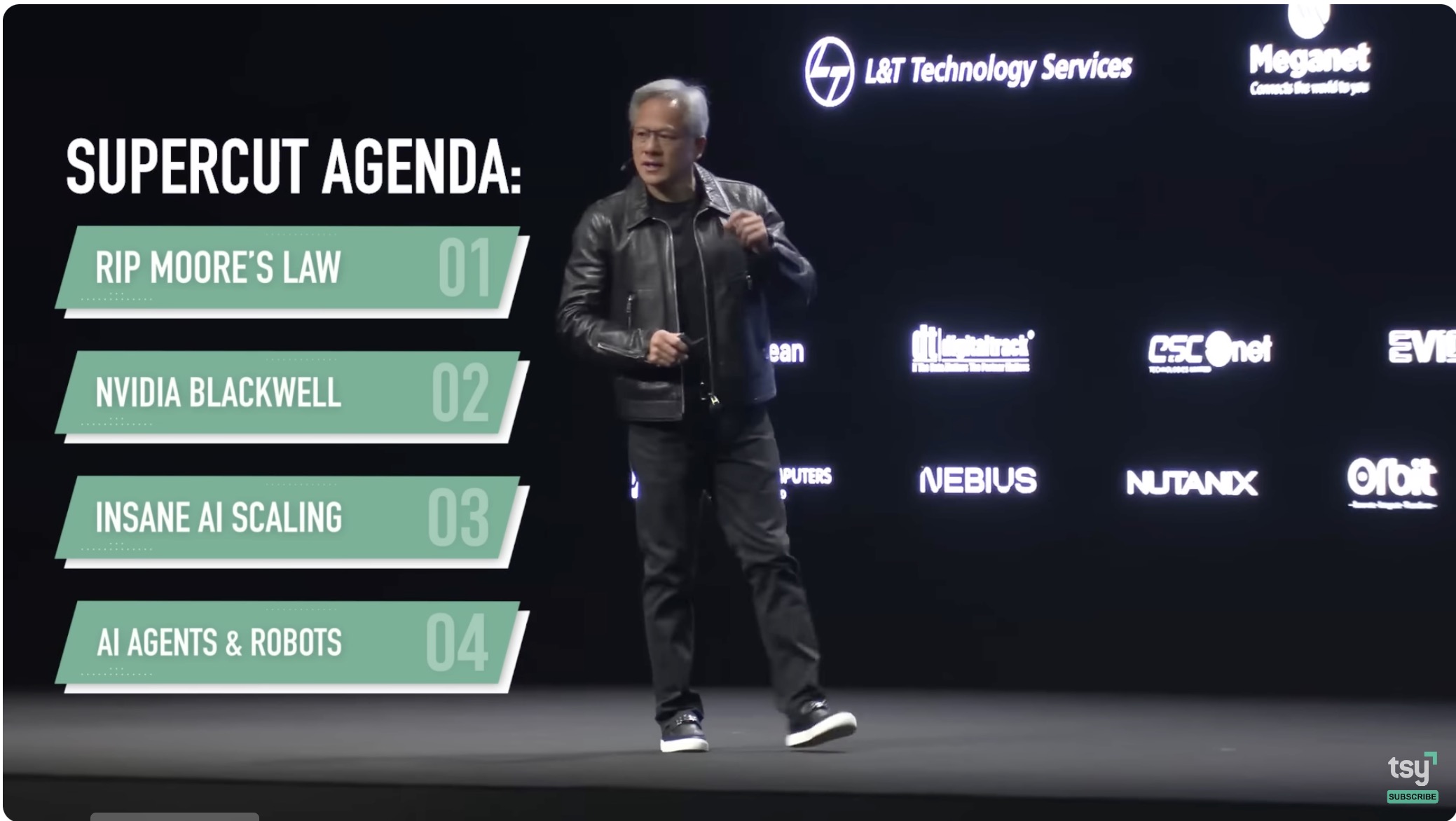

Erfahren Sie, wie NVIDIAs Blackwell-System eine neue Ära des beschleunigten Computings einläutet und Branchen durch fortschrittliche GPU-Technologie, KI und mas...

Open Neural Network Exchange (ONNX) ist ein Open-Source-Format für den nahtlosen Austausch von Machine-Learning-Modellen zwischen verschiedenen Frameworks und v...

OpenAI ist eine führende Forschungsorganisation im Bereich der künstlichen Intelligenz, bekannt für die Entwicklung von GPT, DALL-E und ChatGPT, mit dem Ziel, s...

OpenCV ist eine fortschrittliche Open-Source-Bibliothek für Computer Vision und maschinelles Lernen, die über 2500 Algorithmen für Bildverarbeitung, Objekterken...

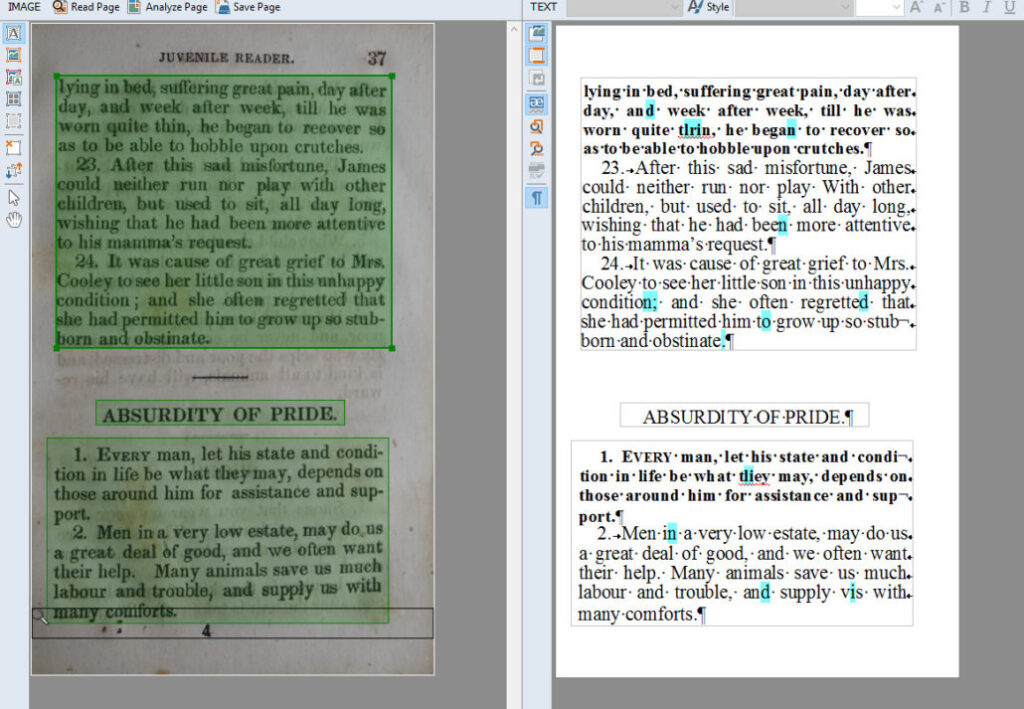

Optische Zeichenerkennung (OCR) ist eine transformative Technologie, die Dokumente wie gescannte Papiere, PDFs oder Bilder in editierbare und durchsuchbare Date...

Overfitting ist ein entscheidendes Konzept in der künstlichen Intelligenz (KI) und im maschinellen Lernen (ML). Es tritt auf, wenn ein Modell die Trainingsdaten...

Pandas ist eine Open-Source-Bibliothek für Datenmanipulation und -analyse in Python, bekannt für ihre Vielseitigkeit, robuste Datenstrukturen und Benutzerfreund...

Parameter-Efficient Fine-Tuning (PEFT) ist ein innovativer Ansatz in der KI und NLP, der es ermöglicht, große vortrainierte Modelle an spezifische Aufgaben anzu...

Das Pathways-Sprachmodell (PaLM) ist Googles fortschrittliche Familie großer Sprachmodelle, entwickelt für vielseitige Anwendungen wie Textgenerierung, logische...

Perplexity AI ist eine fortschrittliche, KI-gestützte Suchmaschine und ein Konversationswerkzeug, das NLP und maschinelles Lernen nutzt, um präzise, kontextbezo...

Personalisierte Vermarktung mit KI nutzt künstliche Intelligenz, um Marketingstrategien und -kommunikation individuell auf Kunden abzustimmen – basierend auf de...

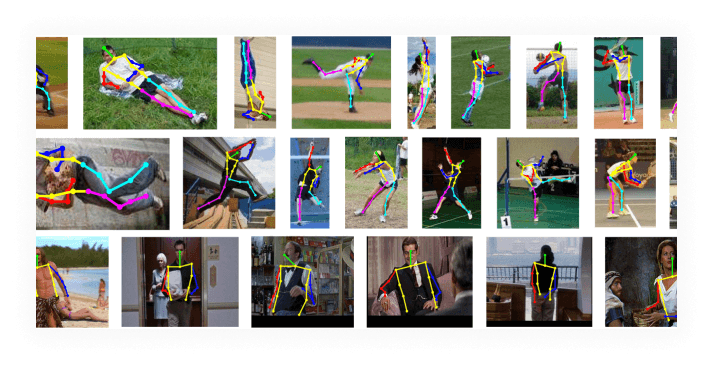

Posenschätzung ist eine Computer-Vision-Technik, die Position und Orientierung einer Person oder eines Objekts in Bildern oder Videos vorhersagt, indem sie Schl...

Erfahren Sie mehr über prädiktive Analytik in der KI, wie der Prozess funktioniert und wie verschiedene Branchen davon profitieren.

Prädiktive Modellierung ist ein anspruchsvoller Prozess in der Datenwissenschaft und Statistik, der zukünftige Ergebnisse durch die Analyse historischer Datenmu...

PyTorch ist ein Open-Source-Framework für maschinelles Lernen, entwickelt von Meta AI, das für seine Flexibilität, dynamische Rechen-Graphen, GPU-Beschleunigung...

Q-Lernen ist ein grundlegendes Konzept der künstlichen Intelligenz (KI) und des maschinellen Lernens, insbesondere im Bereich des bestärkenden Lernens. Es ermög...

Random Forest Regression ist ein leistungsstarker Machine-Learning-Algorithmus für prädiktive Analysen. Er erstellt mehrere Entscheidungsbäume und mittelt deren...

Entdecken Sie Recall im Machine Learning: ein entscheidender Messwert zur Bewertung der Modellleistung, insbesondere bei Klassifikationsaufgaben, bei denen das ...

Regularisierung in der künstlichen Intelligenz (KI) bezeichnet eine Reihe von Techniken, die dazu dienen, Überanpassung (Overfitting) in Machine-Learning-Modell...

Reinforcement Learning (RL) ist eine Methode zum Trainieren von Machine-Learning-Modellen, bei der ein Agent durch Ausführen von Aktionen und Erhalten von Feedb...

Reinforcement Learning aus menschlichem Feedback (RLHF) ist eine Methode des maschinellen Lernens, bei der menschliche Rückmeldungen in den Trainingsprozess von...

Entdecken Sie die wichtigsten Unterschiede zwischen Retrieval-Augmented Generation (RAG) und Cache-Augmented Generation (CAG) in der KI. Erfahren Sie, wie RAG d...

Eine Receiver Operating Characteristic (ROC) Kurve ist eine grafische Darstellung zur Bewertung der Leistung eines binären Klassifikatorsystems, wenn dessen Dis...

Schlussfolgerungen sind der kognitive Prozess, Schlussfolgerungen zu ziehen, Inferenzen zu machen oder Probleme auf der Grundlage von Informationen, Fakten und ...

Scikit-learn ist eine leistungsstarke Open-Source-Bibliothek für maschinelles Lernen in Python, die einfache und effiziente Werkzeuge für die prädiktive Datenan...

SciPy ist eine leistungsstarke Open-Source-Python-Bibliothek für wissenschaftliches und technisches Rechnen. Aufbauend auf NumPy bietet sie fortgeschrittene mat...

Semantische Analyse ist eine entscheidende Technik des Natural Language Processing (NLP), die Text interpretiert und Bedeutung ableitet. Dadurch können Maschine...

Semi-Supervised Learning (SSL) ist eine Machine-Learning-Technik, die sowohl gelabelte als auch ungelabelte Daten nutzt, um Modelle zu trainieren. Sie ist ideal...

Die Sentiment-Analyse, auch Meinungsanalyse genannt, ist eine entscheidende Aufgabe der KI und NLP zur Klassifizierung und Interpretation des emotionalen Tons v...

Entdecken Sie die wichtigsten Unterschiede zwischen skriptbasierten und KI-Chatbots, ihre praktischen Einsatzmöglichkeiten und wie sie die Kundeninteraktion in ...

spaCy ist eine leistungsstarke Open-Source-Python-Bibliothek für fortgeschrittene Natural Language Processing (NLP), bekannt für ihre Geschwindigkeit, Effizienz...

Spracherkennung, auch bekannt als automatische Spracherkennung (ASR) oder Speech-to-Text, ermöglicht es Computern, gesprochene Sprache zu interpretieren und in ...

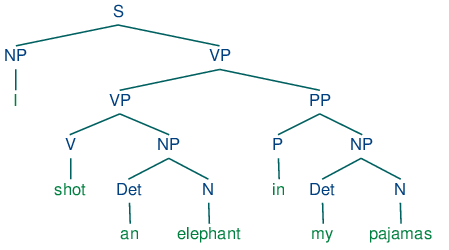

Die Sprachverarbeitung (Natural Language Processing, NLP) ermöglicht es Computern, menschliche Sprache mithilfe von Computerlinguistik, maschinellem Lernen und ...

Stable Diffusion ist ein fortschrittliches Text-zu-Bild-Generierungsmodell, das Deep Learning nutzt, um hochwertige, fotorealistische Bilder aus Textbeschreibun...

Ein Wissensstichtag ist der genaue Zeitpunkt, nach dem ein KI-Modell keine aktualisierten Informationen mehr hat. Erfahren Sie, warum diese Daten wichtig sind, ...

Synthetische Daten sind künstlich generierte Informationen, die reale Daten nachahmen. Sie werden mithilfe von Algorithmen und Computersimulationen erstellt, um...

TensorFlow ist eine Open-Source-Bibliothek, die vom Google Brain-Team entwickelt wurde und für numerische Berechnungen sowie groß angelegte maschinelle Lernverf...

Textklassifikation, auch bekannt als Textkategorisierung oder Text-Tagging, ist eine zentrale NLP-Aufgabe, bei der vordefinierte Kategorien Textdokumenten zugew...

Die Top-k-Genauigkeit ist eine Evaluationsmetrik im maschinellen Lernen, die prüft, ob die wahre Klasse unter den k am höchsten vorhergesagten Klassen ist, und ...

Torch ist eine Open-Source-Machine-Learning-Bibliothek und ein wissenschaftliches Computing-Framework auf Basis von Lua, optimiert für Deep-Learning- und KI-Auf...

Trainingsdaten beziehen sich auf den Datensatz, der verwendet wird, um KI-Algorithmen zu unterrichten, damit sie Muster erkennen, Entscheidungen treffen und Erg...

Trainingsfehler in KI und Machine Learning ist die Abweichung zwischen den vom Modell vorhergesagten und den tatsächlichen Ausgaben während des Trainings. Er is...

Transfer Learning ist eine fortschrittliche Methode des maschinellen Lernens, die es ermöglicht, Modelle, die für eine Aufgabe trainiert wurden, für eine verwan...

Transferlernen ist eine leistungsstarke KI/ML-Technik, die vortrainierte Modelle an neue Aufgaben anpasst, die Leistung mit begrenzten Daten verbessert und die ...

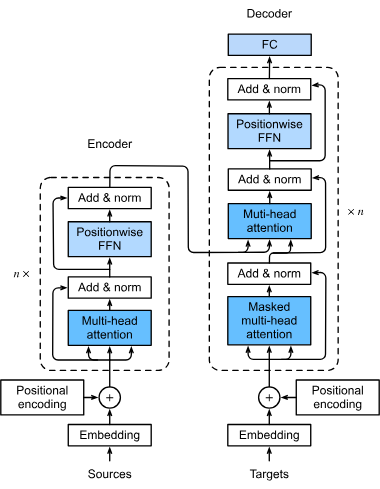

Transformer sind eine revolutionäre neuronale Netzwerkarchitektur, die die künstliche Intelligenz, insbesondere im Bereich der Verarbeitung natürlicher Sprache,...

Trends in der KI-Technologie umfassen aktuelle und aufkommende Fortschritte in der künstlichen Intelligenz, einschließlich maschinellem Lernen, großen Sprachmod...

Künstliche Intelligenz (KI) bei der Überprüfung juristischer Dokumente stellt einen bedeutenden Wandel in der Art und Weise dar, wie Juristinnen und Juristen mi...

Überwachtes Lernen ist ein grundlegender Ansatz im maschinellen Lernen und in der künstlichen Intelligenz, bei dem Algorithmen aus gekennzeichneten Datensätzen ...

Überwachtes Lernen ist ein grundlegendes Konzept der KI und des maschinellen Lernens, bei dem Algorithmen mit beschrifteten Daten trainiert werden, um genaue Vo...

Underfitting tritt auf, wenn ein Machine-Learning-Modell zu einfach ist, um die zugrunde liegenden Muster der Trainingsdaten zu erfassen. Dies führt zu schlecht...

Erfahren Sie, was unstrukturierte Daten sind und wie sie sich von strukturierten Daten unterscheiden. Lernen Sie die Herausforderungen kennen sowie die Werkzeug...

Unüberwachtes Lernen ist ein Zweig des maschinellen Lernens, der sich auf das Finden von Mustern, Strukturen und Beziehungen in nicht gekennzeichneten Daten kon...

Unüberwachtes Lernen ist eine Methode des maschinellen Lernens, bei der Algorithmen mit nicht gelabelten Daten trainiert werden, um verborgene Muster, Strukture...

Die Verarbeitung natürlicher Sprache (NLP) ist ein Teilgebiet der künstlichen Intelligenz (KI), das es Computern ermöglicht, menschliche Sprache zu verstehen, z...