Absatz-Umschreiber

Erfahren Sie, was ein Absatz-Umschreiber ist, wie er funktioniert, seine wichtigsten Funktionen und wie er die Schreibqualität verbessern, Plagiate vermeiden un...

Erfahren Sie, was ein Absatz-Umschreiber ist, wie er funktioniert, seine wichtigsten Funktionen und wie er die Schreibqualität verbessern, Plagiate vermeiden un...

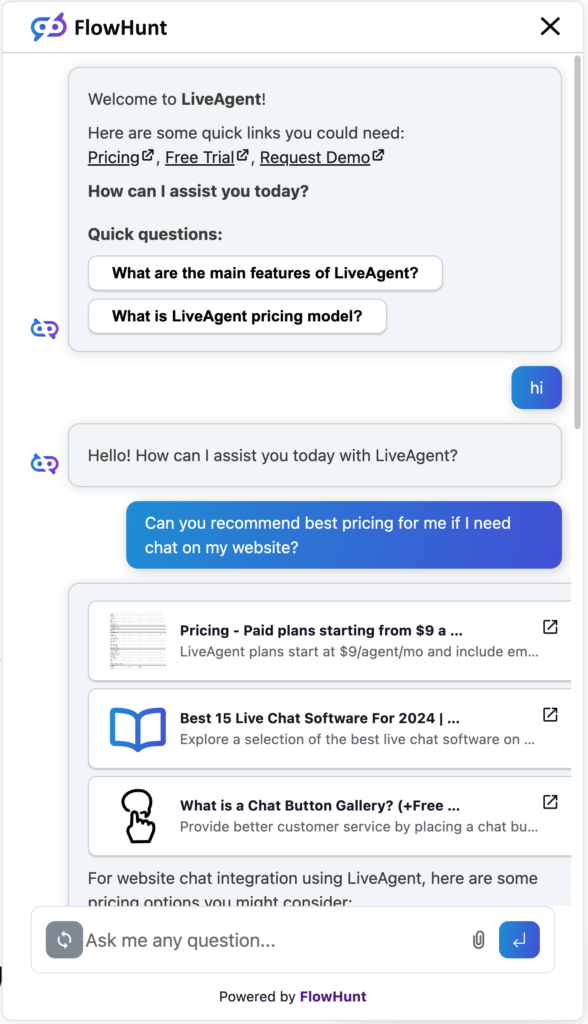

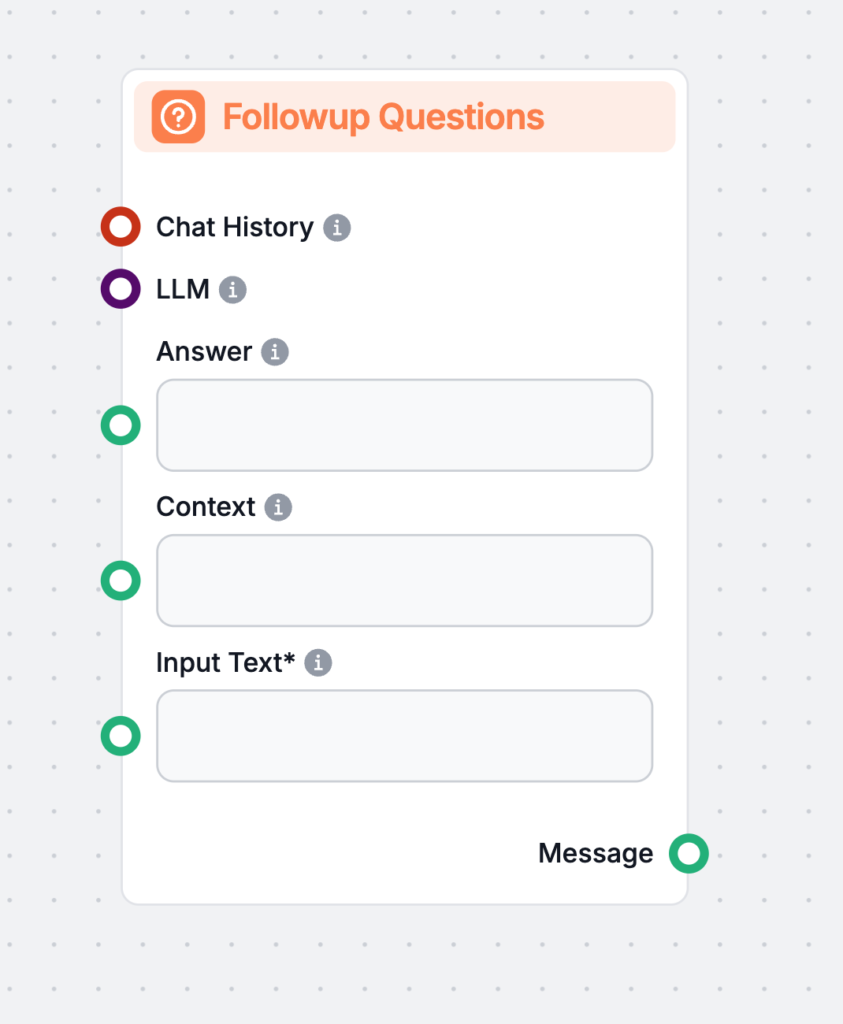

Entdecken Sie FlowHunts KI-gestützten Bildbeschriftungs-Generator. Erstellen Sie sofort ansprechende, relevante Bildunterschriften mit individuell anpassbaren T...

AllenNLP ist eine robuste Open-Source-Bibliothek für NLP-Forschung, entwickelt von AI2 auf PyTorch. Sie bietet modulare, erweiterbare Werkzeuge, vortrainierte M...

Die automatische Klassifizierung automatisiert die Kategorisierung von Inhalten, indem sie Eigenschaften analysiert und mithilfe von Technologien wie maschinell...

Entdecken Sie BERT (Bidirectional Encoder Representations from Transformers), ein Open-Source-Maschinelles Lern-Framework von Google für die Verarbeitung natürl...

Bidirektionales Long Short-Term Memory (BiLSTM) ist eine fortschrittliche Art von rekurrenter neuronaler Netzwerkarchitektur (RNN), die sequenzielle Daten in Vo...

Der BLEU-Score (Bilingual Evaluation Understudy) ist eine entscheidende Kennzahl zur Bewertung der Qualität von Texten, die von maschinellen Übersetzungssysteme...

Chatbots sind digitale Werkzeuge, die mithilfe von KI und NLP menschliche Konversationen simulieren und 24/7-Support, Skalierbarkeit und Kosteneffizienz bieten....

ChatGPT ist ein hochmoderner KI-Chatbot, der von OpenAI entwickelt wurde und fortschrittliche Verarbeitung natürlicher Sprache (NLP) nutzt, um menschenähnliche ...

Entdecken Sie die Multi-Agenten-Frameworks Crew.ai und Langchain. Crew.ai überzeugt durch Zusammenarbeit und Aufgabenverteilung und ist ideal für komplexe Simul...

Datenknappheit bezeichnet unzureichende Datenmengen für das Training von Machine-Learning-Modellen oder umfassende Analysen, was die Entwicklung präziser KI-Sys...

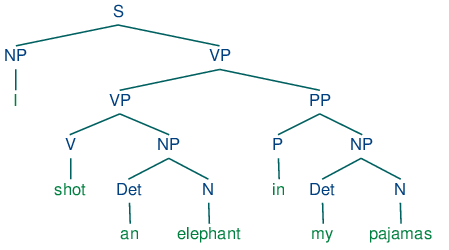

Dependenz-Parsing ist eine Methode der syntaktischen Analyse im NLP, die grammatische Beziehungen zwischen Wörtern identifiziert und baumartige Strukturen bilde...

Erfahren Sie mehr über diskriminative KI-Modelle – maschinelle Lernmodelle, die sich auf Klassifikation und Regression konzentrieren, indem sie Entscheidungsgre...

Die erweiterte Dokumentensuche mit NLP integriert fortschrittliche Techniken der natürlichen Sprachverarbeitung in Dokumentenabrufsysteme und verbessert so die ...

Ein Einbettungsvektor ist eine dichte numerische Darstellung von Daten in einem mehrdimensionalen Raum und erfasst semantische sowie kontextuelle Beziehungen. E...

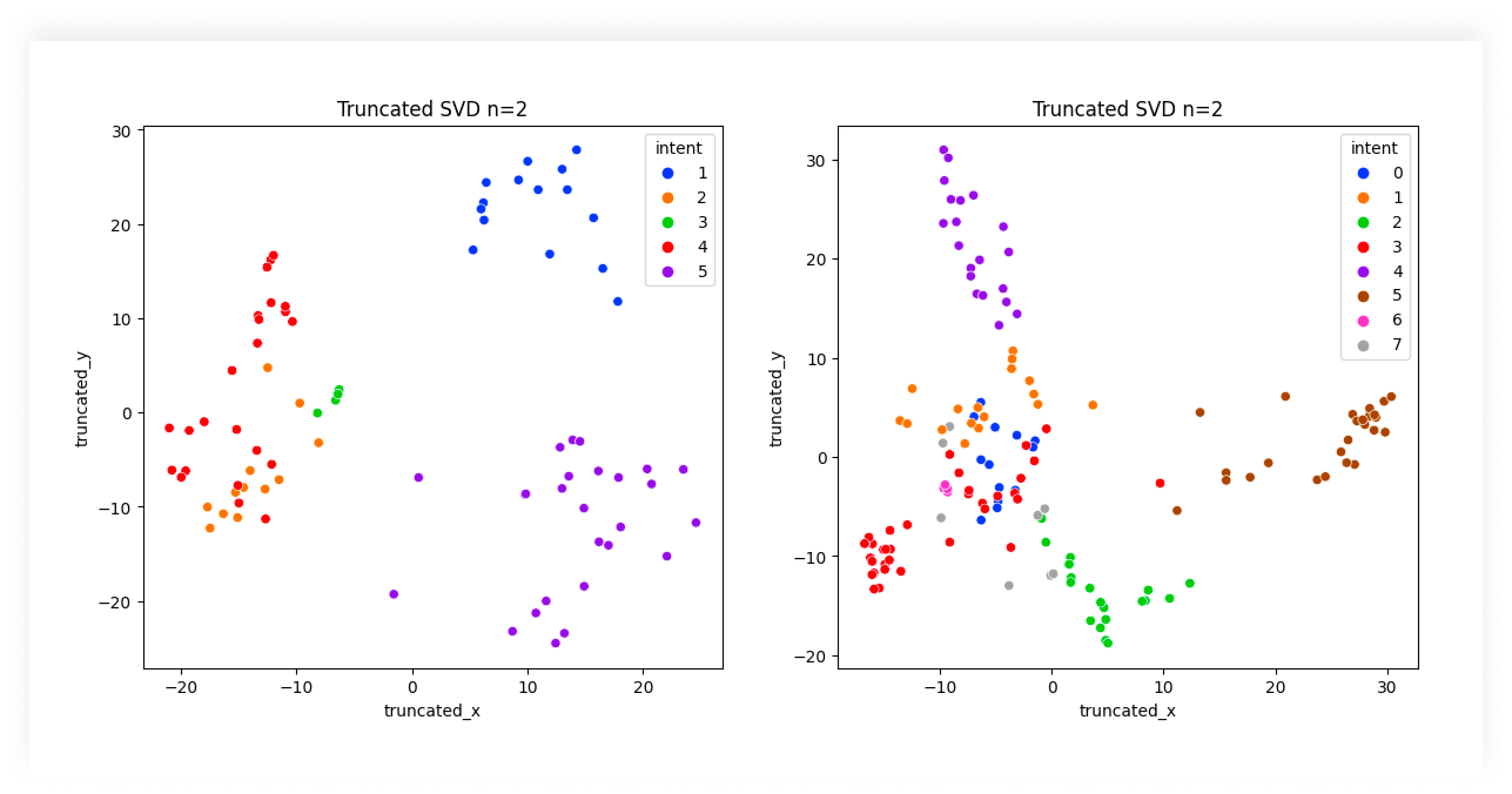

Entdecken Sie die entscheidende Rolle der KI-Intentklassifizierung zur Verbesserung von Nutzerinteraktionen mit Technologie, zur Optimierung des Kundensupports ...

Extraktive KI ist ein spezialisierter Zweig der künstlichen Intelligenz, der sich auf das Identifizieren und Abrufen spezifischer Informationen aus bestehenden ...

Der F-Score, auch bekannt als F-Maß oder F1-Score, ist eine statistische Kennzahl zur Bewertung der Genauigkeit eines Tests oder Modells, insbesondere bei binär...

Die Feinabstimmung von Modellen passt vortrainierte Modelle für neue Aufgaben durch kleinere Anpassungen an und reduziert so den Bedarf an Daten und Ressourcen....

Ein Foundation AI Model ist ein groß angelegtes Machine-Learning-Modell, das auf riesigen Datenmengen trainiert wurde und an eine Vielzahl von Aufgaben anpassba...

Ein Generativer Vortrainierter Transformer (GPT) ist ein KI-Modell, das Deep-Learning-Techniken nutzt, um Texte zu erzeugen, die menschlichem Schreiben sehr ähn...

Gensim ist eine beliebte Open-Source-Python-Bibliothek für die Verarbeitung natürlicher Sprache (NLP), die sich auf unbeaufsichtigtes Topic Modeling, Dokumenten...

Ein Großes Sprachmodell (LLM) ist eine KI, die auf riesigen Textmengen trainiert wurde, um menschliche Sprache zu verstehen, zu generieren und zu verarbeiten. L...

Hugging Face Transformers ist eine führende Open-Source-Python-Bibliothek, die die Implementierung von Transformermodelle für maschinelle Lernaufgaben in NLP, C...

Informationsabruf nutzt KI, NLP und maschinelles Lernen, um Daten effizient und präzise abzurufen, die den Anforderungen der Nutzer entsprechen. Als Grundlage f...

Inhaltserweiterung mit KI verbessert rohe, unstrukturierte Inhalte, indem künstliche Intelligenz eingesetzt wird, um bedeutungsvolle Informationen, Strukturen u...

Entdecken Sie, was ein Insight Engine ist – eine fortschrittliche, KI-gesteuerte Plattform, die die Datenrecherche und -analyse durch das Verständnis von Kontex...

Intelligente Dokumentenverarbeitung (IDP) ist eine fortschrittliche Technologie, die KI nutzt, um die Extraktion, Verarbeitung und Analyse von Daten aus verschi...

Künstliche Intelligenz (KI) im Gesundheitswesen nutzt fortschrittliche Algorithmen und Technologien wie maschinelles Lernen, NLP und Deep Learning, um komplexe ...

Künstliche Intelligenz (KI) in der Cybersicherheit nutzt Technologien wie maschinelles Lernen und NLP, um Cyberbedrohungen zu erkennen, zu verhindern und darauf...

Ein KI-Automatisierungssystem integriert künstliche Intelligenz mit Automatisierungsprozessen und erweitert traditionelle Automatisierung um kognitive Fähigkeit...

KI-gestütztes Marketing nutzt Technologien der künstlichen Intelligenz wie maschinelles Lernen, NLP und prädiktive Analysen, um Aufgaben zu automatisieren, Kund...

Entdecken Sie eine skalierbare Python-Lösung zur Rechnungsdatenerfassung mit KI-basierter OCR. Lernen Sie, wie Sie PDFs konvertieren, Bilder zur FlowHunt-API ho...

Erfahren Sie, was ein KI-SDR ist und wie künstliche intelligente Sales Development Representatives die Akquise, Lead-Qualifizierung, Ansprache und Nachverfolgun...

Dieses Tool ist perfekt für Fachleute, Studierende und alle, die mit umfangreichen Informationen zu tun haben. Es hilft Ihnen, lange Texte in kurze Zusammenfass...

Kognitives Computing stellt ein transformatives Technologiemodell dar, das menschliche Denkprozesse in komplexen Szenarien simuliert. Es integriert KI und Signa...

Konversationelle KI bezeichnet Technologien, die es Computern ermöglichen, menschliche Gespräche mithilfe von NLP, maschinellem Lernen und anderen Sprachtechnol...

Koreferenzauflösung ist eine grundlegende NLP-Aufgabe zur Identifizierung und Verknüpfung von Ausdrücken im Text, die sich auf dieselbe Entität beziehen – entsc...

Ein Korpus (Plural: Korpora) bezeichnet im Bereich der KI eine große, strukturierte Sammlung von Text- oder Audiodaten, die zum Trainieren und Evaluieren von KI...

LangChain ist ein Open-Source-Framework zur Entwicklung von Anwendungen, die von großen Sprachmodellen (LLMs) unterstützt werden. Es vereinfacht die Integration...

Large Language Model Meta AI (LLaMA) ist ein hochmodernes Modell zur Verarbeitung natürlicher Sprache, entwickelt von Meta. Mit bis zu 65 Milliarden Parametern ...

LazyGraphRAG ist ein innovativer Ansatz für Retrieval-Augmented Generation (RAG), der die Effizienz optimiert und Kosten bei KI-gesteuerter Datenabfrage reduzie...

Long Short-Term Memory (LSTM) ist eine spezialisierte Architektur von Rekurrenten Neuronalen Netzwerken (RNN), die darauf ausgelegt ist, langfristige Abhängigke...

Erfahren Sie, wie 'Meinten Sie' (DYM) in der NLP Fehler in Benutzereingaben wie Tippfehler oder Rechtschreibfehler erkennt und korrigiert und Alternativen vorsc...

Multi-Hop-Reasoning ist ein KI-Prozess, insbesondere im Bereich NLP und Wissensgraphen, bei dem Systeme mehrere Informationsstücke verknüpfen, um komplexe Frage...

Die natürliche Sprachgenerierung (NLG) ist ein Teilgebiet der KI, das sich auf die Umwandlung strukturierter Daten in menschenähnlichen Text konzentriert. NLG t...

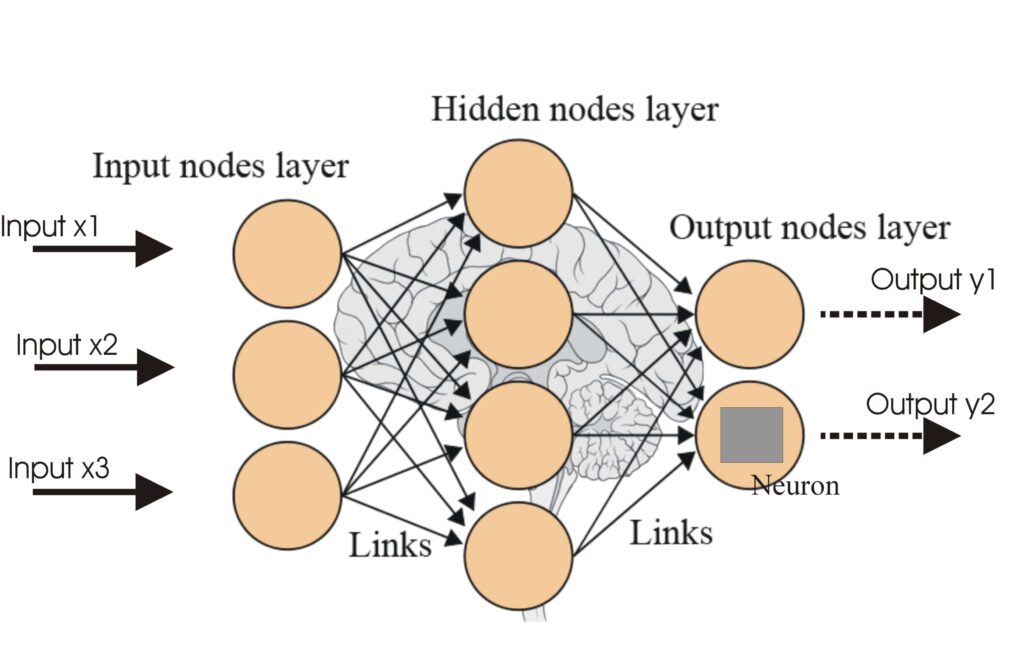

Ein neuronales Netzwerk, oder künstliches neuronales Netzwerk (KNN), ist ein vom menschlichen Gehirn inspiriertes Rechenmodell, das in KI und maschinellem Lerne...

Natural Language Toolkit (NLTK) ist eine umfassende Suite von Python-Bibliotheken und Programmen für symbolische und statistische Verarbeitung natürlicher Sprac...

Parameter-Efficient Fine-Tuning (PEFT) ist ein innovativer Ansatz in der KI und NLP, der es ermöglicht, große vortrainierte Modelle an spezifische Aufgaben anzu...

Paraphrasieren in der Kommunikation ist die Fähigkeit, die Botschaft einer anderen Person mit eigenen Worten wiederzugeben, während die ursprüngliche Bedeutung ...

Perplexity AI ist eine fortschrittliche, KI-gestützte Suchmaschine und ein Konversationswerkzeug, das NLP und maschinelles Lernen nutzt, um präzise, kontextbezo...

PyTorch ist ein Open-Source-Framework für maschinelles Lernen, entwickelt von Meta AI, das für seine Flexibilität, dynamische Rechen-Graphen, GPU-Beschleunigung...

Rekurrente neuronale Netzwerke (RNNs) sind eine fortschrittliche Klasse künstlicher neuronaler Netzwerke, die zur Verarbeitung sequentieller Daten entwickelt wu...

Der ROUGE-Score ist eine Reihe von Metriken zur Bewertung der Qualität von maschinell generierten Zusammenfassungen und Übersetzungen durch den Vergleich mit me...

Erfahren Sie, wie KI-basierte Sales Script Generatoren NLP und NLG nutzen, um personalisierte, überzeugende Verkaufsskripte für Telefonate, E-Mails, Videos und ...

Entdecken Sie, was ein KI-Satz-Umformulierungstool ist, wie es funktioniert, seine Anwendungsfälle und wie es Autoren, Studierenden und Marketingexperten hilft,...

Semantische Analyse ist eine entscheidende Technik des Natural Language Processing (NLP), die Text interpretiert und Bedeutung ableitet. Dadurch können Maschine...

Die Sentiment-Analyse, auch Meinungsanalyse genannt, ist eine entscheidende Aufgabe der KI und NLP zur Klassifizierung und Interpretation des emotionalen Tons v...

Entdecken Sie die Sequenzmodellierung in KI und maschinellem Lernen – sagen Sie Sequenzen in Daten wie Text, Audio und DNA voraus oder generieren Sie sie mithil...

spaCy ist eine leistungsstarke Open-Source-Python-Bibliothek für fortgeschrittene Natural Language Processing (NLP), bekannt für ihre Geschwindigkeit, Effizienz...

Die Spracherkennung in großen Sprachmodellen (LLMs) ist der Prozess, durch den diese Modelle die Sprache eines eingegebenen Textes identifizieren, um eine genau...

Die Sprachverarbeitung (Natural Language Processing, NLP) ermöglicht es Computern, menschliche Sprache mithilfe von Computerlinguistik, maschinellem Lernen und ...

Textgenerierung mit großen Sprachmodellen (LLMs) bezieht sich auf den fortschrittlichen Einsatz von Machine-Learning-Modellen zur Erstellung menschenähnlicher T...

Textklassifikation, auch bekannt als Textkategorisierung oder Text-Tagging, ist eine zentrale NLP-Aufgabe, bei der vordefinierte Kategorien Textdokumenten zugew...

Die Textzusammenfassung ist ein grundlegender KI-Prozess, der umfangreiche Dokumente in prägnante Zusammenfassungen destilliert und dabei wichtige Informationen...

Transferlernen ist eine leistungsstarke KI/ML-Technik, die vortrainierte Modelle an neue Aufgaben anpasst, die Leistung mit begrenzten Daten verbessert und die ...

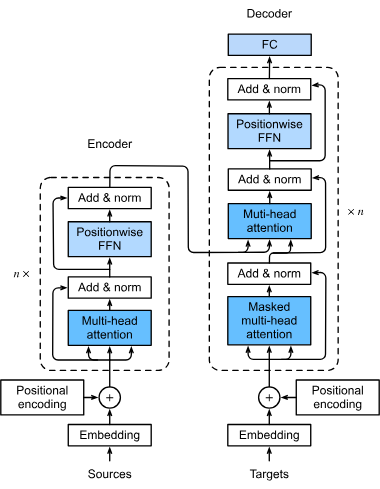

Ein Transformer-Modell ist eine Art von neuronalen Netzwerken, die speziell dafür entwickelt wurden, sequenzielle Daten wie Text, Sprache oder Zeitreihendaten z...

Transformer sind eine revolutionäre neuronale Netzwerkarchitektur, die die künstliche Intelligenz, insbesondere im Bereich der Verarbeitung natürlicher Sprache,...

Künstliche Intelligenz (KI) bei der Überprüfung juristischer Dokumente stellt einen bedeutenden Wandel in der Art und Weise dar, wie Juristinnen und Juristen mi...

Die Verarbeitung natürlicher Sprache (NLP) ist ein Teilgebiet der künstlichen Intelligenz (KI), das es Computern ermöglicht, menschliche Sprache zu verstehen, z...

Erfahren Sie die Grundlagen der KI-Intentklassifizierung, ihre Techniken, Anwendungen in der Praxis, Herausforderungen und Zukunftstrends zur Verbesserung der M...

Windowing in der künstlichen Intelligenz bezieht sich auf die Verarbeitung von Daten in Segmenten oder „Fenstern“, um sequenzielle Informationen effizient zu an...

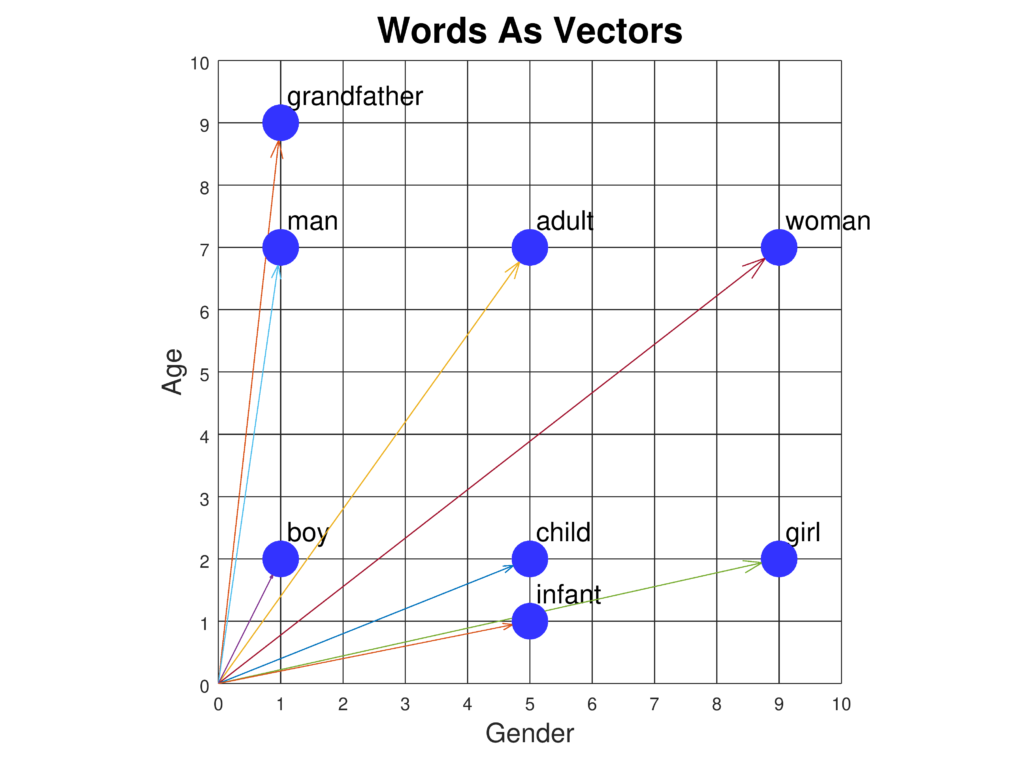

Wort-Embeddings sind fortschrittliche Darstellungen von Wörtern in einem kontinuierlichen Vektorraum, die semantische und syntaktische Beziehungen für fortgesch...

Wortarten-Tagging (POS Tagging) ist eine entscheidende Aufgabe in der Computerlinguistik und der Verarbeitung natürlicher Sprache (NLP). Dabei wird jedem Wort i...