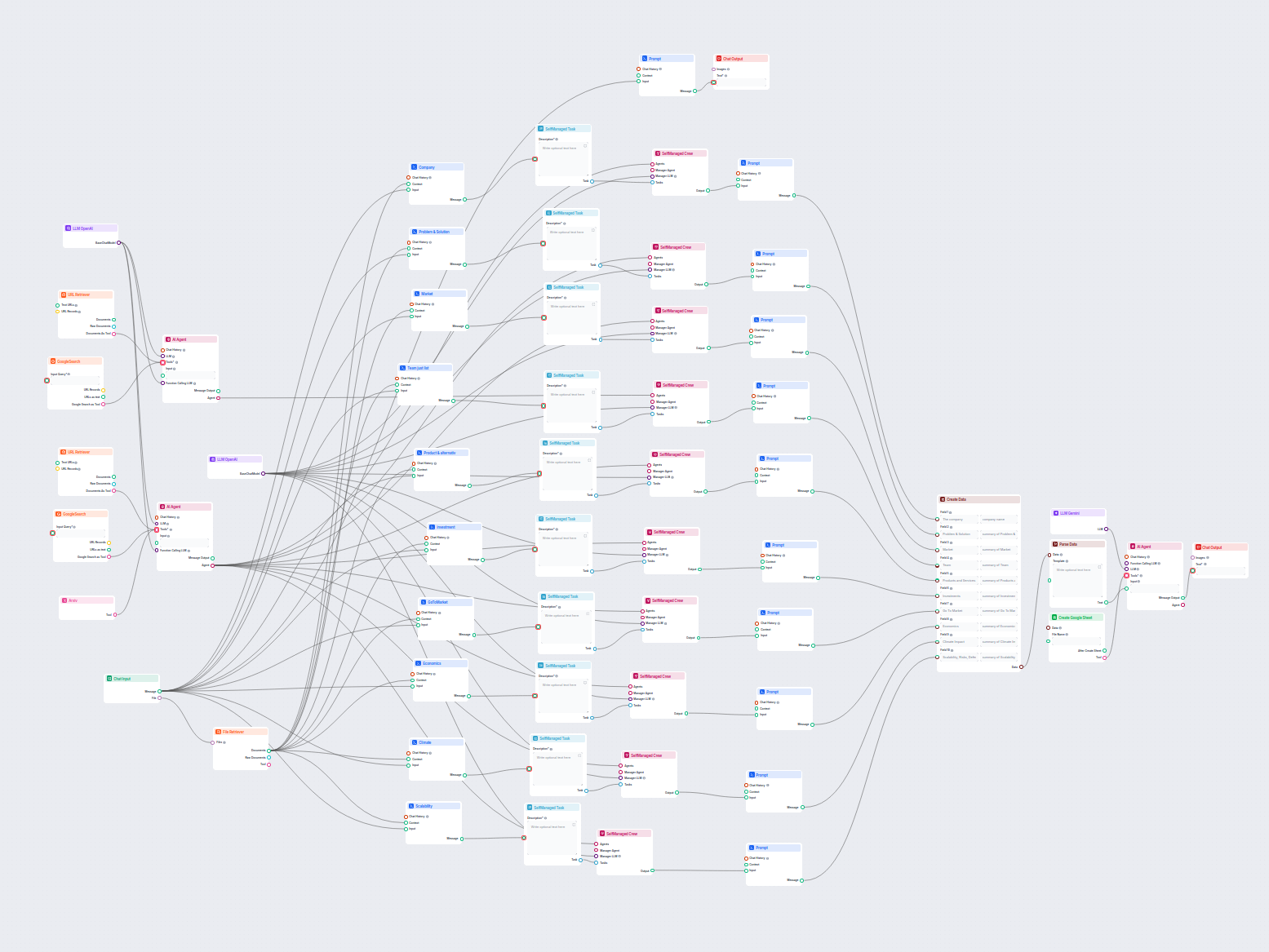

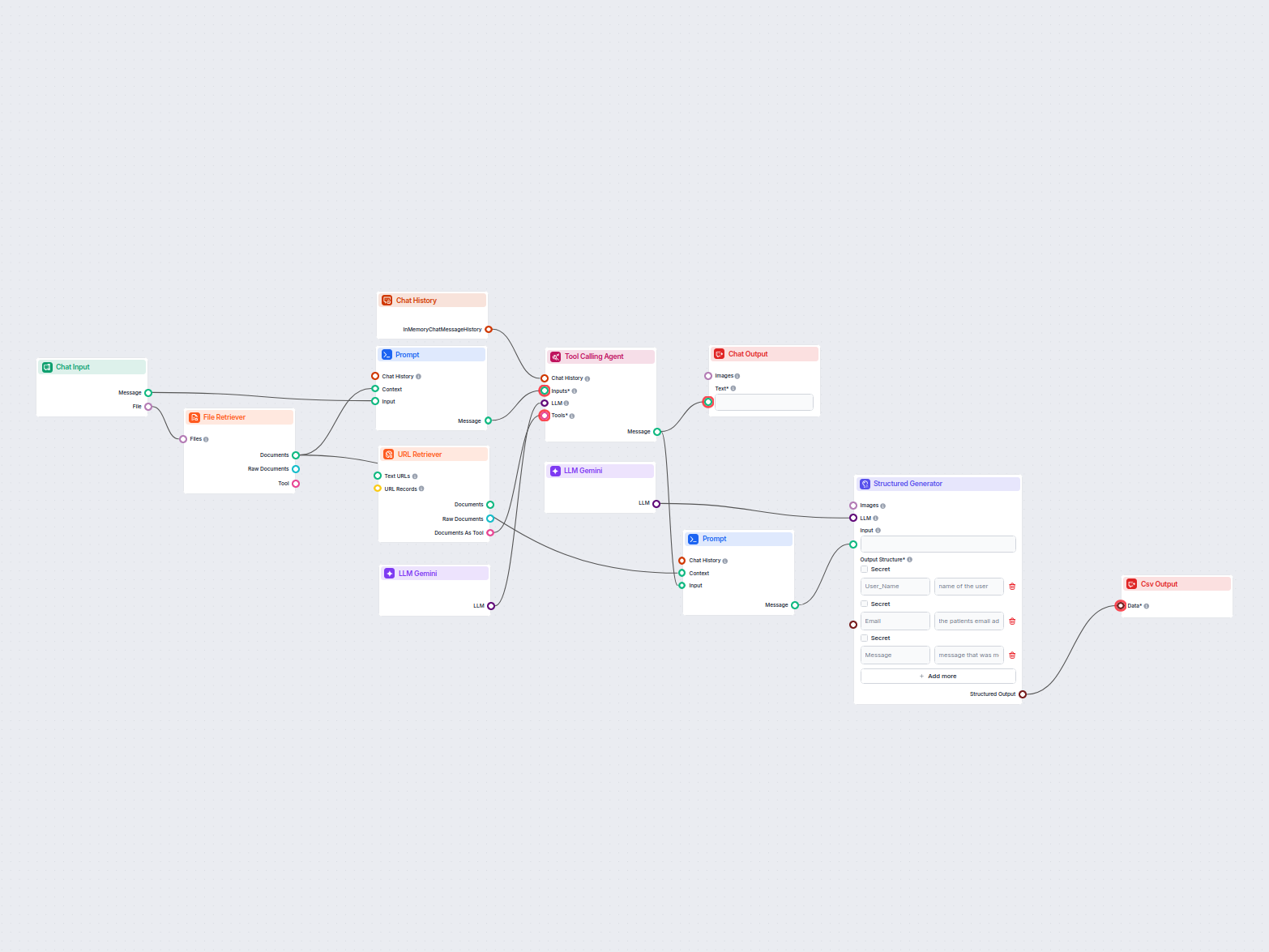

Análisis de Empresas con IA exportado a Google Sheets

Este flujo de trabajo impulsado por IA ofrece un análisis empresarial integral y basado en datos. Recopila información sobre los antecedentes de la empresa, el ...

Desbloquea el poder de los modelos Gemini de Google en FlowHunt—cambia de modelos de IA, controla configuraciones y crea chatbots más inteligentes fácilmente.

Descripción del componente

The LLM Gemini component connects the Gemini models from Google to your flow. While the Generators and Agents are where the actual magic happens, LLM components allow you to control the model used. All components come with ChatGPT-4 by default. You can connect this component if you wish to change the model or gain more control over it.

Remember that connecting an LLM Component is optional. All components that use an LLM come with ChatGPT-4o as the default. The LLM components allow you to change the model and control model settings.

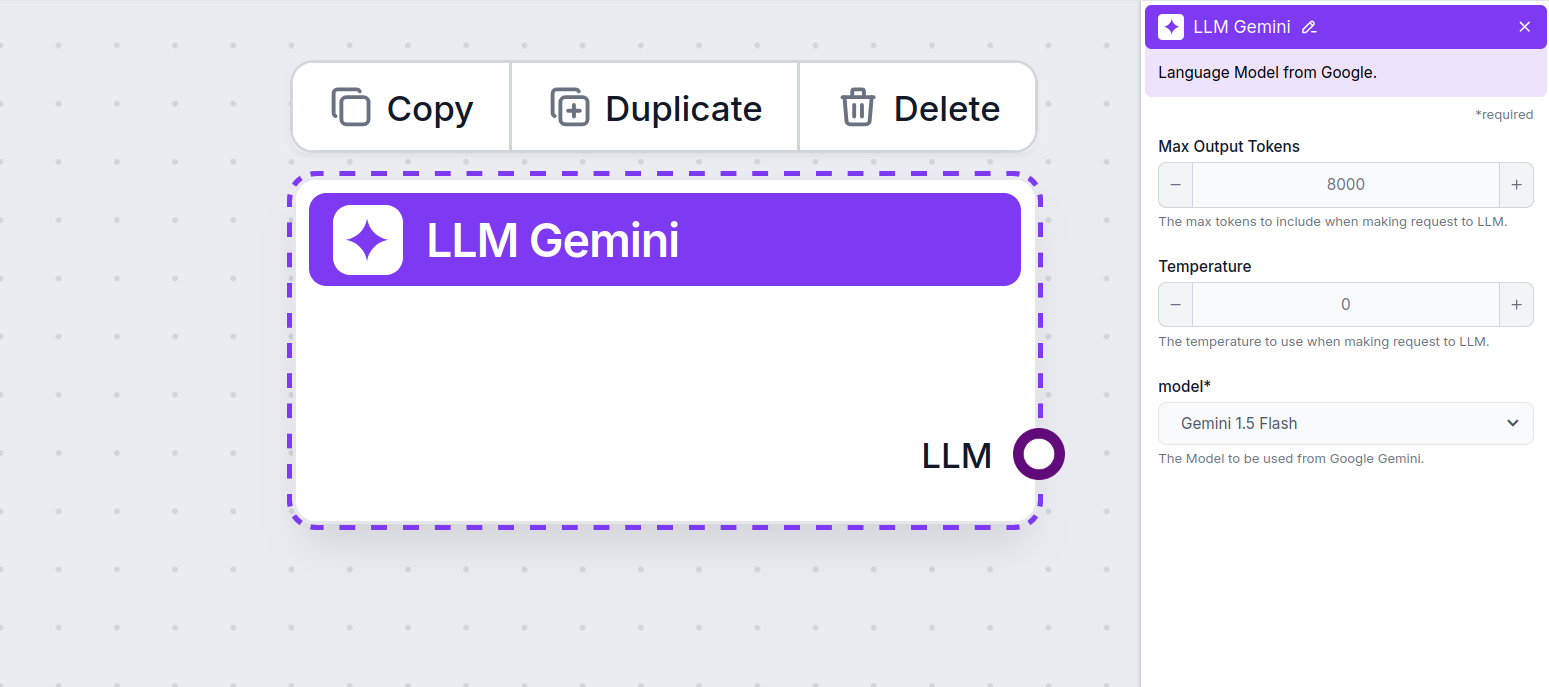

Tokens represent the individual units of text the model processes and generates. Token usage varies with models, and a single token can be anything from words or subwords to a single character. Models are usually priced in millions of tokens.

The max tokens setting limits the total number of tokens that can be processed in a single interaction or request, ensuring the responses are generated within reasonable bounds. The default limit is 4,000 tokens, the optimal size for summarizing documents and several sources to generate an answer.

Temperature controls the variability of answers, ranging from 0 to 1.

A temperature of 0.1 will make the responses very to the point but potentially repetitive and deficient.

A high temperature of 1 allows for maximum creativity in answers but creates the risk of irrelevant or even hallucinatory responses.

For example, the recommended temperature for a customer service bot is between 0.2 and 0.5. This level should keep the answers relevant and to the script while allowing for a natural response variation.

This is the model picker. Here, you’ll find all the supported Gemini models from Google. We support all the latest Gemini models:

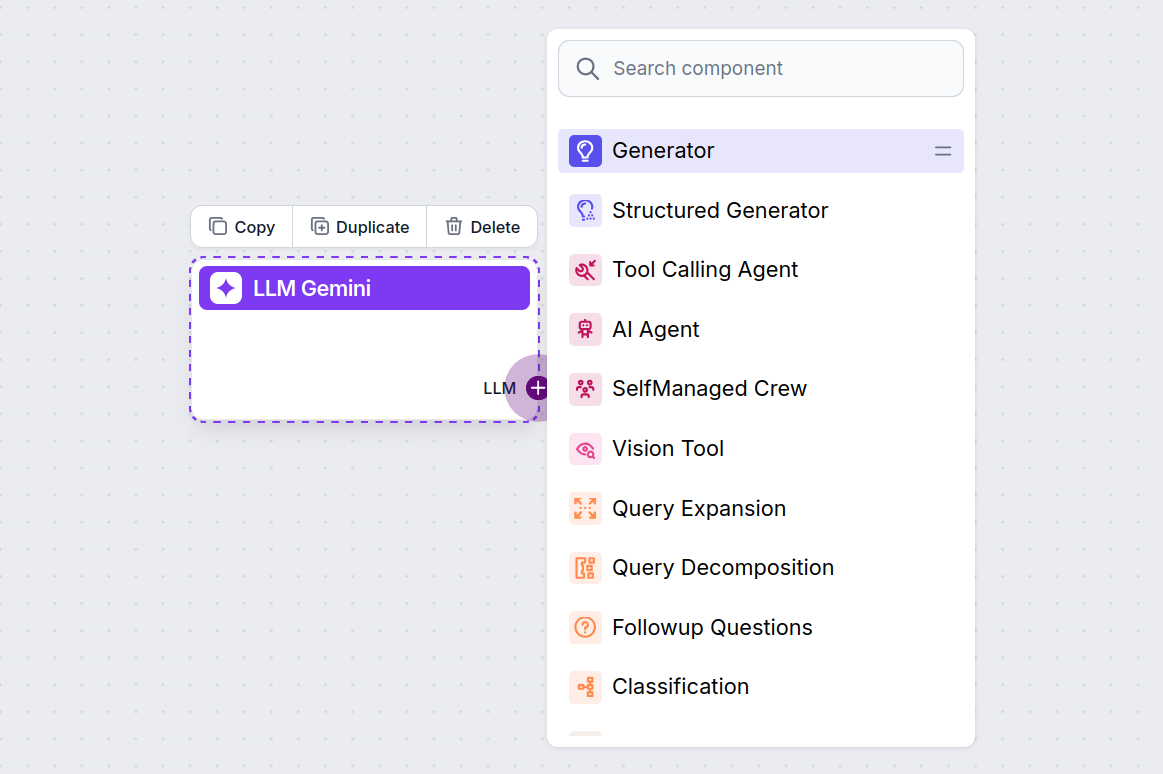

You’ll notice that all LLM components only have an output handle. Input doesn’t pass through the component, as it only represents the model, while the actual generation happens in AI Agents and Generators.

The LLM handle is always purple. The LLM input handle is found on any component that uses AI to generate text or process data. You can see the options by clicking the handle:

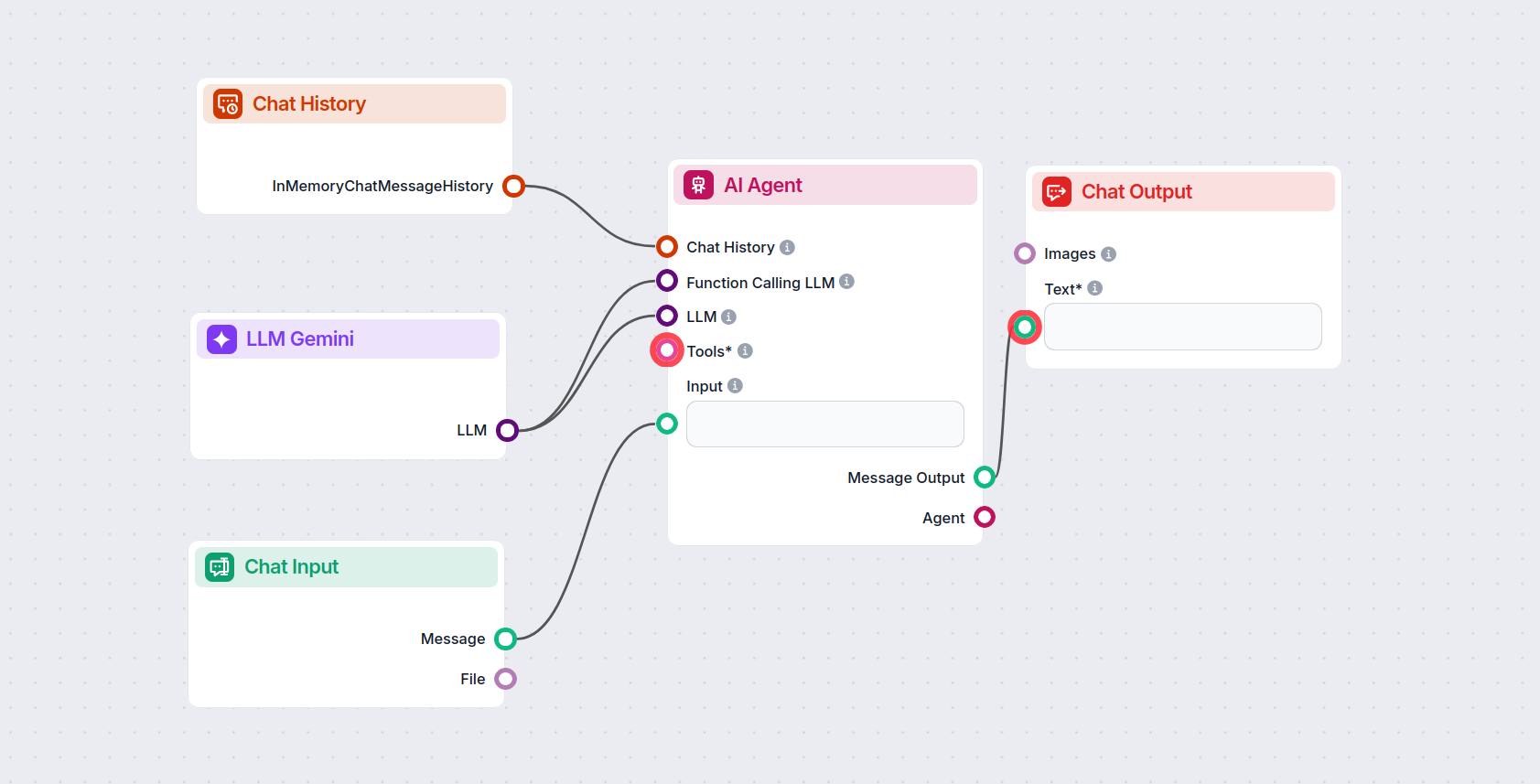

This allows you to create all sorts of tools. Let’s see the component in action. Here’s a simple AI Agent chatbot Flow that’s using Gemini 2.0 Flash Experimental to generate responses. You can think of it as a basic Gemini chatbot.

This simple Chatbot Flow includes:

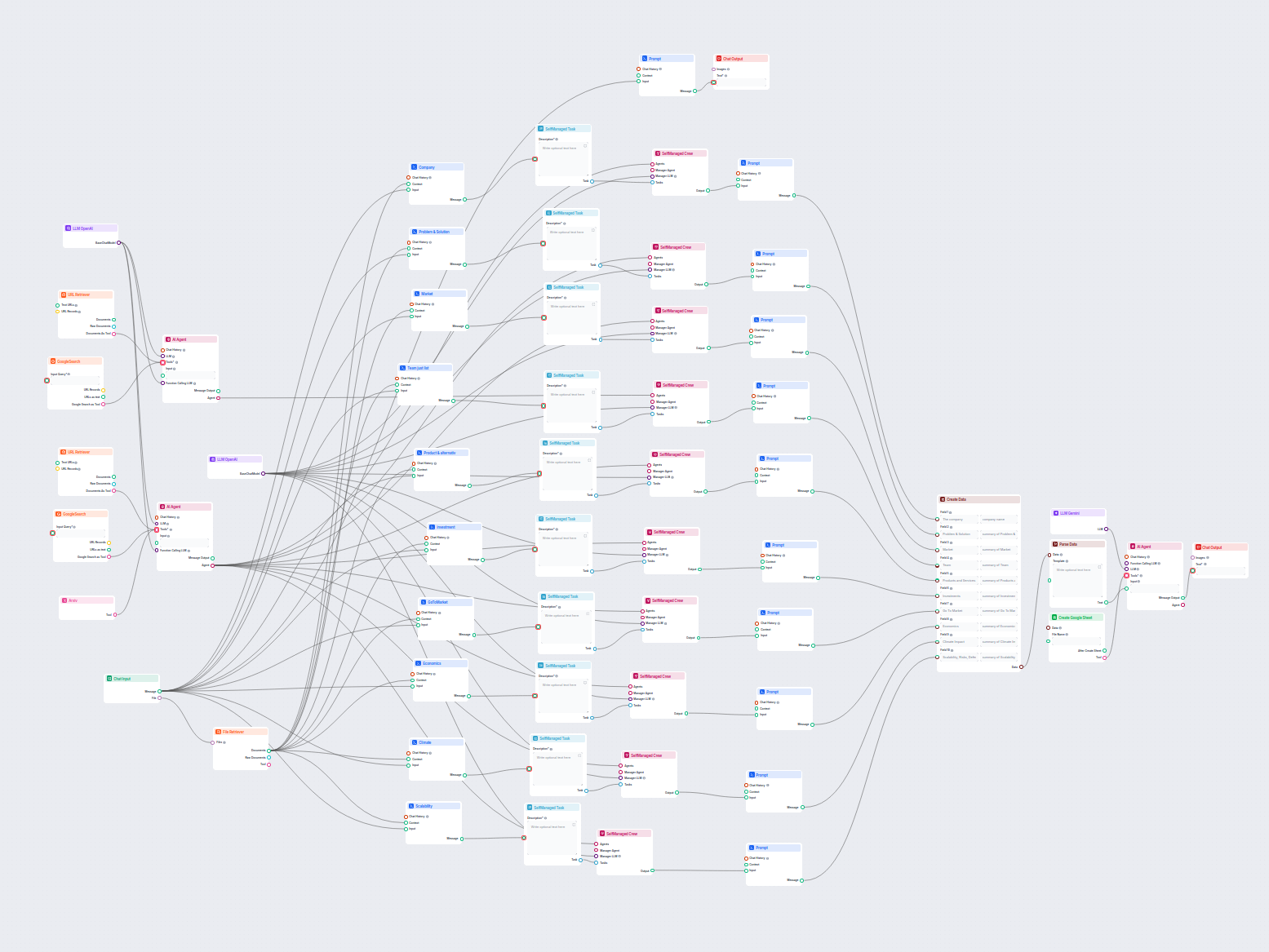

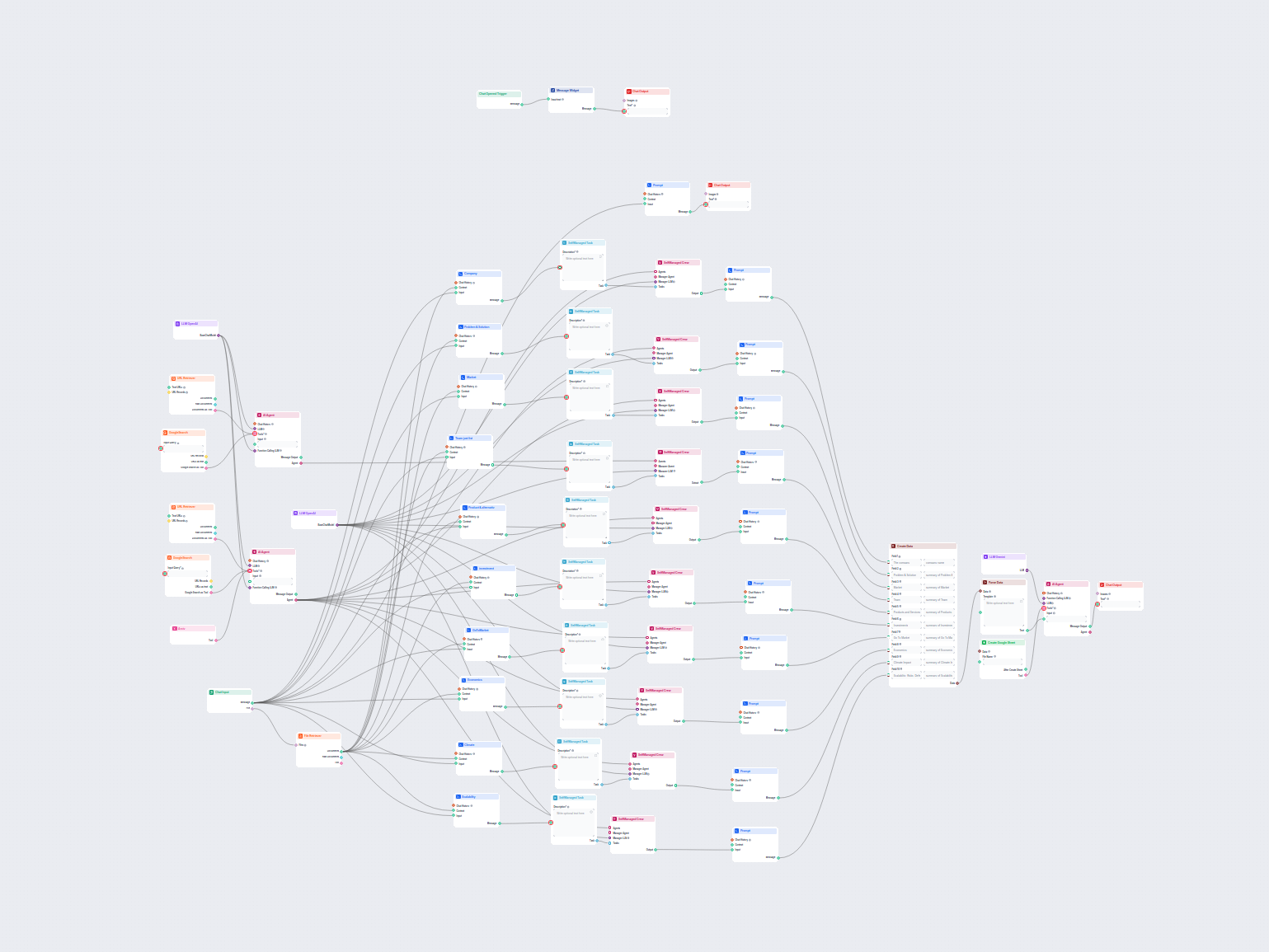

Para ayudarle a comenzar rápidamente, hemos preparado varios ejemplos de plantillas de flujo que demuestran cómo utilizar el componente LLM Gemini de manera efectiva. Estas plantillas muestran diferentes casos de uso y mejores prácticas, facilitando la comprensión e implementación del componente en sus propios proyectos.

Este flujo de trabajo impulsado por IA ofrece un análisis empresarial integral y basado en datos. Recopila información sobre los antecedentes de la empresa, el ...

Este flujo de trabajo con IA analiza en profundidad cualquier empresa investigando datos y documentos públicos, cubriendo mercado, equipo, productos, inversione...

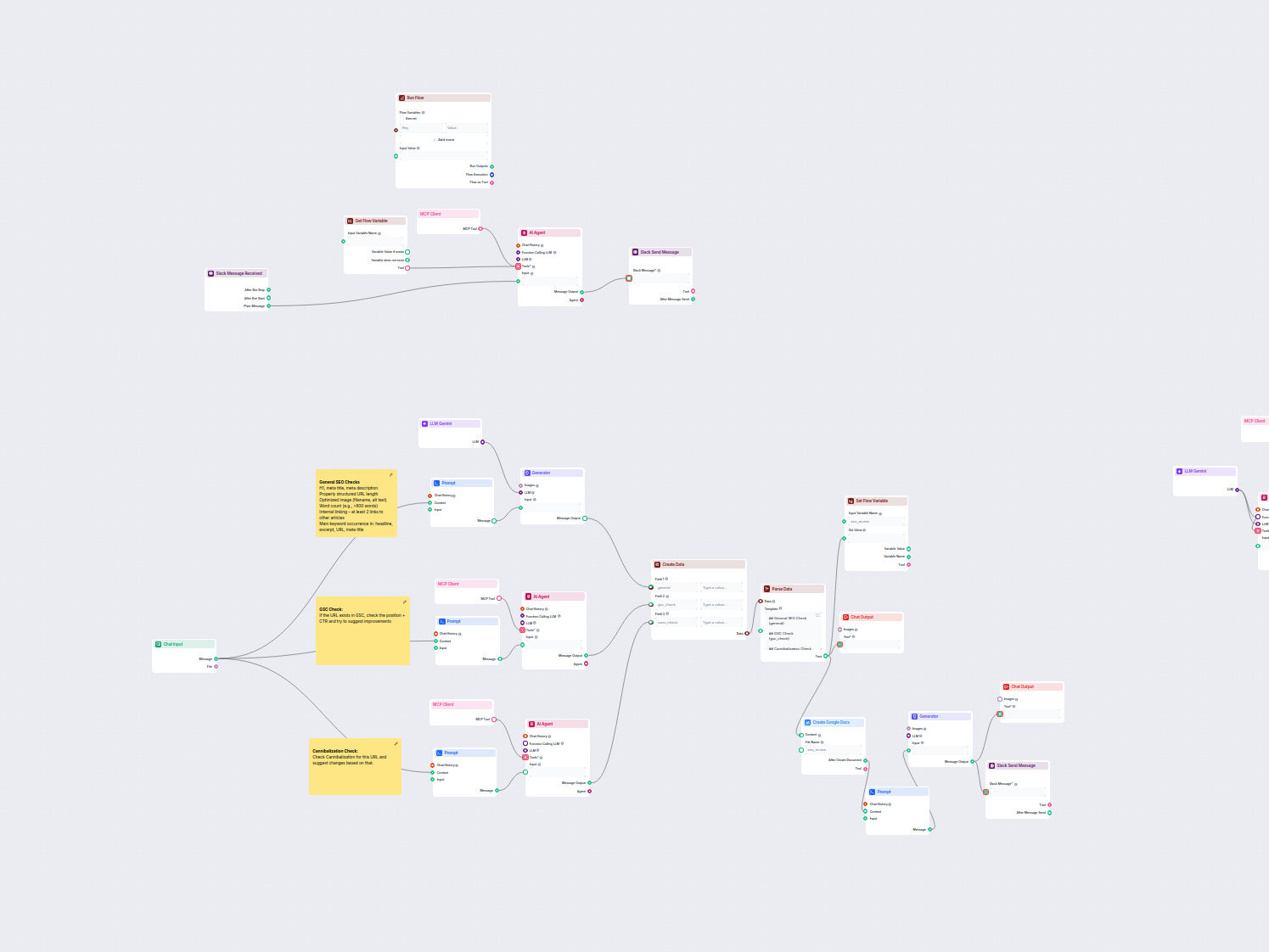

Este flujo de trabajo automatiza el proceso de revisión y auditoría SEO para páginas web. Analiza el contenido de la página en busca de mejores prácticas de SEO...

Este flujo de trabajo extrae y organiza información clave de correos electrónicos y archivos adjuntos, utiliza IA para procesar y estructurar los datos, y entre...

LLM Gemini conecta los modelos Gemini de Google con tus flujos de IA en FlowHunt, permitiéndote elegir entre las últimas variantes de Gemini para generación de texto y personalizar su comportamiento.

FlowHunt es compatible con Gemini 2.0 Flash Experimental, Gemini 1.5 Flash, Gemini 1.5 Flash-8B y Gemini 1.5 Pro—cada uno ofreciendo capacidades únicas para entradas de texto, imagen, audio y video.

Max Tokens limita la longitud de la respuesta, mientras que Temperature controla la creatividad—valores bajos generan respuestas más enfocadas, valores altos permiten mayor variedad. Ambos pueden configurarse por modelo en FlowHunt.

No, el uso de componentes LLM es opcional. Todos los flujos de IA incluyen ChatGPT-4o por defecto, pero agregar LLM Gemini te permite cambiar a modelos de Google y ajustar sus configuraciones.

Comienza a crear chatbots y herramientas de IA avanzadas con Gemini y otros modelos líderes—todo desde un solo panel. Cambia de modelo, personaliza configuraciones y optimiza tus flujos de trabajo.