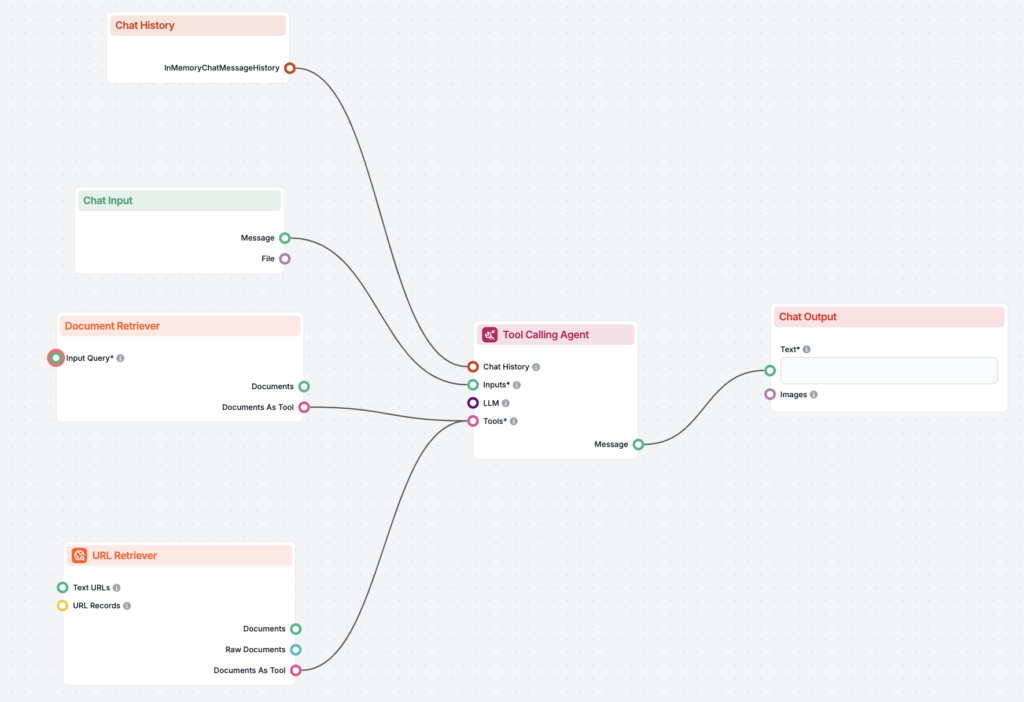

Haz que los LLM verifiquen sus respuestas e incluyan fuentes

¡Mejora la precisión de la IA con RIG! Descubre cómo crear chatbots que verifiquen sus respuestas utilizando tanto fuentes de datos personalizadas como generale...

¡Mejora la precisión de la IA con RIG! Descubre cómo crear chatbots que verifiquen sus respuestas utilizando tanto fuentes de datos personalizadas como generale...

Las heurísticas proporcionan soluciones rápidas y satisfactorias en IA al aprovechar el conocimiento experiencial y reglas generales, simplificando problemas de...

Horovod es un sólido marco de entrenamiento distribuido de aprendizaje profundo de código abierto, diseñado para facilitar el escalado eficiente en múltiples GP...

Hugging Face Transformers es una biblioteca de Python de código abierto líder que facilita la implementación de modelos Transformer para tareas de aprendizaje a...

Human-in-the-Loop (HITL) es un enfoque de IA y aprendizaje automático que integra la experiencia humana en el entrenamiento, ajuste y aplicación de sistemas de ...

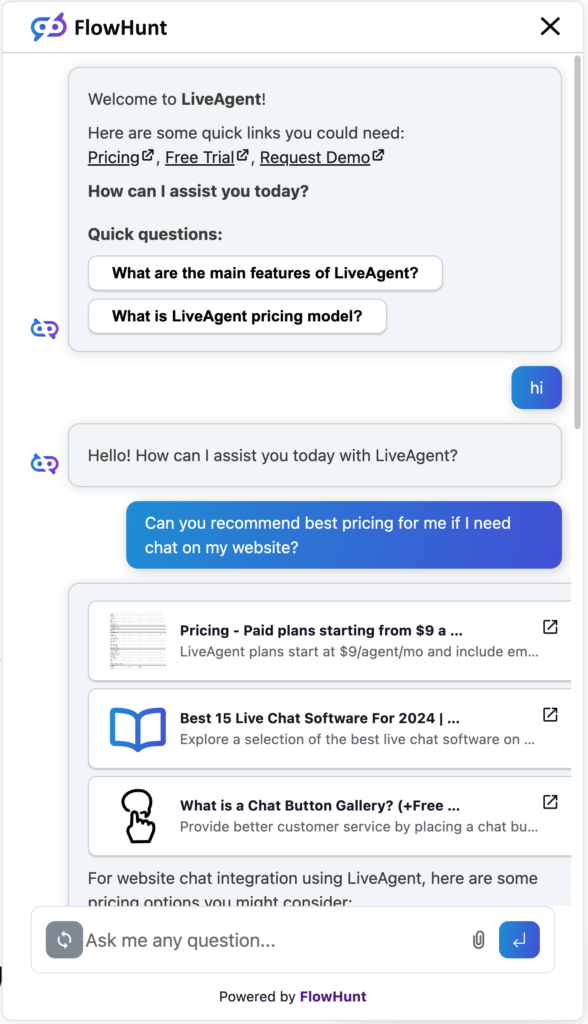

La IA conversacional se refiere a tecnologías que permiten a las computadoras simular conversaciones humanas utilizando PLN, aprendizaje automático y otras tecn...

La Inteligencia Artificial (IA) en ciberseguridad aprovecha tecnologías de IA como el aprendizaje automático y el procesamiento de lenguaje natural (NLP) para d...

La IA está revolucionando el entretenimiento, mejorando los videojuegos, el cine y la música mediante interacciones dinámicas, personalización y evolución de co...

La Inteligencia Artificial (IA) en el sector retail aprovecha tecnologías avanzadas como el aprendizaje automático, el procesamiento del lenguaje natural, la vi...

La Inteligencia Artificial (IA) en el sector salud aprovecha algoritmos avanzados y tecnologías como el aprendizaje automático, PLN y aprendizaje profundo para ...

La Inteligencia Artificial (IA) en la manufactura está transformando la producción al integrar tecnologías avanzadas para aumentar la productividad, la eficienc...

La IA Explicable (XAI) es un conjunto de métodos y procesos diseñados para hacer que los resultados de los modelos de IA sean comprensibles para los humanos, fo...

Explora cómo la Inteligencia Artificial impacta los derechos humanos, equilibrando beneficios como el acceso mejorado a servicios con riesgos como violaciones a...

Descubre cómo la IA está transformando el SEO al automatizar la investigación de palabras clave, la optimización de contenidos y la interacción con el usuario. ...

El Impulso por Gradiente es una potente técnica de ensamblaje de aprendizaje automático para regresión y clasificación. Construye modelos secuencialmente, norma...

La inferencia causal es un enfoque metodológico utilizado para determinar las relaciones de causa y efecto entre variables, crucial en las ciencias para compren...

Explora cómo la Ingeniería y Extracción de Características mejoran el rendimiento de los modelos de IA al transformar datos en bruto en información valiosa. Des...

Descubre el rol de un Ingeniero de Sistemas de IA: diseña, desarrolla y mantiene sistemas de IA, integra aprendizaje automático, gestiona infraestructura y lide...

El Intercambio Abierto de Redes Neuronales (ONNX) es un formato de código abierto para el intercambio fluido de modelos de aprendizaje automático entre diferent...

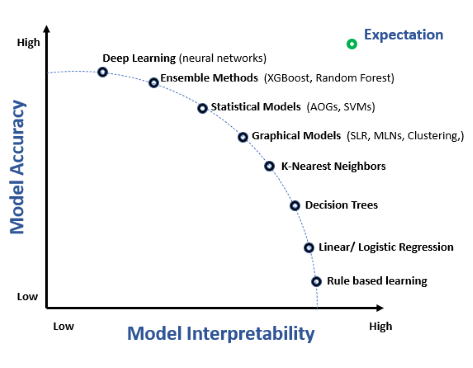

La interpretabilidad de modelos se refiere a la capacidad de comprender, explicar y confiar en las predicciones y decisiones tomadas por modelos de aprendizaje ...

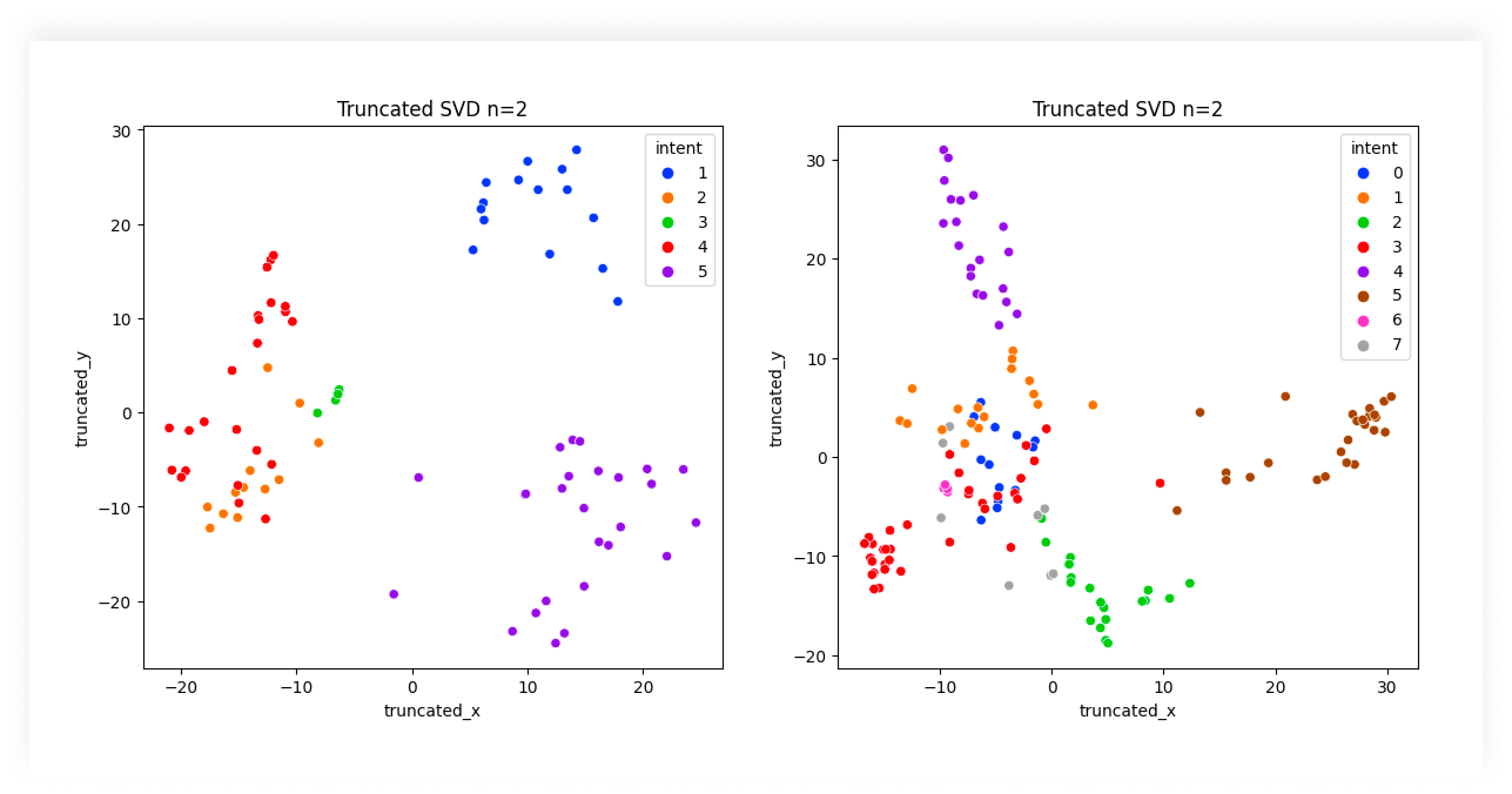

Descubre el papel esencial de la Clasificación de Intenciones en IA para mejorar las interacciones de los usuarios con la tecnología, optimizar el soporte al cl...

Jupyter Notebook es una aplicación web de código abierto que permite a los usuarios crear y compartir documentos con código en vivo, ecuaciones, visualizaciones...

Kaggle es una comunidad y plataforma en línea para científicos de datos e ingenieros de aprendizaje automático para colaborar, aprender, competir y compartir co...

Keras es una API de redes neuronales de alto nivel, potente y fácil de usar, de código abierto, escrita en Python y capaz de ejecutarse sobre TensorFlow, CNTK o...

KNIME (Konstanz Information Miner) es una potente plataforma de análisis de datos de código abierto que ofrece flujos de trabajo visuales, integración de datos ...

Kubeflow es una plataforma de aprendizaje automático (ML) de código abierto sobre Kubernetes, que simplifica el despliegue, la gestión y la escalabilidad de flu...

LightGBM, o Light Gradient Boosting Machine, es un avanzado framework de gradient boosting desarrollado por Microsoft. Diseñado para tareas de aprendizaje autom...

La limpieza de datos es el proceso crucial de detectar y corregir errores o inconsistencias en los datos para mejorar su calidad, asegurando precisión, consiste...

El marketing impulsado por IA aprovecha tecnologías de inteligencia artificial como el aprendizaje automático, el procesamiento del lenguaje natural y la analít...

El Marketing Personalizado con IA aprovecha la inteligencia artificial para adaptar estrategias y comunicaciones de marketing a clientes individuales según sus ...

Una matriz de confusión es una herramienta de aprendizaje automático para evaluar el desempeño de los modelos de clasificación, detallando verdaderos/falsos pos...

La minería de datos es un proceso sofisticado de análisis de grandes conjuntos de datos en bruto para descubrir patrones, relaciones y conocimientos que pueden ...

MLflow es una plataforma de código abierto diseñada para agilizar y gestionar el ciclo de vida del aprendizaje automático (ML). Proporciona herramientas para el...

El modelado predictivo es un proceso sofisticado en la ciencia de datos y la estadística que pronostica resultados futuros analizando patrones de datos históric...

El Modelo de Lenguaje Pathways (PaLM) es la avanzada familia de modelos de lenguaje grande de Google, diseñada para aplicaciones versátiles como generación de t...

Los Modelos de Markov Ocultos (HMM) son sofisticados modelos estadísticos para sistemas donde los estados subyacentes son inobservables. Ampliamente utilizados ...

El Modelo Flux AI de Black Forest Labs es un avanzado sistema de generación de texto a imagen que convierte indicaciones en lenguaje natural en imágenes fotorre...

Un Modelo de IA Fundacional es un modelo de aprendizaje automático a gran escala entrenado con enormes cantidades de datos, adaptable a una amplia variedad de t...

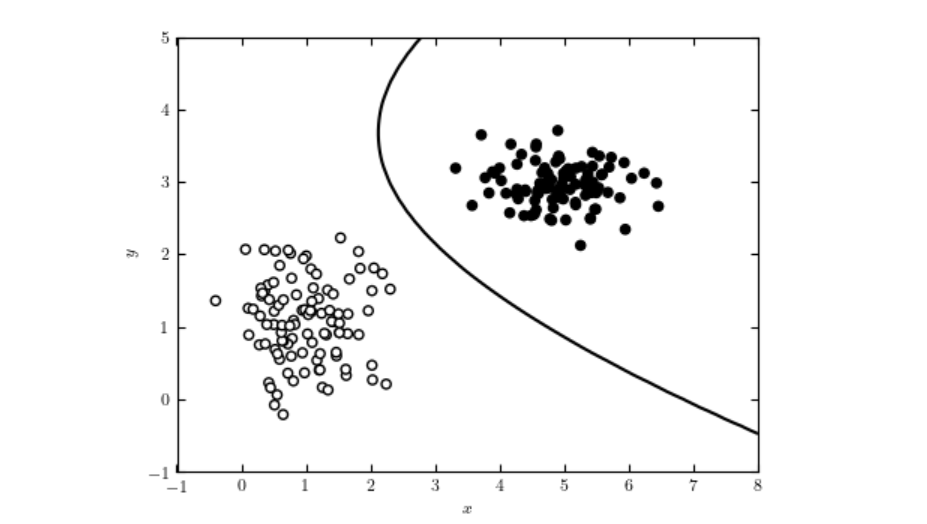

Aprende sobre los Modelos de IA Discriminativos: modelos de aprendizaje automático enfocados en clasificación y regresión mediante el modelado de los límites de...

Descubre qué es un Motor de Insights: una plataforma avanzada impulsada por IA que mejora la búsqueda y el análisis de datos comprendiendo el contexto y la inte...

Apache MXNet es un framework de aprendizaje profundo de código abierto diseñado para el entrenamiento y despliegue eficiente y flexible de redes neuronales prof...

Naive Bayes es una familia de algoritmos de clasificación basados en el Teorema de Bayes, que aplican la probabilidad condicional con la suposición simplificada...

Natural Language Toolkit (NLTK) es un conjunto integral de bibliotecas y programas de Python para el procesamiento de lenguaje natural (PLN) simbólico y estadís...

Las plataformas de IA No-Code permiten a los usuarios crear, desplegar y gestionar modelos de inteligencia artificial y aprendizaje automático sin escribir códi...

La normalización por lotes es una técnica transformadora en el aprendizaje profundo que mejora significativamente el proceso de entrenamiento de redes neuronale...

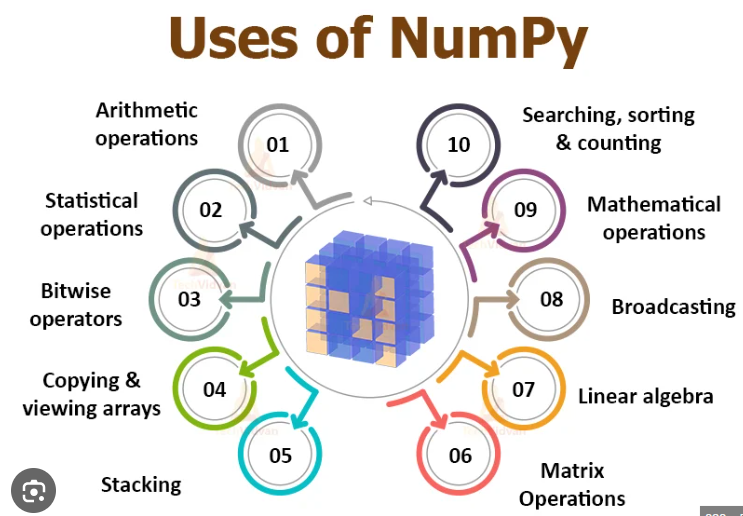

NumPy es una biblioteca de Python de código abierto crucial para la computación numérica, que proporciona operaciones eficientes con arrays y funciones matemáti...

OpenAI es una organización líder en investigación de inteligencia artificial, conocida por desarrollar GPT, DALL-E y ChatGPT, y cuyo objetivo es crear una intel...

OpenCV es una biblioteca avanzada de visión por computadora y aprendizaje automático de código abierto, que ofrece más de 2500 algoritmos para procesamiento de ...

Pandas es una biblioteca de manipulación y análisis de datos de código abierto para Python, reconocida por su versatilidad, estructuras de datos robustas y faci...

La pérdida logarítmica, o pérdida logarítmica/pérdida de entropía cruzada, es una métrica clave para evaluar el rendimiento de modelos de aprendizaje automático...

Perplexity AI es un motor de búsqueda avanzado potenciado por IA y una herramienta conversacional que aprovecha el PLN y el aprendizaje automático para ofrecer ...

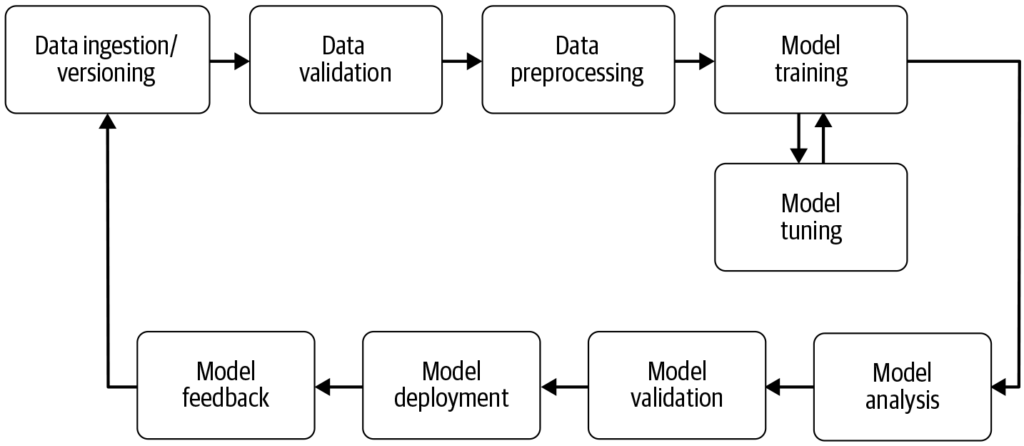

Un pipeline de aprendizaje automático es un flujo de trabajo automatizado que agiliza y estandariza el desarrollo, entrenamiento, evaluación y despliegue de mod...

La potenciación es una técnica de aprendizaje automático que combina las predicciones de varios aprendices débiles para crear un aprendiz fuerte, mejorando la p...

Descubre la importancia de la precisión y la estabilidad del modelo de IA en el aprendizaje automático. Aprende cómo estos indicadores impactan aplicaciones com...

La precisión top-k es una métrica de evaluación de aprendizaje automático que evalúa si la clase verdadera se encuentra entre las k clases predichas principales...

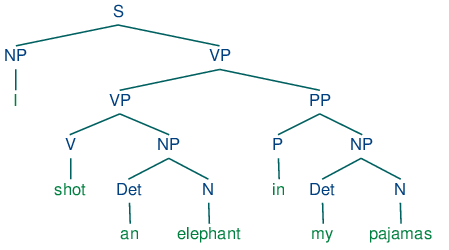

El Procesamiento de Lenguaje Natural (PLN) permite a las computadoras comprender, interpretar y generar lenguaje humano utilizando lingüística computacional, ap...

El Procesamiento de Lenguaje Natural (PLN) es una subárea de la inteligencia artificial (IA) que permite a las computadoras comprender, interpretar y generar le...

El pronóstico financiero es un proceso analítico sofisticado utilizado para predecir los resultados financieros futuros de una empresa mediante el análisis de d...

La Puntuación F, también conocida como Medida F o Puntuación F1, es una métrica estadística utilizada para evaluar la precisión de una prueba o modelo, especial...

PyTorch es un framework de aprendizaje automático de código abierto desarrollado por Meta AI, reconocido por su flexibilidad, gráficos computacionales dinámicos...

Q-learning es un concepto fundamental en inteligencia artificial (IA) y aprendizaje automático, particularmente dentro del aprendizaje por refuerzo. Permite a l...

El R-cuadrado ajustado es una medida estadística utilizada para evaluar la bondad de ajuste de un modelo de regresión, teniendo en cuenta el número de predictor...

El razonamiento es el proceso cognitivo de sacar conclusiones, hacer inferencias o resolver problemas basándose en información, hechos y lógica. Explora su impo...

Explora el recall en aprendizaje automático: una métrica crucial para evaluar el rendimiento del modelo, especialmente en tareas de clasificación donde identifi...

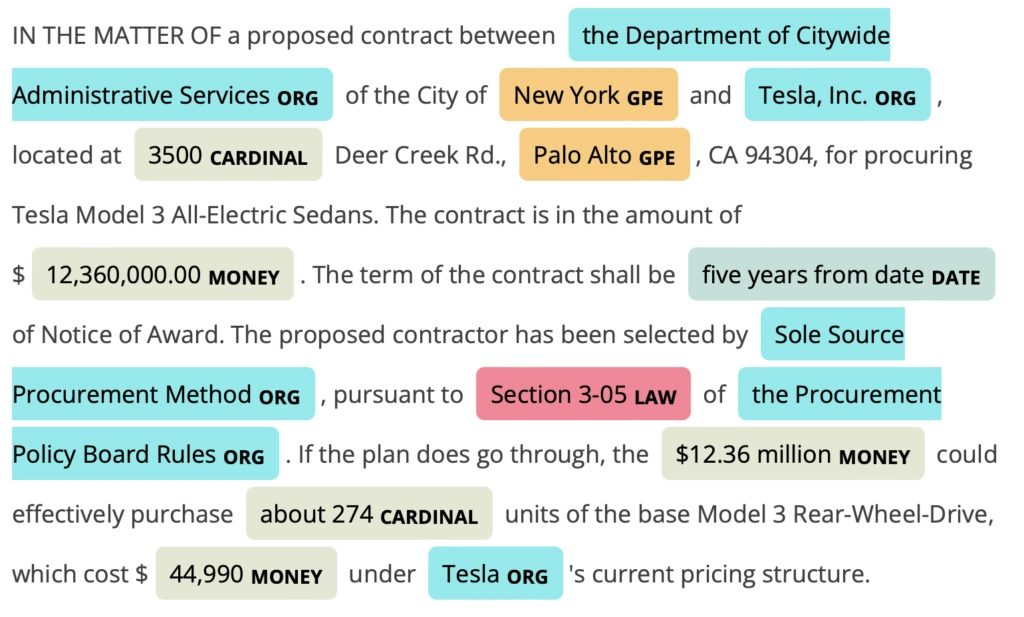

El Reconocimiento de Entidades Nombradas (NER) es un subcampo clave del Procesamiento de Lenguaje Natural (NLP) en IA, enfocado en identificar y clasificar enti...

Descubre qué es el Reconocimiento de Imágenes en IA. Para qué se utiliza, cuáles son las tendencias y en qué se diferencia de tecnologías similares.

El reconocimiento de patrones es un proceso computacional para identificar patrones y regularidades en los datos, crucial en campos como la IA, la informática, ...

El reconocimiento de voz, también conocido como reconocimiento automático de voz (ASR) o conversión de voz a texto, permite a las computadoras interpretar y con...

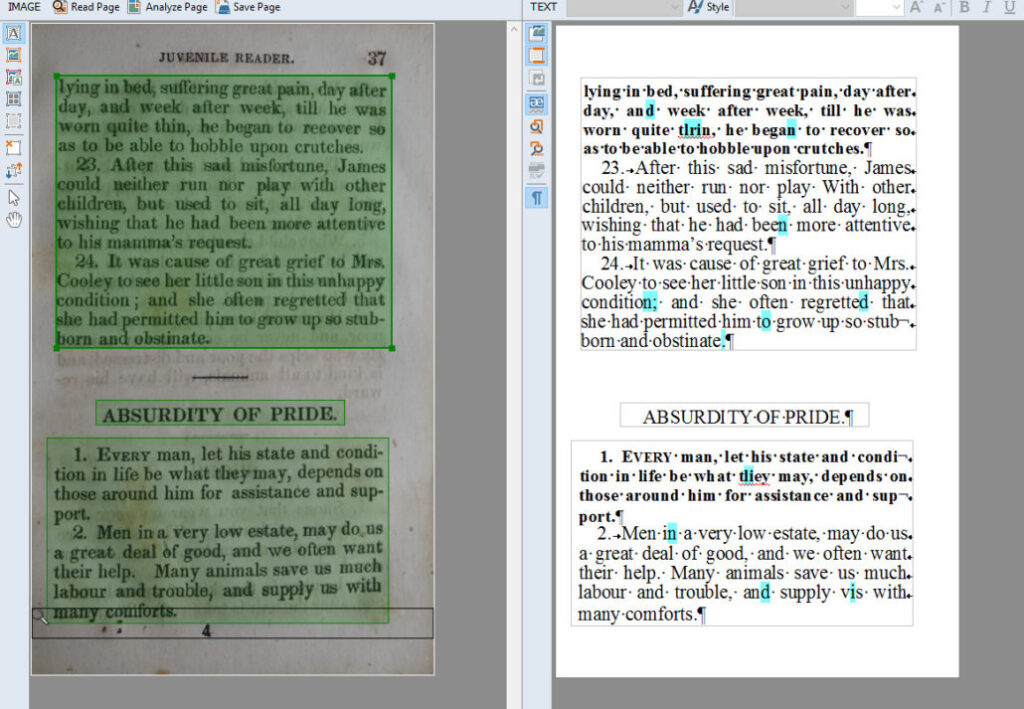

El Reconocimiento Óptico de Caracteres (OCR) es una tecnología transformadora que convierte documentos como papeles escaneados, PDFs o imágenes en datos editabl...

Explora la Reconstrucción 3D: Descubre cómo este proceso avanzado captura objetos o entornos reales y los transforma en modelos 3D detallados usando técnicas co...

La Recuperación de Información aprovecha la IA, el PLN y el aprendizaje automático para recuperar datos de manera eficiente y precisa que satisfagan los requisi...

Una Red Generativa Antagónica (GAN) es un marco de aprendizaje automático con dos redes neuronales—un generador y un discriminador—que compiten para generar dat...

Una Red Bayesiana (BN) es un modelo gráfico probabilístico que representa variables y sus dependencias condicionales mediante un Gráfico Acíclico Dirigido (DAG)...

Una Red de Creencias Profundas (DBN) es un sofisticado modelo generativo que utiliza arquitecturas profundas y Máquinas de Boltzmann Restringidas (RBMs) para ap...

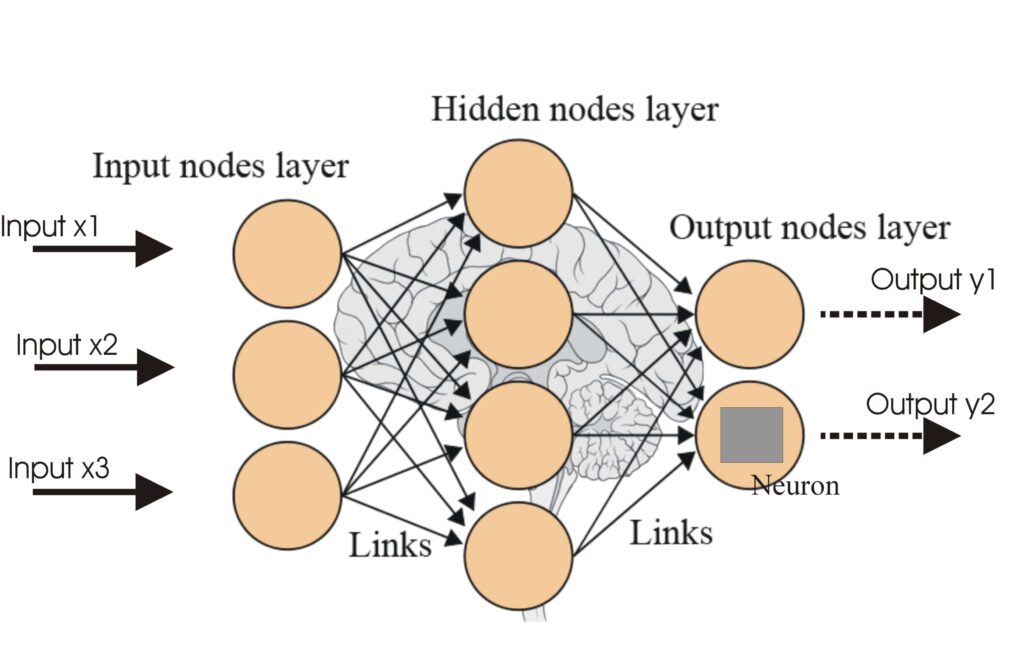

Una red neuronal, o red neuronal artificial (ANN), es un modelo computacional inspirado en el cerebro humano, esencial en la IA y el aprendizaje automático para...

Las Redes Neuronales Artificiales (ANNs) son un subconjunto de algoritmos de aprendizaje automático modelados a partir del cerebro humano. Estos modelos computa...

La reducción de dimensionalidad es una técnica fundamental en el procesamiento de datos y el aprendizaje automático, que reduce el número de variables de entrad...

La Regresión de Bosques Aleatorios es un potente algoritmo de aprendizaje automático utilizado para análisis predictivo. Construye múltiples árboles de decisión...

La regresión lineal es una técnica analítica fundamental en estadística y aprendizaje automático, que modela la relación entre variables dependientes e independ...

La regresión logística es un método estadístico y de aprendizaje automático utilizado para predecir resultados binarios a partir de datos. Estima la probabilida...

La regularización en inteligencia artificial (IA) se refiere a un conjunto de técnicas utilizadas para evitar el sobreajuste en los modelos de aprendizaje autom...

La resolución de correferencia es una tarea fundamental del PLN que identifica y vincula expresiones en el texto que se refieren a la misma entidad, crucial par...

La retroalimentación estudiantil basada en IA utiliza inteligencia artificial para ofrecer ideas y sugerencias evaluativas personalizadas y en tiempo real a los...

La retropropagación es un algoritmo para entrenar redes neuronales artificiales ajustando los pesos para minimizar el error de predicción. Descubre cómo funcion...

La inteligencia artificial (IA) en la revisión de documentos legales representa un cambio significativo en la forma en que los profesionales del derecho gestion...

La robustez del modelo se refiere a la capacidad de un modelo de aprendizaje automático (ML) para mantener un rendimiento consistente y preciso a pesar de las v...

Scikit-learn es una potente biblioteca de aprendizaje automático de código abierto para Python, que proporciona herramientas simples y eficientes para el anális...

SciPy es una robusta biblioteca de Python de código abierto para computación científica y técnica. Basada en NumPy, ofrece algoritmos matemáticos avanzados, opt...

Descubre qué es un SDR de IA y cómo los Representantes de Desarrollo de Ventas con Inteligencia Artificial automatizan la prospección, la calificación de leads,...

Explora el sesgo en IA: comprende sus fuentes, impacto en el aprendizaje automático, ejemplos del mundo real y estrategias de mitigación para construir sistemas...

Un Sistema de Automatización con IA integra tecnologías de inteligencia artificial con procesos de automatización, mejorando la automatización tradicional con h...

El sobreajuste es un concepto crítico en la inteligencia artificial (IA) y el aprendizaje automático (ML), que ocurre cuando un modelo aprende demasiado bien lo...

spaCy es una robusta biblioteca de Python de código abierto para el Procesamiento de Lenguaje Natural (PLN) avanzado, conocida por su velocidad, eficiencia y ca...

Stable Diffusion es un modelo avanzado de generación de imágenes a partir de texto que utiliza aprendizaje profundo para producir imágenes fotorrealistas y de a...

Una startup impulsada por IA es una empresa que centra sus operaciones, productos o servicios en tecnologías de inteligencia artificial para innovar, automatiza...

El subajuste ocurre cuando un modelo de aprendizaje automático es demasiado simple para captar las tendencias subyacentes de los datos con los que se entrena. E...

La Superinteligencia Artificial (ASI) es una IA teórica que supera la inteligencia humana en todos los ámbitos, con capacidades multimodales y de auto-mejora. D...

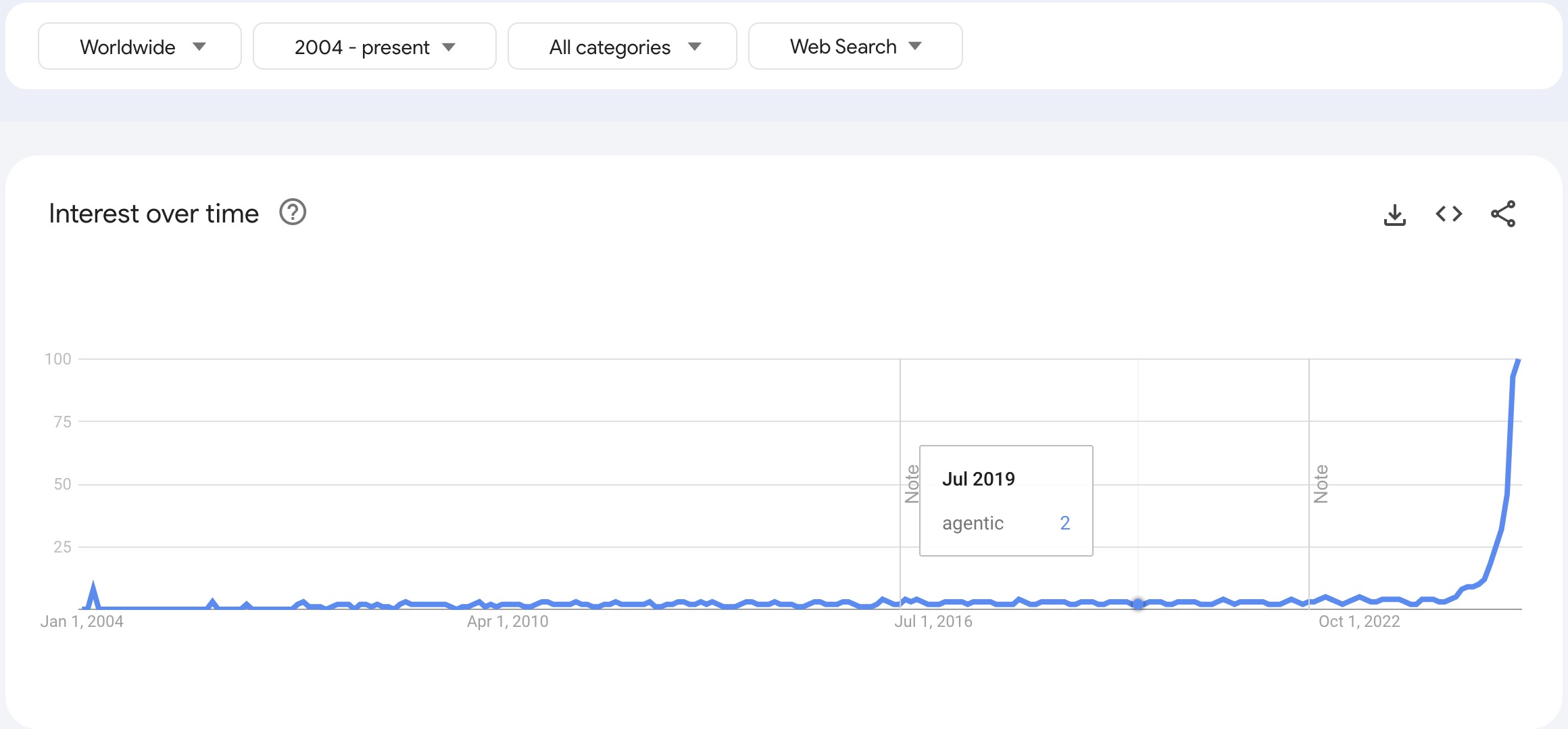

Las tendencias en tecnología de IA abarcan los avances actuales y emergentes en inteligencia artificial, incluyendo aprendizaje automático, grandes modelos de l...

Explora las principales tendencias de IA para 2025, incluido el auge de los agentes de IA y las tripulaciones de IA, y descubre cómo estas innovaciones están tr...

TensorFlow es una biblioteca de código abierto desarrollada por el equipo de Google Brain, diseñada para el cálculo numérico y el aprendizaje automático a gran ...