Hallusinaatio

Hallusinaatio kielimalleissa tapahtuu, kun tekoäly tuottaa tekstiä, joka vaikuttaa uskottavalta, mutta on todellisuudessa virheellistä tai keksittyä. Lue lisää ...

Mitä ovat hallusinaatiot tekoälyssä, miksi niitä tapahtuu ja miten voit välttää ne? Opi pitämään tekoälychatbottisi vastaukset tarkkoina käytännöllisillä, ihmiskeskeisillä strategioilla.

Tekoälychatbotit ovat älykkäämpiä kuin koskaan, mutta joskus ne keksivät asioita täysin tyhjästä. Näitä virheitä kutsutaan “hallusinaatioiksi”, ja ne voivat muuttaa hyödyllisen avustajan sekaannuksen tai jopa riskin lähteeksi. Jos haluat luotettavia vastauksia, sinun täytyy ymmärtää mitä hallusinaatiot ovat, miksi niitä tapahtuu ja miten ne pysäytetään ennen kuin ne aiheuttavat ongelmia.

Hallusinaatio tekoälyssä tarkoittaa, että chatbot tai kielimalli antaa vastauksen, joka kuulostaa oikealta, mutta on todellisuudessa väärä, keksitty tai jopa mahdoton. Nämä virheet eivät ole satunnaisia kirjoitusvirheitä, vaan itsevarmoja, uskottavan kuuloisia väitteitä, joilla ei ole todellisuuspohjaa.

Esimerkiksi voit kysyä chatbotilta: “Kuka voitti fysiikan Nobelin vuonna 2025?” Jos mallilla ei ole ajantasaista tietoa, se saattaa keksiä nimen myöntämättä, ettei tiedä. Toisin kuin hakukone, joka palauttaa “ei tuloksia”, chatbot saattaa täyttää aukot joskus jopa vakuuttavilla mutta väärillä yksityiskohdilla.

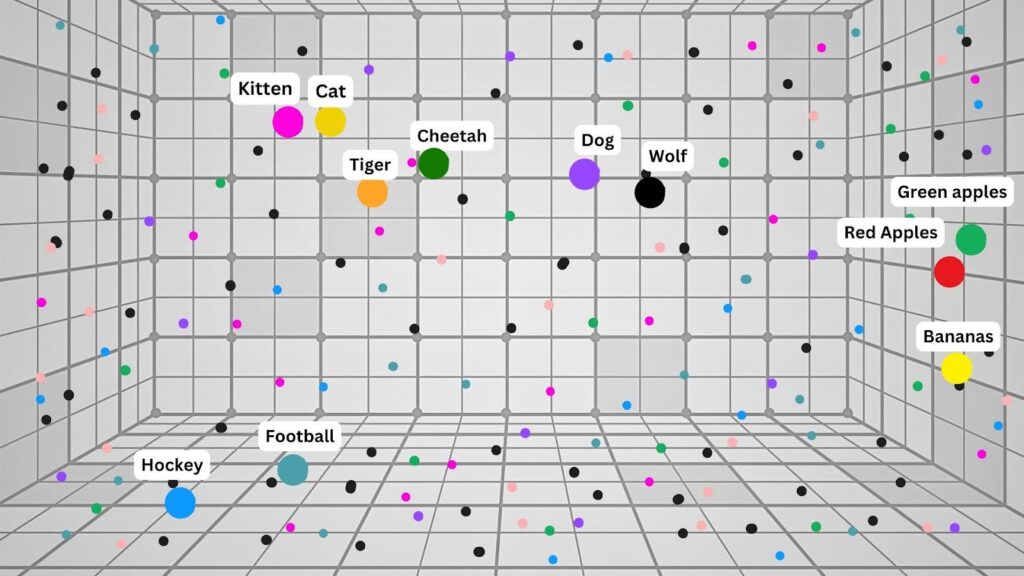

Hallusinaatiot eivät ole bugi, vaan seurausta siitä, kuinka isot kielimallit (LLM:t) kuten ChatGPT, Copilot tai Gemini toimivat. Nämä mallit:

Yleisiä hallusinaatioiden syitä:

Vaikka mikään tekoäly ei ole täydellinen, on olemassa todistetusti toimivia tapoja vähentää hallusinaatioita ja parantaa vastausten laatua. Tässä parhaat käytännöt:

Modernit tekoälytyökalut voivat yhdistää tietokantoihin, hakukoneisiin tai yrityksen wikiin. Tärkeissä tehtävissä anna tekoälylle aina luotettava konteksti tai ohjaa se luotettaviin lähteisiin.

Älä tyydy pelkkään vastaukseen, vaan pyydä tekoälyä antamaan lähteet, linkit tai ainakin selitys, miten se päätyi johtopäätökseen.

Esimerkkipyyntö:

Käytä vain toimitettua yrityksen käsikirjaa ja viimeisintä verkkohakua vastataksesi tähän kysymykseen. Listaa lähteesi ja perustele vastauksesi.

Tämä auttaa paitsi tarkistamaan vastauksen, myös opettaa tekoälyä tarkistamaan itseään.

Mitä tarkempi kysymyksesi on, sitä parempi lopputulos. Kerro tekoälylle, mitä tietoa tulee käyttää, mitä välttää ja missä muodossa haluat vastauksen. Esimerkiksi:

Tiivistä tärkeimmät havainnot liitteenä olevasta markkinaraportista (2024 painos). Jos tietoa puuttuu, sano "ei löydy" sen sijaan, että tekisit oletuksia.

Monet kehittyneet chatbotit tarjoavat reaaliaikaisia hakulaajennuksia, hakutuloksiin perustuvaa generointia (RAG) tai integraatiota yrityksen tietopankkeihin. Käytä näitä aina, jos tarvitaan ajantasaista tai faktoihin perustuvaa tarkkuutta.

Olipa chatbot kuinka kehittynyt tahansa, ihmisen valvonta on kriittistä. Tarkista tärkeät tuotokset aina, erityisesti herkissä aloissa kuten terveydenhuollossa, taloudessa tai juridiikassa.

“Ihminen silmukassa” tarkoittaa:

Haluatko oppia lisää human-in-the-loop-strategioista? Pysy kuulolla, sillä tulossa on erillinen artikkeli tästä aiheesta!

Tekoälyn hallusinaatioita voi tapahtua mille tahansa chatbotille – myös parhaimmille. Avain on ymmärtää miksi näitä virheitä syntyy ja toimia niiden tunnistamiseksi ajoissa:

Näillä tavoilla muutat chatbotin “luovasta tarinankertojasta” luotettavaksi avustajaksi, mutta pidät lopullisen vastuun (ja harkinnan) omissa käsissäsi.

Haluatko ottaa tekoälyn käyttöön työssäsi? Saat käytännön oppaita, tosielämän käyttötapauksia ja vaiheittaisia työnkulkuja kiireisille ammattilaisille. Sähköpostien kirjoittamisesta kokousmuistioiden automaatioon, AI Academy auttaa sinua työskentelemään fiksummin tekoälyn avulla.

👉 Tutustu lisää AI Academyssa ja aloita kokeilu jo tänään!

Autamme kaltaisiasi yrityksiä kehittämään älykkäitä chatbotteja, MCP-palvelimia, AI-työkaluja tai muuntyyppisiä AI-automaatioratkaisuja korvaamaan ihmisiä toistuvissa tehtävissä organisaatiossasi.

Hallusinaatio kielimalleissa tapahtuu, kun tekoäly tuottaa tekstiä, joka vaikuttaa uskottavalta, mutta on todellisuudessa virheellistä tai keksittyä. Lue lisää ...

Paranna AI-chatbottisi tarkkuutta FlowHuntin ohita indeksointi -ominaisuudella. Sulje pois sopimaton sisältö, jotta keskustelut pysyvät relevantteina ja turvall...

Tutustu Human in the Loopin (HITL) merkitykseen ja sovelluksiin tekoälychatboteissa, joissa ihmisen asiantuntemus parantaa tekoälyjärjestelmiä tuoden lisää tark...