Ihminen mukana – Yritysjohtajan opas vastuulliseen tekoälyyn

Käytännön opas yritysjohtajille Human-in-the-Loop (HITL) -kehysten toteuttamiseen vastuullisen tekoälyn hallintaan, riskien vähentämiseen, vaatimustenmukaisuute...

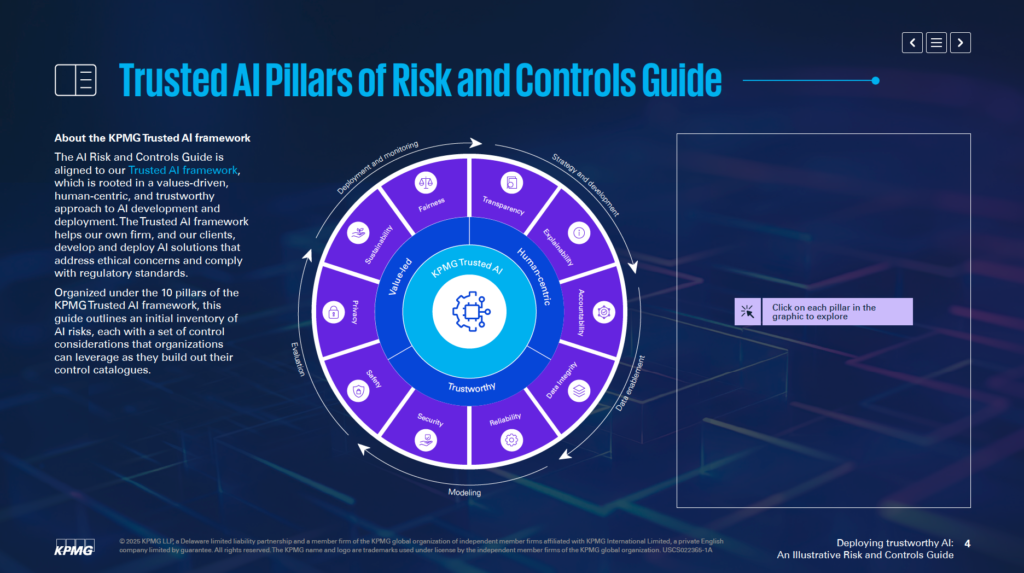

KPMG:n tekoälyn riskien ja valvonnan opas tarjoaa organisaatioille jäsennellyn, eettisen lähestymistavan tekoälyn riskien hallintaan, tukien vastuullista käyttöönottoa ja kansainvälisten standardien noudattamista.

Tämä ensimmäinen tilasto saattaa olla viime vuodelta, mutta se ei voisi olla ajankohtaisempi. KPMG:n vuoden 2024 Yhdysvaltain toimitusjohtajan näkymien mukaan peräti 68 % toimitusjohtajista pitää tekoälyä yhtenä tärkeimmistä investointikohteista. He odottavat sen parantavan tehokkuutta, kehittävän henkilöstön osaamista ja vauhdittavan innovaatiota koko organisaatiossa.

Tämä on merkittävä luottamuksenosoitus tekoälylle – mutta samalla herää tärkeä kysymys: kun panokset ovat näin suuret, miten organisaatiot varmistavat tekoälyn vastuullisen ja eettisen käytön?

Tässä kohtaa KPMG:n tekoälyn riskien ja valvonnan opas astuu kuvaan. Se tarjoaa selkeän ja käytännönläheisen viitekehyksen, jonka avulla organisaatiot voivat hyödyntää tekoälyn mahdollisuuksia hallitusti ja riskit huomioiden. Nykymaailmassa luotettavan tekoälyn rakentaminen ei ole pelkkä hyvä käytäntö – se on liiketoiminnan elinehto.

Tekoäly (AI) mullistaa toimialoja, avaa uusia tehokkuuden, innovaation ja kilpailukyvyn tasoja. Muutoksen myötä syntyy kuitenkin myös erityisiä riskejä ja eettisiä haasteita, joiden hallinta on ratkaisevan tärkeää luottamuksen säilyttämiseksi ja vastuullisen käytön varmistamiseksi. KPMG:n tekoälyn riskien ja valvonnan opas tukee organisaatioita näiden monimutkaisuuksien hallinnassa tarjoten käytännöllisen, jäsennellyn ja arvolähtöisen lähestymistavan tekoälyn hallintaan.

KPMG:n Trusted AI -viitekehykseen pohjautuva opas auttaa yrityksiä kehittämään ja ottamaan käyttöön tekoälyratkaisuja, jotka ovat eettisiä, ihmiskeskeisiä ja kansainvälisten säännösten mukaisia. Opas rakentuu 10 peruspilarin ympärille, joista jokainen käsittelee tekoälyn riskienhallinnan kannalta oleellista osa-aluetta:

Näihin pilareihin keskittymällä organisaatiot voivat sisällyttää eettisiä periaatteita tekoälyn koko elinkaareen – strategiasta ja kehityksestä käyttöönottoon ja valvontaan asti. Opas ei ainoastaan vahvista riskienhallintaa, vaan myös edistää kestävää, luotettavaa ja yhteiskunnan odotusten mukaista innovaatiota.

Olitpa riskienhallinnan ammattilainen, johtoryhmän jäsen, datatieteilijä tai lakineuvoja, tämä opas tarjoaa olennaisia työkaluja ja näkemyksiä tekoälyn vastuulliseen hyödyntämiseen.

KPMG:n tekoälyn riskien ja valvonnan opas on erikoistunut resurssi, joka auttaa organisaatioita hallitsemaan tekoälyyn liittyviä erityisriskejä. Opas tunnistaa, että tekoäly tarjoaa merkittäviä mahdollisuuksia, mutta sen monimutkaisuus ja eettiset kysymykset vaativat kohdennettua riskienhallintaa. Se tarjoaa jäsennellyn viitekehyksen näiden haasteiden vastuulliseen ja tehokkaaseen hallintaan.

Opas ei ole tarkoitettu korvaamaan nykyisiä järjestelmiä, vaan täydentämään olemassa olevia riskienhallintaprosesseja. Sen päätavoitteena on tuoda tekoälykohtaiset näkökulmat osaksi organisaation hallintorakenteita ja varmistaa sujuva yhteensopivuus nykyisten toimintamallien kanssa. Näin organisaatiot voivat vahvistaa riskienhallintaansa ilman, että koko viitekehystä tarvitsee uudistaa.

Opas perustuu KPMG:n Trusted AI -viitekehykseen, joka painottaa arvolähtöistä ja ihmiskeskeistä tekoälyä. Siihen on integroitu periaatteita laajalti tunnustetuista standardeista, kuten ISO 42001, NIST:n AI Risk Management Framework ja EU:n tekoälyasetus. Tämä takaa, että opas on sekä käytännöllinen että kansainvälisesti tunnustettujen parhaiden käytäntöjen ja sääntelyvaatimusten mukainen.

Opas tarjoaa konkreettisia esimerkkejä ja käytännönläheisiä ratkaisuja tekoälyyn liittyvien riskien hallintaan. Se kannustaa organisaatioita soveltamaan näitä esimerkkejä omaan toimintaympäristöönsä huomioiden esimerkiksi, ovatko tekoälyjärjestelmät kehitetty itse vai hankittu ulkopuolelta sekä käytettyjen tietojen ja tekniikoiden luonne. Tämä mukautuvuus varmistaa, että opas soveltuu eri toimialoille ja tekoälyn käyttötapauksiin.

Opas auttaa organisaatioita ottamaan käyttöön tekoälyteknologioita turvallisesti, eettisesti ja läpinäkyvästi. Käsittelemällä tekoälyn teknisiä, operatiivisia ja eettisiä riskejä, se auttaa rakentamaan luottamusta sidosryhmien keskuudessa ja hyödyntämään tekoälyn muutosvoimaa vastuullisesti.

Opas toimii resurssina, jonka avulla tekoälyjärjestelmät tukevat liiketoiminnan tavoitteita riskit minimoiden. Se mahdollistaa innovaation tavalla, joka painottaa vastuullisuutta ja läpinäkyvyyttä.

KPMG:n tekoälyn hallintaopas on suunnattu ammattilaisille, jotka vastaavat tekoälyn käyttöönotosta ja varmistavat, että se toteutetaan turvallisesti, eettisesti ja tehokkaasti. Opas soveltuu organisaatioiden eri osa-alueille, kuten:

Johtoryhmän jäsenet, kuten toimitusjohtajat, tietohallintojohtajat ja teknologiajohtajat hyötyvät oppaasta hallinnoidessaan tekoälyä strategisena painopisteenä. KPMG:n vuoden 2024 US CEO Outlookin mukaan 68 % toimitusjohtajista pitää tekoälyä keskeisenä investointikohteena. Tämä opas auttaa johtoa yhdistämään tekoälystrategiat organisaation tavoitteisiin riskit huomioiden.

Ohjelmistokehittäjät, datatieteilijät ja muut tekoälyratkaisujen rakentamisesta ja käyttöönotosta vastaavat voivat hyödyntää opasta eettisten periaatteiden ja vahvojen kontrollien sisällyttämiseen järjestelmiinsä. Opas ohjaa riskienhallinnan räätälöimistä tekoälymallien arkkitehtuuriin ja datavirtoihin sopivaksi.

Opas soveltuu yrityksille, jotka kehittävät tekoälyjärjestelmiä itse, hankkivat niitä ulkopuolisilta tai hyödyntävät omia tietovarantojaan. Se on erityisen ajankohtainen toimialoilla kuten rahoitus, terveydenhuolto ja teknologia, joissa kehittynyt tekoäly ja arkaluontoinen data ovat keskeisessä roolissa.

Tekoälyn käyttöönotto ilman selkeää hallintaviitekehystä voi altistaa taloudellisille, sääntelyyn liittyville ja maineen riskeille. KPMG:n opas tukee olemassa olevia prosesseja tarjoten jäsennellyn ja eettisen lähestymistavan tekoälyn riskienhallintaan. Se korostaa vastuullisuutta, läpinäkyvyyttä ja eettisiä käytäntöjä, jotta organisaatiot voivat hyödyntää tekoälyä vastuullisesti ja turvallisesti.

Organisaatioiden tulisi aloittaa liittämällä tekoälyyn liittyvät riskit olemassa olevaan riskitaksonomiaansa. Riskitaksonomia on jäsennelty viitekehys, jonka avulla tunnistetaan, järjestetään ja hallitaan potentiaalisia haavoittuvuuksia. Koska tekoäly tuo mukanaan uusia haasteita, perinteisiä taksonomioita tulee laajentaa sisältämään tekoälykohtaisia tekijöitä, kuten datavirtojen oikeellisuus, algoritmien logiikka ja tietolähteiden luotettavuus. Näin tekoälyriskit liitetään osaksi laajempaa riskienhallintaa, eikä niitä käsitellä irrallaan muista riskeistä.

Opas korostaa, että on tärkeää arvioida tekoälyjärjestelmien koko elinkaari. Keskeisiä tarkasteltavia alueita ovat datan alkuperä, sen kulku prosesseissa ja tekoälymallin perustana oleva logiikka. Näin voidaan tunnistaa haavoittuvuudet kehityksen ja käytön eri vaiheissa.

Tekoälyjärjestelmät eroavat toisistaan käyttötarkoituksen, kehitystavan ja datatyypin mukaan. Mallin kehittäminen itse tai hankinta ulkopuolelta vaikuttaa riskeihin merkittävästi. Samoin datan luonne – onko se omaa, julkista vai arkaluontoista – samoin kuin hyödynnetyt tekniikat, edellyttävät yksilöllisiä riskienhallintastrategioita.

Opas suosittelee kontrollitoimien mukauttamista tekoälyjärjestelmien erityistarpeisiin. Jos esimerkiksi käytät omaa dataa, saatat tarvita tiukempia käyttöoikeusrajoituksia. Ulkopuoliselta hankittu järjestelmä taas edellyttää perusteellista kolmannen osapuolen riskienarviointia. Kontrollien räätälöinti auttaa vastaamaan tekoälyjärjestelmien erityishaasteisiin tehokkaammin.

Opas suosittelee riskienhallintakäytäntöjen sisällyttämistä tekoälyn kaikkiin elinkaaren vaiheisiin. Tämä tarkoittaa riskien huomioimista jo suunnitteluvaiheessa, vahvojen valvontajärjestelmien rakentamista käyttöönoton yhteydessä ja riskien säännöllistä uudelleenarviointia järjestelmän kehittyessä. Kun riskeihin puututaan jokaisessa vaiheessa, haavoittuvuudet vähenevät ja tekoälyjärjestelmät pysyvät eettisinä ja luotettavina.

Aloittamalla tekoälyriskien yhdistämisestä nykyiseen riskitaksonomiaan ja räätälöimällä kontrollit tarpeidesi mukaan luot vahvan pohjan luotettavalle tekoälylle. Näin organisaatiot voivat tunnistaa, arvioida ja hallita riskejä järjestelmällisesti ja rakentaa kestävän hallintaviitekehyksen tekoälylle.

KPMG:n Trusted AI -viitekehys rakentuu kymmenen peruspilarin varaan, jotka kattavat tekoälyn eettiset, tekniset ja operatiiviset haasteet. Nämä pilarit ohjaavat organisaatioita suunnittelemaan, kehittämään ja ottamaan käyttöön tekoälyjärjestelmiä vastuullisesti – luottamus ja vastuu säilyvät tekoälyn elinkaaren kaikissa vaiheissa.

Ihmisen valvonta ja vastuu tulee huomioida tekoälyn jokaisessa vaiheessa. Tämä tarkoittaa vastuuhenkilöiden nimeämistä tekoälyriskien hallintaan, sääntöjen ja lakien noudattamisen varmistamista sekä valmiutta puuttua, ohittaa tai kumota tekoälypäätöksiä tarvittaessa.

Tekoälyjärjestelmien tulee pyrkiä vähentämään tai poistamaan harhaa, joka voi vaikuttaa kielteisesti yksilöihin, yhteisöihin tai ryhmiin. Tämä edellyttää datan huolellista tarkastelua monimuotoisuuden varmistamiseksi, oikeudenmukaisuusmittareiden käyttöä kehityksessä ja tulosten jatkuvaa seurantaa tasapuolisen kohtelun takaamiseksi.

Läpinäkyvyys edellyttää avointa tiedottamista tekoälyjärjestelmien toiminnasta ja päätöksenteon perusteista. Tämä sisältää järjestelmän rajoitteiden, suorituskyvyn ja testaustapojen dokumentoinnin. Käyttäjille tulee ilmoittaa, kun heidän tietojaan kerätään, tekoälyn tuottama sisältö tulee merkitä selkeästi ja esimerkiksi biometrisen luokittelun kaltaisissa sovelluksissa käyttäjiä on tiedotettava selkeästi.

Tekoälyjärjestelmien on pystyttävä tarjoamaan ymmärrettävät perustelut päätöksilleen. Tämän saavuttamiseksi organisaatioiden tulee dokumentoida datat, algoritmit ja suorituskykymittarit yksityiskohtaisesti, jotta sidosryhmät voivat analysoida ja toistaa tulokset luotettavasti.

Datan laatu ja luotettavuus koko elinkaaren ajan – keruusta, merkinnöistä ja säilytyksestä analyysiin – ovat olennaisia. Kontrollit tulee asettaa esimerkiksi datan korruptoitumisen tai harhaisuuden varalta. Datan laadun säännöllinen tarkistus ja regressiotestit järjestelmäpäivitysten yhteydessä auttavat ylläpitämään tekoälyn tarkkuutta ja luotettavuutta.

Tekoälyratkaisujen on noudatettava tietosuoja- ja yksityisyyslakeja. Organisaatioiden tulee käsitellä rekisteröityjen pyyntöjä asianmukaisesti, tehdä tietosuojavaikutusten arviointeja ja käyttää kehittyneitä menetelmiä, kuten differentiaalista yksityisyyttä, jotta datan hyödynnettävyys ja yksilöiden suoja voidaan yhdistää.

Tekoälyjärjestelmien tulee toimia johdonmukaisesti tarkoituksensa ja vaaditun tarkkuuden mukaisesti. Tämä edellyttää perusteellista testausta, poikkeamien tunnistamiseen soveltuvia mekanismeja ja jatkuvia palautesilmukoita järjestelmän tulosten varmentamiseksi.

Turvatoimet suojaavat tekoälyjärjestelmiä vahingoittamasta yksilöitä, yrityksiä tai omaisuutta. Näihin sisältyy varmistusrakenteiden suunnittelu, esimerkiksi datan myrkyttämisen tai prompt injection -hyökkäysten seuranta, sekä järjestelmien yhdenmukaisuus eettisten ja operatiivisten standardien kanssa.

Vahvat turvallisuuskäytännöt ovat välttämättömiä tekoälyn suojaamiseksi uhkilta ja haitalliselta toiminnalta. Organisaatioiden tulee tehdä säännöllisiä auditointeja, haavoittuvuuksien arviointeja ja käyttää salaustekniikoita arkaluontoisen datan suojaamiseen.

Tekoälyjärjestelmät tulee suunnitella minimoimaan energiankulutusta ja tukemaan ympäristötavoitteita. Kestävyyden tulee olla mukana suunnittelusta alkaen sekä kulutuksen, tehokkuuden ja päästöjen jatkuvassa seurannassa tekoälyn elinkaaren aikana.

Noudattamalla näitä kymmentä pilaria organisaatiot voivat luoda tekoälyjärjestelmiä, jotka ovat eettisiä, luotettavia ja yhteiskunnan odotusten mukaisia. Viitekehys tarjoaa selkeän rakenteen tekoälyn haasteiden hallintaan vastuullisen innovaation edistämiseksi.

Datan eheys on ratkaisevan tärkeää tekoälyjärjestelmien tarkkuuden, oikeudenmukaisuuden ja luotettavuuden kannalta. Heikko datanhallinta voi johtaa harhaan, virheisiin ja epäluotettaviin tuloksiin. Nämä ongelmat heikentävät luottamusta tekoälyn tuottamiin tuloksiin ja voivat aiheuttaa merkittäviä operatiivisia ja maineeseen liittyviä haasteita. KPMG:n Trusted AI -viitekehys korostaa korkealaatuisen datan ylläpitoa koko sen elinkaaren ajan, jotta tekoälyjärjestelmät toimivat tehokkaasti ja eettisiä standardeja noudattaen.

Ilman vahvaa datanhallintaa tekoälyjärjestelmät voivat tuottaa epäluotettavia tuloksia. Esimerkiksi puutteellinen, virheellinen tai asiaankuulumaton data voi johtaa harhaisiin tai epäluotettaviin lopputuloksiin ja lisätä riskejä eri tekoälysovelluksissa.

Data siirtyy usein järjestelmien välillä esimerkiksi koulutuksen, testauksen tai operoinnin yhteydessä. Jos nämä siirrot eivät ole hallittuja, data voi korruptoitua, kadota tai heikentyä, mikä vaikuttaa tekoälyjärjestelmän toimintaan.

Datanhallinnan parantamiseksi organisaatiot voivat:

Datan siirtojen riskejä voidaan vähentää esimerkiksi:

Jatkuvan valvonnan järjestelmät auttavat ylläpitämään datan eheyttä tekoälyn elinkaaren ajan. Ne voivat tunnistaa ongelmia, kuten odottamattomia muutoksia datan laadussa tai käsittelyssä. Näin mahdollisiin virheisiin voidaan puuttua nopeasti.

Datan eheyden ylläpito on keskeistä luotettavan tekoälyn käyttöönotossa. Organisaatiot voivat pienentää riskejä rakentamalla vahvat hallintamallit, suojaamalla tiedonsiirrot ja ylläpitämällä jatkuvia validointiprosesseja. Näillä toimenpiteillä parannetaan tekoälyn tulosten luotettavuutta ja varmistetaan eettisten ja operatiivisten standardien toteutuminen, mikä vahvistaa luottamusta tekoälyteknologiaan.

Rekisteröityjen oikeuksiin liittyvien pyyntöjen hallinta on merkittävä yksityisyyshaaste tekoälyssä. Organisaatioiden on varmistettava, että yksilöt voivat käyttää oikeuksiaan saada pääsy omiin tietoihinsa, oikaista niitä tai pyytää niiden poistamista GDPR:n ja CCPA:n kaltaisten lakien mukaisesti. Jos pyyntöjä ei käsitellä asianmukaisesti, seurauksena voi olla sääntelyrikkomuksia, luottamuksen menetystä ja vahinkoa organisaation maineelle.

Tämän riskin pienentämiseksi yritysten tulisi kehittää ohjelmia, jotka opastavat yksilöitä heidän tietosuojaoikeuksiensa käyttämisessä tekoälyn kanssa asioidessa. Järjestelmät on suunniteltava käsittelemään pyyntöjä nopeasti ja läpinäkyvästi. Lisäksi organisaatioiden tulee pitää yksityiskohtaista kirjaa pyyntöjen käsittelystä, jotta vaatimustenmukaisuus voidaan osoittaa auditoinnissa.

Tekoälyjärjestelmät käsittelevät usein arkaluontoisia henkilötietoja, jolloin ne ovat houkuttelevia kyberhyökkäyksille. Tietomurron tapahtuessa seurauksena voi olla merkittäviä sakkoja, mainehaittoja ja asiakkaiden luottamuksen menetystä.

Tämän estämiseksi KPMG:n Trusted AI -viitekehys suosittelee eettisten arviointien suorittamista henkilödataa hyödyntäville tekoälyjärjestelmille, jotta ne täyttävät tietosuojavaatimukset. Säännölliset tietosuojatarkastukset ja tietosuojavaikutusten arvioinnit (PIA) ovat välttämättömiä, erityisesti kun henkilötietoja käytetään tekoälymallien koulutukseen. Lisäksi menetelmät, kuten differentiaalinen yksityisyys, jolla dataan lisätään tilastollista “kohinaa”, auttavat anonymisoimaan tietoja analysointia varten.

Tekoälyjärjestelmät, joihin ei sisällytetä yksityisyyden suojatoimia alusta alkaen, aiheuttavat merkittäviä riskejä. Ilman privacy-by-design -periaatetta organisaatiot voivat altistaa arkaluontoista dataa tai jättää noudattamatta lakisääteisiä vaatimuksia.

Yritysten tulee ottaa yksityisyyden suojatoimet mukaan tekoälyjärjestelmien kehitysvaiheisiin. Tämä tarkoittaa tietosuojalakien ja -määräysten noudattamista vahvojen datanhallintakäytäntöjen avulla. Datan keruun, käsittelyn ja säilytyksen selkeä dokumentointi on olennainen osa. Organisaatioiden on myös hankittava selkeä suostumus datan keruuseen ja käsittelyyn, erityisesti arkaluonteisissa tapauksissa, kuten biometrisessä datassa.

Kun tekoälyjärjestelmät eivät selkeästi kerro, miten käyttäjätietoja käsitellään, se voi johtaa luottamuspulaan ja oikeudellisiin tarkasteluihin. Käyttäjille tulee kertoa, milloin heidän tietojaan kerätään ja miten niitä käytetään

KPMG:n tekoälyn riskien ja valvonnan opas on käytännön viitekehys, jonka tavoitteena on auttaa organisaatioita hallitsemaan tekoälyn erityispiirteisiin liittyviä riskejä sekä varmistamaan vastuullinen, eettinen ja vaatimustenmukainen tekoälyn käyttöönotto eri toimialoilla.

Opas rakentuu kymmenen keskeisen pilarin varaan: Vastuu, Oikeudenmukaisuus, Läpinäkyvyys, Selitettävyys, Datan eheys, Luotettavuus, Turvallisuus, Turva, Yksityisyys ja Kestävyys – jokainen näistä käsittelee merkittäviä tekoälyn riskienhallinnan osa-alueita.

Opas on suunnattu riskienhallinnan ammattilaisille, vaatimustenmukaisuustiimeille, kyberturva-asiantuntijoille, lakineuvojille, johtajille, tekoälyn kehittäjille, insinööreille sekä kaikenkokoisille organisaatioille, jotka haluavat hallita tekoälyä vastuullisesti.

Opas on linjassa kansainvälisten standardien, kuten ISO 42001:n, NIST AI Risk Management Frameworkin ja EU:n tekoälyasetuksen kanssa, auttaen organisaatioita integroimaan tekoälykohtaiset kontrollit olemassa oleviin hallintaprosesseihin ja täyttämään sääntelyvelvoitteet.

Opas suosittelee esimerkiksi vahvaa datanhallintaa, yksityisyyden huomioimista jo suunnitteluvaiheessa, jatkuvaa valvontaa, tekoälypäätösten läpinäkyvyyttä, poikkeamien havaitsemista, palautesilmukoita sekä kestävyyteen liittyviä tavoitteita tekoälyyn liittyvien riskien vähentämiseksi.

Ota selvää, miten KPMG:n tekoälyn riskien ja valvonnan opas voi auttaa organisaatiotasi hyödyntämään tekoälyinnovaatioita eettisesti, turvallisesti ja vaatimustenmukaisesti.

Käytännön opas yritysjohtajille Human-in-the-Loop (HITL) -kehysten toteuttamiseen vastuullisen tekoälyn hallintaan, riskien vähentämiseen, vaatimustenmukaisuute...

Tekoälyn käyttöönoton määrät kertovat, kuinka suuri osa organisaatioista on ottanut tekoälyn osaksi toimintaansa. Nämä määrät vaihtelevat toimialoittain, alueit...

Tutustu siihen, miksi tekoälyjohtajuus on olennaista organisaation menestykselle, miten vahvat johtajat vievät läpi tekoälymuutoksen ja kuinka FlowHuntin tekoäl...