Gemini Flash 2.0: AI nopeudella ja tarkkuudella

Gemini Flash 2.0 asettaa uudet standardit tekoälylle parannetulla suorituskyvyllä, nopeudella ja multimodaalisilla kyvyillä. Tutustu sen mahdollisuuksiin tosiel...

Wan 2.1 on tehokas avoimen lähdekoodin tekoälyvideon luontimalli Alibabalta, joka tuottaa studio-tasoista videota tekstistä tai kuvista – kaikille ilmaiseksi käytettäväksi paikallisesti.

Wan 2.1 (tunnetaan myös nimellä WanX 2.1) rikkoo uusia rajoja täysin avoimen lähdekoodin tekoälyvideon luontimallina, jonka on kehittänyt Alibaban Tongyi Lab. Toisin kuin monet omistusoikeudelliset videonluontijärjestelmät, jotka vaativat kalliita tilauksia tai API-pääsyä, Wan 2.1 tarjoaa vastaavaa tai parempaa laatua pysyen samalla täysin ilmaisena ja helposti saavutettavana kehittäjille, tutkijoille ja luoville ammattilaisille.

Wan 2.1:n tekee erityiseksi sen saavutettavuuden ja suorituskyvyn yhdistelmä. Pienempi T2V-1.3B-versio tarvitsee vain noin 8.2 GB GPU-muistia, joten se sopii useimmille moderneille kuluttajatason näytönohjaimille. Samaan aikaan suurempi 14B-parametrinen versio tarjoaa huipputason suorituskykyä, joka päihittää sekä avoimen lähdekoodin että monet kaupalliset mallit vakiotesteissä.

Wan 2.1 ei rajoitu vain tekstistä videoksi -generointiin. Sen monipuolinen arkkitehtuuri tukee:

Tämä joustavuus tarkoittaa, että voit aloittaa tekstikehotteella, still-kuvalla tai jopa olemassa olevalla videolla ja muuntaa sen luovan näkemyksesi mukaisesti.

Ensimmäisenä videomallina, joka kykenee renderöimään luettavaa englantia ja kiinaa luoduissa videoissa, Wan 2.1 avaa uusia mahdollisuuksia kansainvälisille sisällöntuottajille. Tämä ominaisuus on erityisen hyödyllinen tekstitysten tai kohtaustekstien lisäämisessä monikielisiin videoihin.

Wan 2.1:n tehokkuuden ytimessä on sen 3D-kausaalinen Video Variational Autoencoder. Tämä teknologinen läpimurto pakkaa tehokkaasti avaruudellista ja ajallista informaatiota, mahdollistaen mallin:

Pienempi 1.3B-malli tarvitsee vain 8,19 GB VRAMia ja voi tuottaa 5 sekunnin, 480p-videon noin 4 minuutissa RTX 4090:llä. Tehokkuudestaan huolimatta sen laatu vastaa tai ylittää paljon suurempien mallien tason, tarjoten erinomaisen tasapainon nopeuden ja visuaalisen tarkkuuden välillä.

Julkisissa arvioinneissa Wan 14B saavutti korkeimman kokonaispistemäärän Wan-Bench-testeissä, päihittäen kilpailijat mm.:

Toisin kuin suljetut järjestelmät kuten OpenAI:n Sora tai Runway:n Gen-2, Wan 2.1 on vapaasti ajettavissa paikallisesti. Se päihittää yleensä aiemmat avoimen lähdekoodin mallit (kuten CogVideo, MAKE-A-VIDEO ja Pika) sekä monet kaupalliset vaihtoehdot laatutesteissä.

Äskettäisessä alan kyselyssä todettiin, että ”monien tekoälyvideomallien joukossa Wan 2.1 ja Sora erottuvat” – Wan 2.1 avoimuudellaan ja tehokkuudellaan, Sora omistusoikeudellisella innovaatiollaan. Yhteisötesteissä käyttäjät ovat raportoineet Wan 2.1:n kuvasta videoksi -ominaisuuden päihittävän kilpailijat selkeydessä ja elokuvamaisessa tunnelmassa.

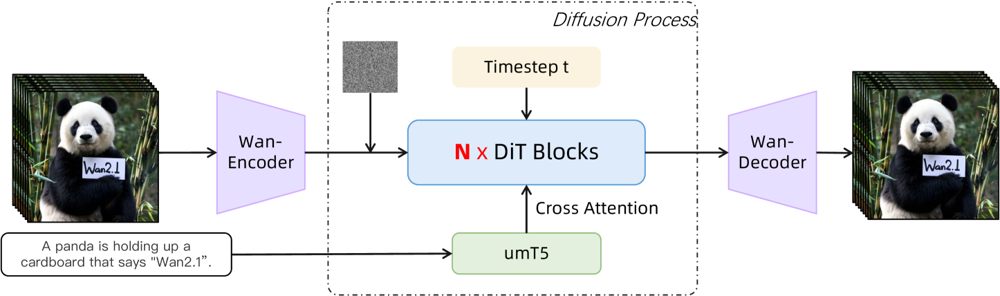

Wan 2.1 rakentuu diffuusio-transformer -runkoon ja uuteen avaruudellis-aikaiseen VAE:hen. Näin se toimii:

Kuvio: Wan 2.1:n korkean tason arkkitehtuuri (tekstistä videoksi). Video (tai kuva) koodataan ensin Wan-VAE-enkooderilla latentiksi. Tämä latentti kulkee N diffuusiotransformerilohkon läpi, jotka hyödyntävät tekstin upotusta (umT5:stä) ristiinhuomioinnin avulla. Lopuksi Wan-VAE-dekooderi rekonstruoi videon ruudut. Tämä rakenne – ”3D-kausaalinen VAE-enkooderi/dekooderi diffuusiotransformerin ympärillä” (ar5iv.org) – mahdollistaa avaruudellisen ja ajallisen datan tehokkaan pakkauksen ja tukee korkealaatuista videoulostuloa.

Tämä innovatiivinen arkkitehtuuri – ”3D-kausaalinen VAE-enkooderi/dekooderi diffuusiotransformerin ympärillä” – mahdollistaa avaruudellisen ja ajallisen datan tehokkaan pakkauksen ja tukee korkealaatuista videoulostuloa.

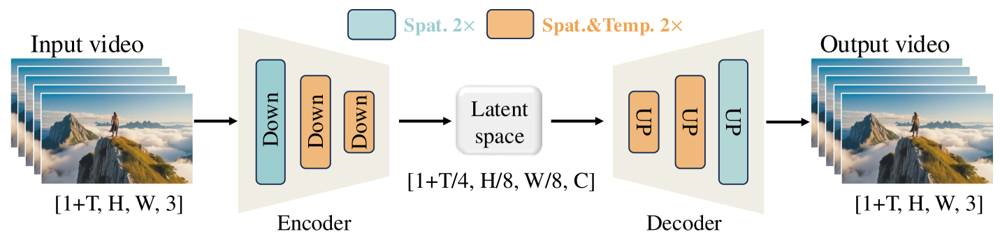

Wan-VAE on suunniteltu erityisesti videoita varten. Se pakkaa syötteen vaikuttavilla kertoimilla (ajallisesti 4× ja avaruudellisesti 8×) kompaktiksi latentiksi ennen kuin dekoodaa sen takaisin täydeksi videoksi. 3D-konvoluutioiden ja kausaalisten (aikaa säilyttävien) kerrosten käyttö varmistaa yhtenäiset liikkeet läpi tuotetun sisällön.

Kuvio: Wan 2.1:n Wan-VAE-rakenne (enkooderi-dekooderi). Wan-VAE-enkooderi (vasemmalla) käyttää syötevideolle (muoto [1+T, H, W, 3] ruudut) sarjan alasnäytteistäviä kerroksia (“Down”), kunnes saavutetaan kompakti latentti ([1+T/4, H/8, W/8, C]). Wan-VAE-dekooderi (oikealla) kasvattaa (“UP”) tämän latenttikoodin takaisin alkuperäisiksi videoruuduiksi. Siniset lohkot kuvaavat avaruudellista pakkausta, oranssit lohkot yhdistettyä avaruudellista ja ajallista pakkausta (ar5iv.org). Pakkaamalla videon 256× (avaruudellis-ajallisessa tilavuudessa), Wan-VAE mahdollistaa korkean resoluution videomallinnuksen myöhemmälle diffuusiomallille.

Haluatko kokeilla Wan 2.1:tä itse? Näin pääset alkuun:

Kloonaa repositorio ja asenna riippuvuudet:

git clone https://github.com/Wan-Video/Wan2.1.git

cd Wan2.1

pip install -r requirements.txt

Lataa mallin painot:

pip install "huggingface_hub[cli]"

huggingface-cli login

huggingface-cli download Wan-AI/Wan2.1-T2V-14B --local-dir ./Wan2.1-T2V-14B

Luo ensimmäinen videosi:

python generate.py --task t2v-14B --size 1280*720 \

--ckpt_dir ./Wan2.1-T2V-14B \

--prompt "A futuristic city skyline at sunset, with flying cars zooming overhead."

--offload_model True --t5_cpu mallin osien siirtoon prosessorille--size-parametrilla (esim. 832*480 tuottaa 16:9 480p-videon)Viitteeksi: RTX 4090 tuottaa 5 sekunnin 480p-videon noin 4 minuutissa. Moni-GPU-kokoonpanot ja erilaiset suorituskykyoptimoinnit (FSDP, kvantisointi ym.) ovat tuettuja laajamittaiseen käyttöön.

Avoimen lähdekoodin voimanpesänä Wan 2.1 haastaa tekoälyvideon jättiläiset ja edustaa merkittävää muutosta saavutettavuudessa. Sen ilmainen ja avoin luonne tarkoittaa, että kuka tahansa hyvällä näytönohjaimella voi kokeilla huipputason videonluontia ilman tilaushintoja tai API-kuluja.

Kehittäjille avoimen lähdekoodin lisenssi mahdollistaa mallin räätälöinnin ja kehittämisen. Tutkijat voivat laajentaa sen kyvykkyyksiä, ja luovat ammattilaiset voivat prototypoida videota nopeasti ja tehokkaasti.

Aikana, jolloin omistusoikeudelliset tekoälymallit ovat yhä useammin maksumuurien takana, Wan 2.1 osoittaa, että huipputason suorituskyky voidaan demokratisoida ja jakaa koko yhteisölle.

Wan 2.1 on täysin avoimen lähdekoodin tekoälyvideomalli, jonka on kehittänyt Alibaban Tongyi Lab. Sillä voi luoda korkealaatuisia videoita tekstikehotteista, kuvista tai olemassa olevista videoista. Se on ilmainen, tukee useita tehtäviä ja toimii tehokkaasti kuluttajatason näytönohjaimilla.

Wan 2.1 tukee monitehtäväistä videonluontia (tekstistä videoksi, kuvasta videoksi, videon editointi jne.), monikielistä tekstin renderöintiä videoissa, korkeaa tehokkuutta 3D-kausaalisen Video VAE:n ansiosta ja päihittää monet kaupalliset sekä avoimen lähdekoodin mallit vertailutesteissä.

Tarvitset Python 3.8+:n, PyTorch 2.4.0+ -version CUDA-tuella sekä NVIDIA-näytönohjaimen (8GB+ VRAM pienemmälle mallille, 16-24GB isolle mallille). Kloonaa GitHub-repositorio, asenna riippuvuudet, lataa mallin painot ja käytä mukana tulevia skriptejä videoiden luomiseen paikallisesti.

Wan 2.1 demokratisoi huipputason videonluontia olemalla avoimen lähdekoodin ja ilmainen, jolloin kehittäjät, tutkijat ja luovat voivat kokeilla ja innovoida ilman maksumuureja tai omistusoikeudellisia rajoituksia.

Toisin kuin suljetun lähdekoodin vaihtoehdot kuten Sora tai Runway Gen-2, Wan 2.1 on täysin avoin ja sitä voi ajaa paikallisesti. Se päihittää yleensä aiemmat avoimen lähdekoodin mallit ja vastaa tai ylittää monia kaupallisia ratkaisuja laatutesteissä.

Arshia on AI-työnkulkuinsinööri FlowHuntilla. Tietojenkäsittelytieteen taustalla ja intohimolla tekoälyyn hän erikoistuu luomaan tehokkaita työnkulkuja, jotka integroivat tekoälytyökaluja arjen tehtäviin, parantaen tuottavuutta ja luovuutta.

Aloita omien tekoälytyökalujen ja videonluontiprosessien rakentaminen FlowHuntilla tai varaa demo nähdäksesi alustan toiminnassa.

Gemini Flash 2.0 asettaa uudet standardit tekoälylle parannetulla suorituskyvyllä, nopeudella ja multimodaalisilla kyvyillä. Tutustu sen mahdollisuuksiin tosiel...

LangChain on avoimen lähdekoodin kehys, joka on suunniteltu sovellusten kehittämiseen suurten kielimallien (LLM) avulla. Se helpottaa tehokkaiden LLM-mallien, k...

Large Language Model Meta AI (LLaMA) on huippuluokan luonnollisen kielen käsittelymalli, jonka on kehittänyt Meta. Jopa 65 miljardilla parametriarvolla LLaMA lo...