LLM Gemini

FlowHunt tukee kymmeniä tekoälymalleja, mukaan lukien Google Gemini. Opi käyttämään Geminia tekoälytyökaluissa ja -chatboteissa, vaihtamaan mallien välillä sekä...

LLM DeepSeek FlowHuntilla antaa käyttöösi ja muokattavaksesi huippuluokan AI-mallit, kuten DeepSeek R1:n tekstin ja kuvan generointiin chatbotteihin ja AI-työkaluihin – kaikki yhdestä hallintapaneelista.

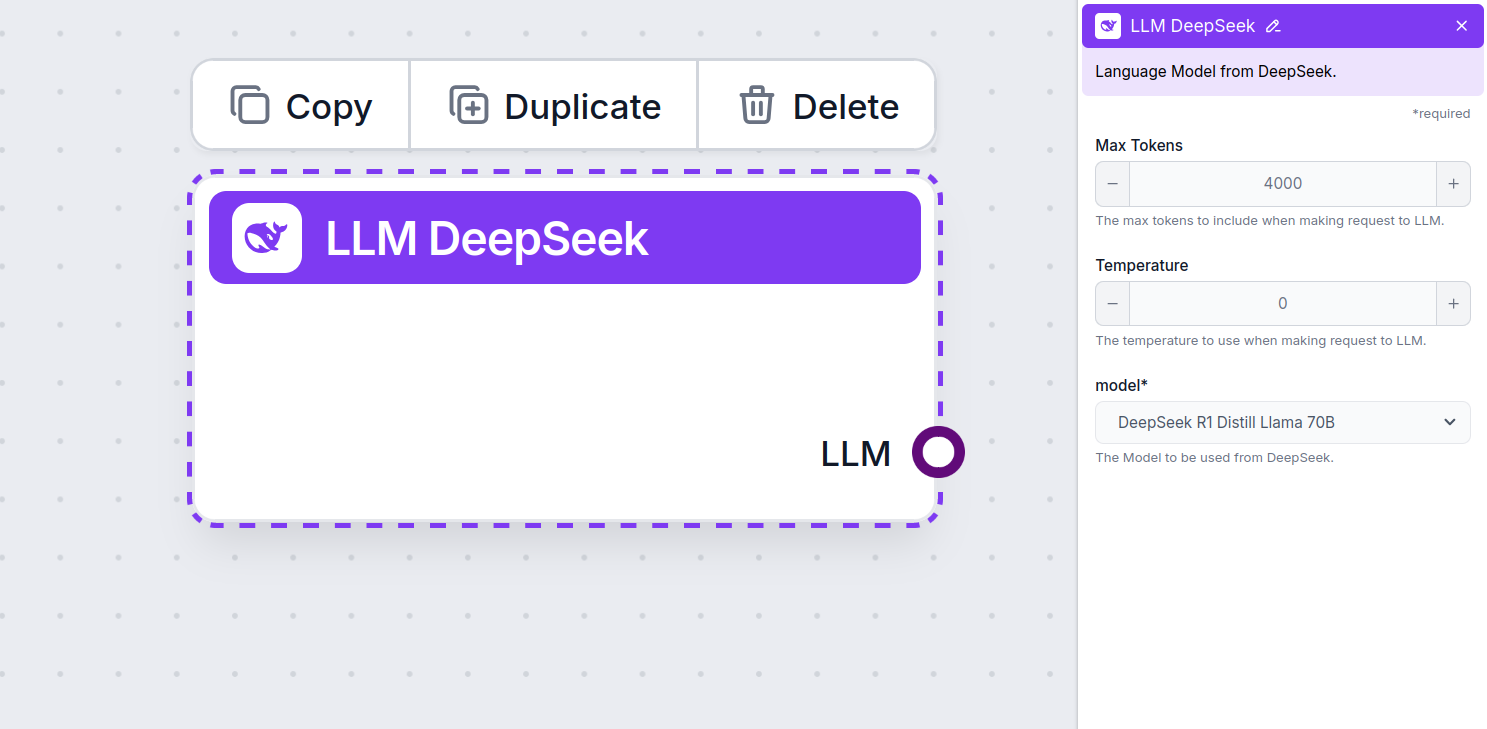

Komponentin kuvaus

LLM DeepSeek -komponentti yhdistää DeepSeek-mallit Flow’husi. Vaikka generaattorit ja agentit ovat paikkoja, joissa varsinainen taika tapahtuu, LLM-komponentit mahdollistavat mallin vaihdon ja hallinnan.

Muista, että LLM-komponentin liittäminen on vapaaehtoista. Kaikki LLM:ää käyttävät komponentit käyttävät oletuksena ChatGPT-4o:ta. LLM-komponenttien avulla voit vaihtaa mallin ja säätää mallin asetuksia.

Tokenit ovat yksittäisiä tekstin yksiköitä, joita malli prosessoi ja tuottaa. Tokenien käyttö vaihtelee malleittain, ja yksi token voi olla sana, sanan osa tai yksittäinen merkki. Mallit hinnoitellaan yleensä miljoonissa tokeneissa.

Max tokens -asetus rajoittaa tokeneiden kokonaismäärää, joka voidaan käsitellä yhdessä vuorovaikutuksessa tai pyynnössä, varmistaen että vastaukset pysyvät kohtuullisissa rajoissa. Oletusraja on 4 000 tokenia, mikä on optimaalinen koko dokumenttien ja useiden lähteiden tiivistämiseen vastauksen tuottamiseksi.

Lämpötila säätelee vastausten vaihtelevuutta, arvoilla 0:sta 1:een.

Lämpötila 0,1 tekee vastauksista hyvin ytimekkäitä, mutta mahdollisesti toistavia ja puutteellisia.

Korkea lämpötila, kuten 1, sallii maksimaalisen luovuuden vastauksissa, mutta kasvattaa epäolennaisten tai jopa harhaisten vastausten riskiä.

Esimerkiksi asiakaspalvelubotille suositeltu lämpötila on 0,2–0,5. Tämä taso pitää vastaukset relevantteina ja käsikirjoituksen mukaisina, mutta sallii luonnollista vaihtelua.

Tämä on mallinvalitsin. Täältä löydät kaikki tuetut DeepSeek-mallit. Kaikki uusimmat Gemini-mallit ovat tuettuina:

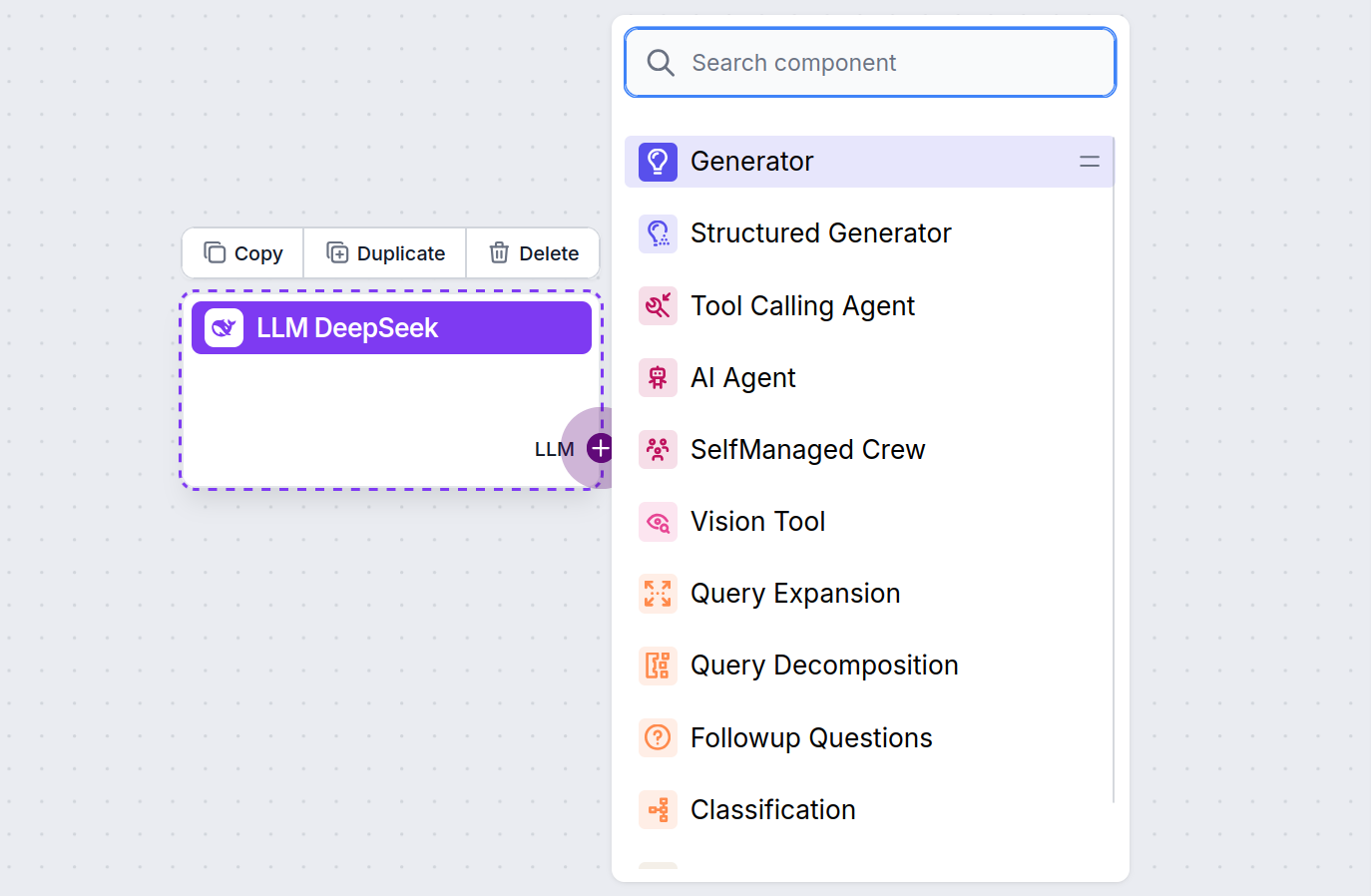

Huomaat, että kaikilla LLM-komponenteilla on vain lähtökahva. Syöte ei kulje komponentin läpi, sillä komponentti edustaa vain mallia – varsinainen generointi tapahtuu AI-agenteissa ja generaattoreissa.

LLM-kahva on aina violetti. LLM-syötekahva löytyy kaikista komponenteista, jotka käyttävät tekoälyä tekstin generointiin tai datan prosessointiin. Voit tarkastella valintoja klikkaamalla kahvaa:

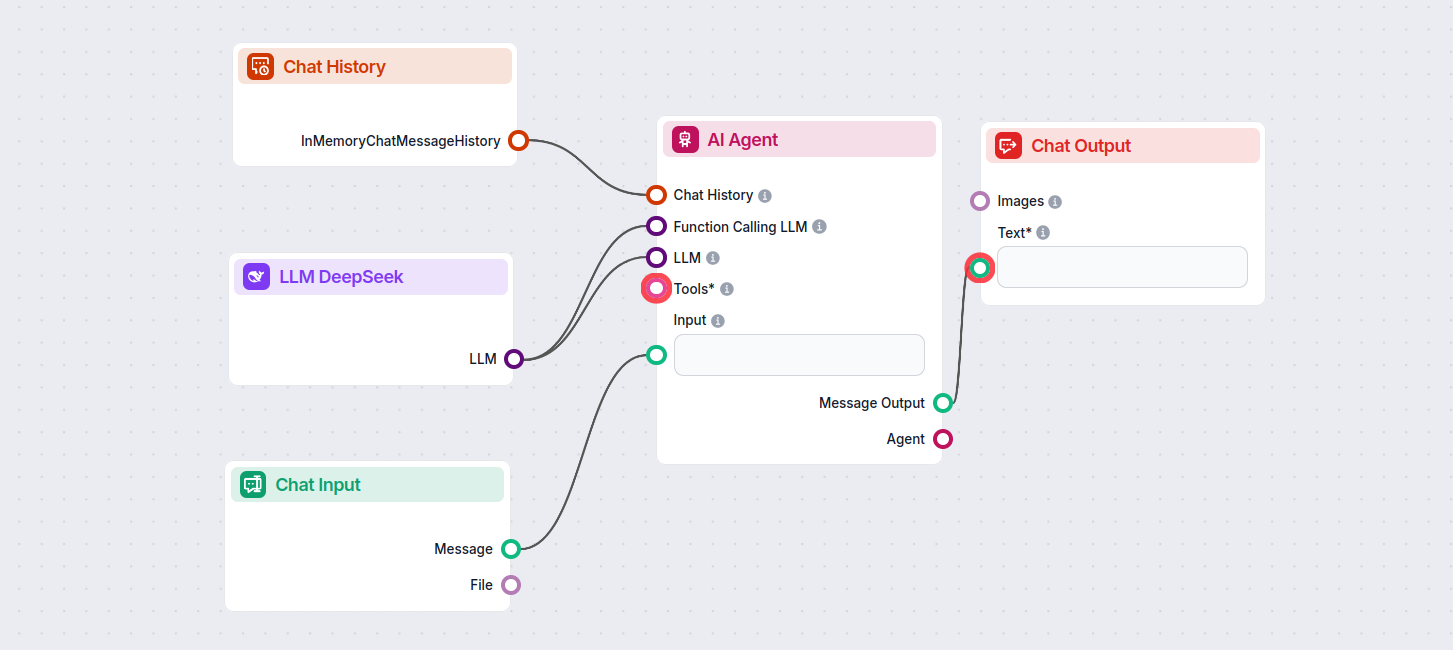

Tämän avulla voit luoda kaikenlaisia työkaluja. Katsotaan komponenttia käytännössä. Tässä yksinkertainen AI Agent -chatbot Flow, joka käyttää DeepSeek R1:tä vastausten tuottamiseen. Voit ajatella sitä perus-DeepSeek-chatbottina.

Tämä yksinkertainen chatbot Flow sisältää:

LLM DeepSeek on FlowHuntin komponentti, jonka avulla voit yhdistää ja hallita DeepSeek AI -malleja tekstin ja kuvan generointiin, mahdollistaen tehokkaat chatbotit ja automaatiovirrat.

FlowHunt tukee kaikkia uusimpia DeepSeek-malleja, mukaan lukien DeepSeek R1, joka tunnetaan nopeudestaan ja suorituskyvystään erityisesti verrattuna muihin johtaviin AI-malleihin.

Voit säätää maksimimäärää tokeneita vastauspituudelle ja lämpötilaa vastausten luovuudelle sekä vaihtaa käytössä olevia DeepSeek-malleja suoraan FlowHuntin hallintapaneelissa.

Ei, LLM-komponentin liittäminen on vapaaehtoista. Oletuksena FlowHunt käyttää ChatGPT-4o:ta, mutta LLM DeepSeekin lisääminen mahdollistaa mallin vaihdon ja hallinnan siitä, mikä AI-malli ohjaa virtojasi.

Aloita fiksumpien AI-chatbottien ja automaatiotyökalujen rakentaminen kehittyneillä DeepSeek-malleilla – ilman monimutkaista käyttöönottoa tai useita tilauksia.

FlowHunt tukee kymmeniä tekoälymalleja, mukaan lukien Google Gemini. Opi käyttämään Geminia tekoälytyökaluissa ja -chatboteissa, vaihtamaan mallien välillä sekä...

FlowHunt tukee kymmeniä tekstinluontimalleja, mukaan lukien xAI:n mallit. Näin voit käyttää xAI-malleja AI-työkaluissasi ja chatboteissasi.

FlowHunt tukee kymmeniä tekoälytekstimalleja, mukaan lukien Mistralin mallit. Näin voit käyttää Mistralia tekoälytyökaluissasi ja chatboteissasi.