LLM xAI

FlowHunt tukee kymmeniä tekstinluontimalleja, mukaan lukien xAI:n mallit. Näin voit käyttää xAI-malleja AI-työkaluissasi ja chatboteissasi.

FlowHuntin LLM Meta AI tuo Metan Llama-mallit ja kymmeniä muita tekoälymalleja yhteen helppokäyttöiseen hallintapaneeliin joustavaan tekstin ja kuvan luontiin.

Komponentin kuvaus

LLM Meta AI -komponentti yhdistää Claude-malliperheen Flowhun. Vaikka generointia ja agentteja käytetään varsinaiseen tekoälytyöhön, LLM-komponentit antavat sinun hallita käytettävää mallia. Kaikissa komponenteissa on oletuksena ChatGPT-4. Voit liittää tämän komponentin, jos haluat vaihtaa mallia tai saada siihen lisää hallintaa.

Muista, että LLM-komponentin liittäminen on vapaaehtoista. Kaikissa LLM:ää käyttävissä komponenteissa on oletuksena ChatGPT-4o. LLM-komponentit mahdollistavat mallin vaihdon ja malliasetusten säätämisen.

Tokenit edustavat tekstin yksittäisiä yksiköitä, joita malli käsittelee ja tuottaa. Tokenien käyttö vaihtelee malleittain, ja yksi token voi olla sana, osasana tai jopa yksittäinen merkki. Mallien hinnoittelu perustuu yleensä miljooniin tokeneihin.

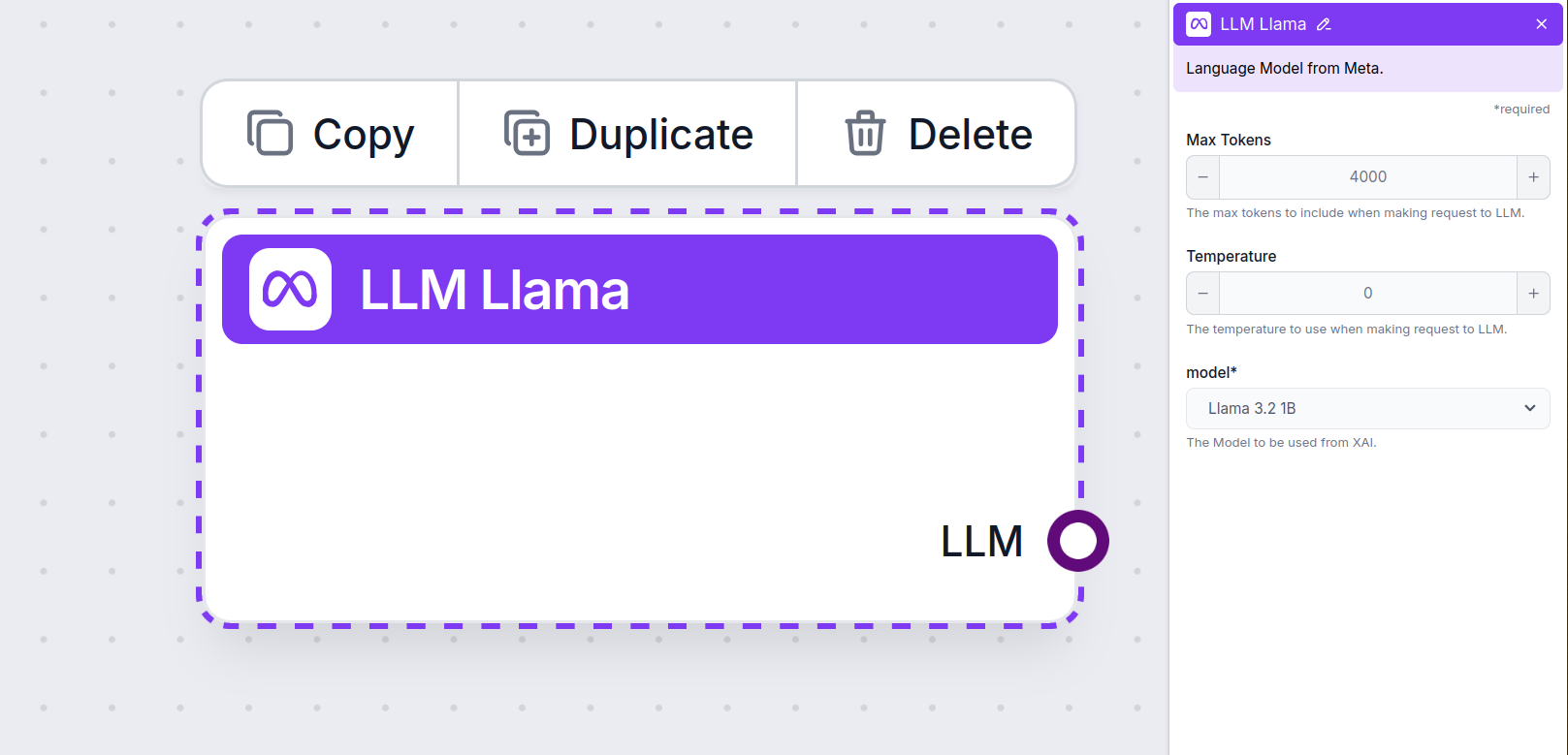

Maksimitokeniasetus rajoittaa kerralla käsiteltävien tokenien kokonaismäärää, varmistaen että vastaukset pysyvät kohtuullisissa rajoissa. Oletusraja on 4 000 tokenia, mikä on optimaalinen koko dokumenttien ja useiden lähteiden tiivistämiseen vastauksen luontia varten.

Lämpötila ohjaa vastausten vaihtelevuutta, välillä 0–1.

Lämpötila 0,1 tekee vastauksista hyvin ytimekkäitä, mutta mahdollisesti toisteisia ja puutteellisia.

Korkea lämpötila 1 mahdollistaa maksimaalisen luovuuden, mutta lisää epäolennaisten tai jopa harhaisten vastausten riskiä.

Esimerkiksi asiakaspalvelubotin suositeltu lämpötila on välillä 0,2–0,5. Tämä taso pitää vastaukset asiallisina ja käsikirjoituksen mukaisina, mutta sallii luonnollisen vaihtelun vastauksissa.

Tässä valitaan käytettävä malli. Täältä löydät kaikki tuetut Meta AI -mallit. Tuemme Metan avoimen lähdekoodin kevyitä Llama-malleja. Nämä mallit on suunniteltu tehokkaaseen laite- ja reunalaskentaan:

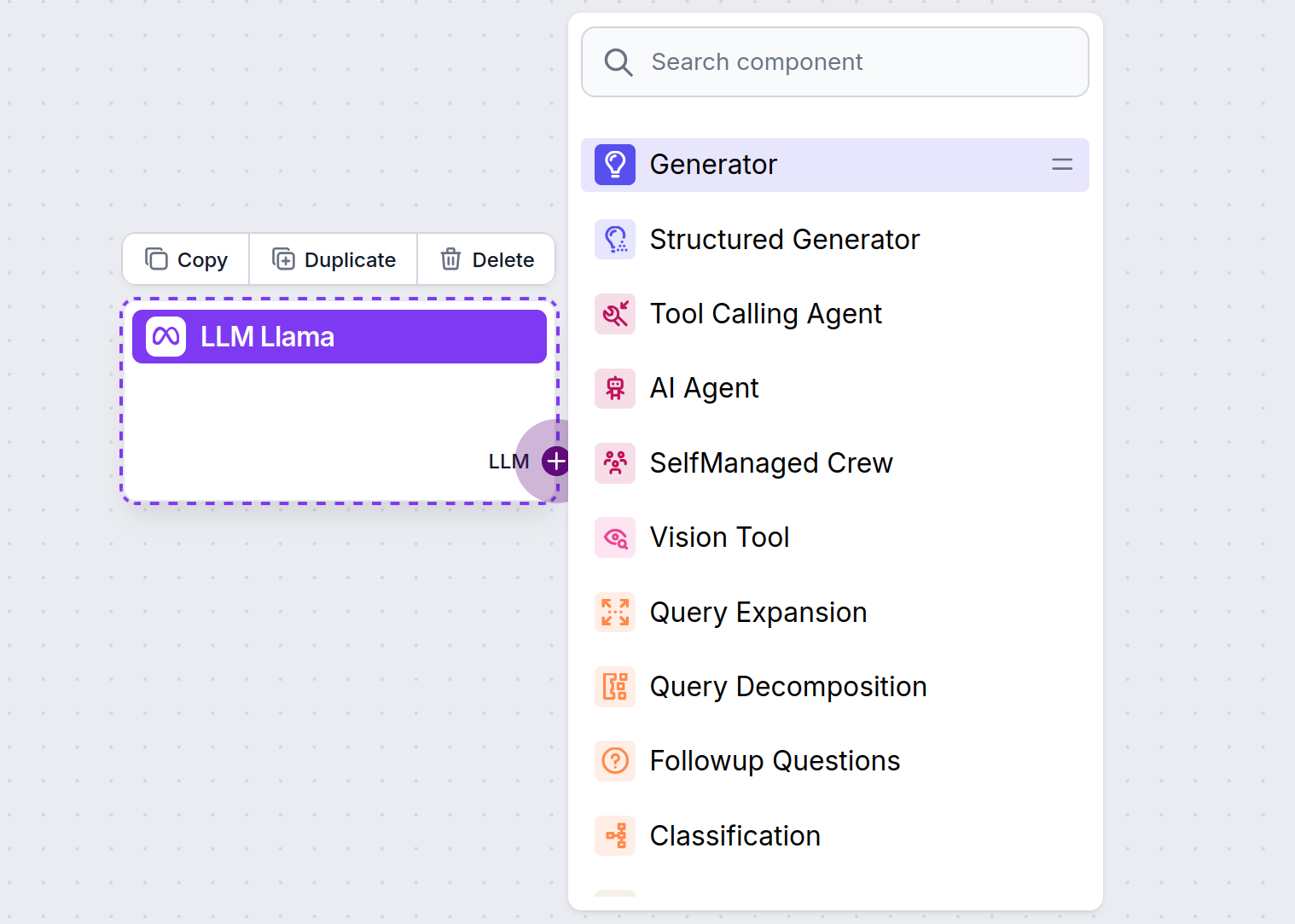

Huomaat, että kaikissa LLM-komponenteissa on vain ulostulokahva. Syöte ei kulje komponentin läpi, sillä komponentti edustaa vain mallia ja varsinainen generointi tapahtuu AI-agenteissa ja generaattoreissa.

LLM-kahva on aina violetti. LLM-syötekahva löytyy kaikista komponenteista, jotka käyttävät tekoälyä tekstin tuottamiseen tai datan käsittelyyn. Vaihtoehdot näet klikkaamalla kahvaa:

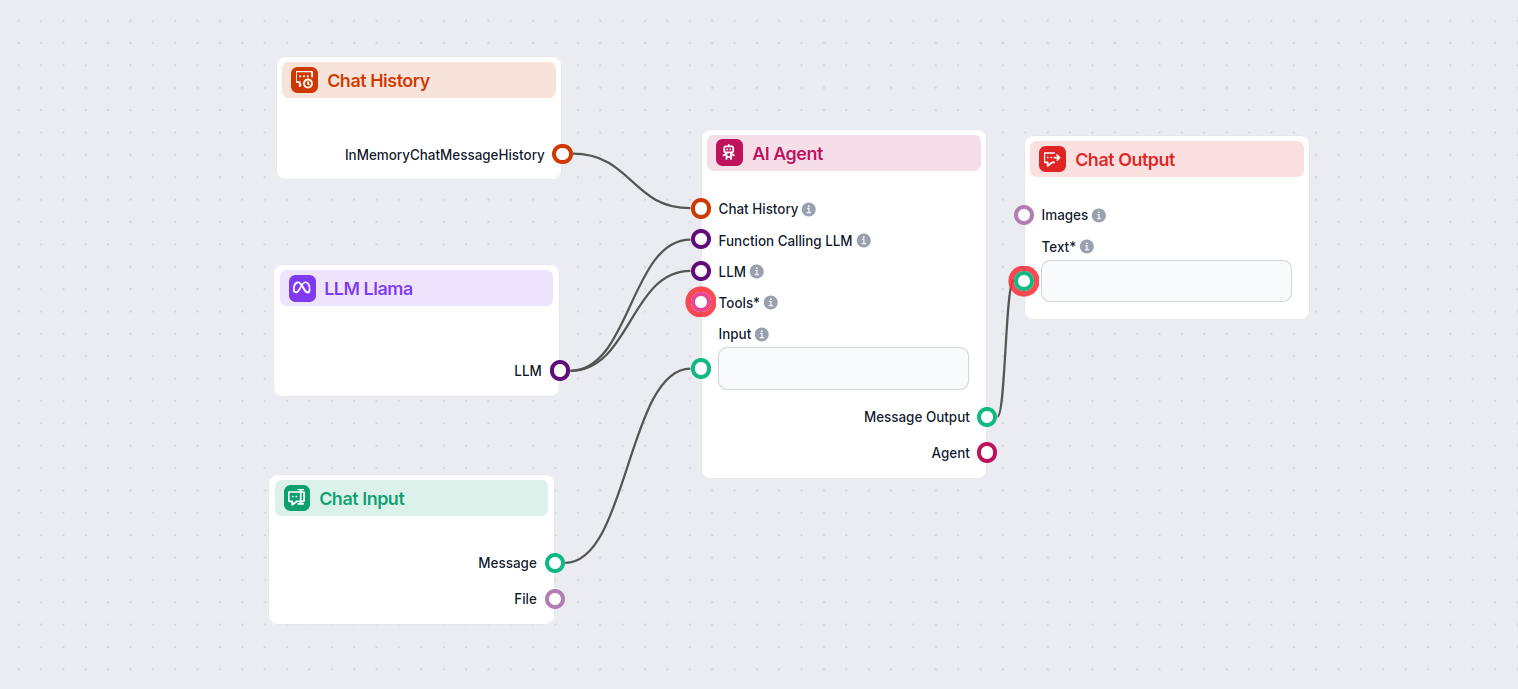

Tämä mahdollistaa erilaisten työkalujen rakentamisen. Katsotaanpa komponenttia toiminnassa. Tässä on yksinkertainen AI Agent -chatbotin työnkulku, joka käyttää Meta AI:n Llama 3.2 1B -mallia vastausten tuottamiseen. Voit ajatella sitä perustason Llama-chatbottina.

Tämä yksinkertainen chatbotin työnkulku sisältää:

LLM Meta AI -komponentti mahdollistaa Metan Llama-mallien ja muiden teksti-/kuvageneraattoreiden liittämisen työnkulkuihin, mahdollistaen helpon mallin valinnan ja edistyneet asetukset kuten maksimimäärä tokeneita ja lämpötila.

FlowHunt tukee Metan avoimen lähdekoodin Llama-malleja, mukaan lukien Llama 3.2 1B ja 3B, jotka on optimoitu tehokkuutta, tiivistämistä ja laitekohtaista käyttöä varten.

Voit säätää asetuksia, kuten maksimimäärä tokeneita (rajoittaa vastauksen pituutta), lämpötila (säätää vastauksen luovuutta) ja mallin valinta suoraan FlowHuntin hallintapaneelista jokaiselle komponentille.

Ei, LLM Meta AI -komponentin lisääminen on vapaaehtoista. Oletuksena komponenteissa käytetään ChatGPT-4o:ta, mutta voit vaihtaa Llamaan tai muihin malleihin saadaksesi enemmän hallintaa tai erityisiin käyttötarkoituksiin.

Aloita älykkäämpien chatbotien ja tekoälytyökalujen rakentaminen Metan Llama-malleilla ja kymmenillä muilla tekoälygeneroijilla – kaikki yhdessä alustassa.

FlowHunt tukee kymmeniä tekstinluontimalleja, mukaan lukien xAI:n mallit. Näin voit käyttää xAI-malleja AI-työkaluissasi ja chatboteissasi.

FlowHunt tukee kymmeniä tekoälytekstimalleja, mukaan lukien Mistralin mallit. Näin voit käyttää Mistralia tekoälytyökaluissasi ja chatboteissasi.

FlowHunt tukee kymmeniä tekstinluontimalleja, mukaan lukien OpenAI:n mallit. Näin käytät ChatGPT:tä tekoälytyökaluissasi ja chatboteissasi.